EN ESTA PÁGINA

Compatibilidad con multiconexión para sistemas finales conectados a Ethernet

Compatibilidad con multiconexión para sistemas finales conectados a IP

Optimización del tráfico de máquinas virtuales de entrada para EVPN

Reducción del tráfico ARP con sincronización y supresión de ARP (ARP de proxy)

Funciones de seguridad de puertos de capa 2 en sistemas finales conectados a Ethernet

Componentes de la arquitectura del plano de la estructura del centro de datos

En esta sección se ofrece una descripción general de los bloques de creación utilizados en esta arquitectura de plano. La implementación de cada tecnología de bloques de construcción se explora con más detalle en secciones posteriores.

Para obtener información acerca del hardware y el software que sirven de base para sus bloques de creación, consulte el Resumen de referencia de estructuras EVPN-VXLAN para centros de datos: Resumen de hardware compatible.

Los bloques de construcción incluyen:

Red subyacente de estructura IP

El bloque de construcción de red subyacente de estructura IP moderna proporciona conectividad IP a través de una topología basada en Clos. Juniper Networks admite los siguientes modelos subyacentes de estructura IP:

-

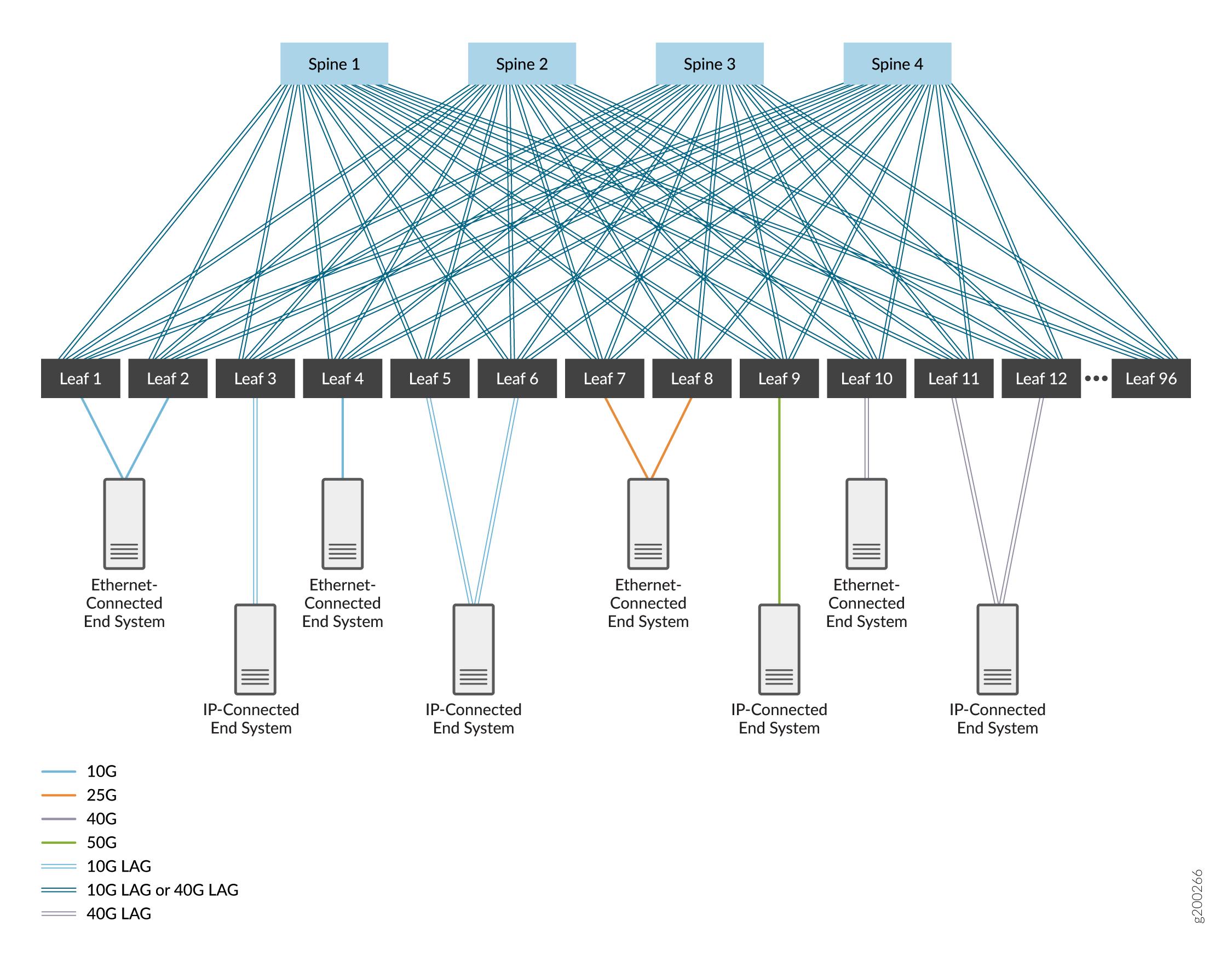

Una estructura IP de 3 etapas, que se compone de un nivel de dispositivos spine y un nivel de dispositivos leaf. Consulte la figura 1.

-

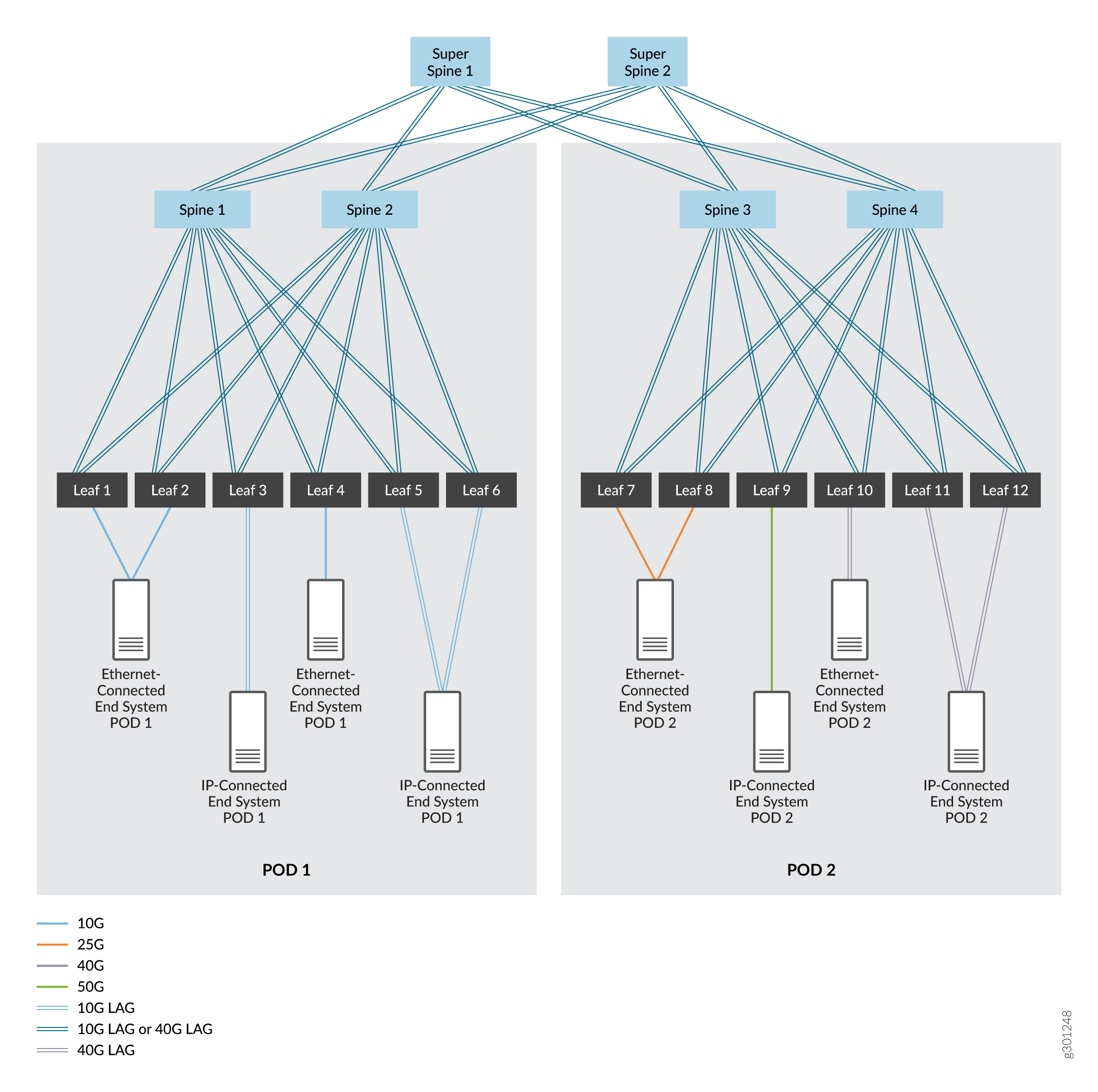

Una estructura IP de 5 etapas, que normalmente comienza como una única estructura de IP de 3 etapas que crece en dos estructuras de IP de 3 etapas. Estas estructuras se segmentan en puntos de entrega independientes (POD) dentro de un centro de datos. Para este caso de uso, admitimos la adición de un nivel de dispositivos de súper columna vertebral que permiten la comunicación entre los dispositivos de columna vertebral y hoja en los dos POD. Consulte la figura 2.

-

Un modelo de estructura IP de spine colapsada, en el que las funciones de capa de hoja se contraen en los dispositivos de columna. Este tipo de estructura se puede configurar y operar de manera similar a una estructura IP de 3 o 5 etapas, excepto sin un nivel separado de dispositivos leaf. Puede usar una estructura de spine colapsada si se está moviendo incrementalmente a un modelo de spine-and-leaf de EVPN, o si tiene dispositivos de acceso o dispositivos de la parte superior del rack (TOR) que no se pueden usar en una capa leaf porque no son compatibles con EVPN-VXLAN.

IP de tres etapas

IP de tres etapas

IP de cinco etapas

IP de cinco etapas

En estas figuras, los dispositivos están interconectados mediante interfaces de alta velocidad que son vínculos únicos o interfaces Ethernet agregadas. Las interfaces Ethernet agregadas son opcionales (normalmente se utiliza un único vínculo entre dispositivos), pero se pueden implementar para aumentar el ancho de banda y proporcionar redundancia a nivel de vínculo. Cubrimos ambas opciones.

Elegimos EBGP como protocolo de enrutamiento en la red subyacente por su confiabilidad y escalabilidad. A cada dispositivo se le asigna su propio sistema autónomo con un número de sistema autónomo único para admitir EBGP. Puede utilizar otros protocolos de enrutamiento en la red subyacente; El uso de esos protocolos está fuera del alcance de este documento.

Los diseños de arquitectura de referencia descritos en esta guía se basan en una estructura IP que utiliza EBGP para la conectividad subyacente e IBGP para el emparejamiento de superposición (consulte IBGP para superposiciones). También puede configurar el emparejamiento de superposición mediante EBGP.

A partir de las versiones 21.2R2 y 21.4R1 de Junos OS, también admitimos la configuración de una estructura IPv6. El diseño de estructura IPv6 de esta guía usa EBGP tanto para la conectividad subyacente como para el emparejamiento de superposición (consulte EBGP para superposiciones con capas subyacentes IPv6).

La estructura IP puede usar IPv4 o IPv6 de la siguiente manera:

-

Una estructura IPv4 utiliza el direccionamiento de interfaz IPv4 y las sesiones BGP subyacentes y superpuestas IPv4 para la comunicación de la carga de trabajo de extremo a extremo.

-

Una estructura IPv6 utiliza direccionamiento de interfaz IPv6 y sesiones BGP subyacentes y superpuestas IPv6 para la comunicación de carga de trabajo de extremo a extremo.

-

No se admite una estructura IP que mezcle IPv4 e IPv6.

Sin embargo, tanto las estructuras IPv4 como las estructuras IPv6 admiten cargas de trabajo de pila doble: las cargas de trabajo pueden ser IPv4 o IPv6, o IPv4 e IPv6.

La detección de reenvío microbidireccional (BFD), la capacidad de ejecutar BFD en vínculos individuales en una interfaz Ethernet agregada, también se puede habilitar en este bloque de construcción para detectar rápidamente fallas de vínculos en cualquier enlace miembro en paquetes de Ethernet agregados que conectan dispositivos.

Para obtener más información, consulte estas otras secciones de esta guía:

-

Configuración de dispositivos spine and leaf en subyacentes de estructura IP de 3 y 5 etapas: Diseño e implementación de redes subyacentes de estructura IP.

-

Implementación del nivel adicional de dispositivos súper spine en una capa subyacente de estructura IP de 5 etapas: diseño e implementación de estructura IP de cinco etapas.

-

Configuración de una capa subyacente IPv6 y compatibilidad con la superposición IPv6 de EBGP: Diseño e implementación de redes de superposición y subyacente de estructura IPv6 con EBGP.

-

Configuración de la capa subyacente en un modelo de tejido de spine colapsado: Diseño e implementación de tejido de spine colapsado.

Compatibilidad con cargas de trabajo IPv4 e IPv6

Dado que muchas redes implementan un entorno de pila dual para cargas de trabajo que incluye protocolos IPv4 e IPv6, este modelo proporciona compatibilidad para ambos protocolos. Los pasos para configurar la estructura de modo que admita cargas de trabajo IPv4 e IPv6 se entrelazan a lo largo de esta guía para permitirle elegir uno o ambos de estos protocolos.

El protocolo IP que se usa para el tráfico de carga de trabajo es independiente de la versión del protocolo IP (IPv4 o IPv6) que configure para la capa subyacente y superpuesta de la estructura IP. ( Consulte Red subyacente de estructura IP.) Una estructura IPv4 o una infraestructura de estructura IPv6 pueden admitir cargas de trabajo IPv4 e IPv6.

Superposiciones de virtualización de red

Una superposición de virtualización de red es una red virtual que se transporta a través de una red subyacente IP. Este bloque de creación permite la multitenencia en una red, lo que le permite compartir una sola red física entre varios inquilinos, a la vez que mantiene el tráfico de red de cada inquilino aislado de los demás inquilinos.

Un inquilino es una comunidad de usuarios (como una unidad de negocio, departamento, grupo de trabajo o aplicación) que contiene grupos de extremos. Los grupos pueden comunicarse con otros grupos en el mismo arrendamiento, y los inquilinos pueden comunicarse con otros inquilinos si las directivas de red lo permiten. Un grupo se expresa normalmente como una subred (VLAN) que puede comunicarse con otros dispositivos de la misma subred y llegar a grupos y puntos de conexión externos mediante una instancia de enrutamiento y reenvío virtual (VRF).

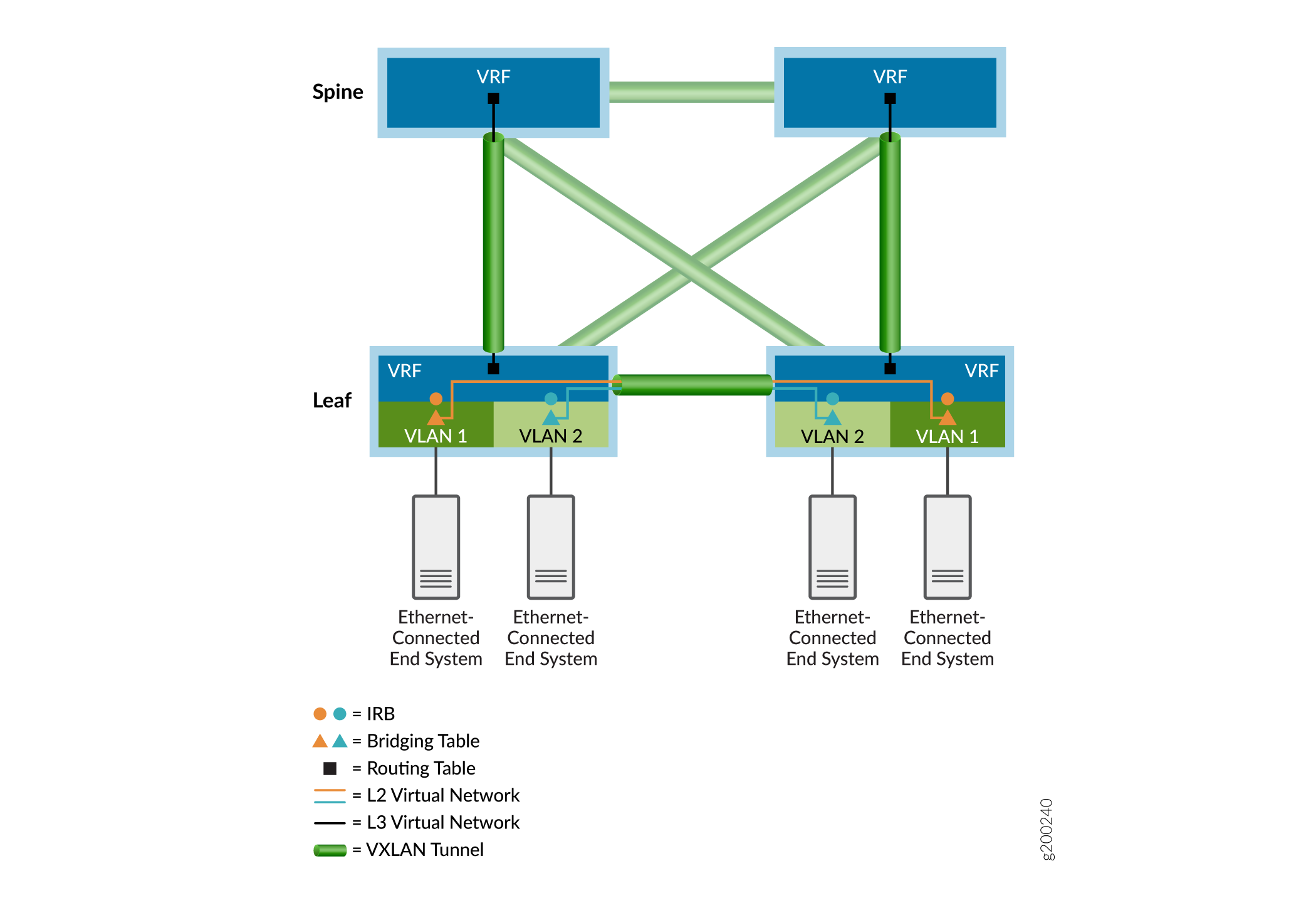

Como se ve en el ejemplo de superposición que se muestra en la figura 3, las tablas de puente Ethernet (representadas por triángulos) manejan tramas de puente de inquilino y las tablas de enrutamiento IP (representadas por cuadrados) procesan paquetes enrutados. El enrutamiento entre VLAN ocurre en las interfaces de enrutamiento y puente integrados (IRB) (representadas por círculos). Las tablas Ethernet e IP se dirigen a redes virtuales (representadas por líneas de colores). Para llegar a los sistemas finales conectados a otros dispositivos de punto de conexión de túnel VXLAN (VTEP), los paquetes de inquilino se encapsulan y se envían a través de un túnel VXLAN con señal EVPN (representado por iconos de túnel verde) a los dispositivos VTEP remotos asociados. Los paquetes tunelizados se desencapsulan en los dispositivos VTEP remotos y se reenvían a los sistemas finales remotos mediante las respectivas tablas de puente o enrutamiento del dispositivo VTEP de salida.

En las secciones siguientes se proporcionan más detalles sobre las redes superpuestas.

- IBGP para superposiciones

- EBGP para superposiciones con subyacentes IPv6

- Superposición con puente

- Superposición de puente enrutado centralmente

- Superposición de puente con enrutamiento de borde

- Superposición de columna colapsada

- Comparación de superposiciones puenteadas, CRB y ERB

- Modelos de direccionamiento IRB en superposiciones de puente

- Superposición enrutada mediante rutas de tipo 5 de EVPN

- Instancias MAC-VRF para multitenencia en superposiciones de virtualización de red

IBGP para superposiciones

El BGP interno (IBGP) es un protocolo de enrutamiento que intercambia información de accesibilidad a través de una red IP. Cuando el IBGP se combina con el BGP multiprotocolo (MP-IBGP), proporciona la base para que EVPN intercambie información de accesibilidad entre dispositivos VTEP. Esta capacidad es necesaria para establecer túneles VXLAN entre VTEP y utilizarlos para superponer servicios de conectividad.

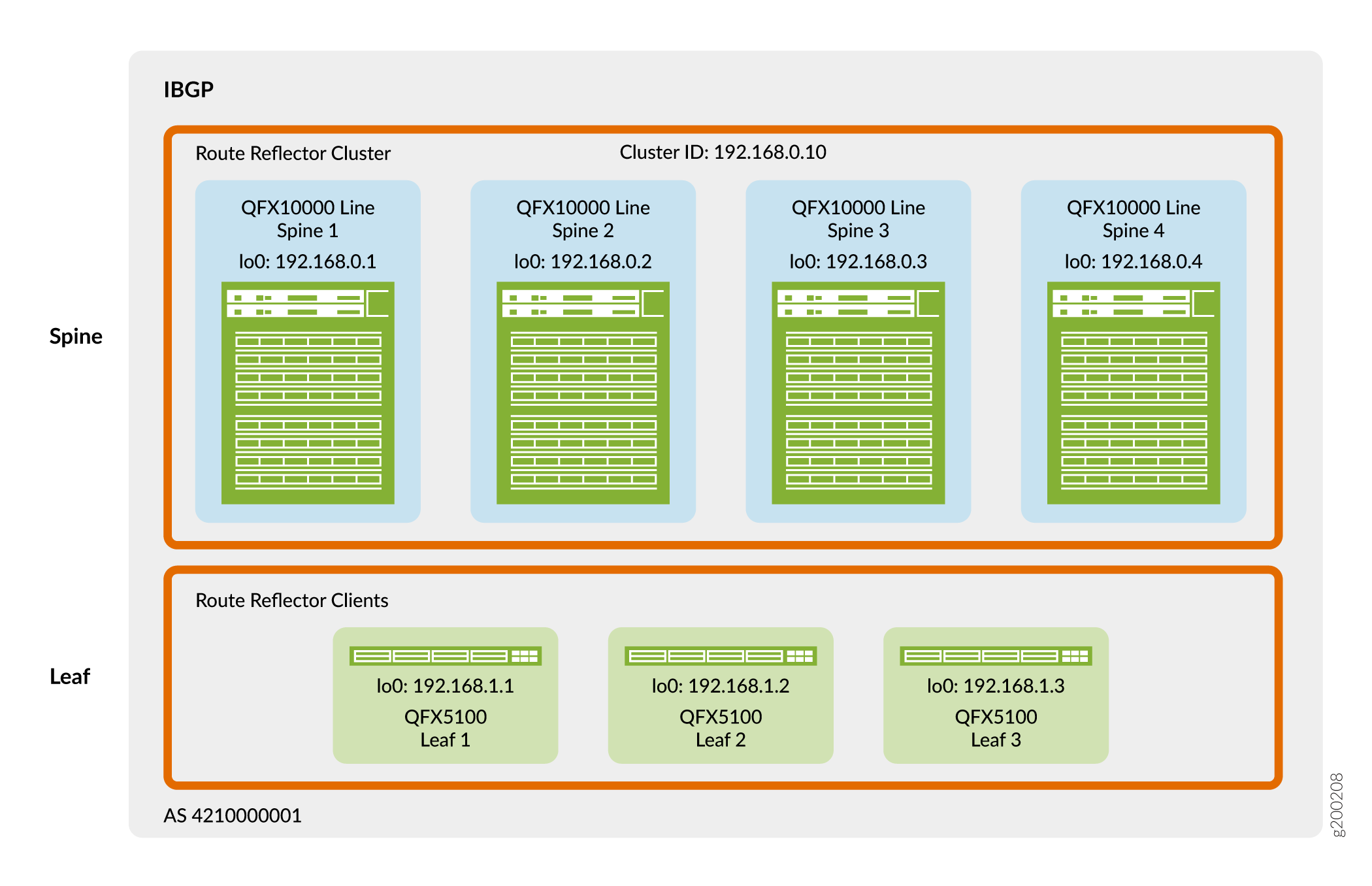

La figura 4 muestra que los dispositivos de spine y leaf usan sus direcciones de circuito cerrado para el emparejamiento en un único sistema autónomo. En este diseño, los dispositivos de columna vertebral actúan como un grupo de reflectores de ruta y los dispositivos de hoja son clientes de reflectores de ruta. Un reflector de ruta satisface el requisito del IBGP de una malla completa sin necesidad de emparejar todos los dispositivos VTEP directamente entre sí. Como resultado, los dispositivos leaf se emparejan solo con los dispositivos spine y los dispositivos spine se emparejan tanto con los dispositivos spine como con los dispositivos leaf. Debido a que los dispositivos de columna vertebral están conectados a todos los dispositivos de hoja, los dispositivos de columna vertebral pueden transmitir información de IBGP entre los vecinos del dispositivo de hoja emparejados indirectamente.

Puede colocar reflectores de ruta en casi cualquier lugar de la red. Sin embargo, debe tener en cuenta lo siguiente:

-

¿El dispositivo seleccionado tiene suficiente memoria y potencia de procesamiento para manejar la carga de trabajo adicional requerida por un reflector de ruta?

-

¿El dispositivo seleccionado es equidistante y accesible desde todos los altavoces EVPN?

-

¿El dispositivo seleccionado tiene las capacidades de software adecuadas?

En este diseño, el grupo reflector de ruta se coloca en la capa de la columna vertebral. Los conmutadores QFX que puede usar como columna vertebral en este diseño de referencia tienen una amplia velocidad de procesamiento para manejar el tráfico del cliente del reflector de ruta en la superposición de virtualización de red.

Para obtener más información sobre la implementación de IBGP en una superposición, consulte Configurar IBGP para la superposición.

EBGP para superposiciones con subyacentes IPv6

Los casos de uso de la arquitectura de referencia original de esta guía ilustran un diseño subyacente de EBGP IPv4 con conectividad de dispositivo de superposición de IBGP IPv4. Consulte Red subyacente de estructura IP e IBGP para obtener información sobre superposiciones. Sin embargo, a medida que los dispositivos de borde de virtualización de red (NVE) comienzan a adoptar VTEP IPv6 para aprovechar el rango de direccionamiento extendido y las capacidades de IPv6, hemos ampliado la compatibilidad con IP Fabric para abarcar IPv6.

A partir de Junos OS versión 21.2R2-S1, en las plataformas compatibles puede utilizar alternativamente una infraestructura de estructura IPv6 con algunos diseños de superposición de arquitectura de referencia. El diseño de la estructura IPv6 comprende direccionamiento de interfaz IPv6, una base de EBGP IPv6 y una superposición de EBGP IPv6 para la conectividad de la carga de trabajo. Con una estructura IPv6, los dispositivos NVE encapsulan el encabezado VXLAN con un encabezado externo IPv6 y tunelizan los paquetes a través de la estructura de extremo a extremo mediante los siguientes saltos IPv6. La carga de trabajo puede ser IPv4 o IPv6.

La mayoría de los elementos que se configuran en los diseños de superposición de arquitectura de referencia admitidos son independientes de si la infraestructura subyacente y de superposición usa IPv4 o IPv6. Los procedimientos de configuración correspondientes para cada uno de los diseños de superposición admitidos señalan cualquier diferencia de configuración si la capa subyacente y la superposición utilizan el diseño de estructura IPv6.

Para obtener más información, consulte las siguientes referencias en esta guía y otros recursos:

Configuración de una estructura IPv6 mediante EBGP para conectividad subyacente y emparejamiento de superposición: Diseño e implementación de redes de superposición y subyacente de estructura IPv6 con EBGP.

Lanzamientos iniciales en los que diferentes plataformas admiten un diseño de estructura IPv6 cuando desempeñan funciones concretas en la estructura: Diseños de referencia de estructura EVPN-VXLAN para centros de datos: resumen de hardware compatible.

Descripción general de la compatibilidad de emparejamiento de superposición y subyacente IPv6 en estructuras EVPN-VXLAN en dispositivos de Juniper Networks: EVPN-VXLAN con una base IPv6.

Superposición con puente

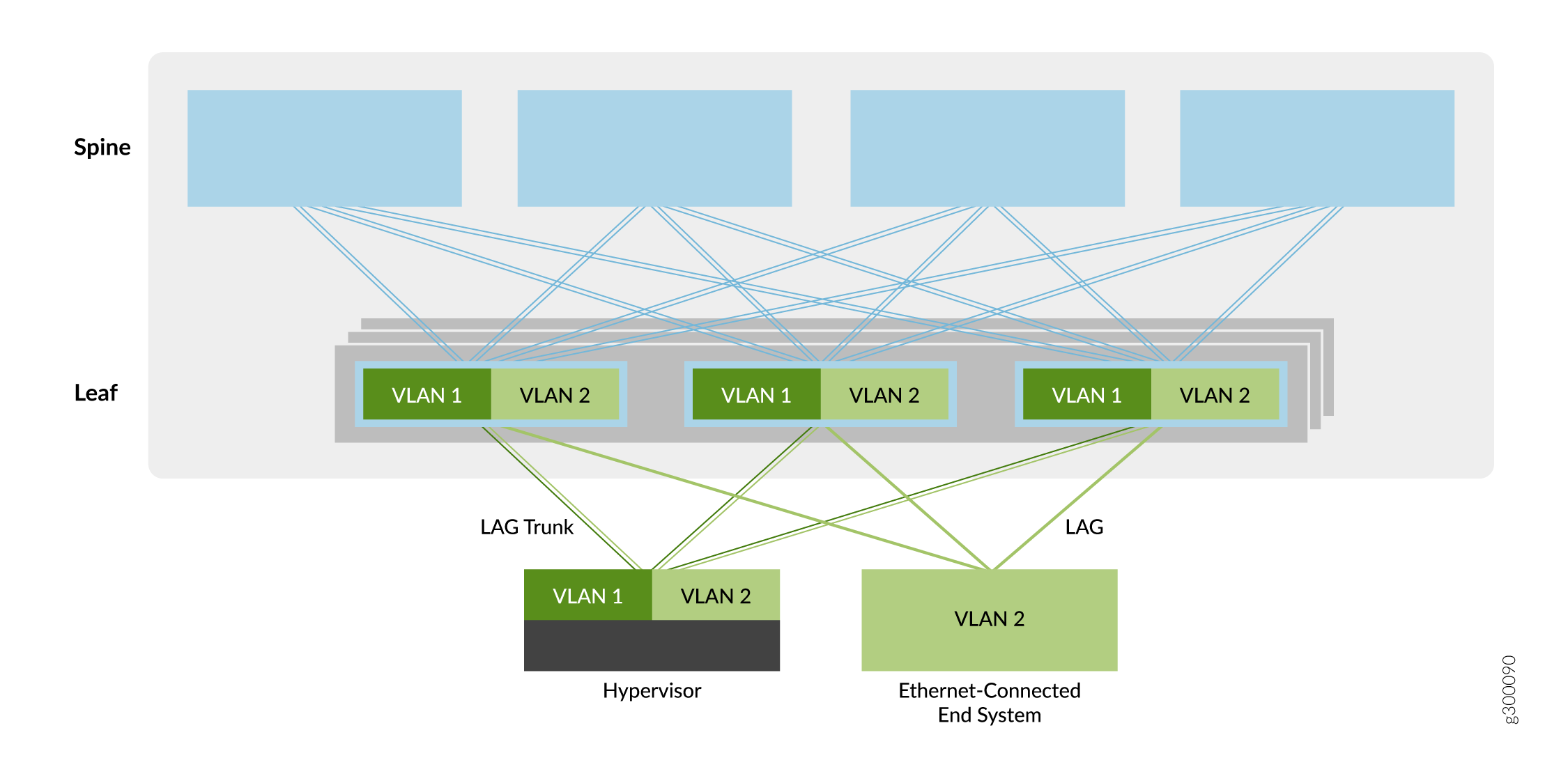

El primer tipo de servicio de superposición descrito en esta guía es una superposición de puente, como se muestra en la figura 5.

de puente

de puente

En este modelo de superposición, las VLAN Ethernet se extienden entre dispositivos leaf a través de túneles VXLAN. Estos túneles VXLAN de hoja a hoja admiten redes de centros de datos que requieren conectividad Ethernet entre dispositivos leaf, pero no necesitan enrutamiento entre las VLAN. Como resultado, los dispositivos spine solo proporcionan conectividad básica subyacente y superpuesta para los dispositivos leaf, y no realizan servicios de enrutamiento o puerta de enlace vistos con otros métodos de superposición.

Los dispositivos leaf originan VTEP para conectarse a los otros dispositivos leaf. Los túneles permiten que los dispositivos leaf envíen tráfico VLAN a otros dispositivos leaf y sistemas finales conectados a Ethernet en el centro de datos. La simplicidad de este servicio de superposición lo hace atractivo para los operadores que necesitan una manera fácil de introducir EVPN/VXLAN en su centro de datos existente basado en Ethernet.

Puede agregar enrutamiento a una superposición de puente implementando un enrutador de la serie MX o un dispositivo de seguridad de la serie SRX externo a la estructura EVPN/VXLAN. De lo contrario, puede seleccionar uno de los otros tipos de superposición que incorporan enrutamiento (como una superposición de puente de enrutamiento de borde, una superposición de puente de enrutamiento central o una superposición de ruta).

Para obtener información sobre la implementación de una superposición puenteada, consulte Diseño e implementación de superposiciones puenteadas.

Superposición de puente enrutado centralmente

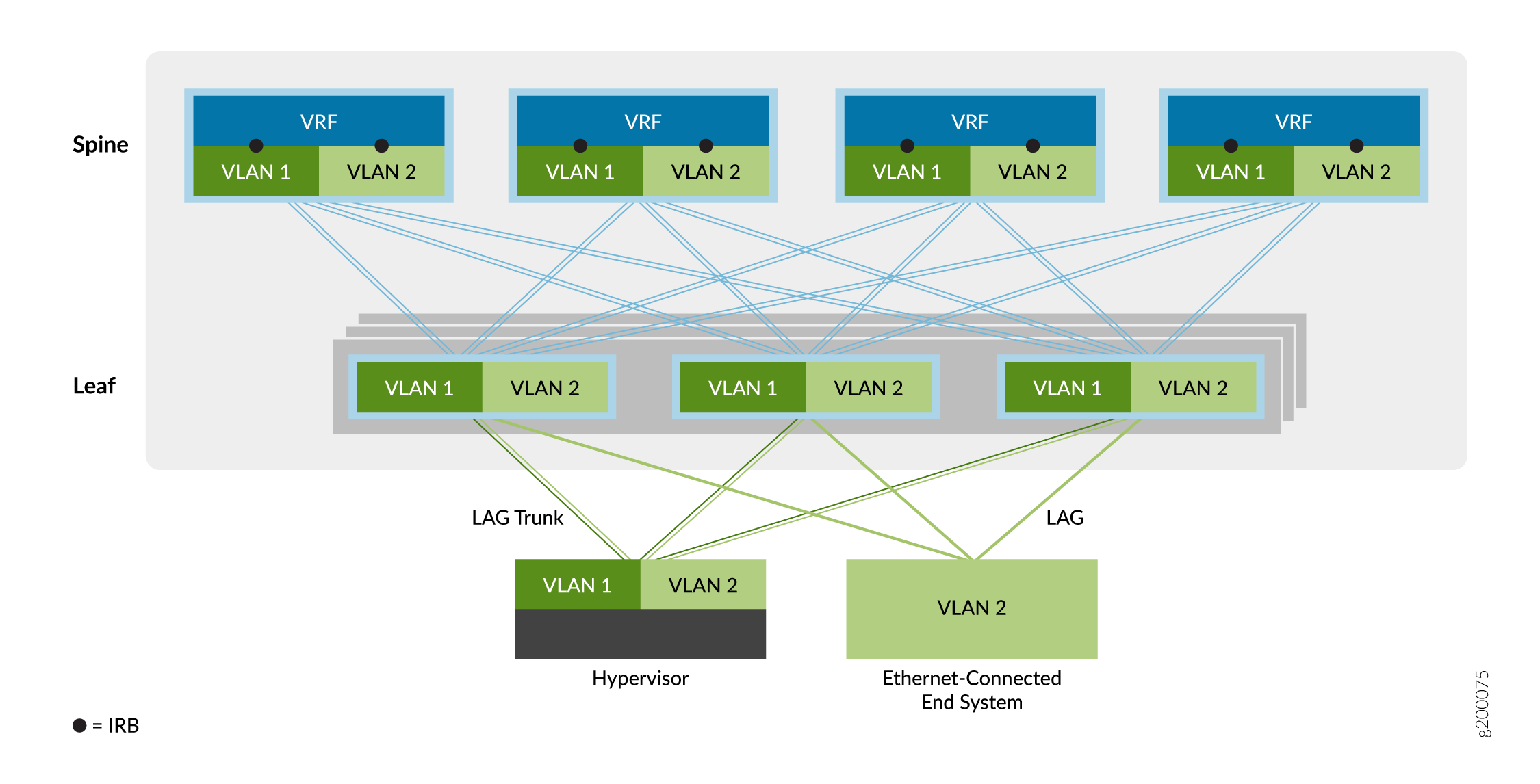

El segundo tipo de servicio de superposición es la superposición de puente de enrutamiento centralizado (CRB), como se muestra en la figura 6.

de puente enrutado centralmente

de puente enrutado centralmente

En una superposición CRB, el enrutamiento se produce en una puerta de enlace central de la red del centro de datos (la capa spine en este ejemplo) en lugar de en el dispositivo VTEP donde están conectados los sistemas finales (la capa leaf en este ejemplo).

Puede usar este modelo de superposición cuando necesite que el tráfico enrutado pase por una puerta de enlace centralizada o cuando sus dispositivos VTEP de borde carezcan de las capacidades de enrutamiento necesarias.

Como se muestra arriba, el tráfico que se origina en los sistemas finales conectados a Ethernet se reenvía a los dispositivos VTEP leaf a través de un tronco (varias VLAN) o un puerto de acceso (VLAN única). El dispositivo VTEP reenvía el tráfico a sistemas finales locales o a un sistema final en un dispositivo VTEP remoto. Una interfaz integrada de enrutamiento y puente (IRB) en cada dispositivo spine ayuda a enrutar el tráfico entre las redes virtuales Ethernet.

El modelo de servicio de superposición de puente compatible con VLAN permite agregar fácilmente una colección de VLAN en la misma red virtual superpuesta. El diseño de EVPN de Juniper Networks admite tres configuraciones de modelo de servicio Ethernet compatible con VLAN en el centro de datos, como se indica a continuación:

-

Default instance VLAN-aware: con esta opción, se implementa una única instancia de conmutación predeterminada que admite un total de 4094 VLAN. Todas las plataformas leaf incluidas en este diseño (Diseños de referencia de estructura EVPN-VXLAN del centro de datos - Resumen de hardware compatible) admiten el estilo de instancia predeterminado de superposición compatible con VLAN.

Para configurar este modelo de servicio, consulte Configuración de una superposición de puente enrutado centralmente compatible con VLAN en la instancia predeterminada.

-

Virtual switch VLAN-aware—Con esta opción, varias instancias de conmutador virtual admiten hasta 4094 VLAN por instancia. Este modelo de servicio Ethernet es ideal para redes superpuestas que requieren escalabilidad más allá de una única instancia predeterminada. La compatibilidad con esta opción está disponible actualmente en la línea de conmutadores QFX10000.

Para implementar este modelo de servicio escalable, consulte Configuración de una superposición de CRB compatible con VLAN con conmutadores virtuales o instancias de MAC-VRF.

-

MAC-VRF instance VLAN-aware—Con esta opción, varias instancias MAC-VRF admiten hasta 4094 VLAN por instancia. Este modelo de servicio Ethernet es ideal para redes superpuestas que requieren escalabilidad más allá de una única instancia predeterminada y en las que desea más opciones para garantizar el aislamiento o la interconexión de VLAN entre diferentes inquilinos en la misma estructura. La compatibilidad con esta opción está disponible en las plataformas compatibles con instancias MAC-VRF (consulte Explorador de características: VRF de MAC con EVPN-VXLAN).

Para implementar este modelo de servicio escalable, consulte Configuración de una superposición de CRB compatible con VLAN con conmutadores virtuales o instancias de MAC-VRF.

Superposición de puente con enrutamiento de borde

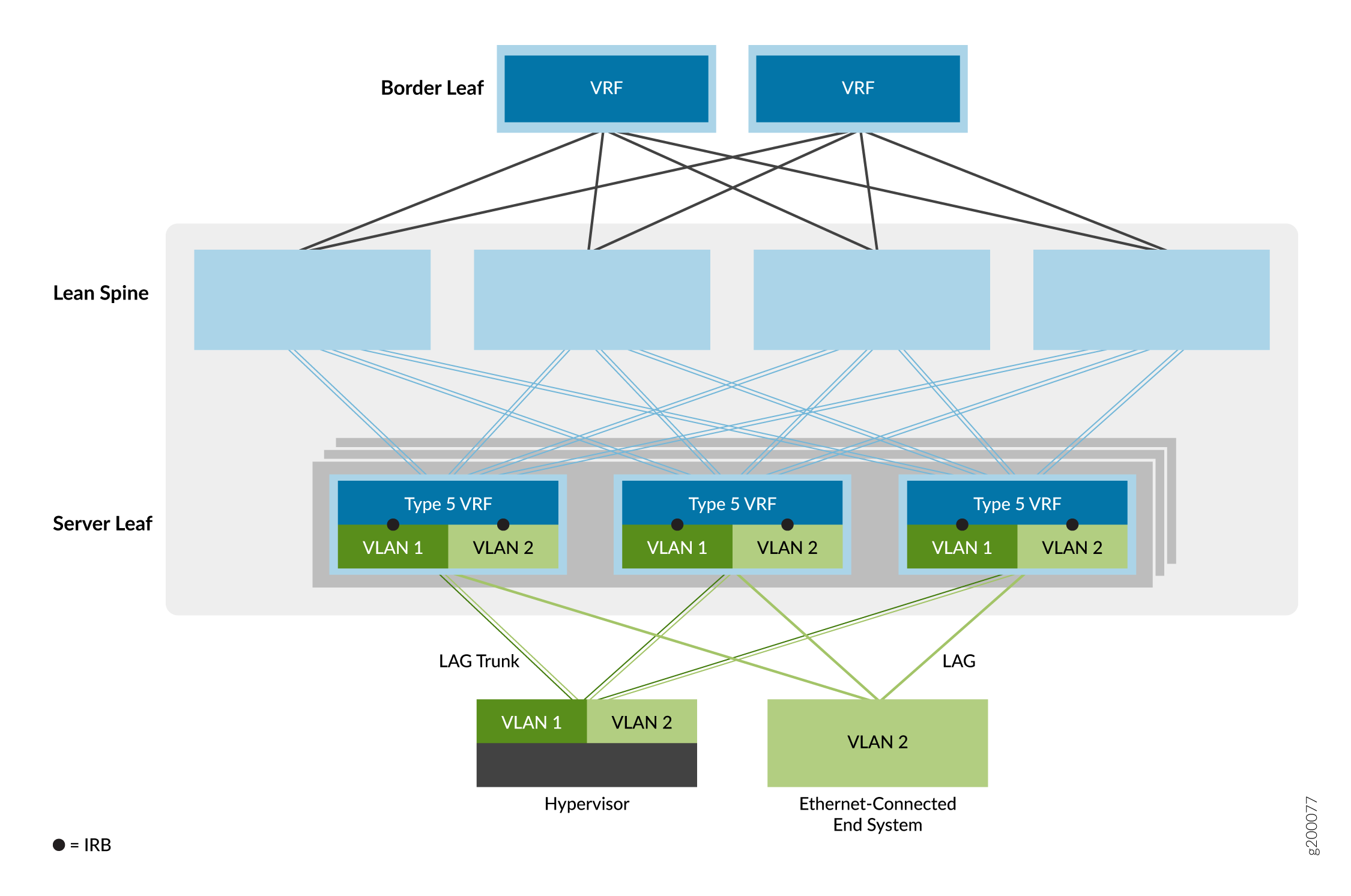

La tercera opción de servicio de superposición es la superposición de puente enrutado en el borde (ERB), como se muestra en la figura 7.

En este modelo de servicio Ethernet, las interfaces IRB se mueven a VTEP de dispositivo leaf en el borde de la red superpuesta para acercar el enrutamiento IP a los sistemas finales. Debido a las capacidades especiales de ASIC necesarias para admitir puentes, enrutamiento y EVPN/VXLAN en un dispositivo, las superposiciones ERB solo son posibles en ciertos conmutadores. Para obtener una lista de los conmutadores que admitimos como dispositivos leaf en una superposición ERB, consulte Diseños de referencia de estructura EVPN-VXLAN para centros de datos: resumen de hardware compatible.

Este modelo permite una red general más simple. Los dispositivos spine están configurados para manejar solo tráfico IP, lo que elimina la necesidad de extender las superposiciones de puente a los dispositivos spine.

Esta opción también permite un tráfico más rápido de servidor a servidor, dentro del centro de datos (también conocido como tráfico este-oeste) donde los sistemas finales están conectados al mismo dispositivo leaf VTEP. Como resultado, el enrutamiento ocurre mucho más cerca de los sistemas finales que con las superposiciones CRB.

Cuando configura interfaces IRB que se incluyen en instancias de enrutamiento EVPN tipo 5 en conmutadores QFX5110 o QFX5120 que funcionan como dispositivos leaf, el dispositivo habilita automáticamente el enrutamiento simétrico entre IRB unidifusión para rutas EVPN tipo 5.

Para obtener información sobre la implementación de la superposición ERB, consulte Diseño e implementación de superposiciones de puente enrutado en bordes.

Superposición de columna colapsada

La red superpuesta en una arquitectura de columna vertebral colapsada es similar a una superposición ERB. En una arquitectura de columna colapsada, las funciones del dispositivo leaf se contraen en los dispositivos spine. Dado que no hay capa de hojas, se configuran las interfaces VTEPS e IRB en los dispositivos spine, que se encuentran en el borde de la red superpuesta, como los dispositivos leaf de un modelo ERB. Los dispositivos spine también pueden realizar funciones de puerta de enlace de borde para enrutar el tráfico de norte a sur o extender el tráfico de capa 2 a través de ubicaciones de centros de datos.

Para obtener una lista de los conmutadores que admitimos con una arquitectura spine colapsada, consulte Diseños de referencia de estructura EVPN-VXLAN de centro de datos: resumen de hardware compatible.

Comparación de superposiciones puenteadas, CRB y ERB

Para ayudarle a decidir qué tipo de superposición es el más adecuado para su entorno EVPN, consulte la Tabla 1.

Admitimos la mezcla de configuraciones de superposición de puente, superposición CRB y superposición ERB en el mismo dispositivo al mismo tiempo en dispositivos que admiten estos tipos de superposición. No es necesario configurar el dispositivo con sistemas lógicos independientes para que el dispositivo funcione en diferentes tipos de superposiciones en paralelo.

| Puntos de comparación |

Superposición ERB |

Superposición CRB |

Superposición con puente |

|---|---|---|---|

| Enrutamiento entre subredes de inquilinos totalmente distribuido |

✓ |

|

|

| Impacto mínimo de la falla de la puerta de enlace IP |

✓ |

|

|

| Enrutamiento dinámico a nodos de terceros a nivel leaf |

✓ |

|

|

| Optimizado para un alto volumen de tráfico este-oeste |

✓ |

|

|

| Mejor integración con estructuras IP sin procesar |

✓ |

|

|

| Virtualización IP VRF más cerca del servidor |

✓ |

|

|

| Se requiere multiconexión de Contrail vRouter |

✓ |

|

|

| Interoperabilidad de EVPN más sencilla con diferentes proveedores |

✓ |

|

|

| Enrutamiento simétrico entre subredes |

✓ |

✓ |

|

| ID de VLAN superpuesto por bastidor |

✓ |

✓ |

✓ |

| Configuración manual y resolución de problemas más sencillas |

|

✓ |

✓ |

| Interfaces de estilo empresarial y de proveedor de servicios |

|

✓ |

✓ |

| Compatibilidad con conmutadores leaf heredados (QFX5100) |

|

✓ |

✓ |

| Control centralizado de optimización del tráfico de máquinas virtuales (VMTO) |

|

✓ |

|

| Puerta de enlace de subred de inquilino IP en el clúster de firewall |

|

|

✓ |

Modelos de direccionamiento IRB en superposiciones de puente

La configuración de interfaces IRB en superposiciones CRB y ERB requiere una comprensión de los modelos para la configuración predeterminada de direcciones IP y MAC de puerta de enlace de las interfaces IRB de la siguiente manera:

Unique IRB IP Address—En este modelo, se configura una dirección IP única en cada interfaz IRB en una subred superpuesta.

El beneficio de tener una dirección IP y una dirección MAC únicas en cada interfaz IRB es la capacidad de monitorear y llegar a cada una de las interfaces IRB desde dentro de la superposición utilizando su dirección IP única. Este modelo también le permite configurar un protocolo de enrutamiento en la interfaz IRB.

La desventaja de este modelo es que la asignación de una dirección IP única a cada interfaz IRB puede consumir muchas direcciones IP de una subred.

Unique IRB IP Address with Virtual Gateway IP Address: este modelo agrega una dirección IP de puerta de enlace virtual al modelo anterior y se recomienda para superposiciones de puente enrutadas centralmente. Es similar al VRRP, pero sin la señalización del plano de datos en banda entre las interfaces IRB de la puerta de enlace. La puerta de enlace virtual debe ser la misma para todas las interfaces IRB de puerta de enlace predeterminadas en la subred superpuesta y está activa en todas las interfaces IRB de puerta de enlace donde esté configurada. También debe configurar una dirección MAC IPv4 común para la puerta de enlace virtual, que se convierte en la dirección MAC de origen en los paquetes de datos reenviados a través de la interfaz IRB.

Además de las ventajas del modelo anterior, la puerta de enlace virtual simplifica la configuración predeterminada de la puerta de enlace en los sistemas finales. La desventaja de este modelo es la misma que el modelo anterior.

IRB with Anycast IP Address and MAC Address—En este modelo, todas las interfaces IRB de puerta de enlace predeterminadas en una subred superpuesta están configuradas con la misma dirección IP y MAC. Recomendamos este modelo para superposiciones ERB.

Una ventaja de este modelo es que solo se requiere una única dirección IP por subred para el direccionamiento de interfaz IRB de puerta de enlace predeterminada, lo que simplifica la configuración predeterminada de la puerta de enlace en los sistemas finales.

Superposición enrutada mediante rutas de tipo 5 de EVPN

La última opción de superposición es una superposición enrutada, como se muestra en la figura 8.

enrutada

enrutada

Esta opción es un servicio de red virtual enrutado IP. A diferencia de una VPN IP basada en MPLS, la red virtual en este modelo se basa en EVPN/VXLAN.

Los proveedores de nube prefieren esta opción de red virtual porque la mayoría de las aplicaciones modernas están optimizadas para IP. Dado que toda la comunicación entre dispositivos tiene lugar en la capa IP, no es necesario utilizar ningún componente de puente Ethernet, como VLAN y ESI, en este modelo de superposición enrutada.

Para obtener información sobre la implementación de una superposición enrutada, consulte Diseño e implementación de superposiciones enrutadas.

Instancias MAC-VRF para multitenencia en superposiciones de virtualización de red

Las instancias de enrutamiento MAC-VRF permiten configurar varias instancias de EVPN con distintos tipos de servicio Ethernet en un dispositivo que actúa como VTEP en una estructura EVPN-VXLAN. Con las instancias de MAC-VRF, puede administrar varios inquilinos en el centro de datos con tablas VRF específicas del cliente para aislar o agrupar las cargas de trabajo de los inquilinos.

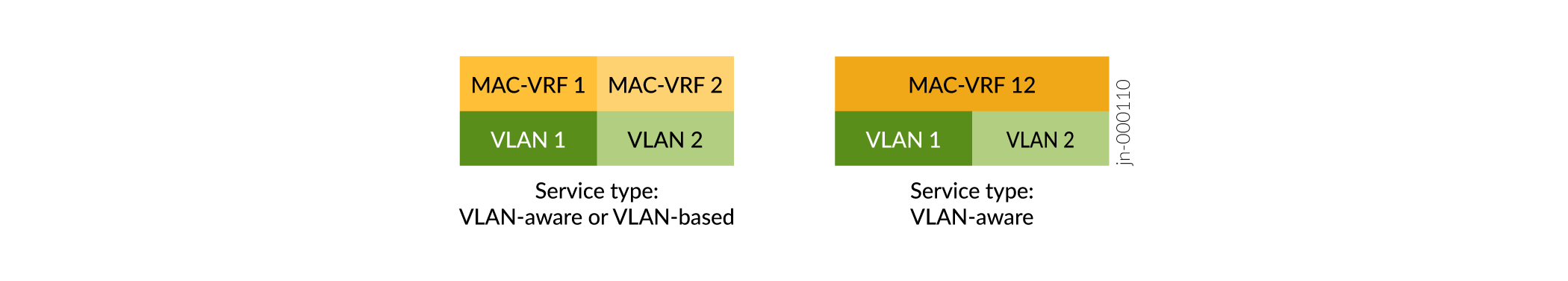

Las instancias de MAC-VRF también admiten el tipo de servicio basado en VLAN, además de la compatibilidad anterior con el tipo de servicio compatible con VLAN. Consulte la figura 9.

de servicio MAC-VRF

de servicio MAC-VRF

-

Servicio basado en VLAN: puede configurar una VLAN y el identificador de red VXLAN correspondiente (VNI) en la instancia de MAC-VRF. Para aprovisionar una VLAN y VNI nuevas, debe configurar una nueva instancia de VRF de MAC con la nueva VLAN y VNI.

-

Servicio compatible con VLAN: puede configurar una o más VLAN y las VNI correspondientes en la misma instancia de MAC-VRF. Para aprovisionar una VLAN y VNI nuevas, puede agregar la nueva configuración de VLAN y VNI a la instancia de MAC-VRF existente, lo que ahorra algunos pasos de configuración en comparación con el uso de un servicio basado en VLAN.

Las instancias MAC-VRF permiten opciones de configuración más flexibles tanto en la capa 2 como en la capa 3. Por ejemplo:

MAC-VRF

MAC-VRF

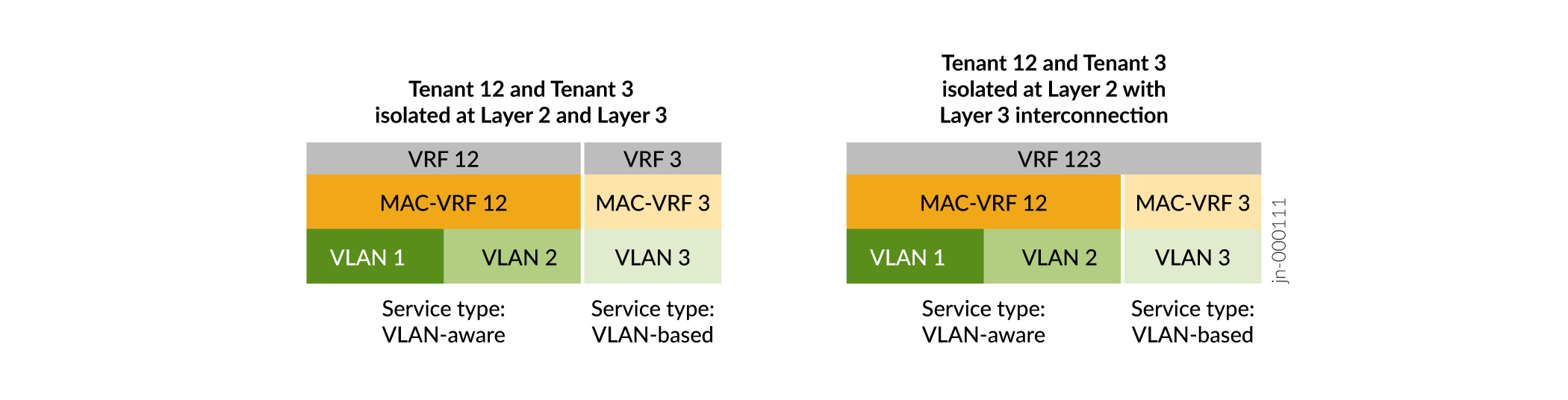

La figura 10 muestra que con las instancias de MAC-VRF:

-

Puede configurar diferentes tipos de servicio en diferentes instancias de MAC-VRF en el mismo dispositivo.

-

Tiene opciones flexibles de aislamiento de inquilinos en la capa 2 (instancias MAC-VRF) y en la capa 3 (instancias VRF). Puede configurar una instancia de VRF que corresponda a la VLAN o VLAN en una sola instancia de MAC-VRF. También puede configurar una instancia de VRF que abarque las VLAN en varias instancias de MAC-VRF.

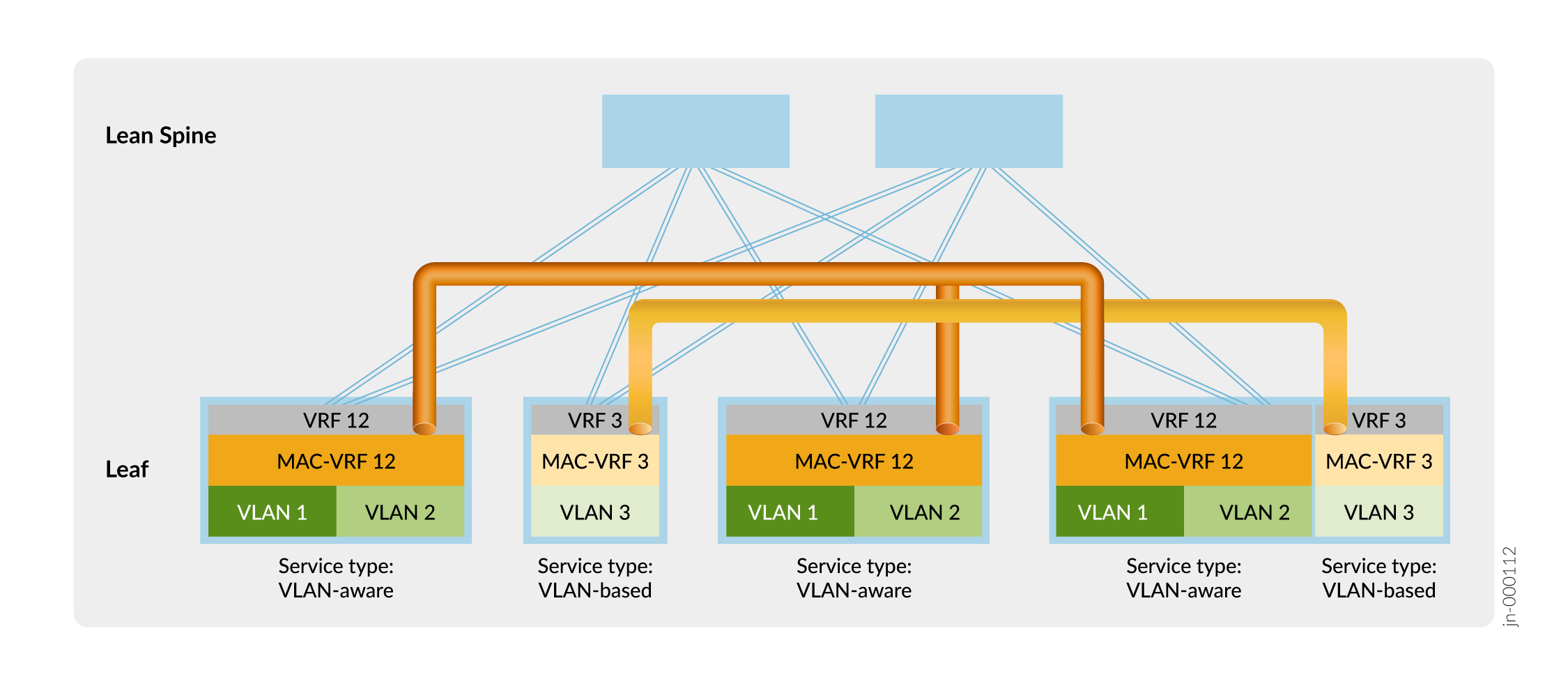

La figura 11 muestra una estructura superpuesta ERB con una configuración MAC-VRF de ejemplo para la separación de inquilinos.

de inquilinos

de inquilinos

En la figura 11, los dispositivos leaf establecen túneles VXLAN que mantienen el aislamiento en la capa 2 entre el inquilino 12 (VLAN 1 y VLAN 2) y el inquilino 3 (VLAN 3) mediante instancias MAC-VRF MAC-VRF 12 y MAC-VRF 3. Los dispositivos leaf también aíslan a los inquilinos en la capa 3 mediante las instancias VRF VRF 12 y VRF 3.

Puede emplear otras opciones para compartir el tráfico de VLAN entre inquilinos aislados en las configuraciones de MAC-VRF y VRF en las capas 2 y 3, como:

-

Establezca una interconexión externa segura entre VRF de inquilino a través de un firewall.

-

Configure la fuga de ruta local entre VRF de capa 3.

Para obtener más información acerca de las instancias de MAC-VRF y su uso en un caso de uso de cliente de ejemplo, consulte Servicios L2 de MAC-VRF de estructura IP de DC EVPN-VXLAN.

Las instancias MAC-VRF corresponden a las instancias de reenvío de la siguiente manera:

-

Las instancias de MAC-VRF en conmutadores de la línea QFX5000 (incluidas las que ejecutan Junos OS o Junos OS Evolved) forman parte de la instancia de reenvío predeterminada. En estos dispositivos, no puede configurar VLAN superpuestas en una instancia de MAC-VRF o en varias instancias de MAC-VRF.

-

En la línea QFX10000 de conmutadores, puede configurar varias instancias de reenvío y asignar una instancia de MAC-VRF a una instancia de reenvío determinada. También puede asignar varias instancias de MAC-VRF a la misma instancia de reenvío. Si configura cada instancia de MAC-VRF para utilizar una instancia de reenvío diferente, puede configurar VLAN superpuestas en varias instancias de MAC-VRF. No puede configurar VLAN superpuestas en una sola instancia de MAC-VRF ni en instancias de MAC-VRF que se asignen a la misma instancia de reenvío.

-

En la configuración predeterminada, los conmutadores incluyen una VLAN predeterminada con ID de VLAN=1 asociada a la instancia de reenvío predeterminada. Dado que los ID de VLAN deben ser únicos en una instancia de reenvío, si desea configurar una VLAN con ID de VLAN=1 en una instancia de MAC-VRF que utilice la instancia de reenvío predeterminada, debe reasignar el ID de VLAN de la VLAN predeterminada a un valor distinto de 1. Por ejemplo:

set vlans default vlan-id 4094 set routing-instances mac-vrf-instance-name vlans vlan-name vlan-id 1

Los ejemplos de configuración de superposición de virtualización de red de referencia de esta guía incluyen pasos para configurar la superposición mediante instancias de MAC-VRF. Configure una instancia de enrutamiento EVPN del tipo mac-vrf, y establezca un diferenciador de ruta y un destino de ruta en la instancia. También debe incluir las interfaces deseadas (incluida una interfaz de origen VTEP), VLAN y asignaciones de VLAN a VNI en la instancia. Consulte las configuraciones de referencia en los siguientes temas:

-

Diseño e implementación de superposiciones en puente: las instancias de MAC-VRF se configuran en los dispositivos leaf.

-

Diseño e implementación de superposiciones de puente enrutadas centralmente: las instancias de MAC-VRF se configuran en los dispositivos spine. En los dispositivos leaf, la configuración MAC-VRF es similar a la configuración de leaf MAC-VRF en un diseño de superposición puenteado.

-

Diseño e implementación de superposiciones de puentes enrutados en el borde: las instancias de MAC-VRF se configuran en los dispositivos leaf.

Un dispositivo puede tener problemas con el escalado de VTEP cuando la configuración utiliza varias instancias de MAC-VRF. Como resultado, para evitar este problema, es necesario habilitar la función de túneles compartidos en la línea QFX5000 de conmutadores que ejecutan Junos OS con una configuración de instancia de MAC-VRF. Cuando se configuran túneles compartidos, el dispositivo minimiza el número de entradas del próximo salto para llegar a los VTEP remotos. Los túneles VXLAN compartidos se habilitan globalmente en el dispositivo mediante la shared-tunnels instrucción en el nivel de [edit forwarding-options evpn-vxlan] jerarquía. Esta configuración requiere que reinicie el dispositivo.

Esta instrucción es opcional en la línea QFX10000 de conmutadores que ejecutan Junos OS, que pueden manejar un mayor escalado de VTEP que los conmutadores QFX5000.

En los dispositivos que ejecutan Junos OS evolucionado en estructuras EVPN-VXLAN, los túneles compartidos están habilitados de forma predeterminada. Junos OS Evolved solo admite EVPN-VXLAN con configuraciones MAC-VRF.

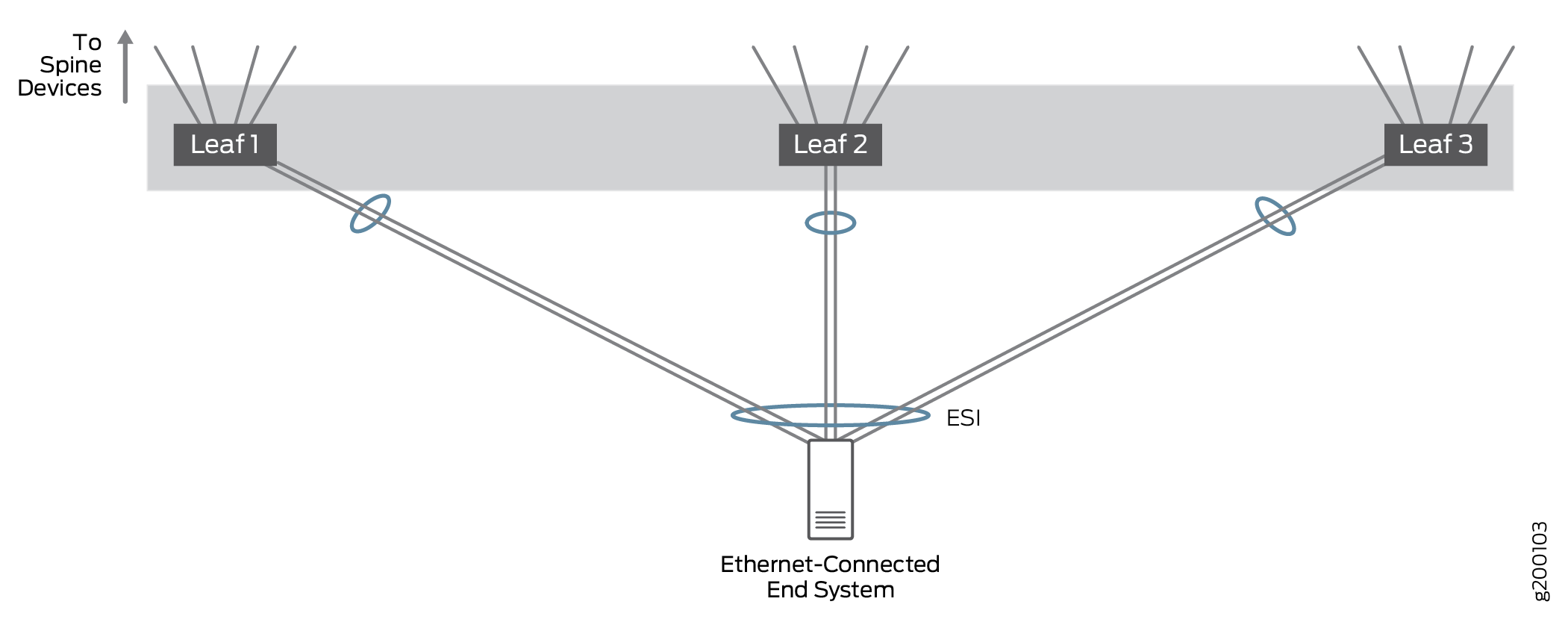

Compatibilidad con multiconexión para sistemas finales conectados a Ethernet

sistemas finales conectados a Ethernet

sistemas finales conectados a Ethernet

La multiconexión conectada a Ethernet permite que los sistemas finales conectados a Ethernet se conecten a la red superpuesta Ethernet a través de un enlace de base única a un dispositivo VTEP o a través de múltiples enlaces multihost a diferentes dispositivos VTEP. El tráfico Ethernet tiene un equilibrio de carga en toda la estructura entre VTEP en dispositivos leaf que se conectan al mismo sistema final.

Probamos configuraciones en las que un sistema final conectado a Ethernet estaba conectado a un dispositivo de una sola hoja o multihost a dispositivos de 2 o 3 hojas para demostrar que el tráfico se maneja correctamente en configuraciones de multiconexión con más de dos dispositivos VTEP de hoja; en la práctica, un sistema final conectado a Ethernet puede ser multihost a una gran cantidad de dispositivos VTEP leaf. Todos los vínculos están activos y el tráfico de red se puede equilibrar en todos los vínculos multiconexión.

En esta arquitectura, EVPN se utiliza para la multiconexión conectada a Ethernet. Los LAG multiconexión de EVPN se identifican mediante un identificador de segmento Ethernet (ESI) en la superposición de puente de EVPN, mientras que LACP se usa para mejorar la disponibilidad del LAG.

El enlace troncal de VLAN permite que una interfaz admita varias VLAN. El enlace troncal de VLAN garantiza que las máquinas virtuales (VM) en hipervisores que no sean superpuestos puedan funcionar en cualquier contexto de red superpuesta.

Para obtener más información acerca de la compatibilidad con multihoming conectado a Ethernet, consulte Diseño e implementación de multiconexión de un sistema final conectado a Ethernet.

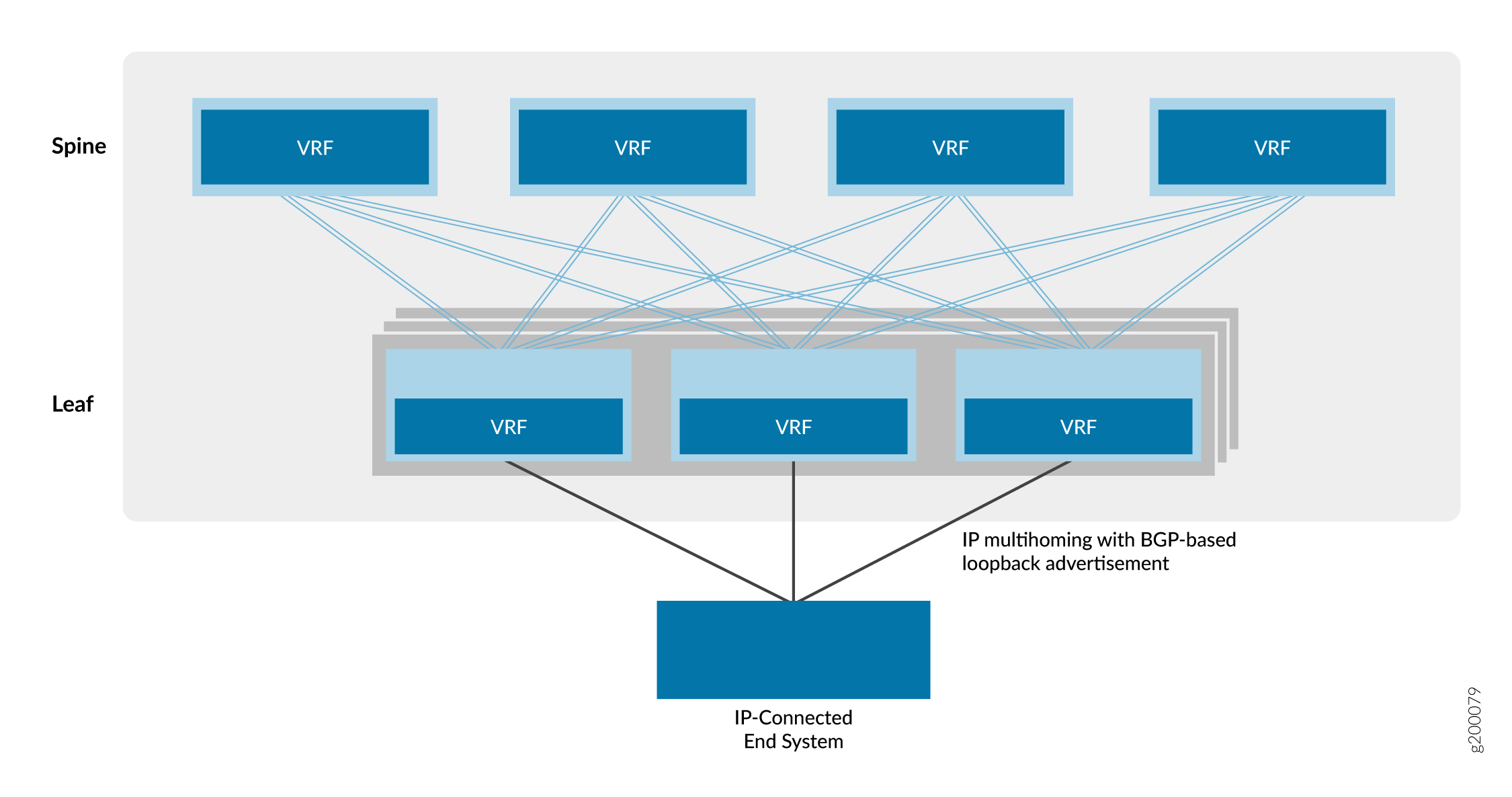

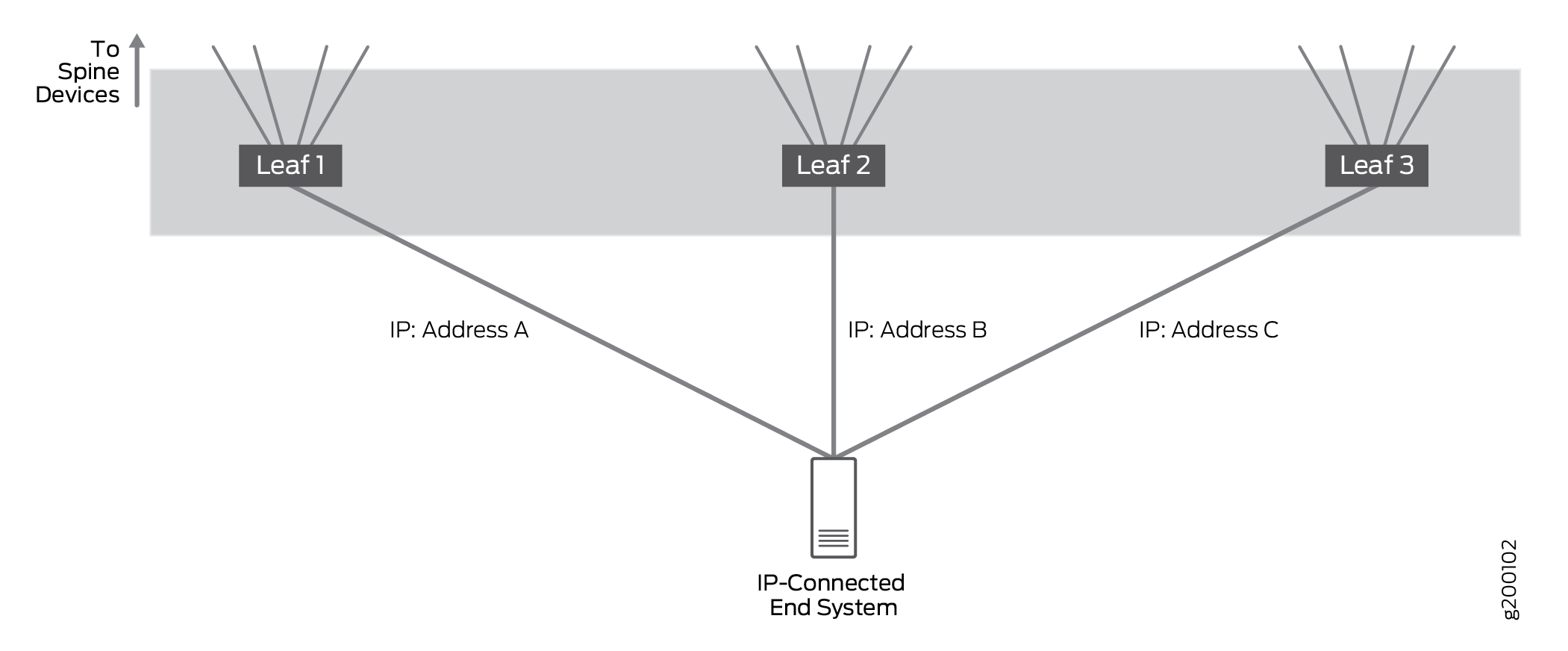

Compatibilidad con multiconexión para sistemas finales conectados a IP

IP

IP

Sistemas de terminales multiconexión conectados a IP para conectarse a la red IP a través de múltiples interfaces de acceso basadas en IP en diferentes dispositivos leaf.

Probamos configuraciones en las que un sistema final conectado a IP estaba conectado a una sola hoja o multihost a dispositivos de 2 o 3 hojas. La configuración validó que el tráfico se maneja correctamente cuando se multiconexión a múltiples dispositivos leaf; en la práctica, un sistema final conectado a IP puede ser multihost a una gran cantidad de dispositivos leaf.

En las configuraciones de host múltiple, todos los vínculos están activos y el tráfico de red se reenvía y recibe a través de todos los vínculos de host múltiple. El tráfico IP tiene un equilibrio de carga a través de los enlaces multihost mediante un algoritmo hash simple.

EBGP se utiliza para intercambiar información de enrutamiento entre el sistema de punto final conectado a IP y los dispositivos leaf conectados para garantizar que la ruta o rutas a los sistemas de punto final se compartan con todos los dispositivos de spine y leaf.

Para obtener más información acerca del bloque de creación de multiconexión conectada a IP, consulte Diseño e implementación de multiconexión de un sistema final conectado a IP.

Dispositivos de borde

Algunos de nuestros diseños de referencia incluyen dispositivos de borde que proporcionan conexiones a los siguientes dispositivos, que son externos a la estructura IP local:

Una puerta de enlace de multidifusión.

Una puerta de enlace de centro de datos para la interconexión del centro de datos (DCI).

Un dispositivo, como un enrutador SRX, en el que se consolidan varios servicios, como firewalls, traducción de direcciones de red (NAT), detección y prevención de intrusiones (IDP), multidifusión, etc. La consolidación de múltiples servicios en un dispositivo físico se conoce como encadenamiento de servicios.

Dispositivos o servidores que actúan como firewalls, servidores DHCP, recopiladores sFlow, etc.

Nota:Si su red incluye dispositivos o servidores heredados que requieren una conexión Ethernet de 1 Gbps a un dispositivo de borde, le recomendamos que utilice un conmutador QFX10008 o QFX5120 como dispositivo de borde.

Para proporcionar la funcionalidad adicional descrita anteriormente, Juniper Networks admite el despliegue de un dispositivo de borde de las siguientes maneras:

Como un dispositivo que sirve solo como dispositivo de borde. En este rol dedicado, puede configurar el dispositivo para manejar una o más de las tareas descritas anteriormente. Para esta situación, el dispositivo se implementa normalmente como una hoja de borde, que está conectada a un dispositivo de spine.

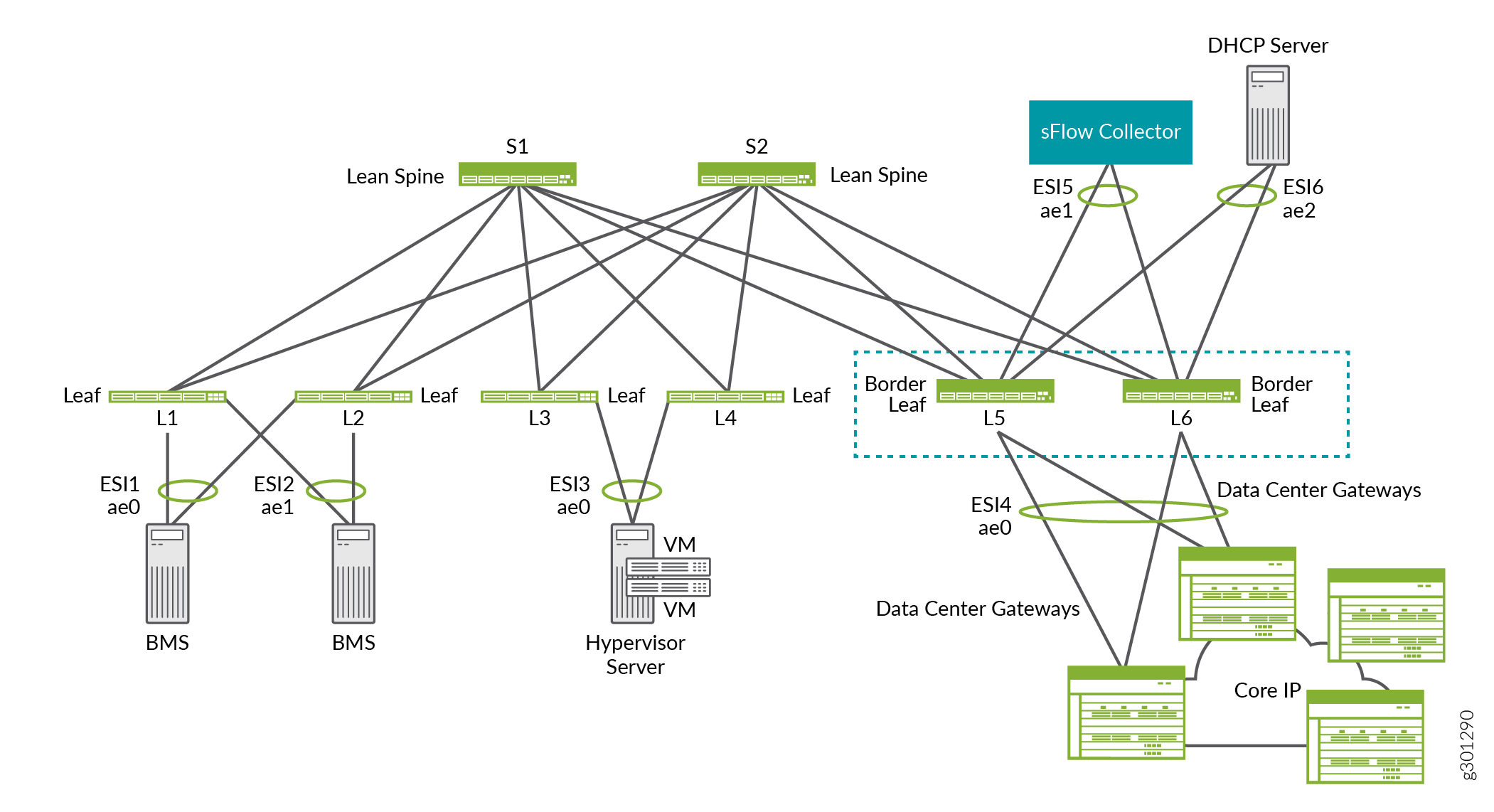

Por ejemplo, en la superposición ERB que se muestra en la figura 14, las hojas de borde L5 y L6 proporcionan conectividad a las puertas de enlace del centro de datos para DCI, un recopilador sFlow y un servidor DHCP.

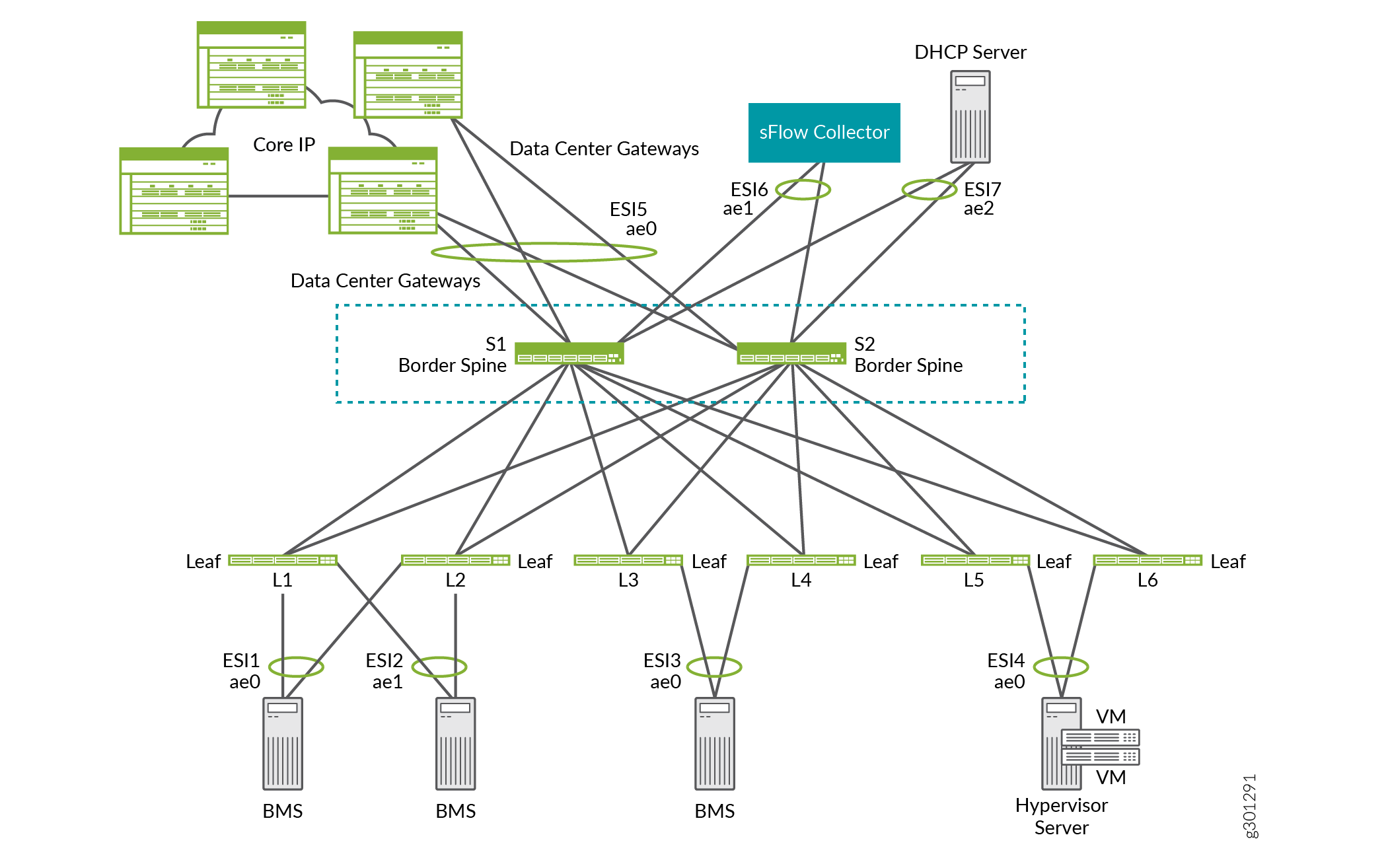

Como un dispositivo que tiene dos funciones: un dispositivo subyacente de red y un dispositivo de borde que puede manejar una o más de las tareas descritas anteriormente. Para esta situación, un dispositivo de columna vertebral generalmente maneja los dos roles. Por lo tanto, la funcionalidad del dispositivo de borde se conoce como columna vertebral de borde.

Por ejemplo, en la superposición ERB que se muestra en la Figura 15, las espinas de borde S1 y S2 funcionan como dispositivos de columna delgada. También proporcionan conectividad a puertas de enlace del centro de datos para DCI, un recopilador sFlow y un servidor DHCP.

borde

borde

de borde

de borde

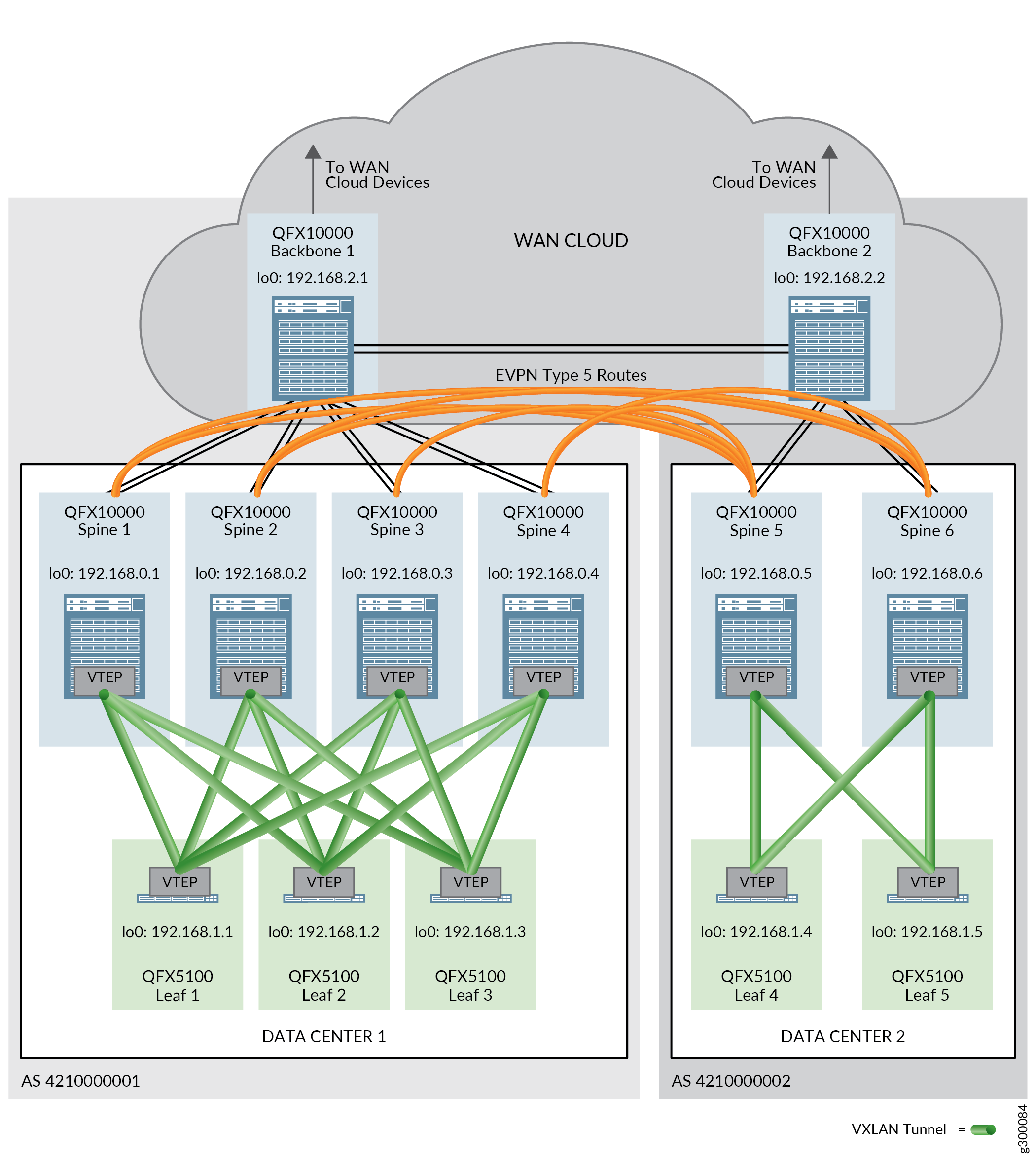

Interconexión del centro de datos (DCI)

El bloque de construcción de interconexión del centro de datos (DCI) proporciona la tecnología necesaria para enviar tráfico entre centros de datos. El diseño validado admite DCI mediante rutas EVPN tipo 5, rutas IPVPN y DCI de capa 2 con unión VXLAN.

Las rutas EVPN tipo 5 o IPVPN se utilizan en un contexto DCI para garantizar que se pueda intercambiar el tráfico entre centros de datos entre centros de datos que utilizan diferentes esquemas de subredes de direcciones IP. Las rutas se intercambian entre dispositivos spine en diferentes centros de datos para permitir el paso de tráfico entre centros de datos.

Se requiere conectividad física entre los centros de datos para poder configurar DCI. La conectividad física la proporcionan los dispositivos troncales en una nube WAN. Un dispositivo troncal está conectado a todos los dispositivos spine en un solo centro de datos (POD), así como a los otros dispositivos troncales que están conectados a los otros centros de datos.

Para obtener información acerca de cómo configurar DCI, consulte:

Encadenamiento de servicios

En muchas redes, es común que el tráfico fluya a través de dispositivos de hardware independientes que proporcionan un servicio, como firewalls, NAT, IDP, multidifusión, etc. Cada dispositivo requiere una operación y administración independientes. Este método de vincular múltiples funciones de red puede considerarse como un encadenamiento de servicios físicos.

Un modelo más eficiente para el encadenamiento de servicios es virtualizar y consolidar las funciones de red en un solo dispositivo. En nuestra arquitectura de plano, estamos utilizando los enrutadores de la serie SRX como el dispositivo que consolida las funciones y los procesos de red y aplica servicios. Ese dispositivo se denomina función de red física (PNF, por sus siglas en inglés).

En esta solución, el encadenamiento de servicios se admite tanto en la superposición de CRB como en la superposición de ERB. Solo funciona para el tráfico entre inquilinos.

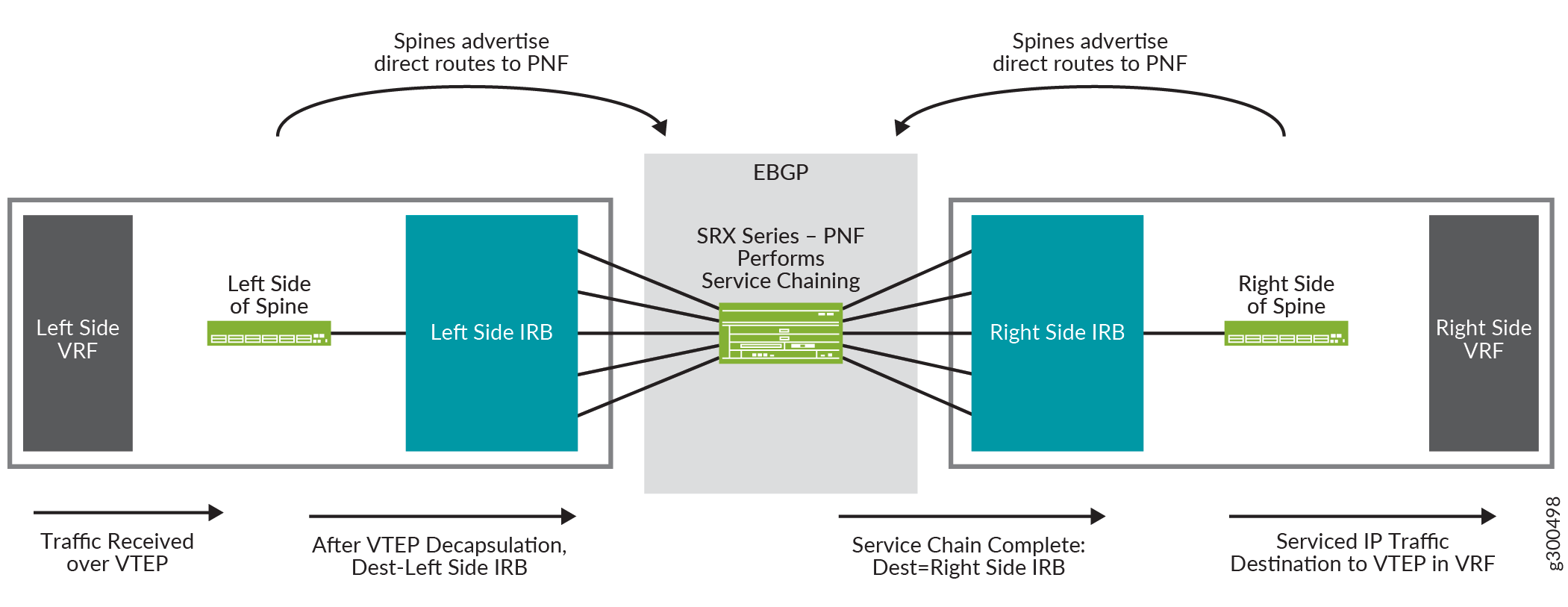

Vista lógica del encadenamiento de servicios

La figura 17 muestra una vista lógica del encadenamiento de servicios. Muestra una columna vertebral con una configuración del lado derecho y una configuración del lado izquierdo. A cada lado hay una instancia de enrutamiento VRF y una interfaz IRB. El enrutador de la serie SRX en el centro es el PNF y realiza el encadenamiento de servicios.

lógica de encadenamiento de servicios

lógica de encadenamiento de servicios

El flujo de tráfico en esta vista lógica es:

-

La columna vertebral recibe un paquete en el VTEP que se encuentra en el VRF del lado izquierdo.

-

El paquete se desencapsula y se envía a la interfaz IRB del lado izquierdo.

-

La interfaz IRB enruta el paquete al enrutador de la serie SRX, que actúa como PNF.

-

El enrutador de la serie SRX realiza el encadenamiento de servicios en el paquete y reenvía el paquete de vuelta a la columna vertebral, donde se recibe en la interfaz IRB que se muestra en el lado derecho de la columna vertebral.

-

La interfaz IRB enruta el paquete al VTEP en el VRF del lado derecho.

Para obtener información acerca de cómo configurar el encadenamiento de servicios, vea Diseño e implementación de encadenamiento de servicios.

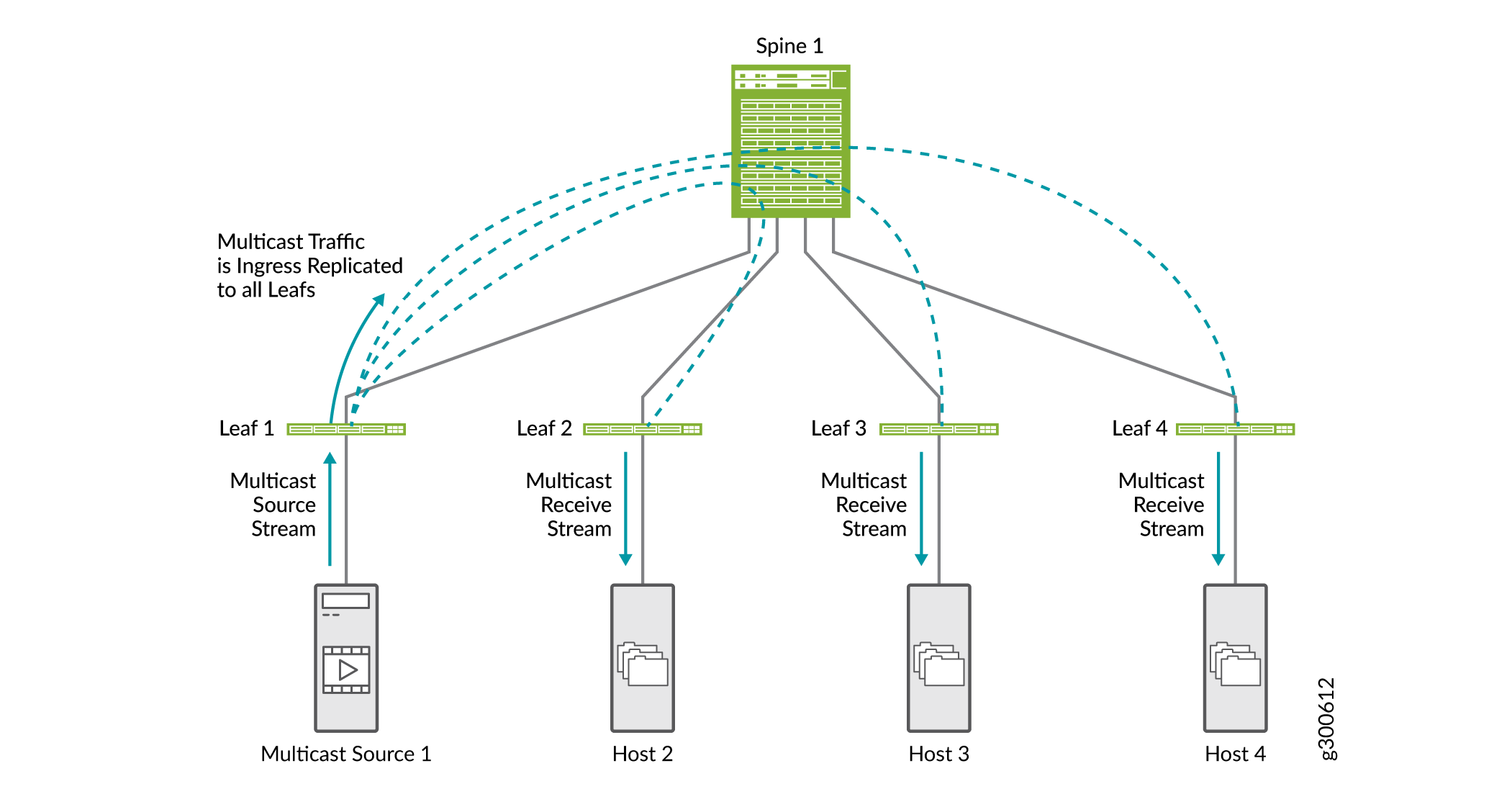

Optimizaciones de multidifusión

Las optimizaciones de multidifusión ayudan a conservar el ancho de banda y enrutar el tráfico de manera más eficiente en un escenario de multidifusión en entornos EVPN VXLAN. Sin ninguna optimización de multidifusión configurada, toda la replicación de multidifusión se realiza en la entrada de la hoja conectada a la fuente de multidifusión, como se muestra en la figura 18. El tráfico de multidifusión se envía a todos los dispositivos leaf que están conectados a la columna vertebral. Cada dispositivo leaf envía tráfico a los hosts conectados.

Existen algunos tipos de optimizaciones de multidifusión admitidas en entornos EVPN VXLAN que pueden funcionar juntas:

Para obtener información acerca de la configuración de entidades de multidifusión, consulte:

- Espionaje IGMP

- Reenvío selectivo de multidifusión

- Replicación asistida del tráfico de multidifusión

- Multidifusión de intersubred optimizada para redes superpuestas ERB

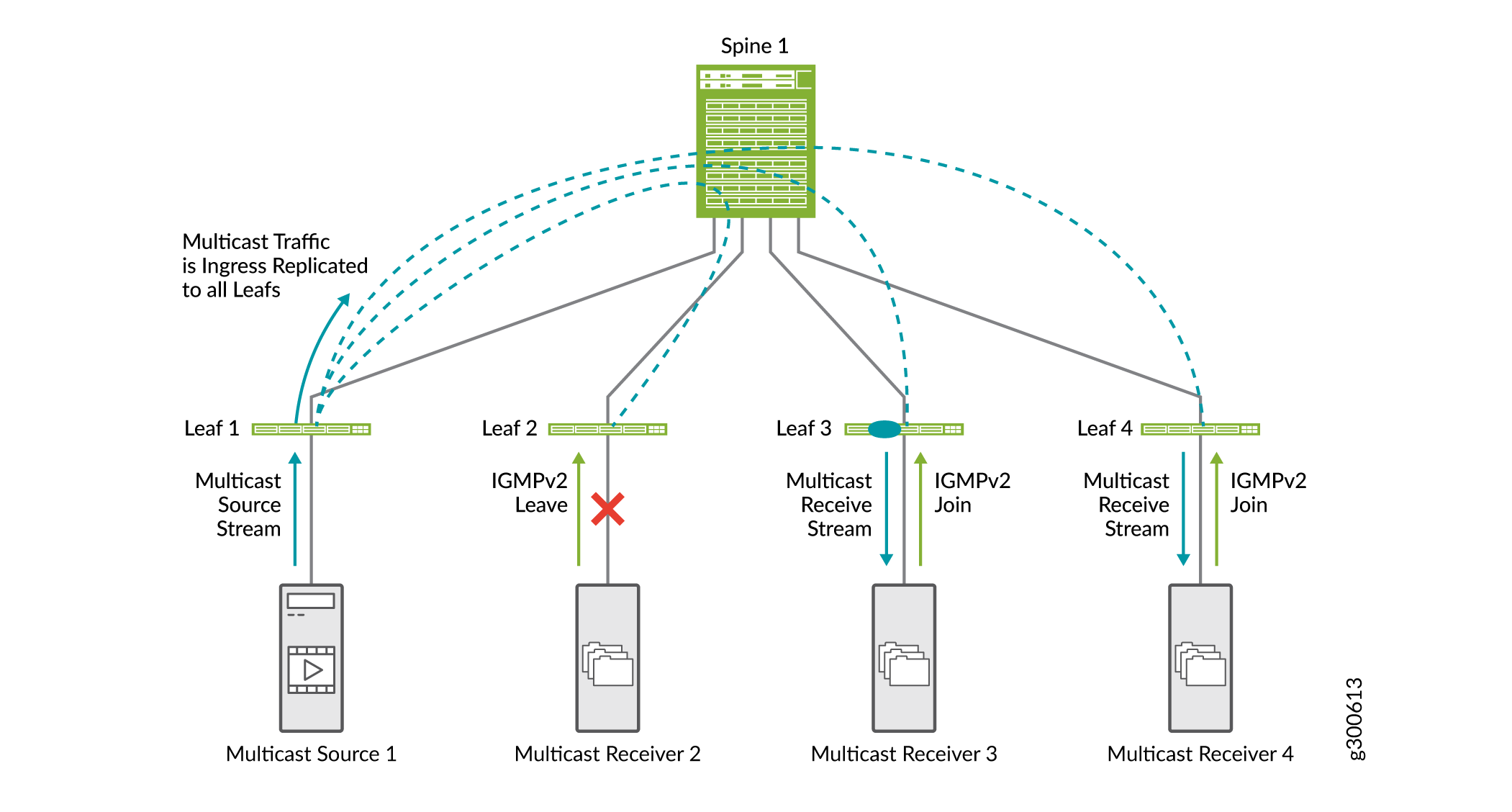

Espionaje IGMP

El espionaje IGMP en una estructura EVPN-VXLAN es útil para optimizar la distribución del tráfico de multidifusión. La supervisión IGMP conserva el ancho de banda porque el tráfico de multidifusión solo se reenvía en interfaces donde hay escuchas IGMP. No todas las interfaces de un dispositivo leaf necesitan recibir tráfico de multidifusión.

Sin espionaje IGMP, los sistemas finales reciben tráfico de multidifusión IP en el que no tienen interés, lo que inunda innecesariamente sus enlaces con tráfico no deseado. En algunos casos, cuando los flujos de multidifusión IP son grandes, la inundación del tráfico no deseado provoca problemas de denegación de servicio.

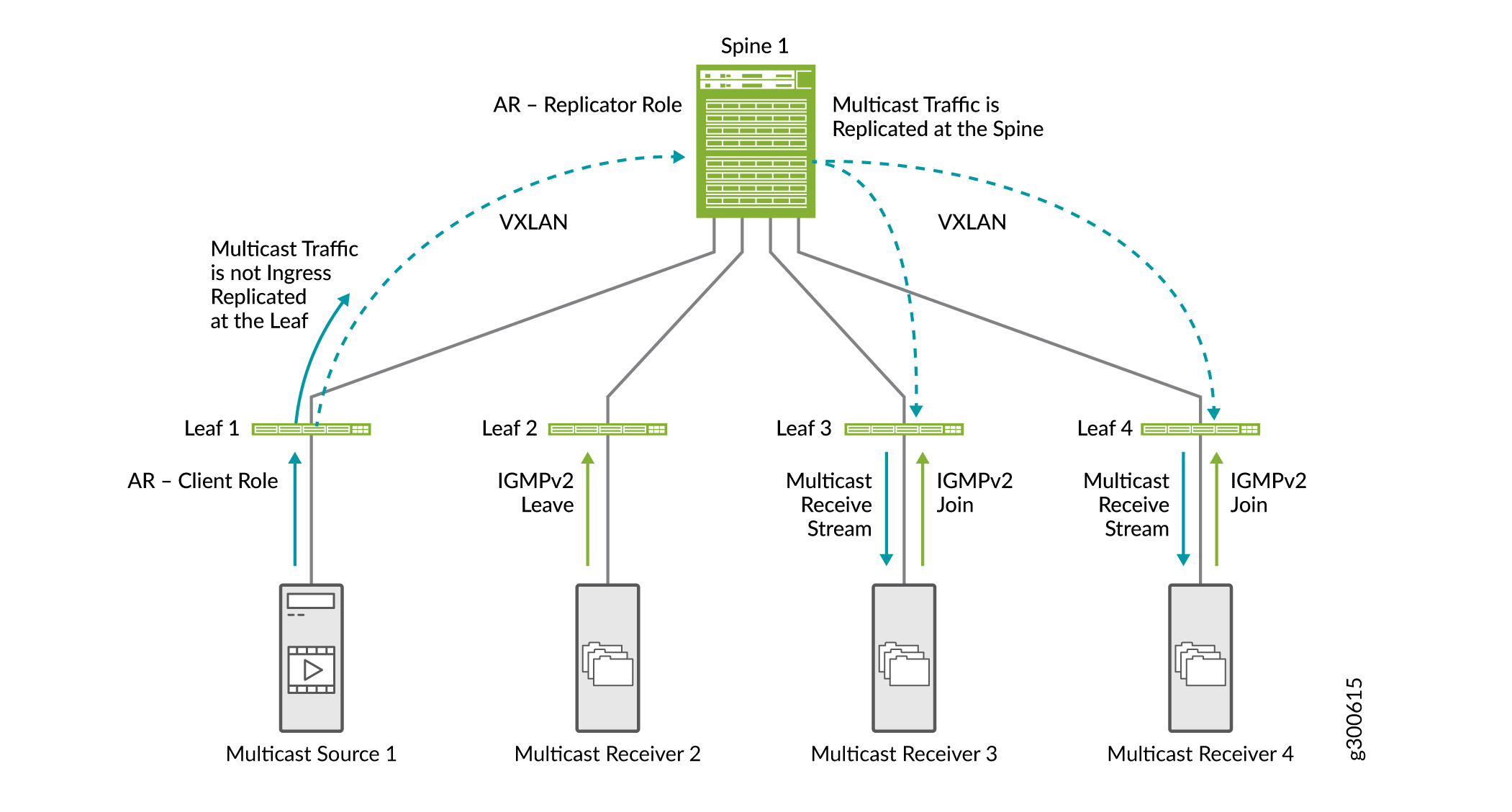

La figura 19 muestra cómo funciona el espionaje IGMP en una estructura EVPN-VXLAN. En esta estructura EVPN-VXLAN de ejemplo, la supervisión IGMP está configurada en todos los dispositivos leaf y el receptor de multidifusión 2 envió previamente una solicitud de unión IGMPv2.

-

El receptor de multidifusión 2 envía una solicitud de permiso IGMPv2.

-

Los receptores de multidifusión 3 y 4 envían una solicitud de unión IGMPv2.

-

Cuando el leaf 1 recibe tráfico de multidifusión de entrada, lo replica para todos los dispositivos leaf y lo reenvía al spine.

-

La columna vertebral reenvía el tráfico a todos los dispositivos leaf.

-

La hoja 2 recibe el tráfico de multidifusión, pero no lo reenvía al receptor porque el receptor envió un mensaje de salida IGMP.

En las redes EVPN-VXLAN solo se admite IGMP versión 2.

Para obtener más información acerca de la supervisión IGMP, consulte Descripción general del reenvío de multidifusión con supervisión IGMP o MLD Snooping en un entorno EVPN-VXLAN.

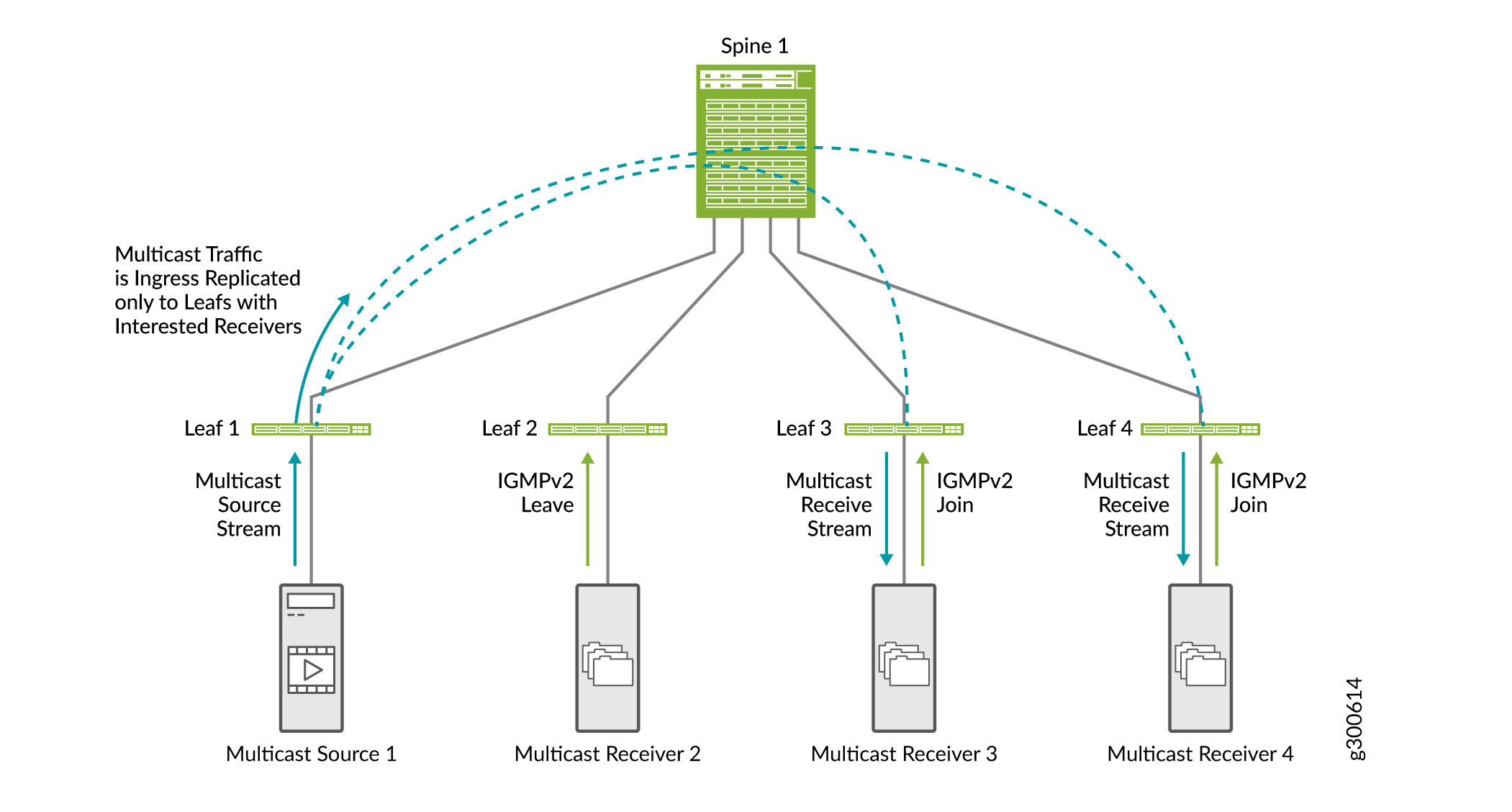

Reenvío selectivo de multidifusión

El reenvío selectivo de Ethernet de multidifusión (SMET) proporciona una mayor eficiencia de red de extremo a extremo y reduce el tráfico en la red EVPN. Conserva el uso de ancho de banda en el núcleo de la estructura y reduce la carga en los dispositivos de salida que no tienen oyentes.

Los dispositivos con supervisión IGMP habilitada utilizan el reenvío selectivo de multidifusión para reenviar el tráfico de multidifusión de forma eficiente. Con la supervisión IGMP habilitada, un dispositivo leaf envía tráfico de multidifusión solo a la interfaz de acceso con un receptor interesado. Con SMET agregado, el dispositivo leaf envía selectivamente tráfico de multidifusión solo a los dispositivos leaf del núcleo que han expresado interés en ese grupo de multidifusión.

La Figura 20 muestra el flujo de tráfico SMET junto con el espionaje IGMP.

-

El receptor de multidifusión 2 envía una solicitud de permiso IGMPv2.

-

Los receptores de multidifusión 3 y 4 envían una solicitud de unión IGMPv2.

-

Cuando la hoja 1 recibe tráfico de multidifusión de entrada, replica el tráfico solo en dispositivos leaf con receptores interesados (dispositivos leaf 3 y 4) y lo reenvía a la columna vertebral.

-

La columna vertebral reenvía el tráfico a los dispositivos de hoja 3 y 4.

No es necesario habilitar SMET; se habilita de forma predeterminada cuando se configura la supervisión IGMP en el dispositivo.

Para obtener más información acerca de SMET, consulte Descripción general del reenvío selectivo de multidifusión.

Replicación asistida del tráfico de multidifusión

La función de replicación asistida (AR) descarga los dispositivos leaf de estructura EVPN-VXLAN de las tareas de replicación de entrada. La hoja de entrada no replica el tráfico de multidifusión. Envía una copia del tráfico de multidifusión a una spine que está configurada como un dispositivo replicador AR. El dispositivo replicador de AR distribuye y controla el tráfico de multidifusión. Además de reducir la carga de replicación en los dispositivos de hoja de entrada, este método conserva el ancho de banda en la estructura entre la hoja y la columna vertebral.

La Figura 21 muestra cómo funciona AR junto con IGMP snooping y SMET.

-

La hoja 1, que está configurada como el dispositivo de hoja AR, recibe tráfico de multidifusión y envía una copia a la columna vertebral que está configurada como el dispositivo replicador de AR.

-

La columna vertebral replica el tráfico de multidifusión. Replica el tráfico de los dispositivos leaf que se aprovisionan con la VNI VLAN en la que el tráfico de multidifusión se originó desde el leaf 1.

Debido a que tenemos IGMP snooping y SMET configurados en la red, la columna envía el tráfico de multidifusión solo a dispositivos leaf con receptores interesados.

En este documento, mostramos las optimizaciones de multidifusión a pequeña escala. En una red a gran escala con muchas espinas y hojas, los beneficios de las optimizaciones son mucho más evidentes.

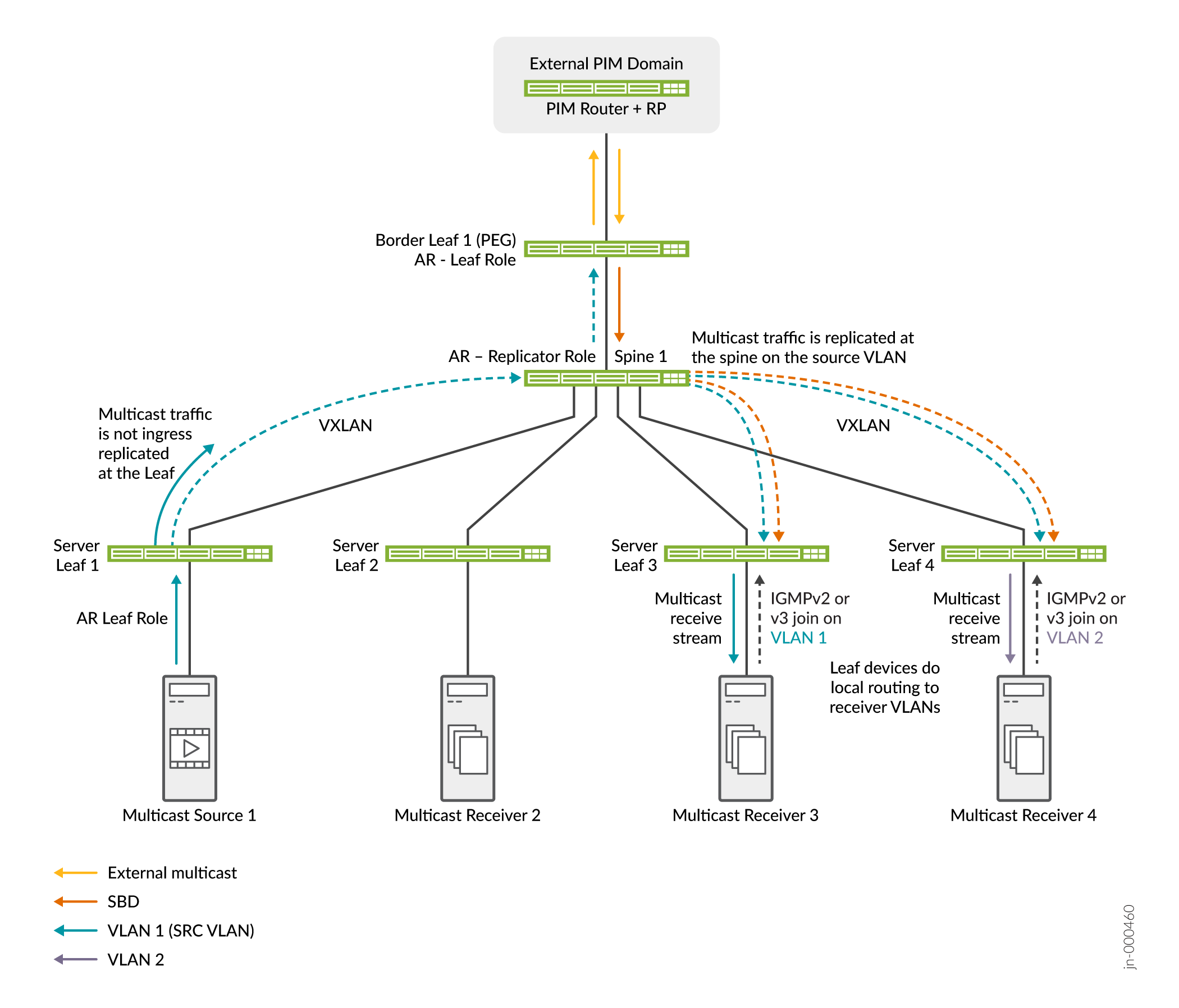

Multidifusión de intersubred optimizada para redes superpuestas ERB

Cuando tiene fuentes y receptores de multidifusión tanto dentro como fuera de una estructura superpuesta ERB, puede configurar multidifusión de intersubred optimizada (OISM) para permitir un flujo de tráfico de multidifusión eficiente a escala.

OISM usa un modelo de enrutamiento local para el tráfico de multidifusión, lo que evita la fijación del tráfico y minimiza la carga de tráfico dentro del núcleo de EVPN. OISM reenvía el tráfico de multidifusión solo en la VLAN de origen de multidifusión. Para los receptores entre subred, los dispositivos leaf utilizan interfaces IRB para enrutar localmente el tráfico recibido en la VLAN de origen a otras VLAN receptoras en el mismo dispositivo. Para optimizar aún más el flujo de tráfico de multidifusión en la estructura EVPN-VXLAN, OISM usa IGMP snooping y SMET para reenviar el tráfico en la estructura solo a dispositivos leaf con receptores interesados.

OISM también permite que la estructura enrute eficazmente el tráfico de fuentes de multidifusión externas a receptores internos, y de fuentes de multidifusión internas a receptores externos. OISM utiliza un dominio de puente suplementario (SBD) dentro de la estructura para reenviar el tráfico de multidifusión recibido en los dispositivos leaf de borde desde fuentes externas. El diseño SBD conserva el modelo de enrutamiento local para el tráfico de origen externo.

Puede usar OISM con AR para reducir la carga de replicación en dispositivos leaf OISM de menor capacidad. (Consulte Replicación asistida del tráfico de multidifusión.)

Vea la Figura 22 para una estructura simple con OISM y AR.

La figura 22 muestra los dispositivos de hoja y hoja de borde del servidor OISM, Spine 1 en el rol de replicador de AR y Hoja de servidor 1 como un origen de multidifusión en el rol de hoja de AR. También pueden existir un origen externo y receptores en el dominio PIM externo. OISM y AR trabajan juntos en este escenario de la siguiente manera:

-

Los receptores de multidifusión detrás del Server Leaf 3 en VLAN 1 y detrás del Server Leaf 4 en VLAN 2 envían uniones IGMP que muestran interés en el grupo de multidifusión. Los receptores externos también pueden unirse al grupo de multidifusión.

-

El origen de multidifusión detrás de Server Leaf 1 envía tráfico de multidifusión para el grupo a la estructura en VLAN 1. Server Leaf 1 envía solo una copia del tráfico al replicador de AR en Spine 1.

-

Además, el tráfico de origen externo para el grupo de multidifusión llega a la hoja de borde 1. Border Leaf 1 reenvía el tráfico del SBD a Spine 1, el replicador de AR.

-

El replicador AR envía copias desde la fuente interna en la VLAN de origen y desde la fuente externa en el SBD a los dispositivos leaf OISM con receptores interesados.

-

Los dispositivos leaf del servidor reenvían el tráfico a los receptores en la VLAN de origen y enrutan localmente el tráfico a los receptores en las otras VLAN.

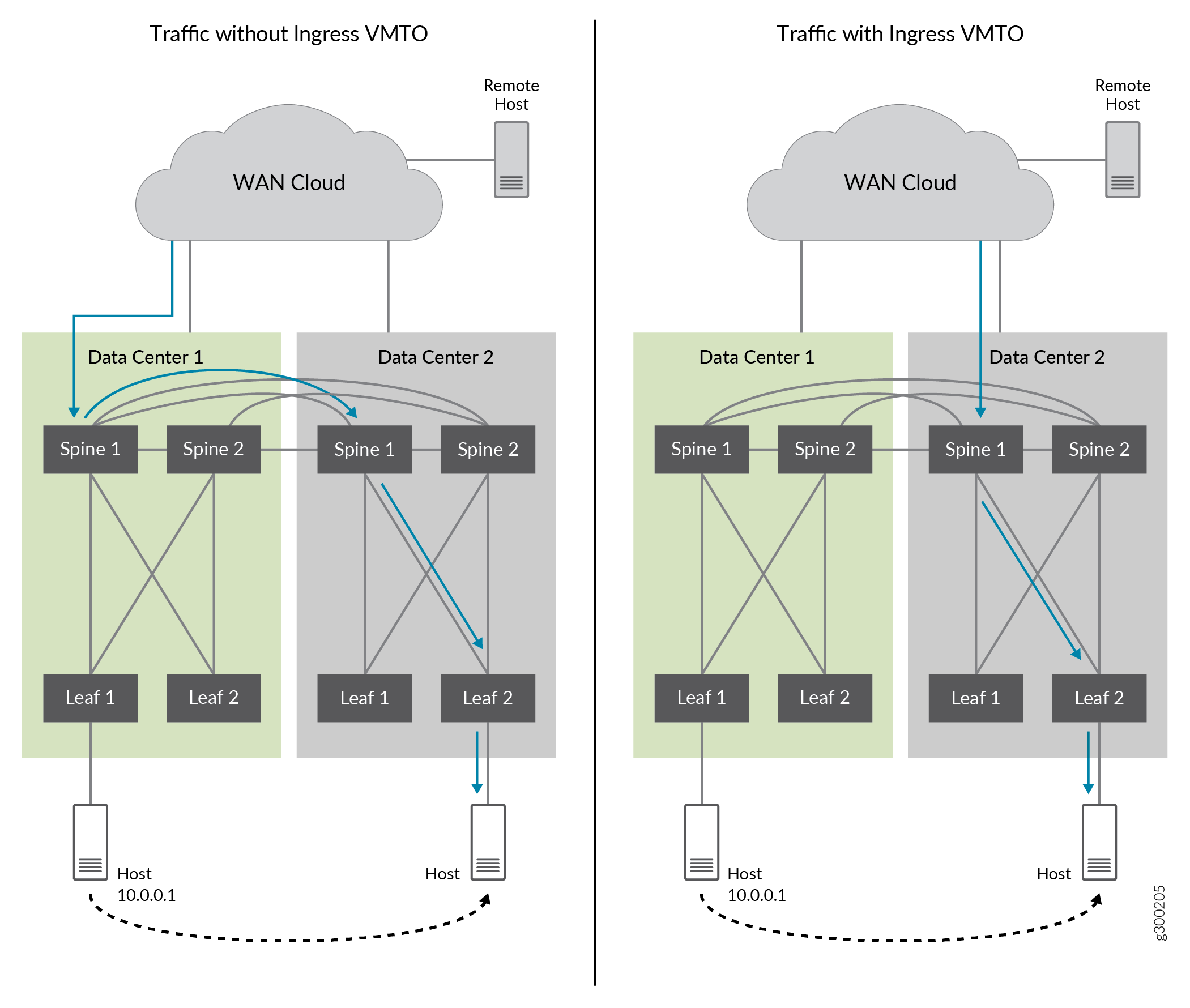

Optimización del tráfico de máquinas virtuales de entrada para EVPN

Cuando las máquinas virtuales y los hosts se mueven dentro de un centro de datos o de un centro de datos a otro, el tráfico de red puede volverse ineficaz si el tráfico no se enruta a la puerta de enlace óptima. Esto puede suceder cuando se reubica un host. La tabla ARP no siempre se vacía y el flujo de datos al host se envía a la puerta de enlace configurada, incluso cuando hay una puerta de enlace más óptima. El tráfico se "trombonea" y se enruta innecesariamente a la puerta de enlace configurada.

La optimización del tráfico de máquina virtual de entrada (VMTO) proporciona una mayor eficiencia de red, optimiza el tráfico de entrada, y puede eliminar el efecto trombón entre las VLAN. Cuando se habilita VMTO de entrada, las rutas se almacenan en una tabla de enrutamiento y reenvío virtual (VRF) de capa 3 y el dispositivo enruta el tráfico entrante directamente al host que se reubicó.

La figura 23 muestra el tráfico tromboneado sin VMTO de entrada y el tráfico optimizado con VMTO de entrada habilitado.

Sin entrada, VMTO, las spine 1 y 2 de DC1 y DC2 anuncian la ruta de host IP remoto 10.0.0.1 cuando la ruta de origen es de DC2. El tráfico de entrada se puede dirigir a las spines 1 y 2 de DC1. Luego se enruta a la columna vertebral 1 y 2 en DC2, donde se movió la ruta 10.0.0.1. Esto causa el efecto trombón.

Con VMTO de entrada, podemos lograr una ruta de reenvío óptima configurando una política para que la ruta del host IP (10.0.01) solo sea anunciada por Spine 1 y 2 desde DC2, y no desde DC1 cuando el host IP se mueve a DC2.

de entrada

de entrada

Para obtener información acerca de la configuración de VMTO, consulte Configuración de VMTO.

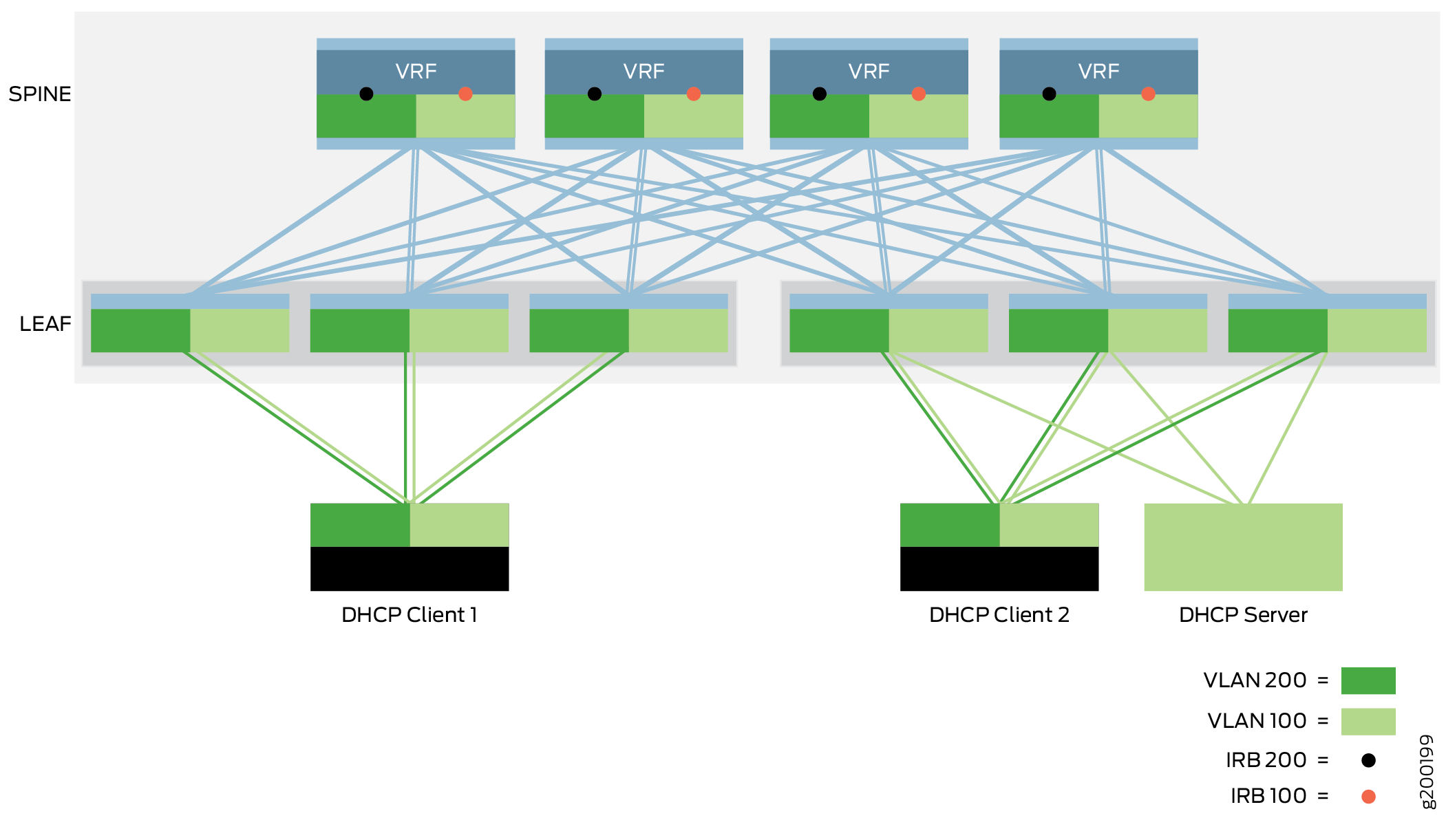

Relé DHCP

CRB

CRB

El bloque de creación de retransmisión del Protocolo de configuración dinámica de host (DHCP) permite que la red pase mensajes DHCP entre un cliente DHCP y un servidor DHCP. La implementación de retransmisión DHCP en este bloque de creación mueve los paquetes DHCP a través de una superposición CRB donde la puerta de enlace se encuentra en la capa de columna vertebral.

El servidor DHCP y los clientes DHCP se conectan a la red mediante interfaces de acceso en dispositivos leaf. El servidor y los clientes DHCP pueden comunicarse entre sí a través de la red existente sin configuración adicional cuando el cliente y el servidor DHCP se encuentran en la misma VLAN. Cuando un cliente y un servidor DHCP se encuentran en VLAN diferentes, el tráfico DHCP entre el cliente y el servidor se reenvía entre las VLAN a través de las interfaces IRB en dispositivos spine. Debe configurar las interfaces IRB en los dispositivos spine para que admitan la retransmisión DHCP entre VLAN.

Para obtener información acerca de la implementación de la retransmisión DHCP, consulte Diseño e implementación de retransmisión DHCP.

Reducción del tráfico ARP con sincronización y supresión de ARP (ARP de proxy)

El objetivo de la sincronización ARP es sincronizar las tablas ARP en todos los VRF que sirven en una subred superpuesta para reducir la cantidad de tráfico y optimizar el procesamiento tanto para los dispositivos de red como para los sistemas finales. Cuando una puerta de enlace IP para una subred se entera de un enlace ARP, lo comparte con otras puertas de enlace para que no tengan que detectar el mismo enlace ARP de forma independiente.

Con la supresión ARP, cuando un dispositivo leaf recibe una solicitud ARP, comprueba su propia tabla ARP que está sincronizada con los otros dispositivos VTEP y responde a la solicitud localmente en lugar de inundar la solicitud ARP.

El ARP proxy y la supresión de ARP están habilitados de forma predeterminada en todos los conmutadores de la serie QFX que pueden actuar como dispositivos leaf en una superposición ERB. Para obtener una lista de estos conmutadores, consulte Diseños de referencia de estructura EVPN-VXLAN de centro de datos: resumen de hardware compatible.

Las interfaces IRB en el dispositivo leaf entregan solicitudes ARP y NDP desde dispositivos leaf locales y remotos. Cuando un dispositivo leaf recibe una solicitud ARP o NDP de otro dispositivo leaf, el dispositivo receptor busca la dirección IP solicitada en su base de datos de enlaces de direcciones MAC+IP.

Si el dispositivo encuentra la dirección MAC+IP enlazada en su base de datos, responde a la solicitud.

Si el dispositivo no encuentra el enlace de la dirección MAC+IP, inunda la solicitud ARP a todos los vínculos Ethernet de la VLAN y a los VTEP asociados.

Dado que todos los dispositivos leaf participantes agregan las entradas ARP y sincronizan sus tablas de enrutamiento y puente, los dispositivos leaf locales responden directamente a las solicitudes de hosts conectados localmente y eliminan la necesidad de que los dispositivos remotos respondan a estas solicitudes ARP.

Para obtener información acerca de cómo implementar la sincronización ARP, ARP de proxy y supresión de ARP, consulte Habilitar ARP de proxy y supresión de ARP para la superposición de puente enrutado en borde.

Funciones de seguridad de puertos de capa 2 en sistemas finales conectados a Ethernet

Las superposiciones CRB y ERB admiten las funciones de seguridad de los sistemas finales conectados a Ethernet de capa 2 que describimos en las siguientes secciones.

Para obtener más información acerca de estas características, consulte Filtrado MAC, control de tormentas y compatibilidad con la duplicación de puertos en un entorno EVPN-VXLAN.

Para obtener información acerca de la configuración de estas funciones, consulte Configuración de funciones de seguridad de puerto de capa 2 en sistemas finales conectados a Ethernet.

- Prevención de tormentas de tráfico BUM con control de tormentas

- Uso del filtrado MAC para mejorar la seguridad de los puertos

- Análisis del tráfico mediante la creación de reflejo de puertos

Prevención de tormentas de tráfico BUM con control de tormentas

El control de tormentas puede evitar que el tráfico excesivo degrade la red. Disminuye el impacto de las tormentas de tráfico de BUM al monitorear los niveles de tráfico en las interfaces EVPN-VXLAN y al eliminar el tráfico de BUM cuando se excede un nivel de tráfico especificado.

En un entorno EVPN-VXLAN, el control de tormentas supervisa:

Tráfico BUM de capa 2 que se origina en una VXLAN y se reenvía a interfaces dentro de la misma VXLAN.

Tráfico de multidifusión de capa 3 que recibe una interfaz IRB en una VXLAN y se reenvía a interfaces de otra VXLAN.

Uso del filtrado MAC para mejorar la seguridad de los puertos

El filtrado MAC mejora la seguridad del puerto al limitar el número de direcciones MAC que se pueden aprender dentro de una VLAN y, por lo tanto, limitar el tráfico en una VXLAN. Limitar el número de direcciones MAC evita que el conmutador inunde la tabla de conmutación Ethernet. La inundación de la tabla de conmutación Ethernet se produce cuando el número de direcciones MAC nuevas que se aprenden hace que la tabla se desborde y las direcciones MAC aprendidas anteriormente se vacían de la tabla. El conmutador vuelve a aprender las direcciones MAC, lo que puede afectar el rendimiento e introducir vulnerabilidades de seguridad.

En este modelo, el filtrado de MAC limita el número de paquetes aceptados que se envían a las interfaces de acceso orientadas a la entrada en función de las direcciones MAC. Para obtener más información acerca de cómo funciona el filtrado de MAC, consulte la información sobre la limitación de MAC en Descripción de la limitación de MAC y la limitación de movimiento de MAC.

Análisis del tráfico mediante la creación de reflejo de puertos

Con la duplicación de puertos basada en analizador, puede analizar el tráfico hasta el nivel de paquete en un entorno EVPN-VXLAN. Puede utilizar esta función para aplicar directivas relacionadas con el uso de la red y el uso compartido de archivos, así como para identificar orígenes problemáticos mediante la localización de un uso de ancho de banda anormal o intenso por estaciones o aplicaciones concretas.

La duplicación de puertos copia los paquetes que entran o salen de un puerto o ingresan una VLAN y envía las copias a una interfaz local para monitoreo local o a una VLAN para monitoreo remoto. Use la creación de reflejo de puertos para enviar tráfico a aplicaciones que analizan el tráfico con fines como supervisar el cumplimiento, aplicar políticas, detectar intrusiones, supervisar y predecir patrones de tráfico, correlacionar eventos, etc.