Componentes da arquitetura de blueprint de malha de data center

Esta seção oferece uma visão geral dos blocos de construção usados nesta arquitetura de blueprint. A implementação de cada tecnologia de blocos de construção é explorada com mais detalhes em seções posteriores.

Para obter informações sobre o hardware e o software que servem como base para seus blocos de construção, veja os designs de referência de malha EVPN-VXLAN de data center — resumo de hardware suportado.

Os blocos de construção incluem:

Rede underlay de malha IP

O moderno bloco de construção de rede underlay de malha IP oferece conectividade IP em uma topologia baseada em Clos. A Juniper Networks oferece suporte aos seguintes modelos de underlay de malha IP:

-

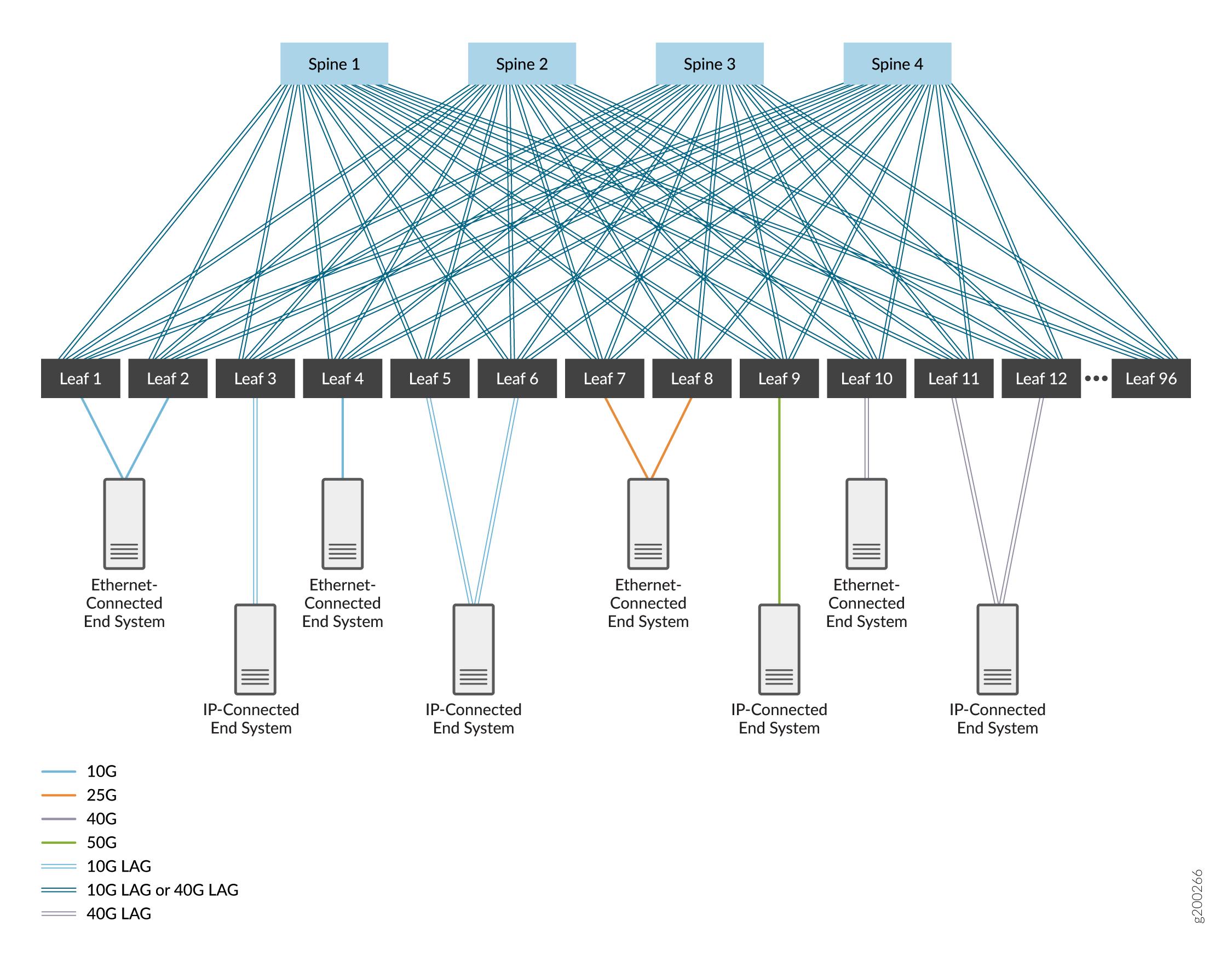

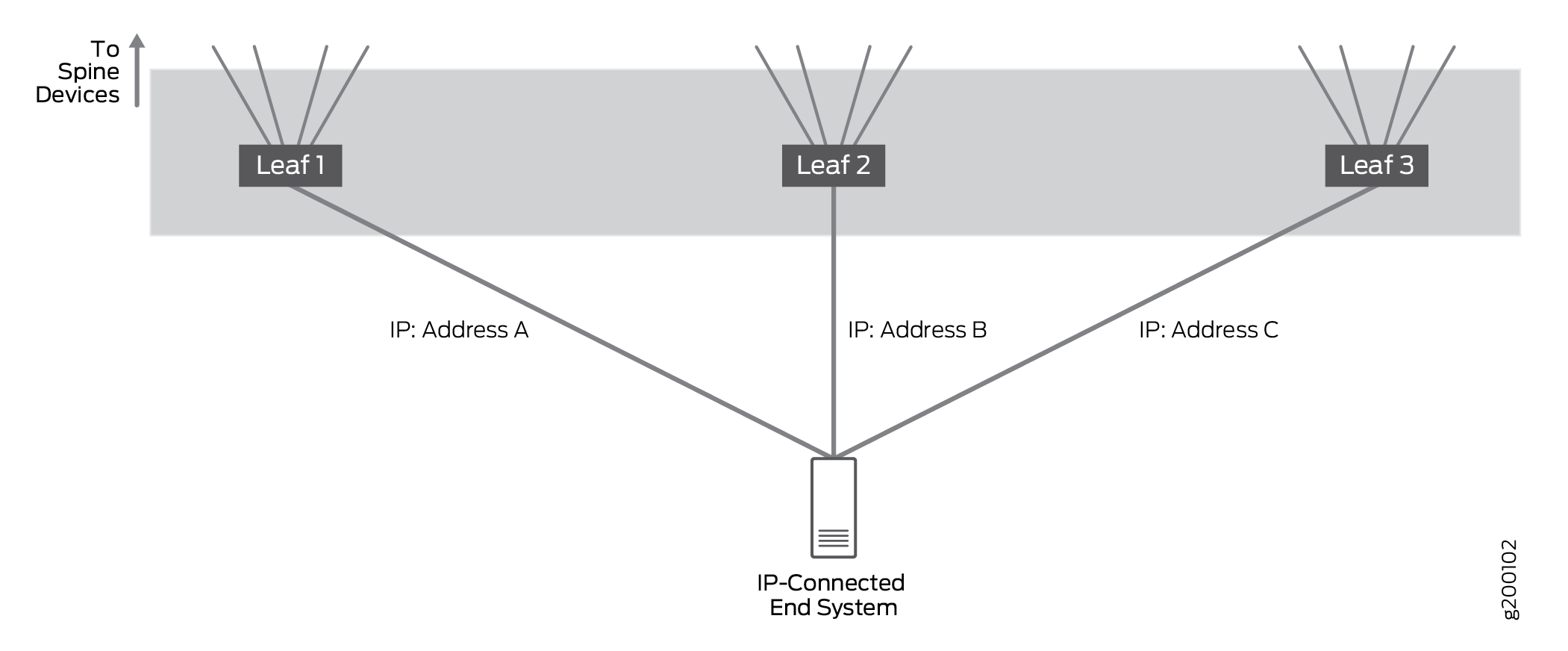

Uma malha IP de 3 estágios, composta por um nível de dispositivos spine e um nível de dispositivos leaf. Veja a Figura 1.

-

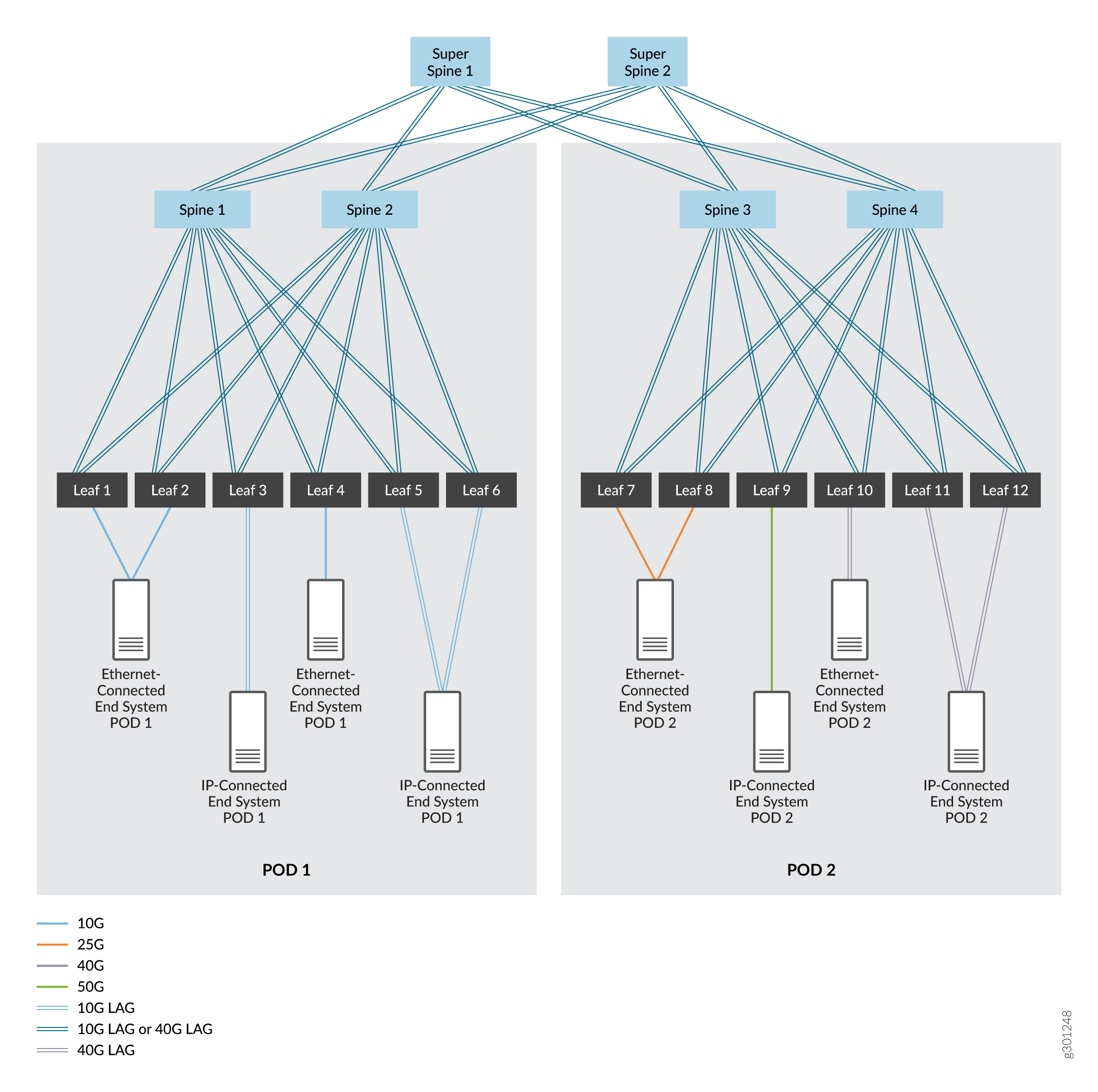

Uma malha IP de 5 estágios, que normalmente começa como uma única malha IP de 3 estágios que cresce em duas malhas IP de 3 estágios. Essas malhas são segmentadas em pontos de entrega (PODs) separados em um data center. Para este caso de uso, oferecemos suporte à inclusão de um nível de dispositivos super spine que permitem a comunicação entre os dispositivos spine e leaf nas duas PODs. Veja a Figura 2.

-

Um modelo de malha IP spine colapsada, no qual as funções da camada leaf são colapsadas nos dispositivos spine. Esse tipo de malha pode ser configurada e operar de maneira semelhante a uma malha IP de 3 estágios ou 5 estágios, exceto sem um nível separado de dispositivos leaf. Você pode usar uma malha spine colapsada se estiver se movendo incrementalmente para um modelo spine-and-leaf EVPN, ou você tem dispositivos de acesso ou dispositivos top-of-rack (TOR) que não podem ser usados em uma camada leaf porque eles não suportam EVPN-VXLAN.

de malha IP de três estágios

de malha IP de três estágios

de malha IP de cinco estágios

de malha IP de cinco estágios

Nesses números, os dispositivos são interconectados usando interfaces de alta velocidade que são links únicos ou interfaces Ethernet agregadas. As interfaces Ethernet agregadas são opcionais — um único elo entre dispositivos é normalmente usado — mas podem ser implantadas para aumentar a largura de banda e fornecer redundância de nível de link. Nós cobrimos as duas opções.

Escolhemos o EBGP como protocolo de roteamento na rede underlay por sua confiabilidade e escalabilidade. Cada dispositivo recebe seu próprio sistema autônomo com um número de sistema autônomo exclusivo para oferecer suporte ao EBGP. Você pode usar outros protocolos de roteamento na rede underlay; o uso desses protocolos está além do escopo deste documento.

Os designs de arquitetura de referência descritos neste guia são baseados em uma malha de IP que usa EBGP para conectividade underlay e IBGP para peering overlay (ver IBGP para Overlays). Você pode, alternativamente, configurar o peering overlay usando o EBGP.

A partir dos versões Junos OS 21.2R2 e 21.4R1, também oferecemos suporte à configuração de uma malha IPv6. O design da malha IPv6 neste guia usa EBGP para conectividade underlay e peering overlay (veja EBGP para Overlays com Underlays IPv6).

A malha de IP pode usar IPv4 ou IPv6 da seguinte forma:

-

Uma malha IPv4 usa endereçamento de interface IPv4, e sessões BGP de underlay e overlay IPv4 para comunicação de carga de trabalho de ponta a ponta.

-

Uma malha IPv6 usa endereçamento de interface IPv6, e sessões BGP de underlay e overlay IPv6 para comunicação de carga de trabalho de ponta a ponta.

-

Não oferecemos suporte a uma malha de IP que mistura IPv4 e IPv6.

No entanto, tanto as malhas IPv4 quanto as malhas IPv6 oferecem suporte a cargas de trabalho de pilha dupla — as cargas de trabalho podem ser IPv4 ou IPv6, ou tanto IPv4 quanto IPv6.

A detecção de encaminhamento micro bidirecional (BFD) — a capacidade de executar BFD em links individuais em uma interface Ethernet agregada — também pode ser habilitada neste bloco de construção para detectar rapidamente falhas de link em quaisquer links de membros em pacotes Ethernet agregados que conectam dispositivos.

Para obter mais informações, veja essas outras seções neste guia:

-

Configuração de dispositivos spine e leaf em underlays de malha IP de 3 estágios e 5 estágios: Projeto e implementação de redes underlay de malha IP.

-

Implementação do nível adicional de dispositivos super spine em uma camada inferior de malha IP de 5 estágios: Projeto e implementação de malha de IP de cinco estágios.

-

Configuração de um underlay IPv6 e suporte a overlay EBGP IPv6: Underlay de malha IPv6 e design e implementação de rede overlay com EBGP.

-

Configuração da underlay em um modelo de malha spine colapsado: Design e implementação de malha spine colapsadas.

Suporte para cargas de trabalho IPv4 e IPv6

Como muitas redes implementam um ambiente dual stack para cargas de trabalho que incluem protocolos IPv4 e IPv6, este blueprint oferece suporte para ambos os protocolos. As etapas para configurar a malha para oferecer suporte a cargas de trabalho IPv4 e IPv6 estão entrelaçadas em todo este guia para permitir que você escolha um ou ambos esses protocolos.

O protocolo IP que você usa para tráfego de carga de trabalho é independente da versão de protocolo IP (IPv4 ou IPv6) que você configura para o underlay e overlay da Malha IP. (Veja rede underlay de malha IP.) Uma malha IPv4 ou uma infraestrutura de malha IPv6 podem suportar cargas de trabalho IPv4 e IPv6.

Overlays de virtualização de rede

Uma sobreposição de virtualização de rede é uma rede virtual que é transportada por uma rede underlay IP. Esse bloco de construção permite a multitenancy em uma rede, permitindo que você compartilhe uma única rede física em vários locatários, mantendo o tráfego de rede de cada locatário isolado dos outros locatários.

Um locatário é uma comunidade de usuários (como uma unidade de negócios, departamento, grupo de trabalho ou aplicativo) que contém grupos de endpoints. Os grupos podem se comunicar com outros grupos na mesma locação, e os locatários podem se comunicar com outros locatários se permitido por políticas de rede. Um grupo é tipicamente expresso como uma sub-rede (VLAN) que pode se comunicar com outros dispositivos na mesma sub-rede, e alcançar grupos e endpoints externos por meio de uma instância de roteamento e encaminhamento virtual (VRF).

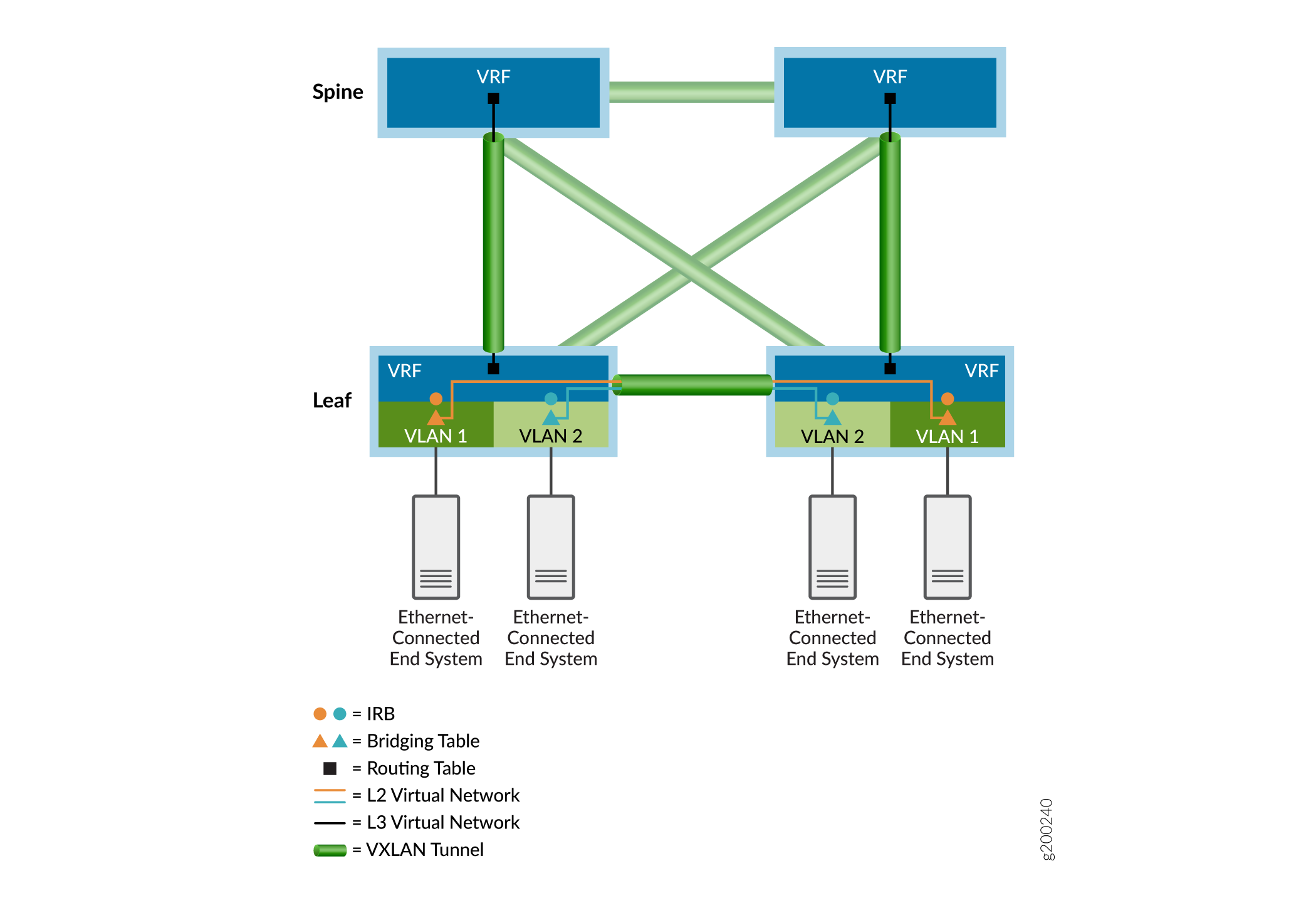

Como visto no exemplo de overlay mostrado na Figura 3, as tabelas de ponte Ethernet (representadas por triângulos) lidam com quadros com pontes de locatário e tabelas de roteamento IP (representadas por quadrados) processam pacotes roteados. O roteamento entre VLAN acontece nas interfaces integradas de roteamento e ponte (IRB) (representadas por círculos). As tabelas de Ethernet e IP são direcionadas para redes virtuais (representadas por linhas coloridas). Para alcançar sistemas finais conectados a outros dispositivos VXLAN Tunnel Endpoint (VTEP), os pacotes de locatários são encapsulados e enviados por um túnel VXLAN sinalizado por EVPN (representado por ícones de túnel verde) para os dispositivos VTEP remotos associados. Os pacotes em túnel são des encapsulados nos dispositivos VTEP remotos e encaminhados aos sistemas finais remotos por meio das respectivas tabelas de ponte ou roteamento do dispositivo VTEP de saída.

As próximas seções fornecem mais detalhes sobre redes overlay.

- IBGP para Overlays

- EBGP para overlays com underlays IPv6

- Bridged Overlay

- Overlay de ponte roteada centralmente

- Overlay de ponte com roteamento de borda

- Overlay spine colapsado

- Comparação de overlays bridged, CRB e ERB

- Modelos de endereçamento da IRB em sobreposições de ponte

- Overlay roteado usando rotas EVPN Tipo 5

- Instâncias MAC-VRF para multitenancy em overlays de virtualização de rede

IBGP para Overlays

BGP interno (IBGP) é um protocolo de roteamento que troca informações de acessibilidade em uma rede IP. Quando o IBGP é combinado com o Multiprotocol BGP (MP-IBGP), ele fornece a base para a EVPN trocar informações de acessibilidade entre dispositivos VTEP. Esse recurso é necessário para estabelecer túneis VXLAN entre VTEP e usá-los para serviços de conectividade overlay.

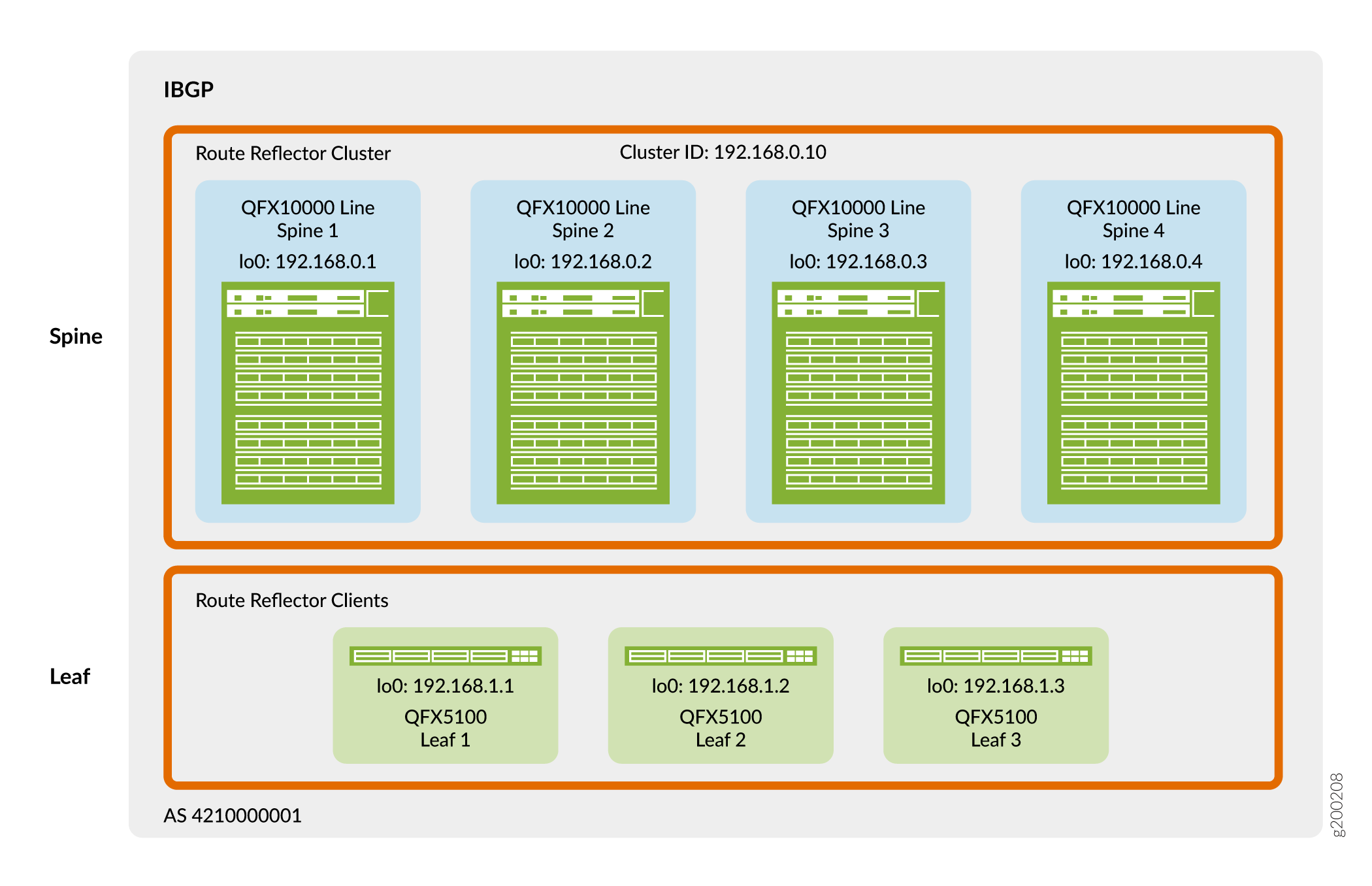

A Figura 4 mostra que os dispositivos spine e leaf usam seus endereços loopback para peering em um único sistema autônomo. Nesse design, os dispositivos spine atuam como um cluster refletor de rota e os dispositivos leaf são clientes refletores de rota. Um refletor de rota satisfaz o requisito do IBGP para uma malha completa sem a necessidade de peer todos os dispositivos VTEP diretamente entre si. Como resultado, os dispositivos leaf peer apenas com os dispositivos spine e os dispositivos spine peer com dispositivos spine e leaf. Como os dispositivos spine estão conectados a todos os dispositivos leaf, os dispositivos spine podem transmitir informações de IBGP entre os vizinhos do dispositivo leaf indiretamente peered.

Você pode colocar refletores de rota em praticamente qualquer lugar da rede. No entanto, você deve considerar o seguinte:

-

O dispositivo selecionado tem memória e poder de processamento suficientes para lidar com a carga de trabalho adicional exigida por um refletor de rota?

-

O dispositivo selecionado é equidistante e acessível de todos os alto-falantes EVPN?

-

O dispositivo selecionado tem os recursos de software adequados?

Nesse design, o cluster refletor de rota é colocado na camada spine. Os switches QFX que você pode usar como spine neste design de referência têm ampla velocidade de processamento para lidar com o tráfego do cliente refletor de rota na sobreposição de virtualização de rede.

Para obter mais informações sobre a implementação do IBGP em uma sobreposição, consulte Configure o IBGP para o Overlay.

EBGP para overlays com underlays IPv6

Os casos de uso de arquitetura de referência originais neste guia ilustram um design de underlay IPv4 EBGP com conectividade de dispositivos overlay IPv4 IBGP. Veja a rede underlay de malha IP e o IBGP para overlays. No entanto, à medida que os dispositivos de borda de virtualização de rede (NVE) começam a adotar VTEPs IPv6 para aproveitar o intervalo de endereçamento estendido e os recursos do IPv6, expandimos o suporte à malha de IP para abranger o IPv6.

A partir do Junos OS Release 21.2R2-S1, em plataformas de suporte você pode usar alternativamente uma infraestrutura de malha IPv6 com alguns designs overlay de arquitetura de referência. O design da malha IPv6 inclui endereçamento de interface IPv6, underlay IPv6 EBGP e sobreposição de EBGP IPv6 para conectividade de carga de trabalho. Com uma malha IPv6, os dispositivos NVE encapsulam o cabeçalho VXLAN com um cabeçalho externo IPv6 e tunelam os pacotes em toda a malha de ponta a ponta usando saltos próximos IPv6. A carga de trabalho pode ser IPv4 ou IPv6.

A maioria dos elementos que você configura nos designs overlay de arquitetura de referência suportados são independentemente de a infraestrutura underlay e overlay usar IPv4 ou IPv6. Os procedimentos de configuração correspondentes para cada um dos designs de overlay suportados exigem qualquer diferença de configuração se o underlay e o overlay usarem o design da malha IPv6.

Para obter mais detalhes, veja as seguintes referências neste guia e outros recursos:

Configuração de uma malha IPv6 usando EBGP para conectividade underlay e peering overlay: Design e implementação de rede underlay de malha IPv6 e overlay com EBGP.

Iniciando versões em que diferentes plataformas oferecem suporte a um projeto de malha IPv6 ao servir em funções específicas na malha: Designs de referência de malha EVPN-VXLAN de data center — Resumo de hardware suportado.

Visão geral do suporte a peering de underlay e overlay IPv6 em malhas EVPN-VXLAN em dispositivos da Juniper Networks: EVPN-VXLAN com um IPv6 Underlay.

Bridged Overlay

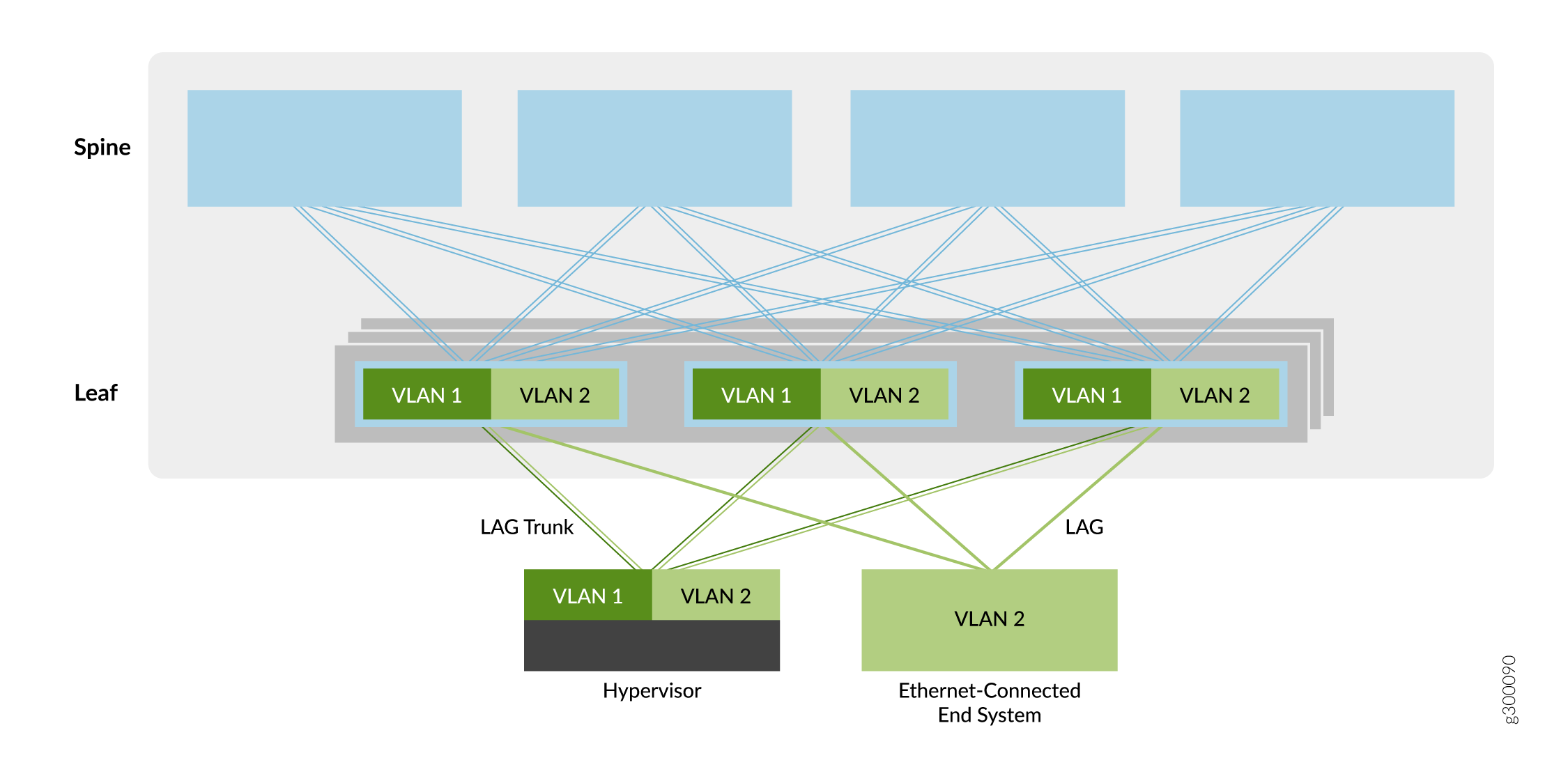

O primeiro tipo de serviço overlay descrito neste guia é uma sobreposição em ponte, conforme mostrado na Figura 5.

Neste modelo de overlay, as VLANs Ethernet são estendidas entre dispositivos leaf em túneis VXLAN. Esses túneis VXLAN leaf-to-leaf oferecem suporte a redes de data center que exigem conectividade Ethernet entre dispositivos leaf, mas não precisam de roteamento entre as VLANs. Como resultado, os dispositivos spine oferecem apenas conectividade básica de underlay e overlay para os dispositivos leaf, e não executam serviços de roteamento ou gateway vistos com outros métodos de overlay.

Os dispositivos Leaf originam VTEPs para se conectarem aos outros dispositivos leaf. Os túneis permitem que os dispositivos leaf enviem tráfego VLAN para outros dispositivos leaf e sistemas finais conectados por Ethernet no data center. A simplicidade desse serviço overlay o torna atraente para operadores que precisam de uma maneira fácil de introduzir a EVPN/VXLAN em seu data center baseado em Ethernet existente.

Você pode adicionar o roteamento a uma sobreposição em ponte, implementando um roteador da Série MX ou dispositivo de segurança da Série SRX externo à malha EVPN/VXLAN. Caso contrário, você pode selecionar um dos outros tipos de overlay que incorporam roteamento (como uma sobreposição de pontes roteada na borda, uma sobreposição de pontes roteada centralmente ou uma sobreposição roteada).

Para obter informações sobre a implementação de uma sobreposição em ponte, veja o Projeto e implementação do Bridged Overlay.

Overlay de ponte roteada centralmente

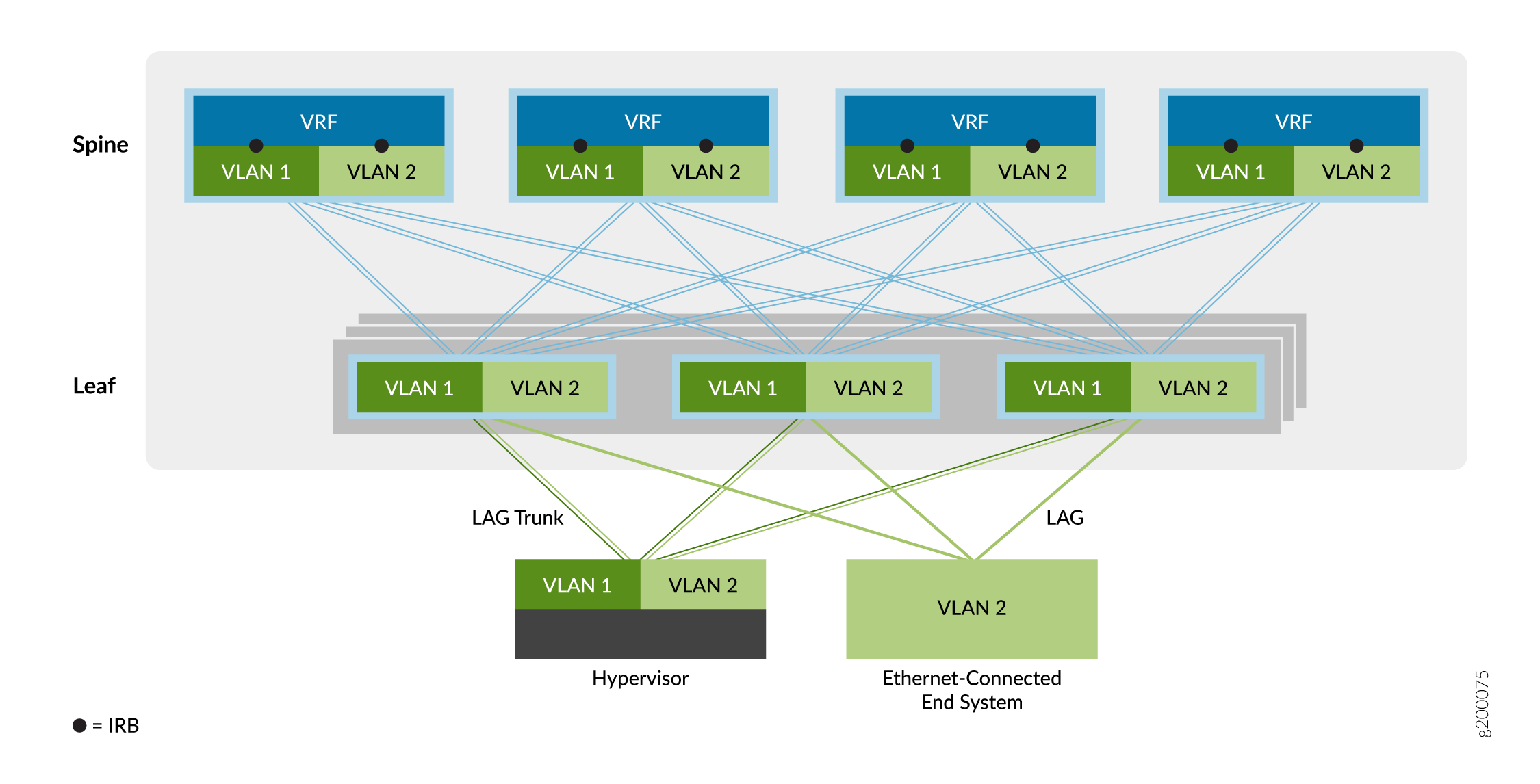

O segundo tipo de serviço overlay é a sobreposição de pontes roteadas centralmente (CRB), conforme mostrado na Figura 6.

de pontes roteada centralmente

de pontes roteada centralmente

Em uma sobreposição do CRB, o roteamento ocorre em um gateway central da rede de data center (a camada spine neste exemplo) e não no dispositivo VTEP onde os sistemas finais estão conectados (a camada leaf neste exemplo).

Você pode usar esse modelo de overlay quando precisa de tráfego roteado para passar por um gateway centralizado ou quando seus dispositivos VTEP de borda não têm os recursos de roteamento necessários.

Como mostrado acima, o tráfego que se origina nos sistemas finais conectados por Ethernet é encaminhado para os dispositivos VTEP leaf em um tronco (várias VLANs) ou uma porta de acesso (VLAN único). O dispositivo VTEP encaminha o tráfego para sistemas finais locais ou para um sistema final em um dispositivo VTEP remoto. Uma interface integrada de roteamento e ponte (IRB) em cada dispositivo spine ajuda a rotear o tráfego entre as redes virtuais Ethernet.

O modelo de serviço de overlay com reconhecimento de VLAN permite agregar facilmente uma coleção de VLANs na mesma rede virtual overlay. O design EVPN da Juniper Networks oferece suporte a três configurações de modelo de serviço Ethernet conscientes de VLAN no data center, da seguinte forma:

-

Default instance VLAN-aware— Com essa opção, você implementa uma única instância de comutação padrão que oferece suporte a um total de 4094 VLANs. Todas as plataformas leaf incluídas neste design (Designs de referência de malha EVPN-VXLAN de data center — Resumo de hardware suportado) oferecem suporte ao estilo de instância padrão de overlay com reconhecimento de VLAN.

Para configurar este modelo de serviço, veja Configuração de uma sobreposição de pontes com roteamento centralizado com reconhecimento VLAN na instância padrão.

-

Virtual switch VLAN-aware— Com essa opção, várias instâncias de switch virtual oferecem suporte a até 4094 VLANs por instância. Este modelo de serviço Ethernet é ideal para redes overlay que exigem escalabilidade além de uma única instância padrão. O suporte para essa opção está disponível atualmente na linha QFX10000 de switches.

Para implementar este modelo de serviço escalável, veja Configuração de uma sobreposição de CRB consciente de VLAN com switches virtuais ou instâncias MAC-VRF.

-

MAC-VRF instance VLAN-aware— Com essa opção, várias instâncias MAC-VRF oferecem suporte a até 4094 VLANs por instância. Este modelo de serviço Ethernet é ideal para redes de sobreposição que exigem escalabilidade além de uma única instância padrão, e onde você deseja mais opções para garantir o isolamento ou interconexão de VLAN entre diferentes locatários na mesma malha. O suporte para essa opção está disponível nas plataformas que oferecem suporte a instâncias MAC-VRF (ver Feature Explorer: MAC VRF com EVPN-VXLAN).

Para implementar este modelo de serviço escalável, veja Configuração de uma sobreposição de CRB consciente de VLAN com switches virtuais ou instâncias MAC-VRF.

Overlay de ponte com roteamento de borda

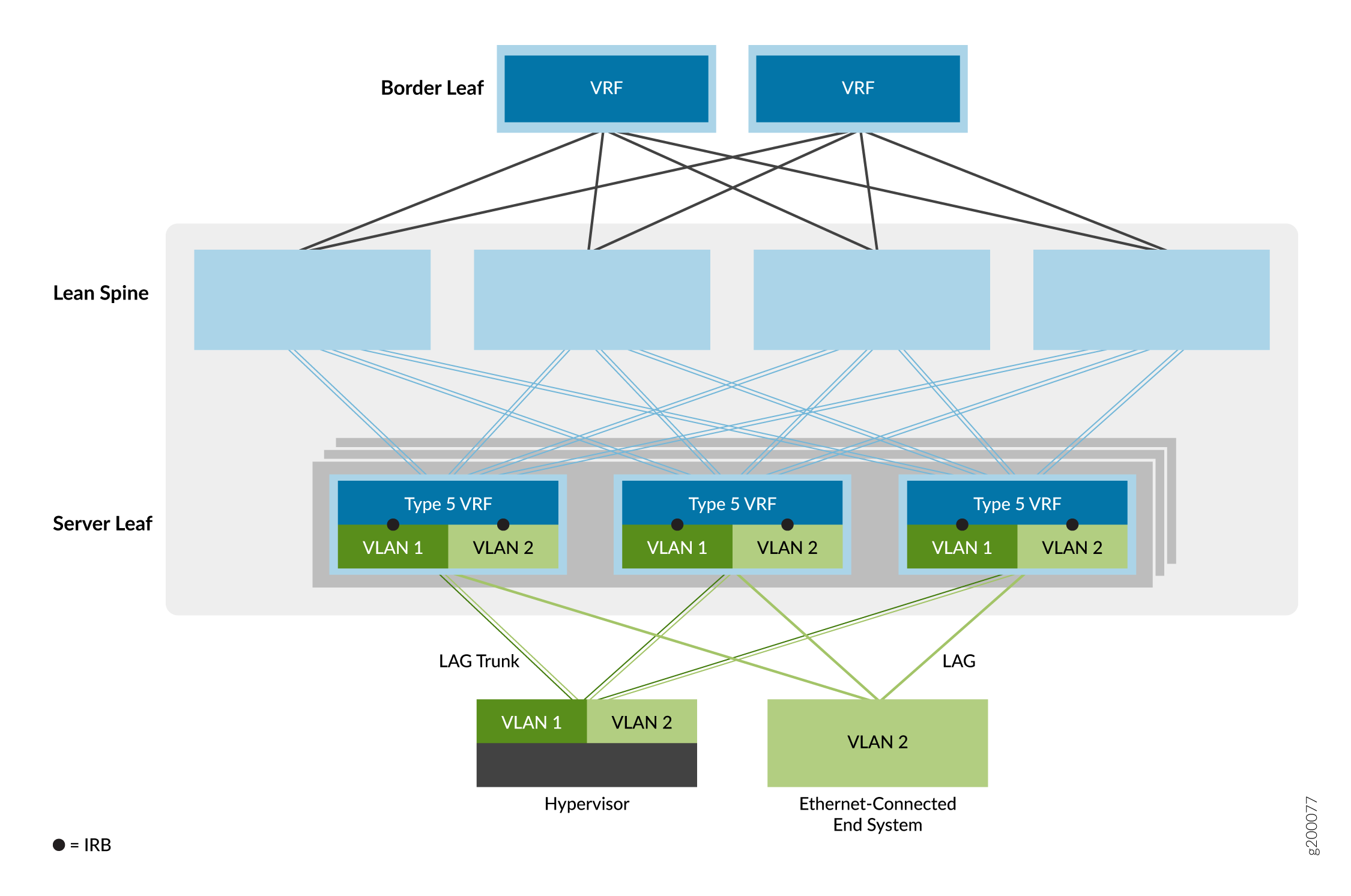

A terceira opção de serviço overlay é a sobreposição de pontes roteadas por borda (ERB), conforme mostrado na Figura 7.

de ponte com roteamento de borda

de ponte com roteamento de borda

Neste modelo de serviço Ethernet, as interfaces IRB são movidas para VTEPs de dispositivos leaf na borda da rede overlay para aproximar o roteamento IP dos sistemas finais. Devido aos recursos especiais de ASIC necessários para oferecer suporte a pontes, roteamento e EVPN/VXLAN em um único dispositivo, os overlays ERB só são possíveis em determinados switches. Para uma lista de switches que oferecemos suporte como dispositivos leaf em um overlay ERB, veja designs de referência de malha de EVPN-VXLAN de data center — resumo de hardware suportado.

Esse modelo permite uma rede geral mais simples. Os dispositivos spine estão configurados para lidar apenas com o tráfego IP, o que elimina a necessidade de estender as sobreposições de ponte para os dispositivos spine.

Essa opção também permite um tráfego intra-data center de servidor a servidor mais rápido (também conhecido como tráfego leste-oeste), onde os sistemas finais são conectados ao mesmo dispositivo leaf VTEP. Como resultado, o roteamento acontece muito mais perto dos sistemas finais do que com as sobreposições do CRB.

Quando você configura interfaces IRB que estão incluídas em instâncias de roteamento EVPN Type-5 em switches QFX5110 ou QFX5120 que funcionam como dispositivos leaf, o dispositivo permite automaticamente o roteamento simétrico inter-IRB unicast para rotas EVPN Tipo 5.

Para obter informações sobre a implementação do overlay da ERB, veja Projeto e implementação de overlay com pontes roteadas de borda.

Overlay spine colapsado

A rede overlay em uma arquitetura spine colapsada é semelhante a um overlay ERB. Em uma arquitetura spine colapsada, as funções do dispositivo leaf são colapsadas nos dispositivos spine. Como não há camada leaf, você configura as interfaces VTEPS e IRB nos dispositivos spine, que estão na borda da rede overlay como os dispositivos leaf em um modelo ERB. Os dispositivos spine também podem executar funções de gateway de borda para rotear o tráfego norte-sul ou estender o tráfego de Camada 2 em locais de data center.

Para obter uma lista de switches que oferecemos suporte com uma arquitetura spine colapsada, veja designs de referência de malha EVPN-VXLAN de data center — resumo de hardware suportado.

Comparação de overlays bridged, CRB e ERB

Para ajudar você a decidir qual tipo de overlay é mais adequado para o seu ambiente EVPN, consulte a Tabela 1.

Oferecemos suporte à mistura de sobreposição, sobreposição de CRB e configurações de overlay de ERB no mesmo dispositivo ao mesmo tempo em dispositivos que oferecem suporte a esses tipos de overlay. Você não precisa configurar o dispositivo com sistemas lógicos separados para que o dispositivo opere em paralelo em diferentes tipos de overlays.

| Pontos de comparação |

ERB Overlay |

CRB Overlay |

Bridged Overlay |

|---|---|---|---|

| Roteamento entre sub-rede de locatário totalmente distribuído |

✓ |

|

|

| Impacto mínimo da falha no gateway IP |

✓ |

|

|

| Roteamento dinâmico para nós de terceiros no nível leaf |

✓ |

|

|

| Otimizado para um alto volume de tráfego leste-oeste |

✓ |

|

|

| Melhor integração com malhas IP brutas |

✓ |

|

|

| Virtualização DE IP VRF mais próxima do servidor |

✓ |

|

|

| Multihoming contrail vRouter necessário |

✓ |

|

|

| Interoperabilidade mais fácil de EVPN com diferentes fornecedores |

✓ |

|

|

| Roteamento simétrico entre sub-redes |

✓ |

✓ |

|

| ID de VLAN sobreposta por rack |

✓ |

✓ |

✓ |

| Configuração manual e resolução de problemas mais simples |

|

✓ |

✓ |

| Interfaces no estilo de provedores de serviços e empresas |

|

✓ |

✓ |

| Suporte legado ao switch leaf (QFX5100) |

|

✓ |

✓ |

| Controle centralizado de otimização de tráfego de máquina virtual (VMTO) |

|

✓ |

|

| Gateway de sub-rede de locatário IP no cluster de firewall |

|

|

✓ |

Modelos de endereçamento da IRB em sobreposições de ponte

A configuração de interfaces IRB em overlays de CRB e ERB requer uma compreensão dos modelos para a configuração padrão de endereços IP e MAC de interfaces IRB da seguinte forma:

Unique IRB IP Address— Neste modelo, um endereço IP exclusivo é configurado em cada interface IRB em uma sub-rede overlay.

O benefício de ter um endereço IP exclusivo e endereço MAC em cada interface IRB é a capacidade de monitorar e alcançar cada uma das interfaces IRB de dentro da overlay usando seu endereço IP exclusivo. Esse modelo também permite configurar um protocolo de roteamento na interface IRB.

A desvantagem desse modelo é que alocar um endereço IP exclusivo para cada interface IRB pode consumir muitos endereços IP de uma sub-rede.

Unique IRB IP Address with Virtual Gateway IP Address— Esse modelo adiciona um endereço IP de gateway virtual ao modelo anterior, e o recomendamos para overlays em pontes roteadas centralmente. É semelhante ao VRRP, mas sem a sinalização de plano de dados em banda entre as interfaces IRB do gateway. O gateway virtual deve ser o mesmo para todas as interfaces IRB de gateway padrão na sub-rede overlay e está ativo em todas as interfaces IRB de gateway onde ela está configurada. Você também deve configurar um endereço MAC IPv4 comum para o gateway virtual, que se torna o endereço MAC de origem em pacotes de dados encaminhados pela interface IRB.

Além dos benefícios do modelo anterior, o gateway virtual simplifica a configuração padrão de gateway nos sistemas finais. A desvantagem desse modelo é a mesma do modelo anterior.

IRB with Anycast IP Address and MAC Address— Neste modelo, todas as interfaces IRB de gateway padrão em uma sub-rede overlay são configuradas com o mesmo endereço IP e MAC. Recomendamos esse modelo para overlays ERB.

Um benefício desse modelo é que apenas um único endereço IP é necessário por sub-rede para endereçamento padrão da interface IRB de gateway, o que simplifica a configuração padrão do gateway nos sistemas finais.

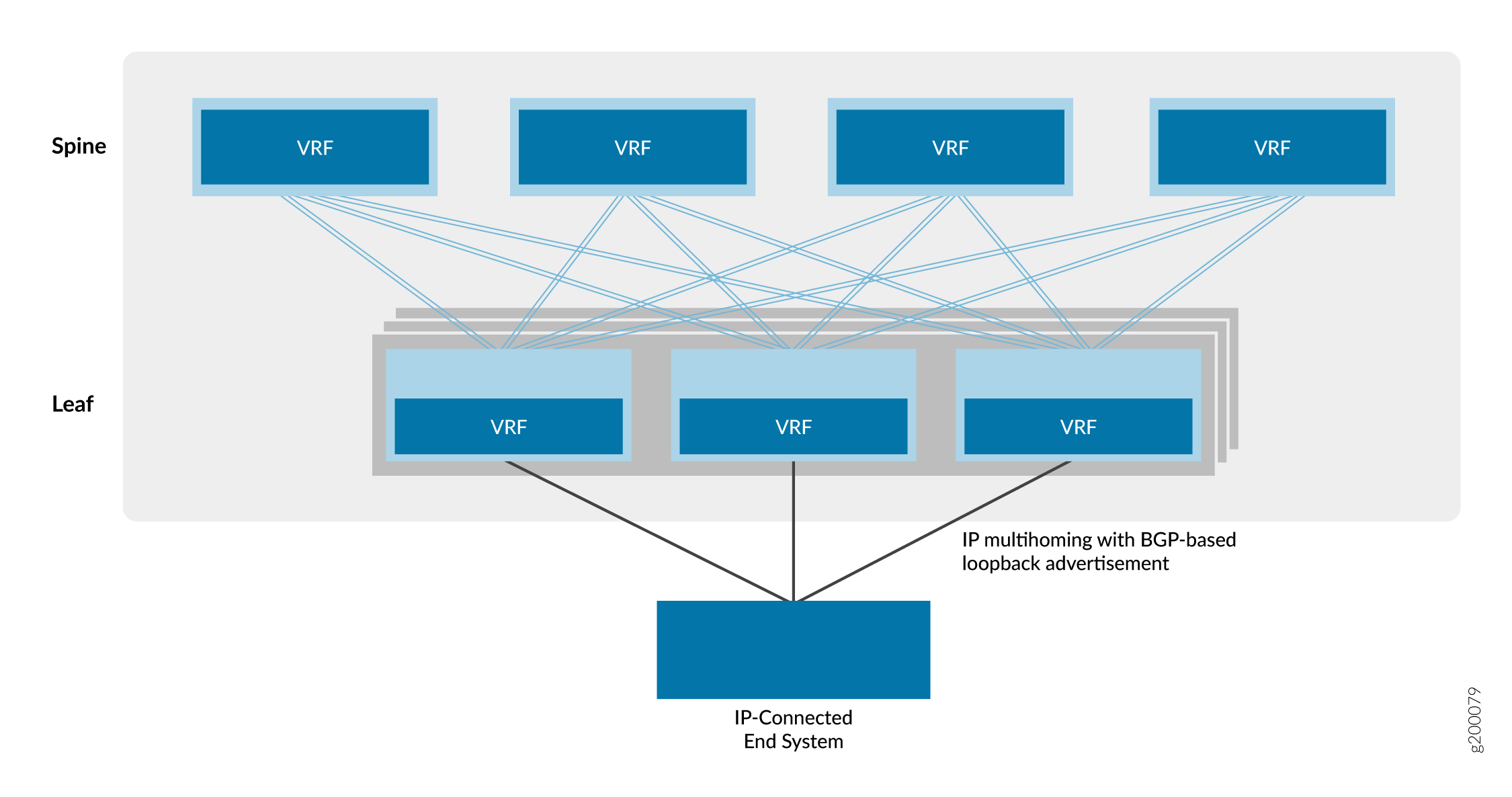

Overlay roteado usando rotas EVPN Tipo 5

A opção de overlay final é uma sobreposição roteada, como mostrado na Figura 8.

roteado

roteado

Essa opção é um serviço de rede virtual roteado por IP. Ao contrário de uma VPN IP baseada em MPLS, a rede virtual neste modelo é baseada em EVPN/VXLAN.

Os provedores de nuvem preferem essa opção de rede virtual porque a maioria dos aplicativos modernos são otimizados para IP. Como toda a comunicação entre dispositivos acontece na camada IP, não é necessário usar nenhum componente de ponte Ethernet, como VLANs e ESIs, neste modelo de overlay roteado.

Para obter informações sobre a implementação de uma sobreposição roteada, consulte o Projeto e implementação de overlay roteado.

Instâncias MAC-VRF para multitenancy em overlays de virtualização de rede

As instâncias de roteamento MAC-VRF permitem que você configure várias instâncias EVPN com diferentes tipos de serviço Ethernet em um dispositivo atuando como um VTEP em uma malha EVPN-VXLAN. Usando instâncias MAC-VRF, você pode gerenciar vários locatários no data center com tabelas VRF específicas para o cliente para isolar ou agrupar cargas de trabalho de locatários.

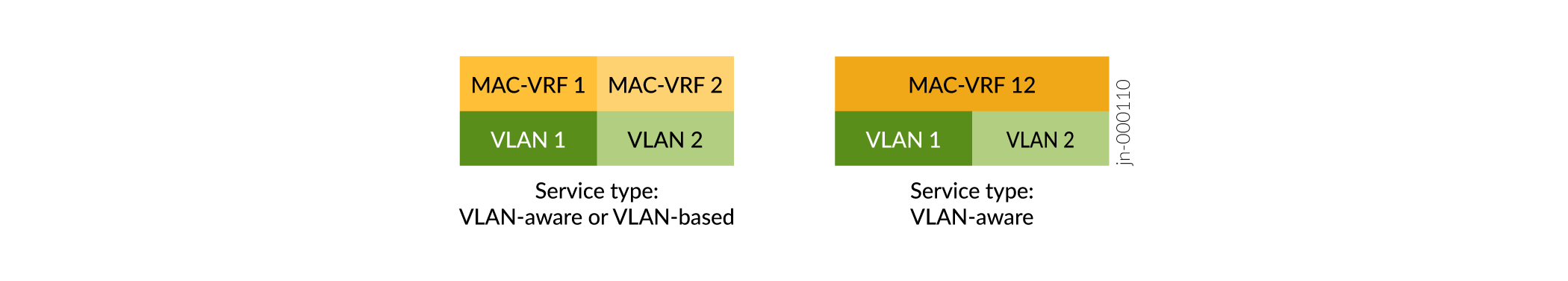

As instâncias MAC-VRF também introduzem suporte para o tipo de serviço baseado em VLAN, além do suporte anterior para o tipo de serviço com reconhecimento de VLAN. Veja a Figura 9.

de serviço MAC-VRF

de serviço MAC-VRF

-

Serviço baseado em VLAN — Você pode configurar um VLAN e o identificador de rede VXLAN (VNI) correspondentes na instância MAC-VRF. Para provisionar um novo VLAN e VNI, você deve configurar uma nova instância MAC VRF com o novo VLAN e VNI.

-

Serviço consciente de VLAN — Você pode configurar uma ou mais VLANs e as VNIs correspondentes na mesma instância MAC-VRF. Para provisionar um novo VLAN e VNI, você pode adicionar a nova configuração VLAN e VNI à instância MAC-VRF existente, que economiza algumas etapas de configuração usando um serviço baseado em VLAN.

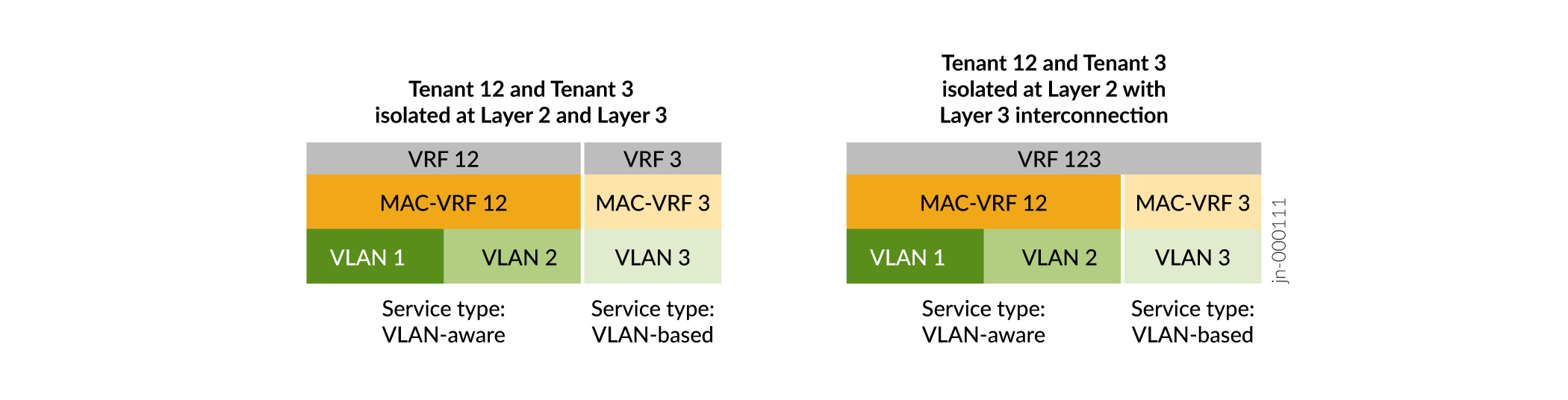

As instâncias MAC-VRF permitem opções de configuração mais flexíveis tanto na Camada 2 quanto na Camada 3. Por exemplo:

MAC-VRF

MAC-VRF

A Figura 10 mostra que, com instâncias MAC-VRF:

-

Você pode configurar diferentes tipos de serviço em diferentes instâncias MAC-VRF no mesmo dispositivo.

-

Você tem opções flexíveis de isolamento de locatários em instâncias de Camada 2 (MAC-VRF), bem como em Camada 3 (instâncias VRF). Você pode configurar uma instância VRF que corresponde à VLAN ou VLANs em uma única instância MAC-VRF. Ou você pode configurar uma instância VRF que abrange as VLANs em várias instâncias MAC-VRF.

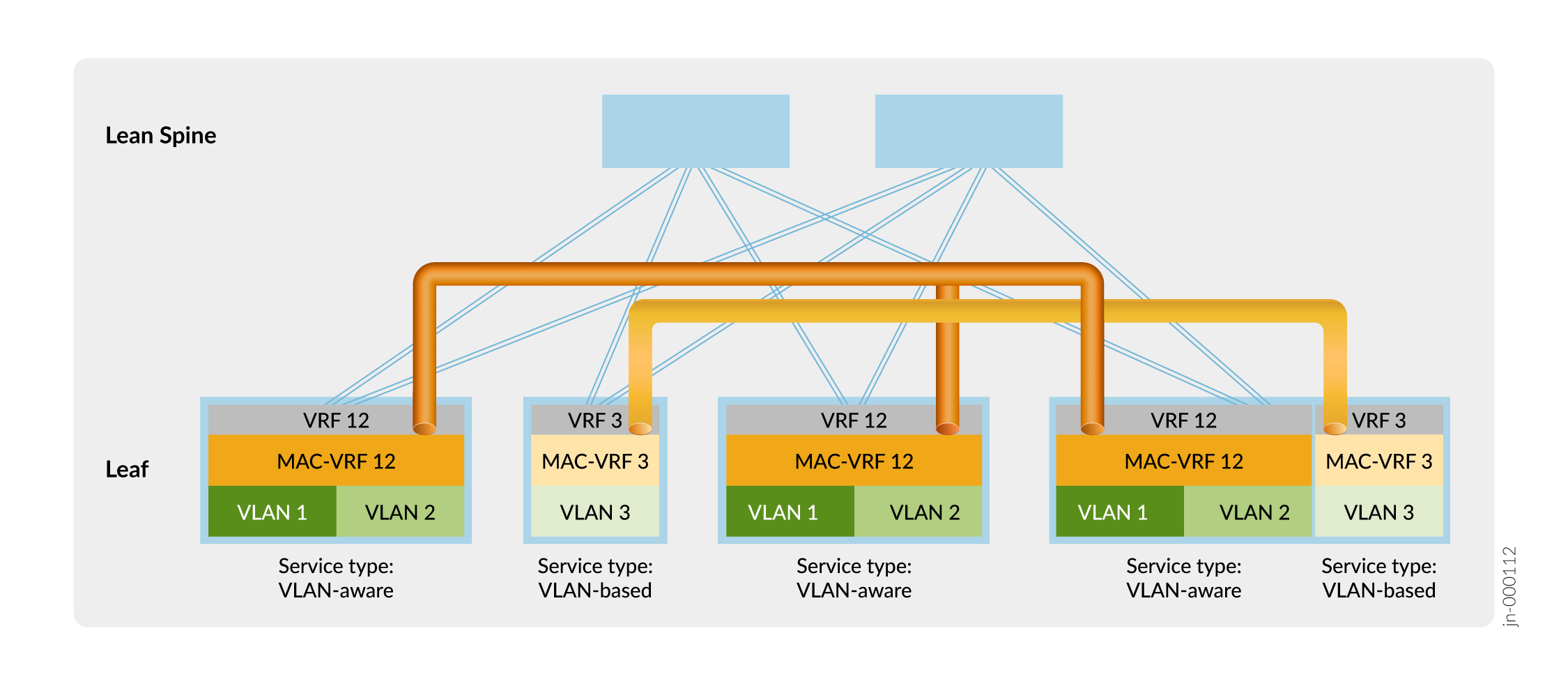

A Figura 11 mostra uma malha overlay ERB com uma configuração MAC-VRF de amostra para separação de locatários.

de locatários

de locatários

Na Figura 11, os dispositivos leaf estabelecem túneis VXLAN que mantêm o isolamento na Camada 2 entre Tenant 12 (VLAN 1 e VLAN 2) e Tenant 3 (VLAN 3) usando instâncias MAC-VRF MAC-VRF 12 e MAC-VRF 3. Os dispositivos leaf também isolam os locatários na Camada 3 usando instâncias VRF VRF 12 e VRF 3.

Você pode empregar outras opções para compartilhar tráfego VLAN entre locatários isolados na Camada 2 e Camada 3 pelas configurações MAC-VRF e VRF, como:

-

Estabeleça uma interconexão externa segura entre VRFs de locatário por meio de um firewall.

-

Configure o vazamento de rota local entre VRFs de Camada 3.

Para obter mais informações sobre instâncias MAC-VRF e usá-las em um exemplo de caso de uso do cliente, consulte EVPN-VXLAN DC IP Fabric MAC-VRF L2 Services.

As instâncias MAC-VRF correspondem a instâncias de encaminhamento da seguinte forma:

-

As instâncias MAC-VRF em switches da linha QFX5000 (incluindo aquelas que executam o Junos OS ou o Junos OS Evolved) fazem parte da instância de encaminhamento padrão. Nesses dispositivos, você não pode configurar VLANs sobrepostas em uma instância MAC-VRF ou em várias instâncias MAC-VRF.

-

Na linha de switches QFX10000, você pode configurar várias instâncias de encaminhamento e mapear uma instância MAC-VRF para uma determinada instância de encaminhamento. Você também pode mapear várias instâncias MAC-VRF para a mesma instância de encaminhamento. Se você configurar cada instância MAC-VRF para usar uma instância de encaminhamento diferente, você pode configurar VLANs sobrepostas em várias instâncias MAC-VRF. Você não pode configurar VLANs sobrepostas em uma única instância MAC-VRF ou em instâncias MAC-VRF que mapeiam para a mesma instância de encaminhamento.

-

Na configuração padrão, os switches incluem um VLAN padrão com VLAN ID=1 associado à instância de encaminhamento padrão. Como os IDs VLAN devem ser exclusivos em uma instância de encaminhamento, se você quiser configurar uma VLAN com VLAN ID=1 em uma instância MAC-VRF que usa a instância de encaminhamento padrão, você deve realocar o ID VLAN do VLAN padrão para um valor diferente de 1. Por exemplo:

set vlans default vlan-id 4094 set routing-instances mac-vrf-instance-name vlans vlan-name vlan-id 1

Os exemplos de configuração de sobreposição de virtualização de rede de referência neste guia incluem etapas para configurar a sobreposição usando instâncias MAC-VRF. Você configura uma instância de roteamento EVPN do tipo mac-vrfe define um diferencial de rota e um alvo de rota na instância. Você também inclui as interfaces desejadas (incluindo uma interface de origem VTEP), VLANs e mapeamentos VLAN-to-VNI na instância. Veja as configurações de referência nos seguintes tópicos:

-

Design e implementação bridged Overlay — você configura instâncias MAC-VRF nos dispositivos leaf.

-

Projeto e implementação de sobreposição de pontes roteadas centralmente — você configura instâncias MAC-VRF nos dispositivos spine. Nos dispositivos leaf, a configuração MAC-VRF é semelhante à configuração de leaf MAC-VRF em um design de overlay em ponte.

-

Projeto e implementação de sobreposição de pontes roteadas por borda — você configura instâncias MAC-VRF nos dispositivos leaf.

Um dispositivo pode ter problemas com a escalabilidade do VTEP quando a configuração usa várias instâncias MAC-VRF. Como resultado, para evitar esse problema, exigimos que você habilite o recurso de túneis compartilhados na linha QFX5000 de switches que executa o Junos OS com uma configuração de instância MAC-VRF. Ao configurar túneis compartilhados, o dispositivo minimiza o número de entradas de próximo salto para alcançar VTEPs remotos. Você habilita túneis VXLAN compartilhados no dispositivo usando a shared-tunnels declaração no nível de [edit forwarding-options evpn-vxlan] hierarquia. Essa configuração exige que você reinicialize o dispositivo.

Essa declaração é opcional na linha QFX10000 de switches que executam o Junos OS, que pode lidar com escalas de VTEP mais altas do que os switches QFX5000.

Em dispositivos que executam o Junos OS Evolved em malhas EVPN-VXLAN, os túneis compartilhados são habilitados por padrão. O Junos OS Evolved oferece suporte apenas à EVPN-VXLAN com configurações MAC-VRF.

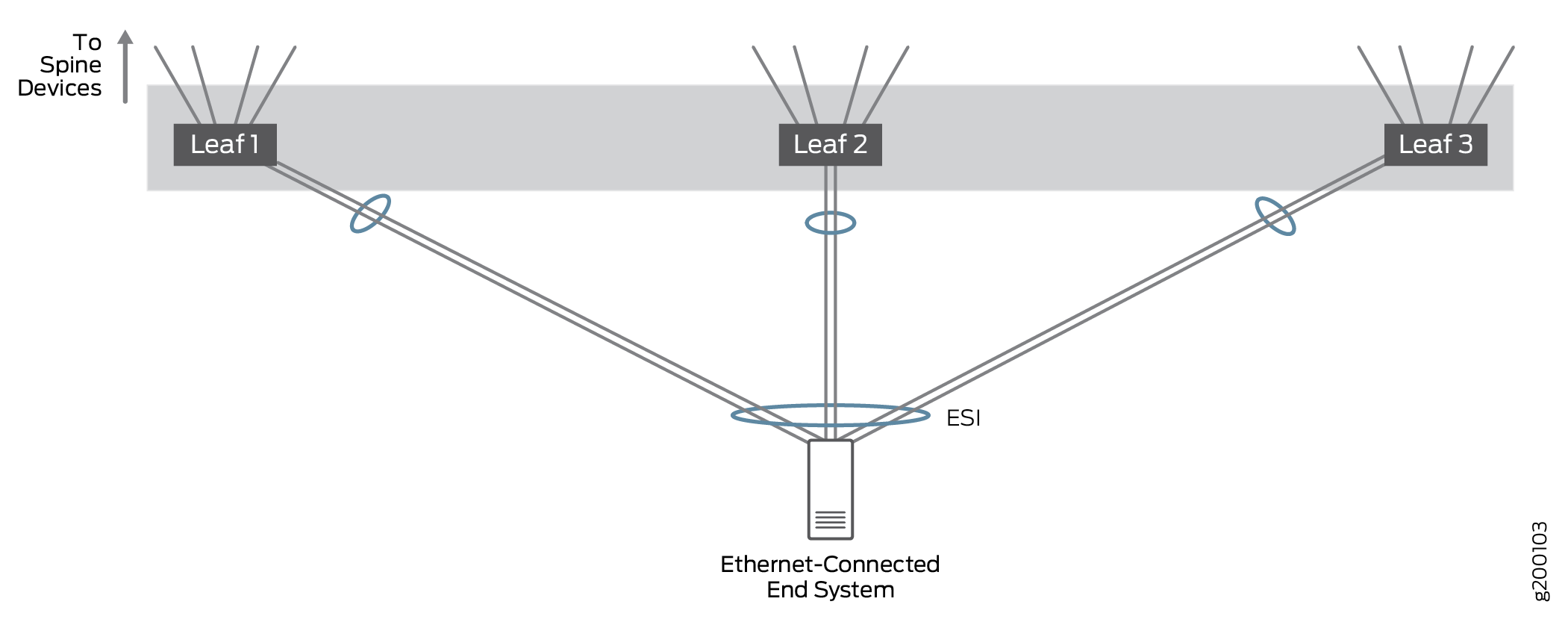

Suporte multihoming para sistemas finais conectados por ethernet

O multihoming conectado por ethernet permite que sistemas finais conectados por Ethernet se conectem à rede overlay Ethernet por meio de um link de casa única a um dispositivo VTEP ou por vários links multihomed a diferentes dispositivos VTEP. O tráfego Ethernet é equilibrado em toda a malha entre VTEPs em dispositivos leaf que se conectam ao mesmo sistema final.

Testamos configurações em que um sistema final conectado por Ethernet estava conectado a um único dispositivo leaf ou dispositivos de 2 ou 3 leaf para provar que o tráfego é tratado corretamente em configurações multihomed com mais de dois dispositivos VTEP leaf; na prática, um sistema final conectado por Ethernet pode ser multihomed para um grande número de dispositivos VTEP leaf. Todos os links estão ativos e o tráfego de rede pode ser equilibrado em todos os links multihomed.

Nesta arquitetura, a EVPN é usada para multihoming conectado à Ethernet. Os LAGs multihomed EVPN são identificados por um identificador de segmentos Ethernet (ESI) na sobreposição de pontes EVPN, enquanto o LACP é usado para melhorar a disponibilidade de LAG.

O tronco VLAN permite que uma interface ofereça suporte a várias VLANs. O tronco de VLAN garante que as máquinas virtuais (VMs) em hipervisores não overlay possam operar em qualquer contexto de rede overlay.

Para obter mais informações sobre o suporte a multihoming conectado à Ethernet, veja Multihoming em um projeto e implementação de sistema final conectado por ethernet.

Suporte multihoming para sistemas finais conectados por IP

Sistemas de endpoint multihoming conectados por IP para se conectar à rede IP em várias interfaces de acesso baseadas em IP em diferentes dispositivos leaf.

Testamos configurações em que um sistema final conectado por IP estava conectado a um único leaf ou multihomed a 2 ou 3 dispositivos leaf. A configuração validou que o tráfego é tratado corretamente quando multihomed para vários dispositivos leaf; na prática, um sistema final conectado por IP pode ser multihomed para um grande número de dispositivos leaf.

Em configurações multihomed, todos os links estão ativos e o tráfego de rede é encaminhado e recebido em todos os links multihomed. O tráfego IP é equilibrado em todos os links multihomed usando um algoritmo de hashing simples.

O EBGP é usado para trocar informações de roteamento entre o sistema de endpoint conectado por IP e os dispositivos leaf conectados para garantir que a rota ou as rotas para os sistemas de endpoint sejam compartilhadas com todos os dispositivos spine e leaf.

Para obter mais informações sobre o bloco de construção multihoming conectado por IP, veja Multihoming um projeto e implementação de sistema final conectados por IP.

Dispositivos de borda

Alguns de nossos designs de referência incluem dispositivos de borda que fornecem conexões aos seguintes dispositivos, que são externos à malha IP local:

Um gateway multicast.

Um gateway de data center para interconexão de data center (DCI).

Um dispositivo como um roteador SRX no qual vários serviços, como firewalls, Network Address Translation (NAT), detecção e prevenção de invasões (IDP), multicast, etc. estão consolidados. A consolidação de vários serviços em um dispositivo físico é conhecida como encadeamento de serviços.

Dispositivos ou servidores que atuam como firewalls, servidores DHCP, coletores de sFlow etc.

Nota:Se sua rede incluir dispositivos ou servidores legados que exijam uma conexão Ethernet de 1 Gbps a um dispositivo de borda, recomendamos usar um QFX10008 ou um switch QFX5120 como dispositivo de borda.

Para fornecer a funcionalidade adicional descrita acima, a Juniper Networks oferece suporte à implantação de um dispositivo de borda das seguintes maneiras:

Como um dispositivo que serve apenas como um dispositivo de borda. Nesta função dedicada, você pode configurar o dispositivo para lidar com uma ou mais das tarefas descritas acima. Para essa situação, o dispositivo normalmente é implantado como um leaf de borda, que é conectado a um dispositivo spine.

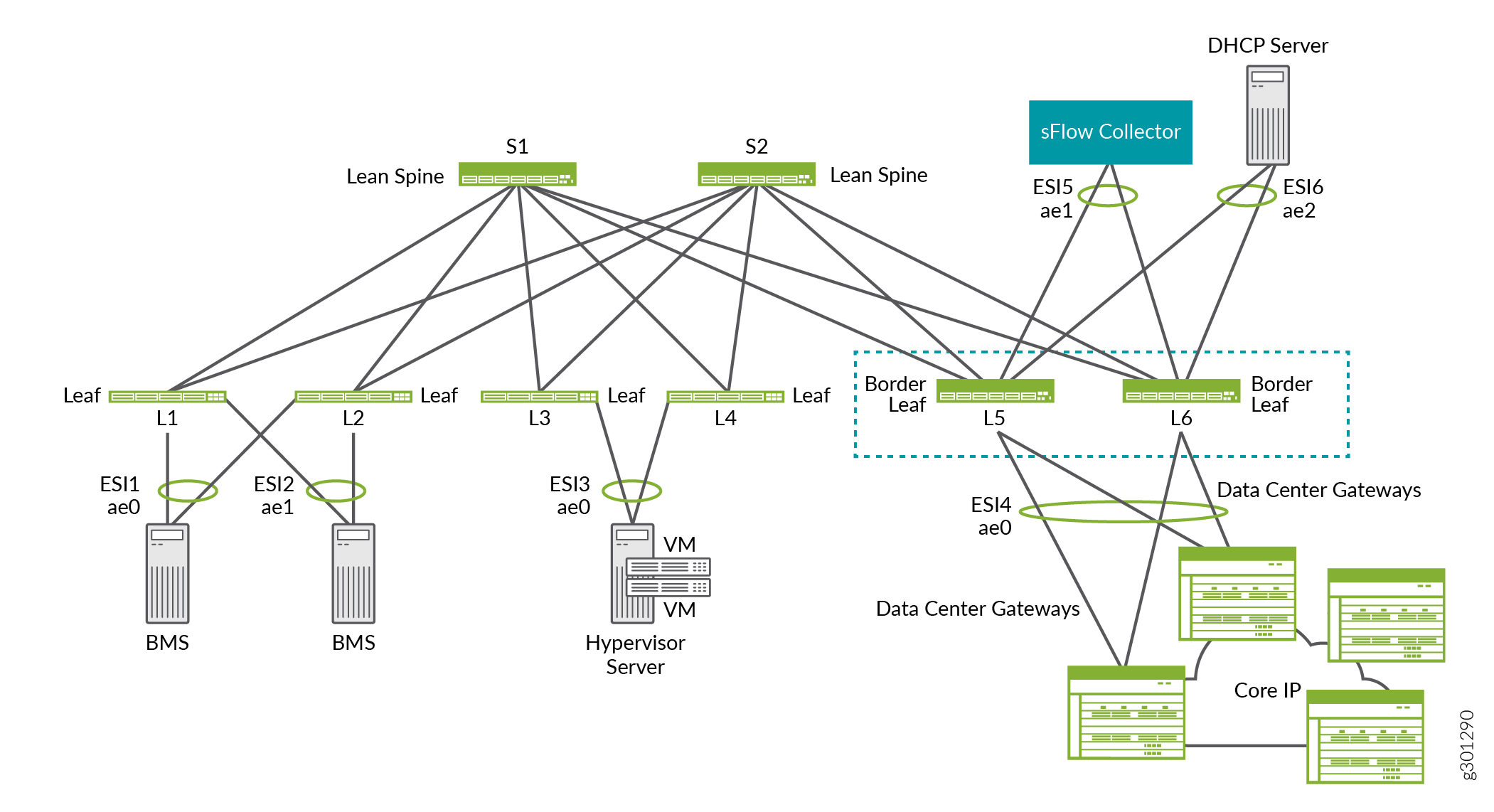

Por exemplo, no overlay ERB mostrado na Figura 14, os leafs de borda L5 e L6 fornecem conectividade a gateways de data center para DCI, um coletor de sFlow e um servidor DHCP.

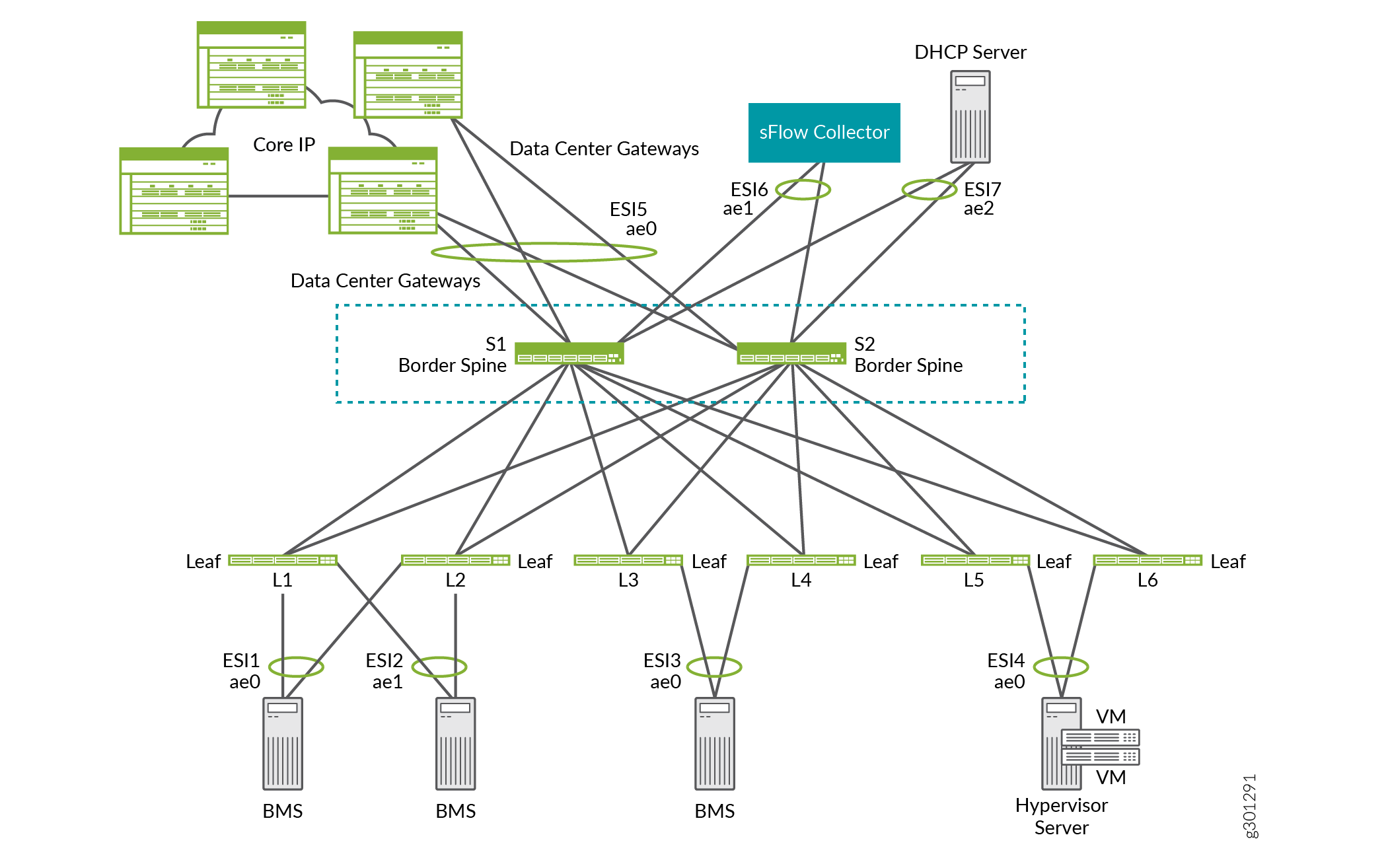

Como um dispositivo que tem duas funções — um dispositivo underlay de rede e um dispositivo de borda que pode lidar com uma ou mais das tarefas descritas acima. Para essa situação, um dispositivo spine geralmente lida com as duas funções. Portanto, a funcionalidade do dispositivo de borda é referida como uma spine de borda.

Por exemplo, no overlay ERB mostrado na Figura 15, os spines de borda S1 e S2 funcionam como dispositivos lean spine. Eles também fornecem conectividade a gateways de data center para DCI, um coletor de sFlow e um servidor DHCP.

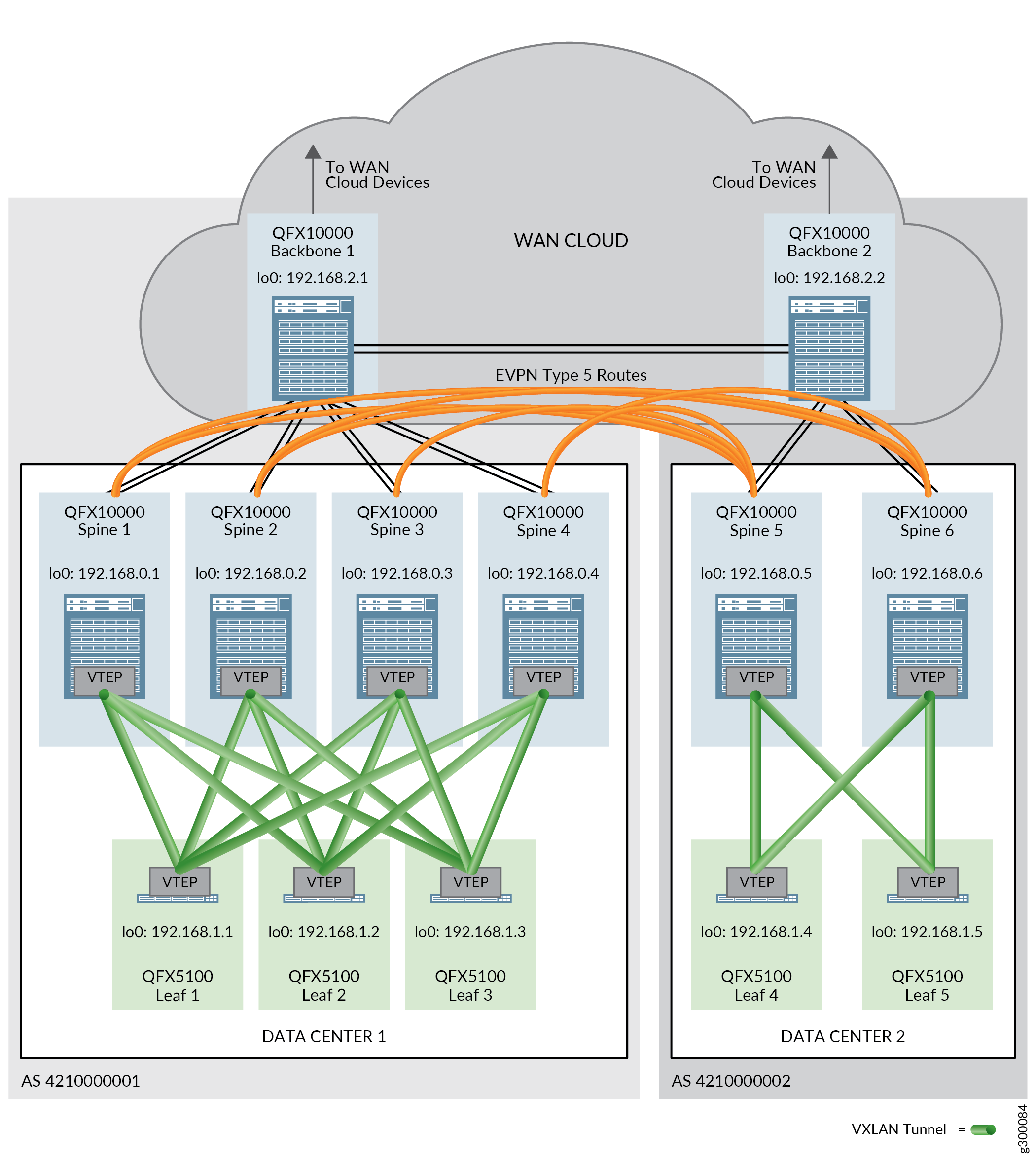

Interconexão de data center (DCI)

O bloco de construção da interconexão de data center (DCI) oferece a tecnologia necessária para enviar tráfego entre data centers. O projeto validado oferece suporte a DCI usando rotas EVPN Tipo 5, rotas IPVPN e DCI de Camada 2 com pontos VXLAN.

As rotas EVPN Tipo 5 ou IPVPN são usadas em um contexto de DCI para garantir que o tráfego entre data centers entre data centers usando diferentes esquemas de sub-rede de endereços IP possa ser trocado. As rotas são trocadas entre dispositivos spine em diferentes data centers para permitir a passagem do tráfego entre data centers.

A conectividade física entre os data centers é necessária antes que você possa configurar a DCI. A conectividade física é fornecida por dispositivos de backbone em uma nuvem WAN. Um dispositivo de backbone é conectado a todos os dispositivos spine em um único data center (POD), bem como aos outros dispositivos de backbone que estão conectados aos outros data centers.

Para obter informações sobre a configuração do DCI, veja:

Encadeamento de serviços

Em muitas redes, é comum o tráfego fluir por dispositivos de hardware separados que cada um fornece um serviço, como firewalls, NAT, IDP, multicast e assim por diante. Cada dispositivo requer operação e gerenciamento separados. Esse método de ligação de várias funções de rede pode ser considerado como encadeamento físico de serviços.

Um modelo mais eficiente para o encadeamento de serviços é virtualizar e consolidar funções de rede em um único dispositivo. Em nossa arquitetura de blueprint, estamos usando os roteadores da Série SRX como o dispositivo que consolida funções e processos de rede e aplica serviços. Esse dispositivo é chamado de função de rede física (PNF).

Nesta solução, o encadeamento de serviços é suportado tanto na sobreposição do CRB quanto na sobreposição da ERB. Funciona apenas para tráfego entre locatários.

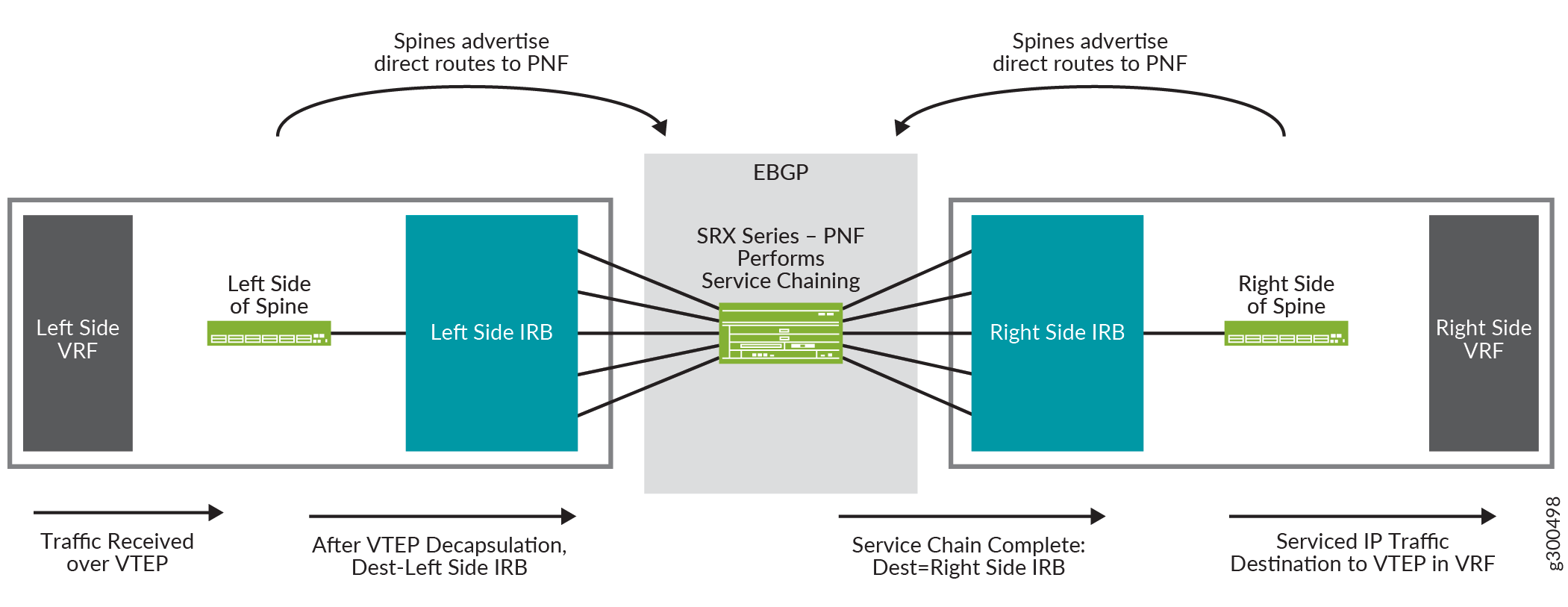

Visão lógica do encadeamento de serviços

A Figura 17 mostra uma visão lógica do encadeamento de serviços. Ele mostra uma spine com uma configuração lateral direita e uma configuração lateral esquerda. De cada lado está uma instância de roteamento VRF e uma interface IRB. O roteador da Série SRX no centro é o PNF, e executa o encadeamento de serviços.

do encadeamento de serviços

do encadeamento de serviços

O fluxo de tráfego nesta visão lógica é:

-

A spine recebe um pacote no VTEP que está no VRF lateral esquerdo.

-

O pacote é descapsulado e enviado para a interface IRB do lado esquerdo.

-

A interface IRB roteia o pacote para o roteador da Série SRX, que está atuando como a PNF.

-

O roteador da Série SRX realiza o encadeamento de serviço no pacote e encaminha o pacote de volta para a spine, onde é recebido na interface IRB mostrada no lado direito da spine.

-

A interface IRB encaminha o pacote para o VTEP no lado direito VRF.

Para obter informações sobre a configuração do encadeamento de serviços, consulte Design e implementação de encadeamento de serviços.

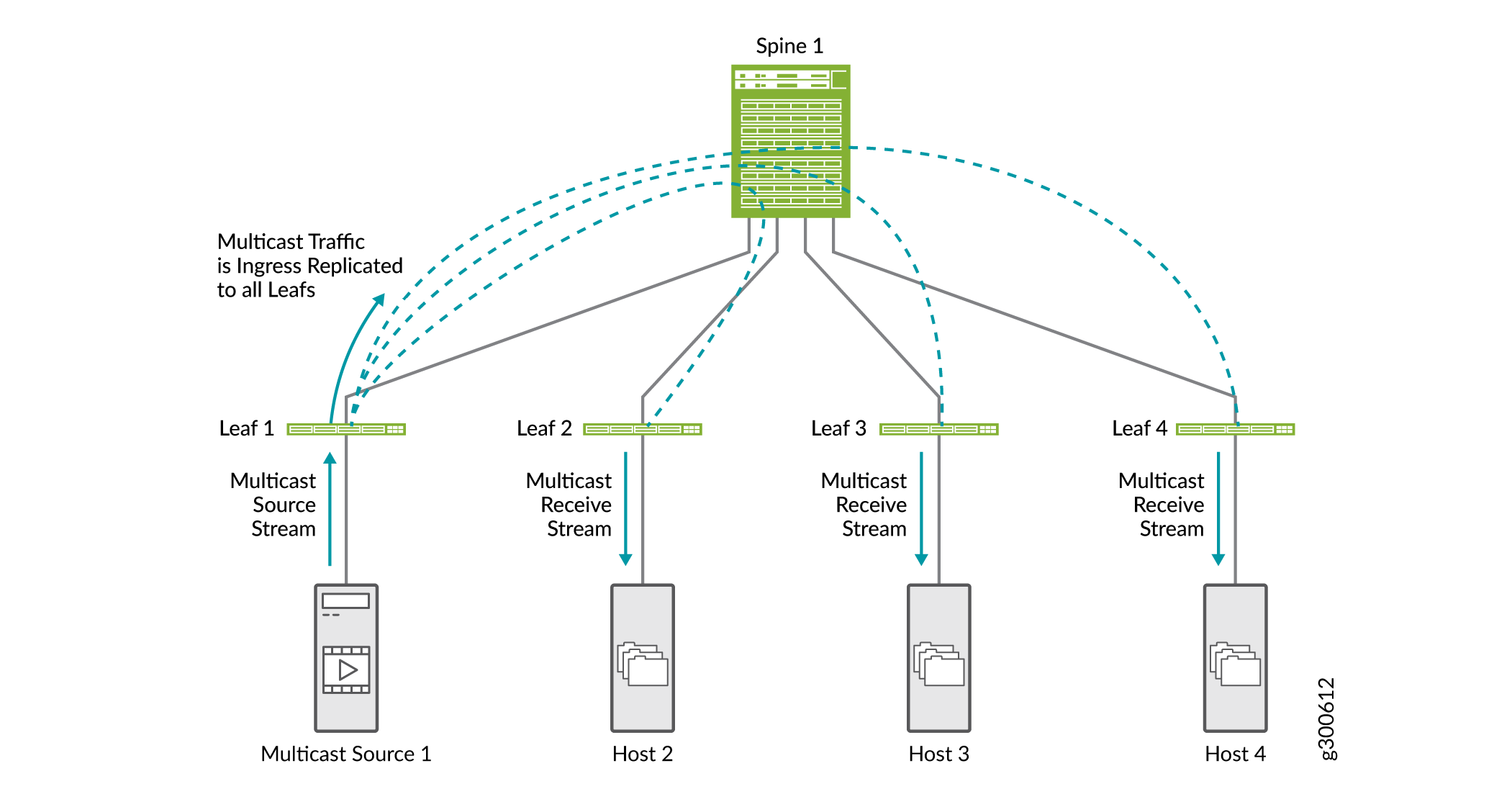

Otimizações multicast

Otimizações multicast ajudam a preservar a largura de banda e rotear o tráfego de forma mais eficiente em um cenário multicast em ambientes EVPN VXLAN. Sem qualquer otimização multicast configurada, toda a replicação multicast é feita na entrada da leaf conectada à fonte multicast, conforme mostrado na Figura 18. O tráfego multicast é enviado a todos os dispositivos leaf que estão conectados à spine. Cada dispositivo leaf envia tráfego para hosts conectados.

Existem alguns tipos de otimizações multicast suportadas em ambientes EVPN VXLAN que podem trabalhar juntos:

Para obter informações sobre a configuração de recursos multicast, veja:

- IGMP Snooping

- Encaminhamento multicast seletivo

- Replicação assistida de tráfego multicast

- Multicast intersubnet otimizado para redes overlay ERB

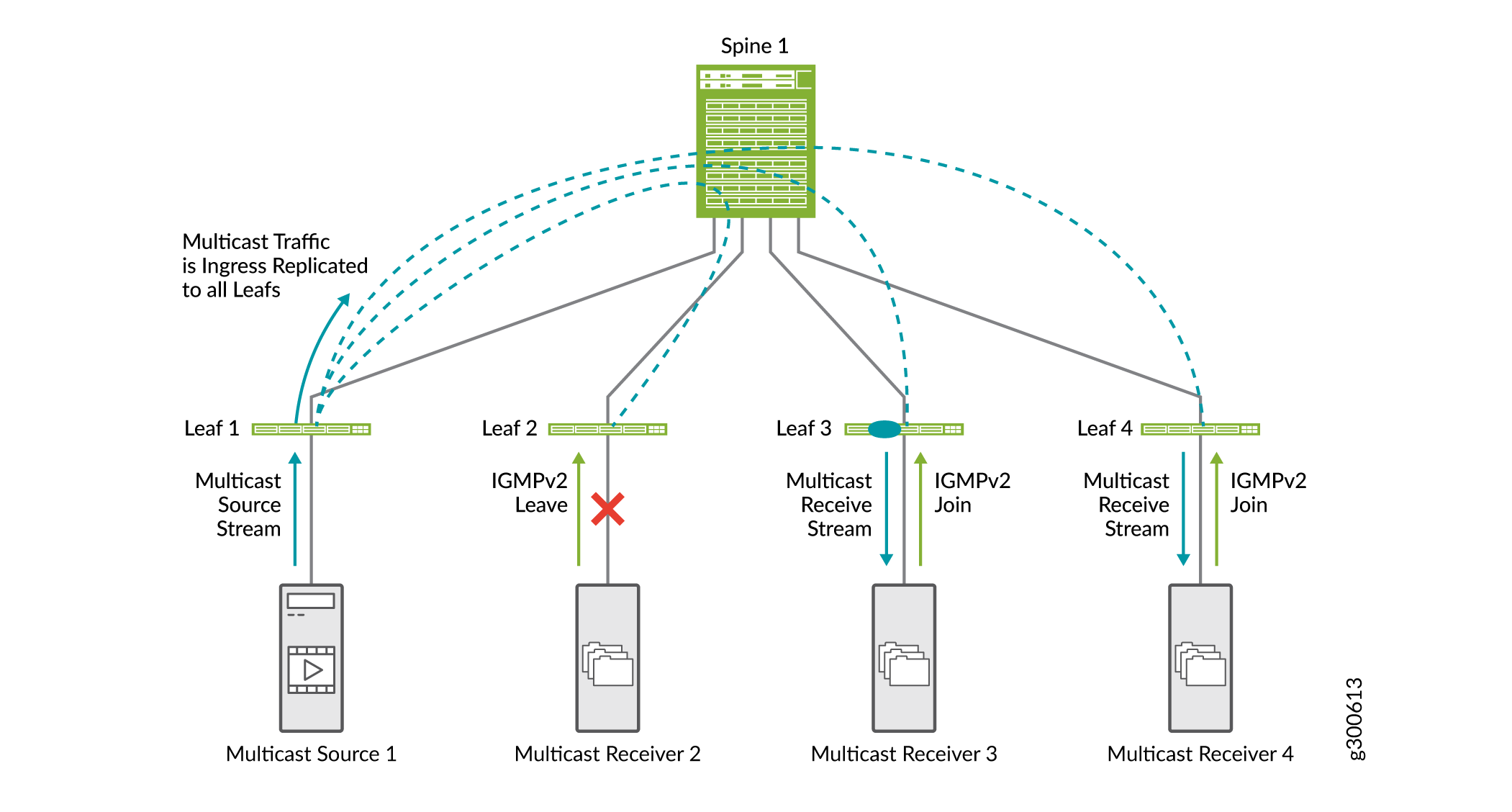

IGMP Snooping

A espionagem de IGMP em uma malha EVPN-VXLAN é útil para otimizar a distribuição do tráfego multicast. A espionagem do IGMP preserva a largura de banda, pois o tráfego multicast é encaminhado apenas em interfaces onde há usuários IGMP. Nem todas as interfaces de um dispositivo leaf precisam receber tráfego multicast.

Sem a espionagem do IGMP, os sistemas finais recebem tráfego IP multicast no qual não têm interesse, o que inunda desnecessariamente seus links com tráfego indesejado. Em alguns casos, quando os fluxos ip multicast são grandes, inundar tráfego indesejado causa problemas de negação de serviço.

A Figura 19 mostra como a espionagem do IGMP funciona em uma malha EVPN-VXLAN. Nesta amostra da malha EVPN-VXLAN, a snooping de IGMP está configurada em todos os dispositivos leaf, e o receptor multicast 2 já enviou uma solicitação de adesão ao IGMPv2.

-

O Multicast Receiver 2 envia uma solicitação de licença IGMPv2.

-

Os receptores multicast 3 e 4 enviam uma solicitação de adesão ao IGMPv2.

-

Quando o Leaf 1 recebe tráfego multicast de entrada, ele o replica para todos os dispositivos leaf e o encaminha para a spine.

-

A spine encaminha o tráfego para todos os dispositivos leaf.

-

O Leaf 2 recebe o tráfego multicast, mas não o encaminha para o receptor porque o receptor enviou uma mensagem de licença IGMP.

Nas redes EVPN-VXLAN, apenas o IGMP versão 2 é suportado.

Para obter mais informações sobre a espionagem do IGMP, veja a visão geral do encaminhamento multicast com O IGMP Snooping ou MLD Snooping em um ambiente EVPN-VXLAN.

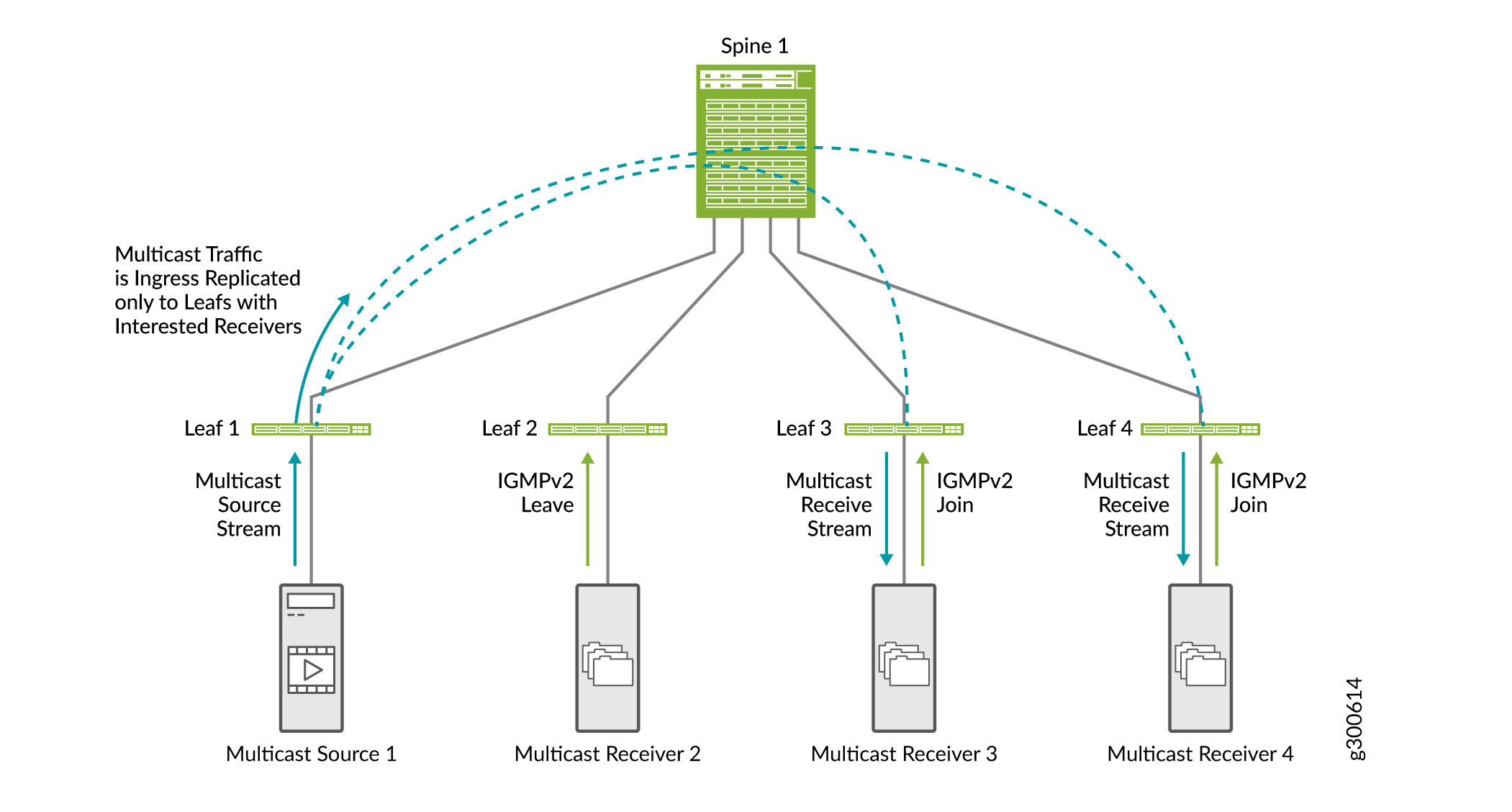

Encaminhamento multicast seletivo

O encaminhamento seletivo de Ethernet multicast (SMET) oferece maior eficiência de rede de ponta a ponta e reduz o tráfego na rede EVPN. Ele conserva o uso de largura de banda no núcleo da malha e reduz a carga em dispositivos de saída que não têm escutas.

Dispositivos com snooping IGMP permitiram usar o encaminhamento multicast seletivo para encaminhar tráfego multicast de forma eficiente. Com a espionagem IGMP habilitada, um dispositivo leaf envia tráfego multicast apenas para a interface de acesso com um receptor interessado. Com o SMET adicionado, o dispositivo leaf envia tráfego multicast seletivamente apenas para os dispositivos leaf no núcleo que manifestaram interesse nesse grupo multicast.

A Figura 20 mostra o fluxo de tráfego SMET junto com a espionagem do IGMP.

-

O Multicast Receiver 2 envia uma solicitação de licença IGMPv2.

-

Os receptores multicast 3 e 4 enviam uma solicitação de adesão ao IGMPv2.

-

Quando o leaf 1 recebe tráfego multicast de entrada, ele replica o tráfego apenas para dispositivos leaf com receptores interessados (dispositivos leaf 3 e 4) e o encaminha para a spine.

-

A spine encaminha o tráfego para dispositivos leaf 3 e 4.

IGMP

IGMP

Você não precisa habilitar o SMET; ele é habilitado por padrão quando a espionagem do IGMP é configurada no dispositivo.

Para obter mais informações sobre o SMET, veja a visão geral do encaminhamento seletivo multicast.

Replicação assistida de tráfego multicast

O recurso de replicação assistida (AR) descarrega dispositivos leaf de malha EVPN-VXLAN de tarefas de replicação de entrada. A folha de entrada não replica o tráfego multicast. Ele envia uma cópia do tráfego multicast para uma spine que é configurada como um dispositivo replicador AR. O dispositivo replicador AR distribui e controla o tráfego multicast. Além de reduzir a carga de replicação nos dispositivos leaf de entrada, esse método conserva a largura de banda na malha entre a folha e a spine.

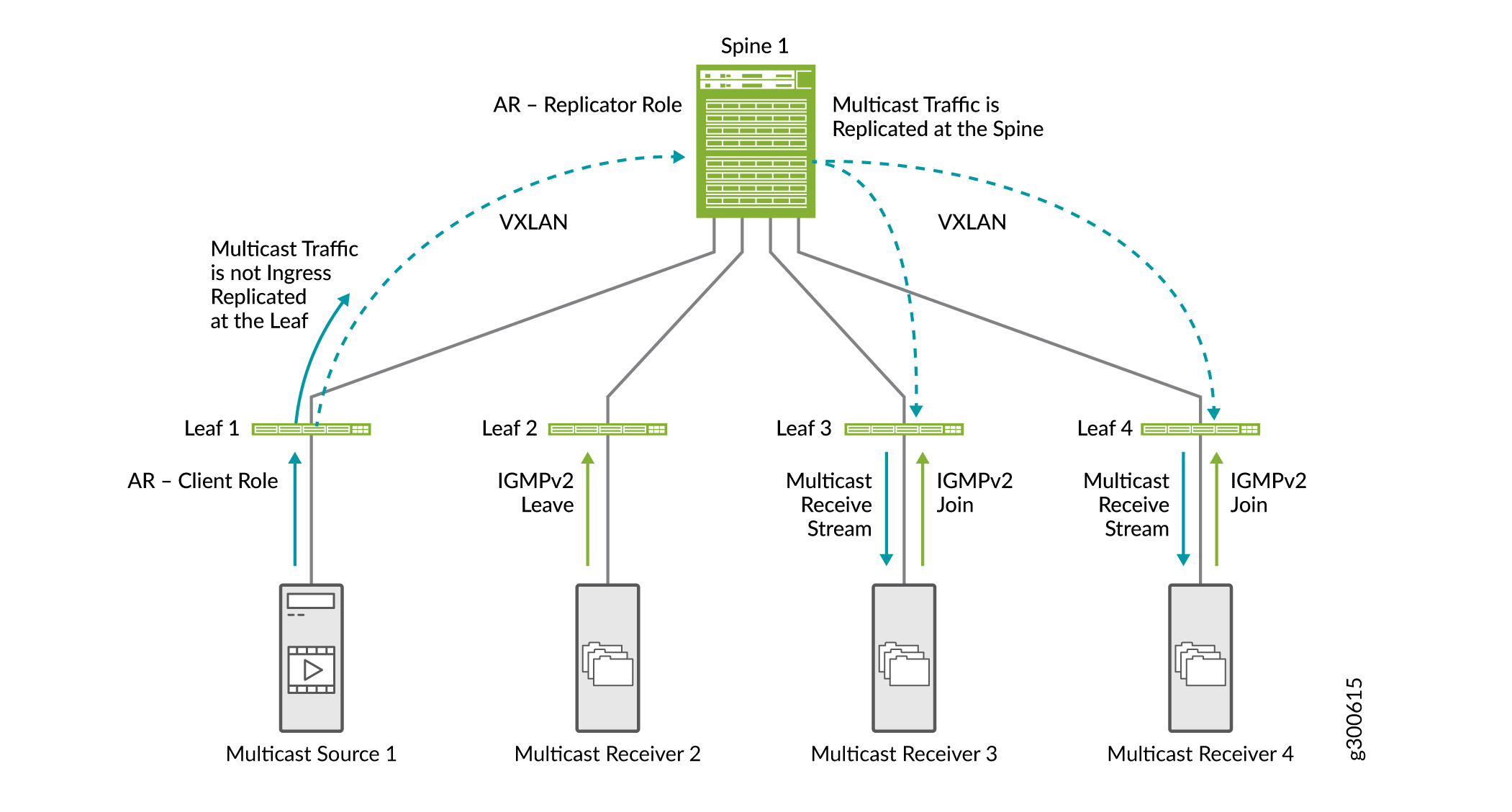

A Figura 21 mostra como o AR funciona junto com a espionagem do IGMP e o SMET.

-

O Leaf 1, que é configurado como o dispositivo leaf AR, recebe tráfego multicast e envia uma cópia para a spine que é configurada como o dispositivo replicador AR.

-

A spine replica o tráfego multicast. Ele replica o tráfego para dispositivos leaf que são provisionados com o VNI VLAN no qual o tráfego multicast se originou do Leaf 1.

Como temos o IGMP e o SMET configurados na rede, a spine envia o tráfego multicast apenas para dispositivos leaf com receptores interessados.

Neste documento, mostramos otimizações multicast em pequena escala. Em uma rede de grande escala com muitas spines e leafs, os benefícios das otimizações são muito mais aparentes.

Multicast intersubnet otimizado para redes overlay ERB

Quando você tem fontes multicast e receptores dentro e fora de uma malha de sobreposição ERB, você pode configurar multicast multicast (OISM) otimizado para permitir um fluxo de tráfego multicast eficiente em escala.

O OISM usa um modelo de roteamento local para tráfego multicast, o que evita o encoberto do tráfego e minimiza a carga de tráfego dentro do núcleo EVPN. O OISM encaminha tráfego multicast apenas na VLAN de origem multicast. Para receptores intersubnet, os dispositivos leaf usam interfaces IRB para rotear localmente o tráfego recebido na VLAN de origem para outras VLANs receptoras no mesmo dispositivo. Para otimizar ainda mais o fluxo de tráfego multicast na malha EVPN-VXLAN, a OISM usa o IGMP e o SMET para encaminhar o tráfego na malha apenas para dispositivos leaf com receptores interessados.

O OISM também permite que a malha encaminhe efetivamente o tráfego de fontes multicast externas para receptores internos, e de fontes internas multicast a receptores externos. O OISM usa um domínio de ponte suplementar (SBD) dentro da malha para encaminhar o tráfego multicast recebido nos dispositivos leaf de borda de fontes externas. O projeto SBD preserva o modelo de roteamento local para tráfego de origem externa.

Você pode usar o OISM com AR para reduzir a carga de replicação em dispositivos leaf OISM de menor capacidade. (Veja replicação assistida do tráfego multicast.)

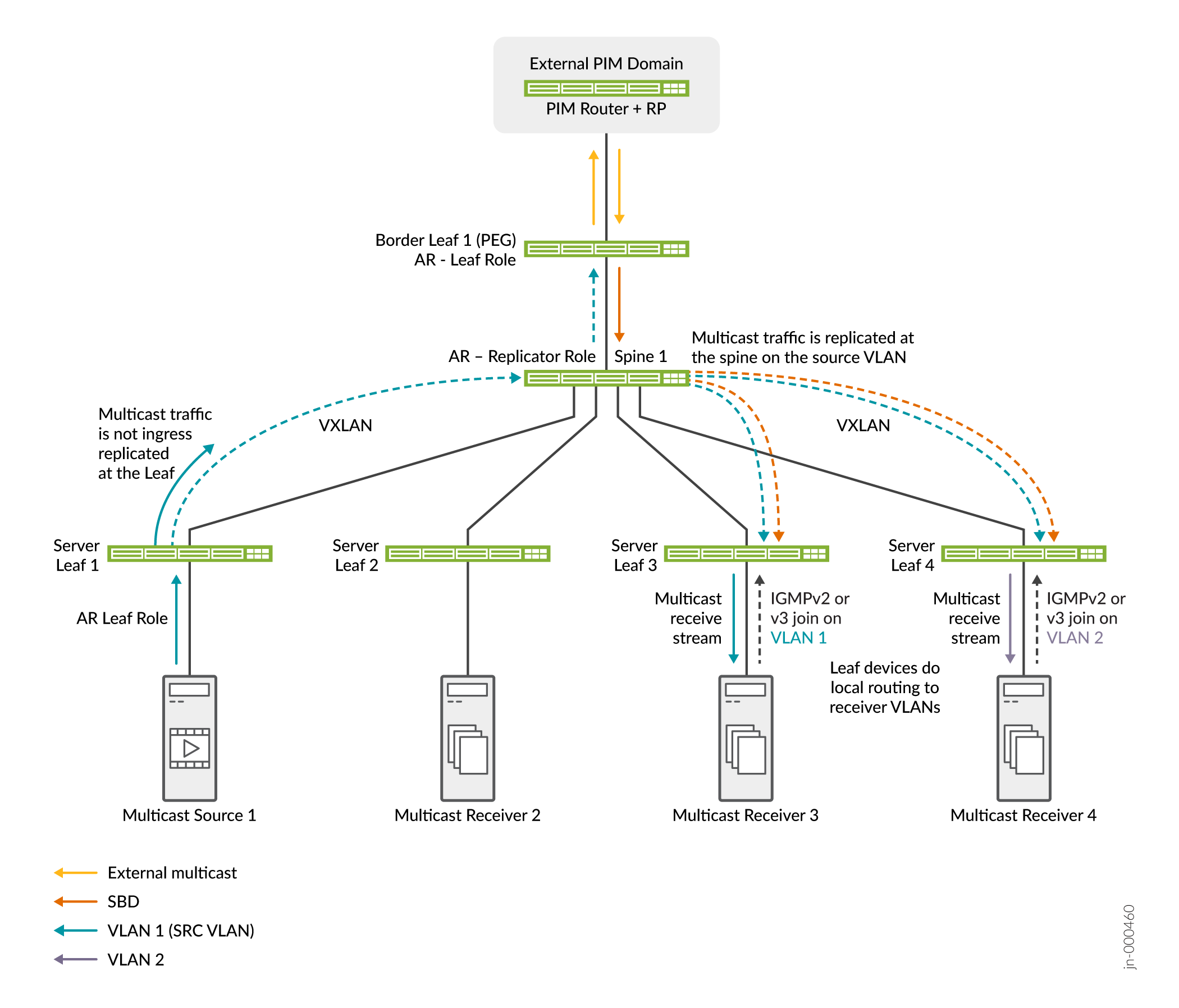

Veja a Figura 22 para uma malha simples com OISM e AR.

A Figura 22 mostra dispositivos leaf de servidor OISM e leaf de borda, Spine 1 na função de replicador AR e Server Leaf 1 como uma fonte multicast na função leaf AR. Uma fonte externa e receptores também podem existir no domínio PIM externo. O OISM e o AR trabalham juntos neste cenário da seguinte forma:

-

Receptores multicast por trás do Server Leaf 3 na VLAN 1 e atrás do Server Leaf 4 na VLAN 2 enviam Juntas de IGMP mostrando interesse no grupo multicast. Receptores externos também podem se juntar ao grupo multicast.

-

A fonte multicast por trás do Server Leaf 1 envia tráfego multicast para o grupo na malha da VLAN 1. O Servidor Leaf 1 envia apenas uma cópia do tráfego para o replicador AR no Spine 1.

-

Além disso, o tráfego de fonte externa para o grupo multicast chega ao Border Leaf 1. O Border Leaf 1 encaminha o tráfego na SBD para Spine 1, o replicador AR.

-

O replicador AR envia cópias da fonte interna na VLAN de origem e da fonte externa na SBD para os dispositivos leaf OISM com receptores interessados.

-

Os dispositivos leaf de servidor encaminham o tráfego para os receptores na VLAN de origem e encaminham localmente o tráfego para os receptores nas outras VLANs.

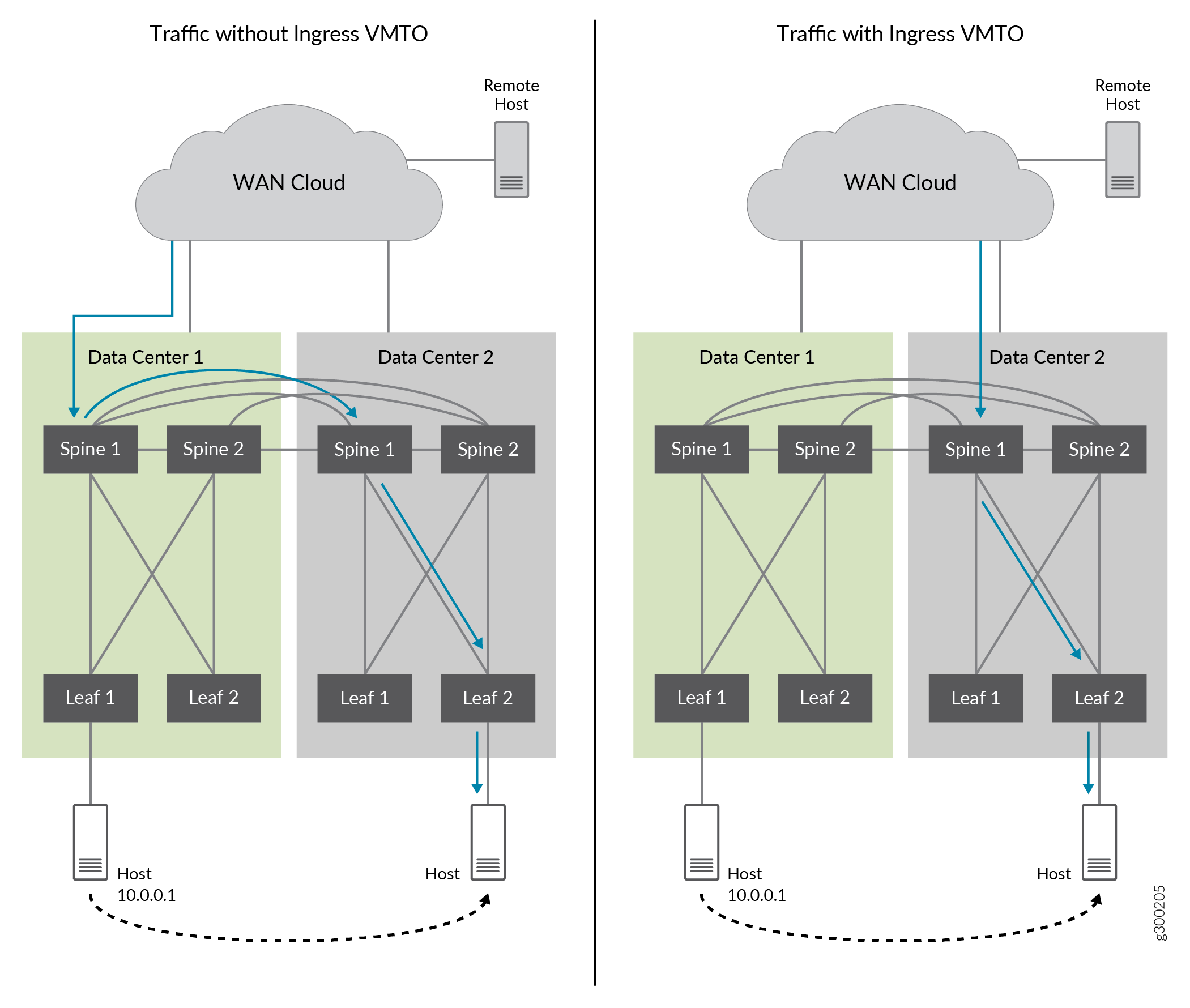

Otimização de tráfego de máquina virtual de entrada para EVPN

Quando máquinas virtuais e hosts são movidos dentro de um data center ou de um data center para outro, o tráfego de rede pode se tornar ineficiente se o tráfego não for roteado para o gateway ideal. Isso pode acontecer quando um host é realocado. A tabela ARP nem sempre é lavada e o fluxo de dados para o host é enviado para o gateway configurado, mesmo quando há um gateway mais ideal. O tráfego é "tromboned" e roteado desnecessariamente para o gateway configurado.

A otimização de tráfego de máquina virtual (VMTO) de entrada oferece maior eficiência de rede e otimiza o tráfego de entrada e pode eliminar o efeito trombone entre VLANs. Quando você habilita o VMTO de entrada, as rotas são armazenadas em uma tabela de roteamento e encaminhamento virtual de Camada 3 (VRF) e o dispositivo roteia o tráfego de entrada diretamente de volta para o host que foi realocado.

A Figura 23 mostra tráfego enlatado sem VMTO de entrada e tráfego otimizado com VMTO de entrada habilitado.

Sem VMTO de entrada, Spine 1 e 2 de DC1 e DC2 anunciam a rota remota de host IP 10.0.0.1 quando a rota de origem é de DC2. O tráfego de entrada pode ser direcionado ao Spine 1 e 2 em DC1. Em seguida, é roteado para spine 1 e 2 em DC2 onde a rota 10.0.0.1 foi movida. Isso causa o efeito tromboning.

Com o VMTO de entrada, podemos alcançar um caminho de encaminhamento ideal configurando uma política para a rota de host IP (10.0.01) a ser anunciada apenas pelo Spine 1 e 2 a partir de DC2, e não de DC1 quando o host IP é transferido para DC2.

de entrada

de entrada

Para obter informações sobre a configuração do VMTO, consulte Configuração do VMTO.

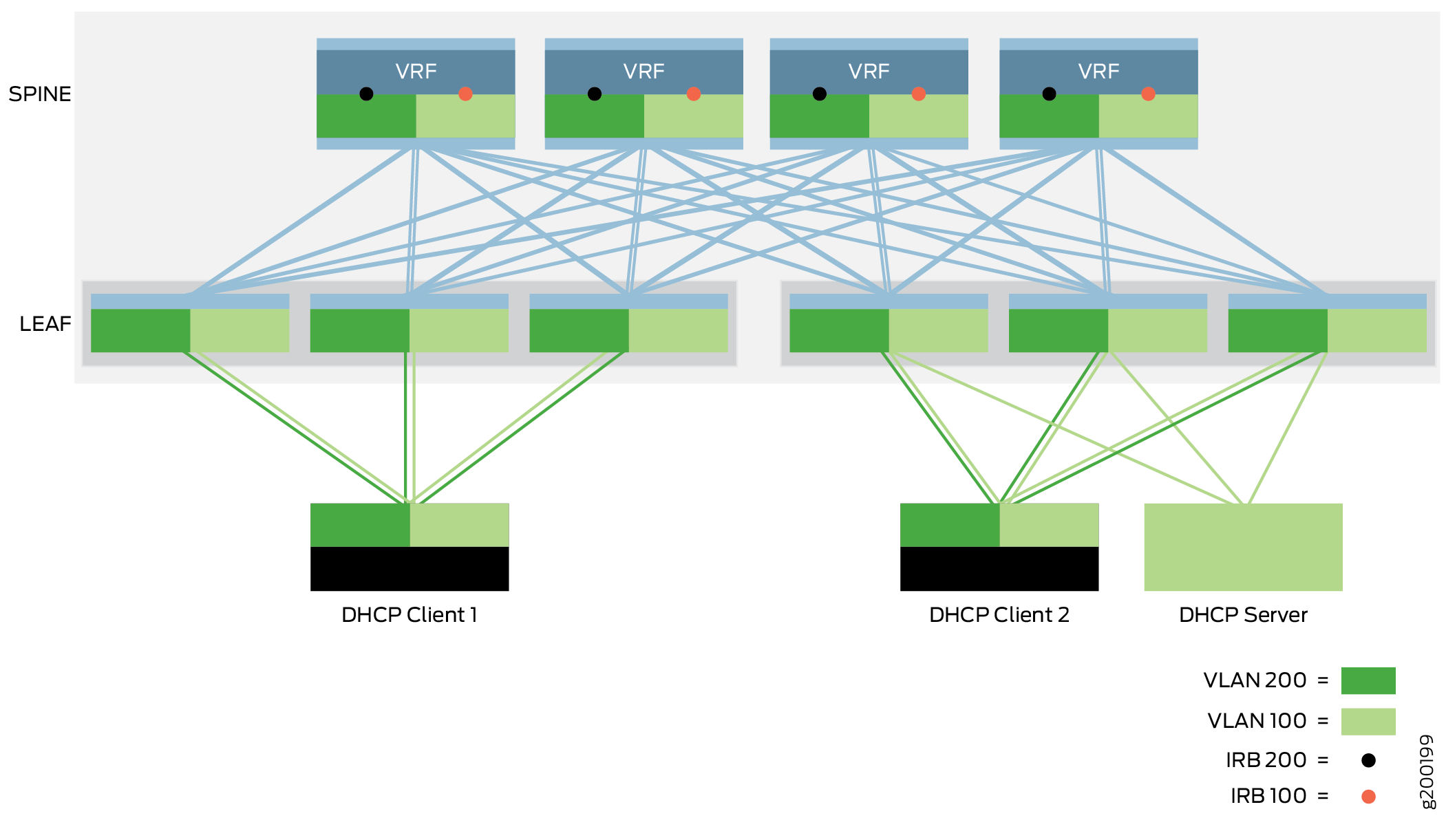

Retransmissão DHCP

do CRB

do CRB

O bloco de construção do protocolo de configuração dinâmica de host (DHCP) permite que a rede passe mensagens DHCP entre um cliente DHCP e um servidor DHCP. A implementação do retransmissão DHCP neste bloco de construção move pacotes DHCP através de uma sobreposição do CRB onde o gateway está localizado na camada spine.

O servidor DHCP e os clientes DHCP se conectam à rede usando interfaces de acesso em dispositivos leaf. O servidor DHCP e os clientes podem se comunicar entre si pela rede existente sem configuração adicional quando o cliente e o servidor DHCP estão na mesma VLAN. Quando um cliente e servidor DHCP está em diferentes VLANs, o tráfego DHCP entre o cliente e o servidor é encaminhado entre as VLANs através das interfaces IRB em dispositivos spine. Você deve configurar as interfaces IRB nos dispositivos spine para oferecer suporte ao retransmissão DHCP entre VLANs.

Para obter informações sobre a implementação do retransmissão DHCP, consulte o projeto e a implementação do retransmissão DHCP.

Redução do tráfego ARP com sincronização e supressão de ARP (Proxy ARP)

O objetivo da sincronização de ARP é sincronizar tabelas de ARP em todos os VRFs que atendem a uma sub-rede overlay para reduzir a quantidade de tráfego e otimizar o processamento para dispositivos de rede e sistemas finais. Quando um gateway IP para uma sub-rede aprende sobre uma ligação ARP, ele o compartilha com outros gateways para que eles não precisem descobrir a mesma ligação ARP de forma independente.

Com a supressão de ARP, quando um dispositivo leaf recebe uma solicitação ARP, ele verifica sua própria tabela ARP que é sincronizada com os outros dispositivos VTEP e responde à solicitação localmente em vez de inundar a solicitação de ARP.

A supressão de ARP e ARP proxy são habilitadas por padrão em todos os switches da Série QFX que podem atuar como dispositivos leaf em uma sobreposição ERB. Para obter uma lista desses switches, veja designs de referência de malha EVPN-VXLAN de data center — resumo de hardware suportado.

As interfaces IRB no dispositivo leaf fornecem solicitações de ARP e solicitações NDP de dispositivos leaf locais e remotos. Quando um dispositivo leaf recebe uma solicitação de ARP ou solicitação NDP de outro dispositivo leaf, o dispositivo receptor pesquisa seu banco de dados de vinculações de endereço MAC+IP para o endereço IP solicitado.

Se o dispositivo encontrar a vinculação do endereço MAC+IP em seu banco de dados, ele responderá à solicitação.

Se o dispositivo não encontrar a ligação de endereço MAC+IP, ele inunda a solicitação de ARP a todos os links Ethernet na VLAN e nos VTEPs associados.

Como todos os dispositivos leaf participantes adicionam as entradas ARP e sincronizam suas tabelas de roteamento e ponte, os dispositivos leaf locais respondem diretamente às solicitações de hosts conectados localmente e removem a necessidade de dispositivos remotos para responder a essas solicitações de ARP.

Para obter informações sobre a implementação da sincronização de ARP, proxy ARP e supressão de ARP, veja habilitação de ARP proxy e supressão de ARP para a sobreposição de pontes roteadas na borda.

Recursos de segurança de porta de camada 2 em sistemas finais conectados por ethernet

Os overlays de CRB e ERB oferecem suporte aos recursos de segurança em sistemas finais conectados por Ethernet de Camada 2 que descrevemos nas próximas seções.

Para obter mais informações sobre esses recursos, veja o suporte a filtragem MAC, controle de tempestade e espelhamento de portas em um ambiente EVPN-VXLAN.

Para obter informações sobre a configuração desses recursos, veja Configuração de recursos de segurança de porta de Camada 2 em sistemas finais conectados por Ethernet.

- Prevenção de tempestades de tráfego BUM com controle de tempestade

- Usando filtragem MAC para melhorar a segurança das portas

- Análise do tráfego usando espelhamento de porta

Prevenção de tempestades de tráfego BUM com controle de tempestade

O controle de tempestade pode evitar que o tráfego excessivo degrade a rede. Ele diminui o impacto de tempestades de tráfego BUM monitorando os níveis de tráfego em interfaces EVPN-VXLAN e reduzindo o tráfego BUM quando um nível de tráfego especificado é excedido.

Em um ambiente EVPN-VXLAN, o controle de tempestade monitora:

Tráfego BUM de camada 2 que se origina em um VXLAN e é encaminhado para interfaces dentro do mesmo VXLAN.

Tráfego multicast de camada 3 que é recebido por uma interface IRB em um VXLAN e é encaminhado para interfaces em outro VXLAN.

Usando filtragem MAC para melhorar a segurança das portas

A filtragem MAC melhora a segurança das portas limitando o número de endereços MAC que podem ser aprendidos em uma VLAN e, portanto, limitam o tráfego em uma VXLAN. Limitar o número de endereços MAC protege o switch contra inundar a tabela de comutação Ethernet. A inundação da tabela de comutação Ethernet ocorre quando o número de novos endereços MAC que são aprendidos faz com que a tabela transborde e os endereços MAC aprendidos anteriormente são retirados da mesa. O switch reaprende os endereços MAC, o que pode afetar o desempenho e introduzir vulnerabilidades de segurança.

Neste blueprint, a filtragem MAC limita o número de pacotes aceitos que são enviados para interfaces de acesso voltadas para a entrada com base em endereços MAC. Para obter mais informações sobre como a filtragem MAC funciona, veja as informações de limitação mac no entendimento da limitação MAC e do mac move limiting.

Análise do tráfego usando espelhamento de porta

Com o espelhamento de porta baseado em analisador, você pode analisar o tráfego até o nível de pacote em um ambiente EVPN-VXLAN. Você pode usar esse recurso para aplicar políticas relacionadas ao uso de rede e compartilhamento de arquivos e identificar fontes problemáticas localizando o uso anormal ou pesado de largura de banda por estações ou aplicativos específicos.

A espelhamento de portas espelha os pacotes que entram ou saem de uma porta ou entram em uma VLAN e enviam as cópias para uma interface local para monitoramento local ou para uma VLAN para monitoramento remoto. Use o espelhamento de portas para enviar tráfego a aplicativos que analisam o tráfego para fins como monitorar a conformidade, aplicar políticas, detectar invasões, monitorar e prever padrões de tráfego, correlacionar eventos e assim por diante.