Anbietergebunden, zu teuer, nicht überzeugend?

Nur Juniper hat das KI-Heilmittel.

Kein anderer Anbieter treibt Innovationen so voran und setzt neue Standards für Kl in Unternehmensnetzwerken wie Juniper Networks. Wir definieren die Kategorie neu und nehmen unsere branchenführenden Kunden mit auf die Reise. Bis zu 90 % weniger Support-Tickets? Ja. 85 % niedrigere Betriebskosten? Selbstverständlich. Hervorragende Benutzererfahrungen, die Sie zum IT-Helden machen? Willkommen an Bord.

Sehen Sie sich diesen direkten Vergleich zwischen uns und unseren „Mitbewerbern“ an. Und bereiten Sie sich darauf vor, Ihre Netzwerkerfahrung von gewöhnlich in herausragend zu verwandeln.

Pressemitteilungen zu Juniper

Unsere neue Ära als HPE Networking

Das nächste Kapitel der Geschichte von Juniper, als Teil von HPE, hat nun offiziell begonnen. Durch die Zusammenführung unserer Unternehmen können wir Kunden ein branchenführendes, umfassendes und sicheres IT-Portfolio anbieten, das nun auch einen vollständigen modernen Netzwerk-Stack umfasst.

HPE beschleunigt mit neuen agentischen, KI-nativen Mist Systems Innovationen den Betrieb des Self-Driving Network

HPE hat heute die Erweiterung des HPE Juniper Networking Portfolios um einige wesentliche Innovationen bekanntgegeben. Diese werden autonomere, intelligentere, proaktivere Netzwerkprozesse ermöglichen und somit die Bereitstellung agentischer AIOps über die KI-native Juniper Mist Platform unterstützen.

Neue agentische KI-native Funktionen verkürzen den Weg zum Self-Driving Network

HPE Networking hat seine KI-native Netzwerkplattform Mist™ Systems kürzlich um neue agentische KI-gestützte Features ergänzt, um den Umstieg von einem unterstützten auf einen autonomen Netzwerkbetrieb zu beschleunigen. Somit ist das Self-Driving Network™ nun zum Greifen nah.

Juniper baut seine Führungsposition bei Datencenter-Netzwerken mit KI-nativen Innovationen aus

Juniper weitet AIOps auf alle Bereiche des Portfolios aus, um die Benutzererfahrung für Betreiber zu simplifizieren. Stellen Sie sich ein Datencenter vor, das Probleme antizipiert und verhindert, bevor sie überhaupt auftreten – willkommen in der Zukunft bei Juniper.

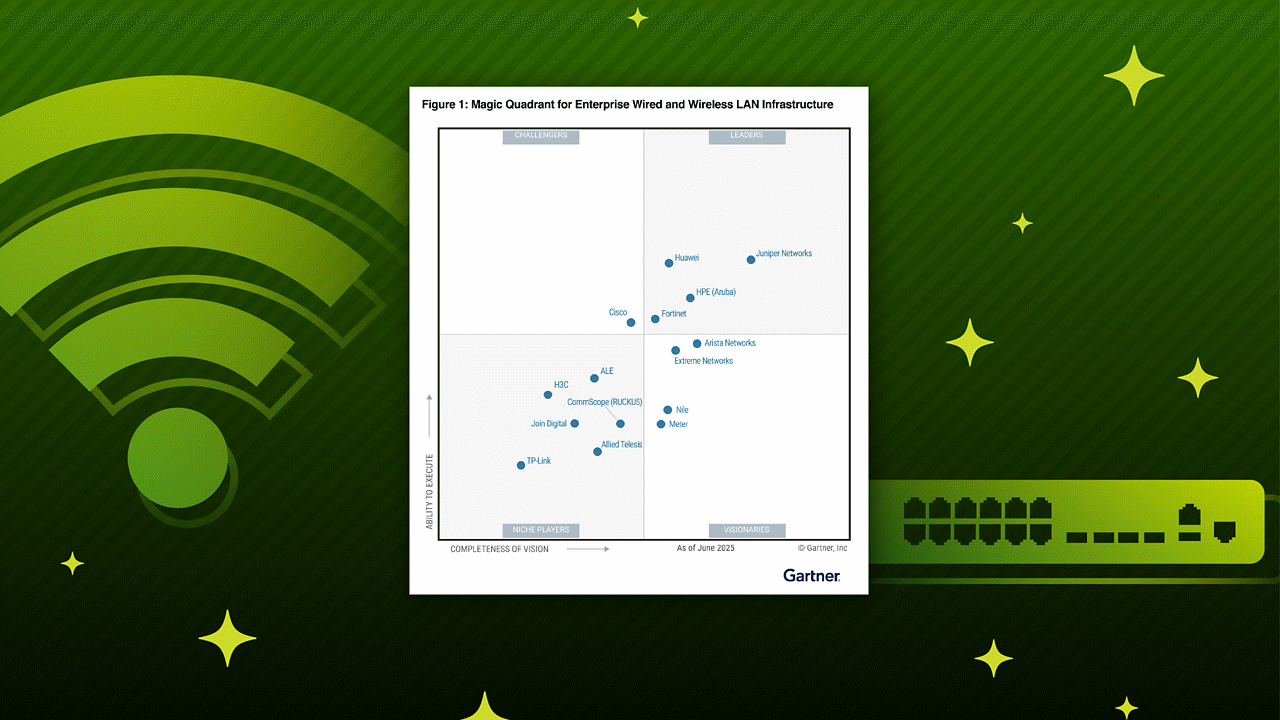

Gartner Magic Quadrant for Enterprise Wired and Wireless LAN Infrastructure, Mike Leibovitz, Christian Canales, Nauman Raja, Tim Zimmerman, 25. Juni 2025.

Gartner, Magic Quadrant for Data Center Switching, Andrew Lerner, Simon Richard, et al., 31. März 2025

Gartner unterstützt keine der in seinen Forschungspublikationen dargestellten Anbieter, Produkte oder Serviceleistungen und empfiehlt Technologieanwendern nicht, sich auf die Anbieter mit den höchsten Bewertungen oder sonstigen Auszeichnungen zu beschränken. Die Forschungspublikationen von Gartner geben die Meinungen der Forschungsabteilung von Gartner wieder und sollten nicht als Tatsachenfeststellungen verstanden werden. Gartner schließt jegliche ausdrückliche oder stillschweigende Haftung in Bezug auf diese Studie sowie jegliche Garantie der Marktgängigkeit oder Eignung für einen bestimmten Zweck aus.

GARTNER ist eine eingetragene Handels- und Dienstleistungsmarke von Gartner, Inc. und/oder den Vertragspartnern des Unternehmens in den USA und in anderen Ländern und MAGIC QUADRANT ist eine eingetragene Handelsmarke von Gartner, Inc. und/oder den Vertragspartnern des Unternehmens. Die Verwendung in diesem Dokument wurde genehmigt. Alle Rechte vorbehalten.

Diese Grafik wurde von Gartner, Inc. als Teil eines umfassenden Marktforschungsberichtes publiziert und sollte im Kontext mit dem Gesamtbericht bewertet werden. Der Gartner-Bericht ist auf Anfrage bei Juniper Networks erhältlich.

Gartner® und IT Symposium/XPO™ sind eingetragene Marken von Gartner, Inc. und/oder seinen Vertragspartnern in den USA und international und werden hier mit Genehmigung verwendet. Alle Rechte vorbehalten.