Collapsed Spine Fabric Design und Implementierung

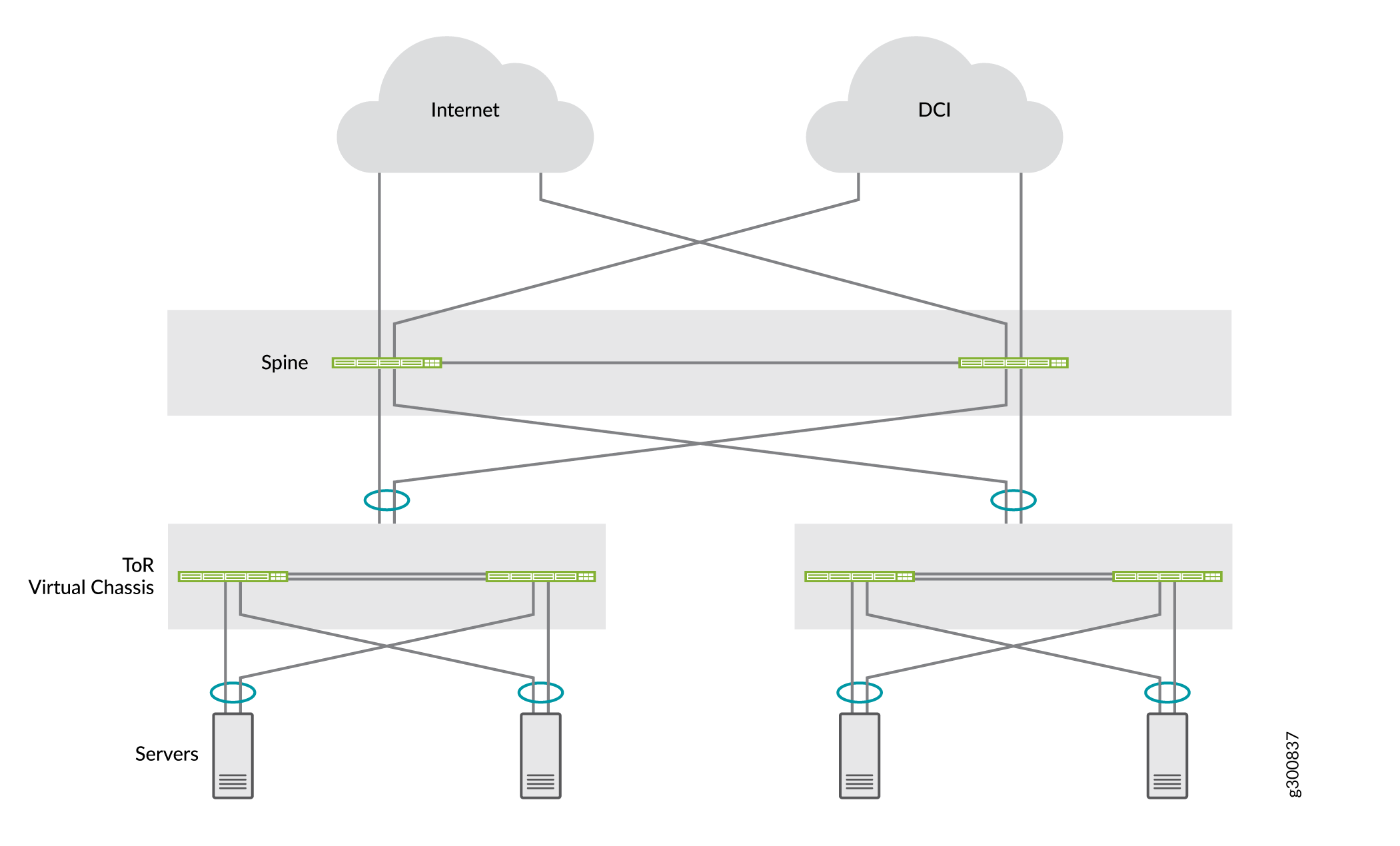

In Collapsed Spine Fabrics werden core EVPN-VXLAN-Overlay-Funktionen nur auf einer Spine-Schicht zusammengefasst. Es gibt keine Leaf-Layer; können die Spine-Geräte direkt mit vorhandenen Top-of-Rack-Switches (ToR) in der Zugriffsebene, die EVPN-VXLAN möglicherweise nicht unterstützen, anknnen.

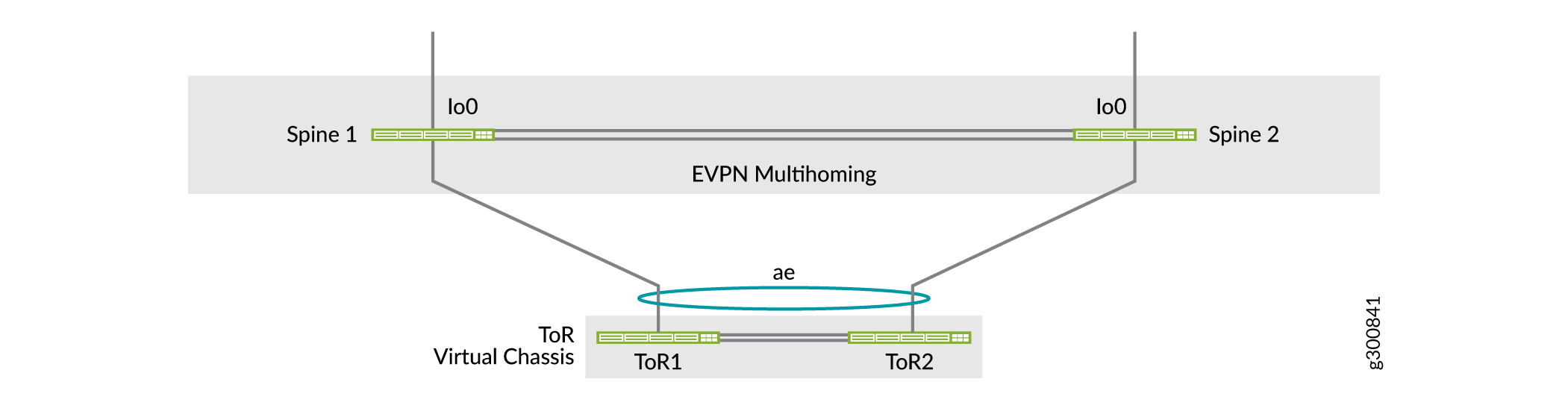

TOR-Switches können zur Ausfallsicherheit auf Zugriffsebenen an mehr als ein Spine-Gerät multihomed werden, was die Spine-Geräte mit EVPN-Multihoming (auch ESI-LAG genannt) verwalten, genauso wie die Leaf-Geräte in anderen EVPN-VXLAN-Referenzarchitekturen. (Weitere Informationen finden Sie unter Multihoming an Ethernet-connected End System Design und Implementierung .)

Die Spine-Geräte übernehmen auch alle Randgeräterollen für die Konnektivität außerhalb des Datencenters.

Einige häufige Elemente in Anwendungsfällen für collapsed Spine-Architektur:

Collapsed Spine Fabric mit Back-to-Back-Spine-Geräten:

In diesem Modell sind die Spine-Geräte mit Punkt-zu-Punkt-Verbindungen verbunden. Die Spine-Geräte richten BGP-Peering im Underlay ein und legen diese Links über ihre Loopback-Adressen über. Siehe Abbildung 1.

Alternativ können die Collapsed Spine Core-Geräte mit einem Route Reflector-Cluster in einer Super-Spine-Schicht integriert werden, was später erläutert wird (unsere Referenzarchitektur).

Datencenter-Standorte, die mit Data Center Interconnect (DCI) verbunden sind:

Die Spine-Geräte können Border-Gateway-Funktionen ausführen, um EVPN-Peering zwischen Datencentern einzurichten, einschließlich Layer-2-Stretch und Layer-3-Konnektivität, wie Abbildung 1 zeigt.

Eigenständige Switches oder Virtual Chassis auf der Zugriffsebene:

Die ToR-Ebene kann eigenständige Switches oder Virtual Chassis multihomed mit den zusammengeklappten Spine-Geräten enthalten. Mit Virtual Chassis können Sie redundante Verbindungen in den ESI-LAGs zwischen den Spine-Geräten und verschiedenen Virtual Chassis-Member-Switches aufbauen, um die Ausfallsicherheit zu erhöhen. Siehe Abbildung 2.

Abbildung 1 zeigt eine logische Ansicht eines collapsed Spine-Datencenters mit Randkonnektivität, DCI zwischen Datencentern und Virtual Chassis im ToR-Layer, das multihomed mit den Spine-Geräten ist.

)

)

Abbildung 2 veranschaulicht Virtual Chassis im ToR-Layer multihomed zu einer Back-to-Back-Collapsed-Spine-Schicht, auf der die Spine-Geräte mit verschiedenen Virtual Chassis-Member-Switches verbinden, um die ESI-LAG-Ausfallsicherheit zu verbessern.

Lesen Sie Collapsed Spine mit EVPN Multihoming, ein Beispiel für die Netzwerkkonfiguration, das einen häufigen Collapsed Spine-Anwendungsfall bei Back-to-Back-Spine-Geräten beschreibt. In diesem Beispiel handelt es sich bei den ToR-Geräten um Virtual Chassis, die multihomed mit den zusammengeklappten Spine-Geräten sind. Das Beispiel umfasst die Konfiguration zusätzlicher Sicherheitsservices mit einem SRX-Chassis-Cluster zum Schutz des mandantenübergreifenden Datenverkehrs, wobei der Datenverkehr zwischen den Datencentern auch als DCI-Lösung über den SRX-Cluster geleitet wird.

Ein weiteres Collapsed Spine Fabric-Modell verbindet die Spine-Geräte durch einen IP-Transit-Layer-Route-Reflector-Cluster, den Sie in die Collapsed Spine Core Underlay- und Overlay-Netzwerke integrieren. Unsere Referenzarchitektur verwendet dieses Modell und wird in den folgenden Abschnitten beschrieben.

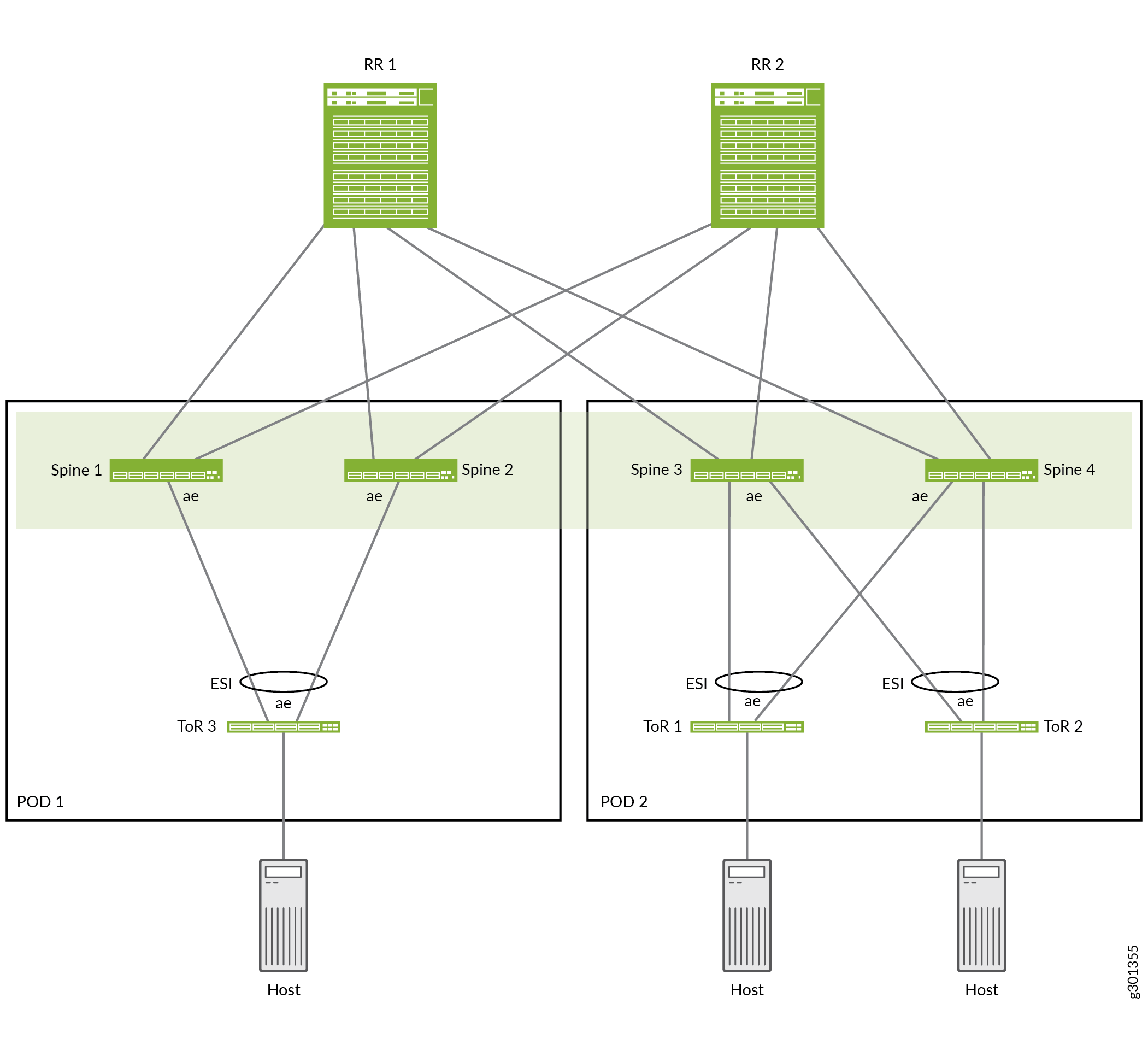

Überblick über die Collapsed Spine-Referenzarchitektur

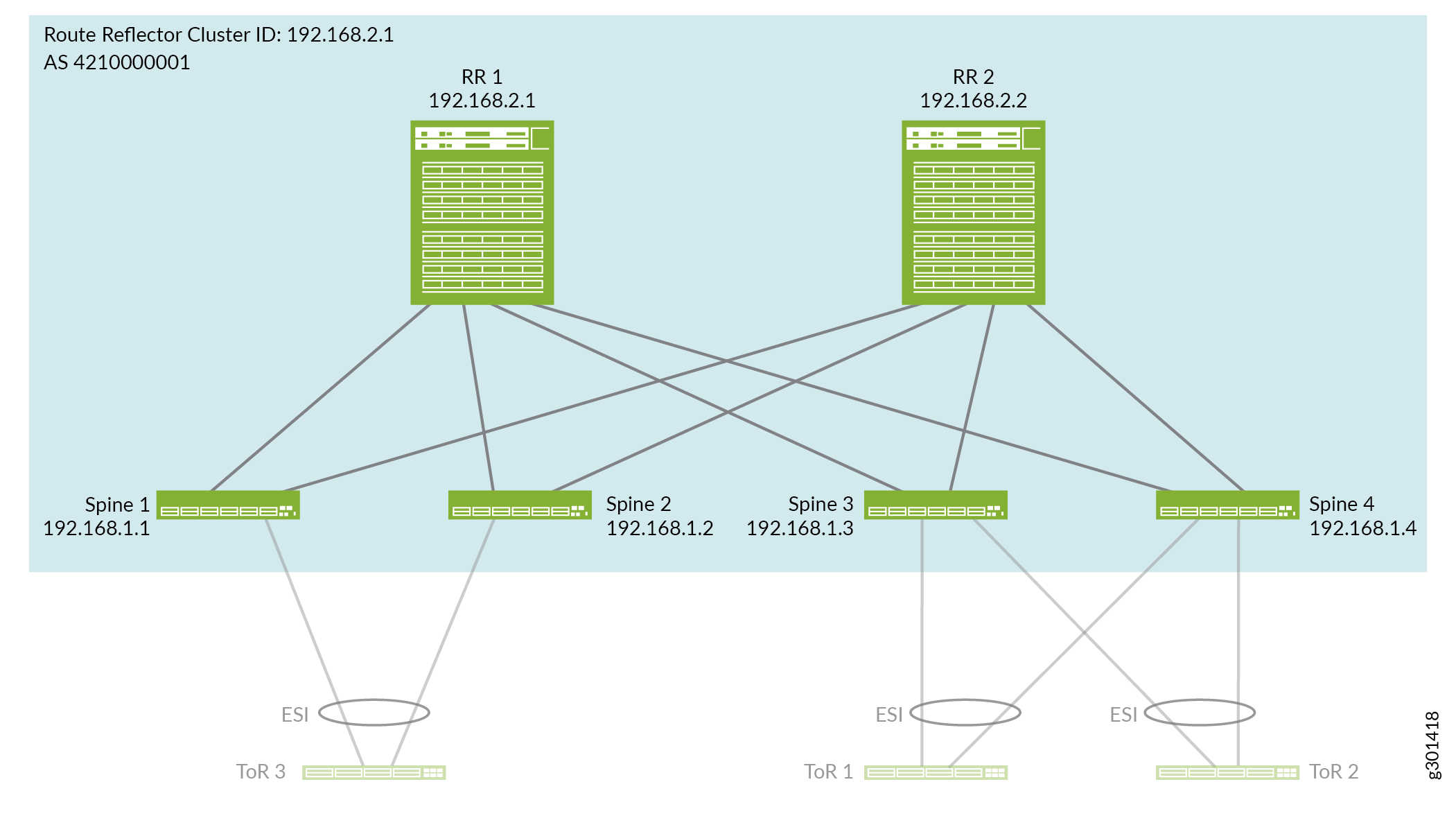

Unsere Referenzarchitektur stellt einen Anwendungsfall für eine collapsed Spine-Datencenter-Fabric dar, die zwei Pod-Module (Inter-Point of Delivery) umfasst. Die PODs und collapsed Spine-Geräte in den PODs werden durch eine Super-Spine-IP-Transitschicht miteinander verbunden, die als Route Reflector Cluster konfiguriert ist. Siehe Abbildung 3. Diese Architektur ähnelt einem fünfstufigen IP-Fabric-Design (siehe Fünfstufiges IP-Fabric-Design und -Implementierung), aber nur mit super Spine-, Spine- und Zugriffsebenen. Sie konfigurieren die collapsed Spine Fabric so, dass die Route Reflector-Cluster-Geräte auf ähnliche Weise in das IP-Fabric-Underlay und das EVPN-Overlay integriert werden.

Abbildung 3 zeigt ein Beispiel für das Collapsed Spine-Referenzdesign, das die folgenden Elemente umfasst:

POD 1: ToR 3 multihomed zu Spine 1 und Spine 2

POD 2: ToR 1 und ToR 2 multihomed zu Spine 3 und Spine 4

Route Reflector Cluster: RR 1 und RR 2 verbinden Spine-Geräte 1 bis 4 miteinander

Die vier Spine-Geräte bilden den Collapsed Spine EVPN Fabric Core, mit Layer-2-Stretch und Layer-3-Routing zwischen den Spine-Geräten in den beiden PODs. Die Spine-Geräte in jedem POD verwenden ESI-LAGs für die multihomed ToR-Switches im selben POD.

Konfigurieren Sie das Collapsed Spine IP-Fabric-Underlay, das in die Route Reflector-Ebene integriert ist

In diesem Abschnitt wird beschrieben, wie Sie die Verbindungsverbindungen und das IP-Fabric-Underlay auf den Spine- und Route-Reflector-Geräten konfigurieren.

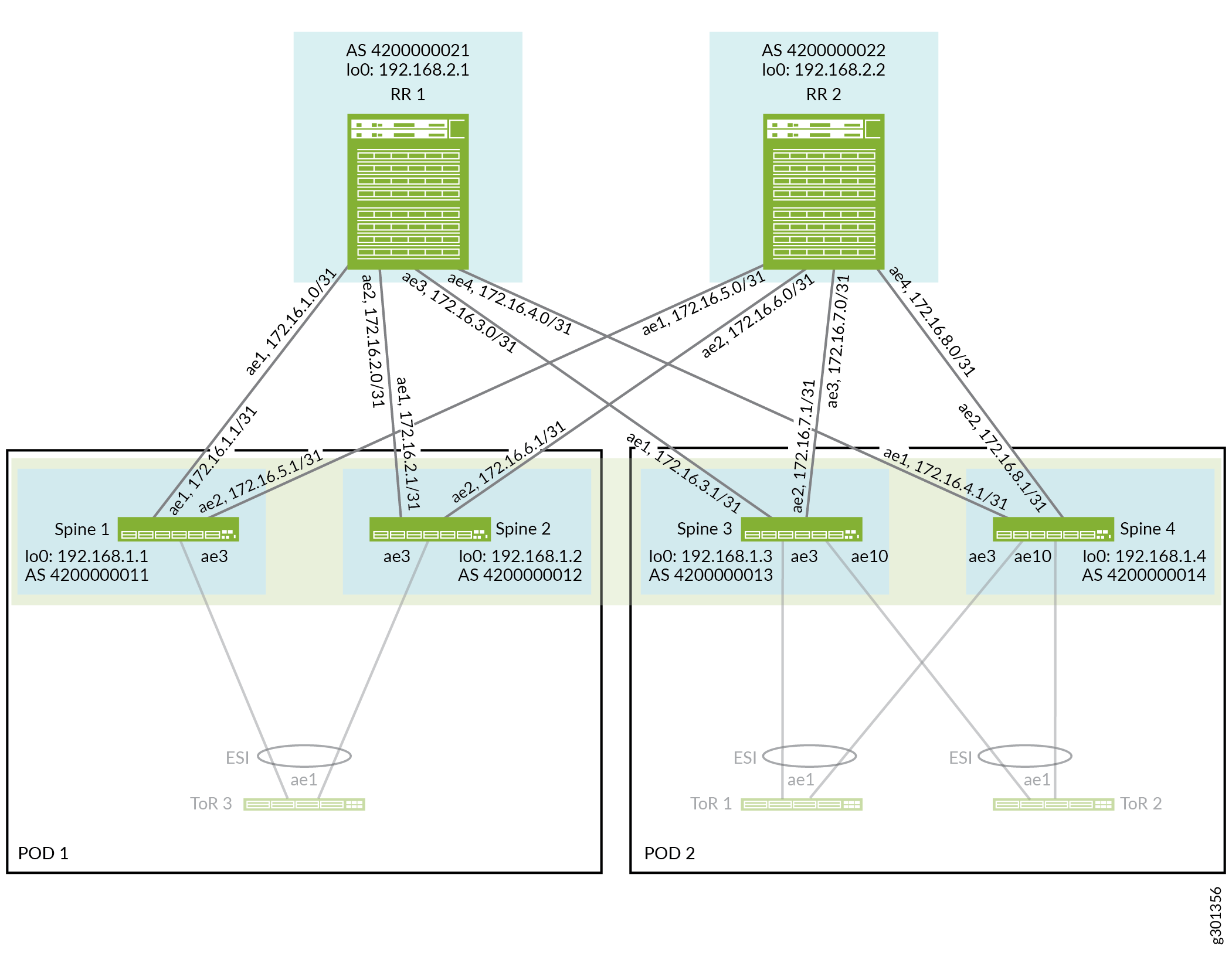

Abbildung 4 zeigt die zusammengelegten Spine- und Route-Reflektorgeräte, die über aggregierte Ethernet-Schnittstellenverbindungen verbunden sind.

So konfigurieren Sie das Underlay:

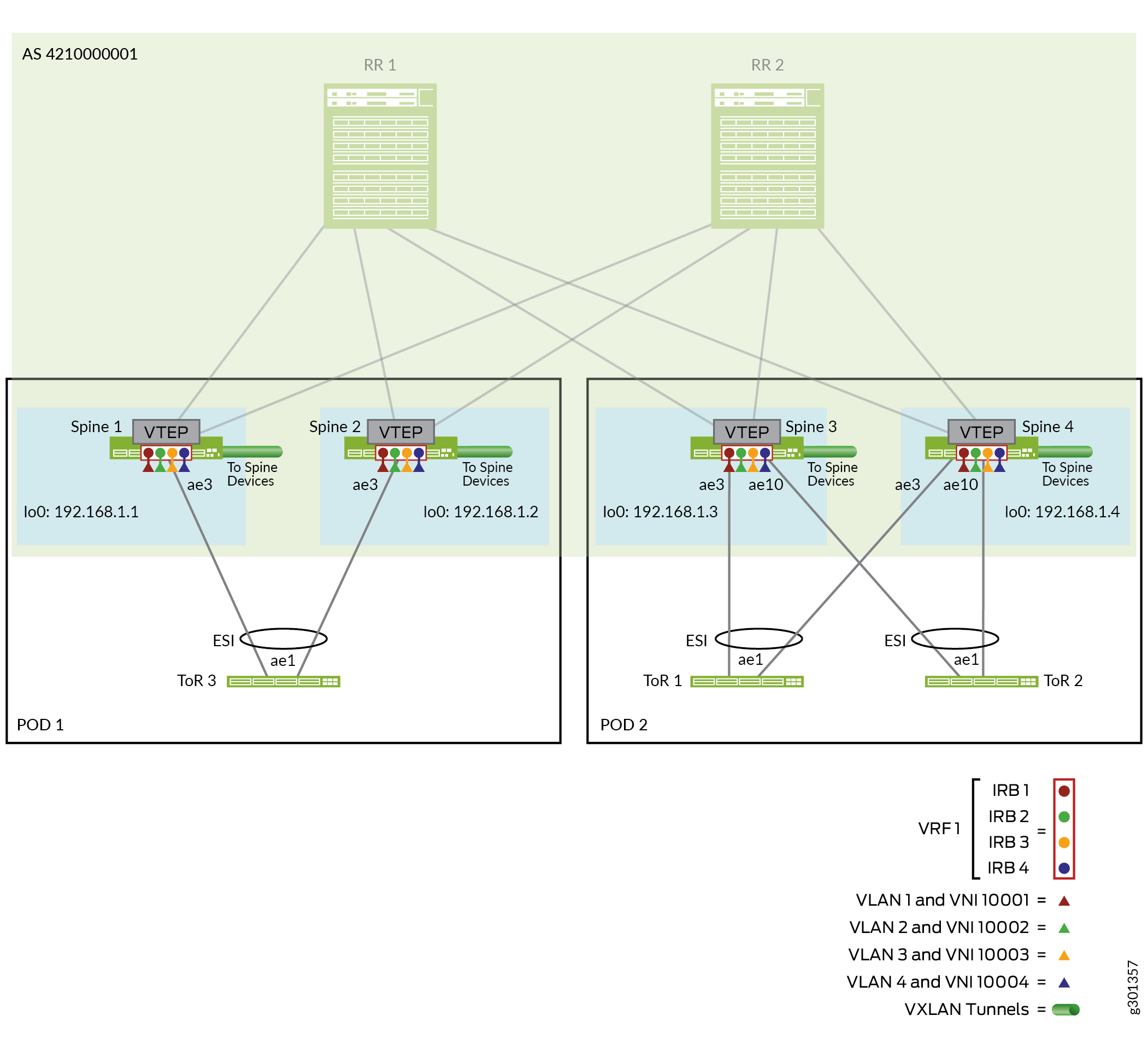

Konfigurieren Sie das Collapsed Spine EVPN-VXLAN-Overlay, das in die Route Reflector-Ebene integriert ist

In diesem Design ähnelt das Overlay anderen EVPN-VXLAN-Datencenter-Spine- und Leaf-Referenzarchitekturen, umfasst jedoch keine Leaf-Ebene. Nur die Spine-Geräte (integriert in den Route Reflector Cluster) führen Intra-VLAN- und Inter-VLAN-Routing in der Fabric durch. Wir konfigurieren IBGP mit Multiprotocol BGP (MP-IBGP) mit einer einzigen autonomen Systemnummer (AS) auf den Spine-Geräten, um einen Signalpfad zwischen ihnen über die Routenreflektor-Cluster-Geräte wie folgt herzustellen:

Die Route Reflector-Cluster-Geräte peeren mit den Spine-Geräten in beiden PODs für den IP-Transit.

Die Spine-Geräte peeren mit den Routenreflektorgeräten.

Siehe Abbildung 5, die die Spine- und Routenreflektor-Cluster-Geräte und BGP-Nachbarn-IP-Adressen veranschaulicht, die wir im EVPN-Overlay-Netzwerk konfigurieren.

Die Overlay-Konfiguration ist auf beiden Routenreflektorgeräten mit Ausnahme der lokalen Adresse des Geräts (die Loopback-Adresse) gleich. Die Routenreflektorgeräte peeren mit allen Spine-Geräten.

Die Overlay-Konfiguration ist auf jedem Spine-Gerät gleich, mit Ausnahme der lokalen Adresse des Geräts (die Loopback-Adresse). Alle Spine-Geräte peeren mit dem Route Reflector Cluster.

Wir konfigurieren EVPN mit VXLAN-Kapselung und VTEP-Schnittstellen (Virtual Tunnel Endpoint) nur auf den Spine-Geräten in der collapsed Spine Fabric.

So konfigurieren Sie das Overlay:

Konfigurieren Sie EVPN-Multihoming und virtuelle Netzwerke auf den Spine-Geräten für die ToR-Switches

Dieses Collapsed Spine-Referenzdesign implementiert EVPN-Multihoming, wie in Multihoming an Ethernet-Connected End System Design and Implementation beschrieben, außer weil die Leaf-Layer-Funktionen in die Spine-Ebene eingeklappt sind, konfigurieren Sie die ESI-LAGs auf den Spine-Geräten. Außerdem konfigurieren Sie VLANs und Layer 2- und Layer 3-Routing-Funktionen auf den Spine-Geräten ähnlich wie auf Leaf-Geräten in einem Erb-Overlay-Design (Edge-Routed Bridging). Die Core-Collapsed-Spine-Konfiguration implementiert eine Layer-2-Erweiterung , indem dieselben VLANs (und VLAN-zu-VNI-Zuordnungen) auf allen Spine-Geräten in beiden PODs festgelegt werden. EVPN Typ 2-Routen ermöglichen die Kommunikation zwischen Endgeräten innerhalb und über die PODs hinweg.

Abbildung 6 zeigt die zusammengeklappten Spine-Geräte in jedem POD, die mit aggregierten Ethernet-Schnittstellenverbindungen zu den multihomed ToR-Switches im POD verbunden sind.

)

)

Aus Gründen der Kürze zeigt dieser Abschnitt eine aggregierte Ethernet-Verbindung zwischen jedem Spine und jedem ToR-Gerät, wobei eine Schnittstelle auf jeder aggregierten Ethernet-Verbindung von den Spine-Geräten zu den ToR-Geräten im POD konfiguriert ist.

In diesem Abschnitt werden nur Konfigurationsdetails für Spine- und ToR-Geräte in POD 2 behandelt. Sie können eine ähnliche Konfiguration mit entsprechenden Geräteparametern und Schnittstellen auf die Spine- und ToR-Geräte in POD 1 anwenden.

Die ToR-Geräte umfassen zwei Schnittstellen in ihren aggregierten Ethernet-Verbindungen, eine zu jedem Spine-Gerät im POD, die die ESI-LAG für Multihoming bilden.

Die Konfiguration umfasst Folgende Schritte:

Konfigurieren Sie die Schnittstellen.

Richten Sie die ESI-LAGs für EVPN-Multihoming ein.

Konfigurieren Sie Layer 2- und Layer 3-Gateway-Funktionen, einschließlich der Definition von VLANs, den zugehörigen IRB-Schnittstellen für das Inter-VLAN-Routing und entsprechende VLAN-zu-VNI-Zuordnungen.

Überprüfung der Collapsed Spine Fabric-Konnektivität mit Route Reflector Cluster und ToR-Geräten

In diesem Abschnitt werden CLI-Befehle dargestellt, mit der sie die Konnektivität zwischen den zusammengeklappten Spine-Geräten und dem Route Reflector-Cluster sowie zwischen den collapsed Spine-Geräten und den ToR-Geräten überprüfen können.

Aus Gründen der Kürze enthält dieser Abschnitt die Überprüfung der Konnektivität auf den Spine-Geräten, die nur Spine 3 und Spine 4 in POD 2 verwenden. Sie können die gleichen Befehle auf den Spine-Geräten (Spine 1 und Spine 2) in POD 1 verwenden.

Überprüfen der Collapsed Spine Fabric BGP Underlay und EVPN-VXLAN Overlay-Konfiguration

In diesem Abschnitt werden CLI-Befehle angezeigt, mit denen Sie überprüfen können, ob Das Underlay und das Overlay für die zusammengeklappten Spine-Geräte funktionieren, die in den Route Reflector cluste integriert sind. Weitere Informationen zu den konfigurierten Underlay- und Overlay-Parametern finden Sie in Abbildung 4 und Abbildung 5 .

Aus Gründen der Kürze enthält dieser Abschnitt die Überprüfung der Konnektivität auf den Spine-Geräten, die nur Spine 3 und Spine 4 in POD 2 verwenden. Sie können die gleichen Befehle auf den Spine-Geräten (Spine 1 und Spine 2) in POD 1 verwenden.