Diseño e implementación de interconexiones del centro de datos mediante rutas tipo 5

Interconexión del centro de datos mediante rutas EVPN tipo 5

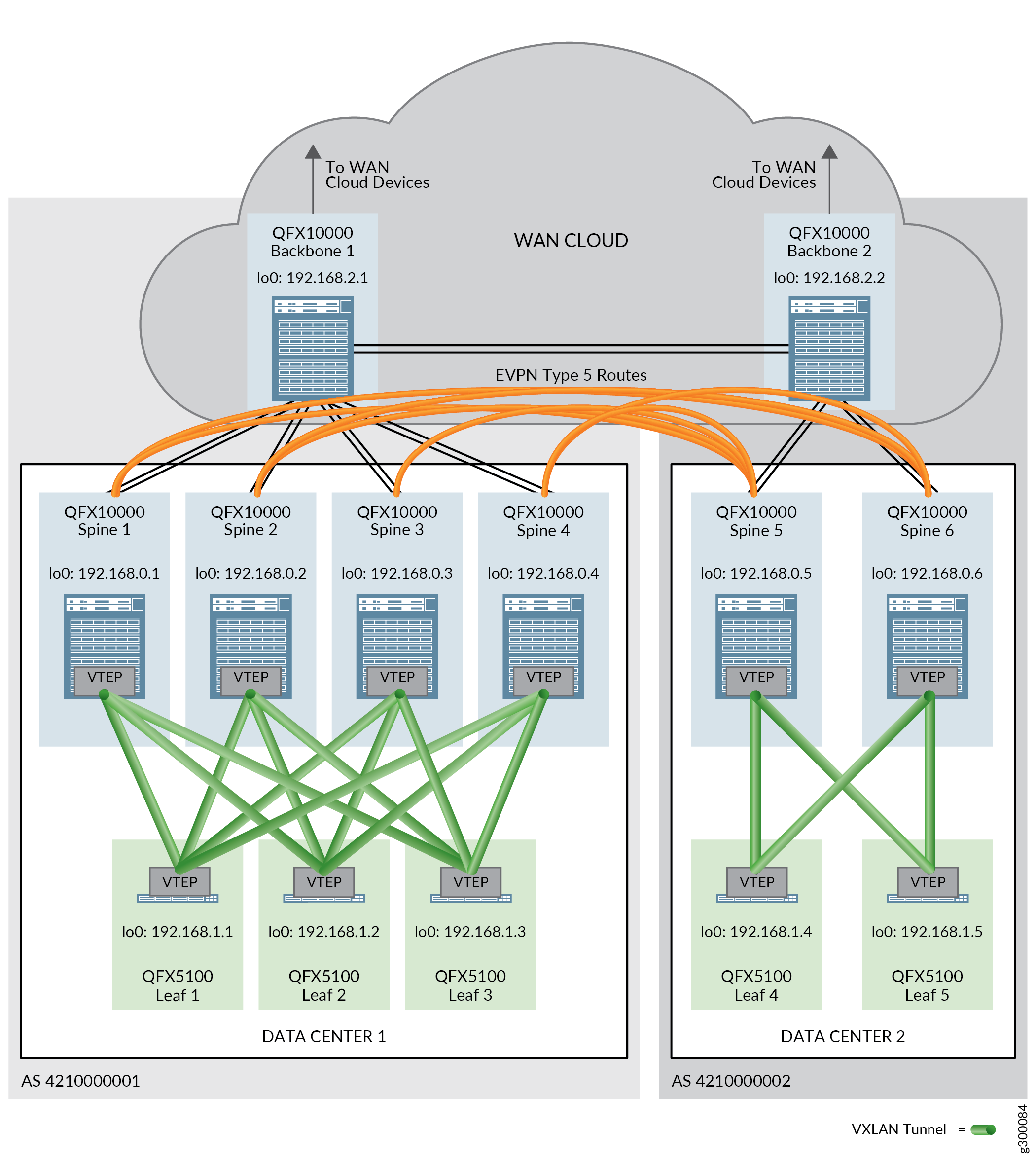

Las rutas tipo 5 de EVPN, también conocidas como rutas de prefijo IP, se utilizan en un contexto DCI para pasar tráfico entre centros de datos que utilizan diferentes esquemas de subred de direcciones IP.

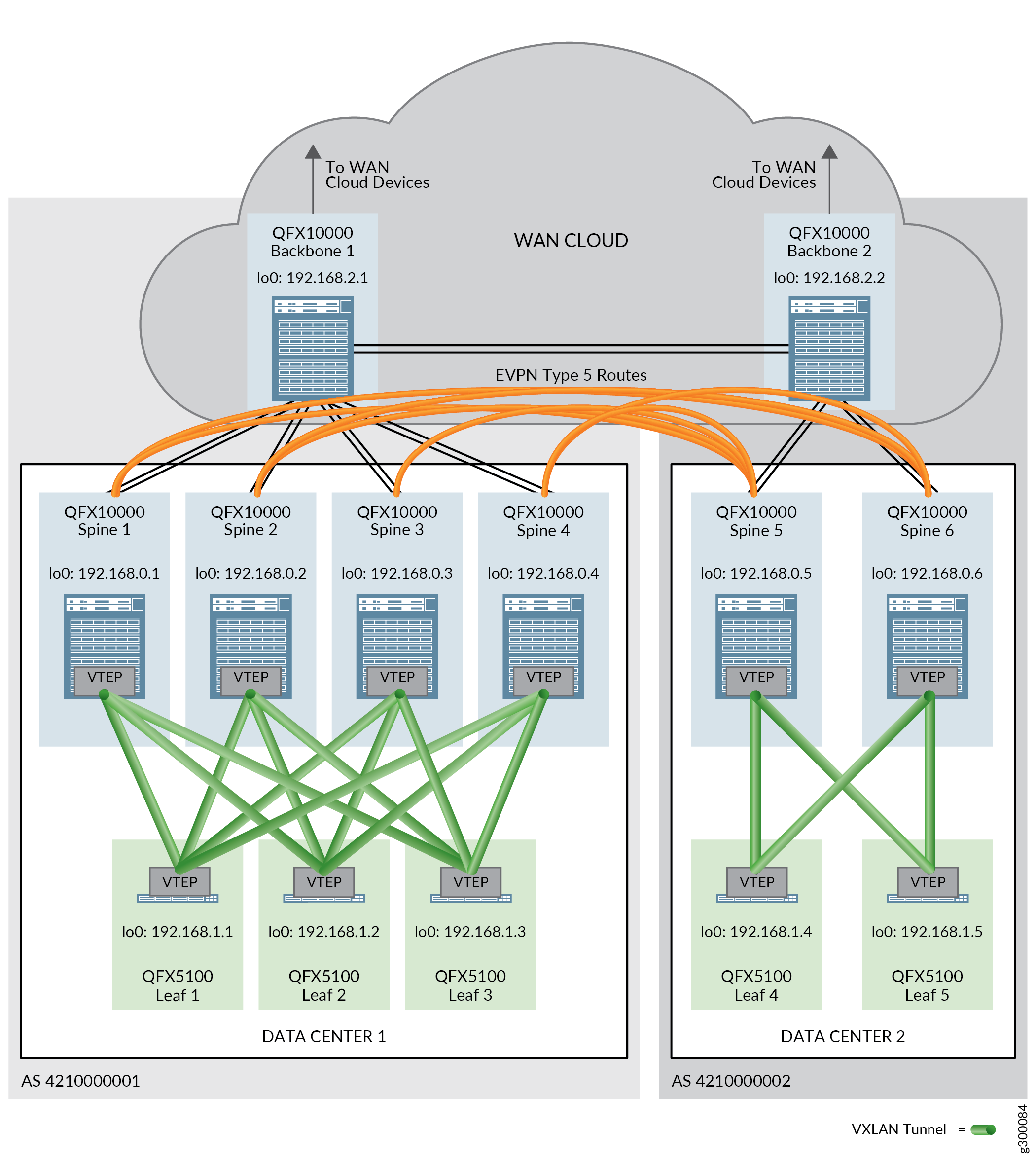

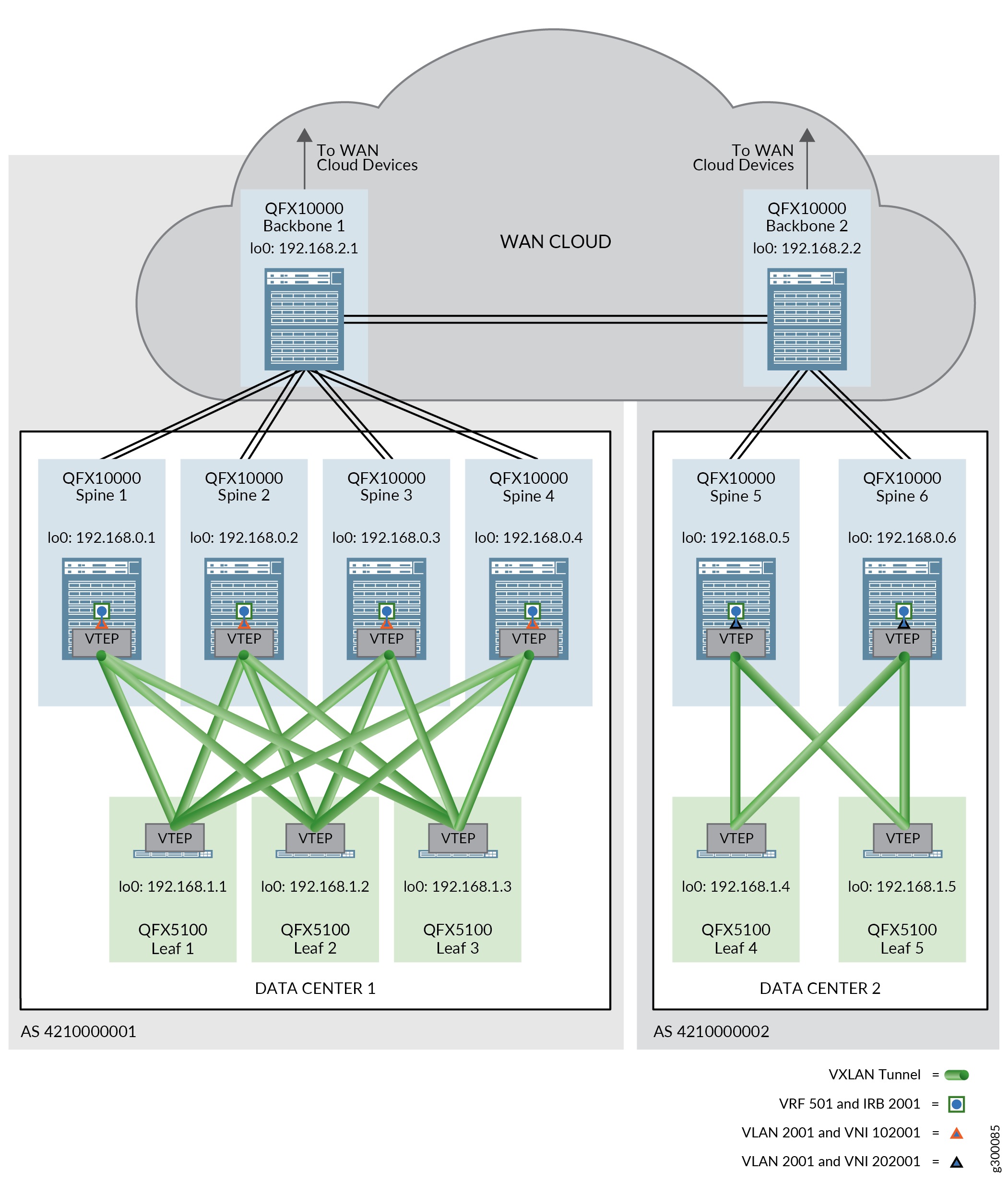

En esta arquitectura de referencia, las rutas de EVPN tipo 5 se intercambian entre dispositivos spine en diferentes centros de datos para permitir el paso del tráfico entre los centros de datos.

La conectividad física entre los centros de datos es necesaria antes de que se puedan enviar mensajes EVPN tipo 5 a través de los centros de datos. Esta conectividad física la proporcionan los dispositivos troncales en una nube WAN. Un dispositivo troncal se conecta a cada dispositivo spine en un único centro de datos y participa en las sesiones de IBGP superpuestas y EBGP subyacentes. El EBGP también se ejecuta en un grupo de BGP independiente para conectar los dispositivos troncales entre sí; La señalización de EVPN está habilitada en este grupo de BGP.

La Figura 1 muestra dos centros de datos que usan rutas EVPN tipo 5 para DCI.

Para obtener más información sobre las rutas de EVPN tipo 5, consulte Ruta tipo 5 de EVPN con encapsulación VXLAN para EVPN-VXLAN.

Todos los procedimientos de esta sección suponen que las rutas de EVPN tipo 2 se están pasando correctamente en los centros de datos. Consulte Diseño e implementación de superposición de puentes enrutados centralmente para obtener instrucciones de configuración.

Esta sección cubre los procesos para configurar un DCI mediante rutas de tipo 5 de EVPN, e incluye los siguientes procedimientos:

- Configuración de interfaces de dispositivo troncal

- Habilitación del EBGP como protocolo de enrutamiento de red subyacente entre los dispositivos spine y los dispositivos troncales

- Habilitación del IBGP para la red superpuesta en el dispositivo troncal

- Habilitación del EBGP como protocolo de enrutamiento entre los dispositivos troncales

- Configuración de DCI mediante rutas EVPN tipo 5

- Verificar que DCI con rutas EVPN tipo 5 está funcionando

- DCI mediante rutas de tipo 5: historial de versiones

Configuración de interfaces de dispositivo troncal

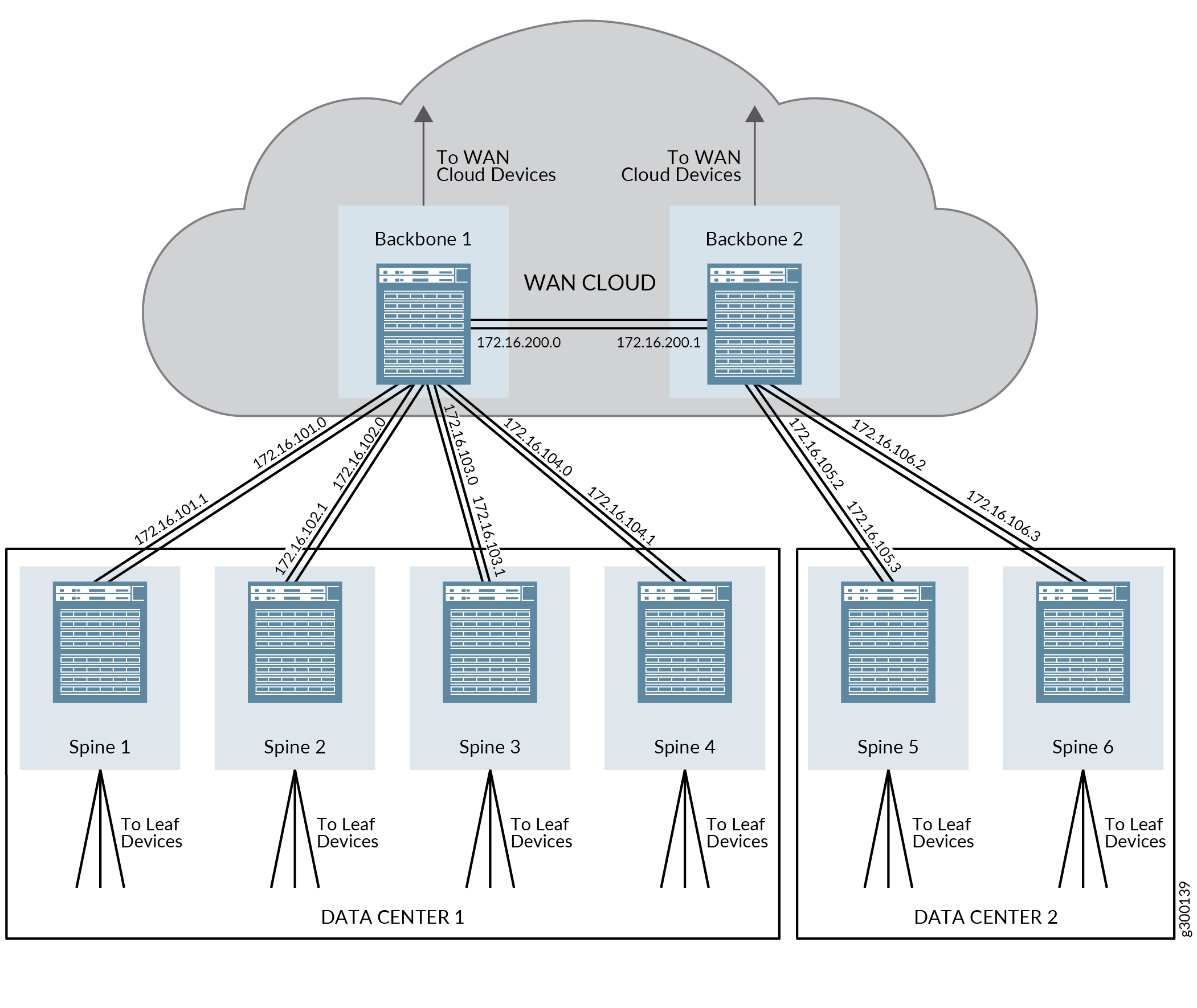

Los dispositivos troncales de esta arquitectura forman parte de la nube WAN y deben proporcionar conectividad tanto a los dispositivos spine de cada centro de datos como al otro dispositivo troncal. Esta conectividad debe establecerse antes de que se puedan intercambiar rutas EVPN tipo 5 entre dispositivos spine en diferentes centros de datos.

La Figura 2 proporciona una descripción general de las direcciones IP que se configuran en estos pasos.

troncales y spine

troncales y spine

Para configurar las interfaces del dispositivo spine y del dispositivo troncal:

(Interfaces Ethernet agregadas) Configure las interfaces Ethernet agregadas en los conmutadores de dispositivos spine en los centros de datos 1 y 2 y en los dispositivos troncales.

En este paso, se muestra la asignación de la dirección IP solo a las interfaces de Ethernet agregadas. Para obtener instrucciones paso a paso completas sobre la creación de interfaces Ethernet agregadas, consulte Configurar la agregación de vínculos.

Dispositivo spine 1 en el centro de datos 1:

set interfaces ae3 unit 0 family inet address 172.16.101.1/31

Dispositivo spine 2 en el centro de datos 1:

set interfaces ae3 unit 0 family inet address 172.16.102.1/31

Dispositivo spine 3 en el centro de datos 1:

set interfaces ae3 unit 0 family inet address 172.16.103.1/31

Dispositivo spine 4 en el centro de datos 1:

set interfaces ae3 unit 0 family inet address 172.16.104.1/31

Dispositivo spine 5 en el centro de datos 2:

set interfaces ae4 unit 0 family inet address 172.16.105.3/31

Dispositivo spine 6 en el centro de datos 2:

set interfaces ae4 unit 0 family inet address 172.16.106.3/31

Dispositivo troncal 1:

set interfaces ae1 unit 0 family inet address 172.16.101.0/31 set interfaces ae2 unit 0 family inet address 172.16.102.0/31 set interfaces ae3 unit 0 family inet address 172.16.103.0/31 set interfaces ae4 unit 0 family inet address 172.16.104.0/31 set interfaces ae200 unit 0 family inet address 172.16.200.0/31

Dispositivo troncal 2:

set interfaces ae5 unit 0 family inet address 172.16.105.2/31 set interfaces ae6 unit 0 family inet address 172.16.106.2/31 set interfaces ae200 unit 0 family inet address 172.16.200.1/31

(Interfaces independientes que no están incluidas en interfaces Ethernet agregadas) Consulte Configuración de la dirección de interfaz.

Habilitación del EBGP como protocolo de enrutamiento de red subyacente entre los dispositivos spine y los dispositivos troncales

El EBGP se utiliza como protocolo de enrutamiento de la red subyacente en este diseño de referencia. Los dispositivos troncales deben participar en el EBGP con los dispositivos spine para admitir la conectividad subyacente.

El proceso para habilitar el EBGP en los dispositivos spine and leaf está cubierto en la sección Diseño e implementación de red subyacente de estructura IP de esta guía. Este procedimiento supone que el EBGP ya se ha habilitado en los dispositivos spine y leaf, aunque alguna configuración de EBGP en los dispositivos spine debe actualizarse para admitir dispositivos troncales y, por lo tanto, se incluye en estos pasos.

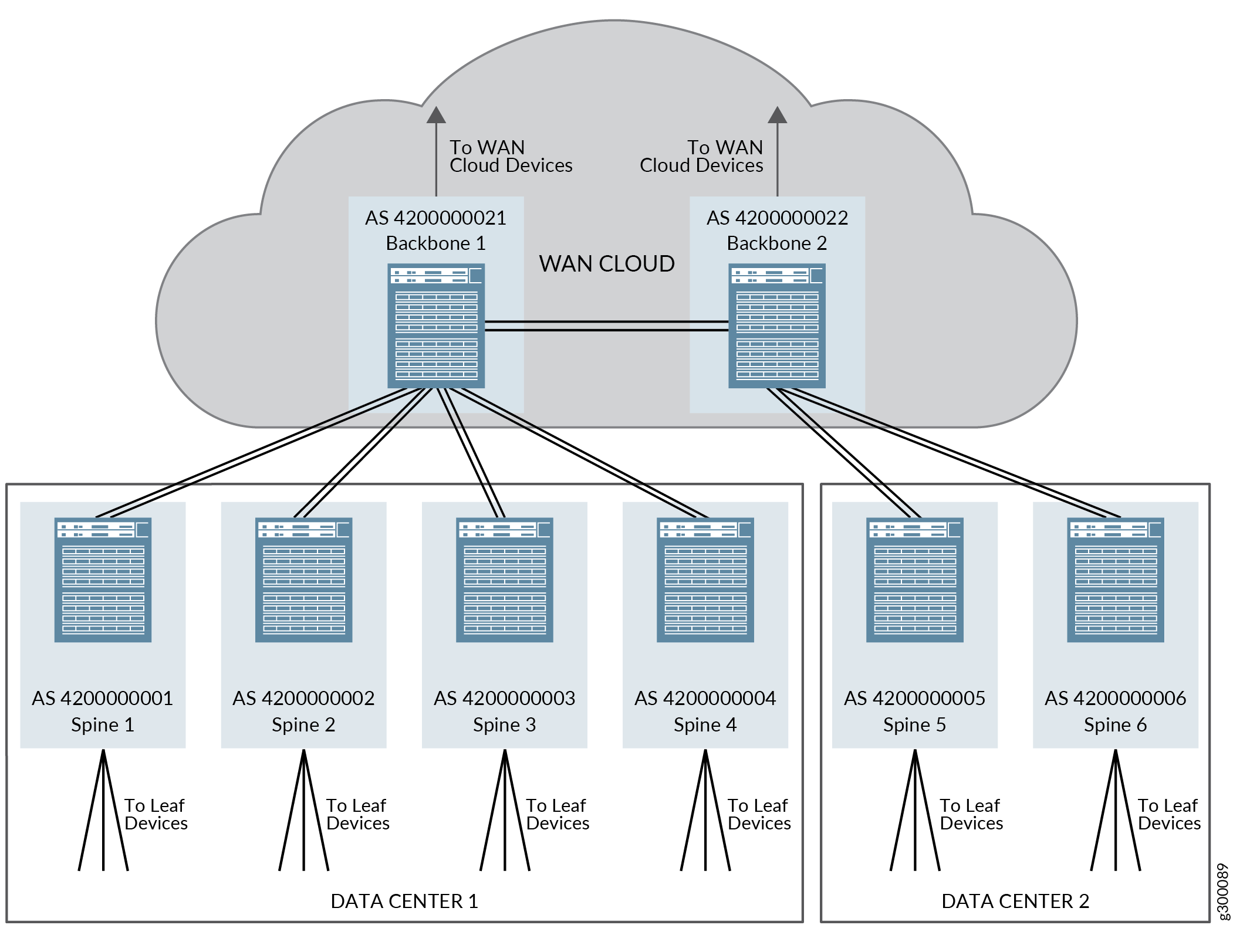

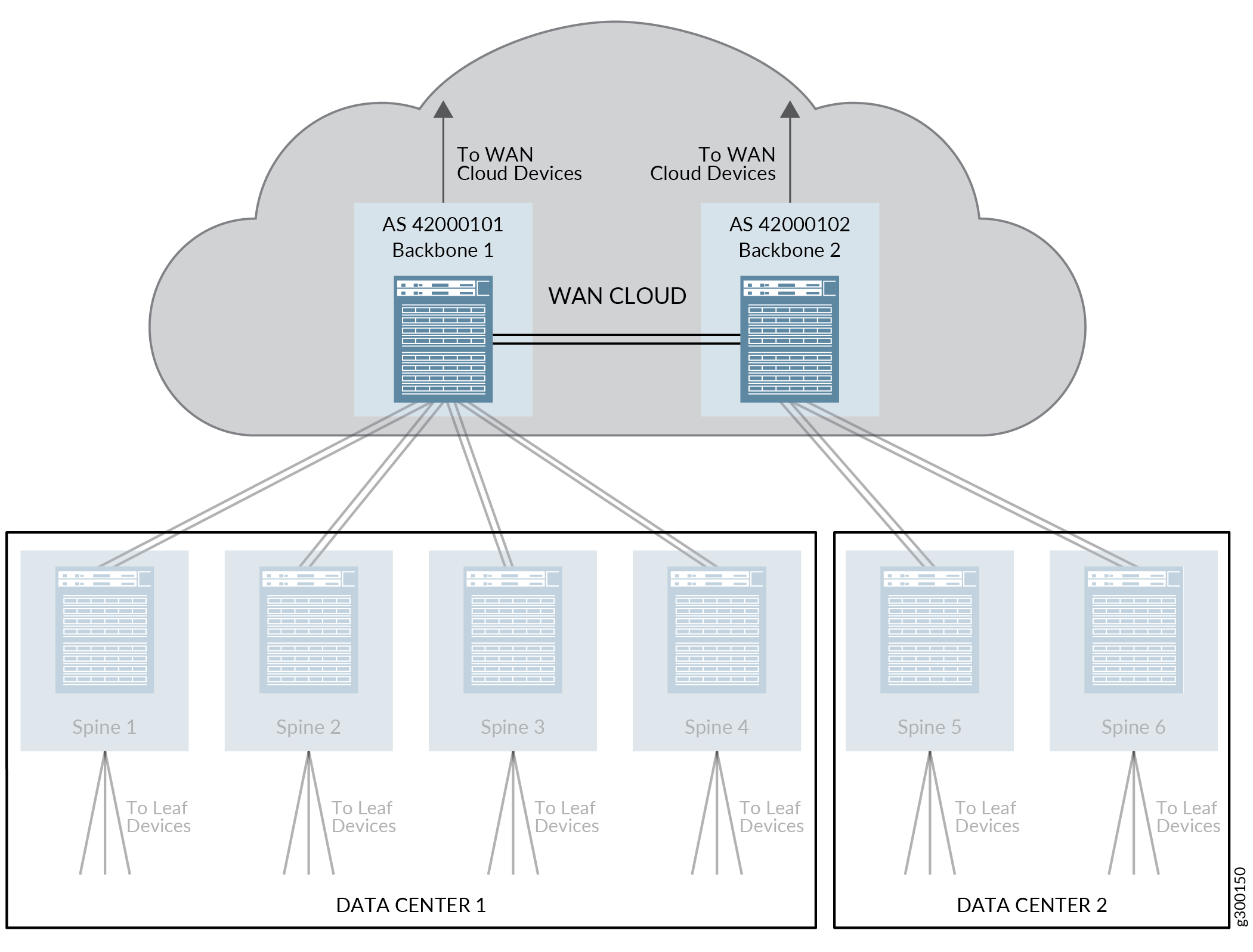

El EBGP funciona en este diseño de referencia mediante la asignación de cada dispositivo leaf, spine y backbone en su propio número único de sistema autónomo (AS) de 32 bits.

La Figura 3 muestra una descripción general de la topología del EBGP para los dispositivos spine y troncal cuando los dispositivos troncales se incluyen en el diseño de referencia.

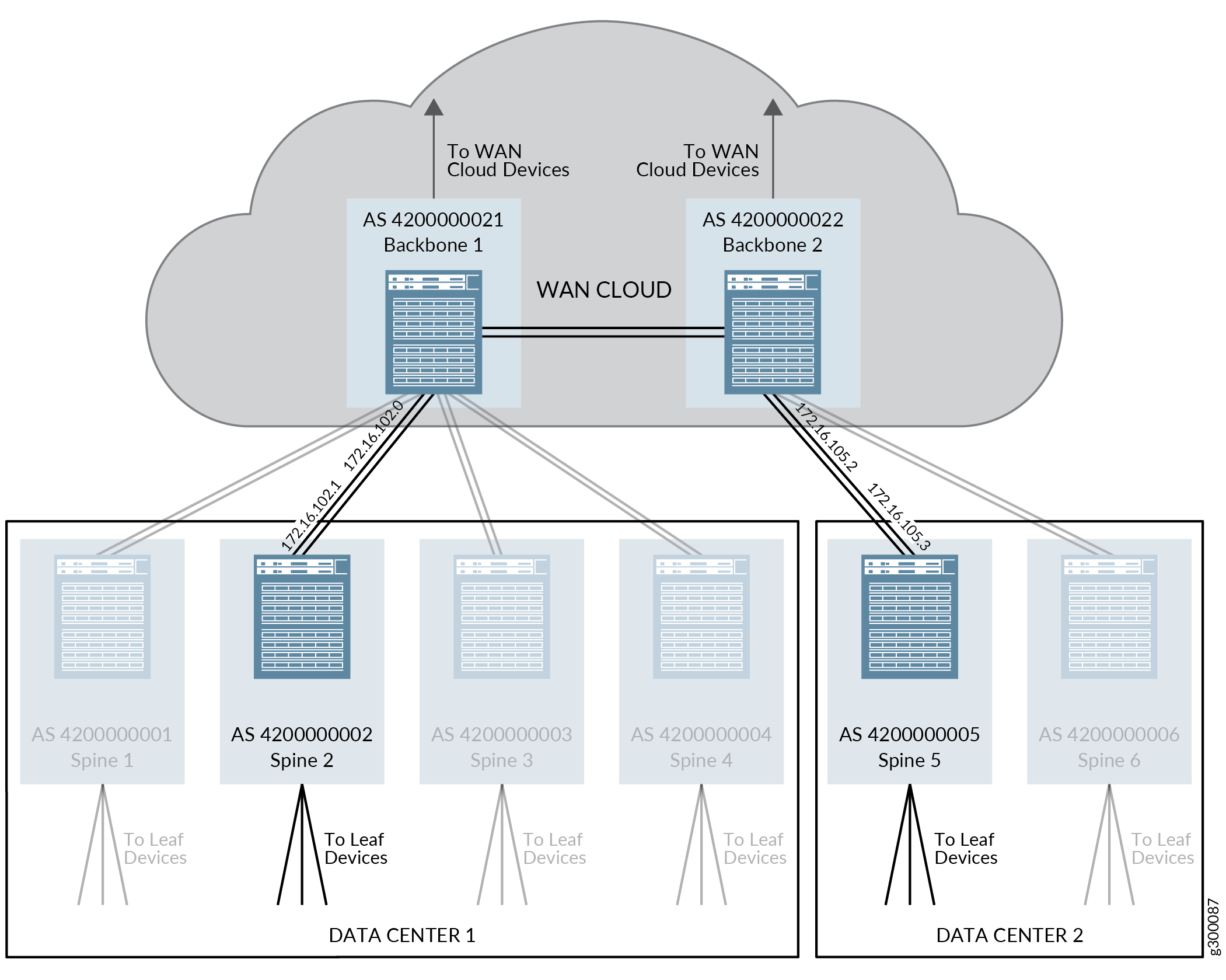

La figura 4 muestra los parámetros de protocolo EBGP que se configuran en este procedimiento. Repita este proceso para los otros dispositivos de la topología para habilitar EBGP en los dispositivos restantes.

troncal

troncal

Para permitir que el EBGP admita la red subyacente en este diseño de referencia:

Habilitación del IBGP para la red superpuesta en el dispositivo troncal

Los dispositivos troncales deben ejecutar IBGP para tener conectividad de red superpuesta y ser capaces de admitir DCI mediante rutas EVPN tipo 5.

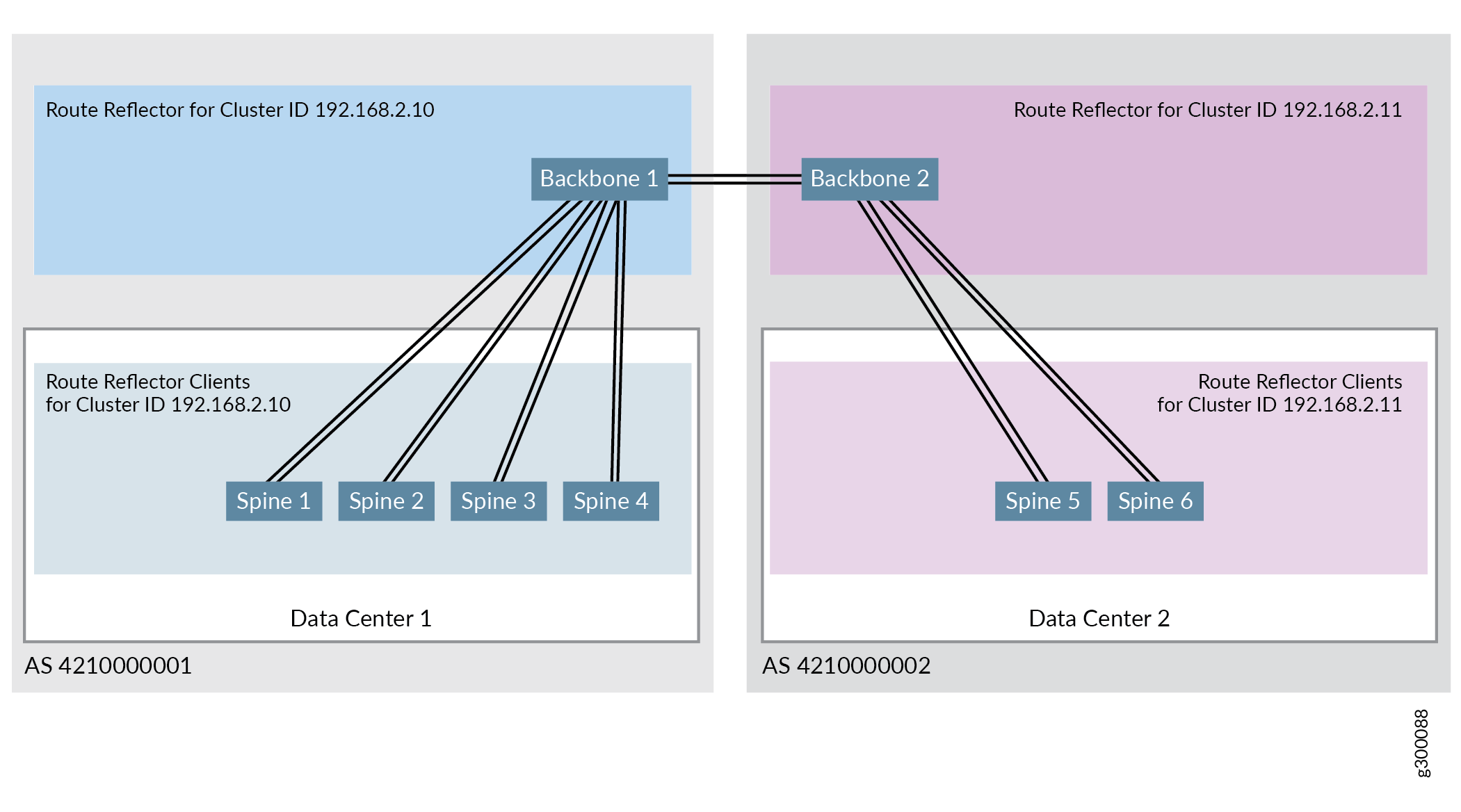

La Figura 5 muestra la configuración del IBGP del diseño de referencia validado cuando los dispositivos troncales se incluyen en la topología. En el diseño de referencia validado, todos los dispositivos spine y leaf del mismo centro de datos se asignan en el mismo sistema autónomo. Los dispositivos troncales se asignan al mismo sistema autónomo que los dispositivos spine y leaf del centro de datos que utiliza el dispositivo troncal como punto de entrada a la nube WAN.

La figura 6 muestra la configuración del reflector de ruta en el diseño de referencia validado. El clúster de reflector de una ruta (ID de clúster 192.168.2.10) incluye el dispositivo troncal 1 como reflector de ruta y todos los dispositivos spine del centro de datos 1 como clientes del reflector de ruta. Otro clúster de reflector de ruta, el ID de clúster 192.168.2.11, incluye el dispositivo troncal 2 como reflector de ruta y todos los dispositivos spine del centro de datos 2 como clientes del reflector de ruta.

de reflector de ruta IBGP

de reflector de ruta IBGP

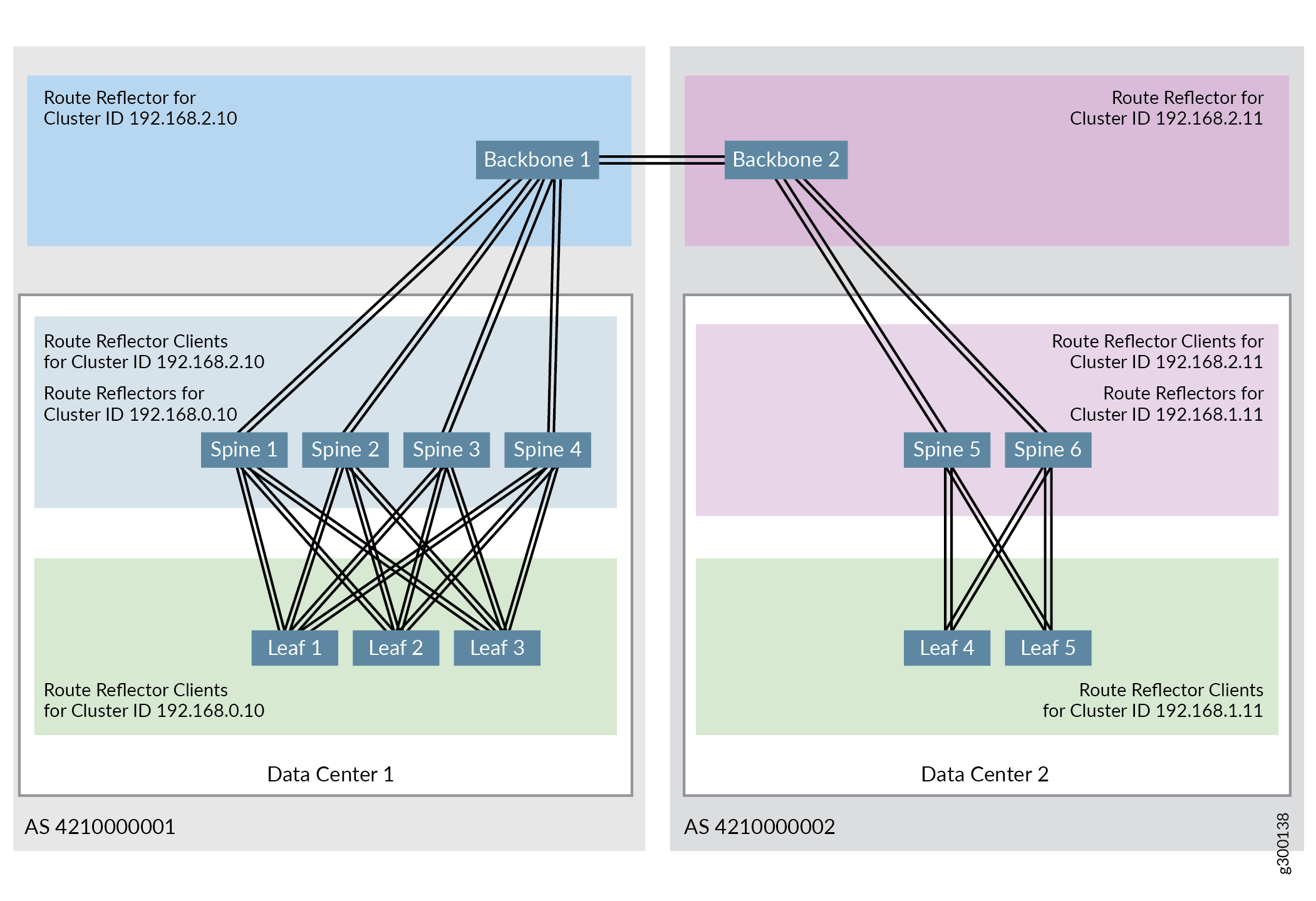

El diseño de referencia validado admite varios reflectores de ruta jerárquicos, donde un clúster incluye dispositivos troncales que actúan como reflectores de ruta para los clientes de dispositivos spine y otro clúster incluye dispositivos spine que actúan como reflectores de ruta para clientes de dispositivos leaf. Para ver los pasos de configuración para configurar el otro reflector de ruta, consulte Configurar IBGP para la superposición.

La Figura 7 muestra la topología de reflector de ruta jerárquica completa cuando se conectan dos centros de datos:

Para obtener más información sobre los reflector de ruta BGP, consulte Descripción de los reflector de ruta BGP.

En este procedimiento, se da por sentado que el IBGP se ha habilitado para los dispositivos spine and leaf, como se detalla en Configurar IBGP para la superposición. Las configuraciones del dispositivo spine se incluyen en este procedimiento para ilustrar sus relaciones con los dispositivos troncales.

Para configurar la conectividad del IBGP para los dispositivos troncales:

Habilitación del EBGP como protocolo de enrutamiento entre los dispositivos troncales

El EBGP también se utiliza como protocolo de enrutamiento entre los dispositivos troncales en este diseño de referencia. Los dispositivos troncales se conectan mediante IP y los dispositivos troncales deben configurarse como pares EBGP.

En estos pasos, se crea un segundo grupoBACKBONE-BGP de EBGP para habilitar el EBGP entre los dispositivos troncales. En estos pasos, se asigna a cada dispositivo troncal en un número de AS de 32 bits único dentro del nuevo grupo de EBGP. Por lo tanto, los dispositivos troncales forman parte de dos grupos de EBGP yUNDERLAY-BGP BACKBONE-BGP—y tienen un número de AS único dentro de cada grupo. La señalización de EVPN, que tiene que ejecutarse para admitir EVPN entre los dispositivos troncales, también se configura dentro del grupo EBGP durante este procedimiento.

La Figura 8 muestra los atributos necesarios para habilitar el EBGP entre los dispositivos troncales.

Para habilitar el EBGP como protocolo de enrutamiento entre los dispositivos troncales:

Configuración de DCI mediante rutas EVPN tipo 5

Los mensajes tipo 5 de EVPN se intercambian entre interfaces IRB en dispositivos spine en diferentes centros de datos cuando se utilizan rutas EVPN tipo 5 para DCI. Estas interfaces IRB se configuran en una instancia de enrutamiento.

Cada centro de datos tiene un identificador de red virtual único (VNI 102001 y 202001) en esta configuración, pero ambas VNI se asignan a la misma VLAN (VLAN 2001) en la misma instancia de enrutamiento (VRF 501).

Consulte la Figura 9 para ver una ilustración de la instancia de enrutamiento.

EVPN tipo 5

EVPN tipo 5

Para habilitar DCI mediante rutas EVPN tipo 5:

En este procedimiento, se da por sentado que las instancias de enrutamiento, las IRB y las VLAN creadas anteriormente en esta guía están operativas. Consulte Diseño e implementación de superposición de puentes enrutados centralmente.

Cuando implemente la funcionalidad leaf de borde en un enrutador MX, tenga en cuenta que el enrutador solo admite instancias de conmutador virtual. Los enrutadores MX no admiten instancias predeterminadas.

Verificar que DCI con rutas EVPN tipo 5 está funcionando

Ingrese los siguientes comandos para verificar que se puede enviar tráfico entre centros de datos mediante rutas de tipo 5 de EVPN:

DCI mediante rutas de tipo 5: historial de versiones

En la Tabla 1 se proporciona un historial de todas las características de esta sección y su soporte dentro de este diseño de referencia.

Lanzamiento |

Descripción |

|---|---|

19.1R2 |

Los conmutadores QFX10002-60C y QFX5120-32C que ejecutan la versión 19.1R2 de Junos OS y versiones posteriores en el mismo tren de versión admiten todas las funciones documentadas en esta sección. |

18.4R2-S2 |

Los conmutadores QFX5110 y QFX5120-48Y, y los enrutadores MX que ejecutan la versión 18.4R2-S2 de Junos OS y versiones posteriores en el mismo tren de versión admiten todas las funciones documentadas en esta sección. |