EN ESTA PÁGINA

Configuración del retraso antes de que los vecinos de LDP se consideren inactivos

Habilitación de mensajes de saludo dirigidos estrictos para LDP

Ejemplo: Configuración de la coincidencia más larga para LDP

Especificación de la dirección de transporte utilizada por LDP

Dirección de transporte de control utilizada para la sesión LDP dirigida

Configuración de los prefijos anunciados en LDP desde la tabla de enrutamiento

Configuración de una acción de error para la sesión BFD en un LSP LDP

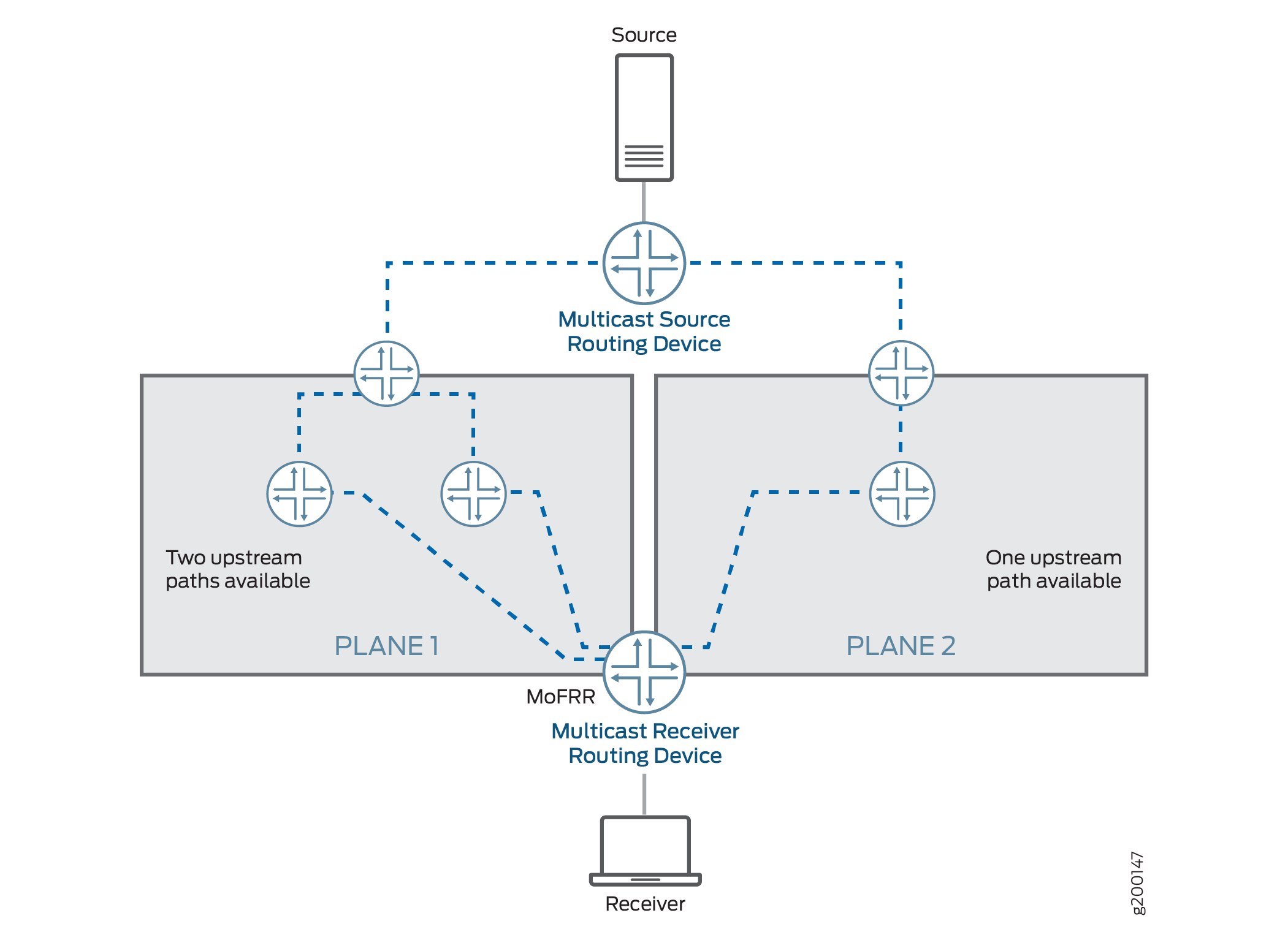

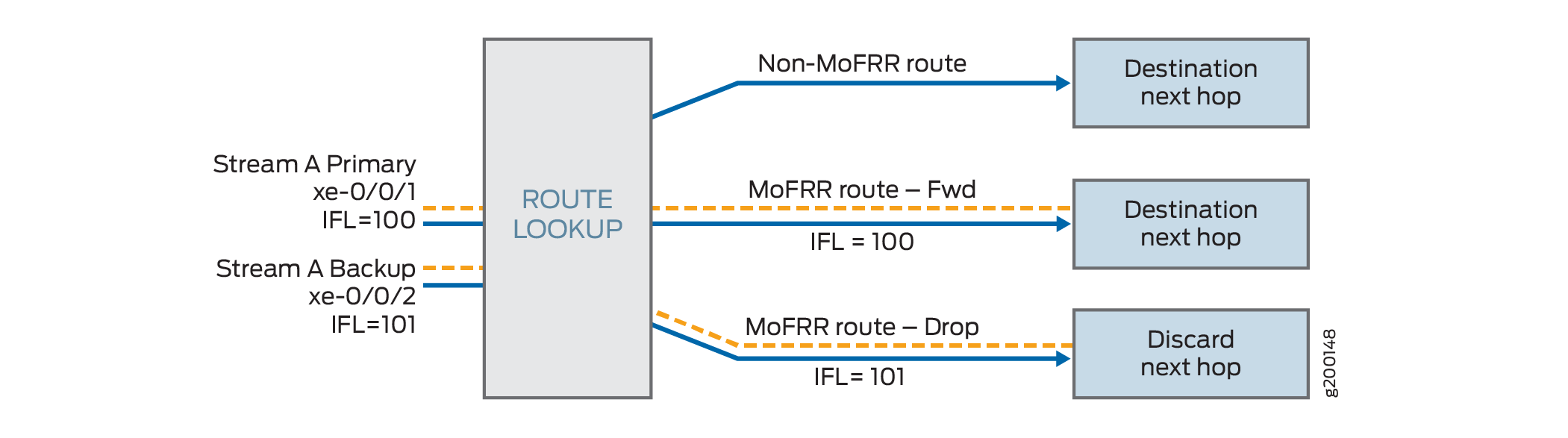

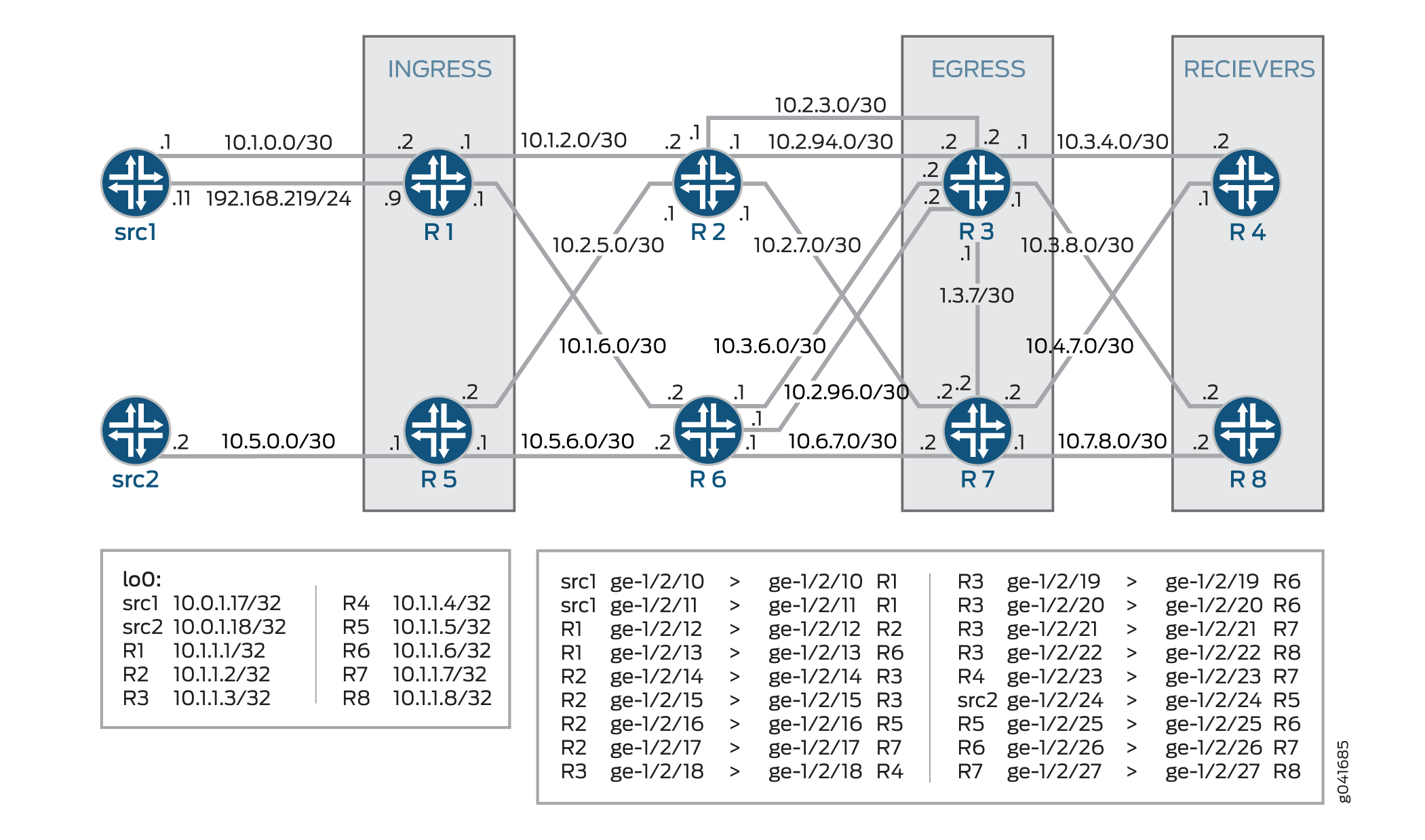

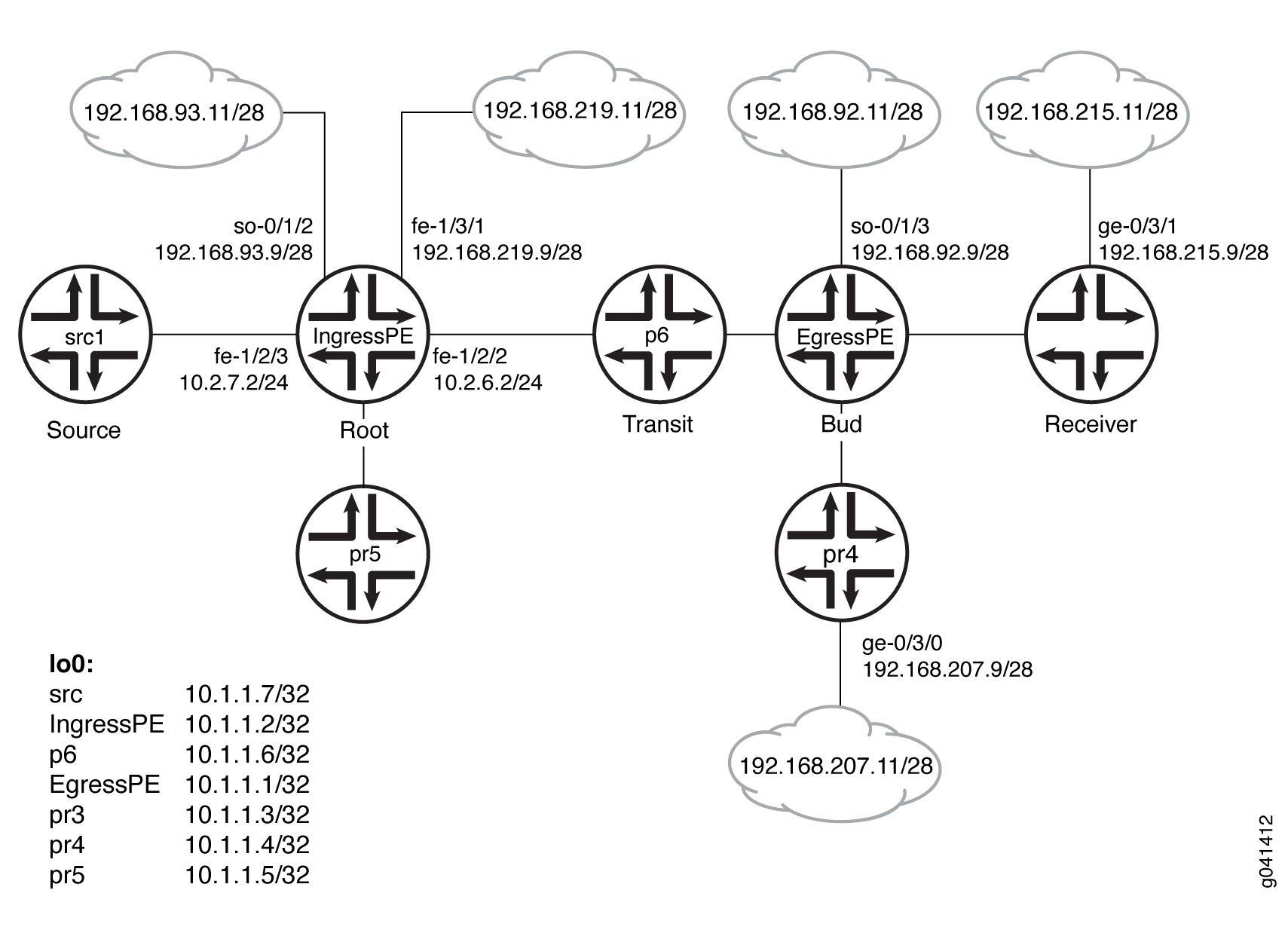

Configuración del reenrutamiento rápido solo de multidifusión

Ejemplo: Configuración del reenrutamiento rápido solo de multidifusión en un dominio LDP multipunto

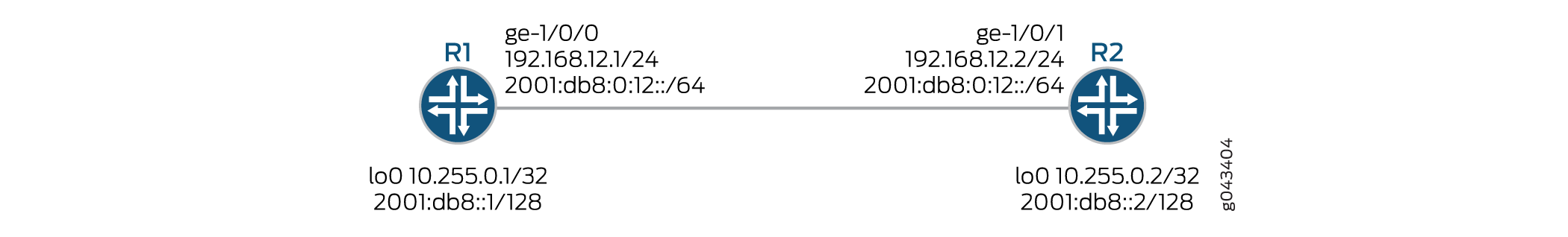

Ejemplo: Configuración de la compatibilidad con IPv6 nativo de LDP

Ejemplo: Configuración de la señalización en banda LDP multipunto para LSP de punto a multipunto

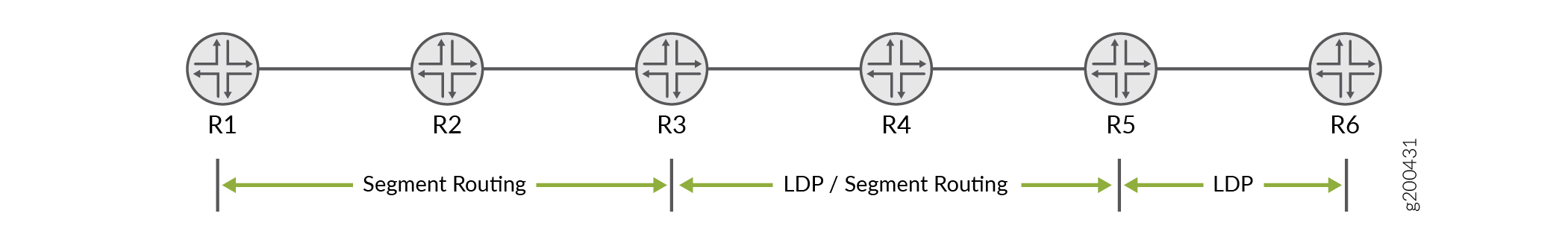

Asignación de cliente y servidor para enrutamiento de segmentos a la interoperabilidad de LDP

Configuración de LDP

Configuración mínima de LDP

Para habilitar LDP con una configuración mínima:

Habilite todas las interfaces relevantes en la familia MPLS. En el caso de LDP dirigido, la interfaz de circuito cerrado debe habilitarse con MPLS de familia.

(Opcional) Configure las interfaces relevantes en el nivel jerárquico

[edit protocol mpls].Habilite LDP en una sola interfaz, incluya la

ldpinstrucción y especifique la interfaz mediante lainterfaceinstrucción.

Esta es la configuración mínima de LDP. Todas las demás instrucciones de configuración de LDP son opcionales.

ldp { interface interface-name; }

Para habilitar LDP en todas las interfaces, especifique all .interface-name

Para obtener una lista de los niveles de jerarquía en los que puede incluir estas instrucciones, consulte las secciones de resumen de instrucciones.

Habilitar y deshabilitar LDP

LDP reconoce las instancias de enrutamiento. Para habilitar LDP en una interfaz específica, incluya las siguientes instrucciones:

ldp { interface interface-name; }

Para obtener una lista de los niveles de jerarquía en los que puede incluir estas instrucciones, consulte las secciones de resumen de instrucciones.

Para habilitar LDP en todas las interfaces, especifique all .interface-name

Si ha configurado propiedades de interfaz en un grupo de interfaces y desea deshabilitar LDP en una de las interfaces, incluya la interface instrucción con la disable opción:

interface interface-name { disable; }

Para obtener una lista de los niveles jerárquicos en los que puede incluir esta instrucción, consulte la sección Resumen de instrucciones.

Configuración del temporizador LDP para mensajes de saludo

Los mensajes de saludo de LDP permiten que los nodos de LDP se descubran entre sí y detecten la falla de un vecino o el vínculo con el vecino. Los mensajes de hola se envían periódicamente en todas las interfaces donde LDP está habilitado.

Hay dos tipos de mensajes de saludo LDP:

Mensajes de enlace de saludo: se envían a través de la interfaz LDP como paquetes UDP dirigidos al puerto de descubrimiento de LDP. La recepción de un mensaje de saludo de vínculo LDP en una interfaz identifica una adyacencia con el enrutador par LDP.

Mensajes de saludo dirigidos: se envían como paquetes UDP dirigidos al puerto de detección de LDP en una dirección específica. Los mensajes de saludo dirigidos se utilizan para admitir sesiones LDP entre enrutadores que no están conectados directamente. Un enrutador de destino determina si responder o ignorar un mensaje de saludo dirigido. Un enrutador de destino que elige responder lo hace enviando periódicamente mensajes de saludo dirigidos al enrutador iniciador.

De forma predeterminada, LDP envía mensajes de saludo cada 5 segundos para los mensajes de saludo de vínculo y cada 15 segundos para los mensajes de saludo dirigidos. Puede configurar el temporizador LDP para modificar la frecuencia con la que se envían ambos tipos de mensajes de saludo. Sin embargo, no puede configurar una hora para el temporizador LDP que sea mayor que el tiempo de espera LDP. Para obtener más información, consulte Configuración del retraso antes de que los vecinos de LDP se consideren inactivos.

- Configuración del temporizador LDP para mensajes de enlace de hola

- Configuración del temporizador LDP para mensajes de saludo dirigidos

Configuración del temporizador LDP para mensajes de enlace de hola

Para modificar la frecuencia con la que LDP envía mensajes de saludo de vínculo, especifique un nuevo intervalo de mensajes de saludo de vínculo para el temporizador de LDP mediante la hello-interval instrucción:

hello-interval seconds;

Para obtener una lista de los niveles jerárquicos en los que puede incluir esta instrucción, vea la sección de resumen de instrucción de esta instrucción.

Configuración del temporizador LDP para mensajes de saludo dirigidos

Para modificar la frecuencia con la que LDP envía mensajes de saludo dirigidos, especifique un nuevo intervalo de mensajes de saludo de destino para el temporizador de LDP configurando la hello-interval instrucción como una opción para la targeted-hello instrucción:

targeted-hello { hello-interval seconds; }

Para obtener una lista de los niveles jerárquicos en los que puede incluir estas instrucciones, consulte las secciones de resumen de instrucciones de estas instrucciones.

Configuración del retraso antes de que los vecinos de LDP se consideren inactivos

El tiempo de espera determina cuánto tiempo debe esperar un nodo LDP para recibir un mensaje de saludo antes de declarar que un vecino está inactivo. Este valor se envía como parte de un mensaje de saludo para que cada nodo LDP indique a sus vecinos cuánto tiempo deben esperar. Los valores enviados por cada vecino no tienen que coincidir.

El tiempo de espera normalmente debe ser al menos tres veces el intervalo de saludo. El valor predeterminado es de 15 segundos para los mensajes de enlace de saludo y de 45 segundos para los mensajes de saludo dirigidos. Sin embargo, es posible configurar un tiempo de espera de LDP que esté cerca del valor del intervalo de saludo.

Al configurar un tiempo de espera de LDP cerca del intervalo de saludo (menos de tres veces el intervalo de saludo), es posible que los errores de vecino de LDP se detecten más rápidamente. Sin embargo, esto también aumenta la posibilidad de que el enrutador pueda declarar un vecino LDP caído que todavía funciona normalmente. Para obtener más información, consulte Configuración del temporizador LDP para mensajes de saludo.

El tiempo de espera de LDP también se negocia automáticamente entre pares de LDP. Cuando dos pares de LDP se anuncian diferentes tiempos de espera de LDP entre sí, se utiliza el valor menor. Si un enrutador par LDP anuncia un tiempo de espera más corto que el valor que ha configurado, se utilizará el tiempo de espera anunciado del enrutador par. Esta negociación también puede afectar al intervalo keepalive del PLD.

Si el tiempo de retención de LDP local no se acorta durante la negociación del par de LDP, el intervalo keepalive configurado por el usuario se deja sin cambios. Sin embargo, si el tiempo de espera local se reduce durante la negociación entre pares, se vuelve a calcular el intervalo keepalive. Si el tiempo de espera del LDP se ha reducido durante la negociación entre pares, el intervalo keepalive se reduce a un tercio del nuevo valor de tiempo de retención. Por ejemplo, si el nuevo valor de tiempo de espera es de 45 segundos, el intervalo keepalive se establece en 15 segundos.

Este cálculo automatizado del intervalo keepalive puede hacer que se configuren diferentes intervalos keepalive en cada enrutador par. Esto permite que los enrutadores sean flexibles en la frecuencia con la que envían mensajes keepalive, ya que la negociación del par LDP garantiza que se envíen con más frecuencia que el tiempo de espera del LDP.

Cuando se vuelve a configurar el intervalo de tiempo de espera, los cambios no surten efecto hasta después de restablecer la sesión. El tiempo de espera se negocia cuando se inicia la sesión de emparejamiento LDP y no se puede renegociar mientras la sesión esté activa (requerido por RFC 5036, Especificación LDP). Para forzar manualmente el restablecimiento de la sesión LDP, ejecute el clear ldp session comando.

- Configuración del tiempo de espera de LDP para mensajes de enlace Hello

- Configuración del tiempo de espera de LDP para mensajes de saludo dirigidos

Configuración del tiempo de espera de LDP para mensajes de enlace Hello

Para modificar cuánto tiempo debe esperar un nodo LDP para recibir un mensaje de saludo de vínculo antes de declarar al vecino inactivo, especifique una nueva hora en segundos mediante la hold-time instrucción:

hold-time seconds;

Para obtener una lista de los niveles jerárquicos en los que puede incluir esta instrucción, vea la sección de resumen de instrucción de esta instrucción.

Configuración del tiempo de espera de LDP para mensajes de saludo dirigidos

Para modificar cuánto tiempo debe esperar un nodo LDP para recibir un mensaje de saludo dirigido antes de declarar al vecino caído, especifique una nueva hora en segundos usando la hold-time instrucción como una opción para la targeted-hello instrucción:

targeted-hello { hold-time seconds; }

Para obtener una lista de los niveles jerárquicos en los que puede incluir estas instrucciones, consulte las secciones de resumen de instrucciones de estas instrucciones.

Habilitación de mensajes de saludo dirigidos estrictos para LDP

Utilice mensajes de saludo dirigidos estrictos para evitar que se establezcan sesiones de LDP con vecinos remotos que no se hayan configurado específicamente. Si configura la strict-targeted-hellos instrucción, un par LDP no responde a los mensajes de saludo dirigidos procedentes de un origen que no sea uno de sus vecinos remotos configurados. Los vecinos remotos configurados pueden incluir:

Puntos de conexión de túneles RSVP para los que está configurada la tunelización LDP

Vecinos del circuito de capa 2

Si un vecino no configurado envía un mensaje de saludo, el par LDP ignora el mensaje y registra un error (con la marca de error seguimiento) que indica el origen. Por ejemplo, si el interlocutor de LDP recibió un saludo de destino de la dirección de Internet 10.0.0.1 y no hay ningún vecino con esta dirección configurado específicamente, se imprime el siguiente mensaje en el archivo de registro de LDP:

LDP: Ignoring targeted hello from 10.0.0.1

Para habilitar mensajes de saludo dirigidos estrictamente, incluya la strict-targeted-hellos instrucción:

strict-targeted-hellos;

Para obtener una lista de los niveles jerárquicos en los que puede incluir esta instrucción, vea la sección de resumen de instrucción de esta instrucción.

Configuración del intervalo para mensajes keepalive de LDP

El intervalo keepalive determina la frecuencia con la que se envía un mensaje a través de la sesión para garantizar que no se supere el tiempo de espera keepalive. Si no se envía ningún otro tráfico LDP a través de la sesión en tanto tiempo, se envía un mensaje keepalive. El valor predeterminado es de 10 segundos. El valor mínimo es 1 segundo.

El valor configurado para el intervalo keepalive se puede modificar durante la negociación de la sesión LDP si el valor configurado para el tiempo de espera de LDP en el enrutador par es menor que el valor configurado localmente. Para obtener más información, consulte Configuración del retraso antes de que los vecinos de LDP se consideren inactivos.

Para modificar el intervalo keepalive, incluya la keepalive-interval instrucción:

keepalive-interval seconds;

Para obtener una lista de los niveles jerárquicos en los que puede incluir esta instrucción, vea la sección de resumen de instrucción de esta instrucción.

Configuración del tiempo de espera de mantenimiento de LDP

Después de establecer una sesión LDP, los mensajes deben intercambiarse periódicamente para asegurarse de que la sesión sigue funcionando. El tiempo de espera de keepalive define la cantidad de tiempo que espera el nodo LDP vecino antes de decidir que la sesión ha fallado. Este valor generalmente se establece en al menos tres veces el intervalo keepalive. El valor predeterminado es de 30 segundos.

Para modificar el intervalo keepalive, incluya la keepalive-timeout instrucción:

keepalive-timeout seconds;

Para obtener una lista de los niveles jerárquicos en los que puede incluir esta instrucción, vea la sección de resumen de instrucción de esta instrucción.

El valor configurado para la keepalive-timeout instrucción se muestra como el tiempo de espera cuando se ejecuta el show ldp session detail comando.

Configuración de la coincidencia más larga para LDP

Para permitir que LDP aprenda las rutas agregadas o resumidas en las áreas de OSPF o los niveles de ISIS entre dominios, Junos OS le permite configurar la coincidencia más larga para LDP en función de RFC5283.

Antes de configurar la coincidencia más larga para LDP, debe hacer lo siguiente:

Configure las interfaces del dispositivo.

Configure el protocolo MPLS .

Configure el protocolo OSPF.

Para configurar la coincidencia más larga para LDP, debe hacer lo siguiente:

Ejemplo: Configuración de la coincidencia más larga para LDP

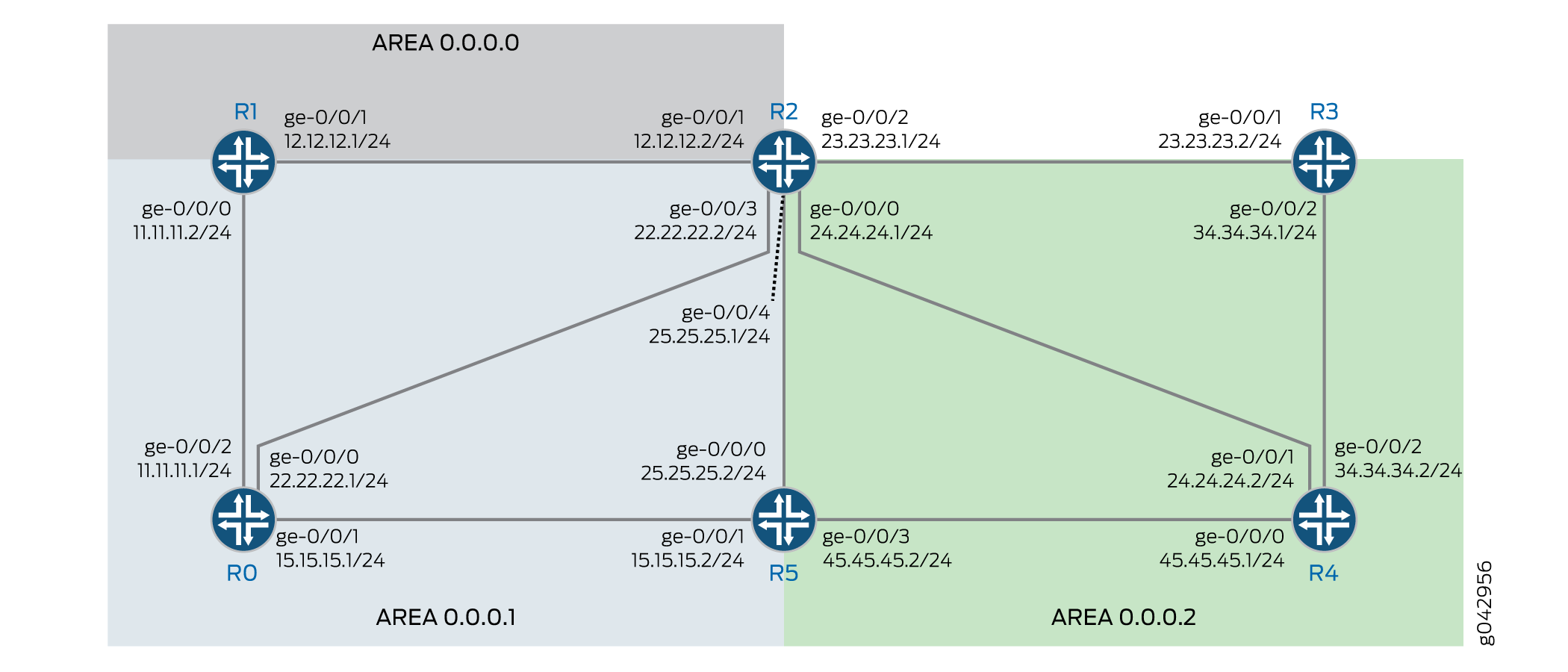

En este ejemplo se muestra cómo configurar la coincidencia más larga para LDP en función de RFC5283. Esto permite a LDP aprender las rutas agregadas o resumidas a través de las áreas OSPF o niveles de ISIS en interdominio. La política de coincidencia más larga proporciona granularidad por prefijo.

Requisitos

En este ejemplo, se utilizan los siguientes componentes de hardware y software:

Seis enrutadores de la serie MX con protocolo OSPF y LDP habilitado en las interfaces conectadas.

Junos OS versión 16.1 o posterior ejecutándose en todos los dispositivos.

Antes de empezar:

Configure las interfaces del dispositivo.

Configure OSPF.

Descripción general

LDP se utiliza a menudo para establecer rutas de conmutación de etiquetas (LSP) MPLS en un dominio de red completo mediante un IGP como OSPF o IS-IS. En dicha red, todos los enlaces en el dominio tienen adyacencias IGP, así como adyacencias LDP. LDP establece los LSP en la ruta más corta a un destino según lo determinado por el reenvío de IP. En Junos OS, la implementación de LDP realiza una búsqueda de coincidencia exacta en la dirección IP del FEC en las rutas RIB o IGP para la asignación de etiquetas. Esta asignación exacta requiere que las direcciones IP del punto de conexión LDP de extremo a extremo de MPLS estén configuradas en todos los LER. Esto frustra el propósito del diseño jerárquico IP o el enrutamiento predeterminado en los dispositivos de acceso. La configuración longest-match ayuda a superar esto al suprimir el comportamiento exacto de coincidencia y configurar LSP basado en la ruta de coincidencia más larga por prefijo.

Topología

En la topología, Figura 1muestra que la coincidencia más larga para LDP está configurada en el dispositivo R0.

Configuración

Configuración rápida de CLI

Para configurar rápidamente este ejemplo, copie los siguientes comandos, péguelos en un archivo de texto, elimine los saltos de línea, cambie los detalles necesarios para que coincidan con su configuración de red, copie y pegue los comandos en la CLI en el nivel de jerarquía [edit] y, luego, ingrese commit desde el modo de configuración.

R0

set interfaces ge-0/0/0 unit 0 family inet address 22.22.22.1/24 set interfaces ge-0/0/1 unit 0 family inet address 15.15.15.1/24 set interfaces ge-0/0/2 unit 0 family inet address 11.11.11.1/24 set interfaces ge-0/0/2 unit 0 family iso set interfaces ge-0/0/2 unit 0 family mpls set interfaces lo0 unit 0 family inet address 10.255.112.1/32 primary set interfaces lo0 unit 0 family inet address 10.255.112.1/32 preferred set interfaces lo0 unit 0 family iso address 49.0002.0192.0168.0001.00 set routing-options router-id 10.255.112.1 set protocols mpls interface ge-0/0/2.0 set protocols ospf area 0.0.0.1 interface ge-0/0/2.0 set protocols ospf area 0.0.0.1 interface lo0.0 passive set protocols ldp longest-match set protocols ldp interface ge-0/0/2.0 set protocols ldp interface lo0.0

R1

set interfaces ge-0/0/0 unit 0 family inet address 11.11.11.2/24 set interfaces ge-0/0/0 unit 0 family iso set interfaces ge-0/0/0 unit 0 family mpls set interfaces ge-0/0/1 unit 0 family inet address 12.12.12.1/24 set interfaces ge-0/0/1 unit 0 family iso set interfaces ge-0/0/1 unit 0 family mpls set interfaces lo0 unit 0 family inet address 10.255.112.2/32 primary set interfaces lo0 unit 0 family inet address 10.255.112.2/32 preferred set interfaces lo0 unit 0 family iso address 49.0002.0192.0168.0002.00 set routing-options router-id 10.255.112.2 set protocols mpls interface ge-0/0/0.0 set protocols mpls interface ge-0/0/1.0 set protocols ospf area 0.0.0.0 interface ge-0/0/1.0 set protocols ospf area 0.0.0.0 interface lo0.0 passive set protocols ospf area 0.0.0.1 interface ge-0/0/0.0 set protocols ldp longest-match set protocols ldp interface ge-0/0/0.0 set protocols ldp interface ge-0/0/1.0 set protocols ldp interface lo0.0

R2

set interfaces ge-0/0/0 unit 0 family inet address 24.24.24.1/24 set interfaces ge-0/0/0 unit 0 family iso set interfaces ge-0/0/0 unit 0 family mpls set interfaces ge-0/0/1 unit 0 family inet address 12.12.12.2/24 set interfaces ge-0/0/1 unit 0 family iso set interfaces ge-0/0/1 unit 0 family mpls set interfaces ge-0/0/2 unit 0 family inet address 23.23.23.1/24 set interfaces ge-0/0/2 unit 0 family iso set interfaces ge-0/0/2 unit 0 family mpls set interfaces ge-0/0/3 unit 0 family inet address 22.22.22.2/24 set interfaces ge-0/0/4 unit 0 family inet address 25.25.25.1/24 set interfaces ge-0/0/4 unit 0 family iso set interfaces ge-0/0/4 unit 0 family mpls set interfaces lo0 unit 0 family inet address 10.255.111.4/32 primary set interfaces lo0 unit 0 family inet address 10.255.111.4/32 preferred set interfaces lo0 unit 0 family iso address 49.0003.0192.0168.0003.00 set routing-options router-id 10.255.111.4 set protocols mpls interface ge-0/0/1.0 set protocols mpls interface ge-0/0/2.0 set protocols mpls interface ge-0/0/0.0 set protocols mpls interface ge-0/0/4.0 set protocols ospf area 0.0.0.0 interface ge-0/0/1.0 set protocols ospf area 0.0.0.0 interface lo0.0 passive set protocols ospf area 0.0.0.2 area-range 10.255.111.0/24 set protocols ospf area 0.0.0.2 interface ge-0/0/2.0 set protocols ospf area 0.0.0.2 interface ge-0/0/0.0 set protocols ospf area 0.0.0.2 interface ge-0/0/4.0 set protocols ldp interface ge-0/0/0.0 set protocols ldp interface ge-0/0/1.0 set protocols ldp interface ge-0/0/2.0 set protocols ldp interface ge-0/0/4.0 set protocols ldp interface lo0.0

R3

set interfaces ge-0/0/0 unit 0 family inet address 35.35.35.1/24 set interfaces ge-0/0/0 unit 0 family iso set interfaces ge-0/0/0 unit 0 family mpls set interfaces ge-0/0/1 unit 0 family inet address 23.23.23.2/24 set interfaces ge-0/0/1 unit 0 family iso set interfaces ge-0/0/1 unit 0 family mpls set interfaces ge-0/0/2 unit 0 family inet address 34.34.34.1/24 set interfaces ge-0/0/2 unit 0 family iso set interfaces ge-0/0/2 unit 0 family mpls set interfaces lo0 unit 0 family inet address 10.255.111.1/32 primary set interfaces lo0 unit 0 family inet address 10.255.111.1/32 preferred set interfaces lo0 unit 0 family iso address 49.0003.0192.0168.0004.00 set routing-options router-id 10.255.111.1 set protocols mpls interface ge-0/0/1.0 set protocols ospf area 0.0.0.2 interface ge-0/0/1.0 set protocols ospf area 0.0.0.2 interface fxp0.0 disable set protocols ospf area 0.0.0.2 interface lo0.0 passive set protocols ldp interface ge-0/0/1.0 set protocols ldp interface lo0.0

R4

set interfaces ge-0/0/0 unit 0 family inet address 45.45.45.1/24 set interfaces ge-0/0/0 unit 0 family iso set interfaces ge-0/0/0 unit 0 family mpls set interfaces ge-0/0/1 unit 0 family inet address 24.24.24.2/24 set interfaces ge-0/0/1 unit 0 family iso set interfaces ge-0/0/1 unit 0 family mpls set interfaces ge-0/0/2 unit 0 family inet address 34.34.34.2/24 set interfaces ge-0/0/2 unit 0 family iso set interfaces ge-0/0/2 unit 0 family mpls set interfaces lo0 unit 0 family inet address 10.255.111.2/32 primary set interfaces lo0 unit 0 family inet address 10.255.111.2/32 preferred set interfaces lo0 unit 0 family iso address 49.0003.0192.0168.0005.00 set routing-options router-id 10.255.111.2 set protocols mpls interface ge-0/0/1.0 set protocols ospf area 0.0.0.2 interface ge-0/0/1.0 set protocols ospf area 0.0.0.2 interface fxp0.0 disable set protocols ospf area 0.0.0.2 interface lo0.0 passive set protocols ldp interface ge-0/0/1.0 set protocols ldp interface lo0.0

R5

set interfaces ge-0/0/0 unit 0 family inet address 25.25.25.2/24 set interfaces ge-0/0/0 unit 0 family iso set interfaces ge-0/0/0 unit 0 family mpls set interfaces ge-0/0/1 unit 0 family inet address 15.15.15.2/24 set interfaces ge-0/0/2 unit 0 family inet address 35.35.35.2/24 set interfaces ge-0/0/3 unit 0 family inet address 45.45.45.2/24 set interfaces ge-0/0/3 unit 0 family iso set interfaces ge-0/0/3 unit 0 family mpls set interfaces lo0 unit 0 family inet address 10.255.111.3/32 primary set interfaces lo0 unit 0 family inet address 10.255.111.3/32 preferred set interfaces lo0 unit 0 family iso address 49.0003.0192.0168.0006.00 set routing-options router-id 10.255.111.3 set protocols mpls interface ge-0/0/0.0 set protocols ospf area 0.0.0.2 interface ge-0/0/0.0 set protocols ospf area 0.0.0.2 interface fxp0.0 disable set protocols ospf area 0.0.0.2 interface lo0.0 passive set protocols ldp interface ge-0/0/0.0 set protocols ldp interface lo0.0

Configuración del dispositivo R0

Procedimiento paso a paso

El ejemplo siguiente requiere que navegue por varios niveles en la jerarquía de configuración. Para obtener información acerca de cómo navegar por la CLI, consulte Uso del editor de CLI en modo de configuración en la Guía del usuario de CLI.

Para configurar el dispositivo R0:

Configure las interfaces.

[edit interfaces] set ge-0/0/0 unit 0 family inet address 22.22.22.1/24 set ge-0/0/1 unit 0 family inet address 15.15.15.1/24 set ge-0/0/2 unit 0 family inet address 11.11.11.1/24 set ge-0/0/2 unit 0 family iso set ge-0/0/2 unit 0 family mpls

Asigne las direcciones de circuito cerrado al dispositivo.

[edit interfaces lo0 unit 0 family] set inet address 10.255.112.1/32 primary set inet address 10.255.112.1/32 preferred set iso address 49.0002.0192.0168.0001.00

Configure el ID del enrutador.

[edit routing-options] set router-id 10.255.112.1

Configure el protocolo MPLS en la interfaz.

[edit protocols mpls] set interface ge-0/0/2.0

Configure el protocolo OSPF en la interfaz.

[edit protocols ospf] set area 0.0.0.1 interface ge-0/0/2.0 set area 0.0.0.1 interface lo0.0 passive

Configure la coincidencia más larga para el protocolo LDP.

[edit protocols ldp] set longest-match

Configure el protocolo LDP en la interfaz.

[edit protocols ldp] set interface ge-0/0/2.0 set interface lo0.0

Resultados

Desde el modo de configuración, escriba los comandos , y show routing-options para confirmar la show interfacesconfiguración. show protocols Si el resultado no muestra la configuración deseada, repita las instrucciones en este ejemplo para corregir la configuración.

user@R0# show interfaces

ge-0/0/0 {

unit 0 {

family inet {

address 22.22.22.1/24;

}

}

}

ge-0/0/1 {

unit 0 {

family inet {

address 15.15.15.1/24;

}

}

}

ge-0/0/2 {

unit 0 {

family inet {

address 11.11.11.1/24;

}

family iso;

family mpls;

}

}

lo0 {

unit 0 {

family inet {

address 10.255.112.1/32 {

primary;

preferred;

}

}

family iso {

address 49.0002.0192.0168.0001.00;

}

}

}

user@R0# show protocols

mpls {

interface ge-0/0/2.0;

}

ospf {

area 0.0.0.1 {

interface ge-0/0/2.0;

interface lo0.0 {

passive;

}

}

}

ldp {

longest-match;

interface ge-0/0/2.0;

interface lo0.0;

}

user@R0# show routing-options router-id 10.255.112.1;

Si ha terminado de configurar el dispositivo, ingrese commit desde el modo de configuración.

Verificación

Confirme que la configuración funcione correctamente.

- Verificación de las rutas

- Verificación de la información general de LDP

- Comprobar las entradas LDP en la tabla de topología interna

- Verifique solo la información FEC de la ruta LDP

- Verificar FEC y rutas ocultas de LDP

Verificación de las rutas

Propósito

Compruebe que se han aprendido las rutas esperadas.

Acción

En el dispositivo R0, desde el modo operativo, ejecute el show route comando para mostrar las rutas en la tabla de enrutamiento.

user@R0> show route

inet.0: 62 destinations, 62 routes (62 active, 0 holddown, 0 hidden)

+ = Active Route, - = Last Active, * = Both

10.4.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.5.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.6.128.0/17 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.9.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.10.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.13.4.0/23 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.13.10.0/23 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.82.0.0/15 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.84.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.85.12.0/22 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.92.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.92.16.0/20 *[Direct/0] 10:08:01

> via fxp0.0

10.92.20.175/32 *[Local/0] 10:08:01

Local via fxp0.0

10.94.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.99.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.102.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.150.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.155.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.157.64.0/19 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.160.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.204.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.205.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.206.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.207.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.209.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.212.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.213.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.214.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.215.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.216.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.218.13.0/24 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.218.14.0/24 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.218.16.0/20 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.218.32.0/20 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.227.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.255.111.0/24 *[OSPF/10] 09:52:14, metric 3

> to 11.11.11.2 via ge-0/0/2.0

10.255.111.4/32 *[OSPF/10] 09:54:10, metric 2

> to 11.11.11.2 via ge-0/0/2.0

10.255.112.1/32 *[Direct/0] 09:55:05

> via lo0.0

10.255.112.2/32 *[OSPF/10] 09:54:18, metric 1

> to 11.11.11.2 via ge-0/0/2.0

11.11.11.0/24 *[Direct/0] 09:55:05

> via ge-0/0/2.0

11.11.11.1/32 *[Local/0] 09:55:05

Local via ge-0/0/2.0

12.12.12.0/24 *[OSPF/10] 09:54:18, metric 2

> to 11.11.11.2 via ge-0/0/2.0

15.15.15.0/24 *[Direct/0] 09:55:05

> via ge-0/0/1.0

15.15.15.1/32 *[Local/0] 09:55:05

Local via ge-0/0/1.0

22.22.22.0/24 *[Direct/0] 09:55:05

> via ge-0/0/0.0

22.22.22.1/32 *[Local/0] 09:55:05

Local via ge-0/0/0.0

23.23.23.0/24 *[OSPF/10] 09:54:10, metric 3

> to 11.11.11.2 via ge-0/0/2.0

24.24.24.0/24 *[OSPF/10] 09:54:10, metric 3

> to 11.11.11.2 via ge-0/0/2.0

25.25.25.0/24 *[OSPF/10] 09:54:10, metric 3

> to 11.11.11.2 via ge-0/0/2.0

128.92.17.45/32 *[OSPF/10] 09:54:05, metric 3

> to 11.11.11.2 via ge-0/0/2.0

128.92.20.175/32 *[Direct/0] 10:08:01

> via lo0.0

128.92.21.186/32 *[OSPF/10] 09:54:10, metric 3

> to 11.11.11.2 via ge-0/0/2.0

128.92.25.135/32 *[OSPF/10] 09:54:10, metric 3

> to 11.11.11.2 via ge-0/0/2.0

128.92.27.91/32 *[OSPF/10] 09:54:18, metric 1

> to 11.11.11.2 via ge-0/0/2.0

128.92.28.70/32 *[OSPF/10] 09:54:10, metric 2

> to 11.11.11.2 via ge-0/0/2.0

172.16.0.0/12 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

192.168.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

192.168.102.0/23 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

207.17.136.0/24 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

207.17.136.192/32 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

207.17.137.0/24 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

224.0.0.5/32 *[OSPF/10] 09:55:05, metric 1

MultiRecv

inet.3: 5 destinations, 5 routes (5 active, 0 holddown, 0 hidden)

+ = Active Route, - = Last Active, * = Both

10.255.111.1/32 *[LDP/9] 09:41:03, metric 3

> to 11.11.11.2 via ge-0/0/2.0, Push 300128

10.255.111.2/32 *[LDP/9] 09:41:03, metric 3

> to 11.11.11.2 via ge-0/0/2.0, Push 300144

10.255.111.3/32 *[LDP/9] 09:41:03, metric 3

> to 11.11.11.2 via ge-0/0/2.0, Push 300160

10.255.111.4/32 *[LDP/9] 09:54:10, metric 2, tag 0

> to 11.11.11.2 via ge-0/0/2.0, Push 300000

10.255.112.2/32 *[LDP/9] 09:54:48, metric 1, tag 0

> to 11.11.11.2 via ge-0/0/2.0

iso.0: 2 destinations, 2 routes (2 active, 0 holddown, 0 hidden)

+ = Active Route, - = Last Active, * = Both

47.0005.80ff.f800.0000.0108.0001.1280.9202.0175/152

*[Direct/0] 10:08:01

> via lo0.0

49.0002.0192.0168.0001/72

*[Direct/0] 09:55:05

> via lo0.0

mpls.0: 10 destinations, 10 routes (10 active, 0 holddown, 0 hidden)

+ = Active Route, - = Last Active, * = Both

0 *[MPLS/0] 09:55:05, metric 1

Receive

1 *[MPLS/0] 09:55:05, metric 1

Receive

2 *[MPLS/0] 09:55:05, metric 1

Receive

13 *[MPLS/0] 09:55:05, metric 1

Receive

300064 *[LDP/9] 09:54:48, metric 1

> to 11.11.11.2 via ge-0/0/2.0, Pop

300064(S=0) *[LDP/9] 09:54:48, metric 1

> to 11.11.11.2 via ge-0/0/2.0, Pop

300112 *[LDP/9] 09:54:10, metric 2, tag 0

> to 11.11.11.2 via ge-0/0/2.0, Swap 300000

300192 *[LDP/9] 09:41:03, metric 3

> to 11.11.11.2 via ge-0/0/2.0, Swap 300128

300208 *[LDP/9] 09:41:03, metric 3

> to 11.11.11.2 via ge-0/0/2.0, Swap 300144

300224 *[LDP/9] 09:41:03, metric 3

> to 11.11.11.2 via ge-0/0/2.0, Swap 300160

inet6.0: 2 destinations, 2 routes (2 active, 0 holddown, 0 hidden)

+ = Active Route, - = Last Active, * = Both

abcd::128:92:20:175/128

*[Direct/0] 10:08:01

> via lo0.0

fe80::5668:a50f:fcc1:1f9c/128

*[Direct/0] 10:08:01

> via lo0.0

Significado

El resultado muestra todas las rutas de la tabla de enrutamiento del dispositivo R0.

Verificación de la información general de LDP

Propósito

Mostrar información general de LDP.

Acción

En el dispositivo R0, desde el modo operativo, ejecute el show ldp overview comando para mostrar la descripción general del LDP.

user@R0> show ldp overview

Instance: master

Reference count: 2

Router ID: 10.255.112.1

Message id: 8

Configuration sequence: 6

Deaggregate: disabled

Explicit null: disabled

IPv6 tunneling: disabled

Strict targeted hellos: disabled

Loopback if added: yes

Route preference: 9

Unicast transit LSP chaining: disabled

P2MP transit LSP chaining: disabled

Transit LSP statistics based on route statistics: disabled

LDP route acknowledgement: enabled

LDP mtu discovery: disabled

Longest Match: enabled

Capabilities enabled: none

Egress FEC capabilities enabled: entropy-label-capability

Downstream unsolicited Sessions:

Operational: 1

Retention: liberal

Control: ordered

Auto targeted sessions:

Auto targeted: disabled

Timers:

Keepalive interval: 10, Keepalive timeout: 30

Link hello interval: 5, Link hello hold time: 15

Targeted hello interval: 15, Targeted hello hold time: 45

Label withdraw delay: 60, Make before break timeout: 30

Make before break switchover delay: 3

Link protection timeout: 120

Graceful restart:

Restart: disabled, Helper: enabled, Restart in process: false

Reconnect time: 60000, Max neighbor reconnect time: 120000

Recovery time: 160000, Max neighbor recovery time: 240000

Traffic Engineering:

Bgp igp: disabled

Both ribs: disabled

Mpls forwarding: disabled

IGP:

Tracking igp metric: disabled

Sync session up delay: 10

Session protection:

Session protection: disabled

Session protection timeout: 0

Interface addresses advertising:

11.11.11.1

10.255.112.1

128.92.20.175

Label allocation:

Current number of LDP labels allocated: 5

Total number of LDP labels allocated: 11

Total number of LDP labels freed: 6

Total number of LDP label allocation failure: 0

Current number of labels allocated by all protocols: 5

Significado

El resultado muestra la información general de LDP del dispositivo R0

Comprobar las entradas LDP en la tabla de topología interna

Propósito

Muestra las entradas de ruta en la tabla de topología interna del Protocolo de distribución de etiquetas (LDP).

Acción

En el dispositivo R0, desde el modo operativo, ejecute el show ldp route comando para mostrar la tabla de topología interna de LDP.

user@R0> show ldp route

Destination Next-hop intf/lsp/table Next-hop address

10.4.0.0/16 fxp0.0 10.92.31.254

10.5.0.0/16 fxp0.0 10.92.31.254

10.6.128.0/17 fxp0.0 10.92.31.254

10.9.0.0/16 fxp0.0 10.92.31.254

10.10.0.0/16 fxp0.0 10.92.31.254

10.13.4.0/23 fxp0.0 10.92.31.254

10.13.10.0/23 fxp0.0 10.92.31.254

10.82.0.0/15 fxp0.0 10.92.31.254

10.84.0.0/16 fxp0.0 10.92.31.254

10.85.12.0/22 fxp0.0 10.92.31.254

10.92.0.0/16 fxp0.0 10.92.31.254

10.92.16.0/20 fxp0.0

10.92.20.175/32

10.94.0.0/16 fxp0.0 10.92.31.254

10.99.0.0/16 fxp0.0 10.92.31.254

10.102.0.0/16 fxp0.0 10.92.31.254

10.150.0.0/16 fxp0.0 10.92.31.254

10.155.0.0/16 fxp0.0 10.92.31.254

10.157.64.0/19 fxp0.0 10.92.31.254

10.160.0.0/16 fxp0.0 10.92.31.254

10.204.0.0/16 fxp0.0 10.92.31.254

10.205.0.0/16 fxp0.0 10.92.31.254

10.206.0.0/16 fxp0.0 10.92.31.254

10.207.0.0/16 fxp0.0 10.92.31.254

10.209.0.0/16 fxp0.0 10.92.31.254

10.212.0.0/16 fxp0.0 10.92.31.254

10.213.0.0/16 fxp0.0 10.92.31.254

10.214.0.0/16 fxp0.0 10.92.31.254

10.215.0.0/16 fxp0.0 10.92.31.254

10.216.0.0/16 fxp0.0 10.92.31.254

10.218.13.0/24 fxp0.0 10.92.31.254

10.218.14.0/24 fxp0.0 10.92.31.254

10.218.16.0/20 fxp0.0 10.92.31.254

10.218.32.0/20 fxp0.0 10.92.31.254

10.227.0.0/16 fxp0.0 10.92.31.254

10.255.111.0/24 ge-0/0/2.0 11.11.11.2

10.255.111.4/32 ge-0/0/2.0 11.11.11.2

10.255.112.1/32 lo0.0

10.255.112.2/32 ge-0/0/2.0 11.11.11.2

11.11.11.0/24 ge-0/0/2.0

11.11.11.1/32

12.12.12.0/24 ge-0/0/2.0 11.11.11.2

15.15.15.0/24 ge-0/0/1.0

15.15.15.1/32

22.22.22.0/24 ge-0/0/0.0

22.22.22.1/32

23.23.23.0/24 ge-0/0/2.0 11.11.11.2

24.24.24.0/24 ge-0/0/2.0 11.11.11.2

25.25.25.0/24 ge-0/0/2.0 11.11.11.2

128.92.17.45/32 ge-0/0/2.0 11.11.11.2

128.92.20.175/32 lo0.0

128.92.21.186/32 ge-0/0/2.0 11.11.11.2

128.92.25.135/32 ge-0/0/2.0 11.11.11.2

128.92.27.91/32 ge-0/0/2.0 11.11.11.2

128.92.28.70/32 ge-0/0/2.0 11.11.11.2

172.16.0.0/12 fxp0.0 10.92.31.254

192.168.0.0/16 fxp0.0 10.92.31.254

192.168.102.0/23 fxp0.0 10.92.31.254

207.17.136.0/24 fxp0.0 10.92.31.254

207.17.136.192/32 fxp0.0 10.92.31.254

207.17.137.0/24 fxp0.0 10.92.31.254

224.0.0.5/32

Significado

El resultado muestra las entradas de ruta en la tabla de topología interna del Protocolo de distribución de etiquetas (LDP) del dispositivo R0.

Verifique solo la información FEC de la ruta LDP

Propósito

Mostrar sólo la información FEC de la ruta LDP.

Acción

En el dispositivo R0, desde el modo operativo, ejecute el show ldp route fec-only comando para mostrar las rutas en la tabla de enrutamiento.

user@R0> show ldp route fec-only

Destination Next-hop intf/lsp/table Next-hop address

10.255.111.1/32 ge-0/0/2.0 11.11.11.2

10.255.111.2/32 ge-0/0/2.0 11.11.11.2

10.255.111.3/32 ge-0/0/2.0 11.11.11.2

10.255.111.4/32 ge-0/0/2.0 11.11.11.2

10.255.112.1/32 lo0.0

10.255.112.2/32 ge-0/0/2.0 11.11.11.2

Significado

La salida muestra solo las rutas FEC del protocolo LDP disponibles para el dispositivo R0.

Verificar FEC y rutas ocultas de LDP

Propósito

Muestre el FEC y las rutas ocultas en la tabla de enrutamiento.

Acción

En el dispositivo R0, desde el modo operativo, ejecute el show ldp route fec-and-route comando para mostrar las rutas FEC y shadow en la tabla de enrutamiento.

user@R0> show ldp route fec-and-route

Destination Next-hop intf/lsp/table Next-hop address

10.4.0.0/16 fxp0.0 10.92.31.254

10.5.0.0/16 fxp0.0 10.92.31.254

10.6.128.0/17 fxp0.0 10.92.31.254

10.9.0.0/16 fxp0.0 10.92.31.254

10.10.0.0/16 fxp0.0 10.92.31.254

10.13.4.0/23 fxp0.0 10.92.31.254

10.13.10.0/23 fxp0.0 10.92.31.254

10.82.0.0/15 fxp0.0 10.92.31.254

10.84.0.0/16 fxp0.0 10.92.31.254

10.85.12.0/22 fxp0.0 10.92.31.254

10.92.0.0/16 fxp0.0 10.92.31.254

10.92.16.0/20 fxp0.0

10.92.20.175/32

10.94.0.0/16 fxp0.0 10.92.31.254

10.99.0.0/16 fxp0.0 10.92.31.254

10.102.0.0/16 fxp0.0 10.92.31.254

10.150.0.0/16 fxp0.0 10.92.31.254

10.155.0.0/16 fxp0.0 10.92.31.254

10.157.64.0/19 fxp0.0 10.92.31.254

10.160.0.0/16 fxp0.0 10.92.31.254

10.204.0.0/16 fxp0.0 10.92.31.254

10.205.0.0/16 fxp0.0 10.92.31.254

10.206.0.0/16 fxp0.0 10.92.31.254

10.207.0.0/16 fxp0.0 10.92.31.254

10.209.0.0/16 fxp0.0 10.92.31.254

10.212.0.0/16 fxp0.0 10.92.31.254

10.213.0.0/16 fxp0.0 10.92.31.254

10.214.0.0/16 fxp0.0 10.92.31.254

10.215.0.0/16 fxp0.0 10.92.31.254

10.216.0.0/16 fxp0.0 10.92.31.254

10.218.13.0/24 fxp0.0 10.92.31.254

10.218.14.0/24 fxp0.0 10.92.31.254

10.218.16.0/20 fxp0.0 10.92.31.254

10.218.32.0/20 fxp0.0 10.92.31.254

10.227.0.0/16 fxp0.0 10.92.31.254

10.255.111.0/24 ge-0/0/2.0 11.11.11.2

10.255.111.1/32 ge-0/0/2.0 11.11.11.2

10.255.111.2/32 ge-0/0/2.0 11.11.11.2

10.255.111.3/32 ge-0/0/2.0 11.11.11.2

10.255.111.4/32 ge-0/0/2.0 11.11.11.2

10.255.111.4/32 ge-0/0/2.0 11.11.11.2

10.255.112.1/32 lo0.0

10.255.112.1/32 lo0.0

10.255.112.2/32 ge-0/0/2.0 11.11.11.2

10.255.112.2/32 ge-0/0/2.0 11.11.11.2

11.11.11.0/24 ge-0/0/2.0

11.11.11.1/32

12.12.12.0/24 ge-0/0/2.0 11.11.11.2

15.15.15.0/24 ge-0/0/1.0

15.15.15.1/32

22.22.22.0/24 ge-0/0/0.0

22.22.22.1/32

23.23.23.0/24 ge-0/0/2.0 11.11.11.2

24.24.24.0/24 ge-0/0/2.0 11.11.11.2

25.25.25.0/24 ge-0/0/2.0 11.11.11.2

128.92.17.45/32 ge-0/0/2.0 11.11.11.2

128.92.20.175/32 lo0.0

128.92.21.186/32 ge-0/0/2.0 11.11.11.2

128.92.25.135/32 ge-0/0/2.0 11.11.11.2

128.92.27.91/32 ge-0/0/2.0 11.11.11.2

128.92.28.70/32 ge-0/0/2.0 11.11.11.2

172.16.0.0/12 fxp0.0 10.92.31.254

192.168.0.0/16 fxp0.0 10.92.31.254

192.168.102.0/23 fxp0.0 10.92.31.254

207.17.136.0/24 fxp0.0 10.92.31.254

207.17.136.192/32 fxp0.0 10.92.31.254

207.17.137.0/24 fxp0.0 10.92.31.254

224.0.0.5/32

Significado

El resultado muestra el FEC y las rutas de sombra del dispositivo R0

Configuración de las preferencias de ruta de LDP

Cuando varios protocolos calculan rutas al mismo destino, las preferencias de ruta se utilizan para seleccionar qué ruta está instalada en la tabla de reenvío. Se selecciona la ruta con el valor de preferencia más bajo. El valor de preferencia puede ser un número del 0 al 255. De forma predeterminada, las rutas LDP tienen un valor de preferencia de 9.

Para modificar las preferencias de ruta, incluya la preference instrucción:

preference preference;

Para obtener una lista de los niveles jerárquicos en los que puede incluir esta instrucción, vea la sección de resumen de instrucción de esta instrucción.

Reinicio correcto de LDP

El reinicio correcto de LDP permite que un enrutador cuyo plano de control LDP está experimentando un reinicio continúe reenviando tráfico mientras recupera su estado de los enrutadores vecinos. También habilita un enrutador en el que está habilitado el modo auxiliar para ayudar a un enrutador vecino que está intentando reiniciar LDP.

Durante la inicialización de la sesión, un enrutador anuncia su capacidad para realizar un reinicio correcto de LDP o para aprovechar que un vecino realiza un reinicio correcto de LDP enviando el TLV de reinicio correcto. Este TLV contiene dos campos relevantes para el reinicio elegante de LDP: el tiempo de reconexión y el tiempo de recuperación. Los valores de los tiempos de reconexión y recuperación indican las capacidades de reinicio correcto compatibles con el enrutador.

Cuando un enrutador descubre que un enrutador vecino se está reiniciando, espera hasta el final del tiempo de recuperación antes de intentar volver a conectarse. El tiempo de recuperación es el tiempo que un enrutador espera a que LDP se reinicie correctamente. El período de recuperación comienza cuando se envía o recibe un mensaje de inicialización. Este período de tiempo también suele ser el período de tiempo que un enrutador vecino mantiene su información sobre el enrutador que se reinicia, lo que le permite continuar reenviando el tráfico.

Puede configurar el reinicio correcto de LDP tanto en la instancia maestra para el protocolo LDP como para una instancia de enrutamiento específica. Puede deshabilitar el reinicio correcto en el nivel global para todos los protocolos, a nivel de protocolo solo para LDP y en una instancia de enrutamiento específica. El reinicio dinámico LDP está deshabilitado de forma predeterminada, ya que a nivel global, el reinicio correcto está deshabilitado de forma predeterminada. Sin embargo, el modo auxiliar (la capacidad de ayudar a un enrutador vecino que intenta un reinicio correcto) está habilitado de forma predeterminada.

Los siguientes son algunos de los comportamientos asociados con el reinicio correcto de LDP:

Las etiquetas salientes no se mantienen en los reinicios. Se asignan nuevas etiquetas salientes.

Cuando un enrutador se está reiniciando, no se envían mensajes de mapa de etiqueta a los vecinos que admitan un reinicio correcto hasta que el enrutador de reinicio se haya estabilizado (los mensajes de mapa de etiqueta se envían inmediatamente a los vecinos que no admiten el reinicio correcto). Sin embargo, todos los demás mensajes (keepalive, dirección-mensaje, notificación y liberación) se envían como de costumbre. La distribución de estos otros mensajes evita que el enrutador distribuya información incompleta.

El modo auxiliar y el reinicio agraciado son independientes. Puede deshabilitar el reinicio correcto en la configuración, pero aún así permitir que el enrutador coopere con un vecino que intente reiniciar correctamente.

Configuración de LDP Correcto reinicio

Cuando se modifica la configuración de reinicio correcto en los niveles de [edit routing-options graceful-restart] jerarquía o [edit protocols ldp graceful-restart] , cualquier sesión de LDP en ejecución se reinicia automáticamente para aplicar la configuración de reinicio correcto. Este comportamiento refleja el comportamiento de BGP cuando modifica su configuración de reinicio correcto.

De forma predeterminada, el modo auxiliar de reinicio correcto está habilitado, pero el reinicio correcto está deshabilitado. Por lo tanto, el comportamiento predeterminado de un enrutador es ayudar a los enrutadores vecinos que intentan un reinicio correcto, pero no intentar un reinicio elegante en sí.

Para configurar un reinicio correcto de LDP, consulte las siguientes secciones:

- Habilitación del reinicio correcto

- Deshabilitar el reinicio correcto de LDP o el modo auxiliar

- Configuración del tiempo de reconexión

- Configuración del tiempo de recuperación y del tiempo máximo de recuperación

Habilitación del reinicio correcto

Para habilitar el reinicio correcto de LDP, también debe habilitar el reinicio correcto en el enrutador. Para habilitar el reinicio correcto, incluya la graceful-restart instrucción:

graceful-restart;

Puede incluir esta instrucción en los siguientes niveles jerárquicos:

[edit routing-options][edit logical-systems logical-system-name routing-options]

Los enrutadores de la serie ACX no admiten el nivel de jerarquía [edit logical-systems logical-system-name routing-options].

La graceful-restart instrucción permite un reinicio correcto para todos los protocolos que admiten esta función en el enrutador. Para obtener más información acerca del reinicio correcto, consulte la Biblioteca de protocolos de enrutamiento de Junos OS para dispositivos de enrutamiento.

De forma predeterminada, el reinicio correcto de LDP se habilita cuando se habilita el reinicio correcto tanto en el nivel de protocolo LDP como en todas las instancias de enrutamiento. Sin embargo, puede deshabilitar tanto el reinicio correcto de LDP como el modo auxiliar de reinicio correcto de LDP.

Deshabilitar el reinicio correcto de LDP o el modo auxiliar

Para deshabilitar el reinicio y la recuperación correctos de LDP, incluya la disable instrucción:

ldp {

graceful-restart {

disable;

}

}

Para obtener una lista de los niveles jerárquicos en los que puede incluir esta instrucción, vea la sección de resumen de instrucción de esta instrucción.

Puede deshabilitar el modo auxiliar sólo en el nivel de protocolos LDP. No puede deshabilitar el modo auxiliar para una instancia de enrutamiento específica. Para deshabilitar el modo auxiliar de LDP, incluya la helper-disable instrucción:

ldp {

graceful-restart {

helper-disable;

}

}

Para obtener una lista de los niveles jerárquicos en los que puede incluir esta instrucción, vea la sección de resumen de instrucción de esta instrucción.

Son posibles las siguientes configuraciones de reinicio correcto de LDP:

El reinicio elegante de LDP y el modo auxiliar están habilitados.

El reinicio correcto de LDP está deshabilitado, pero el modo auxiliar está habilitado. Un enrutador configurado de esta manera no puede reiniciarse correctamente, pero puede ayudar a un vecino que se reinicia.

El reinicio correcto de LDP y el modo auxiliar están deshabilitados. El enrutador no utiliza el reinicio correcto LDP ni el tipo, longitud y valor de reinicio correcto (TLV) enviados en el mensaje de inicialización. El enrutador se comporta como un enrutador que no admite el reinicio correcto de LDP.

Se emite un error de configuración si intenta habilitar el reinicio correcto y deshabilitar el modo auxiliar.

Configuración del tiempo de reconexión

Después de que la conexión LDP entre vecinos falla, los vecinos esperan una cierta cantidad de tiempo para que el enrutador que se reinicia correctamente reanude el envío de mensajes LDP. Después del período de espera, se puede restablecer la sesión de LDP. Puede configurar el período de espera en segundos. Este valor se incluye en el TLV de sesión tolerante a errores que se envía en los mensajes de inicialización de LDP cuando está habilitado el reinicio correcto de LDP.

Supongamos que el enrutador A y el enrutador B son vecinos de LDP. El enrutador A es el enrutador que se reinicia. El tiempo de reconexión es el tiempo que el enrutador A le indica al enrutador B que espere después de que el enrutador B detecte que el enrutador A se reinició.

Para configurar el tiempo de reconexión, incluya la reconnect-time instrucción:

graceful-restart { reconnect-time seconds; }

Puede establecer el tiempo de reconexión en un valor en el intervalo de 30 a 300 segundos. De forma predeterminada, son 60 segundos.

Para obtener una lista de los niveles de jerarquía en los que puede configurar estas instrucciones, consulte las secciones de resumen de instrucciones para estas instrucciones.

Configuración del tiempo de recuperación y del tiempo máximo de recuperación

El tiempo de recuperación es la cantidad de tiempo que un enrutador espera a que LDP se reinicie correctamente. El período de recuperación comienza cuando se envía o recibe un mensaje de inicialización. Este período también suele ser la cantidad de tiempo que un enrutador vecino mantiene su información sobre el enrutador que se reinicia, lo que le permite continuar reenviando el tráfico.

Para evitar que un enrutador vecino se vea afectado negativamente si recibe un valor falso para el tiempo de recuperación del enrutador que se reinicia, puede configurar el tiempo máximo de recuperación en el enrutador vecino. Un enrutador vecino mantiene su estado durante el más corto de los dos tiempos. Por ejemplo, el enrutador A está realizando un reinicio correcto de LDP. Ha enviado un tiempo de recuperación de 900 segundos al enrutador B vecino. Sin embargo, el enrutador B tiene su tiempo máximo de recuperación configurado en 400 segundos. El enrutador B solo esperará 400 segundos antes de purgar su información LDP del enrutador A.

Para configurar el tiempo de recuperación, incluya la recovery-time instrucción y la maximum-neighbor-recovery-time instrucción:

graceful-restart { maximum-neighbor-recovery-time seconds; recovery-time seconds; }

Para obtener una lista de los niveles de jerarquía en los que puede configurar estas instrucciones, consulte las secciones de resumen de instrucciones para estas instrucciones.

Filtrado de enlaces de etiquetas LDP entrantes

Puede filtrar los enlaces de etiquetas LDP recibidos y aplicar políticas para aceptar o denegar enlaces anunciados por enrutadores vecinos. Para configurar el filtrado de etiquetas recibidas, incluya la import instrucción:

import [ policy-names ];

Para obtener una lista de los niveles jerárquicos en los que puede incluir esta instrucción, vea la sección de resumen de instrucción de esta instrucción.

La directiva con nombre (configurada en el [edit policy-options] nivel de jerarquía) se aplica a todos los enlaces de etiquetas recibidos de todos los vecinos de LDP. Todo el filtrado se realiza con from instrucciones. Tabla 1 enumera los únicos from operadores que se aplican al filtrado de etiquetas recibidas LDP.

from Operador |

Description |

|---|---|

|

Coincidencias en enlaces recibidos de un vecino adyacente a través de la interfaz especificada |

|

Coincidencias en enlaces recibidos del ID de enrutador LDP especificado |

|

Coincidencias en enlaces recibidos de un vecino que anuncia la dirección de interfaz especificada |

|

Coincidencias en enlaces con el prefijo especificado |

Si se filtra un enlace, sigue apareciendo en la base de datos LDP, pero no se considera para su instalación como parte de una ruta de conmutación de etiquetas (LSP).

En general, la aplicación de políticas en LDP solo se puede usar para bloquear el establecimiento de LSP, no para controlar su enrutamiento. Esto se debe a que la ruta que sigue un LSP viene determinada por el enrutamiento de unidifusión y no por LDP. Sin embargo, cuando hay varias rutas de igual costo al destino a través de diferentes vecinos, puede usar el filtrado LDP para excluir algunos de los posibles saltos siguientes de la consideración. (De lo contrario, LDP elige uno de los posibles saltos siguientes al azar).

Las sesiones LDP no están enlazadas a interfaces ni direcciones de interfaz. LDP anuncia solo etiquetas por enrutador (no por interfaz); por lo tanto, si existen varios vínculos paralelos entre dos enrutadores, solo se establece una sesión LDP y no está vinculada a una sola interfaz. Cuando un enrutador tiene varias adyacencias al mismo vecino, tenga cuidado de asegurarse de que el filtro haga lo esperado. (Generalmente, usar next-hop y interface no es apropiado en este caso).

Si una etiqueta se ha filtrado (lo que significa que ha sido rechazada por la política y no se utiliza para construir un LSP), se marca como filtrada en la base de datos:

user@host> show ldp database Input label database, 10.10.255.1:0-10.10.255.6:0 Label Prefix 3 10.10.255.6/32 (Filtered) Output label database, 10.10.255.1:0-10.10.255.6:0 Label Prefix 3 10.10.255.1/32 (Filtered)

Para obtener más información acerca de cómo configurar directivas para LDP, consulte la Guía del usuario de directivas de enrutamiento, filtros de firewall y políticas de tráfico.

Ejemplos: Filtrado de enlaces de etiquetas LDP entrantes

Solo acepta prefijos /32 de todos los vecinos:

[edit]

protocols {

ldp {

import only-32;

...

}

}

policy-options {

policy-statement only-32 {

term first {

from {

route-filter 0.0.0.0/0 upto /31;

}

then reject;

}

then accept;

}

}

Acepte 131.108/16 o más tiempo desde el ID 10.10.255.2 del enrutador y acepte todos los prefijos de todos los demás vecinos:

[edit]

protocols {

ldp {

import nosy-neighbor;

...

}

}

policy-options {

policy-statement nosy-neighbor {

term first {

from {

neighbor 10.10.255.2;

route-filter 131.108.0.0/16 orlonger accept;

route-filter 0.0.0.0/0 orlonger reject;

}

}

then accept;

}

}

Filtrado de encuadernaciones de etiquetas LDP salientes

Puede configurar políticas de exportación para filtrar las etiquetas salientes de LDP. Puede filtrar los enlaces de etiquetas salientes aplicando políticas de enrutamiento para impedir que los enlaces se anuncien en enrutadores vecinos. Para configurar el filtrado de etiquetas salientes, incluya la export instrucción:

export [policy-name];

Para obtener una lista de los niveles jerárquicos en los que puede incluir esta instrucción, vea la sección de resumen de instrucción de esta instrucción.

La política de exportación con nombre (configurada en el nivel de [edit policy-options] jerarquía) se aplica a todos los enlaces de etiquetas transmitidos a todos los vecinos de LDP. El único from operador que se aplica al filtrado de etiquetas de salida LDP es route-filter, que hace coincidir los enlaces con el prefijo especificado. Los únicos to operadores que se aplican al filtrado de etiquetas salientes son los operadores de Tabla 2.

al operador |

Description |

|---|---|

|

Coincidencias en enlaces enviados a un vecino adyacente a través de la interfaz especificada |

|

Coincidencias en enlaces enviados al ID de enrutador LDP especificado |

|

Coincidencias en enlaces enviados a un vecino que anuncia la dirección de interfaz especificada |

Si se filtra un enlace, el enlace no se anuncia al enrutador vecino, pero se puede instalar como parte de un LSP en el enrutador local. Puede aplicar directivas en LDP para bloquear el establecimiento de LSP, pero no para controlar su enrutamiento. La ruta que sigue un LSP viene determinada por el enrutamiento de unidifusión, no por LDP.

Las sesiones LDP no están enlazadas a interfaces ni direcciones de interfaz. LDP anuncia solo etiquetas por enrutador (no por interfaz). Si existen varios vínculos paralelos entre dos enrutadores, solo se establece una sesión LDP y no está enlazada a una sola interfaz.

No utilice los next-hop operadores y interface cuando un enrutador tenga varias adyacencias al mismo vecino.

Las etiquetas filtradas están marcadas en la base de datos:

user@host> show ldp database Input label database, 10.10.255.1:0-10.10.255.3:0 Label Prefix 100007 10.10.255.2/32 3 10.10.255.3/32 Output label database, 10.10.255.1:0-10.10.255.3:0 Label Prefix 3 10.10.255.1/32 100001 10.10.255.6/32 (Filtered)

Para obtener más información acerca de cómo configurar directivas para LDP, consulte la Guía del usuario de directivas de enrutamiento, filtros de firewall y políticas de tráfico.

Ejemplos: Filtrado de encuadernaciones de etiquetas LDP salientes

Bloquear la transmisión de la ruta para 10.10.255.6/32 cualquier vecino:

[edit protocols]

ldp {

export block-one;

}

policy-options {

policy-statement block-one {

term first {

from {

route-filter 10.10.255.6/32 exact;

}

then reject;

}

then accept;

}

}

Envíe solo 131.108/16 o más tiempo al ID 10.10.255.2del enrutador y envíe todos los prefijos a todos los demás enrutadores:

[edit protocols]

ldp {

export limit-lsps;

}

policy-options {

policy-statement limit-lsps {

term allow-one {

from {

route-filter 131.108.0.0/16 orlonger;

}

to {

neighbor 10.10.255.2;

}

then accept;

}

term block-the-rest {

to {

neighbor 10.10.255.2;

}

then reject;

}

then accept;

}

}

Especificación de la dirección de transporte utilizada por LDP

Los enrutadores primero deben establecer una sesión TCP entre ellos antes de poder establecer una sesión LDP. La sesión TCP permite a los enrutadores intercambiar los anuncios de etiqueta necesarios para la sesión LDP. Para establecer la sesión TCP, cada enrutador debe aprender la dirección de transporte del otro enrutador. La dirección de transporte es una dirección IP que se utiliza para identificar la sesión TCP sobre la que se ejecutará la sesión LDP.

Para configurar la dirección de transporte LDP, incluya la instrucción transport-address:

transport-address (router-id | interface);

Para obtener una lista de los niveles jerárquicos en los que puede incluir esta instrucción, vea la sección de resumen de instrucción de esta instrucción.

Si especifica la router-id opción, la dirección del identificador de enrutador se utiliza como dirección de transporte (a menos que se configure lo contrario, el identificador de enrutador suele ser el mismo que la dirección de circuito cerrado). Si especifica la interface opción, la dirección de interfaz se utiliza como dirección de transporte para cualquier sesión de LDP a vecinos a la que se pueda acceder a través de esa interfaz. Tenga en cuenta que el identificador del enrutador se utiliza como dirección de transporte de forma predeterminada.

Para un funcionamiento correcto, la dirección de transporte de LDP debe ser accesible. El ID del enrutador es un identificador, no una dirección IP enrutable. Por esta razón, se recomienda que el ID del enrutador se establezca para que coincida con la dirección de circuito cerrado y que el IGP anuncie la dirección de circuito cerrado.

No puede especificar la interface opción cuando hay varios vínculos paralelos al mismo vecino de LDP, porque la especificación LDP requiere que se anuncie la misma dirección de transporte en todas las interfaces al mismo vecino. Si LDP detecta varios vínculos paralelos al mismo vecino, deshabilita las interfaces con ese vecino una por una hasta que se borre la condición, ya sea desconectando el vecino en una interfaz o especificando la router-id opción.

Dirección de transporte de control utilizada para la sesión LDP dirigida

Para establecer una sesión TCP entre dos dispositivos, cada dispositivo debe aprender la dirección de transporte del otro dispositivo. La dirección de transporte es una dirección IP utilizada para identificar la sesión TCP sobre la que opera la sesión LDP. Anteriormente, esta dirección de transporte solo podía ser el ID del enrutador o una dirección de interfaz. Con la función de dirección de transporte LDP, puede configurar explícitamente cualquier dirección IP como dirección de transporte para vecinos LDP de destino para circuitos de capa 2, adyacencias MPLS y VPLS. Esto le permite controlar las sesiones de LDP de destino mediante la configuración de direcciones de transporte.

- Ventajas de controlar la dirección de transporte usada para la sesión LDP dirigida

- Descripción general de la dirección de transporte de LDP de destino

- Preferencia de dirección de transporte

- Solución de problemas de configuración de direcciones de transporte

Ventajas de controlar la dirección de transporte usada para la sesión LDP dirigida

La configuración de la dirección de transporte para establecer sesiones LDP de destino tiene las siguientes ventajas:

Flexible interface configurations: proporciona la flexibilidad de configurar varias direcciones IP para una interfaz de circuito cerrado sin interrumpir la creación de la sesión LDP entre los vecinos del LDP de destino.

Ease of operation—Dirección de transporte configurada a nivel de interfaz, permite utilizar más de un protocolo en la red troncal de IGP para LDP. Esto permite operaciones fluidas y fáciles.

Descripción general de la dirección de transporte de LDP de destino

Antes de Junos OS versión 19.1R1, LDP solo ofrecía compatibilidad con el ID de enrutador o la dirección de interfaz como dirección de transporte en cualquier interfaz LDP. Las adyacencias formadas en esa interfaz utilizaron una de las direcciones IP asignadas a la interfaz o al ID del enrutador. En caso de adyacencia dirigida, la interfaz es la interfaz de circuito cerrado. Cuando se configuraron varias direcciones de circuito cerrado en el dispositivo, no se pudo derivar la dirección de transporte para la interfaz y, como resultado, no se pudo establecer la sesión LDP.

A partir de Junos OS versión 19.1R1, además de las direcciones IP predeterminadas utilizadas para la dirección de transporte de las sesiones LDP de destino, puede configurar cualquier otra dirección IP como dirección de transporte en las sessionsession-groupinstrucciones , y interface configuration. La configuración de la dirección de transporte solo se aplica a los vecinos configurados, incluidos los circuitos de capa 2, las adyacencias MPLS y VPLS. Esta configuración no se aplica a las adyacencias descubiertas (dirigidas o no).

Preferencia de dirección de transporte

Puede configurar la dirección de transporte para sesiones LDP de destino en el nivel de sesión, grupo de sesión e interfaz.

Una vez configurada la dirección de transporte, se establece la sesión de LDP de destino en función de la preferencia de dirección de transporte de LDP.

El orden de preferencia de la dirección de transporte para el vecino de destino (configurado a través del circuito de capa 2, la configuración MPLS, VPLS y LDP) es el siguiente:

Bajo

[edit protocols ldp session]jerarquía.Bajo

[edit protocols ldp session-group]jerarquía.Bajo

[edit protocols ldp interfcae lo0]jerarquía.Bajo

[edit protocols ldp]jerarquía.Dirección predeterminada.

El orden de preferencia de la dirección de transporte para los vecinos descubiertos es el siguiente:

Bajo

[edit protocols ldp interfcae]jerarquía.Bajo

[edit protocols ldp]jerarquía.Dirección predeterminada.

El orden de preferencia de la dirección de transporte para los vecinos de destino automático en los que LDP está configurado para aceptar paquetes de saludo es el siguiente:

Bajo

[edit protocols ldp interfcae lo0]jerarquía.Bajo

[edit protocols ldp]jerarquía.Dirección predeterminada.

Solución de problemas de configuración de direcciones de transporte

Puede utilizar los siguientes resultados del comando show para solucionar problemas de sesiones de LDP dirigidas:

show ldp sessionshow ldp neighborEl

detailnivel de salida delshow ldp neighborcomando muestra la dirección de transporte enviada en los mensajes de saludo al vecino de destino. Si esta dirección no es accesible desde el vecino, la sesión de LDP no aparece.show configuration protocols ldp

También puede habilitar las traceoptions de LDP para solucionar problemas adicionales.

Si la configuración se cambia de usar una dirección de transporte que no es válida (no accesible) a una dirección de transporte que es válida, se pueden observar los siguientes seguimientos:

May 29 10:47:11.569722 Incoming connect from 10.55.1.4 May 29 10:47:11.570064 Connection 10.55.1.4 state Closed -> Open May 29 10:47:11.570727 Session 10.55.1.4 state Nonexistent -> Initialized May 29 10:47:11.570768 Session 10.55.1.4 state Initialized -> OpenRec May 29 10:47:11.570799 LDP: Session param Max PDU length 4096 from 10.55.1.4, negotiated 4096 May 29 10:47:11.570823 Session 10.55.1.4 GR state Nonexistent -> Operational May 29 10:47:11.669295 Session 10.55.1.4 state OpenRec -> Operational May 29 10:47:11.669387 RPD_LDP_SESSIONUP: LDP session 10.55.1.4 is up

Si la configuración se cambia de utilizar una dirección de transporte válida a una dirección de transporte no válida (no accesible), se pueden observar los siguientes seguimientos:

May 29 10:42:36.317942 Session 10.55.1.4 GR state Operational -> Nonexistent May 29 10:42:36.318171 Session 10.55.1.4 state Operational -> Closing May 29 10:42:36.318208 LDP session 10.55.1.4 is down, reason: received notification from peer May 29 10:42:36.318236 RPD_LDP_SESSIONDOWN: LDP session 10.55.1.4 is down, reason: received notification from peer May 29 10:42:36.320081 Connection 10.55.1.4 state Open -> Closed May 29 10:42:36.322411 Session 10.55.1.4 state Closing -> Nonexistent

En caso de configuración defectuosa, realice las siguientes tareas de solución de problemas:

Compruebe el

address familyarchivo . La dirección de transporte que se configura en lasessioninstrucción debe pertenecer a la misma familia de direcciones que el vecino o la sesión.La dirección que se configura como dirección de transporte en una instrucción o

neighborsessiondebe ser local en el enrutador para que se inicien los mensajes de saludo de destino. Puede comprobar si la dirección está configurada. Si la dirección no está configurada en ninguna interfaz, se rechaza la configuración.

Configuración de los prefijos anunciados en LDP desde la tabla de enrutamiento

Puede controlar el conjunto de prefijos que se anuncian en LDP y hacer que el enrutador sea el enrutador de salida para esos prefijos. De forma predeterminada, solo la dirección de circuito cerrado se anuncia en LDP. Para configurar el conjunto de prefijos de la tabla de enrutamiento que se anunciará en LDP, incluya la egress-policy instrucción:

egress-policy policy-name;

Para obtener una lista de los niveles jerárquicos en los que puede incluir esta instrucción, vea la sección de resumen de instrucción de esta instrucción.

Si configura una directiva de salida para LDP que no incluye la dirección de circuito cerrado, ya no se anuncia en LDP. Para seguir anunciando la dirección de circuito cerrado, debe configurarla explícitamente como parte de la directiva de salida de LDP.

La directiva con nombre (configurada en el nivel de [edit policy-options] jerarquía o [edit logical-systems logical-system-name policy-options] ) se aplica a todas las rutas de la tabla de enrutamiento. Las rutas que coinciden con la política se anuncian en LDP. Puede controlar el conjunto de vecinos a los que se anuncian esos prefijos mediante la export instrucción. Solo from se consideran los operadores; puede usar cualquier operador válido from . Para obtener más información, consulte la Biblioteca de protocolos de enrutamiento de Junos OS para dispositivos de enrutamiento.

Los enrutadores de la serie ACX no admiten el nivel de jerarquía [edit logical-systems].

Ejemplo: Configuración de los prefijos anunciados en LDP

Anuncie todas las rutas conectadas en LDP:

[edit protocols]

ldp {

egress-policy connected-only;

}

policy-options {

policy-statement connected-only {

from {

protocol direct;

}

then accept;

}

}

Configuración de la desagregación de FEC

Cuando un enrutador de salida LDP anuncia varios prefijos, los prefijos se enlazan a una sola etiqueta y se agregan en una sola clase de equivalencia de reenvío (FEC). De forma predeterminada, LDP mantiene esta agregación a medida que el anuncio atraviesa la red.

Normalmente, dado que un LSP no se divide en varios saltos siguientes y los prefijos están enlazados a un único LSP, no se produce un equilibrio de carga entre rutas de igual costo. Sin embargo, puede equilibrar la carga en rutas de acceso de igual costo si configura una directiva de equilibrio de carga y desagrega los FEC.

La desagregación de los FEC hace que cada prefijo se vincule a una etiqueta separada y se convierta en un LSP independiente.

Para configurar FEC desagregadas, incluya la deaggregate instrucción:

deaggregate;

Para obtener una lista de los niveles jerárquicos en los que puede incluir esta instrucción, vea la sección de resumen de instrucción de esta instrucción.

Para todas las sesiones de LDP, solo puede configurar FEC desagregados globalmente.

La desagregación de un FEC permite que los múltiples LSP resultantes se distribuyan a través de múltiples rutas de igual costo y distribuye los LSP a través de los múltiples saltos siguientes en los segmentos de salida, pero instala solo un siguiente salto por LSP.

Para agregar FEC, incluya la no-deaggregate instrucción:

no-deaggregate;

Para obtener una lista de los niveles jerárquicos en los que puede incluir esta instrucción, vea la sección de resumen de instrucción de esta instrucción.

Para todas las sesiones de LDP, solo puede configurar FEC agregados globalmente.

Configuración de políticas para FEC de LDP

Puede configurar Junos OS para rastrear y vigilar el tráfico de los FEC de LDP. Los policías de LDP FEC se pueden usar para realizar cualquiera de las siguientes acciones:

Rastrear o vigilar el tráfico de entrada para un LDP FEC.

Rastrear o vigilar el tráfico de tránsito para un FEC LDP.

Rastrear o vigilar el tráfico FEC de LDP que se origina en una clase de reenvío específica.

Rastree o vigile el tráfico FEC de LDP que se origina en un sitio de enrutamiento y reenvío virtual (VRF) específico.

Descarte el tráfico falso enlazado a una FEC de LDP específica.

Para controlar el tráfico de un FEC de LDP, primero debe configurar un filtro. En concreto, debe configurar la interface instrucción o la interface-set instrucción en el nivel jerárquico [edit firewall family protocol-family filter filter-name term term-name from] . La interface instrucción le permite hacer coincidir el filtro con una sola interfaz. La interface-set instrucción le permite hacer coincidir el filtro con varias interfaces.

Para obtener más información acerca de cómo configurar la instrucción, la instrucción y los interface aplicadores de políticas para FEC de LDP, consulte la Guía del usuario de directivas de enrutamiento, filtros de firewall y políticas de tráfico.interface-set

Una vez que haya configurado los filtros, debe incluirlos en la configuración de instrucciones policing para LDP. Para configurar políticas para FEC de LDP, incluya la policing instrucción:

policing { fec fec-address { ingress-traffic filter-name; transit-traffic filter-name; } }

Para obtener una lista de los niveles jerárquicos en los que puede incluir esta instrucción, vea la sección de resumen de instrucción de esta instrucción.

La policing instrucción incluye las siguientes opciones:

fec—Especifique la dirección FEC para el FEC LDP que desea vigilar.ingress-filter: especifique el nombre del filtro de tráfico de entrada.transit-traffic: especifique el nombre del filtro de tráfico de tránsito.

Configuración del filtrado FEC IPv4 de LDP

De forma predeterminada, cuando se establece una sesión LDP de destino, Junos OS siempre intercambia las clases de equivalencia de reenvío IPv4 (FEC) y las FEC del circuito de capa 2 por la sesión LDP de destino. Para una sesión LDP a un vecino conectado indirectamente, es posible que solo desee exportar FEC de circuito de capa 2 al vecino si la sesión se configuró específicamente para admitir circuitos de capa 2 o VPLS.

En una red de proveedores mixta donde todos los prefijos que no son BGP se anuncian en LDP, la base de datos LDP puede llegar a ser grande. Para este tipo de entorno, puede ser útil evitar la publicidad de FEC IPv4 a través de sesiones LDP formadas debido a la configuración del circuito de capa 2 o LDP VPLS. Del mismo modo, puede ser útil filtrar cualquier FEC IPv4 recibido en este tipo de entorno.

Si todos los vecinos de LDP asociados con una sesión de LDP son solo de capa 2, puede configurar Junos OS para que anuncie solo FEC de circuito de capa 2 configurando la l2-smart-policy instrucción. Esta función también filtra automáticamente los FEC IPv4 recibidos en esta sesión. La configuración de una directiva explícita de exportación o importación que se activa para l2-smart-policy deshabilita esta función en la dirección correspondiente.

Si uno de los vecinos de la sesión LDP se forma debido a una adyacencia descubierta o si la adyacencia se forma debido a una configuración de túnel LDP en uno o más LSP RSVP, los FEC IPv4 se anuncian y reciben utilizando el comportamiento predeterminado.

Para evitar que LDP exporte FEC IPv4 a través de sesiones LDP solo con vecinos de capa 2 y para filtrar los FEC IPv4 recibidos en dichas sesiones, incluya la l2-smart-policy instrucción:

l2-smart-policy;

Para obtener una lista de los niveles de jerarquía en los que puede configurar esta instrucción, vea el resumen de instrucción de esta instrucción.

Configuración de BFD para LSP de LDP

Puede configurar la detección de reenvío bidireccional (BFD) para los LSP de LDP. El protocolo BFD es un mecanismo de saludo simple que detecta fallas en una red. Los paquetes Hello se envían en un intervalo regular especificado. Una falla de vecino se detecta cuando el enrutador deja de recibir una respuesta después de un intervalo especificado. BFD trabaja con una amplia variedad de entornos y topologías de red. Los temporizadores de detección de fallas para BFD tienen límites de tiempo más cortos que los mecanismos de detección de fallas de rutas estáticas, lo que proporciona una detección más rápida.

Se registra un error cada vez que falla una sesión BFD para una ruta. A continuación se muestra cómo pueden aparecer los mensajes de registro de BFD para LDP LSP:

RPD_LDP_BFD_UP: LDP BFD session for FEC 10.255.16.14/32 is up RPD_LDP_BFD_DOWN: LDP BFD session for FEC 10.255.16.14/32 is down

También puede configurar BFD para RSVP LSP, como se describe en Configuración de BFD para RSVP señalados por RSVP.

Los temporizadores de detección de fallos BFD son adaptativos y se pueden ajustar para ser más o menos agresivos. Por ejemplo, los temporizadores pueden adaptarse a un valor más alto si falla la adyacencia, o un vecino puede negociar un valor más alto para un temporizador que el valor configurado. Los temporizadores se adaptan a un valor más alto cuando un colgajo de sesión BFD ocurre más de tres veces en un lapso de 15 segundos. Un algoritmo de retroceso aumenta el intervalo de recepción (Rx) en dos si la instancia local de BFD es el motivo de la solapa de sesión. El intervalo de transmisión (Tx) aumenta en dos si la instancia remota de BFD es el motivo de la solapa de sesión. Puede utilizar el comando para devolver los clear bfd adaptation temporizadores de intervalo BFD a sus valores configurados. El clear bfd adaptation comando no tiene hits, lo que significa que el comando no afecta al flujo de tráfico en el dispositivo de enrutamiento.

Para habilitar BFD para LSP de LDP, incluya las oam instrucciones y bfd-liveness-detection :