ネストされた仮想マシンvMXのインストール

ネストされた仮想マシンは、別のVM内に含まれる仮想マシンです。このトピックを読んで、KVM 上でネストされた仮想マシンvMXする方法を理解してください。

ネスト型VMモデルの概要

ネストされた仮想vMX VM(仮想マシン)モデルには、仮想転送プレーン(VFP)VM 内で VM として稼働する仮想 コントロール プレーン(VCP)があります。VFP VM は仮想 Trio 転送プレーン ソフトウェアを実行し、VCP VM は仮想Junos OS。VCP VM と VFP VM は、相互に通信するためにレイヤー 2 接続が必要です。サーバー間のインスタンスごとにサーバーにローカルである内部ブリッジvMX、この通信が可能になります。VCP VM と VFP VM は、サーバーのイーサネット管理ポートと通信するためにレイヤー 2 接続も必要です。仮想イーサネット インスタンスに外部ブリッジを設定するには、VFPとVCPの両方に固有のIPアドレスとMACアドレスを持つ仮想イーサネット インターフェイスvMX必要があります。すべてのインスタンスのイーサネット管理vMXイーサネット管理ポートを通じてサーバーに入り込む。

VMのネストvMX、転送ポート用の virtio および SR-IOV インターフェイスをサポートします。最初のインターフェイスは管理用に使用され、br-extブリッジ(外部ブリッジ)に接続された virtio インターフェイスである必要があります。その後のインターフェイスは WAN インターフェイスであり、virtio または SR-IOV インターフェイスとして使用できます。すべての virtio インターフェイス用のブリッジを作成する必要があります。転送には 1 つ以上の WAN インターフェイスが必要です。

Virtioインターフェイスを使用したネスト型VM

virtioモードでは、サーバー インターフェイスをVFで設定する必要があります。コマンドを使用してインターフェイス( )を削除またはリセットできます。コマンドを使用して、デフォルト インターフェイスを持つIXGBEドライバーをサーバー インターフェイス eth1 rmmod ixgbe に追加 modprobe ixgbe できます。

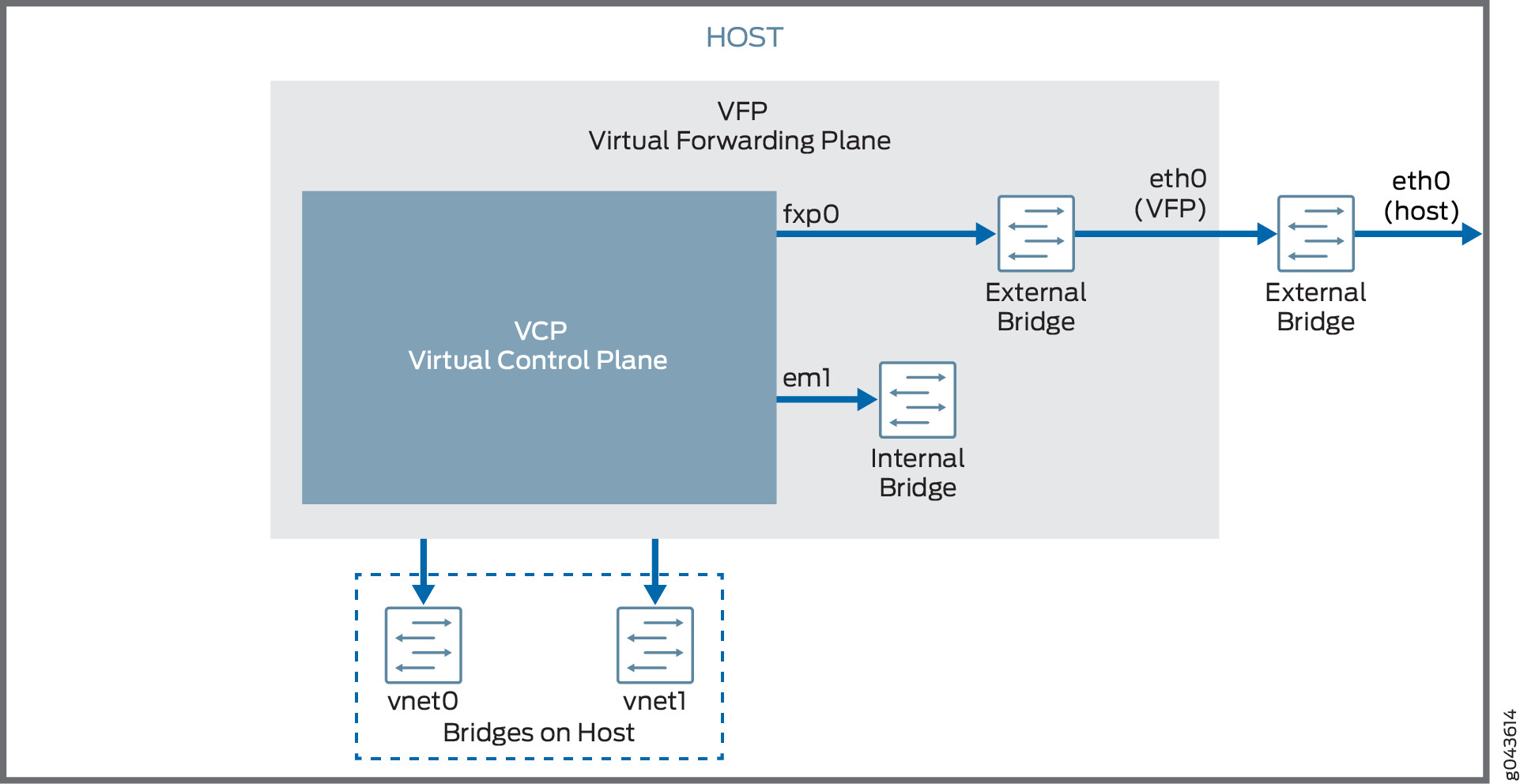

図1は、virtio インターフェイスをvMXされたVMモデルのネスト型モデルを示しています。

SR-IOV インターフェイスを使用したネスト型 VM

SR-IOVモードでは、インターフェイスのvMXがサーバー インターフェイスに関連付けられる。たとえば、 に関連 ge-0/0/0 付けられているインターフェイス eth1 は eth1 、 . で定義 .conf file- interface: ge-0/0/0 ,nic: eth1 されています。

VFは、VFに関連付けられているサーバー インターフェイスのIXGBEドライバーに eth1 追加され、SR-IOVモードで実行中に コマンドを使用して ip link show eth1 チェックできます。

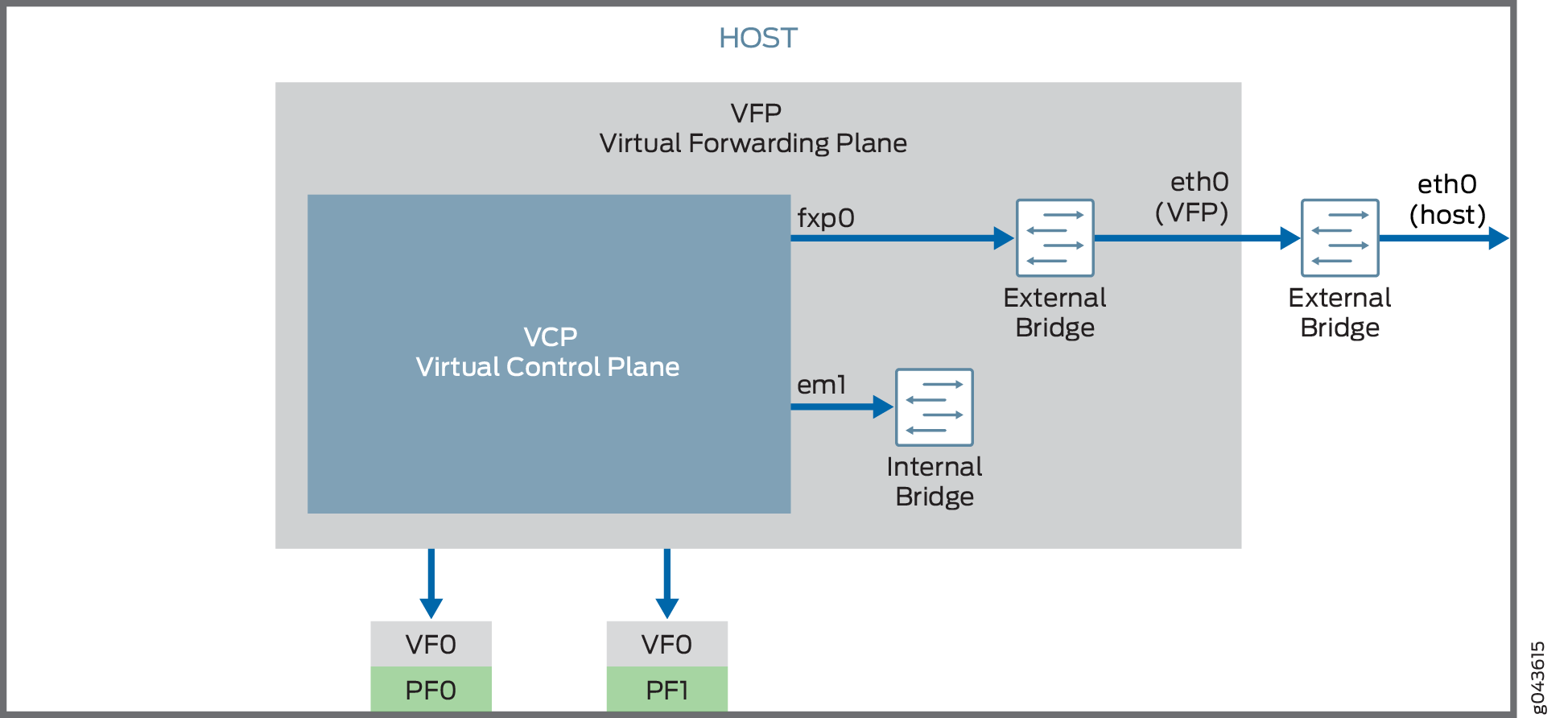

図 2 は 、SR-IOV インターフェイスをvMXされた VM モデルのネスト型仮想マシンを示しています。

ネスト型 VM

ネスト型 VM

SR-IOV インターフェイスでは、ネストされた VM を起動する前に、修正された IXGBE ドライバーをvMX必要があります。

ネットワーク トラフィックが物理サーバーから仮想ネットワークNICされる方法はNIC設定した仮想化技術によって異なります。

ネスト VM モデルのシステム要件

vMXに応じて、2 つのモードで実行するように設定できます。

Lite モード — 低帯域幅で実行する CPU とメモリのリソースを少なくします。

パフォーマンス モード — 広い帯域幅で実行するには、CPU とメモリの観点からより高いリソースが必要です。

注:パフォーマンス モードはデフォルト モードです。

vMX VMモデルによる制約の克服

vMXされた VM モデルでは、以下の機能はサポートされていません。

インターフェイスインスタンスの実行中に、インターフェイスvMX接続または取り外し

ソフトウェア リリースJunos OSアップグレード

ネストされた仮想マシンのハードウェアvMX要件

表 1 は 、ハードウェア要件を示しています。

説明 |

値 |

|---|---|

システム構成の例 |

virtio: 任意の x86 プロセッサー(Intel または VT-d 機能を搭載した場合) SR-IOV 用: Intel 82599 ベースの PCI-Express カード(10 Gbps)および Ivy Bridge プロセッサー。 |

コア数

注:

パフォーマンス モードはデフォルト モードで、最小値は 1 つのポートに基づいて行います。 |

|

メモリ |

|

表 2 は、 ソフトウェア要件を示しています。

説明 |

値 |

|---|---|

オペレーティング システム |

Ubuntu 14.04.1 LTS Linux 3.19.0-80-generic |

仮想 |

QEMU-KVM 2.0.0+qg-2ubuntu1.11 |

必須パッケージ

注:

他のすべての依存関係を満たすために追加のパッケージが必要になる場合があります。 |

bridge-utils qemu-kvm libvirt-bin virtinst

注:

libvirt 1.2.19 |

KVM上でネストされたvMX VMのインストールと起動

KVM 上でネストされた vm vMXを起動するには、これらのタスクを実行します。

- ネストされた仮想マシンをインストールするためのUbuntuホストvMX準備

- 修正された IXGBE ドライバーを読み込む

- ネスト 型インスタンスvMX起動

- VFP コンソール ポートへの接続

- VCP への接続

ネストされた仮想マシンをインストールするためのUbuntuホストvMX準備

仮想マシンをインストールするためにUbuntuホスト システムを準備するには、次vMX。

修正された IXGBE ドライバーを読み込む

SR-IOV インターフェイスを使用している場合、ネストされた VM を起動する前に、修正された IXGBE ドライバーをロードvMX必要があります。修正された IXGBE ドライバーをロードするには、次の方法に示します。

ネスト 型インスタンスvMXの起動

ネスト されたインスタンスを起動vMXするには、次のvMX。

たとえば、このコマンドは、vnet0 および vnet1 ブリッジに接続された 2 つの virtio インターフェイスを使用して、パフォーマンス モードで vMX インスタンスを起動します。

sudo virt-install --hvm --vcpus=12 -r 16384 \

--serial tcp,host=:4001,mode=bind,protocol=telnet \

--nographics --import --noautoconsole \

--cpu \

SandyBridge,+erms,+smep,+fsgsbase,+pdpe1gb,+rdrand,+f16c,+osxsave,+dca,+pcid,+pdcm,+x

tpr,+tm2,+est,+smx,+vmx,+ds_cpl,+monitor,+dtes64,+pbe,+tm,+ht,+ss,+acpi,+ds,+vme \

-w bridge=br-ext,model=virtio \

-w bridge=vnet0,model=virtio \

-w bridge=vnet1,model=virtio \

-n vmx1 --disk vmx-nested-17.2R1.13-4.qcow2,format=qcow2

たとえば、このコマンドは、2 つの SR-IOV インターフェイスvMX モードで、インターフェイス インスタンスを起動します。

sudo virt-install --hvm --vcpus=12 -r 16384 \

--serial tcp,host=:4001,mode=bind,protocol=telnet \

--nographics --import --noautoconsole \

--cpu \

SandyBridge,+erms,+smep,+fsgsbase,+pdpe1gb,+rdrand,+f16c,+osxsave,+dca,+pcid,+pdcm,+x

tpr,+tm2,+est,+smx,+vmx,+ds_cpl,+monitor,+dtes64,+pbe,+tm,+ht,+ss,+acpi,+ds,+vme \

-w bridge=br-ext,model=virtio \

--host-device=pci_0000_81_10_0 \

--host-device=pci_0000_81_10_1 \

-n vmx2 --disk vmx-nested-17.2R1.13-4.qcow2,format=qcow2

VFP コンソール ポートへの接続

コマンドを使用してvMXインスタンスを起動した後、パラメーターで指定したポートのコマンドを使用して、ホストからVFPのコンソール ポートに接続 virt-install telnet localhost serial-port serial-port host -serial できます。

例えば:

$ telnet localhost 4001

デフォルトのユーザー名とパスワードで jnpr ログインします jnpr123 。コマンドを使用して root sudo -i になります。

br-extインターフェイスは、DHCPを使用してIPアドレスの取得を試行します。コマンドを ifconfig br-ext 使用して、割り当てられた IP アドレスを表示します。DHCP が使用できない場合、または静的 IP アドレスが必要な場合は、 に IP アドレスを割り当て br-ext します。これで、SSH プロトコルと割り当てられた IP アドレスを使用して VFP に接続できます。

VCP への接続

VCP VM が起動すると、次のコマンドを使用して VFP VM から TCP ポート 8601 の VCP コンソール ポートに接続できます。

$ telnet localhost 8601

コンソール ポートから、ユーザー名とパスワードを使用して root ログインすることはできません。

少なくとも、VCP にログインした後は、Junos OS最初の設定タスクを実行する必要があります。