Design und Implementierung von Vernetzung von Datencentern mithilfe von Typ-5-Routen

Vernetzung von Datencentern mit EVPN Typ 5-Routen

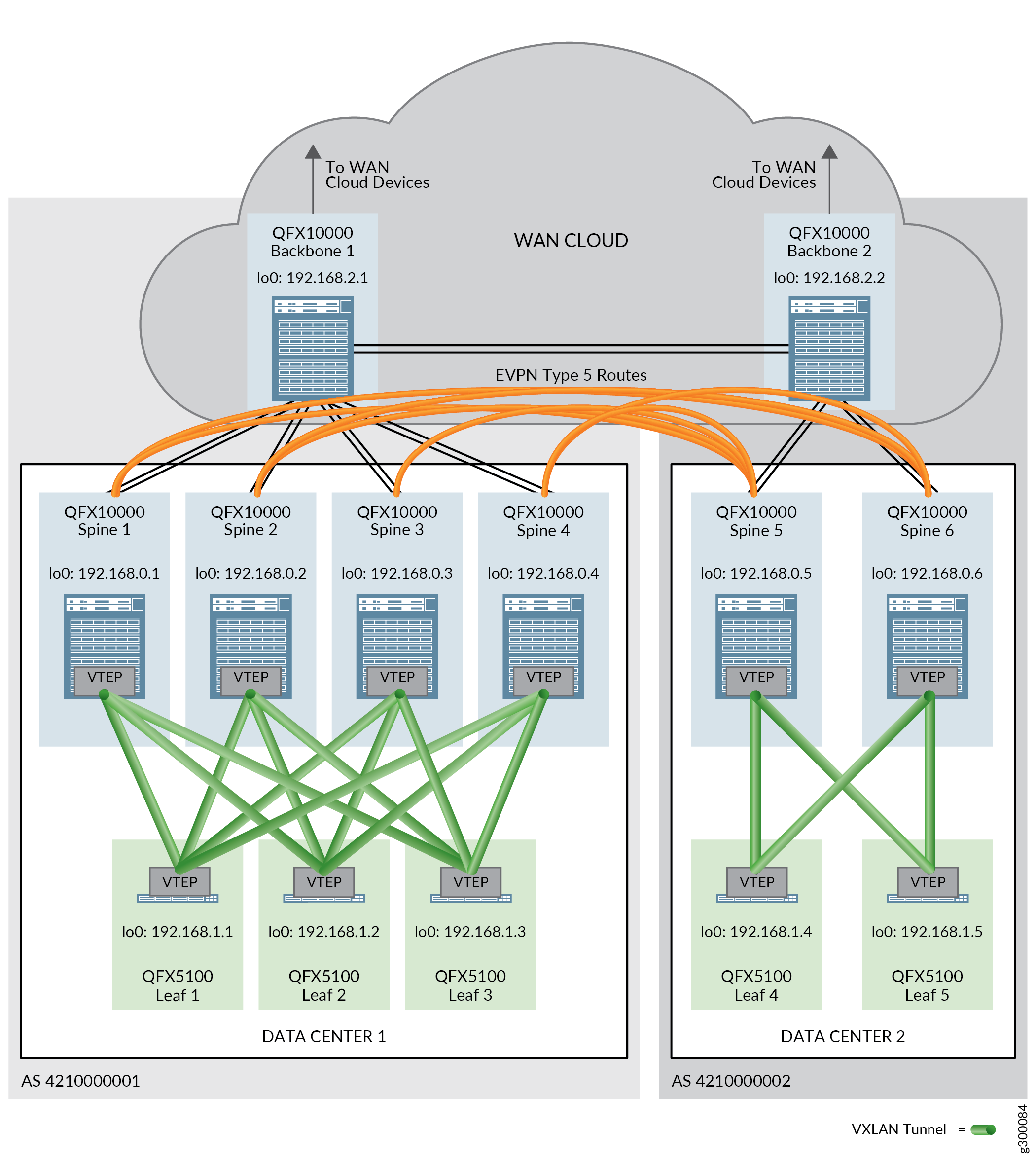

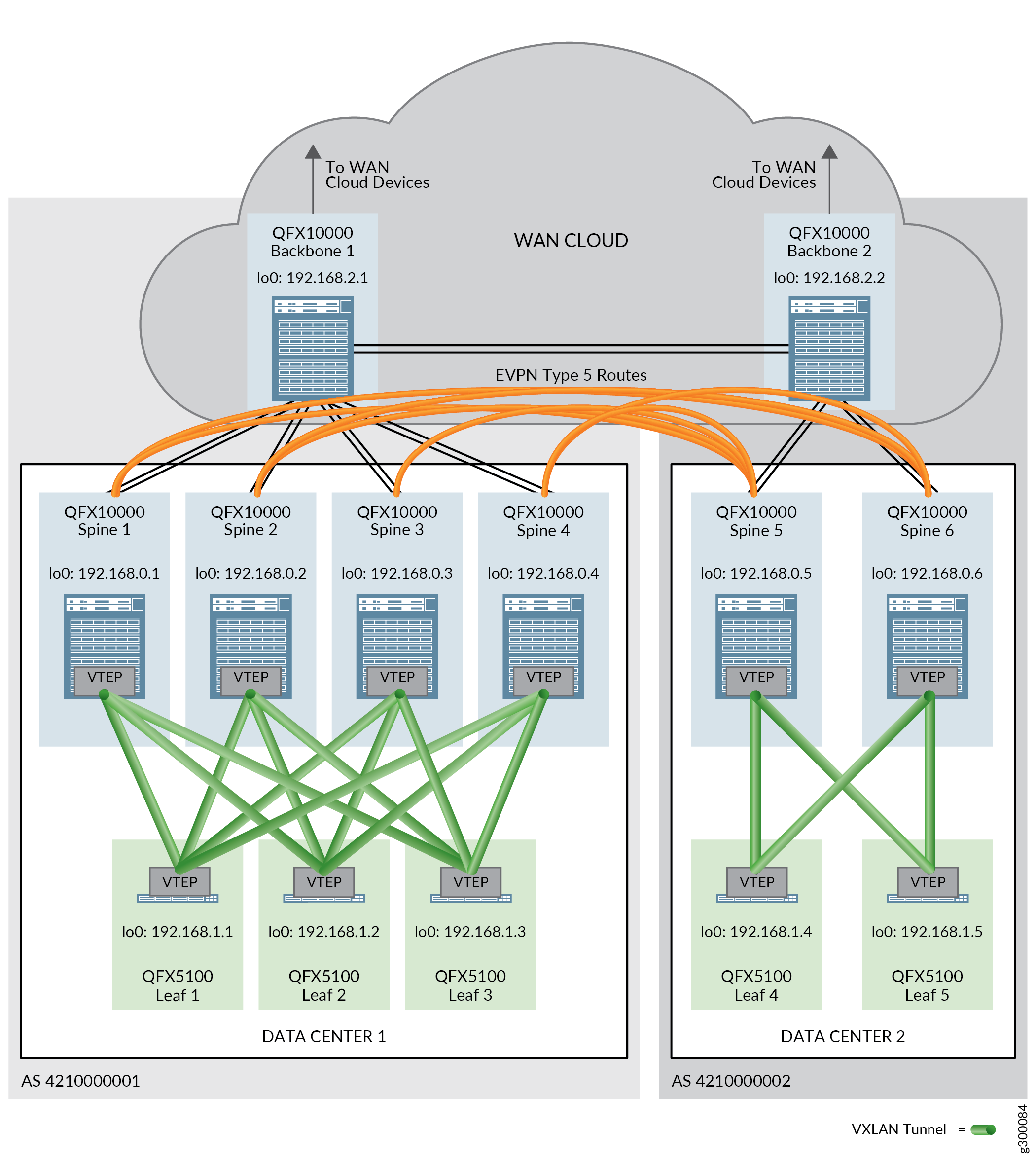

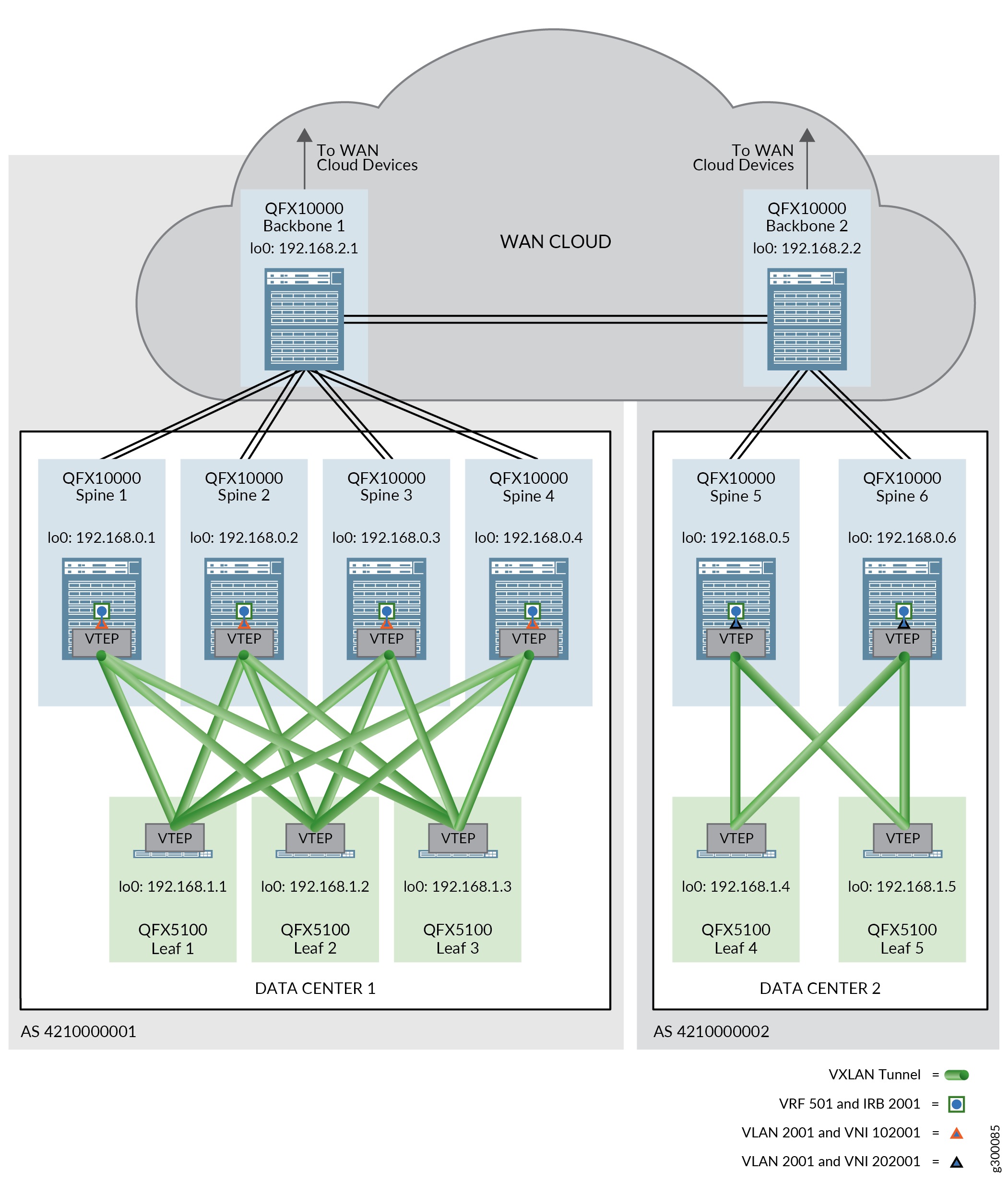

EVPN Typ 5-Routen, auch als IP-Präfix-Routen bekannt, werden in einem DCI-Kontext verwendet, um den Datenverkehr zwischen Datencentern zu leiten, die verschiedene IP-Adress-Subnetting-Schemata verwenden.

In dieser Referenzarchitektur werden EVPN Typ 5-Routen zwischen Spine-Geräten in verschiedenen Datencentern ausgetauscht, um die Weiterleitung des Datenverkehrs zwischen Datencentern zu ermöglichen.

Physische Konnektivität zwischen den Datencentern ist erforderlich, bevor EVPN-Nachrichten vom Typ 5 über Datencenter gesendet werden können. Diese physische Konnektivität wird durch Backbone-Geräte in einer WAN-Cloud bereitgestellt. Ein Backbone-Gerät ist mit jedem Spine-Gerät in einem einzigen Datencenter verbunden und nimmt an den Overlay-IBGP- und Underlay-EBGP-Sitzungen teil. EBGP wird auch in einer separaten BGP-Gruppe ausgeführt, um die Backbone-Geräte miteinander zu verbinden. EVPN-Signalübertragung ist in dieser BGP-Gruppe aktiviert.

Abbildung 1 zeigt zwei Datencenter, die EVPN Typ 5-Routen für DCI verwenden.

Weitere Informationen zu EVPN Typ 5-Routen finden Sie unter EVPN Typ-5-Route mit VXLAN-Kapselung für EVPN-VXLAN.

Alle Verfahren in diesem Abschnitt gehen davon aus, dass EVPN Typ 2-Routen erfolgreich in den Datencentern übergeben werden. Anweisungen zur Einrichtung finden Sie unter Central-Routing-Bridging-Overlay-Design und -Implementierung .

In diesem Abschnitt werden die Prozesse für die Konfiguration eines DCI mithilfe von EVPN Typ 5-Routen behandelt und die folgenden Verfahren umfasst:

- Konfiguration von Backbone-Geräteschnittstellen

- Ermöglichung von EBGP als Underlay-Netzwerk-Routing-Protokoll zwischen Spine- und Backbone-Geräten

- Aktivieren von IBGP für das Overlay-Netzwerk auf dem Backbone-Gerät

- Ermöglichung von EBGP als Routing-Protokoll zwischen Backbone-Geräten

- Konfigurieren von DCI mit EVPN Typ 5-Routen

- Überprüfen, ob DCI mit EVPN-Typ 5-Routen in Betrieb ist

- DCI mit Typ-5-Routen — Versionsgeschichte

Konfiguration von Backbone-Geräteschnittstellen

Die Backbone-Geräte in dieser Architektur sind Teil der WAN-Cloud und müssen sowohl Konnektivität zu den Spine-Geräten in jedem Datencenter als auch zu den anderen Backbone-Geräten bieten. Diese Konnektivität muss hergestellt werden, bevor EVPN Typ 5-Routen zwischen Spine-Geräten in verschiedenen Datencentern ausgetauscht werden können.

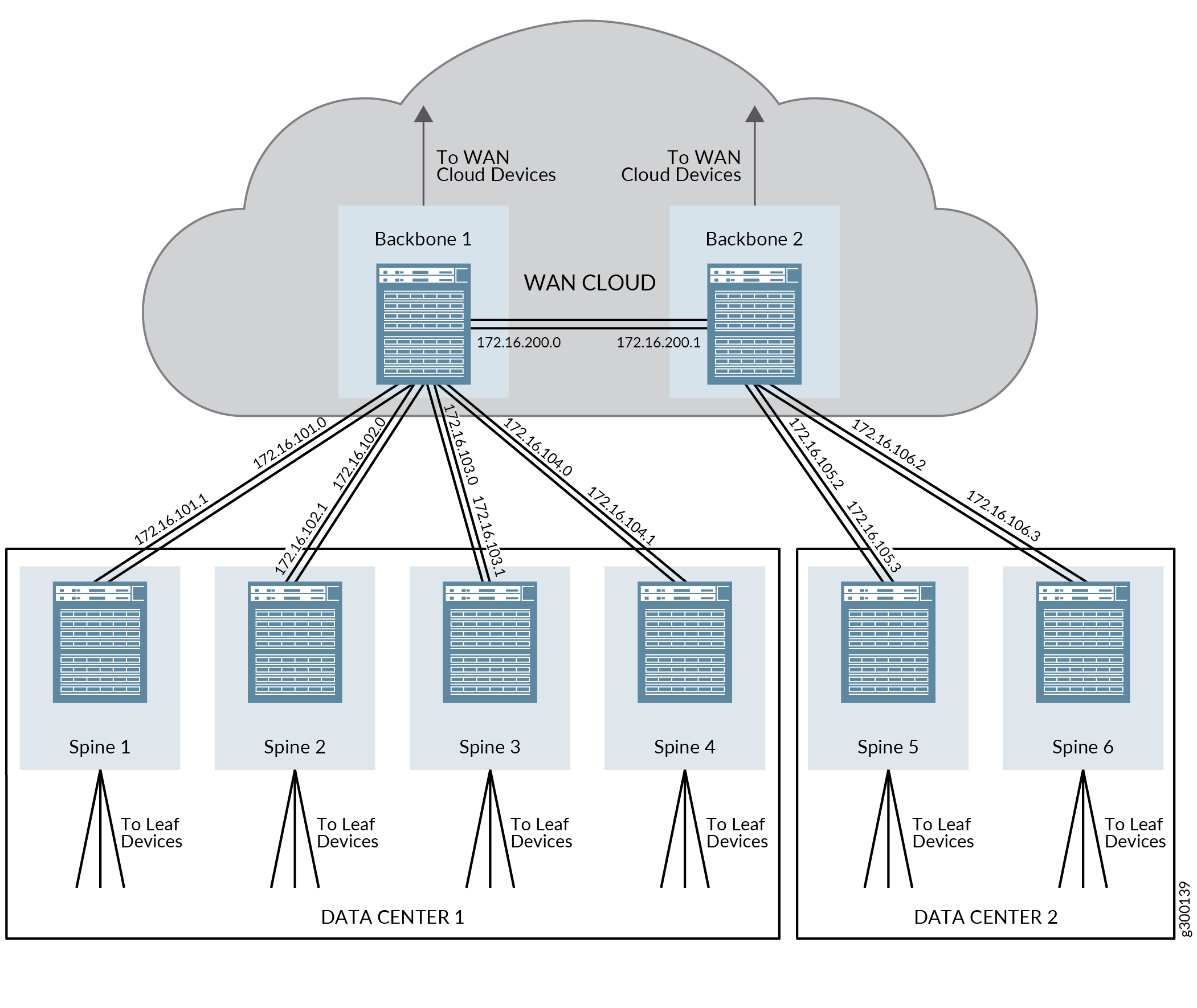

Abbildung 2 bietet einen Überblick über die IP-Adressen, die in diesen Schritten konfiguriert werden.

So konfigurieren Sie das Spine-Gerät und die Backbone-Geräteschnittstellen:

(Aggregierte Ethernet-Schnittstellen) Konfigurieren Sie die aggregierten Ethernet-Schnittstellen auf den Spine-Geräte-Switches in den Datencentern 1 und 2 sowie auf den Backbone-Geräten.

Dieser Schritt zeigt nur die Zuordnung der IP-Adresse zu den aggregierten Ethernet-Schnittstellen. Vollständige Schritt-für-Schritt-Anweisungen zum Erstellen aggregierter Ethernet-Schnittstellen finden Sie unter Konfigurieren der Link-Aggregation.

Spine-Gerät 1 im Datencenter 1:

set interfaces ae3 unit 0 family inet address 172.16.101.1/31

Spine-Gerät 2 im Datencenter 1:

set interfaces ae3 unit 0 family inet address 172.16.102.1/31

Spine-Gerät 3 im Datencenter 1:

set interfaces ae3 unit 0 family inet address 172.16.103.1/31

Spine-Gerät 4 im Datencenter 1:

set interfaces ae3 unit 0 family inet address 172.16.104.1/31

Spine-Gerät 5 im Datencenter 2:

set interfaces ae4 unit 0 family inet address 172.16.105.3/31

Spine-Gerät 6 im Datencenter 2:

set interfaces ae4 unit 0 family inet address 172.16.106.3/31

Backbone-Gerät 1:

set interfaces ae1 unit 0 family inet address 172.16.101.0/31 set interfaces ae2 unit 0 family inet address 172.16.102.0/31 set interfaces ae3 unit 0 family inet address 172.16.103.0/31 set interfaces ae4 unit 0 family inet address 172.16.104.0/31 set interfaces ae200 unit 0 family inet address 172.16.200.0/31

Backbone-Gerät 2:

set interfaces ae5 unit 0 family inet address 172.16.105.2/31 set interfaces ae6 unit 0 family inet address 172.16.106.2/31 set interfaces ae200 unit 0 family inet address 172.16.200.1/31

(Eigenständige Schnittstellen, die nicht in aggregierten Ethernet-Schnittstellen enthalten sind) Siehe Konfigurieren der Schnittstellenadresse.

Ermöglichung von EBGP als Underlay-Netzwerk-Routing-Protokoll zwischen Spine- und Backbone-Geräten

EBGP wird in diesem Referenzdesign als Routing-Protokoll des Underlay-Netzwerks verwendet. Die Backbone-Geräte müssen zusammen mit den Spine-Geräten an der EBGP teilnehmen, um Underlay-Konnektivität zu unterstützen.

Der Prozess zur Aktivierung von EBGP auf Spine- und Leaf-Geräten wird im Abschnitt IP Fabric Underlay Network Design and Implementation dieses Leitfadens behandelt. Dieses Verfahren setzt voraus, dass EBGP bereits auf den Spine- und Leaf-Geräten aktiviert wurde, obwohl einige EBGP-Konfigurationen auf den Spine-Geräten aktualisiert werden müssen, um Backbone-Geräte zu unterstützen, und ist daher in diesen Schritten enthalten.

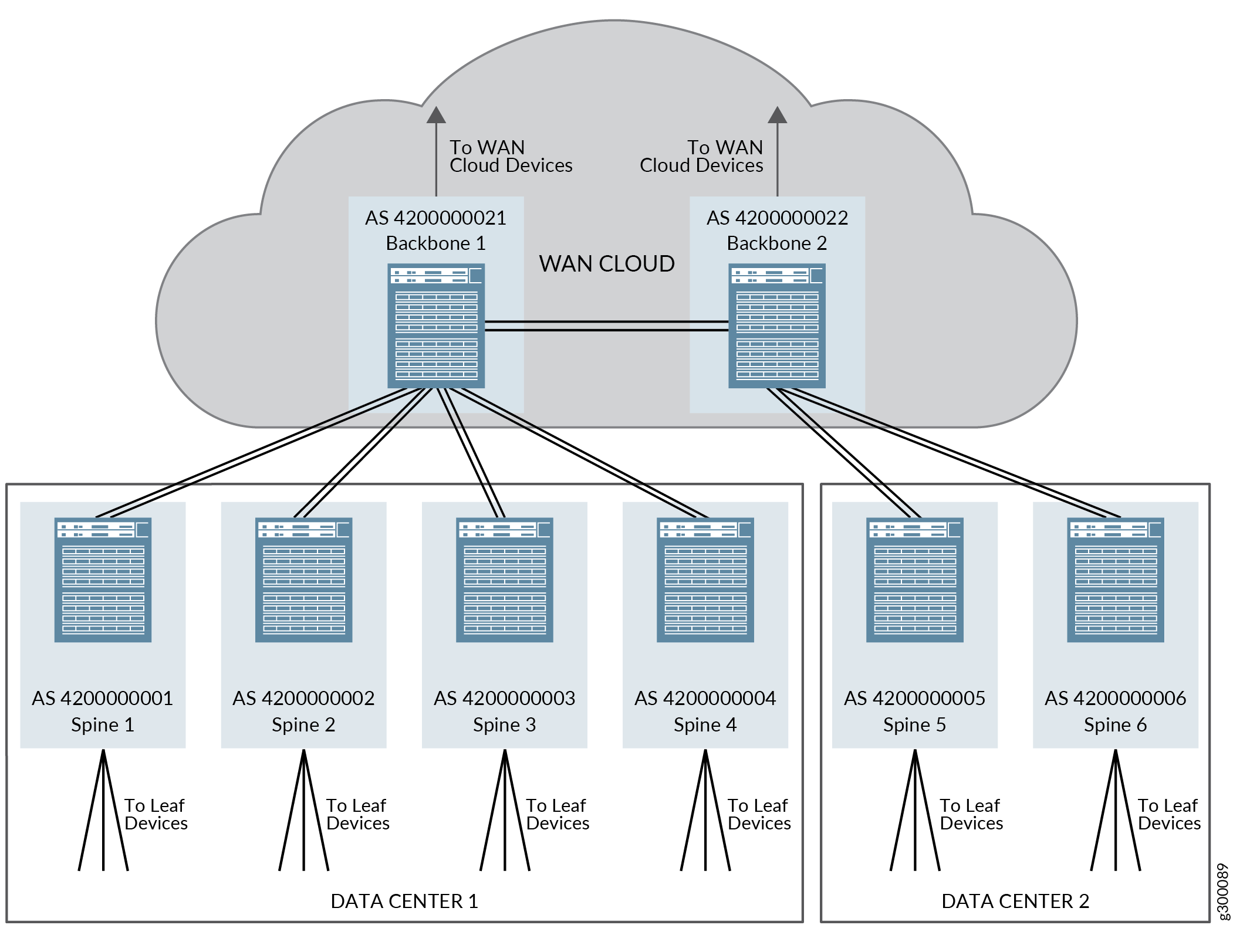

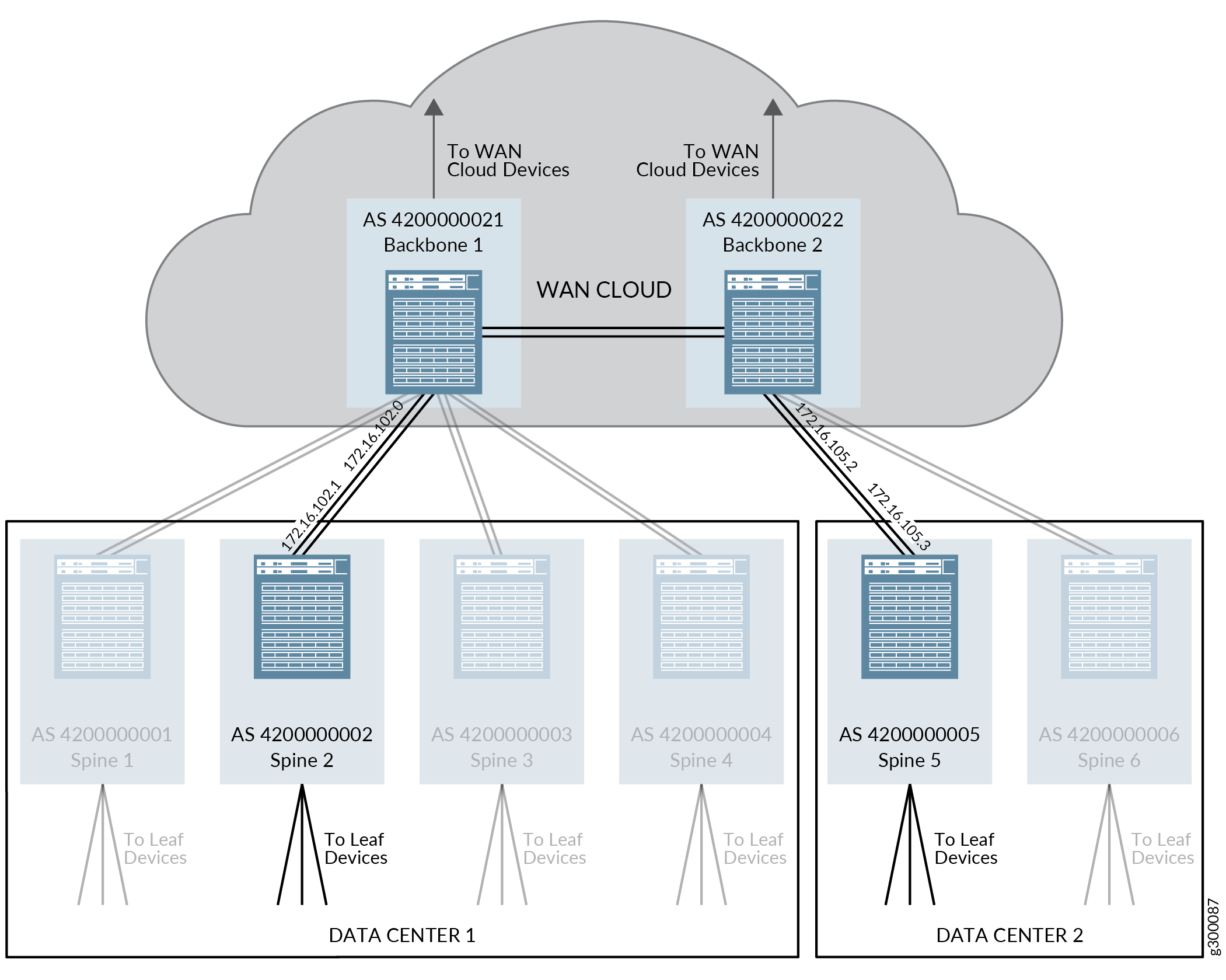

EBGP funktioniert in diesem Referenzdesign, indem jedes Leaf-, Spine- und Backbone-Gerät seiner eigenen 32-Bit-AS-Nummer (Autonomous System) zugewiesen wird.

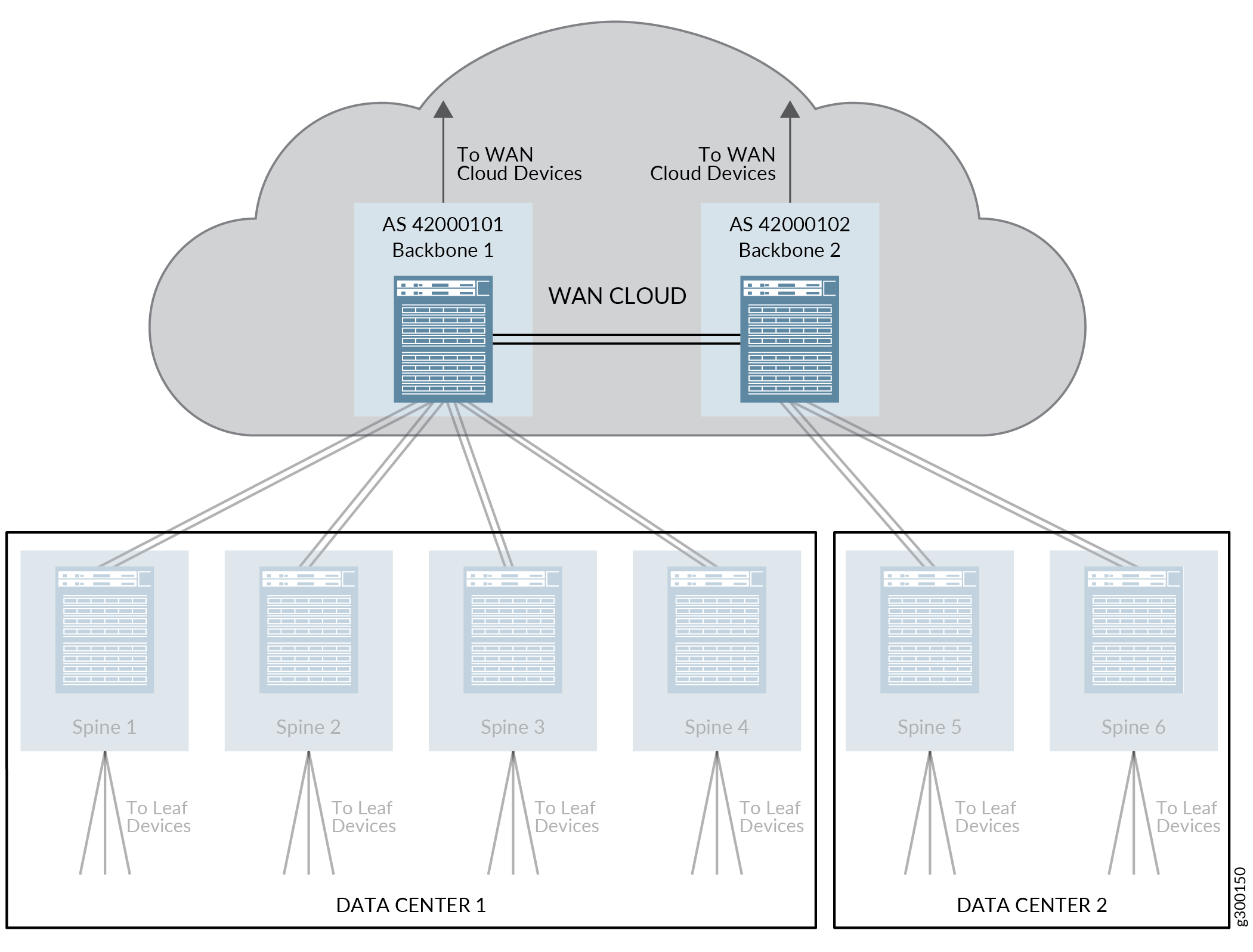

Abbildung 3 zeigt eine Übersicht über die EBGP-Topologie für Spine- und Backbone-Geräte, wenn Backbone-Geräte im Referenzdesign enthalten sind.

Abbildung 4 veranschaulicht die EBGP-Protokollparameter, die in dieser Prozedur konfiguriert werden. Wiederholen Sie diesen Vorgang für die anderen Geräte in der Topologie, um EBGP auf den verbleibenden Geräten zu aktivieren.

So ermöglichen Sie EBGP die Unterstützung des Underlay-Netzwerks in diesem Referenzdesign:

Aktivieren von IBGP für das Overlay-Netzwerk auf dem Backbone-Gerät

Die Backbone-Geräte müssen IBGP ausführen, um Overlay-Netzwerkkonnektivität zu haben und DCI mit EVPN Typ 5-Routen zu unterstützen.

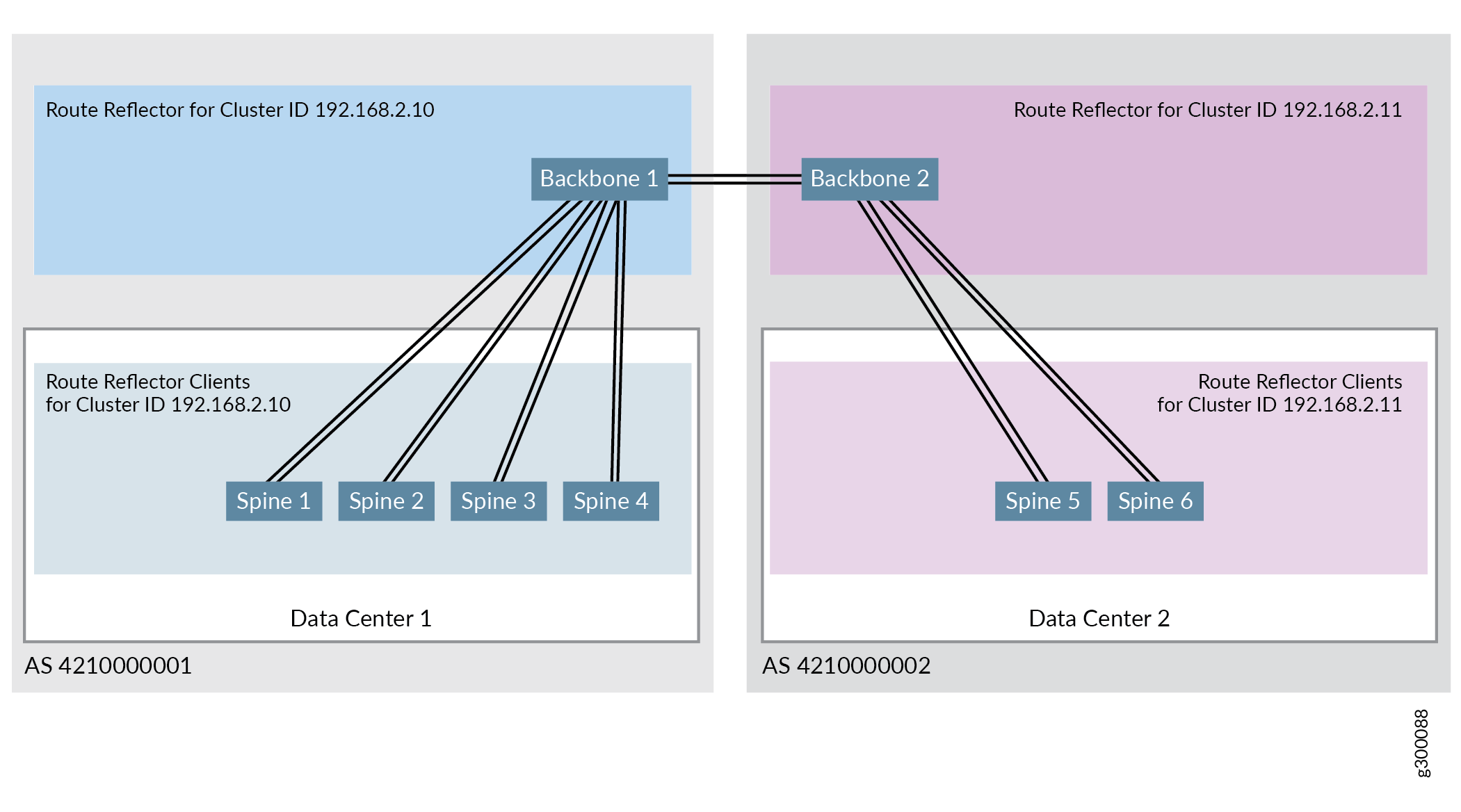

Abbildung 5 zeigt die IBGP-Konfiguration des validierten Referenzdesigns, wenn Backbone-Geräte in der Topologie enthalten sind. Im validierten Referenzdesign werden alle Spine- und Leaf-Geräte im selben Datencenter demselben autonomen System zugeordnet. Die Backbone-Geräte werden demselben autonomen System zugewiesen wie die Spine- und Leaf-Geräte des Datencenters, das das Backbone-Gerät als Einstiegspunkt in die WAN-Cloud verwendet.

Abbildung 6 veranschaulicht die Routenreflektorkonfiguration im validierten Referenzdesign. Ein Route Reflector Cluster – Cluster-ID 192.168.2.10 – umfasst Backbone-Gerät 1 als Route Reflector und alle Spine-Geräte im Datencenter 1 als Route Reflector-Clients. Ein weiterer Route Reflector Cluster – Cluster-ID 192.168.2.11 – umfasst Backbone-Gerät 2 als Routenreflektor und alle Spine-Geräte im Datencenter 2 als Route Reflector-Clients.

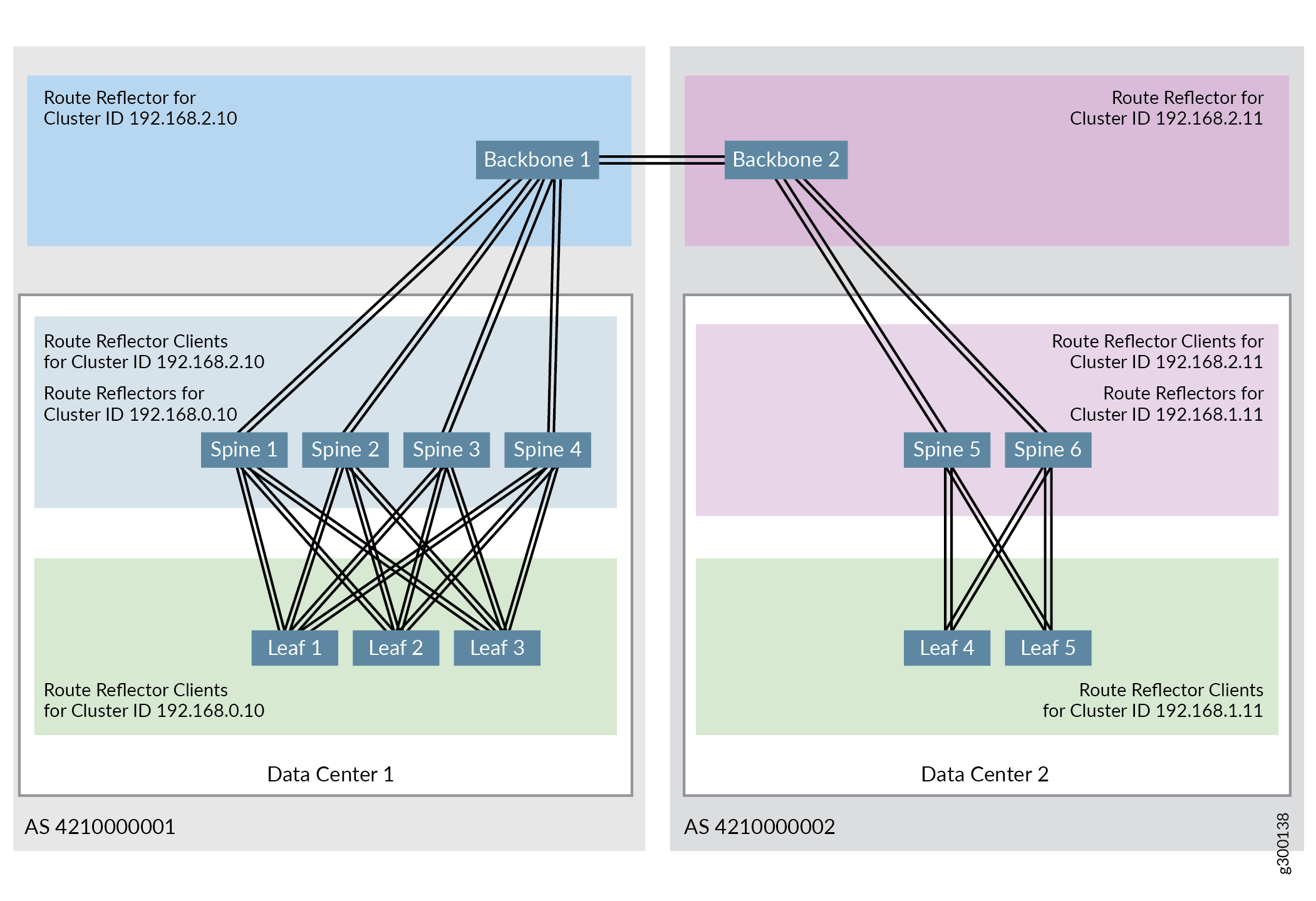

Das validierte Referenzdesign unterstützt mehrere hierarchische Routenreflektoren, wobei ein Cluster Backbone-Geräte umfasst, die als Routenreflektoren für Die Spine-Geräte-Clients fungieren, und ein anderer Cluster enthält Spine-Geräte, die als Routenreflektoren für Leaf-Geräte-Clients fungieren. Die Konfigurationsschritte für die Konfiguration des anderen Route Reflectors finden Sie unter Konfigurieren von IBGP für das Overlay.

Abbildung 7 zeigt die vollständige hierarchische Routenreflektortopologie, wenn zwei Datencenter miteinander verbunden sind:

Weitere Informationen zu BGP-Routenreflektoren finden Sie unter Grundlegendes zu BGP Route Reflectors.

Bei diesem Verfahren wird vorausgesetzt, dass IBGP für Die Spine- und Leaf-Geräte aktiviert wurde, wie in Konfigurieren von IBGP für das Overlay beschrieben. Die Spine-Gerätekonfigurationen sind in diesem Verfahren enthalten, um ihre Beziehungen zu den Backbone-Geräten zu veranschaulichen.

So richten Sie die IBGP-Konnektivität für Backbone-Geräte ein:

Ermöglichung von EBGP als Routing-Protokoll zwischen Backbone-Geräten

EBGP wird in diesem Referenzdesign auch als Routing-Protokoll zwischen den Backbone-Geräten verwendet. Die Backbone-Geräte sind über IP verbunden und die Backbone-Geräte müssen als EBGP-Peers konfiguriert werden.

In diesen Schritten wird eine zweite EBGP-GruppeBACKBONE-BGP erstellt, um EBGP zwischen den Backbone-Geräten zu aktivieren. Jedes Backbone-Gerät wird in der neuen EBGP-Gruppe in diesen Schritten einer eindeutigen 32-Bit-AS-Nummer zugewiesen. Die Backbone-Geräte sind daher Teil von zwei EBGP-Gruppen –UNDERLAY-BGP und BACKBONE-BGP– und haben eine eindeutige AS-Nummer innerhalb jeder Gruppe. Die EVPN-Signalübertragung, die zur Unterstützung von EVPN zwischen den Backbone-Geräten ausgeführt werden muss, wird während dieses Verfahrens auch innerhalb der EBGP-Gruppe konfiguriert.

Abbildung 8 zeigt die Attribute, die für die Aktivierung von EBGP zwischen den Backbone-Geräten erforderlich sind.

So aktivieren Sie EBGP als Routing-Protokoll zwischen den Backbone-Geräten:

Konfigurieren von DCI mit EVPN Typ 5-Routen

EVPN Typ 5 Nachrichten werden zwischen IRB-Schnittstellen auf Spine-Geräten in verschiedenen Datencentern ausgetauscht, wenn EVPN Typ 5-Routen für DCI verwendet werden. Diese IRB-Schnittstellen werden in einer Routing-Instanz konfiguriert.

Jedes Datencenter verfügt in dieser Konfiguration über einen eindeutigen virtuellen Netzwerkbezeichner (VNI 102001 und 202001), aber beide VNIs sind dem gleichen VLAN (VLAN 2001) in derselben Routing-Instanz (VRF 501) zugeordnet.

In Abbildung 9 finden Sie eine Veranschaulichung der Routing-Instanz.

So aktivieren Sie DCI mit EVPN Typ 5-Routen:

Diese Prozedur setzt voraus, dass die Routing-Instanzen, IRBs und VLANs, die zuvor in diesem Leitfaden erstellt wurden, betriebsbereit sind. Siehe Zentral geroutetes Bridging-Overlay-Design und -Implementierung.

Beachten Sie bei der Implementierung von Leaf-Randfunktionen auf einem MX-Router, dass der Router nur virtuelle Switch-Instanzen unterstützt. MX-Router unterstützen keine Standardinstanzen.

Überprüfen, ob DCI mit EVPN-Typ 5-Routen in Betrieb ist

Geben Sie die folgenden Befehle ein, um zu überprüfen, ob Datenverkehr zwischen Datencentern über EVPN Typ 5-Routen gesendet werden kann:

DCI mit Typ-5-Routen — Versionsgeschichte

Tabelle 1 enthält einen Verlauf aller Funktionen in diesem Abschnitt und deren Unterstützung innerhalb dieses Referenzdesigns.

Release |

Beschreibung |

|---|---|

19.1R2 |

QFX10002-60C- und QFX5120-32C-Switches mit Junos OS Version 19.1R2 und höher im selben Release Train unterstützen alle Funktionen, die in diesem Abschnitt dokumentiert sind. |

18,4R2-S2 |

QFX5110- und QFX5120-48Y-Switches sowie MX-Router mit Junos OS Version 18.4R2-S2 und höher im selben Versionszug unterstützen alle in diesem Abschnitt dokumentierten Funktionen. |