Auf dieser Seite

Konfigurieren der Verzögerung, bevor LDP-Nachbarn als inaktiv betrachtet werden

Aktivieren von streng gezielten Begrüssungsnachrichten für LDP

Beispiel: Konfigurieren der längsten Übereinstimmung für LDP

Steuern der Transportadresse, die für die Ziel-LDP-Sitzung verwendet wird

Konfigurieren der Präfixe, die in LDP aus der Routing-Tabelle angekündigt werden

Konfigurieren von ECMP-fähigem BFD für LDP-Sprachdienstleister

Konfigurieren einer Fehleraktion für die BFD-Sitzung auf einem LDP-LSP

Beispiel: Konfigurieren der schnellen Multicast-Weiterleitung in einer Multipoint-LDP-Domäne

Beispiel: Konfigurieren der Multipoint-LDP-In-Band-Signalisierung für Point-to-Multipoint-LSPs

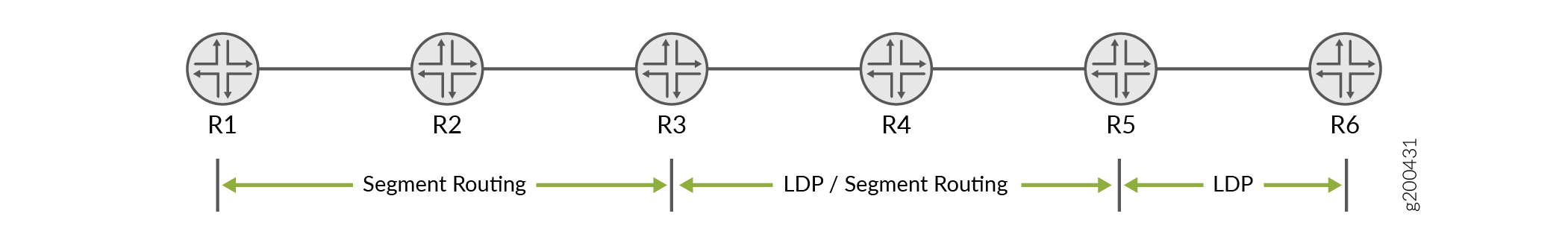

Mapping von Client und Server für Segment-Routing auf LDP-Interoperabilität

LDP-Konfiguration

LDP-Mindestkonfiguration

So aktivieren Sie LDP mit minimaler Konfiguration:

Aktivieren Sie alle relevanten Schnittstellen unter der MPLS-Familie. Im Falle von gerichtetem LDP muss die Loopback-Schnittstelle mit Familien-MPLS aktiviert werden.

(Optional) Konfigurieren Sie die entsprechenden Schnittstellen unter der

[edit protocol mpls]Hierarchieebene.Aktivieren Sie LDP auf einer einzelnen Schnittstelle, fügen Sie die

ldpAnweisung ein, und geben Sie die Schnittstelle mithilfe derinterfaceAnweisung an.

Dies ist die minimale LDP-Konfiguration. Alle anderen LDP-Konfigurationsanweisungen sind optional.

ldp { interface interface-name; }

Um LDP auf allen Schnittstellen zu aktivieren, geben Sie all für interface-namean.

Eine Liste der Hierarchieebenen, auf denen Sie diese Anweisungen einschließen können, finden Sie in den Abschnitten zur Anweisungszusammenfassung.

Aktivieren und Deaktivieren von LDP

LDP ist Routing-instanzfähig. Um LDP auf einer bestimmten Schnittstelle zu aktivieren, fügen Sie die folgenden Anweisungen hinzu:

ldp { interface interface-name; }

Eine Liste der Hierarchieebenen, auf denen Sie diese Anweisungen einschließen können, finden Sie in den Abschnitten zur Anweisungszusammenfassung.

Um LDP auf allen Schnittstellen zu aktivieren, geben Sie all für interface-namean.

Wenn Sie Schnittstelleneigenschaften für eine Gruppe von Schnittstellen konfiguriert haben und LDP für eine der Schnittstellen deaktivieren möchten, fügen Sie die interface Anweisung mit der disable Option ein:

interface interface-name { disable; }

Eine Liste der Hierarchieebenen, auf denen Sie diese Anweisung einbinden können, finden Sie im Abschnitt Anweisungszusammenfassung.

Konfigurieren des LDP-Timers für Hallo-Nachrichten

LDP-Hello-Nachrichten ermöglichen es LDP-Knoten, sich gegenseitig zu erkennen und den Ausfall eines Nachbarn oder die Verbindung zum Nachbarn zu erkennen. Hello-Nachrichten werden regelmäßig an allen Schnittstellen gesendet, auf denen LDP aktiviert ist.

Es gibt zwei Arten von LDP-Hello-Nachrichten:

Link Hello-Nachrichten - Werden über die LDP-Schnittstelle als UDP-Pakete gesendet, die an den LDP-Erkennungsport adressiert sind. Der Empfang einer LDP-Link-Hello-Nachricht auf einer Schnittstelle identifiziert eine Nachbarschaft mit dem LDP-Peer-Router.

Gezielte Hallo-Nachrichten: Werden als UDP-Pakete gesendet, die an den LDP-Erkennungsport an einer bestimmten Adresse adressiert sind. Gezielte Hallo-Nachrichten werden verwendet, um LDP-Sitzungen zwischen Routern zu unterstützen, die nicht direkt verbunden sind. Ein Zielrouter bestimmt, ob eine gezielte Hallo-Nachricht beantwortet oder ignoriert werden soll. Ein Zielrouter, der sich für eine Antwort entscheidet, sendet dazu regelmäßig gezielte Hallo-Nachrichten an den initiierenden Router zurück.

Standardmäßig sendet LDP Hello-Nachrichten alle 5 Sekunden für Link-Hello-Nachrichten und alle 15 Sekunden für gezielte Hello-Nachrichten. Sie können den LDP-Timer konfigurieren, um zu ändern, wie oft beide Arten von Begrüßungsnachrichten gesendet werden. Sie können jedoch keine Zeit für den LDP-Timer konfigurieren, die größer als die LDP-Haltezeit ist. Weitere Informationen finden Sie unter Konfigurieren der Verzögerung, bevor LDP-Nachbarn als inaktiv betrachtet werden.

- Konfigurieren des LDP-Timers für Link-Hello-Nachrichten

- Konfigurieren des LDP-Timers für gezielte Hallo-Nachrichten

Konfigurieren des LDP-Timers für Link-Hello-Nachrichten

Um zu ändern, wie oft LDP Link-Hello-Nachrichten sendet, geben Sie mithilfe der folgenden hello-interval Anweisung ein neues Link-Hello-Meldungsintervall für den LDP-Timer an:

hello-interval seconds;

Eine Liste der Hierarchieebenen, auf denen Sie diese Anweisung einschließen können, finden Sie im Abschnitt Anweisungszusammenfassung für diese Anweisung.

Konfigurieren des LDP-Timers für gezielte Hallo-Nachrichten

Um zu ändern, wie oft LDP gezielte Hallo-Nachrichten sendet, geben Sie ein neues Intervall für gezielte Hallo-Nachrichten für den LDP-Timer an, indem Sie die hello-interval Anweisung als Option für die targeted-hello Anweisung konfigurieren:

targeted-hello { hello-interval seconds; }

Eine Liste der Hierarchieebenen, auf denen Sie diese Anweisungen einschließen können, finden Sie in den Abschnitten zur Anweisungszusammenfassung für diese Anweisungen.

Konfigurieren der Verzögerung, bevor LDP-Nachbarn als inaktiv betrachtet werden

Die Haltezeit bestimmt, wie lange ein LDP-Knoten auf eine Hallo-Nachricht warten soll, bevor er einen Nachbarn für ausgefallen erklärt. Dieser Wert wird als Teil einer Hello-Nachricht gesendet, sodass jeder LDP-Knoten seinen Nachbarn mitteilt, wie lange sie warten sollen. Die von den einzelnen Nachbarn gesendeten Werte müssen nicht übereinstimmen.

Die Haltezeit sollte normalerweise mindestens das Dreifache des Hallo-Intervalls betragen. Der Standardwert ist 15 Sekunden für Link-Hello-Nachrichten und 45 Sekunden für gezielte Hello-Nachrichten. Es ist jedoch möglich, eine LDP-Haltezeit zu konfigurieren, die nahe am Wert für das Hello-Intervall liegt.

Durch die Konfiguration einer LDP-Haltezeit in der Nähe des Hello-Intervalls (weniger als das Dreifache des Hello-Intervalls) können LDP-Nachbarfehler schneller erkannt werden. Dies erhöht jedoch auch die Wahrscheinlichkeit, dass der Router einen LDP-Nachbarn für heruntergefahren erklärt, der noch normal funktioniert. Weitere Informationen finden Sie unter Konfigurieren des LDP-Timers für Hello-Nachrichten.

Die LDP-Haltezeit wird ebenfalls automatisch zwischen LDP-Peers ausgehandelt. Wenn sich zwei LDP-Peers gegenseitig unterschiedliche LDP-Haltezeiten ankündigen, wird der kleinere Wert verwendet. Wenn ein LDP-Peer-Router eine kürzere Haltezeit als den von Ihnen konfigurierten Wert ankündigt, wird die angekündigte Haltezeit des Peer-Routers verwendet. Diese Aushandlung kann sich auch auf das LDP-Keepalive-Intervall auswirken.

Wenn die lokale LDP-Haltezeit während der LDP-Peer-Aushandlung nicht verkürzt wird, bleibt das vom Benutzer konfigurierte Keepalive-Intervall unverändert. Wenn jedoch die lokale Haltezeit während der Peeraushandlung reduziert wird, wird das Keepalive-Intervall neu berechnet. Wenn die LDP-Haltezeit während der Peer-Aushandlung reduziert wurde, wird das Keepalive-Intervall auf ein Drittel des neuen Haltezeitwerts reduziert. Wenn der neue Haltezeitwert z. B. 45 Sekunden beträgt, wird das Keepalive-Intervall auf 15 Sekunden festgelegt.

Diese automatische Berechnung des Keepalive-Intervalls kann dazu führen, dass auf jedem Peer-Router unterschiedliche Keepalive-Intervalle konfiguriert werden. Dadurch können die Router flexibel sein, wie oft sie Keepalive-Nachrichten senden, da die LDP-Peer-Aushandlung sicherstellt, dass sie häufiger gesendet werden als die LDP-Haltezeit.

Wenn Sie das Haltezeitintervall neu konfigurieren, werden die Änderungen erst nach dem Zurücksetzen der Sitzung wirksam. Die Haltezeit wird ausgehandelt, wenn die LDP-Peering-Sitzung initiiert wird, und kann nicht neu ausgehandelt werden, solange die Sitzung aktiv ist (erforderlich gemäß RFC 5036, LDP-Spezifikation). Um das Zurücksetzen der LDP-Sitzung manuell zu erzwingen, geben Sie den clear ldp session Befehl ein.

- Konfigurieren der LDP-Haltezeit für Link-Hello-Nachrichten

- Konfigurieren der LDP-Haltezeit für gezielte Hallo-Nachrichten

Konfigurieren der LDP-Haltezeit für Link-Hello-Nachrichten

Um zu ändern, wie lange ein LDP-Knoten auf eine Link Hello-Nachricht warten soll, bevor der Nachbar als inaktiv deklariert wird, geben Sie mit der hold-time folgenden Anweisung eine neue Zeit in Sekunden an:

hold-time seconds;

Eine Liste der Hierarchieebenen, auf denen Sie diese Anweisung einschließen können, finden Sie im Abschnitt Anweisungszusammenfassung für diese Anweisung.

Konfigurieren der LDP-Haltezeit für gezielte Hallo-Nachrichten

Um zu ändern, wie lange ein LDP-Knoten auf eine gezielte Hello-Nachricht warten soll, bevor der Nachbar deklariert wird, geben Sie eine neue Zeit in Sekunden an, indem Sie die hold-time Anweisung als Option für die targeted-hello Anweisung verwenden:

targeted-hello { hold-time seconds; }

Eine Liste der Hierarchieebenen, auf denen Sie diese Anweisungen einschließen können, finden Sie in den Abschnitten zur Anweisungszusammenfassung für diese Anweisungen.

Aktivieren von streng gezielten Begrüssungsnachrichten für LDP

Verwenden Sie streng gezielte Hello-Nachrichten, um zu verhindern, dass LDP-Sitzungen mit Remotenachbarn eingerichtet werden, die nicht speziell konfiguriert wurden. Wenn Sie die strict-targeted-hellos Anweisung konfigurieren, antwortet ein LDP-Peer nicht auf gezielte Hello-Nachrichten, die von einer Quelle stammen, die nicht zu den konfigurierten Remotenachbarn gehört. Zu den konfigurierten Remote-Nachbarn gehören unter anderem:

Endpunkte von RSVP-Tunneln, für die LDP-Tunneling konfiguriert ist

Layer 2-Verbindungsnachbarn

Wenn ein nicht konfigurierter Nachbar eine Hello-Nachricht sendet, ignoriert der LDP-Peer die Nachricht und protokolliert einen Fehler (mit dem Trace-Flag), der error die Quelle angibt. Wenn der LDP-Peer z. B. ein gezieltes Hallo von der Internetadresse 10.0.0.1 empfangen hat und kein Nachbar mit dieser Adresse speziell konfiguriert ist, wird die folgende Meldung in der LDP-Protokolldatei ausgegeben:

LDP: Ignoring targeted hello from 10.0.0.1

Um streng zielgerichtete Hallo-Nachrichten zu aktivieren, fügen Sie die strict-targeted-hellos folgende Anweisung ein:

strict-targeted-hellos;

Eine Liste der Hierarchieebenen, auf denen Sie diese Anweisung einschließen können, finden Sie im Abschnitt Anweisungszusammenfassung für diese Anweisung.

Konfigurieren des Intervalls für LDP-Keepalive-Nachrichten

Das Keepalive-Intervall bestimmt, wie oft eine Nachricht über die Sitzung gesendet wird, um sicherzustellen, dass das Keepalive-Timeout nicht überschritten wird. Wenn in dieser Zeit kein anderer LDP-Datenverkehr über die Sitzung gesendet wird, wird eine Keepalive-Nachricht gesendet. Der Standardwert ist 10 Sekunden. Der Mindestwert beträgt 1 Sekunde.

Der für das Keepalive-Intervall konfigurierte Wert kann während der LDP-Sitzungsaushandlung geändert werden, wenn der für die LDP-Haltezeit auf dem Peer-Router konfigurierte Wert niedriger ist als der lokal konfigurierte Wert. Weitere Informationen finden Sie unter Konfigurieren der Verzögerung, bevor LDP-Nachbarn als inaktiv betrachtet werden.

Um das Keepalive-Intervall zu ändern, fügen Sie die keepalive-interval folgende Anweisung ein:

keepalive-interval seconds;

Eine Liste der Hierarchieebenen, auf denen Sie diese Anweisung einschließen können, finden Sie im Abschnitt Anweisungszusammenfassung für diese Anweisung.

Konfigurieren des LDP-Keepalive-Timeouts

Nachdem eine LDP-Sitzung eingerichtet wurde, müssen regelmäßig Nachrichten ausgetauscht werden, um sicherzustellen, dass die Sitzung weiterhin funktioniert. Das Keepalive-Timeout definiert die Zeitspanne, die der benachbarte LDP-Knoten wartet, bevor er entscheidet, dass die Sitzung fehlgeschlagen ist. Dieser Wert wird in der Regel auf mindestens das Dreifache des Keepalive-Intervalls festgelegt. Der Standardwert ist 30 Sekunden.

Um das Keepalive-Intervall zu ändern, fügen Sie die keepalive-timeout folgende Anweisung ein:

keepalive-timeout seconds;

Eine Liste der Hierarchieebenen, auf denen Sie diese Anweisung einschließen können, finden Sie im Abschnitt Anweisungszusammenfassung für diese Anweisung.

Der für die keepalive-timeout Anweisung konfigurierte Wert wird als Haltezeit angezeigt, wenn Sie den show ldp session detail Befehl ausgeben.

Konfigurieren der längsten Übereinstimmung für LDP

Damit LDP die Routen lernen kann, die über OSPF-Bereiche oder ISIS-Ebenen in domänenübergreifenden Bereichen aggregiert oder zusammengefasst werden, können Sie mit Junos OS die längste Übereinstimmung für LDP basierend auf RFC5283konfigurieren.

Bevor Sie die längste Übereinstimmung für LDP konfigurieren, müssen Sie die folgenden Schritte ausführen:

Konfigurieren Sie die Geräteschnittstellen.

Konfigurieren Sie das MPLS-Protokoll.

Konfigurieren Sie das OSPF-Protokoll.

Um die längste Übereinstimmung für LDP zu konfigurieren, müssen Sie die folgenden Schritte ausführen:

Beispiel: Konfigurieren der längsten Übereinstimmung für LDP

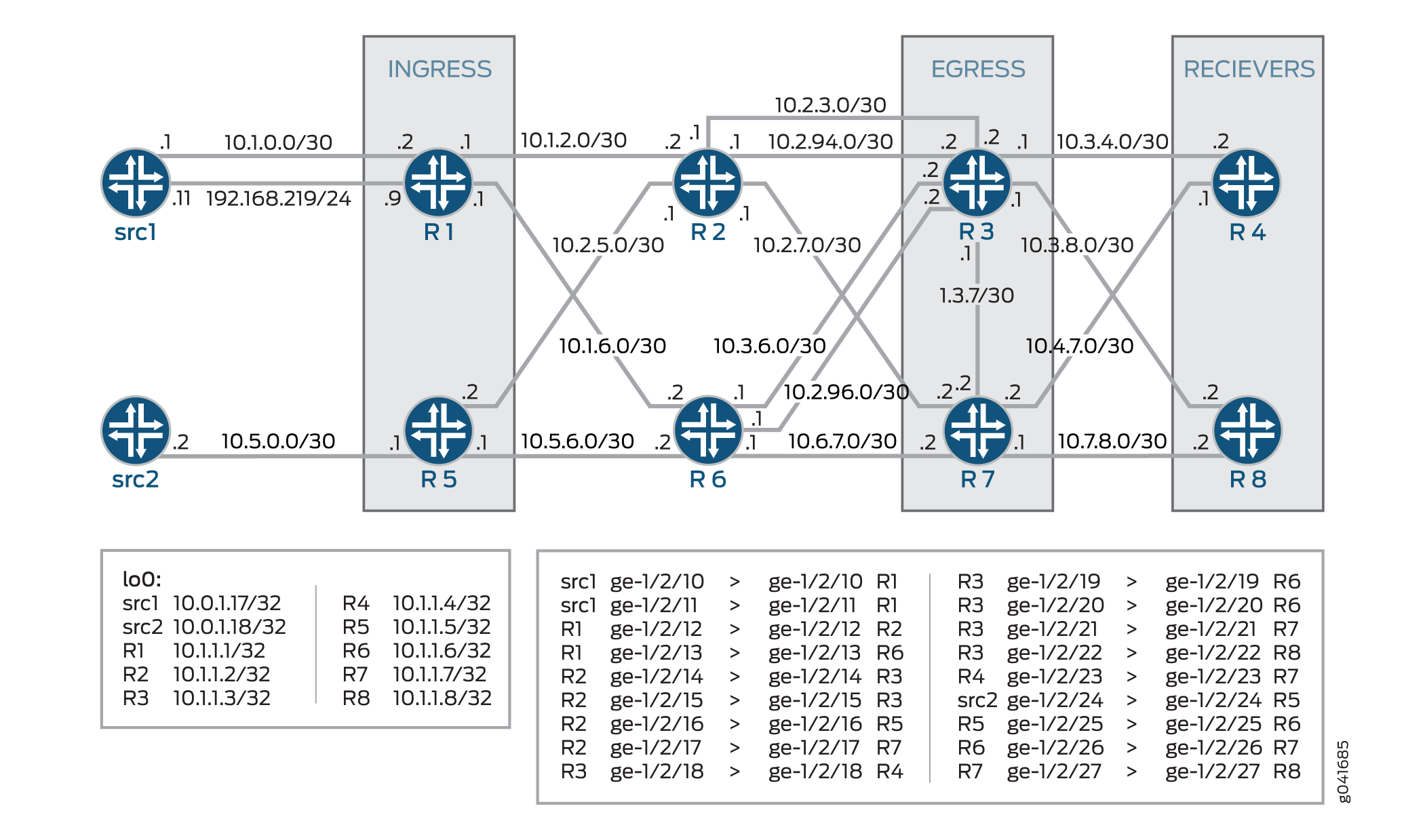

In diesem Beispiel wird gezeigt, wie die längste Übereinstimmung für LDP basierend auf RFC5283konfiguriert wird. Dies ermöglicht es LDP, die Routen aggregiert oder zusammengefasst über OSPF-Bereiche oder ISIS-Ebenen in Inter-Domain zu lernen. Die längste Übereinstimmungsrichtlinie bietet Granularität pro Präfix.

Anforderungen

In diesem Beispiel werden die folgenden Hardware- und Softwarekomponenten verwendet:

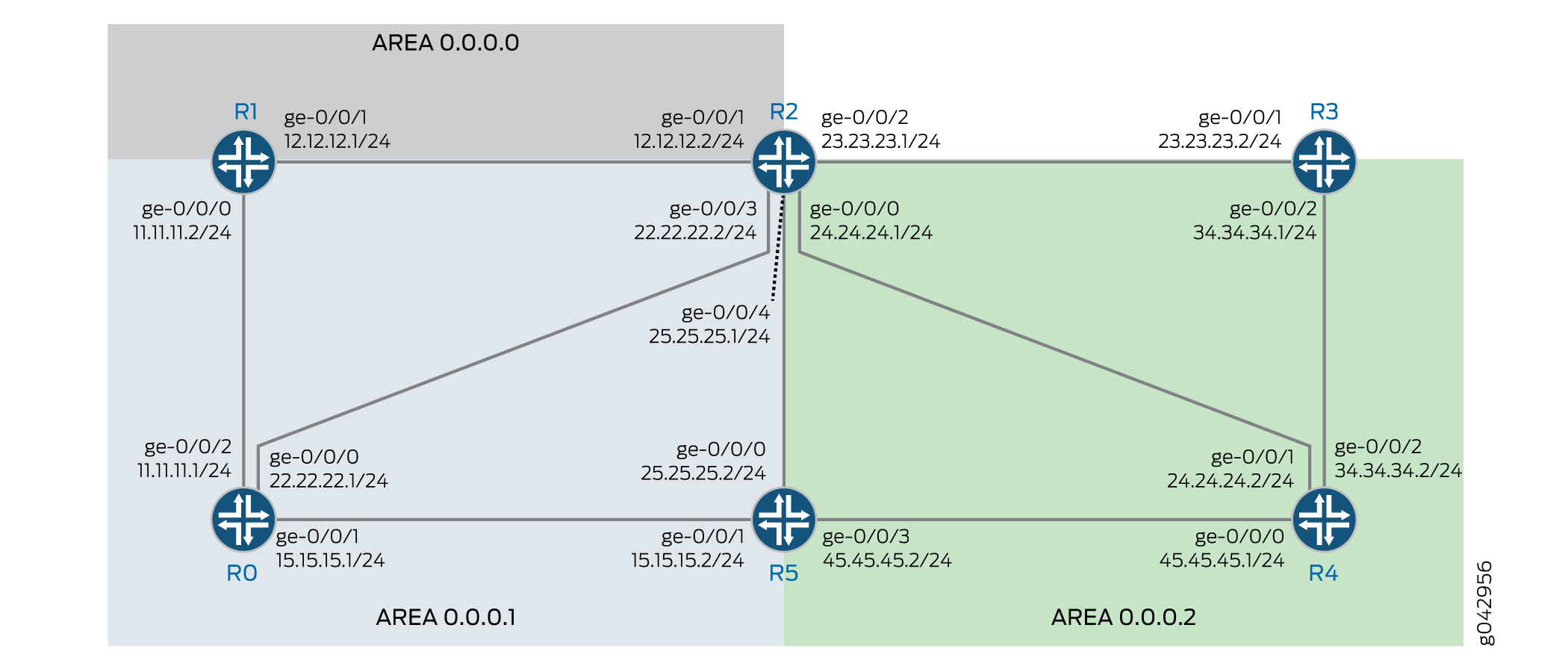

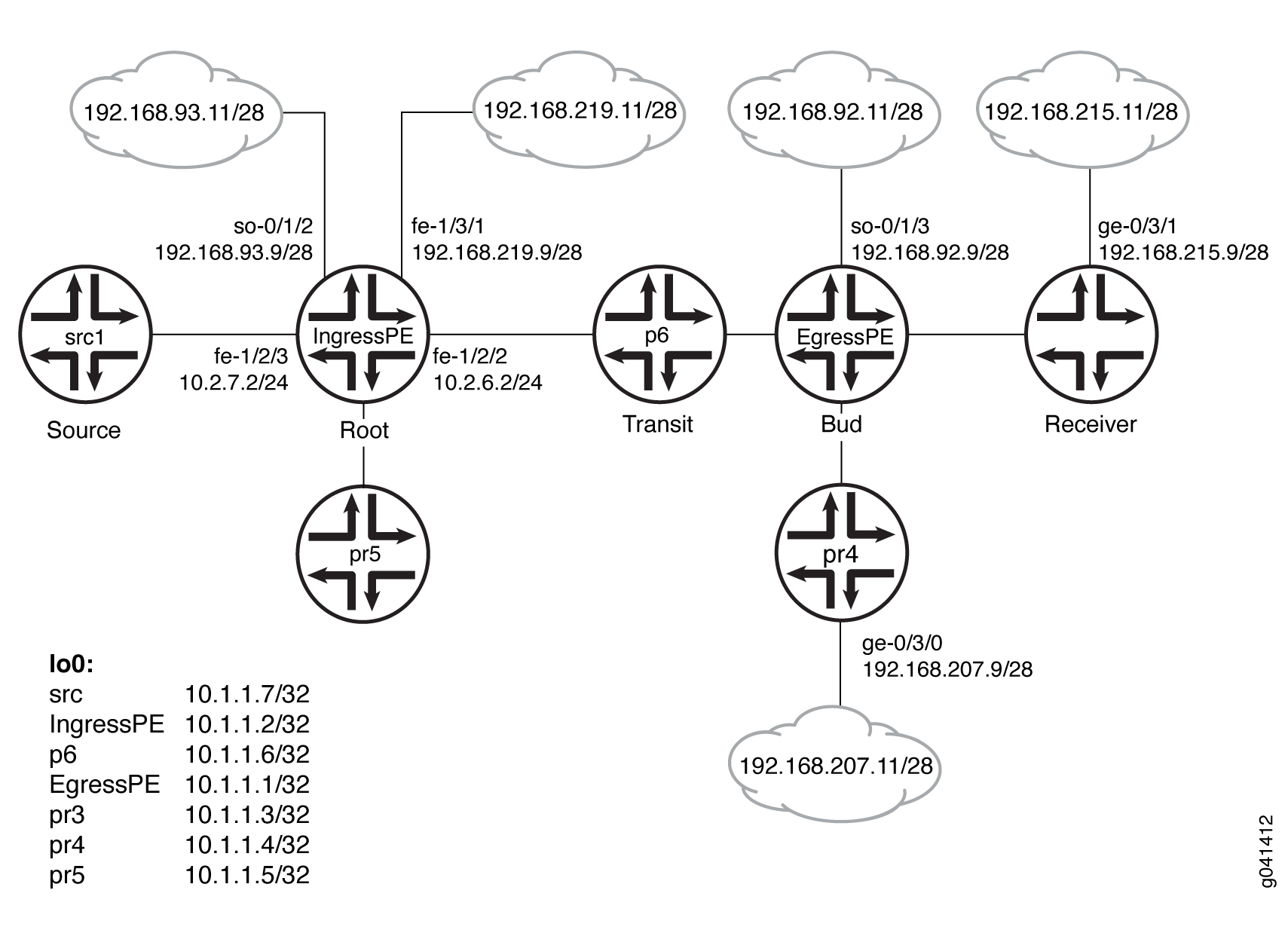

Sechs Router der MX-Serie mit OSPF-Protokoll und LDP-aktiviert auf den angeschlossenen Schnittstellen.

Junos OS, Version 16.1 oder höher, läuft auf allen Geräten.

Bevor Sie beginnen:

Konfigurieren Sie die Geräteschnittstellen.

Konfigurieren Sie OSPF.

Überblick

LDP wird häufig verwendet, um MPLS Label-Switched Paths (LSPs) in einer gesamten Netzwerkdomäne mithilfe eines IGP wie OSPF oder IS-IS einzurichten. In einem solchen Netzwerk haben alle Links in der Domäne sowohl IGP-Nachbarschaften als auch LDP-Nachbarschaften. LDP richtet die Sprachdienstleister auf dem kürzesten Weg zu einem Ziel ein, das durch die IP-Weiterleitung bestimmt wird. In Junos OS führt die LDP-Implementierung eine Suche nach exakten Übereinstimmungen der IP-Adresse des FEC in den RIB- oder IGP-Routen für die Label-Zuordnung durch. Für diese exakte Zuordnung müssen in allen LERs MPLS-End-to-End-LDP-Endpunkt-IP-Adressen konfiguriert werden. Dies vereitelt den Zweck des hierarchischen IP-Designs oder des Standard-Routings in Zugriffsgeräten. Die Konfiguration longest-match hilft, dieses Problem zu überwinden, indem das exakte Übereinstimmungsverhalten unterdrückt und LSP basierend auf der längsten übereinstimmenden Route pro Präfix eingerichtet wird.

Topologie

Zeigt in der Topologie an, Abbildung 1dass die längste Übereinstimmung für LDP auf Gerät R0 konfiguriert ist.

Konfiguration

CLI-Schnellkonfiguration

Um dieses Beispiel schnell zu konfigurieren, kopieren Sie die folgenden Befehle, fügen Sie sie in eine Textdatei ein, entfernen Sie alle Zeilenumbrüche, ändern Sie alle Details, die für Ihre Netzwerkkonfiguration erforderlich sind, kopieren Sie die Befehle und fügen Sie sie in die CLI auf Hierarchieebene ein, und geben Sie sie dann aus dem [edit] Konfigurationsmodus ein commit .

R0

set interfaces ge-0/0/0 unit 0 family inet address 22.22.22.1/24 set interfaces ge-0/0/1 unit 0 family inet address 15.15.15.1/24 set interfaces ge-0/0/2 unit 0 family inet address 11.11.11.1/24 set interfaces ge-0/0/2 unit 0 family iso set interfaces ge-0/0/2 unit 0 family mpls set interfaces lo0 unit 0 family inet address 10.255.112.1/32 primary set interfaces lo0 unit 0 family inet address 10.255.112.1/32 preferred set interfaces lo0 unit 0 family iso address 49.0002.0192.0168.0001.00 set routing-options router-id 10.255.112.1 set protocols mpls interface ge-0/0/2.0 set protocols ospf area 0.0.0.1 interface ge-0/0/2.0 set protocols ospf area 0.0.0.1 interface lo0.0 passive set protocols ldp longest-match set protocols ldp interface ge-0/0/2.0 set protocols ldp interface lo0.0

R1

set interfaces ge-0/0/0 unit 0 family inet address 11.11.11.2/24 set interfaces ge-0/0/0 unit 0 family iso set interfaces ge-0/0/0 unit 0 family mpls set interfaces ge-0/0/1 unit 0 family inet address 12.12.12.1/24 set interfaces ge-0/0/1 unit 0 family iso set interfaces ge-0/0/1 unit 0 family mpls set interfaces lo0 unit 0 family inet address 10.255.112.2/32 primary set interfaces lo0 unit 0 family inet address 10.255.112.2/32 preferred set interfaces lo0 unit 0 family iso address 49.0002.0192.0168.0002.00 set routing-options router-id 10.255.112.2 set protocols mpls interface ge-0/0/0.0 set protocols mpls interface ge-0/0/1.0 set protocols ospf area 0.0.0.0 interface ge-0/0/1.0 set protocols ospf area 0.0.0.0 interface lo0.0 passive set protocols ospf area 0.0.0.1 interface ge-0/0/0.0 set protocols ldp longest-match set protocols ldp interface ge-0/0/0.0 set protocols ldp interface ge-0/0/1.0 set protocols ldp interface lo0.0

R2

set interfaces ge-0/0/0 unit 0 family inet address 24.24.24.1/24 set interfaces ge-0/0/0 unit 0 family iso set interfaces ge-0/0/0 unit 0 family mpls set interfaces ge-0/0/1 unit 0 family inet address 12.12.12.2/24 set interfaces ge-0/0/1 unit 0 family iso set interfaces ge-0/0/1 unit 0 family mpls set interfaces ge-0/0/2 unit 0 family inet address 23.23.23.1/24 set interfaces ge-0/0/2 unit 0 family iso set interfaces ge-0/0/2 unit 0 family mpls set interfaces ge-0/0/3 unit 0 family inet address 22.22.22.2/24 set interfaces ge-0/0/4 unit 0 family inet address 25.25.25.1/24 set interfaces ge-0/0/4 unit 0 family iso set interfaces ge-0/0/4 unit 0 family mpls set interfaces lo0 unit 0 family inet address 10.255.111.4/32 primary set interfaces lo0 unit 0 family inet address 10.255.111.4/32 preferred set interfaces lo0 unit 0 family iso address 49.0003.0192.0168.0003.00 set routing-options router-id 10.255.111.4 set protocols mpls interface ge-0/0/1.0 set protocols mpls interface ge-0/0/2.0 set protocols mpls interface ge-0/0/0.0 set protocols mpls interface ge-0/0/4.0 set protocols ospf area 0.0.0.0 interface ge-0/0/1.0 set protocols ospf area 0.0.0.0 interface lo0.0 passive set protocols ospf area 0.0.0.2 area-range 10.255.111.0/24 set protocols ospf area 0.0.0.2 interface ge-0/0/2.0 set protocols ospf area 0.0.0.2 interface ge-0/0/0.0 set protocols ospf area 0.0.0.2 interface ge-0/0/4.0 set protocols ldp interface ge-0/0/0.0 set protocols ldp interface ge-0/0/1.0 set protocols ldp interface ge-0/0/2.0 set protocols ldp interface ge-0/0/4.0 set protocols ldp interface lo0.0

R3

set interfaces ge-0/0/0 unit 0 family inet address 35.35.35.1/24 set interfaces ge-0/0/0 unit 0 family iso set interfaces ge-0/0/0 unit 0 family mpls set interfaces ge-0/0/1 unit 0 family inet address 23.23.23.2/24 set interfaces ge-0/0/1 unit 0 family iso set interfaces ge-0/0/1 unit 0 family mpls set interfaces ge-0/0/2 unit 0 family inet address 34.34.34.1/24 set interfaces ge-0/0/2 unit 0 family iso set interfaces ge-0/0/2 unit 0 family mpls set interfaces lo0 unit 0 family inet address 10.255.111.1/32 primary set interfaces lo0 unit 0 family inet address 10.255.111.1/32 preferred set interfaces lo0 unit 0 family iso address 49.0003.0192.0168.0004.00 set routing-options router-id 10.255.111.1 set protocols mpls interface ge-0/0/1.0 set protocols ospf area 0.0.0.2 interface ge-0/0/1.0 set protocols ospf area 0.0.0.2 interface fxp0.0 disable set protocols ospf area 0.0.0.2 interface lo0.0 passive set protocols ldp interface ge-0/0/1.0 set protocols ldp interface lo0.0

R4

set interfaces ge-0/0/0 unit 0 family inet address 45.45.45.1/24 set interfaces ge-0/0/0 unit 0 family iso set interfaces ge-0/0/0 unit 0 family mpls set interfaces ge-0/0/1 unit 0 family inet address 24.24.24.2/24 set interfaces ge-0/0/1 unit 0 family iso set interfaces ge-0/0/1 unit 0 family mpls set interfaces ge-0/0/2 unit 0 family inet address 34.34.34.2/24 set interfaces ge-0/0/2 unit 0 family iso set interfaces ge-0/0/2 unit 0 family mpls set interfaces lo0 unit 0 family inet address 10.255.111.2/32 primary set interfaces lo0 unit 0 family inet address 10.255.111.2/32 preferred set interfaces lo0 unit 0 family iso address 49.0003.0192.0168.0005.00 set routing-options router-id 10.255.111.2 set protocols mpls interface ge-0/0/1.0 set protocols ospf area 0.0.0.2 interface ge-0/0/1.0 set protocols ospf area 0.0.0.2 interface fxp0.0 disable set protocols ospf area 0.0.0.2 interface lo0.0 passive set protocols ldp interface ge-0/0/1.0 set protocols ldp interface lo0.0

R5

set interfaces ge-0/0/0 unit 0 family inet address 25.25.25.2/24 set interfaces ge-0/0/0 unit 0 family iso set interfaces ge-0/0/0 unit 0 family mpls set interfaces ge-0/0/1 unit 0 family inet address 15.15.15.2/24 set interfaces ge-0/0/2 unit 0 family inet address 35.35.35.2/24 set interfaces ge-0/0/3 unit 0 family inet address 45.45.45.2/24 set interfaces ge-0/0/3 unit 0 family iso set interfaces ge-0/0/3 unit 0 family mpls set interfaces lo0 unit 0 family inet address 10.255.111.3/32 primary set interfaces lo0 unit 0 family inet address 10.255.111.3/32 preferred set interfaces lo0 unit 0 family iso address 49.0003.0192.0168.0006.00 set routing-options router-id 10.255.111.3 set protocols mpls interface ge-0/0/0.0 set protocols ospf area 0.0.0.2 interface ge-0/0/0.0 set protocols ospf area 0.0.0.2 interface fxp0.0 disable set protocols ospf area 0.0.0.2 interface lo0.0 passive set protocols ldp interface ge-0/0/0.0 set protocols ldp interface lo0.0

Konfigurieren des Geräts R0

Schritt-für-Schritt-Anleitung

Im folgenden Beispiel müssen Sie durch verschiedene Ebenen in der Konfigurationshierarchie navigieren. Weitere Informationen zum Navigieren in der CLI finden Sie unter Verwenden des CLI-Editors im Konfigurationsmodus im CLI-Benutzerhandbuch.

So konfigurieren Sie Gerät R0:

Konfigurieren Sie die Schnittstellen.

[edit interfaces] set ge-0/0/0 unit 0 family inet address 22.22.22.1/24 set ge-0/0/1 unit 0 family inet address 15.15.15.1/24 set ge-0/0/2 unit 0 family inet address 11.11.11.1/24 set ge-0/0/2 unit 0 family iso set ge-0/0/2 unit 0 family mpls

Weisen Sie dem Gerät die Loopback-Adressen zu.

[edit interfaces lo0 unit 0 family] set inet address 10.255.112.1/32 primary set inet address 10.255.112.1/32 preferred set iso address 49.0002.0192.0168.0001.00

Konfigurieren Sie die Router-ID.

[edit routing-options] set router-id 10.255.112.1

Konfigurieren Sie das MPLS-Protokoll auf der Schnittstelle.

[edit protocols mpls] set interface ge-0/0/2.0

Konfigurieren Sie das OSPF-Protokoll auf der Schnittstelle.

[edit protocols ospf] set area 0.0.0.1 interface ge-0/0/2.0 set area 0.0.0.1 interface lo0.0 passive

Konfigurieren Sie die längste Übereinstimmung für das LDP-Protokoll.

[edit protocols ldp] set longest-match

Konfigurieren Sie das LDP-Protokoll auf der Schnittstelle.

[edit protocols ldp] set interface ge-0/0/2.0 set interface lo0.0

Ergebnisse

Bestätigen Sie im Konfigurationsmodus Ihre Konfiguration, indem Sie die show interfacesBefehle , show protocolsund show routing-options eingeben. Wenn die Ausgabe nicht die gewünschte Konfiguration anzeigt, wiederholen Sie die Anweisungen in diesem Beispiel, um die Konfiguration zu korrigieren.

user@R0# show interfaces

ge-0/0/0 {

unit 0 {

family inet {

address 22.22.22.1/24;

}

}

}

ge-0/0/1 {

unit 0 {

family inet {

address 15.15.15.1/24;

}

}

}

ge-0/0/2 {

unit 0 {

family inet {

address 11.11.11.1/24;

}

family iso;

family mpls;

}

}

lo0 {

unit 0 {

family inet {

address 10.255.112.1/32 {

primary;

preferred;

}

}

family iso {

address 49.0002.0192.0168.0001.00;

}

}

}

user@R0# show protocols

mpls {

interface ge-0/0/2.0;

}

ospf {

area 0.0.0.1 {

interface ge-0/0/2.0;

interface lo0.0 {

passive;

}

}

}

ldp {

longest-match;

interface ge-0/0/2.0;

interface lo0.0;

}

user@R0# show routing-options router-id 10.255.112.1;

Wenn Sie mit der Konfiguration des Geräts fertig sind, geben Sie es im Konfigurationsmodus ein commit .

Verifizierung

Vergewissern Sie sich, dass die Konfiguration ordnungsgemäß funktioniert.

- Verifizieren der Routen

- Überprüfen der LDP-Übersichtsinformationen

- Überprüfen Sie die LDP-Einträge in der internen Topologietabelle

- Überprüfen Sie nur die FEC-Informationen der LDP-Route

- FEC- und Schattenrouten von LDP verifizieren

Verifizieren der Routen

Zweck

Stellen Sie sicher, dass die erwarteten Routen gelernt wurden.

Action!

Führen Sie auf Gerät R0 im Betriebsmodus den show route Befehl aus, um die Routen in der Routing-Tabelle anzuzeigen.

user@R0> show route

inet.0: 62 destinations, 62 routes (62 active, 0 holddown, 0 hidden)

+ = Active Route, - = Last Active, * = Both

10.4.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.5.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.6.128.0/17 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.9.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.10.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.13.4.0/23 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.13.10.0/23 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.82.0.0/15 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.84.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.85.12.0/22 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.92.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.92.16.0/20 *[Direct/0] 10:08:01

> via fxp0.0

10.92.20.175/32 *[Local/0] 10:08:01

Local via fxp0.0

10.94.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.99.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.102.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.150.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.155.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.157.64.0/19 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.160.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.204.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.205.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.206.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.207.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.209.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.212.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.213.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.214.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.215.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.216.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.218.13.0/24 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.218.14.0/24 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.218.16.0/20 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.218.32.0/20 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.227.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.255.111.0/24 *[OSPF/10] 09:52:14, metric 3

> to 11.11.11.2 via ge-0/0/2.0

10.255.111.4/32 *[OSPF/10] 09:54:10, metric 2

> to 11.11.11.2 via ge-0/0/2.0

10.255.112.1/32 *[Direct/0] 09:55:05

> via lo0.0

10.255.112.2/32 *[OSPF/10] 09:54:18, metric 1

> to 11.11.11.2 via ge-0/0/2.0

11.11.11.0/24 *[Direct/0] 09:55:05

> via ge-0/0/2.0

11.11.11.1/32 *[Local/0] 09:55:05

Local via ge-0/0/2.0

12.12.12.0/24 *[OSPF/10] 09:54:18, metric 2

> to 11.11.11.2 via ge-0/0/2.0

15.15.15.0/24 *[Direct/0] 09:55:05

> via ge-0/0/1.0

15.15.15.1/32 *[Local/0] 09:55:05

Local via ge-0/0/1.0

22.22.22.0/24 *[Direct/0] 09:55:05

> via ge-0/0/0.0

22.22.22.1/32 *[Local/0] 09:55:05

Local via ge-0/0/0.0

23.23.23.0/24 *[OSPF/10] 09:54:10, metric 3

> to 11.11.11.2 via ge-0/0/2.0

24.24.24.0/24 *[OSPF/10] 09:54:10, metric 3

> to 11.11.11.2 via ge-0/0/2.0

25.25.25.0/24 *[OSPF/10] 09:54:10, metric 3

> to 11.11.11.2 via ge-0/0/2.0

128.92.17.45/32 *[OSPF/10] 09:54:05, metric 3

> to 11.11.11.2 via ge-0/0/2.0

128.92.20.175/32 *[Direct/0] 10:08:01

> via lo0.0

128.92.21.186/32 *[OSPF/10] 09:54:10, metric 3

> to 11.11.11.2 via ge-0/0/2.0

128.92.25.135/32 *[OSPF/10] 09:54:10, metric 3

> to 11.11.11.2 via ge-0/0/2.0

128.92.27.91/32 *[OSPF/10] 09:54:18, metric 1

> to 11.11.11.2 via ge-0/0/2.0

128.92.28.70/32 *[OSPF/10] 09:54:10, metric 2

> to 11.11.11.2 via ge-0/0/2.0

172.16.0.0/12 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

192.168.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

192.168.102.0/23 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

207.17.136.0/24 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

207.17.136.192/32 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

207.17.137.0/24 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

224.0.0.5/32 *[OSPF/10] 09:55:05, metric 1

MultiRecv

inet.3: 5 destinations, 5 routes (5 active, 0 holddown, 0 hidden)

+ = Active Route, - = Last Active, * = Both

10.255.111.1/32 *[LDP/9] 09:41:03, metric 3

> to 11.11.11.2 via ge-0/0/2.0, Push 300128

10.255.111.2/32 *[LDP/9] 09:41:03, metric 3

> to 11.11.11.2 via ge-0/0/2.0, Push 300144

10.255.111.3/32 *[LDP/9] 09:41:03, metric 3

> to 11.11.11.2 via ge-0/0/2.0, Push 300160

10.255.111.4/32 *[LDP/9] 09:54:10, metric 2, tag 0

> to 11.11.11.2 via ge-0/0/2.0, Push 300000

10.255.112.2/32 *[LDP/9] 09:54:48, metric 1, tag 0

> to 11.11.11.2 via ge-0/0/2.0

iso.0: 2 destinations, 2 routes (2 active, 0 holddown, 0 hidden)

+ = Active Route, - = Last Active, * = Both

47.0005.80ff.f800.0000.0108.0001.1280.9202.0175/152

*[Direct/0] 10:08:01

> via lo0.0

49.0002.0192.0168.0001/72

*[Direct/0] 09:55:05

> via lo0.0

mpls.0: 10 destinations, 10 routes (10 active, 0 holddown, 0 hidden)

+ = Active Route, - = Last Active, * = Both

0 *[MPLS/0] 09:55:05, metric 1

Receive

1 *[MPLS/0] 09:55:05, metric 1

Receive

2 *[MPLS/0] 09:55:05, metric 1

Receive

13 *[MPLS/0] 09:55:05, metric 1

Receive

300064 *[LDP/9] 09:54:48, metric 1

> to 11.11.11.2 via ge-0/0/2.0, Pop

300064(S=0) *[LDP/9] 09:54:48, metric 1

> to 11.11.11.2 via ge-0/0/2.0, Pop

300112 *[LDP/9] 09:54:10, metric 2, tag 0

> to 11.11.11.2 via ge-0/0/2.0, Swap 300000

300192 *[LDP/9] 09:41:03, metric 3

> to 11.11.11.2 via ge-0/0/2.0, Swap 300128

300208 *[LDP/9] 09:41:03, metric 3

> to 11.11.11.2 via ge-0/0/2.0, Swap 300144

300224 *[LDP/9] 09:41:03, metric 3

> to 11.11.11.2 via ge-0/0/2.0, Swap 300160

inet6.0: 2 destinations, 2 routes (2 active, 0 holddown, 0 hidden)

+ = Active Route, - = Last Active, * = Both

abcd::128:92:20:175/128

*[Direct/0] 10:08:01

> via lo0.0

fe80::5668:a50f:fcc1:1f9c/128

*[Direct/0] 10:08:01

> via lo0.0

Bedeutung

Die Ausgabe zeigt alle Routen in der Routing-Tabelle des Geräts R0 an.

Überprüfen der LDP-Übersichtsinformationen

Zweck

LDP-Übersichtsinformationen anzeigen.

Action!

Führen Sie auf Gerät R0 im Betriebsmodus den show ldp overview Befehl aus, um die Übersicht über das LDP anzuzeigen.

user@R0> show ldp overview

Instance: master

Reference count: 2

Router ID: 10.255.112.1

Message id: 8

Configuration sequence: 6

Deaggregate: disabled

Explicit null: disabled

IPv6 tunneling: disabled

Strict targeted hellos: disabled

Loopback if added: yes

Route preference: 9

Unicast transit LSP chaining: disabled

P2MP transit LSP chaining: disabled

Transit LSP statistics based on route statistics: disabled

LDP route acknowledgement: enabled

LDP mtu discovery: disabled

Longest Match: enabled

Capabilities enabled: none

Egress FEC capabilities enabled: entropy-label-capability

Downstream unsolicited Sessions:

Operational: 1

Retention: liberal

Control: ordered

Auto targeted sessions:

Auto targeted: disabled

Timers:

Keepalive interval: 10, Keepalive timeout: 30

Link hello interval: 5, Link hello hold time: 15

Targeted hello interval: 15, Targeted hello hold time: 45

Label withdraw delay: 60, Make before break timeout: 30

Make before break switchover delay: 3

Link protection timeout: 120

Graceful restart:

Restart: disabled, Helper: enabled, Restart in process: false

Reconnect time: 60000, Max neighbor reconnect time: 120000

Recovery time: 160000, Max neighbor recovery time: 240000

Traffic Engineering:

Bgp igp: disabled

Both ribs: disabled

Mpls forwarding: disabled

IGP:

Tracking igp metric: disabled

Sync session up delay: 10

Session protection:

Session protection: disabled

Session protection timeout: 0

Interface addresses advertising:

11.11.11.1

10.255.112.1

128.92.20.175

Label allocation:

Current number of LDP labels allocated: 5

Total number of LDP labels allocated: 11

Total number of LDP labels freed: 6

Total number of LDP label allocation failure: 0

Current number of labels allocated by all protocols: 5

Bedeutung

Die Ausgabe zeigt die LDP-Übersichtsinformationen des Geräts R0 an

Überprüfen Sie die LDP-Einträge in der internen Topologietabelle

Zweck

Zeigen Sie die Routeneinträge in der internen Topologietabelle des Label Distribution Protocol (LDP) an.

Action!

Führen Sie auf Gerät R0 im Betriebsmodus den show ldp route Befehl aus, um die interne Topologietabelle von LDP anzuzeigen.

user@R0> show ldp route

Destination Next-hop intf/lsp/table Next-hop address

10.4.0.0/16 fxp0.0 10.92.31.254

10.5.0.0/16 fxp0.0 10.92.31.254

10.6.128.0/17 fxp0.0 10.92.31.254

10.9.0.0/16 fxp0.0 10.92.31.254

10.10.0.0/16 fxp0.0 10.92.31.254

10.13.4.0/23 fxp0.0 10.92.31.254

10.13.10.0/23 fxp0.0 10.92.31.254

10.82.0.0/15 fxp0.0 10.92.31.254

10.84.0.0/16 fxp0.0 10.92.31.254

10.85.12.0/22 fxp0.0 10.92.31.254

10.92.0.0/16 fxp0.0 10.92.31.254

10.92.16.0/20 fxp0.0

10.92.20.175/32

10.94.0.0/16 fxp0.0 10.92.31.254

10.99.0.0/16 fxp0.0 10.92.31.254

10.102.0.0/16 fxp0.0 10.92.31.254

10.150.0.0/16 fxp0.0 10.92.31.254

10.155.0.0/16 fxp0.0 10.92.31.254

10.157.64.0/19 fxp0.0 10.92.31.254

10.160.0.0/16 fxp0.0 10.92.31.254

10.204.0.0/16 fxp0.0 10.92.31.254

10.205.0.0/16 fxp0.0 10.92.31.254

10.206.0.0/16 fxp0.0 10.92.31.254

10.207.0.0/16 fxp0.0 10.92.31.254

10.209.0.0/16 fxp0.0 10.92.31.254

10.212.0.0/16 fxp0.0 10.92.31.254

10.213.0.0/16 fxp0.0 10.92.31.254

10.214.0.0/16 fxp0.0 10.92.31.254

10.215.0.0/16 fxp0.0 10.92.31.254

10.216.0.0/16 fxp0.0 10.92.31.254

10.218.13.0/24 fxp0.0 10.92.31.254

10.218.14.0/24 fxp0.0 10.92.31.254

10.218.16.0/20 fxp0.0 10.92.31.254

10.218.32.0/20 fxp0.0 10.92.31.254

10.227.0.0/16 fxp0.0 10.92.31.254

10.255.111.0/24 ge-0/0/2.0 11.11.11.2

10.255.111.4/32 ge-0/0/2.0 11.11.11.2

10.255.112.1/32 lo0.0

10.255.112.2/32 ge-0/0/2.0 11.11.11.2

11.11.11.0/24 ge-0/0/2.0

11.11.11.1/32

12.12.12.0/24 ge-0/0/2.0 11.11.11.2

15.15.15.0/24 ge-0/0/1.0

15.15.15.1/32

22.22.22.0/24 ge-0/0/0.0

22.22.22.1/32

23.23.23.0/24 ge-0/0/2.0 11.11.11.2

24.24.24.0/24 ge-0/0/2.0 11.11.11.2

25.25.25.0/24 ge-0/0/2.0 11.11.11.2

128.92.17.45/32 ge-0/0/2.0 11.11.11.2

128.92.20.175/32 lo0.0

128.92.21.186/32 ge-0/0/2.0 11.11.11.2

128.92.25.135/32 ge-0/0/2.0 11.11.11.2

128.92.27.91/32 ge-0/0/2.0 11.11.11.2

128.92.28.70/32 ge-0/0/2.0 11.11.11.2

172.16.0.0/12 fxp0.0 10.92.31.254

192.168.0.0/16 fxp0.0 10.92.31.254

192.168.102.0/23 fxp0.0 10.92.31.254

207.17.136.0/24 fxp0.0 10.92.31.254

207.17.136.192/32 fxp0.0 10.92.31.254

207.17.137.0/24 fxp0.0 10.92.31.254

224.0.0.5/32

Bedeutung

Die Ausgabe zeigt die Routeneinträge in der internen Topologietabelle des Label Distribution Protocol (LDP) von Gerät R0 an.

Überprüfen Sie nur die FEC-Informationen der LDP-Route

Zweck

Zeigt nur die FEC-Informationen der LDP-Route an.

Action!

Führen Sie auf Gerät R0 im Betriebsmodus den show ldp route fec-only Befehl aus, um die Routen in der Routing-Tabelle anzuzeigen.

user@R0> show ldp route fec-only

Destination Next-hop intf/lsp/table Next-hop address

10.255.111.1/32 ge-0/0/2.0 11.11.11.2

10.255.111.2/32 ge-0/0/2.0 11.11.11.2

10.255.111.3/32 ge-0/0/2.0 11.11.11.2

10.255.111.4/32 ge-0/0/2.0 11.11.11.2

10.255.112.1/32 lo0.0

10.255.112.2/32 ge-0/0/2.0 11.11.11.2

Bedeutung

In der Ausgabe werden nur die FEC-Routen des LDP-Protokolls angezeigt, die für Gerät R0 verfügbar sind.

FEC- und Schattenrouten von LDP verifizieren

Zweck

Zeigen Sie den FEC und die Schattenrouten in der Routing-Tabelle an.

Action!

Führen Sie auf Gerät R0 im Betriebsmodus den show ldp route fec-and-route Befehl aus, um die FEC- und Schattenrouten in der Routing-Tabelle anzuzeigen.

user@R0> show ldp route fec-and-route

Destination Next-hop intf/lsp/table Next-hop address

10.4.0.0/16 fxp0.0 10.92.31.254

10.5.0.0/16 fxp0.0 10.92.31.254

10.6.128.0/17 fxp0.0 10.92.31.254

10.9.0.0/16 fxp0.0 10.92.31.254

10.10.0.0/16 fxp0.0 10.92.31.254

10.13.4.0/23 fxp0.0 10.92.31.254

10.13.10.0/23 fxp0.0 10.92.31.254

10.82.0.0/15 fxp0.0 10.92.31.254

10.84.0.0/16 fxp0.0 10.92.31.254

10.85.12.0/22 fxp0.0 10.92.31.254

10.92.0.0/16 fxp0.0 10.92.31.254

10.92.16.0/20 fxp0.0

10.92.20.175/32

10.94.0.0/16 fxp0.0 10.92.31.254

10.99.0.0/16 fxp0.0 10.92.31.254

10.102.0.0/16 fxp0.0 10.92.31.254

10.150.0.0/16 fxp0.0 10.92.31.254

10.155.0.0/16 fxp0.0 10.92.31.254

10.157.64.0/19 fxp0.0 10.92.31.254

10.160.0.0/16 fxp0.0 10.92.31.254

10.204.0.0/16 fxp0.0 10.92.31.254

10.205.0.0/16 fxp0.0 10.92.31.254

10.206.0.0/16 fxp0.0 10.92.31.254

10.207.0.0/16 fxp0.0 10.92.31.254

10.209.0.0/16 fxp0.0 10.92.31.254

10.212.0.0/16 fxp0.0 10.92.31.254

10.213.0.0/16 fxp0.0 10.92.31.254

10.214.0.0/16 fxp0.0 10.92.31.254

10.215.0.0/16 fxp0.0 10.92.31.254

10.216.0.0/16 fxp0.0 10.92.31.254

10.218.13.0/24 fxp0.0 10.92.31.254

10.218.14.0/24 fxp0.0 10.92.31.254

10.218.16.0/20 fxp0.0 10.92.31.254

10.218.32.0/20 fxp0.0 10.92.31.254

10.227.0.0/16 fxp0.0 10.92.31.254

10.255.111.0/24 ge-0/0/2.0 11.11.11.2

10.255.111.1/32 ge-0/0/2.0 11.11.11.2

10.255.111.2/32 ge-0/0/2.0 11.11.11.2

10.255.111.3/32 ge-0/0/2.0 11.11.11.2

10.255.111.4/32 ge-0/0/2.0 11.11.11.2

10.255.111.4/32 ge-0/0/2.0 11.11.11.2

10.255.112.1/32 lo0.0

10.255.112.1/32 lo0.0

10.255.112.2/32 ge-0/0/2.0 11.11.11.2

10.255.112.2/32 ge-0/0/2.0 11.11.11.2

11.11.11.0/24 ge-0/0/2.0

11.11.11.1/32

12.12.12.0/24 ge-0/0/2.0 11.11.11.2

15.15.15.0/24 ge-0/0/1.0

15.15.15.1/32

22.22.22.0/24 ge-0/0/0.0

22.22.22.1/32

23.23.23.0/24 ge-0/0/2.0 11.11.11.2

24.24.24.0/24 ge-0/0/2.0 11.11.11.2

25.25.25.0/24 ge-0/0/2.0 11.11.11.2

128.92.17.45/32 ge-0/0/2.0 11.11.11.2

128.92.20.175/32 lo0.0

128.92.21.186/32 ge-0/0/2.0 11.11.11.2

128.92.25.135/32 ge-0/0/2.0 11.11.11.2

128.92.27.91/32 ge-0/0/2.0 11.11.11.2

128.92.28.70/32 ge-0/0/2.0 11.11.11.2

172.16.0.0/12 fxp0.0 10.92.31.254

192.168.0.0/16 fxp0.0 10.92.31.254

192.168.102.0/23 fxp0.0 10.92.31.254

207.17.136.0/24 fxp0.0 10.92.31.254

207.17.136.192/32 fxp0.0 10.92.31.254

207.17.137.0/24 fxp0.0 10.92.31.254

224.0.0.5/32

Bedeutung

Die Ausgabe zeigt die FEC und die Schattenrouten von Gerät R0 an

LDP-Routeneinstellungen konfigurieren

Wenn mehrere Protokolle Routen zum gleichen Ziel berechnen, werden Routeneinstellungen verwendet, um auszuwählen, welche Route in der Weiterleitungstabelle installiert wird. Die Route mit dem niedrigsten Präferenzwert wird ausgewählt. Der Voreinstellungswert kann eine Zahl im Bereich von 0 bis 255 sein. Standardmäßig haben LDP-Routen den Präferenzwert 9.

Um die Routeneinstellungen zu ändern, fügen Sie die preference folgende Anweisung ein:

preference preference;

Eine Liste der Hierarchieebenen, auf denen Sie diese Anweisung einschließen können, finden Sie im Abschnitt Anweisungszusammenfassung für diese Anweisung.

LDP Graceful-Restart

Der LDP-Graceful-Restart ermöglicht es einem Router, dessen LDP-Steuerungsebene neu gestartet wird, weiterhin den Datenverkehr weiterzuleiten und gleichzeitig seinen Status von benachbarten Routern wiederherzustellen. Außerdem wird ein Router, auf dem der Hilfsmodus aktiviert ist, aktiviert, um einen benachbarten Router zu unterstützen, der versucht, LDP neu zu starten.

Während der Sitzungsinitialisierung kündigt ein Router seine Fähigkeit an, einen ordnungsgemäßen LDP-Neustart durchzuführen oder einen Nachbarn zu nutzen, der einen ordnungsgemäßen LDP-Neustart durchführt, indem er die TLV für den ordnungsgemäßen Neustart sendet. Diese TLV enthält zwei Felder, die für den LDP-Graceful-Neustart relevant sind: die Zeit für die Wiederherstellung der Verbindung und die Wiederherstellungszeit. Die Werte der Wiederverbindungs- und Wiederherstellungszeiten geben die vom Router unterstützten Funktionen für einen ordnungsgemäßen Neustart an.

Wenn ein Router feststellt, dass ein benachbarter Router neu gestartet wird, wartet er bis zum Ende der Wiederherstellungszeit, bevor er versucht, die Verbindung wiederherzustellen. Die Wiederherstellungszeit ist die Zeitspanne, die ein Router darauf wartet, dass LDP ordnungsgemäß neu gestartet wird. Der Wiederherstellungszeitraum beginnt, wenn eine Initialisierungsnachricht gesendet oder empfangen wird. Dieser Zeitraum ist in der Regel auch die Zeitspanne, in der ein benachbarter Router seine Informationen über den neu startenden Router beibehält, sodass er weiterhin Datenverkehr weiterleiten kann.

Sie können den ordnungsgemäßen LDP-Neustart sowohl in der Master-Instance für das LDP-Protokoll als auch für eine bestimmte Routing-Instanz konfigurieren. Sie können den ordnungsgemäßen Neustart auf globaler Ebene für alle Protokolle, nur auf Protokollebene für LDP und für eine bestimmte Routing-Instanz deaktivieren. Der ordnungsgemäße LDP-Neustart ist standardmäßig deaktiviert, da auf globaler Ebene der ordnungsgemäße Neustart standardmäßig deaktiviert ist. Der Hilfsmodus (die Fähigkeit, einen benachbarten Router beim Versuch eines ordnungsgemäßen Neustarts zu unterstützen) ist jedoch standardmäßig aktiviert.

Im Folgenden sind einige der Verhaltensweisen aufgeführt, die mit dem ordnungsgemäßen LDP-Neustart verbunden sind:

Ausgehende Bezeichnungen werden bei Neustarts nicht beibehalten. Neue ausgehende Etiketten werden zugewiesen.

Wenn ein Router neu gestartet wird, werden keine Beschriftungszuordnungsnachrichten an Nachbarn gesendet, die einen ordnungsgemäßen Neustart unterstützen, bis sich der neu startende Router stabilisiert hat (Beschriftungszuordnungsnachrichten werden sofort an Nachbarn gesendet, die keinen ordnungsgemäßen Neustart unterstützen). Alle anderen Nachrichten (keepalive, address-message, notification und release) werden jedoch wie gewohnt gesendet. Durch das Verteilen dieser anderen Nachrichten wird verhindert, dass der Router unvollständige Informationen verteilt.

Der Hilfsmodus und der ordnungsgemäße Neustart sind unabhängig. Sie können den ordnungsgemäßen Neustart in der Konfiguration deaktivieren, dem Router aber dennoch erlauben, mit einem Nachbarn zusammenzuarbeiten, der versucht, ordnungsgemäß neu zu starten.

Konfigurieren des LDP-Graceful-Neustarts

Wenn Sie die Konfiguration für den ordnungsgemäßen Neustart auf der [edit routing-options graceful-restart] oder [edit protocols ldp graceful-restart] der Hierarchieebene ändern, wird jede laufende LDP-Sitzung automatisch neu gestartet, um die Konfiguration für den ordnungsgemäßen Neustart anzuwenden. Dieses Verhalten spiegelt das Verhalten von BGP wider, wenn Sie die Konfiguration für einen ordnungsgemäßen Neustart ändern.

Standardmäßig ist der Hilfsmodus für einen ordnungsgemäßen Neustart aktiviert, der ordnungsgemäße Neustart ist jedoch deaktiviert. Daher besteht das Standardverhalten eines Routers darin, benachbarte Router bei dem Versuch eines ordnungsgemäßen Neustarts zu unterstützen, aber nicht, selbst einen ordnungsgemäßen Neustart zu versuchen.

Informationen zum Konfigurieren des ordnungsgemäßen LDP-Neustarts finden Sie in den folgenden Abschnitten:

- Aktivieren des ordnungsgemäßen Neustarts

- Deaktivieren des LDP-Graceful-Neustarts oder des Hilfsmodus

- Konfigurieren der Wiederverbindungszeit

- Konfigurieren der Wiederherstellungszeit und der maximalen Wiederherstellungszeit

Aktivieren des ordnungsgemäßen Neustarts

Um den ordnungsgemäßen LDP-Neustart zu aktivieren, müssen Sie auch den ordnungsgemäßen Neustart auf dem Router aktivieren. Um einen ordnungsgemäßen Neustart zu ermöglichen, fügen Sie die graceful-restart folgende Anweisung ein:

graceful-restart;

Sie können diese Anweisung auf den folgenden Hierarchieebenen einbinden:

[edit routing-options][edit logical-systems logical-system-name routing-options]

Router der ACX-Serie unterstützen die Hierarchieebene [edit logical-systems logical-system-name routing-options] nicht.

Die graceful-restart Anweisung ermöglicht einen ordnungsgemäßen Neustart für alle Protokolle, die diese Funktion auf dem Router unterstützen. Weitere Informationen zum ordnungsgemäßen Neustart finden Sie in der Junos OS Routing Protocols Library for Routing Devices.

Standardmäßig ist der ordnungsgemäße LDP-Neustart aktiviert, wenn Sie den ordnungsgemäßen Neustart sowohl auf der LDP-Protokollebene als auch auf allen Routing-Instanzen aktivieren. Sie können jedoch sowohl den LDP-Graceful-Restart als auch den LDP-Helfermodus für Graceful-Restart deaktivieren.

Deaktivieren des LDP-Graceful-Neustarts oder des Hilfsmodus

Um den ordnungsgemäßen LDP-Neustart und die Wiederherstellung zu deaktivieren, fügen Sie die disable folgende Anweisung ein:

ldp {

graceful-restart {

disable;

}

}

Eine Liste der Hierarchieebenen, auf denen Sie diese Anweisung einschließen können, finden Sie im Abschnitt Anweisungszusammenfassung für diese Anweisung.

Sie können den Hilfsmodus nur auf der Ebene der LDP-Protokolle deaktivieren. Sie können den Hilfsmodus für eine bestimmte Routing-Instanz nicht deaktivieren. Um den LDP-Hilfsmodus zu deaktivieren, fügen Sie die helper-disable folgende Anweisung ein:

ldp {

graceful-restart {

helper-disable;

}

}

Eine Liste der Hierarchieebenen, auf denen Sie diese Anweisung einschließen können, finden Sie im Abschnitt Anweisungszusammenfassung für diese Anweisung.

Die folgenden LDP-Konfigurationen für einen ordnungsgemäßen Neustart sind möglich:

LDP Graceful Restart und Hilfsmodus sind beide aktiviert.

Der ordnungsgemäße LDP-Neustart ist deaktiviert, aber der Hilfsmodus ist aktiviert. Ein auf diese Weise konfigurierter Router kann nicht ordnungsgemäß neu gestartet werden, kann aber einem Nachbarn beim Neustart helfen.

Der LDP-Graceful-Restart und der Hilfsmodus sind beide deaktiviert. Der Router verwendet weder den ordnungsgemäßen LDP-Neustart noch den in der Initialisierungsnachricht gesendeten Typ, Länge und Wert (TLV) des ordnungsgemäßen Neustarts. Der Router verhält sich wie ein Router, der den ordnungsgemäßen LDP-Neustart nicht unterstützen kann.

Ein Konfigurationsfehler wird ausgegeben, wenn Sie versuchen, den ordnungsgemäßen Neustart zu aktivieren und den Hilfsmodus zu deaktivieren.

Konfigurieren der Wiederverbindungszeit

Nachdem die LDP-Verbindung zwischen Nachbarn fehlgeschlagen ist, warten die Nachbarn eine bestimmte Zeit, bis der ordnungsgemäß neu gestartete Router das Senden von LDP-Nachrichten wieder aufnimmt. Nach Ablauf der Wartezeit kann die LDP-Sitzung wiederhergestellt werden. Sie können die Wartezeit in Sekunden konfigurieren. Dieser Wert ist in der fehlertoleranten Sitzungs-TLV enthalten, die in LDP-Initialisierungsnachrichten gesendet wird, wenn der ordnungsgemäße LDP-Neustart aktiviert ist.

Angenommen, Router A und Router B sind LDP-Nachbarn. Router A ist der neu startende Router. Die Wiederverbindungszeit ist die Zeit, die Router A Router B anweist, zu warten, nachdem Router B erkannt hat, dass Router A neu gestartet wurde.

Um die Zeit für die Wiederherstellung der Verbindung zu konfigurieren, fügen Sie die reconnect-time folgende Anweisung ein:

graceful-restart { reconnect-time seconds; }

Sie können die Zeit für die Wiederherstellung der Verbindung auf einen Wert im Bereich von 30 bis 300 Sekunden einstellen. Standardmäßig sind es 60 Sekunden.

Eine Liste der Hierarchieebenen, auf denen Sie diese Anweisungen konfigurieren können, finden Sie in den Abschnitten zur Anweisungszusammenfassung für diese Anweisungen.

Konfigurieren der Wiederherstellungszeit und der maximalen Wiederherstellungszeit

Die Wiederherstellungszeit ist die Zeitspanne, die ein Router darauf wartet, dass LDP ordnungsgemäß neu gestartet wird. Der Wiederherstellungszeitraum beginnt, wenn eine Initialisierungsnachricht gesendet oder empfangen wird. Dieser Zeitraum ist in der Regel auch die Zeitspanne, in der ein benachbarter Router seine Informationen über den neu startenden Router beibehält, sodass er weiterhin Datenverkehr weiterleiten kann.

Um zu verhindern, dass ein benachbarter Router beeinträchtigt wird, wenn er einen falschen Wert für die Wiederherstellungszeit vom neu startenden Router erhält, können Sie die maximale Wiederherstellungszeit auf dem benachbarten Router konfigurieren. Ein benachbarter Router behält seinen Status für das kürzere der beiden Male bei. Beispiel: Router A führt einen ordnungsgemäßen LDP-Neustart durch. Er hat eine Wiederherstellungszeit von 900 Sekunden an den benachbarten Router B gesendet. Die maximale Wiederherstellungszeit von Router B ist jedoch auf 400 Sekunden festgelegt. Router B wartet nur 400 Sekunden, bevor er seine LDP-Informationen von Router A löscht.

Um die Wiederherstellungszeit zu konfigurieren, schließen Sie die recovery-time Anweisung und die maximum-neighbor-recovery-time Anweisung ein:

graceful-restart { maximum-neighbor-recovery-time seconds; recovery-time seconds; }

Eine Liste der Hierarchieebenen, auf denen Sie diese Anweisungen konfigurieren können, finden Sie in den Abschnitten zur Anweisungszusammenfassung für diese Anweisungen.

Filtern eingehender LDP-Label-Bindungen

Sie können empfangene LDP-Label-Bindungen filtern und Richtlinien anwenden, um Bindungen zu akzeptieren oder abzulehnen, die von benachbarten Routern angekündigt wurden. Um die Filterung nach empfangenen Etiketten zu konfigurieren, fügen Sie die import folgende Anweisung ein:

import [ policy-names ];

Eine Liste der Hierarchieebenen, auf denen Sie diese Anweisung einschließen können, finden Sie im Abschnitt Anweisungszusammenfassung für diese Anweisung.

Die benannte Richtlinie (auf Hierarchieebene [edit policy-options] konfiguriert) wird auf alle Bezeichnungsbindungen angewendet, die von allen LDP-Nachbarn empfangen werden. Die gesamte Filterung erfolgt mit from Anweisungen. Tabelle 1 listet die einzigen from Operatoren auf, die für die LDP-Filterung mit empfangenen Bezeichnungen gelten.

from Operator |

Beschreibung |

|---|---|

|

Übereinstimmungen mit Bindungen, die von einem Nachbarn empfangen wurden, der über die angegebene Schnittstelle benachbart ist |

|

Übereinstimmungen mit Bindungen, die von der angegebenen LDP-Router-ID empfangen wurden |

|

Übereinstimmungen mit Bindungen, die von einem Nachbarn empfangen wurden, der die angegebene Schnittstellenadresse ankündigt |

|

Stimmt mit Bindungen mit dem angegebenen Präfix überein |

Wenn eine Bindung gefiltert wird, wird sie weiterhin in der LDP-Datenbank angezeigt, aber nicht für die Installation als Teil eines label-switchedierten Pfads (LSP) berücksichtigt.

Im Allgemeinen kann das Anwenden von Richtlinien in LDP nur verwendet werden, um die Einrichtung von LSPs zu blockieren, nicht um deren Routing zu steuern. Dies liegt daran, dass der Pfad, dem ein LSP folgt, durch das Unicast-Routing und nicht durch LDP bestimmt wird. Wenn es jedoch mehrere Pfade mit gleichen Kosten zum Ziel über verschiedene Nachbarn gibt, können Sie die LDP-Filterung verwenden, um einige der möglichen nächsten Hops von der Berücksichtigung auszuschließen. (Andernfalls wählt LDP nach dem Zufallsprinzip einen der möglichen nächsten Hops aus.)

LDP-Sitzungen sind nicht an Schnittstellen oder Schnittstellenadressen gebunden. LDP wirbt nur für Labels pro Router (nicht pro Schnittstelle). Wenn also mehrere parallele Verbindungen zwischen zwei Routern vorhanden sind, wird nur eine LDP-Sitzung aufgebaut, die nicht an eine einzelne Schnittstelle gebunden ist. Wenn ein Router mehrere Nachbarschaften zum selben Nachbarn hat, stellen Sie sicher, dass der Filter die erwartete Leistung erbringt. (Im Allgemeinen ist die Verwendung von next-hop und interface in diesem Fall nicht angemessen.)

Wenn eine Bezeichnung gefiltert wurde (d. h., sie wurde von der Richtlinie abgelehnt und wird nicht zum Erstellen eines LSP verwendet), wird sie in der Datenbank als gefiltert markiert:

user@host> show ldp database Input label database, 10.10.255.1:0-10.10.255.6:0 Label Prefix 3 10.10.255.6/32 (Filtered) Output label database, 10.10.255.1:0-10.10.255.6:0 Label Prefix 3 10.10.255.1/32 (Filtered)

Weitere Informationen zum Konfigurieren von Richtlinien für LDP finden Sie im Benutzerhandbuch für Routingrichtlinien, Firewallfilter und Traffic Policers.

Beispiele: Filtern eingehender LDP-Label-Bindungen

Akzeptieren Sie nur /32-Präfixe von allen Nachbarn:

[edit]

protocols {

ldp {

import only-32;

...

}

}

policy-options {

policy-statement only-32 {

term first {

from {

route-filter 0.0.0.0/0 upto /31;

}

then reject;

}

then accept;

}

}

Akzeptieren Sie oder länger von der Router-ID 131.108/1610.10.255.2 und akzeptieren Sie alle Präfixe von allen anderen Nachbarn:

[edit]

protocols {

ldp {

import nosy-neighbor;

...

}

}

policy-options {

policy-statement nosy-neighbor {

term first {

from {

neighbor 10.10.255.2;

route-filter 131.108.0.0/16 orlonger accept;

route-filter 0.0.0.0/0 orlonger reject;

}

}

then accept;

}

}

Filtern ausgehender LDP-Labelbindungen

Sie können Exportrichtlinien konfigurieren, um ausgehende LDP-Etiketten zu filtern. Sie können ausgehende Label-Bindungen filtern, indem Sie Routing-Richtlinien anwenden, um zu verhindern, dass Bindungen an benachbarte Router angekündigt werden. Um die Filterung ausgehender Etiketten zu konfigurieren, fügen Sie die export folgende Anweisung ein:

export [policy-name];

Eine Liste der Hierarchieebenen, auf denen Sie diese Anweisung einschließen können, finden Sie im Abschnitt Anweisungszusammenfassung für diese Anweisung.

Die benannte Exportrichtlinie (auf Hierarchieebene [edit policy-options] konfiguriert) wird auf alle Bezeichnungsbindungen angewendet, die an alle LDP-Nachbarn übertragen werden. Der einzige from Operator, der für die LDP-Filterung ausgehender Bezeichnungen gilt, ist route-filter, der Bindungen mit dem angegebenen Präfix entspricht. Die einzigen to Operatoren, die für die Filterung ausgehender Bezeichnungen gelten, sind die Operatoren in Tabelle 2.

zum Bediener |

Beschreibung |

|---|---|

|

Übereinstimmungen mit Bindungen, die an einen Nachbarn gesendet werden, der über die angegebene Schnittstelle benachbart ist |

|

Übereinstimmungen mit Bindungen, die an die angegebene LDP-Router-ID gesendet werden |

|

Übereinstimmungen mit Bindungen, die an einen Nachbarn gesendet werden, der die angegebene Schnittstellenadresse ankündigt |

Wenn eine Bindung gefiltert wird, wird die Bindung nicht dem benachbarten Router angekündigt, sondern kann als Teil eines LSP auf dem lokalen Router installiert werden. Sie können Richtlinien in LDP anwenden, um die Einrichtung von Sprachdienstleistern zu blockieren, aber nicht, um deren Routing zu steuern. Der Pfad, dem ein LSP folgt, wird durch Unicast-Routing bestimmt, nicht durch LDP.

LDP-Sitzungen sind nicht an Schnittstellen oder Schnittstellenadressen gebunden. LDP wirbt nur für Bezeichnungen pro Router (nicht pro Schnittstelle). Wenn mehrere parallele Verbindungen zwischen zwei Routern vorhanden sind, wird nur eine LDP-Sitzung aufgebaut, die nicht an eine einzelne Schnittstelle gebunden ist.

Verwenden Sie die next-hop Operatoren und interface nicht, wenn ein Router mehrere Nachbarschaften zum selben Nachbarn hat.

Gefilterte Labels werden in der Datenbank markiert:

user@host> show ldp database Input label database, 10.10.255.1:0-10.10.255.3:0 Label Prefix 100007 10.10.255.2/32 3 10.10.255.3/32 Output label database, 10.10.255.1:0-10.10.255.3:0 Label Prefix 3 10.10.255.1/32 100001 10.10.255.6/32 (Filtered)

Weitere Informationen zum Konfigurieren von Richtlinien für LDP finden Sie im Benutzerhandbuch für Routingrichtlinien, Firewallfilter und Traffic Policers.

Beispiele: Filtern ausgehender LDP-Labelbindungen

Blockieren Sie die Übertragung der Route an 10.10.255.6/32 beliebige Nachbarn:

[edit protocols]

ldp {

export block-one;

}

policy-options {

policy-statement block-one {

term first {

from {

route-filter 10.10.255.6/32 exact;

}

then reject;

}

then accept;

}

}

131.108/16 Nur oder länger an Router-ID 10.10.255.2senden und alle Präfixe an alle anderen Router senden:

[edit protocols]

ldp {

export limit-lsps;

}

policy-options {

policy-statement limit-lsps {

term allow-one {

from {

route-filter 131.108.0.0/16 orlonger;

}

to {

neighbor 10.10.255.2;

}

then accept;

}

term block-the-rest {

to {

neighbor 10.10.255.2;

}

then reject;

}

then accept;

}

}

Angeben der von LDP verwendeten Transportadresse

Router müssen zuerst eine TCP-Sitzung untereinander aufbauen, bevor sie eine LDP-Sitzung einrichten können. Die TCP-Sitzung ermöglicht es den Routern, die für die LDP-Sitzung benötigten Label-Ankündigungen auszutauschen. Um die TCP-Sitzung aufzubauen, muss jeder Router die Transportadresse des anderen Routers lernen. Die Transportadresse ist eine IP-Adresse, die zur Identifizierung der TCP-Sitzung verwendet wird, über die die LDP-Sitzung ausgeführt wird.

Um die LDP-Transportadresse zu konfigurieren, fügen Sie die transport-address-Anweisung ein:

transport-address (router-id | interface);

Eine Liste der Hierarchieebenen, auf denen Sie diese Anweisung einschließen können, finden Sie im Abschnitt Anweisungszusammenfassung für diese Anweisung.

Wenn Sie die router-id Option angeben, wird die Adresse der Router-ID als Transportadresse verwendet (sofern nicht anders konfiguriert, ist die Router-ID in der Regel identisch mit der Loopback-Adresse). Wenn Sie die interface Option angeben, wird die Schnittstellenadresse als Transportadresse für alle LDP-Sitzungen zu Nachbarn verwendet, die über diese Schnittstelle erreicht werden können. Beachten Sie, dass standardmäßig die Router-Kennung als Transportadresse verwendet wird.

Für den ordnungsgemäßen Betrieb muss die LDP-Transportadresse erreichbar sein. Bei der Router-ID handelt es sich um eine Kennung, nicht um eine routingfähige IP-Adresse. Aus diesem Grund wird empfohlen, die Router-ID so einzustellen, dass sie mit der Loopback-Adresse übereinstimmt, und dass die Loopback-Adresse von der IGP angekündigt wird.

Sie können die interface Option nicht angeben, wenn mehrere parallele Verbindungen zum selben LDP-Nachbarn vorhanden sind, da die LDP-Spezifikation erfordert, dass dieselbe Transportadresse auf allen Schnittstellen desselben Nachbarn angekündigt wird. Wenn LDP mehrere parallele Links zum selben Nachbarn erkennt, werden Schnittstellen zu diesem Nachbarn nacheinander deaktiviert, bis die Bedingung gelöscht wird, entweder durch Trennen des Nachbarn auf einer Schnittstelle oder durch Angeben der router-id Option.

Steuern der Transportadresse, die für die Ziel-LDP-Sitzung verwendet wird

Um eine TCP-Sitzung zwischen zwei Geräten aufzubauen, muss jedes Gerät die Transportadresse des anderen Geräts lernen. Die Transportadresse ist eine IP-Adresse, die zur Identifizierung der TCP-Sitzung verwendet wird, über die die LDP-Sitzung ausgeführt wird. Bisher konnte diese Transportadresse nur die Router-ID oder eine Schnittstellenadresse sein. Mit der LDP-Transportadressenfunktion können Sie jede IP-Adresse explizit als Transportadresse für LDP-Zielnachbarn für Layer-2-Circuit-, MPLS- und VPLS-Nachbarschaften konfigurieren. Auf diese Weise können Sie die Ziel-LDP-Sitzungen mithilfe der Transportadresskonfiguration steuern.

- Vorteile der Steuerung der Transportadresse, die für eine Ziel-LDP-Sitzung verwendet wird

- Übersicht über Ziel-LDP-Transportadressen

- Bevorzugte Transportadressen

- Fehlerbehebung bei der Konfiguration von Transportadressen

Vorteile der Steuerung der Transportadresse, die für eine Ziel-LDP-Sitzung verwendet wird

Das Konfigurieren der Transportadresse zum Einrichten von Ziel-LDP-Sitzungen hat die folgenden Vorteile:

Flexible interface configurations—Bietet die Flexibilität, mehrere IP-Adressen für eine Loopback-Schnittstelle zu konfigurieren, ohne die Erstellung einer LDP-Sitzung zwischen den LDP-Zielnachbarn zu unterbrechen.

Ease of operation—Die auf Schnittstellenebene konfigurierte Transportadresse ermöglicht die Verwendung von mehr als einem Protokoll im IGP-Backbone für LDP. Dies ermöglicht einen reibungslosen und einfachen Betrieb.

Übersicht über Ziel-LDP-Transportadressen

Vor Junos OS Version 19.1R1 bot LDP nur Unterstützung für die Router-ID oder die Schnittstellenadresse als Transportadresse auf jeder LDP-Schnittstelle. Die Adjacencies, die auf dieser Schnittstelle gebildet wurden, verwendeten eine der IP-Adressen, die der Schnittstelle zugewiesen waren, oder die Router-ID. Im Falle einer gezielten Nachbarschaft ist die Schnittstelle die Loopback-Schnittstelle. Wenn mehrere Loopbackadressen auf dem Gerät konfiguriert waren, konnte die Transportadresse für die Schnittstelle nicht abgeleitet werden, und infolgedessen konnte die LDP-Sitzung nicht eingerichtet werden.

Ab Junos OS Version 19.1R1 können Sie zusätzlich zu den Standard-IP-Adressen, die für die Transportadresse von LDP-Zielsitzungen verwendet werden, jede andere IP-Adresse als Transportadresse unter den sessionKonfigurationsanweisungen , session-group und interface konfigurieren. Die Transportadresskonfiguration gilt nur für konfigurierte Nachbarn, einschließlich Layer-2-Verbindungen, MPLS- und VPLS-Nachbarschaften. Diese Konfiguration gilt nicht für erkannte Nachbarschaften (zielgerichtet oder nicht).

Bevorzugte Transportadressen

Sie können die Transportadresse für Ziel-LDP-Sitzungen auf Sitzungs-, Sitzungsgruppen- und Schnittstellenebene konfigurieren.

Nachdem die Transportadresse konfiguriert wurde, wird die Ziel-LDP-Sitzung basierend auf der Transportadresspräferenz von LDP eingerichtet.

Die Reihenfolge der Präferenz der Transportadresse für den Zielnachbarn (konfiguriert über Layer 2-Verbindung, MPLS-, VPLS- und LDP-Konfiguration) ist wie folgt:

Unter

[edit protocols ldp session]Hierarchie.Unter

[edit protocols ldp session-group]Hierarchie.Unter

[edit protocols ldp interfcae lo0]Hierarchie.Unter

[edit protocols ldp]Hierarchie.Standardadresse.

Die Reihenfolge der Präferenz der Transportadresse für die ermittelten Nachbarn lautet wie folgt:

Unter

[edit protocols ldp interfcae]Hierarchie.Unter

[edit protocols ldp]Hierarchie.Standardadresse.

Die Reihenfolge der Präferenz der Transportadresse für automatisch adressierte Nachbarn, bei denen LDP so konfiguriert ist, dass Hello-Pakete akzeptiert werden, lautet wie folgt:

Unter

[edit protocols ldp interfcae lo0]Hierarchie.Unter

[edit protocols ldp]Hierarchie.Standardadresse.

Fehlerbehebung bei der Konfiguration von Transportadressen

Sie können die folgenden show-Befehlsausgaben verwenden, um Probleme bei Ziel-LDP-Sitzungen zu beheben:

show ldp sessionshow ldp neighborDie

detailAusgabeebene desshow ldp neighborBefehls zeigt die Transportadresse an, die in den Hallo-Nachrichten an den Zielnachbarn gesendet wird. Wenn diese Adresse vom Nachbarn aus nicht erreichbar ist, wird die LDP-Sitzung nicht gestartet.show configuration protocols ldp

Sie können auch LDP-Trace-Optionen für die weitere Fehlerbehebung aktivieren.

Wenn die Konfiguration von einer ungültigen (nicht erreichbaren) Transportadresse auf eine gültige Transportadresse geändert wird, können die folgenden Ablaufverfolgungen beobachtet werden:

May 29 10:47:11.569722 Incoming connect from 10.55.1.4 May 29 10:47:11.570064 Connection 10.55.1.4 state Closed -> Open May 29 10:47:11.570727 Session 10.55.1.4 state Nonexistent -> Initialized May 29 10:47:11.570768 Session 10.55.1.4 state Initialized -> OpenRec May 29 10:47:11.570799 LDP: Session param Max PDU length 4096 from 10.55.1.4, negotiated 4096 May 29 10:47:11.570823 Session 10.55.1.4 GR state Nonexistent -> Operational May 29 10:47:11.669295 Session 10.55.1.4 state OpenRec -> Operational May 29 10:47:11.669387 RPD_LDP_SESSIONUP: LDP session 10.55.1.4 is up

Wenn die Konfiguration von der Verwendung einer gültigen Transportadresse in eine Transportadresse geändert wird, die ungültig (nicht erreichbar) ist, können die folgenden Traces beobachtet werden:

May 29 10:42:36.317942 Session 10.55.1.4 GR state Operational -> Nonexistent May 29 10:42:36.318171 Session 10.55.1.4 state Operational -> Closing May 29 10:42:36.318208 LDP session 10.55.1.4 is down, reason: received notification from peer May 29 10:42:36.318236 RPD_LDP_SESSIONDOWN: LDP session 10.55.1.4 is down, reason: received notification from peer May 29 10:42:36.320081 Connection 10.55.1.4 state Open -> Closed May 29 10:42:36.322411 Session 10.55.1.4 state Closing -> Nonexistent

Führen Sie im Falle einer fehlerhaften Konfiguration die folgenden Fehlerbehebungsaufgaben durch:

Aktivieren Sie die

address familyOption . Die Transportadresse, die unter dersessionAnweisung konfiguriert wird, muss derselben Adressfamilie angehören wie der Nachbar oder die Sitzung.Die Adresse, die als Transportadresse unter einer

neighboroder-Anweisungsessionkonfiguriert ist, muss für den Router lokal sein, damit die angestrebten Hello-Nachrichten gestartet werden können. Sie können überprüfen, ob die Adresse konfiguriert ist. Wenn die Adresse unter keiner Schnittstelle konfiguriert ist, wird die Konfiguration abgelehnt.

Konfigurieren der Präfixe, die in LDP aus der Routing-Tabelle angekündigt werden

Sie können den Satz von Präfixen steuern, die in LDP angekündigt werden, und veranlassen, dass der Router der Ausgangsrouter für diese Präfixe ist. Standardmäßig wird nur die Loopback-Adresse in LDP angekündigt. Fügen Sie die egress-policy folgende Anweisung ein, um den Satz von Präfixen aus der Routingtabelle zu konfigurieren, die in LDP angekündigt werden sollen:

egress-policy policy-name;

Eine Liste der Hierarchieebenen, auf denen Sie diese Anweisung einschließen können, finden Sie im Abschnitt Anweisungszusammenfassung für diese Anweisung.

Wenn Sie eine Ausgangsrichtlinie für LDP konfigurieren, die die Loopbackadresse nicht enthält, wird sie in LDP nicht mehr angekündigt. Wenn Sie die Loopbackadresse weiterhin ankündigen möchten, müssen Sie sie explizit als Teil der LDP-Ausgangsrichtlinie konfigurieren.

Die benannte Richtlinie (konfiguriert auf der [edit policy-options] Hierarchieebene oder [edit logical-systems logical-system-name policy-options] ) wird auf alle Routen in der Routingtabelle angewendet. Die Routen, die der Richtlinie entsprechen, werden in LDP angekündigt. Sie können die Gruppe von Nachbarn, für die diese Präfixe angekündigt werden, mithilfe der export Anweisung steuern. Es werden nur from Operatoren berücksichtigt, Sie können jeden gültigen from Operator verwenden. Weitere Informationen finden Sie in der Junos OS Routing Protocols Library for Routing Devices.

Router der ACX-Serie unterstützen die Hierarchieebene [edit logical-systems] nicht.

Beispiel: Konfigurieren der in LDP angekündigten Präfixe

Kündigen Sie alle verbundenen Routen in LDP an:

[edit protocols]

ldp {

egress-policy connected-only;

}

policy-options {

policy-statement connected-only {

from {

protocol direct;

}

then accept;

}

}

Konfigurieren der FEC-Deaggregation

Wenn ein LDP-Ausgangsrouter mehrere Präfixe ankündigt, werden die Präfixe an ein einzelnes Label gebunden und zu einer einzigen Weiterleitungsäquivalenzklasse (FEC) aggregiert. Standardmäßig behält LDP diese Aggregation bei, wenn die Ankündigung das Netzwerk durchläuft.

Da ein LSP nicht auf mehrere nächste Hops aufgeteilt ist und die Präfixe an einen einzelnen LSP gebunden sind, findet normalerweise kein Lastenausgleich über Pfade mit gleichen Kosten statt. Sie können jedoch einen Lastenausgleich über Pfade zu gleichen Kosten durchführen, wenn Sie eine Lastenausgleichsrichtlinie konfigurieren und die FECs deaggregieren.

Das Deaggregieren der FECs bewirkt, dass jedes Präfix an ein separates Label gebunden wird und zu einem separaten LSP wird.

Um deaggregierte FECs zu konfigurieren, fügen Sie die deaggregate folgende Anweisung ein:

deaggregate;

Eine Liste der Hierarchieebenen, auf denen Sie diese Anweisung einschließen können, finden Sie im Abschnitt Anweisungszusammenfassung für diese Anweisung.

Für alle LDP-Sitzungen können Sie deaggregierte FECs nur global konfigurieren.

Durch die Deaggregation einer FEC können die resultierenden mehreren LSPs auf mehrere Pfade mit gleichen Kosten verteilt werden, und LSPs werden auf die mehreren nächsten Hops in den Ausgangssegmenten verteilt, es wird jedoch nur ein nächster Hop pro LSP installiert.

Um FECs zu aggregieren, fügen Sie die no-deaggregate folgende Anweisung ein:

no-deaggregate;

Eine Liste der Hierarchieebenen, auf denen Sie diese Anweisung einschließen können, finden Sie im Abschnitt Anweisungszusammenfassung für diese Anweisung.

Für alle LDP-Sitzungen können Sie aggregierte FECs nur global konfigurieren.

Konfigurieren von Policern für LDP-FECs

Sie können das Junos-Betriebssystem so konfigurieren, dass der Datenverkehr für LDP-FECs verfolgt und überwacht wird. LDP FEC-Policer können für Folgendes verwendet werden:

Verfolgen oder überwachen Sie den eingehenden Datenverkehr für eine LDP FEC.

Verfolgen oder überwachen Sie den Transitverkehr für eine LDP FEC.

Verfolgen oder überwachen Sie den LDP-FEC-Datenverkehr, der von einer bestimmten Weiterleitungsklasse stammt.

Verfolgen oder überwachen Sie den LDP-FEC-Datenverkehr, der von einem bestimmten virtuellen Routing- und Weiterleitungsstandort (VRF) stammt.

Verwerfen Sie falschen Datenverkehr, der für eine bestimmte LDP-FEC bestimmt ist.

Um den Datenverkehr für eine LDP-FEC zu überwachen, müssen Sie zunächst einen Filter konfigurieren. Insbesondere müssen Sie entweder die interface Anweisung oder die interface-set Anweisung auf Hierarchieebene [edit firewall family protocol-family filter filter-name term term-name from] konfigurieren. Mit dieser interface Anweisung können Sie den Filter einer einzelnen Schnittstelle zuordnen. Mit dieser interface-set Anweisung können Sie den Filter mehreren Schnittstellen zuordnen.

Weitere Informationen zum Konfigurieren der interface Anweisung, der Anweisung und der Policer für LDP-FECs finden Sie im Benutzerhandbuch für Routingrichtlinien, Firewallfilterinterface-setund Traffic Policers.

Nachdem Sie die Filter konfiguriert haben, müssen Sie sie in die policing Anweisungskonfiguration für LDP aufnehmen. Um Policer für LDP-FECs zu konfigurieren, fügen Sie die policing folgende Anweisung ein:

policing { fec fec-address { ingress-traffic filter-name; transit-traffic filter-name; } }

Eine Liste der Hierarchieebenen, auf denen Sie diese Anweisung einschließen können, finden Sie im Abschnitt Anweisungszusammenfassung für diese Anweisung.

Die policing Anweisung enthält die folgenden Optionen:

fec– Geben Sie die FEC-Adresse für den LDP-FEC an, den Sie überwachen möchten.ingress-filter– Geben Sie den Namen des Filters für eingehenden Datenverkehr an.transit-traffic– Geben Sie den Namen des Filters für den Transitdatenverkehr an.

Konfigurieren der LDP-IPv4-FEC-Filterung

Wenn eine LDP-Zielsitzung eingerichtet wird, tauscht das Junos-Betriebssystem standardmäßig immer sowohl die IPv4-Weiterleitungsäquivalenzklassen (FECs) als auch die FECs der Layer-2-Verbindung über die LDP-Zielsitzung aus. Für eine LDP-Sitzung mit einem indirekt verbundenen Nachbarn sollten Sie Layer-2-Circuit-FECs nur dann in den Neighbor exportieren, wenn die Session speziell für die Unterstützung von Layer-2-Circuits oder VPLS konfiguriert wurde.

In einem Netzwerk gemischter Anbieter, in dem alle Nicht-BGP-Präfixe in LDP angekündigt werden, kann die LDP-Datenbank groß werden. Für diese Art von Umgebung kann es nützlich sein, die Ankündigung von IPv4-FECs über LDP-Sitzungen zu verhindern, die aufgrund einer Layer-2-Verbindung oder einer LDP-VPLS-Konfiguration gebildet wurden. Ebenso kann es nützlich sein, alle IPv4-FECs zu filtern, die in dieser Art von Umgebung empfangen werden.

Wenn es sich bei allen LDP-Nachbarn, die einer LDP-Sitzung zugeordnet sind, nur um Layer- 2-Nachbarn handelt, können Sie das Junos-Betriebssystem so konfigurieren, dass nur Layer- 2-Circuit-FECs angekündigt werden, indem Sie die l2-smart-policy Anweisung konfigurieren. Diese Funktion filtert auch automatisch die IPv4-FECs heraus, die in dieser Sitzung empfangen wurden. Wenn Sie eine explizite Export- oder Importrichtlinie konfigurieren, die für l2-smart-policy aktiviert ist, wird diese Funktion in die entsprechende Richtung deaktiviert.

Wenn einer der Nachbarn der LDP-Sitzung aufgrund einer erkannten Nachbarschaft gebildet wird oder wenn die Nachbarschaft aufgrund einer LDP-Tunneling-Konfiguration auf einem oder mehreren RSVP-LSPs gebildet wird, werden die IPv4-FECs mit dem Standardverhalten angekündigt und empfangen.

Fügen Sie die folgende Anweisung ein, um zu verhindern, dass LDP IPv4-FECs über LDP-Sitzungen nur mit Layer- 2-Nachbarn exportiert, und um IPv4-FECs herauszufiltern, die l2-smart-policy über solche Sitzungen empfangen wurden:

l2-smart-policy;

Eine Liste der Hierarchieebenen, auf denen Sie diese Anweisung konfigurieren können, finden Sie in der Anweisungszusammenfassung für diese Anweisung.

Konfigurieren von BFD für LDP-LSPs

Sie können die Bidirectional Forwarding Detection (BFD) für LDP-LSPs konfigurieren. Das BFD-Protokoll ist ein einfacher Hello-Mechanismus, der Fehler in einem Netzwerk erkennt. Hello-Pakete werden in einem festgelegten, regelmäßigen Intervall gesendet. Ein Nachbarfehler wird erkannt, wenn der Router nach einem bestimmten Intervall keine Antwort mehr empfängt. BFD funktioniert mit einer Vielzahl von Netzwerkumgebungen und Topologien. Die Fehlererkennungs-Timer für BFD haben kürzere Zeitlimits als die Fehlererkennungsmechanismen statischer Routen und ermöglichen so eine schnellere Erkennung.

Ein Fehler wird protokolliert, wenn eine BFD-Sitzung für einen Pfad fehlschlägt. Im Folgenden wird gezeigt, wie BFD für LDP LSP-Protokollmeldungen angezeigt werden können:

RPD_LDP_BFD_UP: LDP BFD session for FEC 10.255.16.14/32 is up RPD_LDP_BFD_DOWN: LDP BFD session for FEC 10.255.16.14/32 is down

Sie können BFD auch für RSVP-LSPs konfigurieren, wie unter Konfigurieren von BFD für RSVP-signalisierte LSPsbeschrieben.