Instalação de VMX aninhados

Uma máquina virtual aninhada é uma máquina virtual contida em outro VM. Leia este tópico para entender como lançar o vMX VM aninhado na KVM.

Visão geral do modelo de VM aninhado

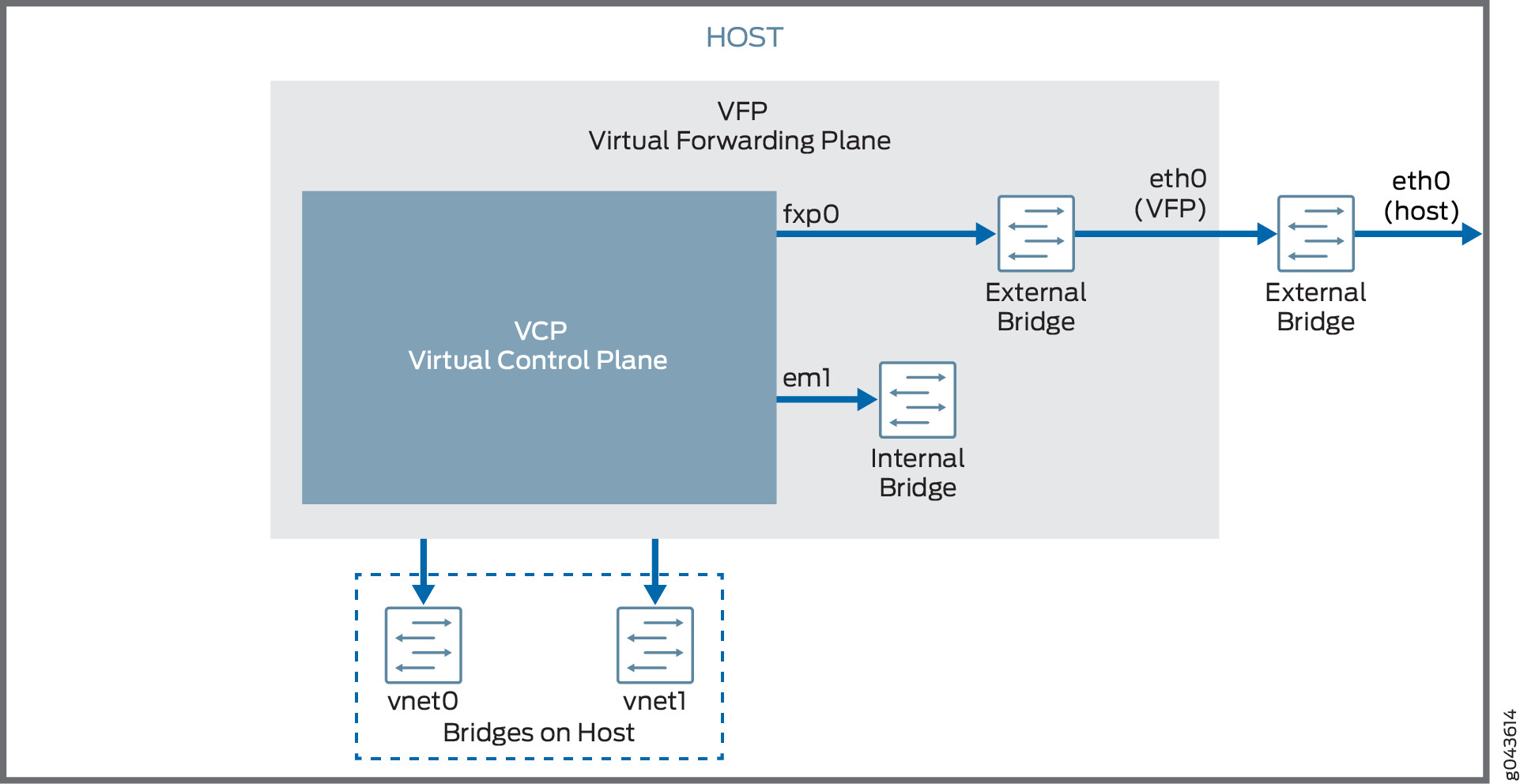

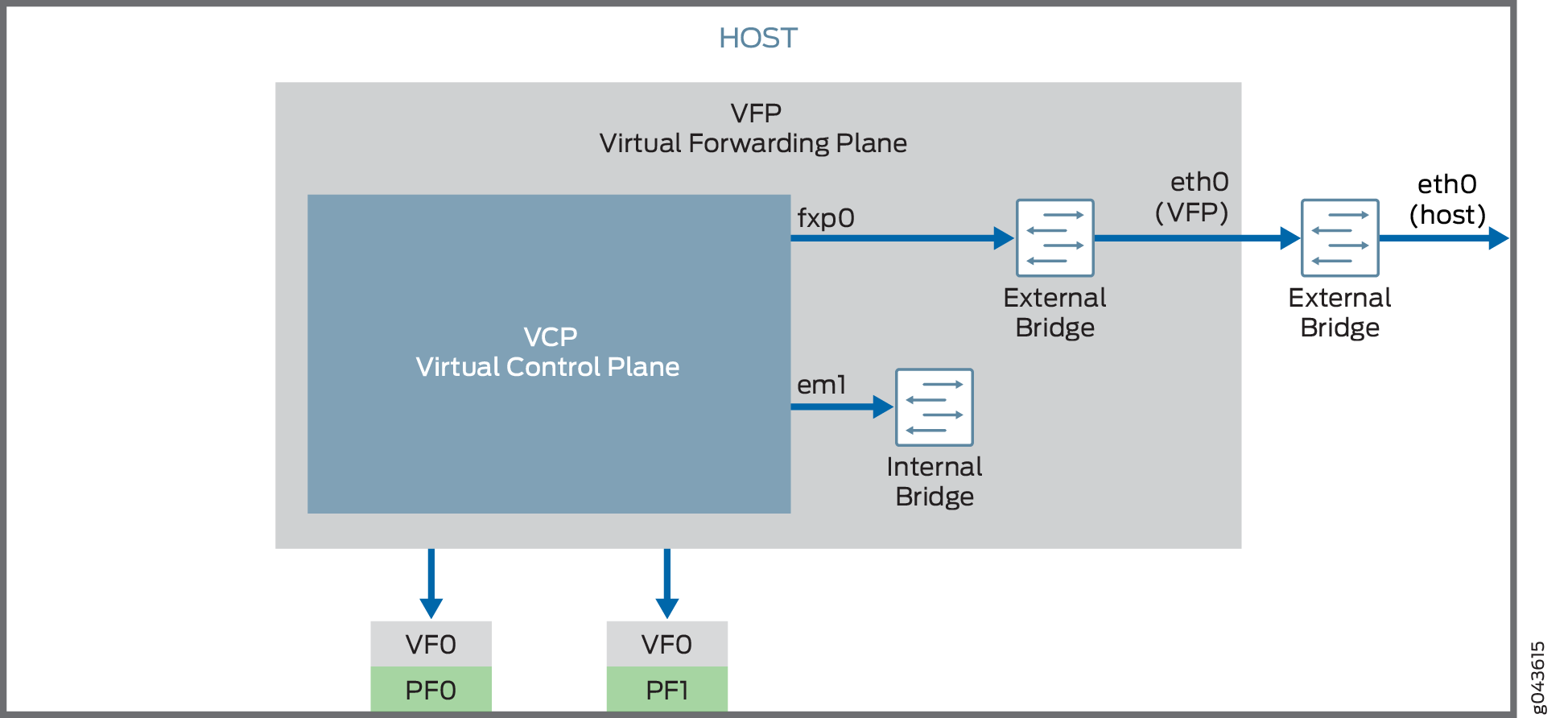

O modelo aninhado de máquina virtual vMX (VM) tem o plano de controle virtual (VCP) funcionando como um VM dentro do plano de encaminhamento virtual (VFP) VM. O VFP VM executa o software de plano de encaminhamento trio virtual e o VCP VM executa o Junos OS. O VM VCP e o VFP VM exigem conectividade de Camada 2 para se comunicarem entre si. Uma ponte interna que é local para o servidor para cada instância vMX permite essa comunicação. O VM VCP e o VFP VM também exigem conectividade de Camada 2 para se comunicarem com a porta de gerenciamento Ethernet no servidor. Você deve especificar interfaces Ethernet virtuais com endereços IP exclusivos e endereços MAC para o VFP e o VCP para configurar uma ponte externa para uma instância vMX. O tráfego de gerenciamento de ethernet para todas as instâncias vMX entra no servidor através da porta de gerenciamento Ethernet.

O vMX VM aninhado oferece suporte a interfaces virtio e SR-IOV para portas de encaminhamento. A primeira interface é usada para gerenciamento e deve ser uma interface virtio conectada à ponte br-ext (ponte externa). Interfaces posteriores são interfaces WAN e podem ser interfaces virtio ou SR-IOV. Você deve criar as pontes para todas as interfaces virtio. Você deve ter pelo menos uma interface WAN para o encaminhamento.

- VM aninhado com Interfaces Virtio

- VM aninhado com interfaces SR-IOV

- Requisitos do sistema para modelo VM aninhado

- Limitações vMX com o modelo VM aninhado

VM aninhado com Interfaces Virtio

No modo virtio, as interfaces de servidor não devem ser configuradas com os VFs. Você pode remover ou redefinir as interfaces (eth1) usando o rmmod ixgbe comando e adicionar o driver IXGBE com interface padrão à interface do servidor usando o modprobe ixgbe comando.

A Figura 1 ilustra o modelo vMX VM aninhado com interfaces virtio.

virtio

virtio

VM aninhado com interfaces SR-IOV

No modo SR-IOV, as interfaces vMX estão associadas às interfaces de servidor. Por exemplo, a ge-0/0/0 interface está associada a eth1 . eth1 é definida no .conf file- interface: ge-0/0/0 ,nic: eth1.

O VF é adicionado ao driver IXGBE da interface eth1 do servidor que está associado ao VF e pode ser verificado usando o ip link show eth1 comando enquanto está em execução no modo SR-IOV.

A Figura 2 ilustra o modelo vMX VM aninhado com interfaces SR-IOV.

SR-IOV

SR-IOV

Para interfaces SR-IOV, você deve carregar o driver IXGBE modificado antes de lançar o vMX VM aninhado.

A maneira como o tráfego de rede passa da NIC física para a NIC virtual depende da técnica de virtualização que você configura.

Requisitos do sistema para modelo VM aninhado

O vMX pode ser configurado para ser executado em dois modos, dependendo do caso de uso:

Modo Lite — precisa de menos recursos em termos de CPU e memória para ser executado em menor largura de banda.

Modo de desempenho — precisa de recursos mais altos em termos de CPU e memória para ser executado em maior largura de banda.

Nota:O modo de desempenho é o modo padrão.

Limitações vMX com o modelo VM aninhado

O vMX não oferece suporte aos seguintes recursos com o modelo VM aninhado:

Anexo ou distanciamento de interfaces enquanto uma instância vMX está em execução

Atualização da versão do Junos OS

Requisitos de hardware e software para VMS vMX aninhados

A Tabela 1 lista os requisitos de hardware.

Descrição |

Valor |

|---|---|

Configuração do sistema de amostra |

Para virtio: qualquer processador x86 (Intel ou AMD) com recursos VT-d. Para SR-IOV: placas PCI-Express baseadas em Intel 82599 (10 Gbps) e processadores Ivy Bridge. |

Número de núcleos

Nota:

O modo de desempenho é o modo padrão e o valor mínimo é baseado em uma porta. |

|

Memória |

|

A Tabela 2 lista os requisitos de software.

Descrição |

Valor |

|---|---|

Sistema Operacional |

Ubuntu 14.04.1 LTS Linux 3.19.0-80 genérico |

Virtualização |

QEMU-KVM 2.0.0+dfsg-2ubuntu1.11 |

Pacotes necessários

Nota:

Outros pacotes adicionais podem ser necessários para satisfazer todas as dependências. |

bridge-utils qemu-kvm libvirt-bin virtinst

Nota:

libvirt 1.2.19 |

Instalação e lançamento do vMX VM aninhado na KVM

Para lançar o vMX VM aninhado na KVM, execute essas tarefas.

- Preparando o host Ubuntu para instalar o VM VM aninhado

- Carregando o driver IXGBE modificado

- Lançamento de uma instância vMX aninhada

- Conectando-se à porta do console VFP

- Conectando-se ao VCP

Preparando o host Ubuntu para instalar o VM VM aninhado

Para preparar o sistema de host do Ubuntu para a instalação do vMX:

Carregando o driver IXGBE modificado

Se você estiver usando interfaces SR-IOV, você deve carregar o driver IXGBE modificado antes de lançar o vMX VM aninhado. Para carregar o driver IXGBE modificado:

Lançamento de uma instância vMX aninhada

Para lançar a instância vMX aninhada:

Por exemplo, este comando lança uma instância vMX no modo de desempenho com duas interfaces virtio conectadas às pontes vnet0 e vnet1:

sudo virt-install --hvm --vcpus=12 -r 16384 \

--serial tcp,host=:4001,mode=bind,protocol=telnet \

--nographics --import --noautoconsole \

--cpu \

SandyBridge,+erms,+smep,+fsgsbase,+pdpe1gb,+rdrand,+f16c,+osxsave,+dca,+pcid,+pdcm,+x

tpr,+tm2,+est,+smx,+vmx,+ds_cpl,+monitor,+dtes64,+pbe,+tm,+ht,+ss,+acpi,+ds,+vme \

-w bridge=br-ext,model=virtio \

-w bridge=vnet0,model=virtio \

-w bridge=vnet1,model=virtio \

-n vmx1 --disk vmx-nested-17.2R1.13-4.qcow2,format=qcow2

Por exemplo, este comando lança uma instância vMX no modo de desempenho com duas interfaces SR-IOV:

sudo virt-install --hvm --vcpus=12 -r 16384 \

--serial tcp,host=:4001,mode=bind,protocol=telnet \

--nographics --import --noautoconsole \

--cpu \

SandyBridge,+erms,+smep,+fsgsbase,+pdpe1gb,+rdrand,+f16c,+osxsave,+dca,+pcid,+pdcm,+x

tpr,+tm2,+est,+smx,+vmx,+ds_cpl,+monitor,+dtes64,+pbe,+tm,+ht,+ss,+acpi,+ds,+vme \

-w bridge=br-ext,model=virtio \

--host-device=pci_0000_81_10_0 \

--host-device=pci_0000_81_10_1 \

-n vmx2 --disk vmx-nested-17.2R1.13-4.qcow2,format=qcow2

Conectando-se à porta do console VFP

Após o lançamento da instância vMX com o virt-install comando, você pode se conectar à porta de console do VFP do host com o telnet localhost serial-port comando, onde serial-port está a porta especificada por você como host com o -serial parâmetro.

Por exemplo:

$ telnet localhost 4001

Faça login com o nome de jnpr usuário e a senha jnpr123padrão. Torne-se raiz usando o sudo -i comando.

A interface br-ext tenta buscar um endereço IP usando DHCP. Use o ifconfig br-ext comando para exibir o endereço IP atribuído. Se o DHCP estiver indisponível ou se preferir um endereço IP estático, atribua um endereço IP a br-ext. Agora, você pode se conectar ao VFP usando o protocolo SSH e este endereço IP atribuído.

Conectando-se ao VCP

Quando o VM VCP é lançado, você pode se conectar à porta do console VCP na porta TCP 8601 do VFP VM usando este comando:

$ telnet localhost 8601

Na porta do console, você pode fazer login com nome de root usuário e sem senha.

No mínimo, você deve realizar essas tarefas iniciais de configuração do Junos OS após o login no VCP: