Projeto e implementação de interconexão de data center usando rotas do tipo 5

Interconexão de data center usando rotas EVPN Tipo 5

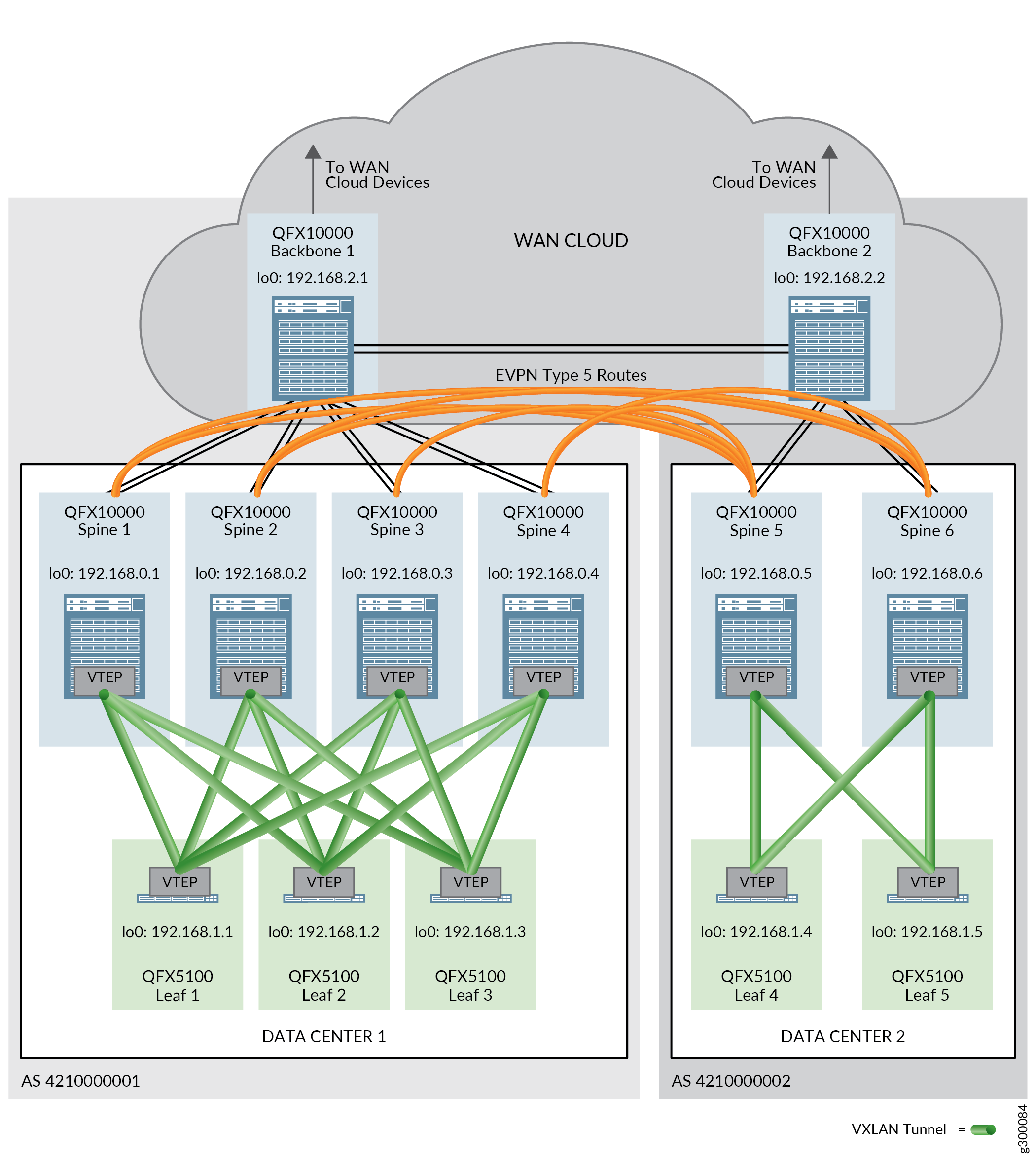

As rotas EVPN Tipo 5, também conhecidas como rotas de prefixo IP, são usadas em um contexto de DCI para passar tráfego entre data centers que estão usando diferentes esquemas de sub-rede de endereço IP.

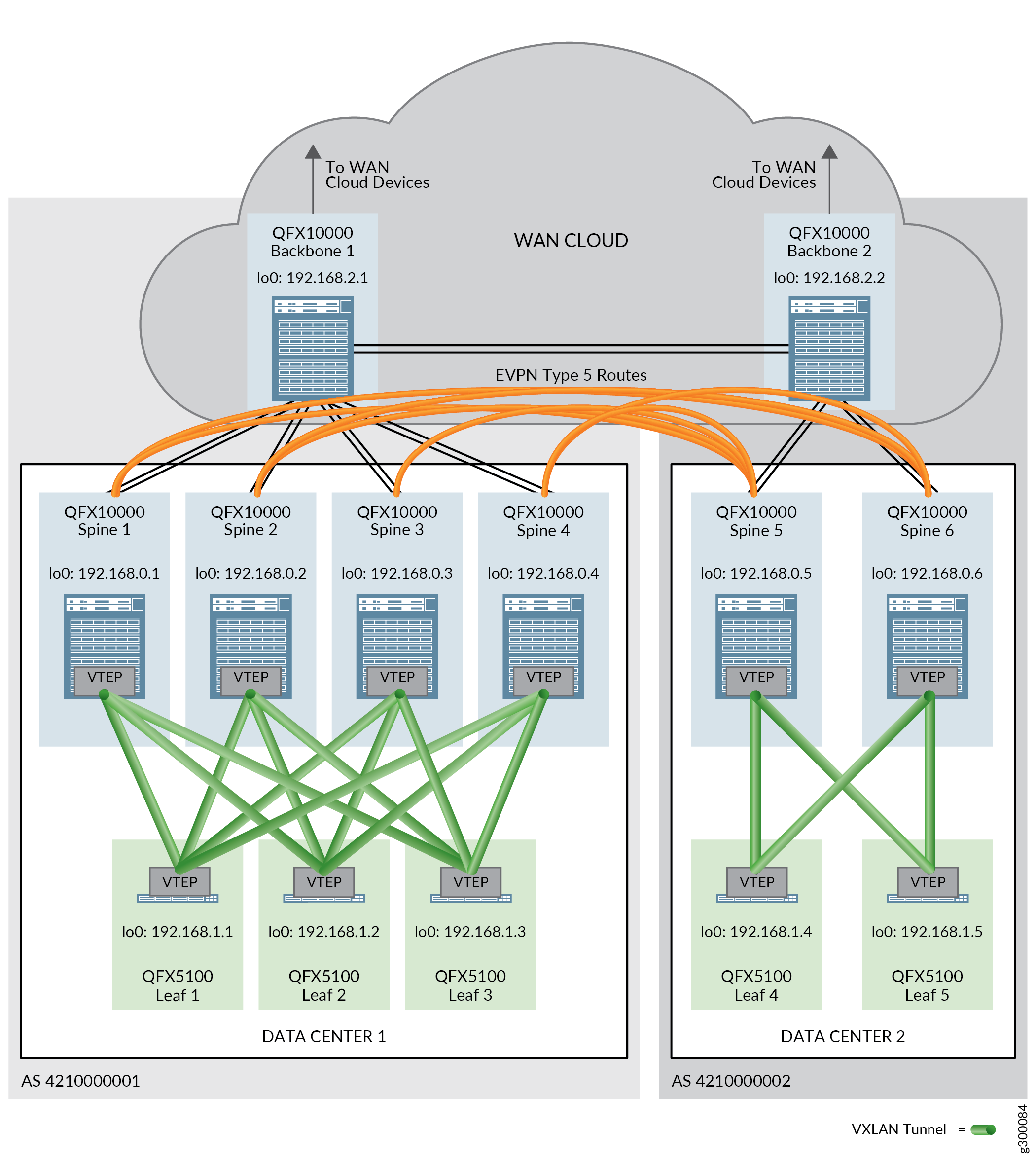

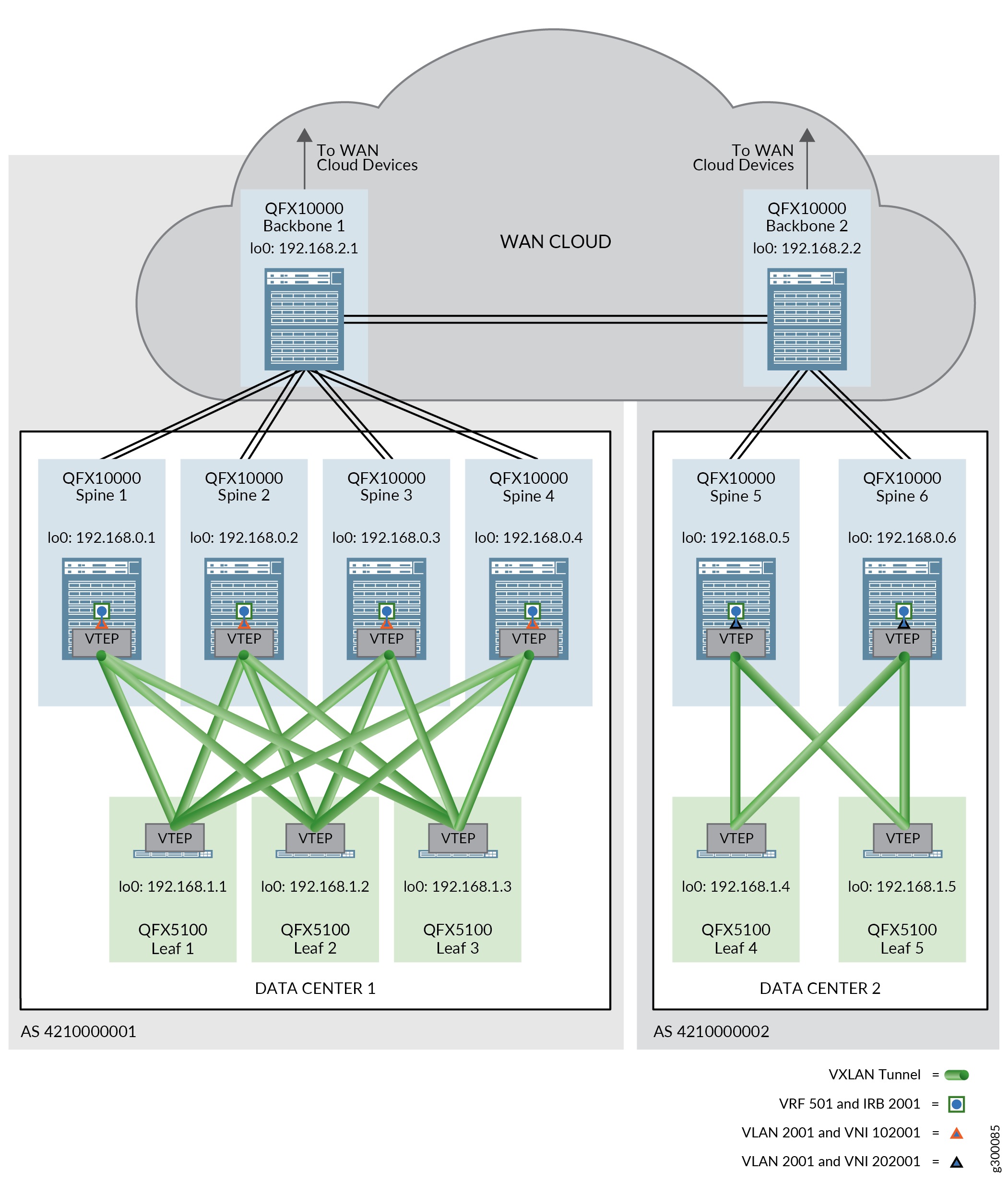

Nesta arquitetura de referência, as rotas EVPN Tipo 5 são trocadas entre dispositivos spine em diferentes data centers para permitir a passagem de tráfego entre data centers.

A conectividade física entre os data centers é necessária antes que as mensagens EVPN Tipo 5 possam ser enviadas por data centers. Essa conectividade física é fornecida por dispositivos de backbone em uma nuvem WAN. Um dispositivo de backbone é conectado a cada dispositivo spine em um único data center e participa das sessões de EBGP overlay e underlay. O EBGP também é executado em um grupo BGP separado para conectar os dispositivos de backbone uns aos outros; A sinalização EVPN está habilitada neste grupo BGP.

A Figura 1 mostra dois data centers usando rotas EVPN Tipo 5 para DCI.

Para obter mais informações sobre as rotas EVPN Tipo 5, consulte a rota EVPN Tipo-5 com encapsulamento VXLAN para EVPN-VXLAN.

Todos os procedimentos nesta seção assumem que as rotas EVPN Tipo 2 estão sendo aprovadas com sucesso nos data centers. Consulte o projeto e a implementação de sobreposição de pontes roteadas centralmente para obter instruções de configuração.

Esta seção abrange os processos de configuração de uma DCI usando rotas EVPN Tipo 5, e inclui os seguintes procedimentos:

- Configuração de interfaces de dispositivos de backbone

- Habilitando o EBGP como o protocolo de roteamento de rede underlay entre os dispositivos spine e os dispositivos backbone

- Habilitando o IBGP para a rede overlay no dispositivo backbone

- Habilitando o EBGP como protocolo de roteamento entre os dispositivos backbone

- Configuração de DCI usando rotas EVPN Tipo 5

- Verificando se a DCI usando rotas EVPN Tipo 5 está operando

- DCI usando rotas do tipo 5 — Histórico de lançamentos

Configuração de interfaces de dispositivos de backbone

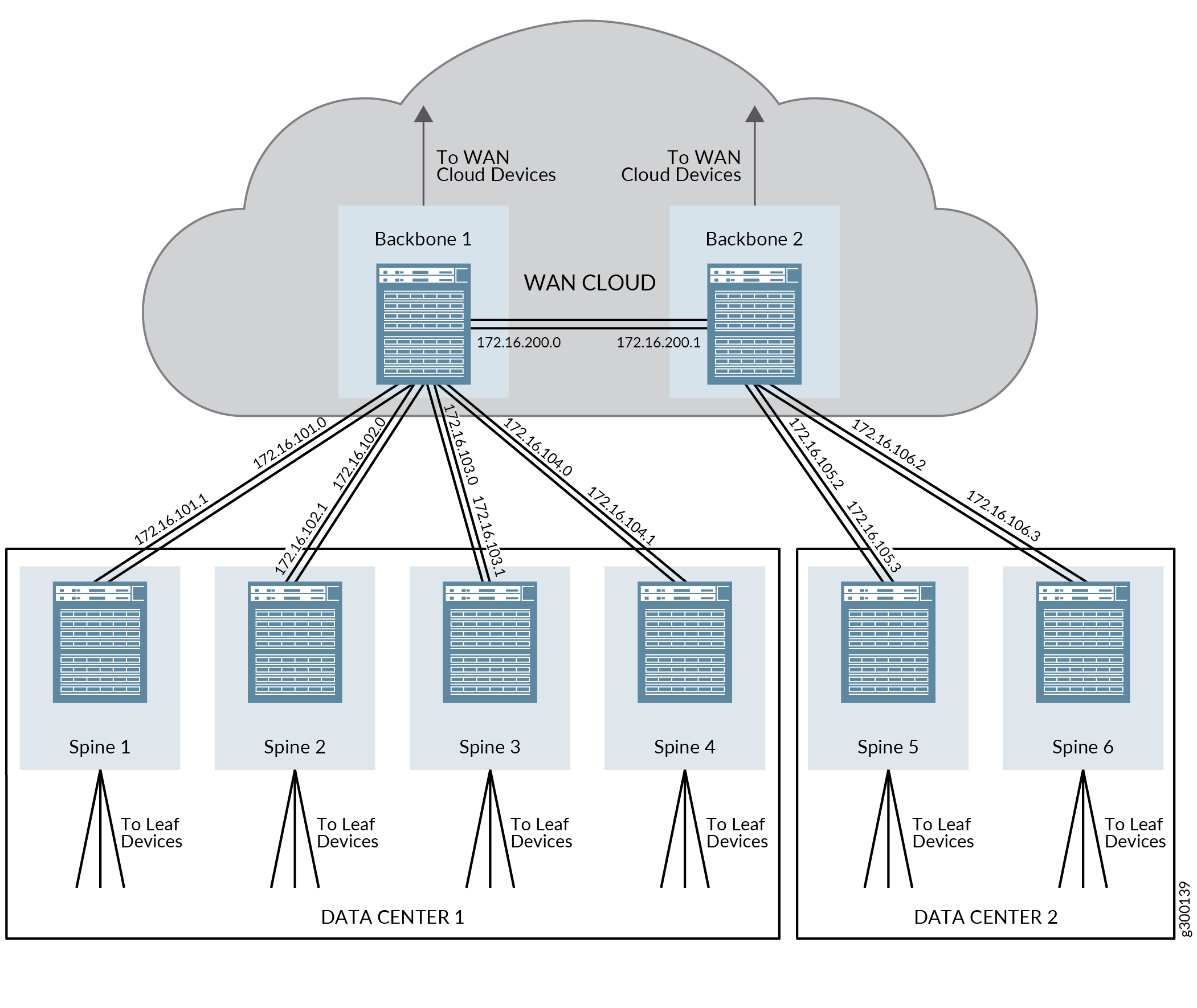

Os dispositivos de backbone nesta arquitetura fazem parte da nuvem WAN e devem fornecer conectividade tanto aos dispositivos spine em cada data center quanto ao outro dispositivo backbone. Essa conectividade deve ser estabelecida antes que as rotas EVPN Tipo 5 possam ser trocadas entre dispositivos spine em diferentes data centers.

A Figura 2 fornece uma visão geral dos endereços IP que estão configurados nessas etapas.

backbone e spine

backbone e spine

Para configurar as interfaces do dispositivo spine e do backbone:

(Interfaces Ethernet agregadas) Configure as interfaces Ethernet agregadas nos switches de dispositivo spine em Data Centers 1 e 2 e nos dispositivos backbone.

Essa etapa mostra a atribuição do endereço IP apenas para as interfaces Ethernet agregadas. Para obter instruções completas passo a passo sobre a criação de interfaces Ethernet agregadas, veja Configuração da agregação de enlaces.

Dispositivo spine 1 em data center 1:

set interfaces ae3 unit 0 family inet address 172.16.101.1/31

Dispositivo Spine 2 em data center 1:

set interfaces ae3 unit 0 family inet address 172.16.102.1/31

Dispositivo Spine 3 em data center 1:

set interfaces ae3 unit 0 family inet address 172.16.103.1/31

Dispositivo Spine 4 em data center 1:

set interfaces ae3 unit 0 family inet address 172.16.104.1/31

Dispositivo Spine 5 em data center 2:

set interfaces ae4 unit 0 family inet address 172.16.105.3/31

Dispositivo spine 6 em data center 2:

set interfaces ae4 unit 0 family inet address 172.16.106.3/31

Dispositivo de backbone 1:

set interfaces ae1 unit 0 family inet address 172.16.101.0/31 set interfaces ae2 unit 0 family inet address 172.16.102.0/31 set interfaces ae3 unit 0 family inet address 172.16.103.0/31 set interfaces ae4 unit 0 family inet address 172.16.104.0/31 set interfaces ae200 unit 0 family inet address 172.16.200.0/31

Dispositivo backbone 2:

set interfaces ae5 unit 0 family inet address 172.16.105.2/31 set interfaces ae6 unit 0 family inet address 172.16.106.2/31 set interfaces ae200 unit 0 family inet address 172.16.200.1/31

(Interfaces independentes que não estão incluídas em interfaces Ethernet agregadas) Veja configuração do endereço da interface.

Habilitando o EBGP como o protocolo de roteamento de rede underlay entre os dispositivos spine e os dispositivos backbone

O EBGP é usado como protocolo de roteamento da rede underlay neste projeto de referência. Os dispositivos de backbone devem participar do EBGP com os dispositivos spine para oferecer suporte à conectividade underlay.

O processo para habilitar o EBGP nos dispositivos spine e leaf está coberto pela seção de Design e Implementação de Rede Underlay de Malha IP deste guia. Esse procedimento pressupõe que o EBGP já foi habilitado nos dispositivos spine e leaf, embora alguma configuração de EBGP nos dispositivos spine precise ser atualizada para oferecer suporte a dispositivos backbone e, portanto, está incluída nestas etapas.

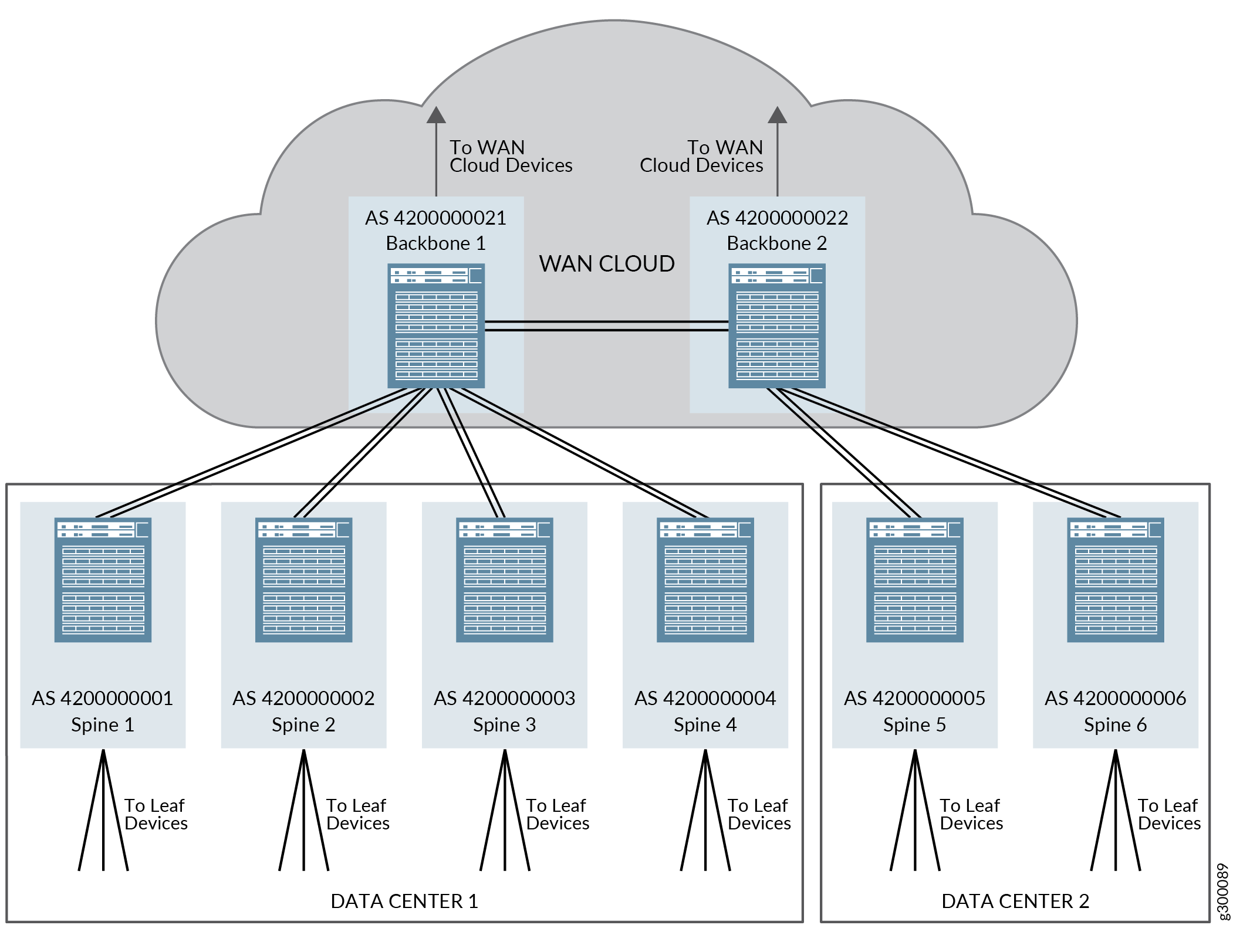

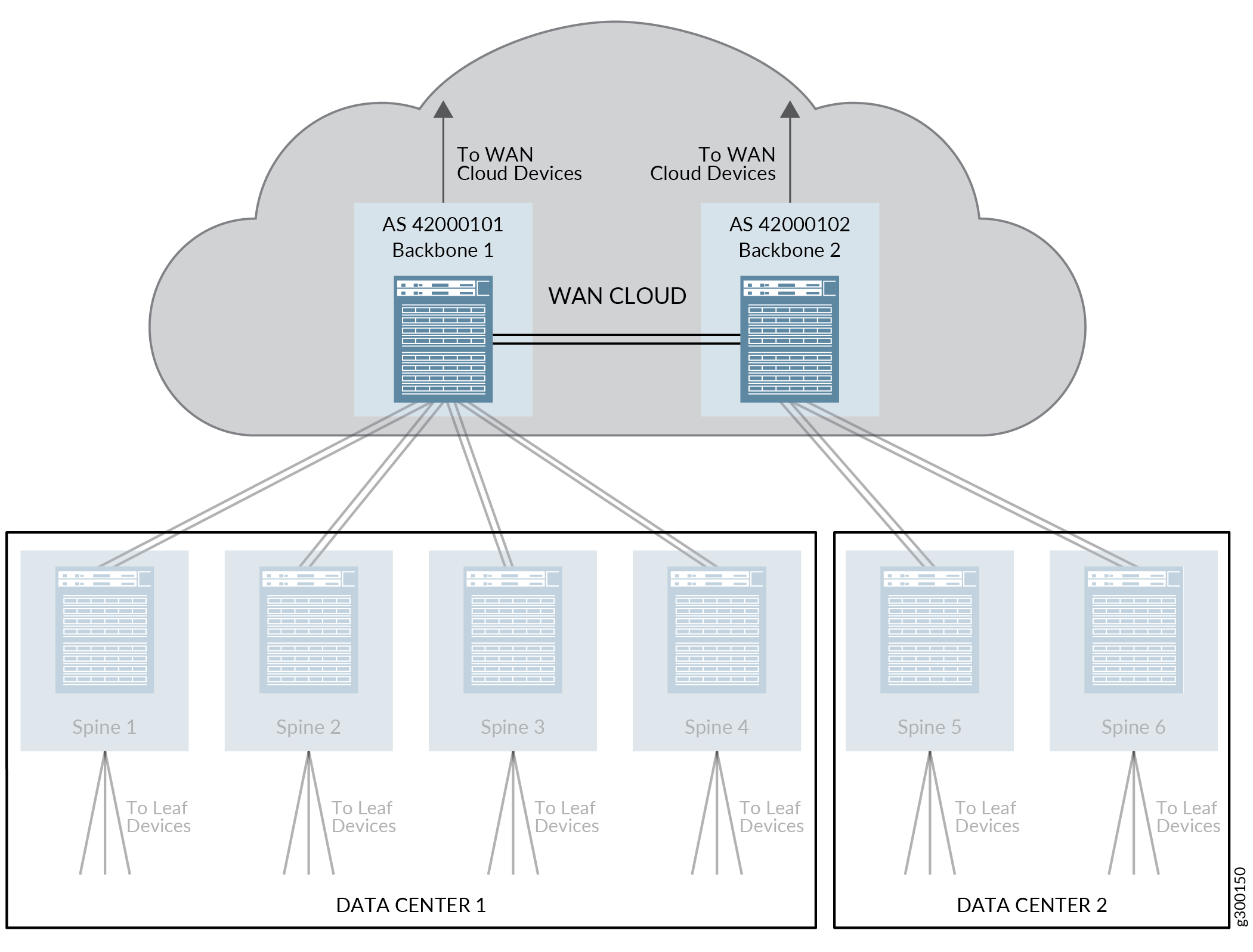

O EBGP funciona neste design de referência atribuindo cada dispositivo leaf, spine e backbone em seu próprio número exclusivo de sistema autônomo (AS) de 32 bits.

A Figura 3 mostra uma visão geral da topologia EBGP para dispositivos spine e backbone quando dispositivos de backbone são incluídos no design de referência.

backbone

backbone

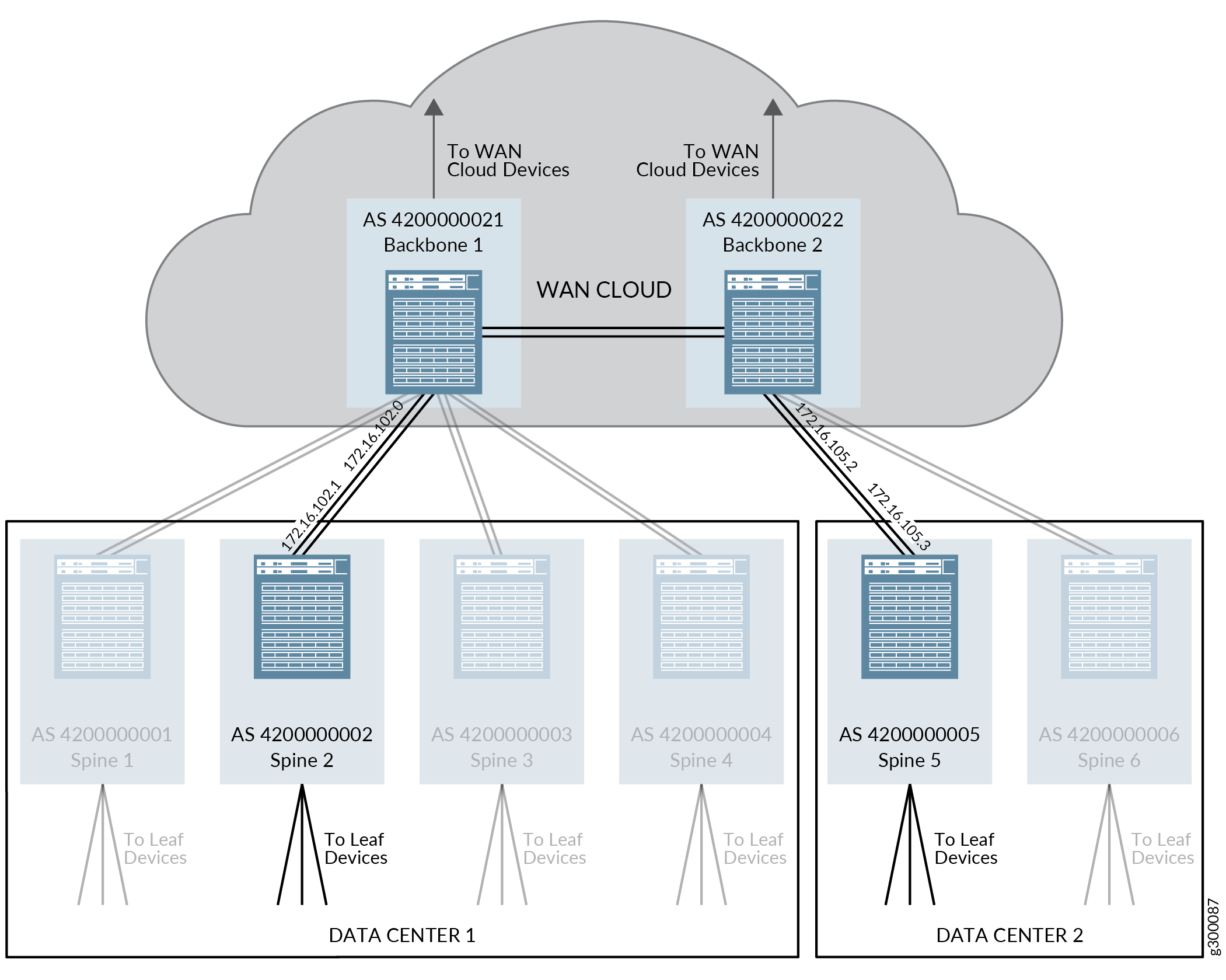

A Figura 4 ilustra os parâmetros de protocolo EBGP que estão configurados neste procedimento. Repita esse processo para os outros dispositivos na topologia para habilitar o EBGP nos dispositivos restantes.

de backbone

de backbone

Para permitir que o EBGP ofereça suporte à rede underlay neste design de referência:

Habilitando o IBGP para a rede overlay no dispositivo backbone

Os dispositivos de backbone devem executar o IBGP para ter conectividade de rede overlay e ser capazes de oferecer suporte a DCI usando rotas EVPN Tipo 5.

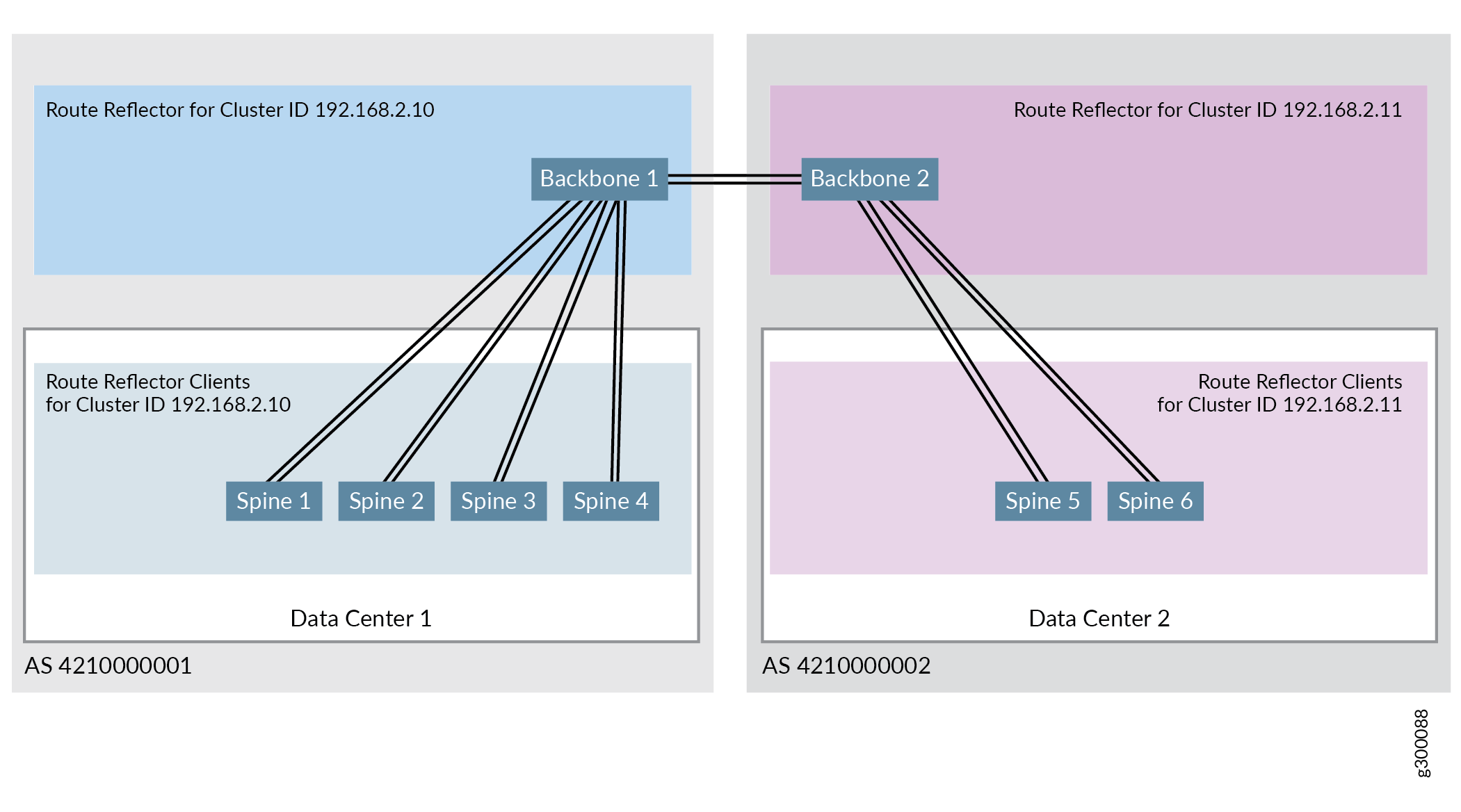

A Figura 5 mostra a configuração do IBGP do design de referência validado quando os dispositivos de backbone são incluídos na topologia. No design de referência validado, todos os dispositivos spine e leaf no mesmo data center são atribuídos ao mesmo sistema autônomo. Os dispositivos de backbone são atribuídos ao mesmo sistema autônomo que os dispositivos spine e leaf do data center que está usando o dispositivo backbone como ponto de entrada na nuvem WAN.

backbone

backbone

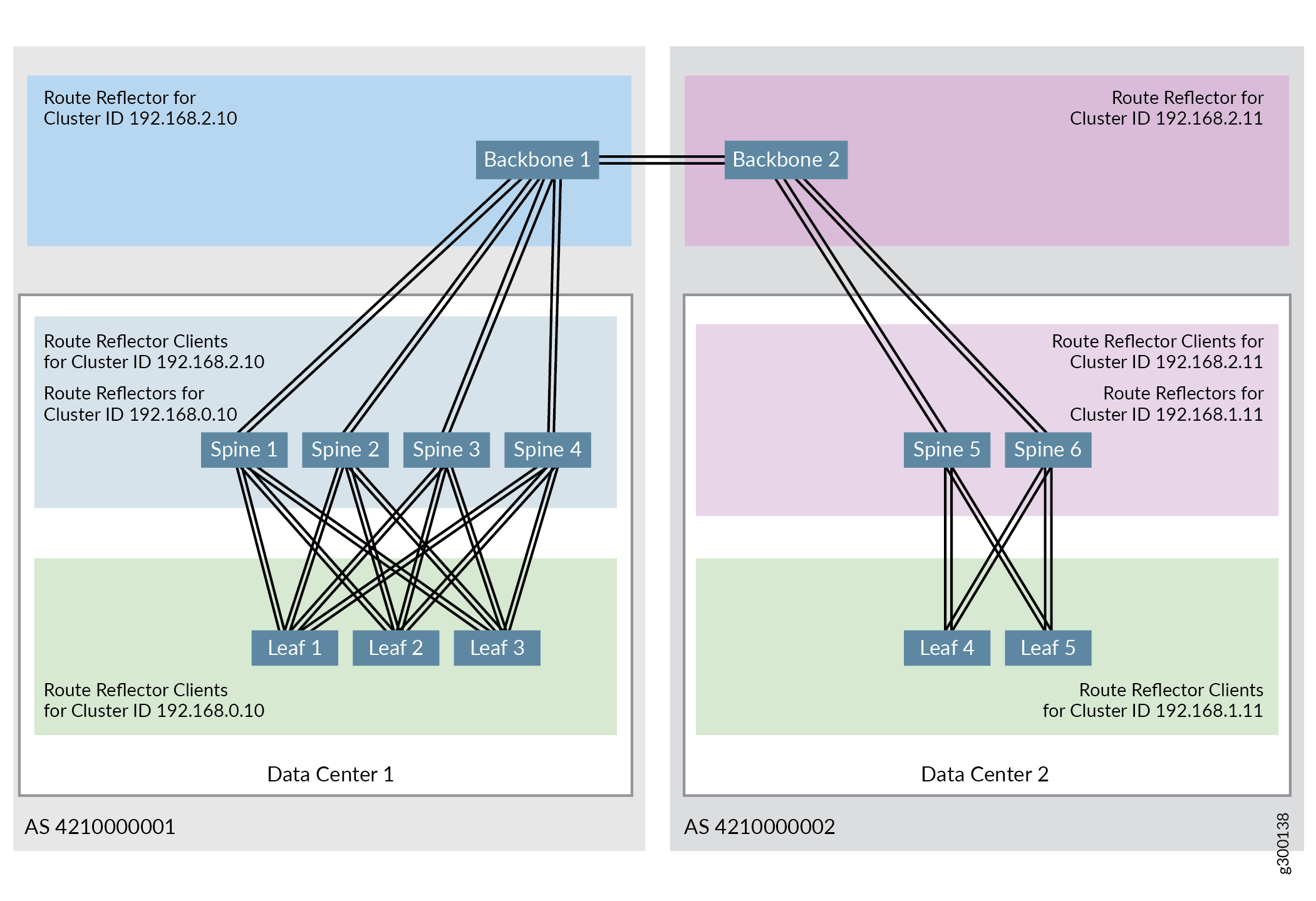

A Figura 6 ilustra a configuração do refletor de rota no design de referência validado. Um cluster refletor de rota — cluster ID 192.168.2.10 — inclui o dispositivo backbone 1 como refletor de rota e todos os dispositivos spine no data center 1 como clientes refletores de rota. Outro cluster refletor de rota — cluster ID 192.168.2.11 — inclui o dispositivo backbone 2 como refletor de rota e todos os dispositivos spine no data center 2 como clientes refletores de rota.

O design de referência validado oferece suporte a vários refletores de rota hierárquicos, onde um cluster inclui dispositivos de backbone atuando como refletores de rota para clientes de dispositivos spine e outro cluster inclui dispositivos spine atuando como refletores de rota para clientes de dispositivos leaf. Para ver as etapas de configuração para configurar o outro refletor de rota, consulte Configure o IBGP para o Overlay.

A Figura 7 mostra a topologia completa do refletor de rotas hierárquica quando dois data centers estão conectados:

Para obter mais informações sobre refletores de rota BGP, consulte Entendendo os refletores de rota BGP.

Esse procedimento pressupõe que o IBGP tenha sido habilitado para dispositivos spine e leaf conforme detalhado na Configuração do IBGP para o Overlay. As configurações do dispositivo spine estão incluídas neste procedimento para ilustrar suas relações com os dispositivos de backbone.

Para configurar a conectividade do IBGP para os dispositivos de backbone:

Habilitando o EBGP como protocolo de roteamento entre os dispositivos backbone

O EBGP também é usado como protocolo de roteamento entre os dispositivos de backbone neste design de referência. Os dispositivos de backbone estão conectados usando IP e os dispositivos de backbone devem ser configurados como pares de EBGP.

Um segundo grupo de EBGP —BACKBONE-BGP é criado nestas etapas para habilitar o EBGP entre os dispositivos de backbone. Cada dispositivo de backbone é atribuído a um número AS exclusivo de 32 bits dentro do novo grupo EBGP nestas etapas. Os dispositivos de backbone, portanto, fazem parte de dois grupos de EBGP eUNDERLAY-BGP BACKBONE-BGPtêm um número de AS único em cada grupo. A sinalização EVPN, que precisa ser executada para oferecer suporte à EVPN entre os dispositivos de backbone, também está configurada dentro do grupo EBGP durante este procedimento.

A Figura 8 ilustra os atributos necessários para habilitar o EBGP entre os dispositivos de backbone.

de dispositivos de backbone

de dispositivos de backbone

Para habilitar o EBGP como protocolo de roteamento entre os dispositivos de backbone:

Configuração de DCI usando rotas EVPN Tipo 5

As mensagens EVPN Tipo 5 são trocadas entre interfaces IRB em dispositivos spine em diferentes data centers quando as rotas EVPN Tipo 5 são usadas para DCI. Essas interfaces IRB estão configuradas em uma instância de roteamento.

Cada data center tem um identificador de rede virtual único (VNI 102001 e 202001) nesta configuração, mas ambas as VNIs são mapeadas para a mesma VLAN (VLAN 2001) na mesma instância de roteamento (VRF 501).

Veja a Figura 9 para uma ilustração da instância de roteamento.

EVPN Tipo 5

EVPN Tipo 5

Para habilitar a DCI usando rotas EVPN Tipo 5:

Esse procedimento pressupõe que as instâncias de roteamento, IRBs e VLANs criadas anteriormente neste guia estão operacionais. Veja o projeto e a implementação de sobreposição de pontes roteadas centralmente.

Ao implementar a funcionalidade border leaf em um roteador MX, tenha em mente que o roteador oferece suporte apenas a instâncias de switch virtuais. Os roteadores MX não oferecem suporte a instâncias padrão.

Verificando se a DCI usando rotas EVPN Tipo 5 está operando

Digite os seguintes comandos para verificar se o tráfego pode ser enviado entre data centers usando rotas EVPN Tipo 5:

DCI usando rotas do tipo 5 — Histórico de lançamentos

A Tabela 1 oferece um histórico de todos os recursos desta seção e seu suporte dentro deste design de referência.

Lançamento |

Descrição |

|---|---|

19.1R2 |

switches QFX10002-60C e QFX5120-32C que executam o Junos OS Release 19.1R2 e versões posteriores no mesmo trem de versão suportam todos os recursos documentados nesta seção. |

18.4R2-S2 |

QFX5110 e switches QFX5120-48Y, e roteadores MX que executam o Junos OS Release 18.4R2-S2 e versões posteriores na mesma versão de versão suportam todos os recursos documentados nesta seção. |