이 페이지의 내용

클러스터 노드 준비

이 항목에서는 배포를 위해 Routing Director 배포 클러스터 노드를 준비하기 위해 수행해야 하는 단계에 대해 설명합니다.

ESXi 8.0, KVM 및 Proxmox VE 하이퍼바이저에 배포할 클러스터 노드를 준비하려면 다음 단계를 수행합니다.

-

생성 방법은 클러스터를 배포하려는 베어메탈 하이퍼바이저에 따라 다릅니다.

OVA 파일 다운로드

OVA 파일을 다운로드하고 무결성을 확인합니다.

Juniper Routing Director 소프트웨어 다운로드 사이트에서 Juniper Routing Director 설치 OVA 파일을 다운로드합니다. OVA는 노드 VM을 생성하고 클러스터를 배포하는 데 사용됩니다.

실제 파일명에는 routing-director-2.7.0-build.ova와 같은 릴리스 날짜가 포함됩니다.

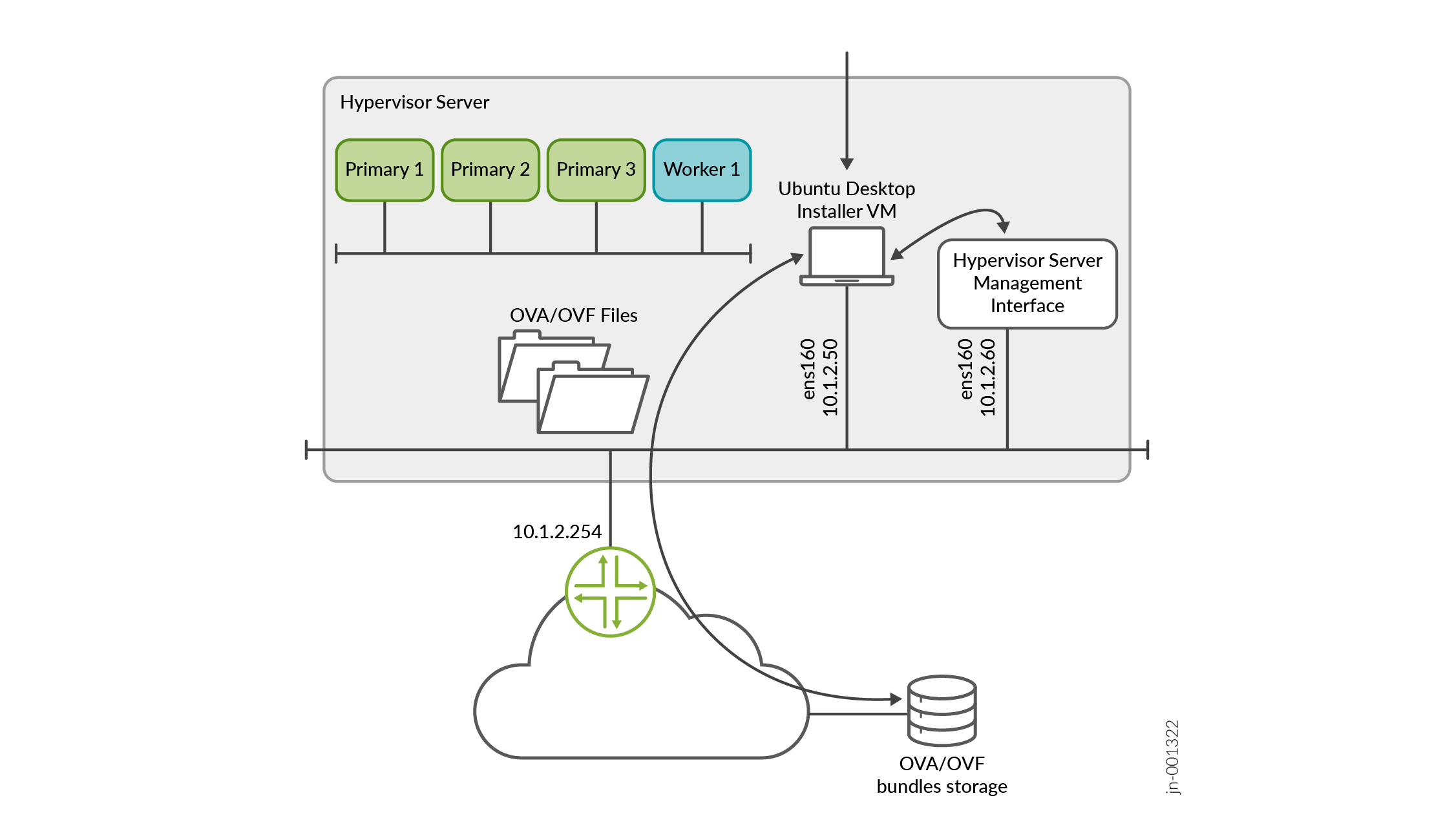

파일 크기가 커서 파일을 다운로드한 다음 컴퓨터에서 VM을 만드는 데 상당한 시간이 걸릴 수 있습니다. 따라서 Routing Director를 설치하려는 동일한 서버 또는 다른 서버에 기본 Ubuntu 데스크톱 VM이 될 수 있는 로컬 설치 관리자 VM을 만드는 것이 좋습니다. 이 로컬 설치 관리자 VM에 OVA 파일을 다운로드할 수 있어야 하며 VM에 파일을 저장할 공간이 충분해야 합니다. 그림 1과 같이 서버의 관리 IP 주소에 대한 연결을 구성합니다.

그림 1: OVA/OVF 파일을 다운로드할 로컬 설치 관리자 VM

다운로드할 로컬 설치 관리자 VM

또는 명령을 사용하여

wget "http://cdn.juniper.net/software/file-download-url/routing-director-2.7.0-build.ova"OVA를 하이퍼바이저에 직접 다운로드할 수 있습니다.(선택 사항) OVA 파일의 무결성을 검증합니다. Ubuntu 데스크톱을 사용하는 경우 다음 명령을 사용합니다.

root@ubuntu:~$ sha512sum routing-director-2.7.0-build.ova 7deda68aae8ba6399aa95d5365a659a8d579c5562811ebe588972cf0c5107337628370d78dcbdb56ab8ea97e73b7597f3a5ff06e9f501706bd8954b7454b86d2 routing-director-2.7.0-build.ova

화면에 표시된 숫자가 Juniper Routing Director 소프트웨어 다운로드 사이트에서 제공되는 SHA512 체크섬 번호와 동일한지 확인합니다. 체크섬을 클릭하여 유효한 SHA512 체크섬을 확인합니다.

ESXi 8.0에서

ESXi 8.0을 사용하는 경우 OVA를 직접 사용하여 VM을 생성할 수 있습니다.

OVA에서 OVF 및 .vmdk 파일을 추출하고 사용하여 VM을 생성할 수도 있습니다. 파일을 추출하려면 다음 명령을 사용합니다.

root@ubuntu:# tar -xvf routing-director-2.7.0-build.ova routing-director-2.7.0-build-disk1.vmdk routing-director.-2.7.0-disk2.vmdk routing-director-2.7.0.mf routing-director-2.7.0.ovf

설치 데스크톱에서 Windows를 실행 중인 경우 https://gnuwin32.sourceforge.net/packages/gtar.htm 에서 tar 유틸리티를 다운로드하고 사용하여 파일을 추출할 수 있습니다.

참고:vCenter가 없는 독립형 ESXi 8.0 서버를 사용하는 경우 VMware 호스트 클라이언트의 제한으로 인해 큰 OVA 파일을 클라이언트에 업로드할 수 없습니다. 이러한 경우 OVF 및 .vmdk 파일을 추출하고 사용하여 VM을 생성해야 합니다.

KVM 및 Proxmox VE에서

KVM을 사용하는 경우 명령을 사용하여 OVA에서 .vmdk 파일을 추출해야 합니다.

tar -xvf routing-director-2.7.0-build.ova이 문서의 나머지 부분에서는 OVA가 단일 KVM 서버에 다운로드되었다고 가정합니다. 서버가 여러 개인 경우 모든 서버에 파일을 다운로드합니다. 이 문서에 설명된 단계는 CLI 구축 방법을 사용하여 VM을 생성하기 위한 일반적인 지침입니다. 또한 GUI 기반 구축을 사용하고 하이퍼바이저 요구 사항에 맞게 단계를 변경할 수도 있습니다. 하이퍼바이저의 네트워크 구성은 이 문서의 범위를 벗어납니다.

이제 노드 VM을 만들 수 있습니다.

노드 VM 만들기

OVA 파일의 무결성을 확인한 후 노드 VM을 생성합니다. 다음 방법 중 하나를 사용하여 클러스터를 배포할 하이퍼바이저를 기반으로 노드 VM을 생성합니다.

ESXi 8.0에서

ESXi 8.0 하이퍼바이저에서 다음 단계를 수행합니다.

웹 브라우저에서 Routing Director를 설치할 VMware ESXi 8.0 서버에 연결하고 로그인합니다.

로컬 설치 관리자 VM을 사용하는 경우 VM의 브라우저를 사용하여 VMware ESXi 서버에 연결합니다.

노드 VM을 만듭니다.

다음 단계를 수행하여 VM을 만듭니다.

호스트 아이콘을 마우스 오른쪽 단추로 클릭하고 VM 만들기/등록을 선택합니다.

새 가상 머신 마법사가 나타납니다.

생성 유형 선택 페이지에서 OVF 또는 OVA 파일에서 가상 머신 배포를 선택합니다.

다음을 클릭합니다.

OVF 및 VMDK 파일 선택 페이지에서 노드 VM의 이름을 입력합니다.

OVA 파일(또는 OVF 및 .vmdk 파일)을 업로드하거나 끌어다 놓으려면 클릭합니다.

업로드할 파일 목록을 검토하고 다음을 클릭합니다.

스토리지 선택 페이지에서 노드 VM에 512GB SSD를 수용할 수 있는 적절한 데이터스토어를 선택합니다. SSD는 필수입니다.

다음을 클릭합니다. 파일 추출에는 몇 분 정도 걸립니다.

배포 옵션 페이지에서 다음을 수행합니다.

노드 VM이 연결할 가상 네트워크를 선택합니다.

씩 디스크 프로비저닝 옵션을 선택합니다.

VM의 전원을 자동으로 켜도록 설정합니다.

다음을 클릭합니다.

완료 준비 완료 페이지에서 VM 설정을 검토합니다.

마침을 클릭하여 노드 VM을 생성합니다.

기본 디스크 및 Ceph 스토리지 디스크의 크기를 늘립니다. 인벤토리 페이지에서 새로 생성된 VM을 마우스 오른쪽 버튼으로 클릭하고 가상 하드웨어> 설정 편집을 클릭합니다. 기본 디스크인 하드 디스크 1에 400GB를 입력하고 Ceph 스토리지 디스크인 하드 디스크 2에 100GB를 입력합니다.

VM의 전원을 켜려면 인벤토리 페이지에서 새로 생성된 VM을 마우스 오른쪽 버튼으로 클릭하고 전원 > 전원 켜기를 클릭합니다.

나머지 노드 VM에 대해 2.a-2.h단계를 반복합니다.

또는 VMware vCenter를 사용하는 경우 VM을 마우스 오른쪽 버튼으로 클릭하고 복제 > 가상 시스템에 복제 옵션을 클릭하여 새로 생성된 VM을 복제할 수 있습니다. VM을 세 번 복제하여 나머지 노드 VM을 만듭니다.

프롬프트 메시지가 표시되면 적절한 VM 이름을 입력합니다.

(선택 사항) 페이지 아래쪽의 최근 작업 섹션에서 VM 만들기 진행률을 확인합니다. VM이 생성되면 VMware Host Client 인벤토리의 [가상 시스템]에 표시됩니다.

모든 VM이 생성되면 VM의 사양이 올바르고 전원이 켜져 있는지 확인합니다.

노드 준비 단계를 완료하고 모든 VM을 생성했습니다. 클러스터를 구성하고 배포할 준비가 되었습니다. 클러스터 배포로 이동합니다.

KVM에서

Ubuntu 22.04.05 및 RHEL 8.10 호스트 OS의 KVM 하이퍼바이저에서 다음 단계를 수행합니다.

이 예에서는 다음 위치 및 명명 매개 변수를 사용하여 별도의 하이퍼바이저 서버에 클러스터를 배포합니다.

-

별도의 하이퍼바이저에서 다음 데이터 위치(SSD)에 각각 하나의 VM을 만듭니다.

-

VM1의 경우 /data/routing-director1

-

VM2의 경우 /data/routing-director2/

-

VM3의 경우 /data/routing-director3/

-

VM4의 경우 /data/routing-director4/

여기서 VM1, VM2, VM3 및 VM4는 4개의 클러스터 노드 VM입니다.

3개의 노드가 있는 클러스터를 만드는 경우 VM4 구성에 해당하는 모든 단계를 건너뜁니다.

-

-

VM1의 이름은 routing-director1, VM2의 이름은 routing-director2, VM3의 이름은 routing-director3, VM4의 이름은 routing-director4입니다.

-

각 VM에 대한 두 디스크 이미지의 이름은 routing-director-disk1.img 및 routing-director-disk2.img입니다. 각 VM의 두 디스크 이미지는 모두 해당 routing-directorx 디렉터리에 있습니다. x 여기서 VM 번호(1에서 4까지)는 입니다.

-

모든 VM의 경우 4노드 클러스터에서 CPU = 16, RAM = 32GB, 모드 = 호스트 CPU입니다.

모든 VM의 경우 3노드 클러스터에서 CPU = 24, RAM = 48GB, 모드 = 호스트 CPU입니다.

이는 각 노드 VM에 필요한 최소 하드웨어 리소스입니다.

-

VM은 브리지된 네트워크에 연결

br-ex됩니다.

다음 단계를 수행하여 노드 VM을 생성합니다.

KVM 하이퍼바이저 CLI에 로그인합니다.

필요한 libvirt, libvirt-daemon-kvm, qemu-kvm, bridge-utils 및 qemu-kvm 패키지가 설치되어 있는지 확인합니다.

및

dnf install libvirt libvirt-daemon-kvm qemu-kvm bridge-utils명령을 사용하여dnf update패키지를 설치합니다.-

파일을 원시 형식으로 변환

.vmdk합니다.root@kvm1:~/routing-director# qemu-img convert -O raw routing-director-2.7.0-build-disk1.vmdk routing-director-disk1.img root@kvm1:~/routing-director# qemu-img convert -O raw routing-director-2.7.0-disk2.vmdk routing-director-disk2.img root@kvm1:~/routing-director# ls -l total 111327724 -rw-r--r-- 1 root root 268435456000 Feb 13 16:23 routing-director-disk1.img -rw-r--r-- 1 root root 53687091200 Feb 13 16:23 routing-director-disk2.img -rw-r--r-- 1 64 64 34630534656 Feb 5 10:08 routing-director-2.7.0-build-disk1.vmdk -rw-r--r-- 1 64 64 74240 Feb 5 10:08 routing-director-2.7.0-disk2.vmdk -rw-r--r-- 1 64 64 394 Feb 5 09:26 routing-director-2.7.0.mf -rw-r--r-- 1 root root 34679057408 Feb 5 10:08 routing-director-2.7.0-build.ova -rw-r--r-- 1 64 64 10866 Feb 5 09:26 routing-director-2.7.0.ovf

디스크 크기를 조정하고 확장합니다.

root@kvm1:~/routing-director# qemu-img resize -f raw routing-director-disk1.img 400G Image resized. root@kvm1:~/routing-director# qemu-img resize -f raw routing-director-disk2.img 100G Image resized. root@kvm1:~/routing-director# ls -l total 111327724 -rw-r--r-- 1 root root 322122547200 Feb 13 16:23 routing-director-disk1.img -rw-r--r-- 1 root root 80530636800 Feb 13 16:23 routing-director-disk2.img -rw-r--r-- 1 64 64 34630534656 Feb 5 10:08 routing-director-2.7.0-build-disk1.vmdk -rw-r--r-- 1 64 64 74240 Feb 5 10:08 routing-director-2.7.0-disk2.vmdk -rw-r--r-- 1 64 64 394 Feb 5 09:26 routing-director-2.7.0.mf -rw-r--r-- 1 root root 34679057408 Feb 5 10:08 routing-director-2.7.0-build.ova -rw-r--r-- 1 64 64 10866 Feb 5 09:26 routing-director-2.7.0.ovf

VM 파일을 배치할 폴더를 만듭니다.

예를 들어 VM1의 경우 /data/routing-director1/ 입니다.

다른 하이퍼바이저에 로그인하여 클러스터의 나머지 노드 VM에 대해 1-5단계를 반복합니다. 각 VM에 대해 적절한 폴더를 만듭니다. 예를 들어:

VM2의 경우 /data/routing-director2/

VM3의 경우 /data/routing-director3/

VM4의 경우 /data/routing-director4/

3노드 클러스터를 만드는 경우 이 폴더를 건너뜁니다.

복사 명령을 사용하여 원시 디스크 이미지와

routing-director-disk2.img원시 디스크 이미지를 모두routing-director-disk1.img각 VM의 위치에 복사합니다cp. 예를 들면 .root@kvm1:~/routing-director# cp routing-director-disk1.img /data/routing-director1/모든 파일이 복사되면 폴더와 파일 구조는 다음과 유사해집니다.

root@kvm1:~/routing-director# ls -l /data/routing-director1 total 39852200 -rw-r--r-- 1 root root 322122547200 Feb 28 05:45 routing-director-disk1.img -rw-r--r-- 1 root root 80530636800 Feb 13 16:30 routing-director-disk2.img

root@kvm2:~/routing-director# ls -l /data/routing-director2 total 39852200 -rw-r--r-- 1 root root 322122547200 Feb 28 05:45 routing-director-disk1.img -rw-r--r-- 1 root root 80530636800 Feb 13 16:30 routing-director-disk2.img

root@kvm3:~/routing-director# ls -l /data/routing-director3 total 39852200 -rw-r--r-- 1 root root 322122547200 Feb 28 05:45 routing-director-disk1.img -rw-r--r-- 1 root root 80530636800 Feb 13 16:30 routing-director-disk2.img

root@kvm4:~/routing-director# ls -l /data/routing-director4 total 39852200 -rw-r--r-- 1 root root 322122547200 Feb 28 05:45 routing-director-disk1.img -rw-r--r-- 1 root root 80530636800 Feb 13 16:30 routing-director-disk2.img

각 VM을 구성하기 위한 XML 파일을 생성하고 사용자 지정합니다. Ubuntu와 RHEL에 대해 서로 다른 XML 파일을 생성해야 합니다. 호스트 OS에 기반한 XML 파일의 주목할 만한 차이점은 다음과 같습니다.

Ubuntu 22.04.05의 경우 - 머신 유형은 이고

pc-q35-jammy에뮬레이터 바이너리는/usr/bin/qemu-system-x86_64RHEL 8.10의 경우 머신 유형은 이고

q35에뮬레이터 바이너리는/usr/libexec/qemu-kvm

4노드 클러스터의 노드에 대한 Ubuntu용 샘플 XML 파일은 다음과 같습니다.

<domain type='kvm'> <!-- Specify VM name here --> <name>routing-director1</name> <!-- Specify VM RAM size here --> <memory unit='KiB'>33554432</memory> <currentMemory unit='KiB'>33554432</currentMemory> <!-- Specify number of vcpu for the VM here --> <vcpu placement='static'>16</vcpu> <!-- For Ubuntu 22.04 KVM use pc-q35-jammy as machine type For RHEL 8.10 KVM use q53 as machine type --> <os> <type arch='x86_64' machine='pc-q35-jammy'>hvm</type> </os> <features> <acpi/> <apic/> <vmport state='off'/> </features> <cpu mode='host-passthrough' check='none' migratable='on'/> <clock offset='utc'> <timer name='rtc' tickpolicy='catchup'/> <timer name='pit' tickpolicy='delay'/> <timer name='hpet' present='no'/> </clock> <on_poweroff>destroy</on_poweroff> <on_reboot>restart</on_reboot> <on_crash>destroy</on_crash> <pm> <suspend-to-mem enabled='no'/> <suspend-to-disk enabled='no'/> </pm> <devices> <!-- For Ubuntu 22.04 KVM use /usr/bin/qemu-system-x86_64 as emulator For RHEL 8.10 KVM use /usr/libexec/qemu-kvm as emulator --> <emulator>/usr/bin/qemu-system-x86_64</emulator> <disk type='file' device='disk'> <driver name='qemu' type='raw' cache='none' discard='ignore'/> <!-- Specify the path to the 1st virtual disk for the main disk --> <source file='/data/routing-director1/routing-director-disk1.img'/> <target dev='vda' bus='virtio'/> <boot order='1'/> <address type='pci' domain='0x0000' bus='0x05' slot='0x00' function='0x0'/> </disk> <disk type='file' device='disk'> <driver name='qemu' type='raw' cache='none' discard='ignore'/> <!-- Specify the path to the 2nd virtual disk for the CEPH OSD disk --> <source file='/data/routing-director1/routing-director-disk2.img'/> <target dev='vdb' bus='virtio'/> <address type='pci' domain='0x0000' bus='0x06' slot='0x00' function='0x0'/> </disk> <controller type='usb' index='0' model='qemu-xhci' ports='15'> <address type='pci' domain='0x0000' bus='0x02' slot='0x00' function='0x0'/> </controller> <controller type='scsi' index='0' model='virtio-scsi'> <address type='pci' domain='0x0000' bus='0x03' slot='0x00' function='0x0'/> </controller> <controller type='sata' index='0'> <address type='pci' domain='0x0000' bus='0x00' slot='0x1f' function='0x2'/> </controller> <controller type='virtio-serial' index='0'> <address type='pci' domain='0x0000' bus='0x04' slot='0x00' function='0x0'/> </controller> <interface type='bridge'> <!-- Specify the linux bridge name for the VM to attach to --> <source bridge='br-ex'/> <model type='virtio'/> <address type='pci' domain='0x0000' bus='0x01' slot='0x00' function='0x0'/> </interface> <serial type='pty'> <target type='isa-serial' port='0'> <model name='isa-serial'/> </target> </serial> <console type='pty'> <target type='serial' port='0'/> </console> <channel type='unix'> <target type='virtio' name='org.qemu.guest_agent.0'/> <address type='virtio-serial' controller='0' bus='0' port='1'/> </channel> <input type='keyboard' bus='ps2'/> <!-- Specify the TCP port for VNC access for GUI console access The port number should be uniq and unused TCP port. KVM can also allocate dynamic port by setting port='' and autoport='yes' --> <graphics type='vnc' port='5911' autoport='no' listen='0.0.0.0'> <listen type='address' address='0.0.0.0'/> </graphics> <video> <model type='qxl' ram='65536' vram='65536' vgamem='16384' heads='1' primary='yes'/> <address type='pci' domain='0x0000' bus='0x00' slot='0x01' function='0x0'/> </video> <memballoon model='virtio'> <address type='pci' domain='0x0000' bus='0x07' slot='0x00' function='0x0'/> </memballoon> <rng model='virtio'> <backend model='random'>/dev/urandom</backend> <address type='pci' domain='0x0000' bus='0x08' slot='0x00' function='0x0'/> </rng> </devices> </domain>이 파일을 /root/routing-director/routing-director1.xml로 저장합니다. 이 예제에서는 다음과 같습니다.

VM1은 routing-director1에 해당합니다.

VM1 CPU = 16, VM1 RAM = 32GB, VM1 모드 = 호스트 CPU(4노드 클러스터)입니다. 3노드 클러스터의 경우 이 값을 CPU = 24, RAM = 48GB로 변경합니다.

VM1에는 /data/routing-director1/routing-director-disk1.img 및 /data/routing-director1/routing-director-disk2.img에 두 개의 이미지 디스크 이미지가 있습니다

VM은 이름

br-ex으로 브리지된 네트워크에 연결됩니다.그래픽 콘솔용 VNC 포트는 포트 5911에서 수신하고 있습니다. 포트

autoport='yes'를 동적으로 할당하려면 .

4노드 클러스터의 노드에 대한 RHEL 8.10의 샘플 XML 파일은 다음과 같습니다.

<domain type='kvm'> <!-- Specify VM name here --> <name>routing-director1</name> <!-- Specify VM RAM size here --> <memory unit='KiB'>33554432</memory> <currentMemory unit='KiB'>33554432</currentMemory> <!-- Specify number of vcpu for the VM here --> <vcpu placement='static'>16</vcpu> <!-- For Ubuntu 22.04 KVM use pc-q35-jammy as machine type For RHEL 8.10 KVM use q53 as machine type --> <os> <type arch='x86_64' machine='q35'>hvm</type> </os> <features> <acpi/> <apic/> <vmport state='off'/> </features> <cpu mode='host-passthrough' check='none' migratable='on'/> <clock offset='utc'> <timer name='rtc' tickpolicy='catchup'/> <timer name='pit' tickpolicy='delay'/> <timer name='hpet' present='no'/> </clock> <on_poweroff>destroy</on_poweroff> <on_reboot>restart</on_reboot> <on_crash>destroy</on_crash> <pm> <suspend-to-mem enabled='no'/> <suspend-to-disk enabled='no'/> </pm> <devices> <!-- For Ubuntu 22.04 KVM use /usr/bin/qemu-system-x86_64 as emulator For RHEL 8.10 KVM use /usr/libexec/qemu-kvm as emulator --> <emulator>/usr/libexec/qemu-kvm</emulator> <disk type='file' device='disk'> <driver name='qemu' type='raw' cache='none' discard='ignore'/> <!-- Specify the path to the 1st virtual disk for the main disk --> <source file='/data/routing-director1/routing-director-disk1.img'/> <target dev='vda' bus='virtio'/> <boot order='1'/> <address type='pci' domain='0x0000' bus='0x05' slot='0x00' function='0x0'/> </disk> <disk type='file' device='disk'> <driver name='qemu' type='raw' cache='none' discard='ignore'/> <!-- Specify the path to the 2nd virtual disk for the CEPH OSD disk --> <source file='/data/routing-director1/routing-director-disk2.img'/> <target dev='vdb' bus='virtio'/> <address type='pci' domain='0x0000' bus='0x06' slot='0x00' function='0x0'/> </disk> <controller type='usb' index='0' model='qemu-xhci' ports='15'> <address type='pci' domain='0x0000' bus='0x02' slot='0x00' function='0x0'/> </controller> <controller type='scsi' index='0' model='virtio-scsi'> <address type='pci' domain='0x0000' bus='0x03' slot='0x00' function='0x0'/> </controller> <controller type='sata' index='0'> <address type='pci' domain='0x0000' bus='0x00' slot='0x1f' function='0x2'/> </controller> <controller type='virtio-serial' index='0'> <address type='pci' domain='0x0000' bus='0x04' slot='0x00' function='0x0'/> </controller> <interface type='bridge'> <!-- Specify the linux bridge name for the VM to attach to --> <source bridge='br-ex'/> <model type='virtio'/> <address type='pci' domain='0x0000' bus='0x01' slot='0x00' function='0x0'/> </interface> <serial type='pty'> <target type='isa-serial' port='0'> <model name='isa-serial'/> </target> </serial> <console type='pty'> <target type='serial' port='0'/> </console> <channel type='unix'> <target type='virtio' name='org.qemu.guest_agent.0'/> <address type='virtio-serial' controller='0' bus='0' port='1'/> </channel> <input type='keyboard' bus='ps2'/> <!-- Specify the TCP port for VNC access for GUI console access The port number should be uniq and unused TCP port. KVM can also allocate dynamic port by setting port='' and autoport='yes' --> <graphics type='vnc' port='5911' autoport='no' listen='0.0.0.0'> <listen type='address' address='0.0.0.0'/> </graphics> <video> <model type='qxl' ram='65536' vram='65536' vgamem='16384' heads='1' primary='yes'/> <address type='pci' domain='0x0000' bus='0x00' slot='0x01' function='0x0'/> </video> <memballoon model='virtio'> <address type='pci' domain='0x0000' bus='0x07' slot='0x00' function='0x0'/> </memballoon> <rng model='virtio'> <backend model='random'>/dev/urandom</backend> <address type='pci' domain='0x0000' bus='0x08' slot='0x00' function='0x0'/> </rng> </devices> </domain>이 파일을 /root/routing-director/routing-director1.xml로 저장합니다. 이 예제에서는 다음과 같습니다.

VM1은 routing-director1에 해당합니다.

VM1 CPU = 16, VM1 RAM = 32GB, VM1 모드 = 호스트 CPU(4노드 클러스터)입니다. 3노드 클러스터의 경우 이 값을 CPU = 24, RAM = 48GB로 변경합니다.

VM1에는 /data/routing-director1/routing-director-disk1.img 및 /data/routing-director1/routing-director-disk2.img에 두 개의 이미지 디스크 이미지가 있습니다

VM은 이름으로 브리지된 네트워크에 연결됩니다.

br-ex그래픽 콘솔용 VNC 포트는 포트 5911에서 수신하고 있습니다. 포트

autoport='yes'를 동적으로 할당하려면 .

XML 파일을 사용하여 VM을 정의합니다.

root@kvm1:~/routing-director# virsh define routing-director1.xml Domain 'routing-director1' defined from routing-director1.xml

VM이 등록되었는지 확인합니다.

root@kvm1:~/routing-director# virsh list --all Id Name State ----------------------------------- - routing-director1 shut off

KVM이 재부팅된 경우 VM을 설정합니다.

autostartroot@kvm1:~/routing-director# virsh autostart routing-director1 Domain 'routing-director1' marked as autostarted

VM의 전원을 켭니다.

root@kvm1:~/routing-director# virsh start routing-director1 Domain 'routing-director1' started

다음 방법 중 하나로 VM 콘솔에 연결합니다.

시리얼 콘솔 사용.

직렬 콘솔을 사용하여 VM에 연결합니다.

root@kvm1:~/routing-director# virsh console routing-director1 Connected to domain 'routing-director1' Escape character is ^] (Ctrl + ]) OK ] Listening on Journal Socket. [ 6.635248] systemd[1]: Listening on Network Service Netlink Socket. [ OK ] Listening on Network Service Netlink Socket. [ 6.640195] systemd[1]: Listening on udev Control Socket. [ OK ] Listening on udev Control Socket. [ 6.646190] systemd[1]: Listening on udev Kernel Socket. [ OK ] Listening on udev Kernel Socket. [ 6.651480] systemd[1]: Mounting Huge Pages File System... ... ... [ OK ] Reached target Login Prompts. [ OK ] Reached target Multi-User System. [ OK ] Reached target Graphical Interface. Starting Record Runlevel Change in UTMP... [ OK ] Finished Record Runlevel Change in UTMP. epic login:VNC 클라이언트 사용.

VNC 호환 클라이언트를 사용하고 에 연결합니다.

kvm-ip::5911방화벽이 컴퓨터와 VM 간의 통신을 위해 포트 5911을 허용하는지 확인합니다.

나머지 VM에 대해 8-13단계를 반복합니다.

나머지 VM에 대한 XML 파일을 만들 때 VM 이름과 디스크 위치를 적절하게 변경합니다. 또한 각 VM에 대한 그래픽 콘솔 포트 번호를 변경합니다.

(선택 사항) 클러스터가 성공적으로 배포되면 하이퍼바이저에서 .vmdk 및 .ova 파일을 삭제하여 공간을 확보할 수 있습니다.

노드 준비 단계를 완료하고 모든 VM을 생성했습니다. 클러스터를 구성하고 배포할 준비가 되었습니다. 클러스터 배포로 이동합니다.

Proxmox VE에서

Proxmox VE 하이퍼바이저에서 다음 단계를 수행합니다.

이 예에서는 세 개의 프로비저닝된 데이터스토어(data0, data1 및 data2)가 있는 단일 서버에 Routing Director를 설치합니다. data0은 OVA 파일을 저장하는 데 사용되며, data1은 첫 번째 디스크 이미지를 저장하는 데 사용되며, data2는 두 번째 디스크 이미지를 저장하는 데 사용됩니다. VM의 이름은 VM1, VM2, VM3 및 VM4입니다. 또한 클러스터를 구축하는 데 필요한 최소한의 하드웨어 리소스도 구성하고 있습니다.

시스템에 디스크가 하나만 있는 경우 data0, data1, data2 등과 같은 표준 권장 파일 시스템/디렉터리 대신 LVM을 사용해야 합니다. importdisk 명령과 qm set 디스크의 명령은 저장 공간의 차이로 인해 아래 나열된 명령과 다르게 보입니다.

예를 들어:

-

qm importdisk 100 routing-director-2.7.0-disk1.vmdk local-lvm -

qm set 100 -virtio0 local-lvm:vm-404-disk-0,backup=0,replicate=no,discard=on,iothread=on -

qm set 100 -virtio0 local-lvm:vm-404-disk-1,backup=0,replicate=no,discard=on,iothread=on

다음 단계를 수행하여 노드 VM을 생성합니다.

Proxmox VE 서버 CLI에 로그인합니다.

directory 메서드를 사용하여 data0, data1 및 data2 데이터스토어를 생성합니다.

XFS 또는 EXT4 중 하나를 사용할 수 있습니다. EXT4는 성능이 약간 더 좋고 계획되지 않은 재부팅에서도 더 잘 살아남기 때문에 EXT4를 사용하는 것이 좋습니다.

OVA를 data0 데이터스토어에 복사하고 .vmdk 파일을 추출합니다.

이 예에서는 data0에 ova 라는 폴더를 만들고, routing-director-2.7.0-build.ova 파일을 ova 폴더에 복사한 다음, 명령을

tar -xvf routing-director-2.7.0-build.ova사용하여 파일을 추출했습니다.VirtIO 네트워크 인터페이스(net0)를 사용하여 첫 번째 VM을 생성하고 VM 이름, ID 및 메모리를 구성합니다.

root@proxmox:# qm create 100 --memory 32768 --name VM1 --net0 virtio,bridge=vmbr0

여기서 VM ID는 100이고, VM 이름은

VM1이며, VM 메모리는 4노드 클러스터의 경우 32GB입니다. 3노드 클러스터의 경우 메모리를 48GB로 변경합니다.VM ID가 고유 식별자이며 동일한 서버 또는 동일한 Proxmox 클러스터에 있는 다른 VM과 공유되지 않는지 확인하십시오.

4노드 클러스터의 경우 총 vCPU 수를 16개로 구성합니다. 클러스터에 3개의 노드가 있는 경우 24개의 vCPU를 구성합니다.

root@proxmox# qm set 100 --sockets 2 update VM 100: -sockets 2 root@proxmox# qm set 100 --cores 8 update VM 100: -cores 8

VM에 대한 스토리지를 구성합니다.

root@proxmox# qm set 100 -scsihw virtio-scsi-single update VM 100: -scsihw virtio-scsi-single

CPU 유형을 호스트로 구성합니다.

root@proxmox# qm set 100 --cpu cputype=host update VM 100: -cpu cputype=host

data0/ova 폴더로 이동합니다.

디스크 1을 원시 이미지로 VM으로 가져옵니다. 여기에서 routing-director-2.7.0-build-disk1.vmdk 파일을 data1 데이터스토어로 가져옵니다.

root@proxmox:/mnt/pve/data0/ova# qm importdisk 100 routing-director-2.7.0-build-disk1.vmdk data1 importing disk 'routing-director-2.7.0-build-disk1.vmdk' to VM 100 ... Formatting '/mnt/pve/data1/images/100/vm-100-disk-0.raw', fmt=raw size=268435456000 preallocation=off transferred 0.0 B of 250.0 GiB (0.00%) transferred 2.5 GiB of 250.0 GiB (1.00%) transferred 5.0 GiB of 250.0 GiB (2.00%) transferred 7.5 GiB of 250.0 GiB (3.00%) ... <output snipped> ... transferred 250.0 GiB of 250.0 GiB (100.00%) unused0: successfully imported disk 'data1:100/vm-100-disk-0.raw'

디스크 2를 원시 이미지로 VM으로 가져옵니다. 여기에서 routing-director-2.7.0-disk2.vmdk 파일을 data2 데이터스토어로 가져옵니다.

root@proxmox:/mnt/pve/data0/ova# qm importdisk 100 routing-director-2.7.0-disk2.vmdk data2 importing disk 'routing-director-2.7.0-build-.vmdk' to VM 100 ... Formatting '/mnt/pve/data2/images/100/vm-100-disk-0.raw', fmt=raw size=53687091200 preallocation=off transferred 0.0 B of 50.0 GiB (0.00%) transferred 50.0 GiB of 50.0 GiB (100.00%) unused1: successfully imported disk 'data2:100/vm-100-disk-0.raw'

원시 디스크를 virtio0 및 virtio1에 할당하고 IO 스레드, 백업, 삭제 및 복제 옵션을 구성합니다.

디스크가 동일한 데이터스토어에 있는 경우 disk-0 및 disk-1이 되고, data1 및 data2와 같은 여러 데이터 저장소를 사용하는 경우 두 디스크는 해당 특정 데이터스토어에서 ID 100에 할당된 첫 번째 디스크이므로 disk-0이 됩니다.

root@proxmox:/mnt/pve/data0/ova# qm set 100 -virtio0 data1:100/vm-100-disk-0.raw,backup=0,replicate=no,discard=on,iothread=on update VM 100: -virtio0 data1:100/vm-100-disk-0.raw,backup=0,replicate=no,discard=on,iothread=on root@proxmox:/mnt/pve/data0/ova# qm set 100 -virtio1 data2:100/vm-100-disk-0.raw,backup=0,replicate=no,discard=on,iothread=on update VM 100: -virtio1 data2:100/vm-100-disk-0.raw,backup=0,replicate=no,discard=on,iothread=on

VM에 대한 부팅 디바이스를 할당합니다.

root@proxmox:/mnt/pve/data0/ova# qm set 100 --boot c --bootdisk virtio0 update VM 100: -boot c -bootdisk virtio0

디스크 1은 기본 부팅 장치이고 디스크 2는 Ceph 스토리지에 사용됩니다.

(선택 사항) VM을 비벌루닝 디바이스로 구성합니다.

root@proxmox:/mnt/pve/data0/ova# qm set 100 --balloon 0 update VM 100: -balloon 0

(선택 사항) OS용 GUI를 사용하지 않는 경우 태블릿을 0으로 설정하여 CPU와 메모리를 절약하십시오.

root@proxmox:/mnt/pve/data0/ova# qm set 100 --tablet 0 update VM 100: -tablet 0

(선택 사항) 디스플레이 옵션을 표준 VGA로 설정하여 CPU 및 메모리를 절약합니다.

root@proxmox:/mnt/pve/data0/ova# qm set 100 --vga std update VM 100: -vga std

(선택 사항) CLI를 사용하여 VM 콘솔에 연결하려면 소켓을 사용하여 시리얼 터미널을 구성합니다.

root@proxmox:/mnt/pve/data0/ova# qm set 100 --serial0 socket update vm 100: -serial0 socket

기본 부팅 및 Ceph 디스크 모두에 대한 디스크 크기를 구성합니다.

Proxmox VE GUI에 로그인합니다.

VM1을 선택하고 하드웨어를 클릭합니다.

Hard Disk(virtio0)를 선택하고 Disk Action > Resize를 클릭합니다.

디스크 크기를 400GB로 조정합니다. 현재 디스크 크기는 250GB(크기=250G)여야 합니다. 크기를 총 400GB로 늘리려면 크기 증분(GiB) 에 150을 입력하고 디스크 크기 조정을 클릭합니다.

Hard Disk(virtio1)를 선택하고 Disk Action > Resize를 클릭합니다.

디스크 크기를 100GB로 조정합니다. 현재 디스크 크기는 50GB(크기=50G)여야 합니다. 크기를 총 100GB로 늘리려면 크기 증분(GiB) 에 50을 입력하고 디스크 크기 조정을 클릭합니다.

VM의 전원을 켭니다.

root@proxmox:/mnt/pve/data0/ova# qm start 100

VM 콘솔을 시작합니다.

CLI 사용 - 직렬 터미널을 구성한 경우 다음 명령을 사용하여 CLI를 통해 VM 콘솔에 액세스할 수 있습니다.

root@proxmox:/mnt/pve/data0/ova# qm terminal 100

VM 콘솔이 나타납니다.

GUI 사용 - Proxmox VE GUI에 로그인합니다. 전원이 켜진 VM1을 선택하고 >_ 콘솔을 클릭합니다. VM 콘솔이 나타납니다.

나머지 VM에 대해 4-19단계를 반복합니다. 적절한 고유 VM ID 및 이름을 입력합니다.

노드 준비 단계를 완료하고 모든 VM을 생성했습니다. 클러스터를 구성하고 배포할 준비가 되었습니다. 클러스터 배포로 이동합니다.