Sur cette page

Configuration du délai avant que les voisins LDP ne soient considérés comme inactifs

Configuration de l’intervalle pour les messages persistants LDP

Exemple : Configuration de la correspondance la plus longue pour LDP

Adresse de transport de contrôle utilisée pour la session LDP ciblée

Configuration des préfixes annoncés dans LDP à partir de la table de routage

Configuration d’une action d’échec pour la session BFD sur un LSP LDP

Configuration de l’intervalle de retenue pour la session BFD

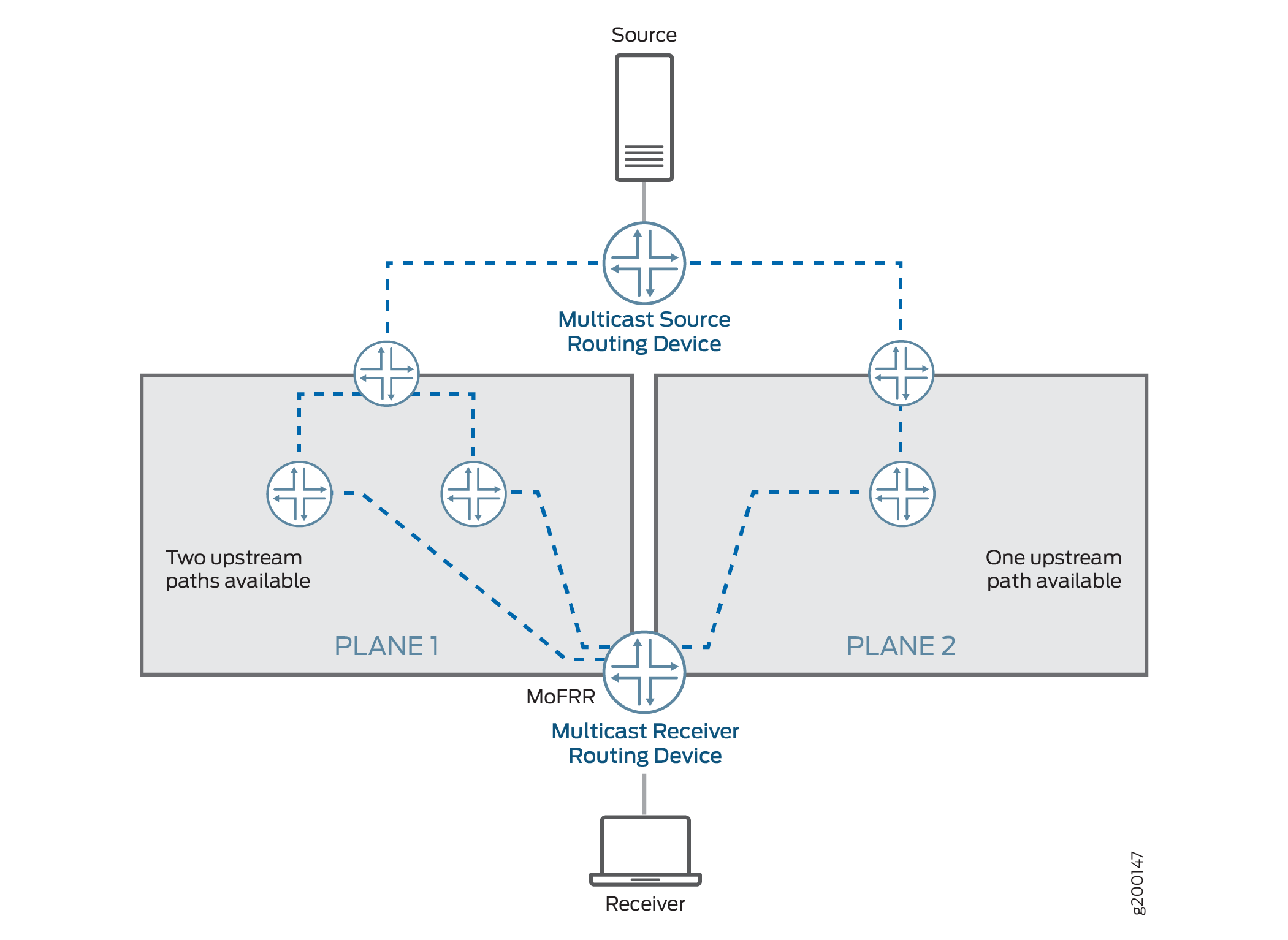

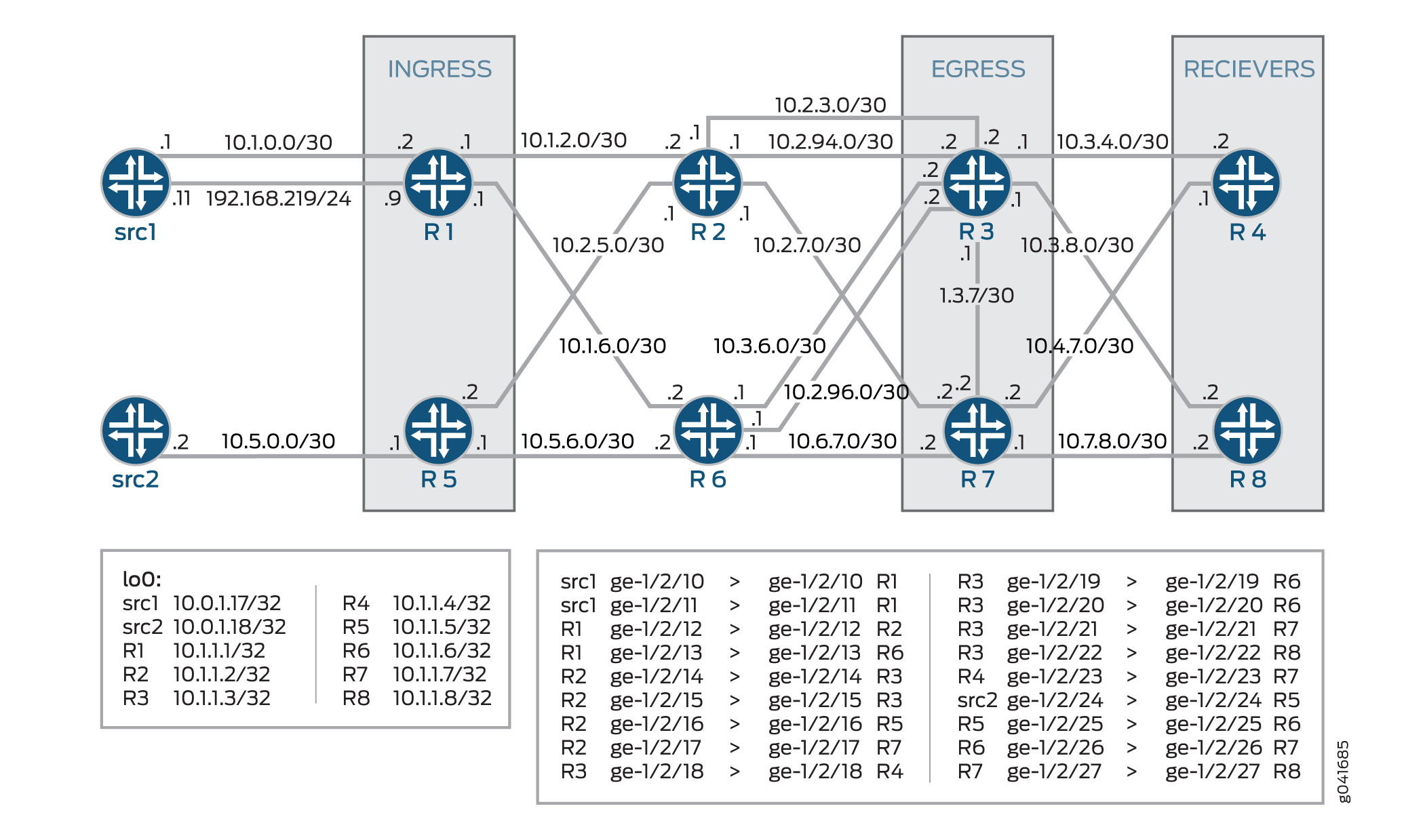

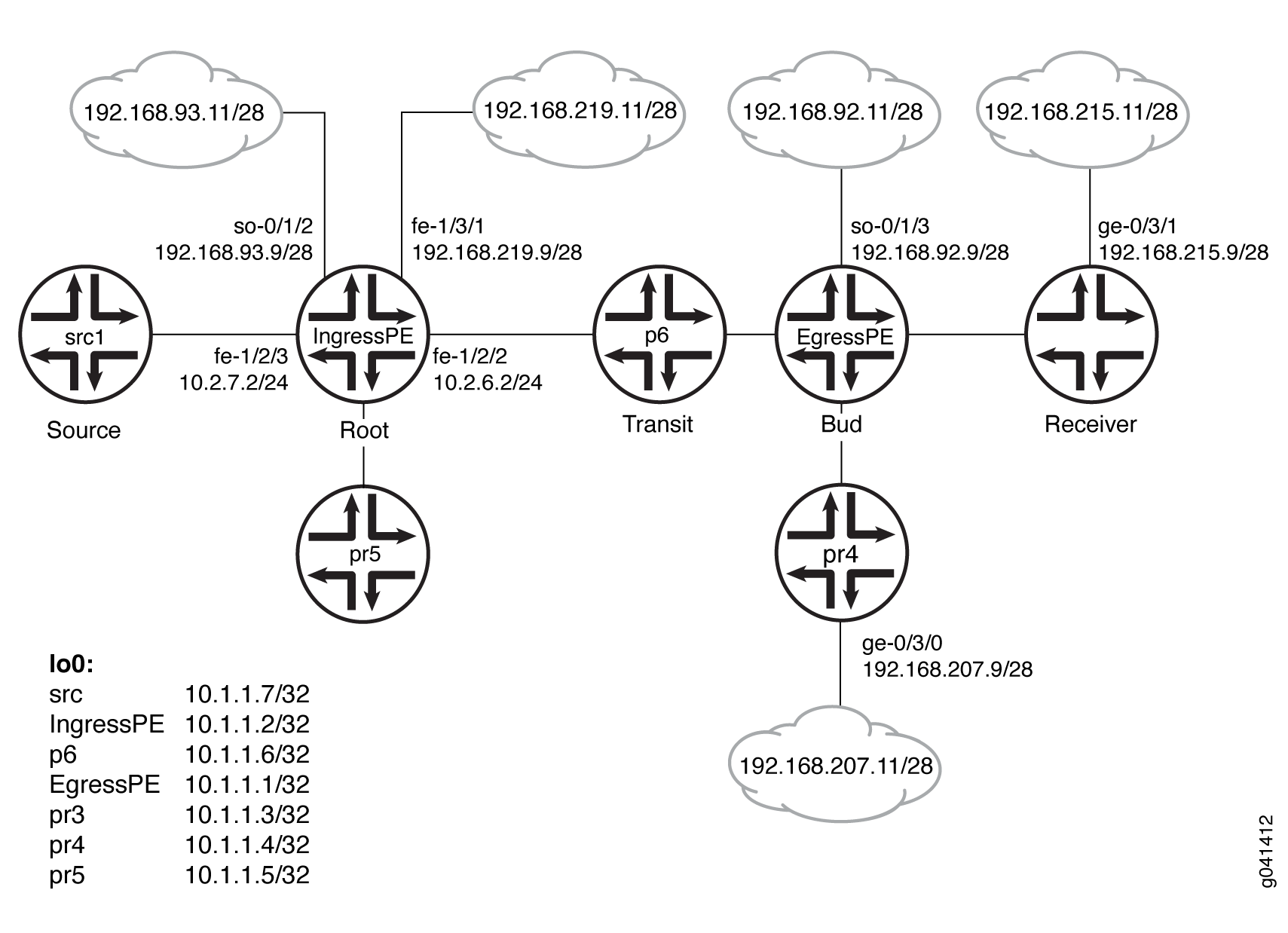

Exemple : Configuration du reroutage rapide multicast uniquement dans un domaine LDP multipoint

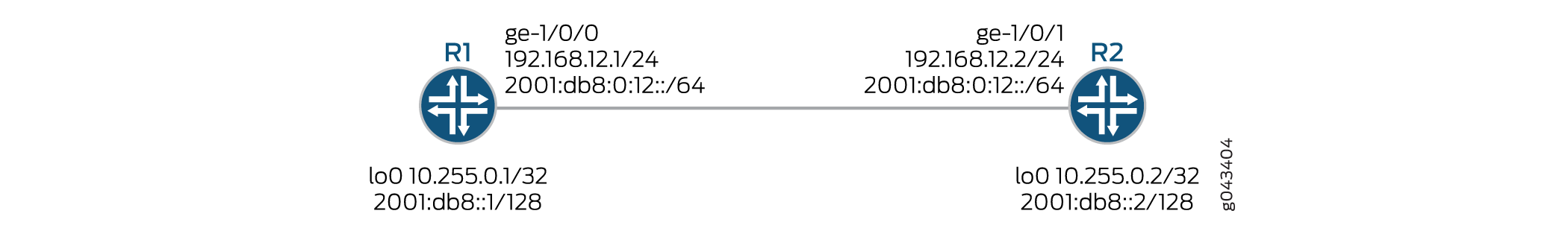

Exemple : Configuration de la prise en charge IPv6 native LDP

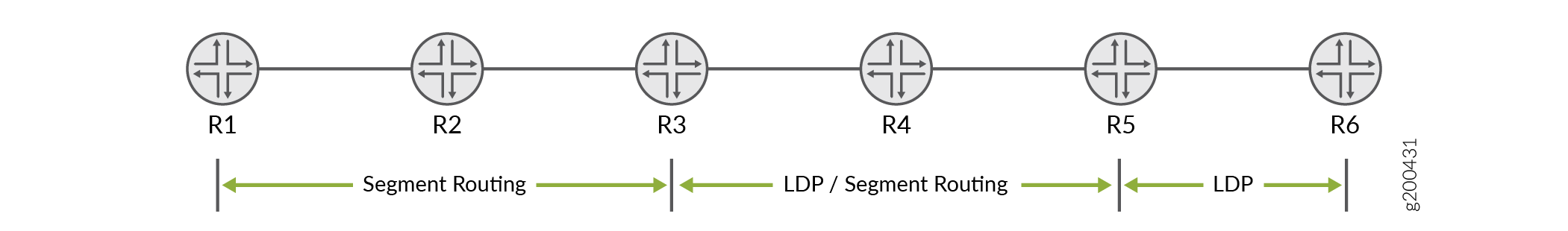

Mappage du client et du serveur pour l’interopérabilité Segment Routing à LDP

LDP Configuration

Configuration LDP minimale

Pour activer LDP avec une configuration minimale :

Activez toutes les interfaces pertinentes dans la famille MPLS. Dans le cas d’un LDP dirigé, l’interface de bouclage doit être activée avec la famille MPLS.

(Facultatif) Configurez les interfaces appropriées au niveau de la

[edit protocol mpls]hiérarchie.Activez LDP sur une seule interface, incluez l’instruction

ldpet spécifiez l’interface à l’aide de l’instructioninterface.

Il s’agit de la configuration LDP minimale. Toutes les autres instructions de configuration LDP sont facultatives.

ldp { interface interface-name; }

Pour activer LDP sur toutes les interfaces, spécifiez all pour interface-name.

Pour obtenir la liste des niveaux hiérarchiques auxquels vous pouvez inclure ces relevés, reportez-vous aux sections récapitulatives des relevés.

Activation et désactivation de LDP

LDP est conscient des instances de routage. Pour activer LDP sur une interface spécifique, incluez les instructions suivantes :

ldp { interface interface-name; }

Pour obtenir la liste des niveaux hiérarchiques auxquels vous pouvez inclure ces relevés, reportez-vous aux sections récapitulatives des relevés.

Pour activer LDP sur toutes les interfaces, spécifiez all pour interface-name.

Si vous avez configuré des propriétés d’interface sur un groupe d’interfaces et que vous souhaitez désactiver LDP sur l’une d’elles, incluez l’instruction interface avec l’option disable :

interface interface-name { disable; }

Pour obtenir la liste des niveaux hiérarchiques auxquels vous pouvez inclure cette instruction, reportez-vous à la section Résumé de la déclaration.

Configuration du minuteur LDP pour Hello Messages

Les messages Hello LDP permettent aux nœuds LDP de se découvrir les uns les autres et de détecter la défaillance d’un voisin ou le lien avec le voisin. Des messages Hello sont envoyés périodiquement sur toutes les interfaces sur lesquelles LDP est activé.

Il existe deux types de messages de bonjour LDP :

Link hello messages : envoyés via l’interface LDP sous forme de paquets UDP adressés au port de découverte LDP. La réception d’un message de bonjour de lien LDP sur une interface identifie une contiguïté avec le routeur homologue LDP.

Messages d’accueil ciblés : envoyés sous forme de paquets UDP adressés au port de découverte LDP à une adresse spécifique. Les messages hello ciblés sont utilisés pour prendre en charge les sessions LDP entre des routeurs qui ne sont pas directement connectés. Un routeur ciblé détermine s’il doit répondre ou ignorer un message de bonjour ciblé. Un routeur ciblé qui choisit de répondre le fait en renvoyant périodiquement des messages de bonjour ciblés au routeur à l’origine.

Par défaut, LDP envoie des messages hello toutes les 5 secondes pour les messages hello de lien et toutes les 15 secondes pour les hello messages ciblés. Vous pouvez configurer le minuteur LDP pour modifier la fréquence d’envoi des deux types de messages hello. Toutefois, vous ne pouvez pas configurer une heure pour le minuteur LDP supérieure à la durée de maintien LDP. Pour plus d’informations, reportez-vous à la section Configuration du délai avant que les voisins LDP ne soient considérés comme inactifs.

- Configuration du minuteur LDP pour les messages Link Hello

- Configuration du minuteur LDP pour les messages Hello ciblés

Configuration du minuteur LDP pour les messages Link Hello

Pour modifier la fréquence à laquelle LDP envoie des messages hello de lien, spécifiez un nouvel intervalle de message hello link pour le temporisateur LDP à l’aide de l’instruction hello-interval suivante :

hello-interval seconds;

Pour obtenir la liste des niveaux hiérarchiques auxquels vous pouvez inclure cette instruction, reportez-vous à la section Résumé de cette instruction.

Configuration du minuteur LDP pour les messages Hello ciblés

Pour modifier la fréquence à laquelle LDP envoie des messages hello ciblés, spécifiez un nouvel intervalle de hello message ciblé pour le temporisateur LDP en configurant l’instruction hello-interval en tant qu’option pour l’instruction targeted-hello :

targeted-hello { hello-interval seconds; }

Pour obtenir la liste des niveaux hiérarchiques auxquels vous pouvez inclure ces instructions, reportez-vous aux sections de résumé des instructions pour ces instructions.

Configuration du délai avant que les voisins LDP ne soient considérés comme inactifs

Le temps d’attente détermine combien de temps un nœud LDP doit attendre un message de bonjour avant de déclarer qu’un voisin est en panne. Cette valeur est envoyée dans le cadre d’un message hello afin que chaque nœud LDP indique à ses voisins combien de temps attendre. Il n’est pas nécessaire que les valeurs envoyées par chaque voisin correspondent.

Le temps d’attente doit normalement être d’au moins trois fois l’intervalle hello. La valeur par défaut est de 15 secondes pour les messages de bonjour de lien et de 45 secondes pour les messages de bonjour ciblés. Cependant, il est possible de configurer un temps de maintien LDP proche de la valeur de l’intervalle hello.

En configurant un temps de maintien LDP proche de l’intervalle hello (moins de trois fois l’intervalle hello), les défaillances du voisin LDP peuvent être détectées plus rapidement. Cependant, cela augmente également la possibilité que le routeur déclare un voisin LDP inactif qui fonctionne toujours normalement. Pour plus d’informations, reportez-vous à la section Configuration du minuteur LDP pour Hello Messages.

Le temps d’attente LDP est également négocié automatiquement entre les homologues LDP. Lorsque deux homologues LDP annoncent des temps de maintien LDP différents, la valeur la plus petite est utilisée. Si un routeur homologue LDP annonce un temps d’attente plus court que la valeur que vous avez configurée, le temps d’attente annoncé du routeur homologue est utilisé. Cette négociation peut également affecter l’intervalle de maintien en vie LDP.

Si le temps de maintien LDP local n’est pas raccourci pendant la négociation de l’homologue LDP, l’intervalle keepalive configuré par l’utilisateur reste inchangé. Toutefois, si le temps de maintien local est réduit pendant la négociation entre pairs, l’intervalle de rétention est recalculé. Si le temps de mise en attente LDP a été réduit pendant la négociation entre pairs, l’intervalle de rétention est réduit à un tiers de la nouvelle valeur de temps de mise en attente. Par exemple, si la nouvelle valeur de temps de maintien est de 45 secondes, l’intervalle keepalive est défini sur 15 secondes.

Ce calcul automatisé de l’intervalle de rétention peut entraîner la configuration de différents intervalles de rétention sur chaque routeur homologue. Cela permet aux routeurs d’être flexibles quant à la fréquence à laquelle ils envoient des messages persistants, car la négociation d’homologue LDP garantit qu’ils sont envoyés plus fréquemment que le temps d’attente LDP.

Lorsque vous reconfigurez l’intervalle de temps d’attente, les modifications ne prennent effet qu’après la réinitialisation de la session. Le temps d’attente est négocié lorsque la session d’appairage LDP est initiée et ne peut pas être renégocié tant que la session est active (requis par la RFC 5036, spécification LDP). Pour forcer manuellement la réinitialisation de la session LDP, exécutez la clear ldp session commande.

- Configuration du temps d’attente LDP pour les messages Link Hello

- Configuration du temps d’attente LDP pour les messages Hello ciblés

Configuration du temps d’attente LDP pour les messages Link Hello

Pour modifier la durée pendant laquelle un noeud LDP doit attendre un message hello de liaison avant de déclarer le voisin en panne, spécifiez une nouvelle heure en secondes à l’aide de l’instruction hold-time :

hold-time seconds;

Pour obtenir la liste des niveaux hiérarchiques auxquels vous pouvez inclure cette instruction, reportez-vous à la section Résumé de cette instruction.

Configuration du temps d’attente LDP pour les messages Hello ciblés

Pour modifier la durée pendant laquelle un nœud LDP doit attendre un message hello ciblé avant de déclarer le voisin en panne, spécifiez une nouvelle durée en secondes à l’aide de l’instruction hold-time comme option pour l’instruction targeted-hello :

targeted-hello { hold-time seconds; }

Pour obtenir la liste des niveaux hiérarchiques auxquels vous pouvez inclure ces instructions, reportez-vous aux sections de résumé des instructions pour ces instructions.

Activation des messages Hello ciblés stricts pour LDP

Utilisez des messages d’accueil ciblés stricts pour empêcher l’établissement de sessions LDP avec des voisins distants qui n’ont pas été configurés spécifiquement. Si vous configurez l’instruction strict-targeted-hellos , un homologue LDP ne répond pas aux messages hello ciblés provenant d’une source qui n’est pas l’un de ses voisins distants configurés. Les voisins distants configurés peuvent inclure :

Points de terminaison des tunnels RSVP pour lesquels la tunnelisation LDP est configurée

Voisins de circuit de couche 2

Si un voisin non configuré envoie un message hello, l’homologue LDP ignore le message et consigne une erreur (avec l’indicateur de error trace) indiquant la source. Par exemple, si l’homologue LDP a reçu un bonjour ciblé de l’adresse Internet 10.0.0.1 et qu’aucun voisin avec cette adresse n’est spécifiquement configuré, le message suivant est imprimé dans le fichier journal LDP :

LDP: Ignoring targeted hello from 10.0.0.1

Pour activer les messages hello ciblés stricts, incluez l’instruction strict-targeted-hellos suivante :

strict-targeted-hellos;

Pour obtenir la liste des niveaux hiérarchiques auxquels vous pouvez inclure cette instruction, reportez-vous à la section Résumé de cette instruction.

Configuration de l’intervalle pour les messages persistants LDP

L’intervalle keepalive détermine la fréquence à laquelle un message est envoyé au cours de la session pour s’assurer que le délai d’expiration du keepalive n’est pas dépassé. Si aucun autre trafic LDP n’est envoyé sur la session pendant ce laps de temps, un message keepalive est envoyé. La valeur par défaut est de 10 secondes. La valeur minimale est de 1 seconde.

La valeur configurée pour l’intervalle keepalive peut être modifiée lors de la négociation de session LDP si la valeur configurée pour le temps de maintien LDP sur le routeur homologue est inférieure à la valeur configurée localement. Pour plus d’informations, reportez-vous à la section Configuration du délai avant que les voisins LDP ne soient considérés comme inactifs.

Pour modifier l’intervalle keepalive, incluez l’instruction keepalive-interval suivante :

keepalive-interval seconds;

Pour obtenir la liste des niveaux hiérarchiques auxquels vous pouvez inclure cette instruction, reportez-vous à la section Résumé de cette instruction.

Configuration du délai d’expiration de LDP Keepalive

Une fois qu’une session LDP est établie, des messages doivent être échangés régulièrement pour s’assurer que la session fonctionne toujours. Le délai d’expiration keepalive définit le temps d’attente du nœud LDP voisin avant de décider de l’échec de la session. Cette valeur est généralement définie sur au moins trois fois l’intervalle keepalive. La valeur par défaut est de 30 secondes.

Pour modifier l’intervalle keepalive, incluez l’instruction keepalive-timeout suivante :

keepalive-timeout seconds;

Pour obtenir la liste des niveaux hiérarchiques auxquels vous pouvez inclure cette instruction, reportez-vous à la section Résumé de cette instruction.

La valeur configurée pour l’instruction s’affiche keepalive-timeout en tant que temps d’attente lorsque vous exécutez la show ldp session detail commande.

Configuration de la correspondance la plus longue pour LDP

Afin de permettre à LDP d’apprendre les routes agrégées ou résumées à travers les zones OSPF ou les niveaux ISIS dans inter -domain, Junos OS vous permet de configurer la correspondance la plus longue pour LDP en fonction de RFC5283.

Avant de configurer la correspondance la plus longue pour LDP, vous devez procéder comme suit :

Configurez les interfaces de l’appareil.

Configurez le protocole MPLS .

Configurez le protocole OSPF.

Pour configurer la correspondance la plus longue pour LDP, vous devez procéder comme suit :

Exemple : Configuration de la correspondance la plus longue pour LDP

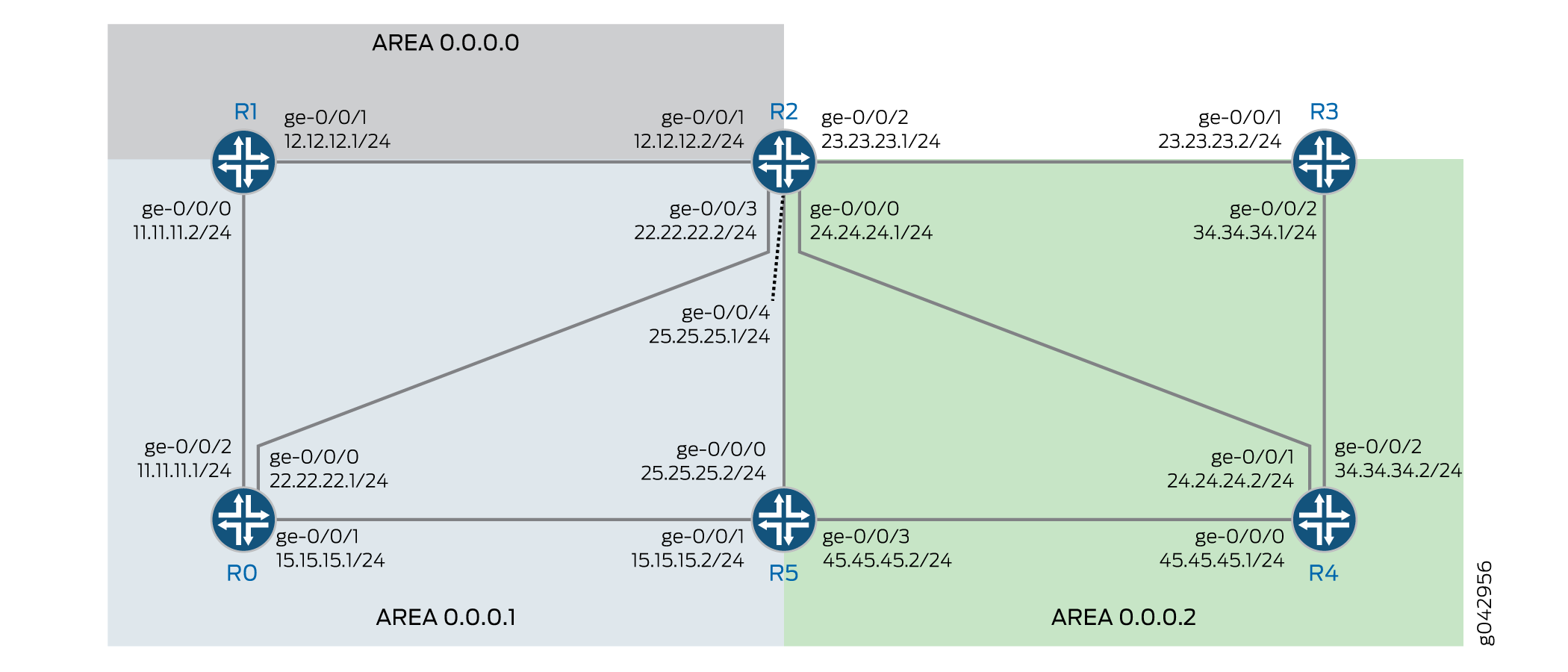

Cet exemple montre comment configurer la correspondance la plus longue pour LDP en fonction de RFC5283. Cela permet à LDP d’apprendre les routes agrégées ou résumées à travers les zones OSPF ou les niveaux ISIS dans l’inter-domaine. La stratégie de correspondance la plus longue fournit une granularité par préfixe.

Conditions préalables

Cet exemple utilise les composants matériels et logiciels suivants :

Six routeurs MX Series avec protocole OSPF et LDP activé sur les interfaces connectées.

Junos OS version 16.1 ou ultérieure s’exécute sur tous les équipements.

Avant de commencer :

Configurez les interfaces de l’appareil.

Configurez OSPF.

Présentation

Le LDP est souvent utilisé pour établir des chemins de commutation d’étiquettes (LSP) MPLS sur l’ensemble d’un domaine réseau à l’aide d’un IGP tel qu’OSPF ou IS-IS. Dans un tel réseau, tous les liens du domaine ont des adjacences IGP ainsi que des adjacences LDP. Le protocole LDP établit les LSP sur le chemin le plus court vers une destination déterminée par le transfert IP. Sous Junos OS, l’implémentation LDP effectue une recherche de correspondance exacte sur l’adresse IP de la FEC dans les routes RIB ou IGP pour le mappage d’étiquettes. Ce mappage exact nécessite la configuration des adresses IP des points de terminaison MPLS LDP de bout en bout dans tous les LER. Cela va à l’encontre de l’objectif de la conception hiérarchique IP ou du routage par défaut dans les équipements d’accès. La configuration longest-match permet de surmonter ce problème en supprimant le comportement de correspondance exact et en configurant LSP en fonction de l’itinéraire de correspondance le plus long par préfixe.

Topologie

Dans la topologie, Figure 1indique que la correspondance la plus longue pour LDP est configurée sur l’appareil R0 .

Configuration

Configuration rapide de l’interface de ligne de commande

Pour configurer rapidement cet exemple, copiez les commandes suivantes, collez-les dans un fichier texte, supprimez les sauts de ligne, modifiez tous les détails nécessaires pour qu’ils correspondent à la configuration de votre réseau, copiez et collez les commandes dans l’interface de ligne de commande au niveau de la [edit] hiérarchie, puis passez commit en mode de configuration.

R0

set interfaces ge-0/0/0 unit 0 family inet address 22.22.22.1/24 set interfaces ge-0/0/1 unit 0 family inet address 15.15.15.1/24 set interfaces ge-0/0/2 unit 0 family inet address 11.11.11.1/24 set interfaces ge-0/0/2 unit 0 family iso set interfaces ge-0/0/2 unit 0 family mpls set interfaces lo0 unit 0 family inet address 10.255.112.1/32 primary set interfaces lo0 unit 0 family inet address 10.255.112.1/32 preferred set interfaces lo0 unit 0 family iso address 49.0002.0192.0168.0001.00 set routing-options router-id 10.255.112.1 set protocols mpls interface ge-0/0/2.0 set protocols ospf area 0.0.0.1 interface ge-0/0/2.0 set protocols ospf area 0.0.0.1 interface lo0.0 passive set protocols ldp longest-match set protocols ldp interface ge-0/0/2.0 set protocols ldp interface lo0.0

R1

set interfaces ge-0/0/0 unit 0 family inet address 11.11.11.2/24 set interfaces ge-0/0/0 unit 0 family iso set interfaces ge-0/0/0 unit 0 family mpls set interfaces ge-0/0/1 unit 0 family inet address 12.12.12.1/24 set interfaces ge-0/0/1 unit 0 family iso set interfaces ge-0/0/1 unit 0 family mpls set interfaces lo0 unit 0 family inet address 10.255.112.2/32 primary set interfaces lo0 unit 0 family inet address 10.255.112.2/32 preferred set interfaces lo0 unit 0 family iso address 49.0002.0192.0168.0002.00 set routing-options router-id 10.255.112.2 set protocols mpls interface ge-0/0/0.0 set protocols mpls interface ge-0/0/1.0 set protocols ospf area 0.0.0.0 interface ge-0/0/1.0 set protocols ospf area 0.0.0.0 interface lo0.0 passive set protocols ospf area 0.0.0.1 interface ge-0/0/0.0 set protocols ldp longest-match set protocols ldp interface ge-0/0/0.0 set protocols ldp interface ge-0/0/1.0 set protocols ldp interface lo0.0

R2

set interfaces ge-0/0/0 unit 0 family inet address 24.24.24.1/24 set interfaces ge-0/0/0 unit 0 family iso set interfaces ge-0/0/0 unit 0 family mpls set interfaces ge-0/0/1 unit 0 family inet address 12.12.12.2/24 set interfaces ge-0/0/1 unit 0 family iso set interfaces ge-0/0/1 unit 0 family mpls set interfaces ge-0/0/2 unit 0 family inet address 23.23.23.1/24 set interfaces ge-0/0/2 unit 0 family iso set interfaces ge-0/0/2 unit 0 family mpls set interfaces ge-0/0/3 unit 0 family inet address 22.22.22.2/24 set interfaces ge-0/0/4 unit 0 family inet address 25.25.25.1/24 set interfaces ge-0/0/4 unit 0 family iso set interfaces ge-0/0/4 unit 0 family mpls set interfaces lo0 unit 0 family inet address 10.255.111.4/32 primary set interfaces lo0 unit 0 family inet address 10.255.111.4/32 preferred set interfaces lo0 unit 0 family iso address 49.0003.0192.0168.0003.00 set routing-options router-id 10.255.111.4 set protocols mpls interface ge-0/0/1.0 set protocols mpls interface ge-0/0/2.0 set protocols mpls interface ge-0/0/0.0 set protocols mpls interface ge-0/0/4.0 set protocols ospf area 0.0.0.0 interface ge-0/0/1.0 set protocols ospf area 0.0.0.0 interface lo0.0 passive set protocols ospf area 0.0.0.2 area-range 10.255.111.0/24 set protocols ospf area 0.0.0.2 interface ge-0/0/2.0 set protocols ospf area 0.0.0.2 interface ge-0/0/0.0 set protocols ospf area 0.0.0.2 interface ge-0/0/4.0 set protocols ldp interface ge-0/0/0.0 set protocols ldp interface ge-0/0/1.0 set protocols ldp interface ge-0/0/2.0 set protocols ldp interface ge-0/0/4.0 set protocols ldp interface lo0.0

R3

set interfaces ge-0/0/0 unit 0 family inet address 35.35.35.1/24 set interfaces ge-0/0/0 unit 0 family iso set interfaces ge-0/0/0 unit 0 family mpls set interfaces ge-0/0/1 unit 0 family inet address 23.23.23.2/24 set interfaces ge-0/0/1 unit 0 family iso set interfaces ge-0/0/1 unit 0 family mpls set interfaces ge-0/0/2 unit 0 family inet address 34.34.34.1/24 set interfaces ge-0/0/2 unit 0 family iso set interfaces ge-0/0/2 unit 0 family mpls set interfaces lo0 unit 0 family inet address 10.255.111.1/32 primary set interfaces lo0 unit 0 family inet address 10.255.111.1/32 preferred set interfaces lo0 unit 0 family iso address 49.0003.0192.0168.0004.00 set routing-options router-id 10.255.111.1 set protocols mpls interface ge-0/0/1.0 set protocols ospf area 0.0.0.2 interface ge-0/0/1.0 set protocols ospf area 0.0.0.2 interface fxp0.0 disable set protocols ospf area 0.0.0.2 interface lo0.0 passive set protocols ldp interface ge-0/0/1.0 set protocols ldp interface lo0.0

R4

set interfaces ge-0/0/0 unit 0 family inet address 45.45.45.1/24 set interfaces ge-0/0/0 unit 0 family iso set interfaces ge-0/0/0 unit 0 family mpls set interfaces ge-0/0/1 unit 0 family inet address 24.24.24.2/24 set interfaces ge-0/0/1 unit 0 family iso set interfaces ge-0/0/1 unit 0 family mpls set interfaces ge-0/0/2 unit 0 family inet address 34.34.34.2/24 set interfaces ge-0/0/2 unit 0 family iso set interfaces ge-0/0/2 unit 0 family mpls set interfaces lo0 unit 0 family inet address 10.255.111.2/32 primary set interfaces lo0 unit 0 family inet address 10.255.111.2/32 preferred set interfaces lo0 unit 0 family iso address 49.0003.0192.0168.0005.00 set routing-options router-id 10.255.111.2 set protocols mpls interface ge-0/0/1.0 set protocols ospf area 0.0.0.2 interface ge-0/0/1.0 set protocols ospf area 0.0.0.2 interface fxp0.0 disable set protocols ospf area 0.0.0.2 interface lo0.0 passive set protocols ldp interface ge-0/0/1.0 set protocols ldp interface lo0.0

R5

set interfaces ge-0/0/0 unit 0 family inet address 25.25.25.2/24 set interfaces ge-0/0/0 unit 0 family iso set interfaces ge-0/0/0 unit 0 family mpls set interfaces ge-0/0/1 unit 0 family inet address 15.15.15.2/24 set interfaces ge-0/0/2 unit 0 family inet address 35.35.35.2/24 set interfaces ge-0/0/3 unit 0 family inet address 45.45.45.2/24 set interfaces ge-0/0/3 unit 0 family iso set interfaces ge-0/0/3 unit 0 family mpls set interfaces lo0 unit 0 family inet address 10.255.111.3/32 primary set interfaces lo0 unit 0 family inet address 10.255.111.3/32 preferred set interfaces lo0 unit 0 family iso address 49.0003.0192.0168.0006.00 set routing-options router-id 10.255.111.3 set protocols mpls interface ge-0/0/0.0 set protocols ospf area 0.0.0.2 interface ge-0/0/0.0 set protocols ospf area 0.0.0.2 interface fxp0.0 disable set protocols ospf area 0.0.0.2 interface lo0.0 passive set protocols ldp interface ge-0/0/0.0 set protocols ldp interface lo0.0

Configuration de l’appareil R0

Procédure étape par étape

L’exemple suivant nécessite que vous naviguiez à différents niveaux dans la hiérarchie de configuration. Pour plus d’informations sur la navigation dans l’interface de ligne de commande, reportez-vous à la section Utilisation de l’éditeur CLI en mode de configuration dans le Guide de l’utilisateur de l’interface de ligne de commande.

Pour configurer l’appareil R0 :

Configurez les interfaces.

[edit interfaces] set ge-0/0/0 unit 0 family inet address 22.22.22.1/24 set ge-0/0/1 unit 0 family inet address 15.15.15.1/24 set ge-0/0/2 unit 0 family inet address 11.11.11.1/24 set ge-0/0/2 unit 0 family iso set ge-0/0/2 unit 0 family mpls

Attribuez les adresses de bouclage à l’appareil.

[edit interfaces lo0 unit 0 family] set inet address 10.255.112.1/32 primary set inet address 10.255.112.1/32 preferred set iso address 49.0002.0192.0168.0001.00

Configurez l’ID du routeur.

[edit routing-options] set router-id 10.255.112.1

Configurez le protocole MPLS sur l’interface.

[edit protocols mpls] set interface ge-0/0/2.0

Configurez le protocole OSPF sur l’interface.

[edit protocols ospf] set area 0.0.0.1 interface ge-0/0/2.0 set area 0.0.0.1 interface lo0.0 passive

Configurez la correspondance la plus longue pour le protocole LDP.

[edit protocols ldp] set longest-match

Configurez le protocole LDP sur l’interface.

[edit protocols ldp] set interface ge-0/0/2.0 set interface lo0.0

Résultats

À partir du mode de configuration, confirmez votre configuration en saisissant les show interfacescommandes , show protocolset show routing-options . Si la sortie n’affiche pas la configuration prévue, répétez les instructions de cet exemple pour corriger la configuration.

user@R0# show interfaces

ge-0/0/0 {

unit 0 {

family inet {

address 22.22.22.1/24;

}

}

}

ge-0/0/1 {

unit 0 {

family inet {

address 15.15.15.1/24;

}

}

}

ge-0/0/2 {

unit 0 {

family inet {

address 11.11.11.1/24;

}

family iso;

family mpls;

}

}

lo0 {

unit 0 {

family inet {

address 10.255.112.1/32 {

primary;

preferred;

}

}

family iso {

address 49.0002.0192.0168.0001.00;

}

}

}

user@R0# show protocols

mpls {

interface ge-0/0/2.0;

}

ospf {

area 0.0.0.1 {

interface ge-0/0/2.0;

interface lo0.0 {

passive;

}

}

}

ldp {

longest-match;

interface ge-0/0/2.0;

interface lo0.0;

}

user@R0# show routing-options router-id 10.255.112.1;

Si vous avez terminé de configurer l’appareil, entrez-le commit à partir du mode de configuration.

Vérification

Vérifiez que la configuration fonctionne correctement.

- Vérification des itinéraires

- Vérification des informations de présentation du PLD

- Vérifiez les entrées LDP dans la table de topologie interne.

- Vérifier uniquement les informations FEC du routage LDP

- Vérifier les routes FEC et Shadow de LDP

Vérification des itinéraires

But

Vérifiez que les itinéraires attendus sont appris.

Action

Sur le périphérique R0, à partir du mode opérationnel, exécutez la show route commande pour afficher les routes dans la table de routage.

user@R0> show route

inet.0: 62 destinations, 62 routes (62 active, 0 holddown, 0 hidden)

+ = Active Route, - = Last Active, * = Both

10.4.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.5.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.6.128.0/17 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.9.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.10.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.13.4.0/23 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.13.10.0/23 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.82.0.0/15 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.84.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.85.12.0/22 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.92.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.92.16.0/20 *[Direct/0] 10:08:01

> via fxp0.0

10.92.20.175/32 *[Local/0] 10:08:01

Local via fxp0.0

10.94.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.99.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.102.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.150.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.155.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.157.64.0/19 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.160.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.204.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.205.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.206.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.207.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.209.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.212.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.213.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.214.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.215.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.216.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.218.13.0/24 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.218.14.0/24 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.218.16.0/20 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.218.32.0/20 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.227.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

10.255.111.0/24 *[OSPF/10] 09:52:14, metric 3

> to 11.11.11.2 via ge-0/0/2.0

10.255.111.4/32 *[OSPF/10] 09:54:10, metric 2

> to 11.11.11.2 via ge-0/0/2.0

10.255.112.1/32 *[Direct/0] 09:55:05

> via lo0.0

10.255.112.2/32 *[OSPF/10] 09:54:18, metric 1

> to 11.11.11.2 via ge-0/0/2.0

11.11.11.0/24 *[Direct/0] 09:55:05

> via ge-0/0/2.0

11.11.11.1/32 *[Local/0] 09:55:05

Local via ge-0/0/2.0

12.12.12.0/24 *[OSPF/10] 09:54:18, metric 2

> to 11.11.11.2 via ge-0/0/2.0

15.15.15.0/24 *[Direct/0] 09:55:05

> via ge-0/0/1.0

15.15.15.1/32 *[Local/0] 09:55:05

Local via ge-0/0/1.0

22.22.22.0/24 *[Direct/0] 09:55:05

> via ge-0/0/0.0

22.22.22.1/32 *[Local/0] 09:55:05

Local via ge-0/0/0.0

23.23.23.0/24 *[OSPF/10] 09:54:10, metric 3

> to 11.11.11.2 via ge-0/0/2.0

24.24.24.0/24 *[OSPF/10] 09:54:10, metric 3

> to 11.11.11.2 via ge-0/0/2.0

25.25.25.0/24 *[OSPF/10] 09:54:10, metric 3

> to 11.11.11.2 via ge-0/0/2.0

128.92.17.45/32 *[OSPF/10] 09:54:05, metric 3

> to 11.11.11.2 via ge-0/0/2.0

128.92.20.175/32 *[Direct/0] 10:08:01

> via lo0.0

128.92.21.186/32 *[OSPF/10] 09:54:10, metric 3

> to 11.11.11.2 via ge-0/0/2.0

128.92.25.135/32 *[OSPF/10] 09:54:10, metric 3

> to 11.11.11.2 via ge-0/0/2.0

128.92.27.91/32 *[OSPF/10] 09:54:18, metric 1

> to 11.11.11.2 via ge-0/0/2.0

128.92.28.70/32 *[OSPF/10] 09:54:10, metric 2

> to 11.11.11.2 via ge-0/0/2.0

172.16.0.0/12 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

192.168.0.0/16 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

192.168.102.0/23 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

207.17.136.0/24 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

207.17.136.192/32 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

207.17.137.0/24 *[Static/5] 10:08:01

> to 10.92.31.254 via fxp0.0

224.0.0.5/32 *[OSPF/10] 09:55:05, metric 1

MultiRecv

inet.3: 5 destinations, 5 routes (5 active, 0 holddown, 0 hidden)

+ = Active Route, - = Last Active, * = Both

10.255.111.1/32 *[LDP/9] 09:41:03, metric 3

> to 11.11.11.2 via ge-0/0/2.0, Push 300128

10.255.111.2/32 *[LDP/9] 09:41:03, metric 3

> to 11.11.11.2 via ge-0/0/2.0, Push 300144

10.255.111.3/32 *[LDP/9] 09:41:03, metric 3

> to 11.11.11.2 via ge-0/0/2.0, Push 300160

10.255.111.4/32 *[LDP/9] 09:54:10, metric 2, tag 0

> to 11.11.11.2 via ge-0/0/2.0, Push 300000

10.255.112.2/32 *[LDP/9] 09:54:48, metric 1, tag 0

> to 11.11.11.2 via ge-0/0/2.0

iso.0: 2 destinations, 2 routes (2 active, 0 holddown, 0 hidden)

+ = Active Route, - = Last Active, * = Both

47.0005.80ff.f800.0000.0108.0001.1280.9202.0175/152

*[Direct/0] 10:08:01

> via lo0.0

49.0002.0192.0168.0001/72

*[Direct/0] 09:55:05

> via lo0.0

mpls.0: 10 destinations, 10 routes (10 active, 0 holddown, 0 hidden)

+ = Active Route, - = Last Active, * = Both

0 *[MPLS/0] 09:55:05, metric 1

Receive

1 *[MPLS/0] 09:55:05, metric 1

Receive

2 *[MPLS/0] 09:55:05, metric 1

Receive

13 *[MPLS/0] 09:55:05, metric 1

Receive

300064 *[LDP/9] 09:54:48, metric 1

> to 11.11.11.2 via ge-0/0/2.0, Pop

300064(S=0) *[LDP/9] 09:54:48, metric 1

> to 11.11.11.2 via ge-0/0/2.0, Pop

300112 *[LDP/9] 09:54:10, metric 2, tag 0

> to 11.11.11.2 via ge-0/0/2.0, Swap 300000

300192 *[LDP/9] 09:41:03, metric 3

> to 11.11.11.2 via ge-0/0/2.0, Swap 300128

300208 *[LDP/9] 09:41:03, metric 3

> to 11.11.11.2 via ge-0/0/2.0, Swap 300144

300224 *[LDP/9] 09:41:03, metric 3

> to 11.11.11.2 via ge-0/0/2.0, Swap 300160

inet6.0: 2 destinations, 2 routes (2 active, 0 holddown, 0 hidden)

+ = Active Route, - = Last Active, * = Both

abcd::128:92:20:175/128

*[Direct/0] 10:08:01

> via lo0.0

fe80::5668:a50f:fcc1:1f9c/128

*[Direct/0] 10:08:01

> via lo0.0

Sens

La sortie affiche toutes les routes de la table de routage du périphérique R0.

Vérification des informations de présentation du PLD

But

Afficher les informations de présentation de LDP.

Action

Sur l’appareil R0, à partir du mode opérationnel, exécutez la show ldp overview commande pour afficher la vue d’ensemble du LDP.

user@R0> show ldp overview

Instance: master

Reference count: 2

Router ID: 10.255.112.1

Message id: 8

Configuration sequence: 6

Deaggregate: disabled

Explicit null: disabled

IPv6 tunneling: disabled

Strict targeted hellos: disabled

Loopback if added: yes

Route preference: 9

Unicast transit LSP chaining: disabled

P2MP transit LSP chaining: disabled

Transit LSP statistics based on route statistics: disabled

LDP route acknowledgement: enabled

LDP mtu discovery: disabled

Longest Match: enabled

Capabilities enabled: none

Egress FEC capabilities enabled: entropy-label-capability

Downstream unsolicited Sessions:

Operational: 1

Retention: liberal

Control: ordered

Auto targeted sessions:

Auto targeted: disabled

Timers:

Keepalive interval: 10, Keepalive timeout: 30

Link hello interval: 5, Link hello hold time: 15

Targeted hello interval: 15, Targeted hello hold time: 45

Label withdraw delay: 60, Make before break timeout: 30

Make before break switchover delay: 3

Link protection timeout: 120

Graceful restart:

Restart: disabled, Helper: enabled, Restart in process: false

Reconnect time: 60000, Max neighbor reconnect time: 120000

Recovery time: 160000, Max neighbor recovery time: 240000

Traffic Engineering:

Bgp igp: disabled

Both ribs: disabled

Mpls forwarding: disabled

IGP:

Tracking igp metric: disabled

Sync session up delay: 10

Session protection:

Session protection: disabled

Session protection timeout: 0

Interface addresses advertising:

11.11.11.1

10.255.112.1

128.92.20.175

Label allocation:

Current number of LDP labels allocated: 5

Total number of LDP labels allocated: 11

Total number of LDP labels freed: 6

Total number of LDP label allocation failure: 0

Current number of labels allocated by all protocols: 5

Sens

La sortie affiche les informations de vue d’ensemble LDP de l’appareil R0

Vérifiez les entrées LDP dans la table de topologie interne.

But

Affichez les entrées de route dans la table de topologie interne du protocole de distribution d’étiquettes (LDP).

Action

Sur l’appareil R0, à partir du mode opérationnel, exécutez la show ldp route commande pour afficher la table de topologie interne de LDP.

user@R0> show ldp route

Destination Next-hop intf/lsp/table Next-hop address

10.4.0.0/16 fxp0.0 10.92.31.254

10.5.0.0/16 fxp0.0 10.92.31.254

10.6.128.0/17 fxp0.0 10.92.31.254

10.9.0.0/16 fxp0.0 10.92.31.254

10.10.0.0/16 fxp0.0 10.92.31.254

10.13.4.0/23 fxp0.0 10.92.31.254

10.13.10.0/23 fxp0.0 10.92.31.254

10.82.0.0/15 fxp0.0 10.92.31.254

10.84.0.0/16 fxp0.0 10.92.31.254

10.85.12.0/22 fxp0.0 10.92.31.254

10.92.0.0/16 fxp0.0 10.92.31.254

10.92.16.0/20 fxp0.0

10.92.20.175/32

10.94.0.0/16 fxp0.0 10.92.31.254

10.99.0.0/16 fxp0.0 10.92.31.254

10.102.0.0/16 fxp0.0 10.92.31.254

10.150.0.0/16 fxp0.0 10.92.31.254

10.155.0.0/16 fxp0.0 10.92.31.254

10.157.64.0/19 fxp0.0 10.92.31.254

10.160.0.0/16 fxp0.0 10.92.31.254

10.204.0.0/16 fxp0.0 10.92.31.254

10.205.0.0/16 fxp0.0 10.92.31.254

10.206.0.0/16 fxp0.0 10.92.31.254

10.207.0.0/16 fxp0.0 10.92.31.254

10.209.0.0/16 fxp0.0 10.92.31.254

10.212.0.0/16 fxp0.0 10.92.31.254

10.213.0.0/16 fxp0.0 10.92.31.254

10.214.0.0/16 fxp0.0 10.92.31.254

10.215.0.0/16 fxp0.0 10.92.31.254

10.216.0.0/16 fxp0.0 10.92.31.254

10.218.13.0/24 fxp0.0 10.92.31.254

10.218.14.0/24 fxp0.0 10.92.31.254

10.218.16.0/20 fxp0.0 10.92.31.254

10.218.32.0/20 fxp0.0 10.92.31.254

10.227.0.0/16 fxp0.0 10.92.31.254

10.255.111.0/24 ge-0/0/2.0 11.11.11.2

10.255.111.4/32 ge-0/0/2.0 11.11.11.2

10.255.112.1/32 lo0.0

10.255.112.2/32 ge-0/0/2.0 11.11.11.2

11.11.11.0/24 ge-0/0/2.0

11.11.11.1/32

12.12.12.0/24 ge-0/0/2.0 11.11.11.2

15.15.15.0/24 ge-0/0/1.0

15.15.15.1/32

22.22.22.0/24 ge-0/0/0.0

22.22.22.1/32

23.23.23.0/24 ge-0/0/2.0 11.11.11.2

24.24.24.0/24 ge-0/0/2.0 11.11.11.2

25.25.25.0/24 ge-0/0/2.0 11.11.11.2

128.92.17.45/32 ge-0/0/2.0 11.11.11.2

128.92.20.175/32 lo0.0

128.92.21.186/32 ge-0/0/2.0 11.11.11.2

128.92.25.135/32 ge-0/0/2.0 11.11.11.2

128.92.27.91/32 ge-0/0/2.0 11.11.11.2

128.92.28.70/32 ge-0/0/2.0 11.11.11.2

172.16.0.0/12 fxp0.0 10.92.31.254

192.168.0.0/16 fxp0.0 10.92.31.254

192.168.102.0/23 fxp0.0 10.92.31.254

207.17.136.0/24 fxp0.0 10.92.31.254

207.17.136.192/32 fxp0.0 10.92.31.254

207.17.137.0/24 fxp0.0 10.92.31.254

224.0.0.5/32

Sens

La sortie affiche les entrées de route dans la table de topologie interne LDP (Label Distribution Protocol) de l’équipement R0.

Vérifier uniquement les informations FEC du routage LDP

But

Affichez uniquement les informations FEC du routage LDP.

Action

Sur le périphérique R0, à partir du mode opérationnel, exécutez la show ldp route fec-only commande pour afficher les routes dans la table de routage.

user@R0> show ldp route fec-only

Destination Next-hop intf/lsp/table Next-hop address

10.255.111.1/32 ge-0/0/2.0 11.11.11.2

10.255.111.2/32 ge-0/0/2.0 11.11.11.2

10.255.111.3/32 ge-0/0/2.0 11.11.11.2

10.255.111.4/32 ge-0/0/2.0 11.11.11.2

10.255.112.1/32 lo0.0

10.255.112.2/32 ge-0/0/2.0 11.11.11.2

Sens

La sortie affiche uniquement les routes FEC du protocole LDP disponibles pour l’appareil R0.

Vérifier les routes FEC et Shadow de LDP

But

Affichez la FEC et les routes fantômes dans la table de routage.

Action

Sur le périphérique R0, à partir du mode opérationnel, exécutez la show ldp route fec-and-route commande pour afficher les routes FEC et shadow dans la table de routage.

user@R0> show ldp route fec-and-route

Destination Next-hop intf/lsp/table Next-hop address

10.4.0.0/16 fxp0.0 10.92.31.254

10.5.0.0/16 fxp0.0 10.92.31.254

10.6.128.0/17 fxp0.0 10.92.31.254

10.9.0.0/16 fxp0.0 10.92.31.254

10.10.0.0/16 fxp0.0 10.92.31.254

10.13.4.0/23 fxp0.0 10.92.31.254

10.13.10.0/23 fxp0.0 10.92.31.254

10.82.0.0/15 fxp0.0 10.92.31.254

10.84.0.0/16 fxp0.0 10.92.31.254

10.85.12.0/22 fxp0.0 10.92.31.254

10.92.0.0/16 fxp0.0 10.92.31.254

10.92.16.0/20 fxp0.0

10.92.20.175/32

10.94.0.0/16 fxp0.0 10.92.31.254

10.99.0.0/16 fxp0.0 10.92.31.254

10.102.0.0/16 fxp0.0 10.92.31.254

10.150.0.0/16 fxp0.0 10.92.31.254

10.155.0.0/16 fxp0.0 10.92.31.254

10.157.64.0/19 fxp0.0 10.92.31.254

10.160.0.0/16 fxp0.0 10.92.31.254

10.204.0.0/16 fxp0.0 10.92.31.254

10.205.0.0/16 fxp0.0 10.92.31.254

10.206.0.0/16 fxp0.0 10.92.31.254

10.207.0.0/16 fxp0.0 10.92.31.254

10.209.0.0/16 fxp0.0 10.92.31.254

10.212.0.0/16 fxp0.0 10.92.31.254

10.213.0.0/16 fxp0.0 10.92.31.254

10.214.0.0/16 fxp0.0 10.92.31.254

10.215.0.0/16 fxp0.0 10.92.31.254

10.216.0.0/16 fxp0.0 10.92.31.254

10.218.13.0/24 fxp0.0 10.92.31.254

10.218.14.0/24 fxp0.0 10.92.31.254

10.218.16.0/20 fxp0.0 10.92.31.254

10.218.32.0/20 fxp0.0 10.92.31.254

10.227.0.0/16 fxp0.0 10.92.31.254

10.255.111.0/24 ge-0/0/2.0 11.11.11.2

10.255.111.1/32 ge-0/0/2.0 11.11.11.2

10.255.111.2/32 ge-0/0/2.0 11.11.11.2

10.255.111.3/32 ge-0/0/2.0 11.11.11.2

10.255.111.4/32 ge-0/0/2.0 11.11.11.2

10.255.111.4/32 ge-0/0/2.0 11.11.11.2

10.255.112.1/32 lo0.0

10.255.112.1/32 lo0.0

10.255.112.2/32 ge-0/0/2.0 11.11.11.2

10.255.112.2/32 ge-0/0/2.0 11.11.11.2

11.11.11.0/24 ge-0/0/2.0

11.11.11.1/32

12.12.12.0/24 ge-0/0/2.0 11.11.11.2

15.15.15.0/24 ge-0/0/1.0

15.15.15.1/32

22.22.22.0/24 ge-0/0/0.0

22.22.22.1/32

23.23.23.0/24 ge-0/0/2.0 11.11.11.2

24.24.24.0/24 ge-0/0/2.0 11.11.11.2

25.25.25.0/24 ge-0/0/2.0 11.11.11.2

128.92.17.45/32 ge-0/0/2.0 11.11.11.2

128.92.20.175/32 lo0.0

128.92.21.186/32 ge-0/0/2.0 11.11.11.2

128.92.25.135/32 ge-0/0/2.0 11.11.11.2

128.92.27.91/32 ge-0/0/2.0 11.11.11.2

128.92.28.70/32 ge-0/0/2.0 11.11.11.2

172.16.0.0/12 fxp0.0 10.92.31.254

192.168.0.0/16 fxp0.0 10.92.31.254

192.168.102.0/23 fxp0.0 10.92.31.254

207.17.136.0/24 fxp0.0 10.92.31.254

207.17.136.192/32 fxp0.0 10.92.31.254

207.17.137.0/24 fxp0.0 10.92.31.254

224.0.0.5/32

Sens

La sortie affiche la FEC et les routes d’ombre de l’appareil R0

Configuration des préférences de routage LDP

Lorsque plusieurs protocoles calculent des routes vers la même destination, les préférences de route sont utilisées pour sélectionner la route installée dans la table de transfert. L’itinéraire avec la valeur de préférence la plus faible est sélectionné. La valeur de préférence peut être un nombre compris entre 0 et 255. Par défaut, les routes LDP ont une valeur de préférence de 9.

Pour modifier les préférences d’itinéraire, incluez l’instruction preference suivante :

preference preference;

Pour obtenir la liste des niveaux hiérarchiques auxquels vous pouvez inclure cette instruction, reportez-vous à la section Résumé de cette instruction.

Redémarrage progressif de LDP

Le redémarrage progressif LDP permet à un routeur dont le plan de contrôle LDP est en cours de redémarrage de continuer à transférer le trafic tout en récupérant son état à partir des routeurs voisins. Il active également un routeur sur lequel le mode d’assistance est activé pour aider un routeur voisin qui tente de redémarrer LDP.

Lors de l’initialisation de session, un routeur annonce sa capacité à effectuer un redémarrage progressif LDP ou à tirer parti d’un voisin effectuant un redémarrage progressif LDP en envoyant le TLV de redémarrage progressif. Ce TLV contient deux champs pertinents pour le redémarrage progressif LDP : le temps de reconnexion et le temps de récupération. Les valeurs des temps de reconnexion et de récupération indiquent les capacités de redémarrage progressif prises en charge par le routeur.

Lorsqu’un routeur découvre qu’un routeur voisin est en train de redémarrer, il attend la fin du temps de récupération avant de tenter de se reconnecter. Le temps de récupération correspond à la durée pendant laquelle un routeur attend que LDP redémarre correctement. La période de récupération commence lorsqu’un message d’initialisation est envoyé ou reçu. Cette période correspond généralement à la durée pendant laquelle un routeur voisin conserve ses informations sur le routeur qui redémarre, ce qui lui permet de continuer à transférer le trafic.

Vous pouvez configurer le redémarrage progressif LDP à la fois dans l’instance principale pour le protocole LDP et pour une instance de routage spécifique. Vous pouvez désactiver le redémarrage progressif au niveau global pour tous les protocoles, au niveau du protocole pour LDP uniquement et sur une instance de routage spécifique. Le redémarrage progressif LDP est désactivé par défaut, car au niveau global, le redémarrage progressif est désactivé par défaut. Toutefois, le mode d’assistance (la possibilité d’assister un routeur voisin qui tente un redémarrage progressif) est activé par défaut.

Voici quelques-uns des comportements associés au redémarrage normal de LDP :

Les étiquettes sortantes ne sont pas conservées lors des redémarrages. De nouveaux labels sortants sont attribués.

Lorsqu’un routeur redémarre, aucun message de mappage d’étiquettes n’est envoyé aux voisins qui prennent en charge le redémarrage normal jusqu’à ce que le routeur de redémarrage se soit stabilisé (les messages de mappage d’étiquettes sont immédiatement envoyés aux voisins qui ne prennent pas en charge le redémarrage normal). Cependant, tous les autres messages (keepalive, address-message, notification et release) sont envoyés comme d’habitude. La distribution de ces autres messages empêche le routeur de diffuser des informations incomplètes.

Le mode d’assistance et le redémarrage progressif sont indépendants. Vous pouvez désactiver le redémarrage progressif dans la configuration, tout en autorisant le routeur à coopérer avec un voisin qui tente de redémarrer correctement.

Configuration du redémarrage progressif de LDP

Lorsque vous modifiez la configuration du redémarrage progressif au niveau de la hiérarchie ou [edit protocols ldp graceful-restart] de la [edit routing-options graceful-restart] hiérarchie, toute session LDP en cours d’exécution est automatiquement redémarrée pour appliquer la configuration du redémarrage progressif. Ce comportement reflète le comportement de BGP lorsque vous modifiez sa configuration de redémarrage progressif.

Par défaut, le mode d’assistance au redémarrage progressif est activé, mais le redémarrage progressif est désactivé. Ainsi, le comportement par défaut d’un routeur est d’aider les routeurs voisins qui tentent un redémarrage progressif, mais pas de tenter un redémarrage progressif lui-même.

Pour configurer le redémarrage progressif de LDP, reportez-vous aux sections suivantes :

- Activation du redémarrage progressif

- Désactivation du mode de redémarrage progressif ou du mode d’assistance LDP

- Configuration de l’heure de reconnexion

- Configuration du temps de récupération et du temps de récupération maximal

Activation du redémarrage progressif

Pour activer le redémarrage progressif LDP, vous devez également activer le redémarrage progressif sur le routeur. Pour activer le redémarrage normal, incluez l’instruction graceful-restart suivante :

graceful-restart;

Vous pouvez inclure cette instruction aux niveaux hiérarchiques suivants :

[edit routing-options][edit logical-systems logical-system-name routing-options]

Les routeurs ACX Series ne prennent pas en charge le niveau hiérarchique [edit logical-systems logical-system-name routing-options].

L’instruction graceful-restart permet un redémarrage progressif pour tous les protocoles prenant en charge cette fonctionnalité sur le routeur. Pour plus d’informations sur le redémarrage normal, reportez-vous à la bibliothèque des protocoles de routage de Junos OS pour les périphériques de routage.

Par défaut, le redémarrage progressif LDP est activé lorsque vous activez le redémarrage progressif à la fois au niveau du protocole LDP et sur toutes les instances de routage. Toutefois, vous pouvez désactiver à la fois le mode d’assistance au redémarrage progressif LDP et le mode d’assistance au redémarrage progressif LDP.

Désactivation du mode de redémarrage progressif ou du mode d’assistance LDP

Pour désactiver le redémarrage et la récupération progressifs de LDP, incluez l’instruction disable suivante :

ldp {

graceful-restart {

disable;

}

}

Pour obtenir la liste des niveaux hiérarchiques auxquels vous pouvez inclure cette instruction, reportez-vous à la section Résumé de cette instruction.

Vous ne pouvez désactiver le mode d’assistance qu’au niveau des protocoles LDP. Vous ne pouvez pas désactiver le mode d’assistance pour une instance de routage spécifique. Pour désactiver le mode d’assistance LDP, incluez l’instruction helper-disable suivante :

ldp {

graceful-restart {

helper-disable;

}

}

Pour obtenir la liste des niveaux hiérarchiques auxquels vous pouvez inclure cette instruction, reportez-vous à la section Résumé de cette instruction.

Les configurations de redémarrage progressif LDP suivantes sont possibles :

Le redémarrage progressif LDP et le mode d’assistance sont tous deux activés.

Le redémarrage progressif LDP est désactivé, mais le mode d’assistance est activé. Un routeur configuré de cette manière ne peut pas redémarrer correctement, mais peut aider un voisin qui redémarre.

Le redémarrage progressif LDP et le mode d’assistance sont tous deux désactivés. Le routeur n’utilise pas le redémarrage progressif LDP ni le type, la longueur et la valeur de redémarrage progressif (TLV) envoyés dans le message d’initialisation. Le routeur se comporte comme un routeur qui ne peut pas prendre en charge le redémarrage normal LDP.

Une erreur de configuration est émise si vous tentez d’activer le redémarrage progressif et de désactiver le mode d’assistance.

Configuration de l’heure de reconnexion

Après l’échec de la connexion LDP entre les voisins, les voisins attendent un certain temps que le routeur redémarre normalement pour reprendre l’envoi de messages LDP. Une fois la période d’attente terminée, la session LDP peut être rétablie. Vous pouvez configurer la période d’attente en secondes. Cette valeur est incluse dans le TLV de session tolérant aux pannes envoyé dans les messages d’initialisation LDP lorsque le redémarrage normal LDP est activé.

Supposons que le routeur A et le routeur B soient voisins LDP. Le routeur A est le routeur qui redémarre. Le temps de reconnexion est le temps pendant lequel le routeur A indique au routeur B d’attendre après que le routeur B a détecté que le routeur A a redémarré.

Pour configurer l’heure de reconnexion, incluez l’instruction reconnect-time suivante :

graceful-restart { reconnect-time seconds; }

Vous pouvez définir le temps de reconnexion sur une valeur comprise entre 30 et 300 secondes. Par défaut, elle est de 60 secondes.

Pour obtenir la liste des niveaux hiérarchiques auxquels vous pouvez configurer ces instructions, reportez-vous aux sections récapitulatives des instructions pour ces instructions.

Configuration du temps de récupération et du temps de récupération maximal

Le temps de récupération correspond au temps qu’un routeur attend que LDP redémarre correctement. La période de récupération commence lorsqu’un message d’initialisation est envoyé ou reçu. Cette période correspond généralement à la durée pendant laquelle un routeur voisin conserve ses informations sur le routeur qui redémarre, ce qui lui permet de continuer à transférer le trafic.

Pour éviter qu’un routeur voisin ne soit affecté négativement s’il reçoit une valeur fausse pour le temps de récupération du routeur redémarrant, vous pouvez configurer le temps de récupération maximal sur le routeur voisin. Un routeur voisin conserve son état pendant la plus courte des deux fois. Par exemple, le routeur A effectue un redémarrage progressif LDP. Il a envoyé un temps de récupération de 900 secondes au routeur B voisin. Cependant, le temps de récupération maximal du routeur B est configuré à 400 secondes. Le routeur B n’attendra que 400 secondes avant de purger ses informations LDP du routeur A.

Pour configurer le temps de récupération, incluez l’instruction recovery-time et l’instruction maximum-neighbor-recovery-time :

graceful-restart { maximum-neighbor-recovery-time seconds; recovery-time seconds; }

Pour obtenir la liste des niveaux hiérarchiques auxquels vous pouvez configurer ces instructions, reportez-vous aux sections récapitulatives des instructions pour ces instructions.

Filtrage des liaisons d’étiquettes LDP entrantes

Vous pouvez filtrer les liaisons d’étiquettes LDP reçues, en appliquant des stratégies pour accepter ou refuser les liaisons annoncées par les routeurs voisins. Pour configurer le filtrage des étiquettes reçues, incluez l’instruction import suivante :

import [ policy-names ];

Pour obtenir la liste des niveaux hiérarchiques auxquels vous pouvez inclure cette instruction, reportez-vous à la section Résumé de cette instruction.

La stratégie nommée (configurée au niveau de la [edit policy-options] hiérarchie) est appliquée à toutes les liaisons d’étiquettes reçues de tous les voisins LDP. Tout le filtrage est effectué à l’aide from d’instructions. Tableau 1 répertorie les seuls from opérateurs qui s’appliquent au filtrage des étiquettes reçues LDP.

from Opérateur |

Description |

|---|---|

|

Correspondances sur les liaisons reçues d’un voisin adjacent sur l’interface spécifiée |

|

Correspondances sur les liaisons reçues de l’ID de routeur LDP spécifié |

|

Correspondances sur les liaisons reçues d’un voisin annonçant l’adresse d’interface spécifiée |

|

Correspondances sur les liaisons avec le préfixe spécifié |

Si une liaison est filtrée, elle apparaît toujours dans la base de données LDP, mais ne peut pas être installée dans le cadre d’un chemin de commutation d’étiquettes (LSP).

En règle générale, l’application de stratégies dans LDP ne peut être utilisée que pour bloquer l’établissement de LSP, et non pour contrôler leur routage. En effet, le chemin suivi par un LSP est déterminé par le routage unicast, et non par LDP. Toutefois, lorsqu’il existe plusieurs chemins d’accès à coût égal vers la destination via différents voisins, vous pouvez utiliser le filtrage LDP pour exclure certains des sauts suivants possibles de la prise en compte. (Sinon, LDP choisit l’un des sauts suivants possibles au hasard.)

Les sessions LDP ne sont pas liées à des interfaces ou adresses d’interface. LDP n’annonce que des étiquettes par routeur (et non par interface) ; Ainsi, s’il existe plusieurs liaisons parallèles entre deux routeurs, une seule session LDP est établie, et elle n’est pas liée à une seule interface. Lorsqu’un routeur a plusieurs contiguïtés par rapport au même voisin, veillez à ce que le filtre fasse ce qui est attendu. (En règle générale, l’utilisation de next-hop et interface n’est pas appropriée dans ce cas.)

Si une étiquette a été filtrée (c’est-à-dire qu’elle a été rejetée par la stratégie et qu’elle n’est pas utilisée pour construire un LSP), elle est marquée comme filtrée dans la base de données :

user@host> show ldp database Input label database, 10.10.255.1:0-10.10.255.6:0 Label Prefix 3 10.10.255.6/32 (Filtered) Output label database, 10.10.255.1:0-10.10.255.6:0 Label Prefix 3 10.10.255.1/32 (Filtered)

Pour plus d’informations sur la configuration des stratégies pour LDP, consultez le Guide de l’utilisateur Stratégies de routage, filtres de pare-feu et mécanismes de contrôle du trafic.

Exemples: Filtrage des liaisons d’étiquettes LDP entrantes

N’acceptez que les préfixes /32 de tous les voisins :

[edit]

protocols {

ldp {

import only-32;

...

}

}

policy-options {

policy-statement only-32 {

term first {

from {

route-filter 0.0.0.0/0 upto /31;

}

then reject;

}

then accept;

}

}

Acceptez 131.108/16 ou plus à partir de l’ID 10.10.255.2 de routeur et acceptez tous les préfixes de tous les autres voisins :

[edit]

protocols {

ldp {

import nosy-neighbor;

...

}

}

policy-options {

policy-statement nosy-neighbor {

term first {

from {

neighbor 10.10.255.2;

route-filter 131.108.0.0/16 orlonger accept;

route-filter 0.0.0.0/0 orlonger reject;

}

}

then accept;

}

}

Filtrage des liaisons d’étiquettes LDP sortantes

Vous pouvez configurer des stratégies d’exportation pour filtrer les étiquettes sortantes LDP. Vous pouvez filtrer les liaisons d’étiquettes sortantes en appliquant des stratégies de routage pour empêcher les liaisons d’être annoncées aux routeurs voisins. Pour configurer le filtrage des étiquettes sortantes, incluez l’instruction export suivante :

export [policy-name];

Pour obtenir la liste des niveaux hiérarchiques auxquels vous pouvez inclure cette instruction, reportez-vous à la section Résumé de cette instruction.

La stratégie d’exportation nommée (configurée au niveau de la [edit policy-options] hiérarchie) est appliquée à toutes les liaisons d’étiquettes transmises à tous les voisins LDP. Le seul from opérateur qui s’applique au filtrage d’étiquettes sortantes LDP est route-filter, qui fait correspondre les liaisons avec le préfixe spécifié. Les seuls to opérateurs qui s’appliquent au filtrage d’étiquettes sortantes sont les opérateurs de Tableau 2.

à l’opérateur |

Description |

|---|---|

|

Correspondances sur les liaisons envoyées à un voisin adjacent sur l’interface spécifiée |

|

Correspondances sur les liaisons envoyées à l’ID de routeur LDP spécifié |

|

Correspondances sur les liaisons envoyées à un voisin annonçant l’adresse d’interface spécifiée |

Si une liaison est filtrée, elle n’est pas annoncée au routeur voisin, mais elle peut être installée dans le cadre d’un LSP sur le routeur local. Vous pouvez appliquer des stratégies dans LDP pour bloquer l’établissement de LSP, mais pas pour contrôler leur routage. Le chemin suivi par un LSP est déterminé par le routage unicast, et non par LDP.

Les sessions LDP ne sont pas liées à des interfaces ou adresses d’interface. LDP n’annonce que des étiquettes par routeur (et non par interface). S’il existe plusieurs liaisons parallèles entre deux routeurs, une seule session LDP est établie et elle n’est pas liée à une seule interface.

N’utilisez pas les next-hop opérateurs et interface lorsqu’un routeur a plusieurs contiguïtés par rapport au même voisin.

Les étiquettes filtrées sont marquées dans la base de données :

user@host> show ldp database Input label database, 10.10.255.1:0-10.10.255.3:0 Label Prefix 100007 10.10.255.2/32 3 10.10.255.3/32 Output label database, 10.10.255.1:0-10.10.255.3:0 Label Prefix 3 10.10.255.1/32 100001 10.10.255.6/32 (Filtered)

Pour plus d’informations sur la configuration des stratégies pour LDP, consultez le Guide de l’utilisateur Stratégies de routage, filtres de pare-feu et mécanismes de contrôle du trafic.

Exemples: Filtrage des liaisons d’étiquettes LDP sortantes

Bloquez la transmission de l’itinéraire à 10.10.255.6/32 tous les voisins :

[edit protocols]

ldp {

export block-one;

}

policy-options {

policy-statement block-one {

term first {

from {

route-filter 10.10.255.6/32 exact;

}

then reject;

}

then accept;

}

}

Envoyez uniquement 131.108/16 ou plus à l’ID 10.10.255.2de routeur , et envoyez tous les préfixes à tous les autres routeurs :

[edit protocols]

ldp {

export limit-lsps;

}

policy-options {

policy-statement limit-lsps {

term allow-one {

from {

route-filter 131.108.0.0/16 orlonger;

}

to {

neighbor 10.10.255.2;

}

then accept;

}

term block-the-rest {

to {

neighbor 10.10.255.2;

}

then reject;

}

then accept;

}

}

Spécification de l’adresse de transport utilisée par LDP

Les routeurs doivent d’abord établir une session TCP entre eux avant de pouvoir établir une session LDP. La session TCP permet aux routeurs d’échanger les annonces d’étiquettes nécessaires à la session LDP. Pour établir la session TCP, chaque routeur doit connaître l’adresse de transport de l’autre routeur. L’adresse de transport est une adresse IP utilisée pour identifier la session TCP sur laquelle la session LDP s’exécutera.

Pour configurer l’adresse de transport LDP, incluez l’instruction transport-address :

transport-address (router-id | interface);

Pour obtenir la liste des niveaux hiérarchiques auxquels vous pouvez inclure cette instruction, reportez-vous à la section Résumé de cette instruction.

Si vous spécifiez l’option router-id , l’adresse de l’identificateur de routeur est utilisée comme adresse de transport (sauf configuration contraire, l’identificateur de routeur est généralement le même que l’adresse de bouclage). Si vous spécifiez cette interface option, l’adresse de l’interface est utilisée comme adresse de transport pour toutes les sessions LDP vers les voisins qui peuvent être atteints via cette interface. Notez que l’identifiant du routeur est utilisé comme adresse de transport par défaut.

Pour que le fonctionnement se fasse correctement, l’adresse de transport LDP doit être accessible. L’ID de routeur est un identifiant, pas une adresse IP routable. Pour cette raison, il est recommandé que l’ID du routeur soit défini pour correspondre à l’adresse de bouclage et que l’adresse de bouclage soit annoncée par l’IGP.

Vous ne pouvez pas spécifier l’option interface lorsqu’il existe plusieurs liaisons parallèles vers le même voisin LDP, car la spécification LDP exige que la même adresse de transport soit annoncée sur toutes les interfaces vers le même voisin. Si LDP détecte plusieurs liaisons parallèles vers le même voisin, il désactive les interfaces vers ce voisin une par une jusqu’à ce que la condition soit effacée, soit en déconnectant le voisin sur une interface, soit en spécifiant l’option router-id .

Adresse de transport de contrôle utilisée pour la session LDP ciblée

Pour établir une session TCP entre deux périphériques, chaque équipement doit apprendre l’adresse de transport de l’autre équipement. L’adresse de transport est une adresse IP utilisée pour identifier la session TCP sur laquelle la session LDP fonctionne. Auparavant, cette adresse de transport ne pouvait être que l’ID du routeur ou une adresse d’interface. Grâce à la fonctionnalité d’adresse de transport LDP, vous pouvez configurer explicitement n’importe quelle adresse IP en tant qu’adresse de transport pour les voisins LDP ciblés pour les circuits de couche 2, MPLS et VPLS. Cela vous permet de contrôler les sessions LDP ciblées à l’aide de la configuration des adresses de transport.

- Avantages du contrôle de l’adresse de transport utilisée pour les sessions LDP ciblées

- Vue d’ensemble des adresses de transport LDP ciblées

- Préférence d’adresse de transport

- Dépannage de la configuration de l’adresse de transport

Avantages du contrôle de l’adresse de transport utilisée pour les sessions LDP ciblées

La configuration de l’adresse de transport pour l’établissement de sessions LDP ciblées présente les avantages suivants :

Flexible interface configurations: permet de configurer plusieurs adresses IP pour une interface de bouclage sans interrompre la création d’une session LDP entre les voisins LDP ciblés.

Ease of operation: l’adresse de transport configurée au niveau de l’interface vous permet d’utiliser plusieurs protocoles dans le réseau dorsal IGP pour LDP. Cela permet des opérations fluides et faciles.

Vue d’ensemble des adresses de transport LDP ciblées

Avant Junos OS version 19.1R1, LDP ne prenait en charge que l’ID de routeur ou l’adresse d’interface en tant qu’adresse de transport sur toute interface LDP. Les contiguïtés formées sur cette interface utilisaient l’une des adresses IP attribuées à l’interface ou à l’ID du routeur. En cas de contiguïté ciblée, l’interface est l’interface de bouclage. Lorsque plusieurs adresses de bouclage étaient configurées sur l’équipement, l’adresse de transport de l’interface ne pouvait pas être dérivée et, par conséquent, la session LDP ne pouvait pas être établie.

À partir de Junos OS version 19.1R1, en plus des adresses IP par défaut utilisées pour l’adresse de transport des sessions LDP ciblées, vous pouvez configurer n’importe quelle autre adresse IP comme adresse de transport sous les sessioninstructions de configuration , session-groupet interface . La configuration de l’adresse de transport ne s’applique qu’aux voisins configurés, y compris les circuits de couche 2, les adjacences MPLS et VPLS. Cette configuration ne s’applique pas aux contiguïtés découvertes (ciblées ou non).

Préférence d’adresse de transport

Vous pouvez configurer l’adresse de transport pour les sessions LDP ciblées au niveau de la session, du groupe de sessions et de l’interface.

Une fois l’adresse de transport configurée, la session LDP ciblée est établie en fonction de la préférence d’adresse de transport de LDP.

L’ordre de préférence de l’adresse de transport pour le voisin ciblé (configurée via la configuration circuit de couche 2, MPLS, VPLS et LDP) est le suivant :

Sous

[edit protocols ldp session]la hiérarchie.Sous

[edit protocols ldp session-group]la hiérarchie.Sous

[edit protocols ldp interfcae lo0]la hiérarchie.Sous

[edit protocols ldp]la hiérarchie.Adresse par défaut.

L’ordre de préférence de l’adresse de transport pour les voisins découverts est le suivant :

Sous

[edit protocols ldp interfcae]la hiérarchie.Sous

[edit protocols ldp]la hiérarchie.Adresse par défaut.

L’ordre de préférence de l’adresse de transport pour les voisins auto-ciblés où LDP est configuré pour accepter les paquets hello est le suivant :

Sous

[edit protocols ldp interfcae lo0]la hiérarchie.Sous

[edit protocols ldp]la hiérarchie.Adresse par défaut.

Dépannage de la configuration de l’adresse de transport

Vous pouvez utiliser les sorties de commande show suivantes pour dépanner les sessions LDP ciblées :

show ldp sessionshow ldp neighborLe

detailniveau de sortie de lashow ldp neighborcommande affiche l’adresse de transport envoyée dans les messages hello au voisin ciblé. Si cette adresse n’est pas joignable depuis le voisin, la session LDP ne s’affiche pas.show configuration protocols ldp

Vous pouvez également activer les traceoptions LDP pour un dépannage plus poussé.

Si l’on remplace l’utilisation d’une adresse de transport non valide (non accessible) par une adresse de transport valide, les traces suivantes peuvent être observées :

May 29 10:47:11.569722 Incoming connect from 10.55.1.4 May 29 10:47:11.570064 Connection 10.55.1.4 state Closed -> Open May 29 10:47:11.570727 Session 10.55.1.4 state Nonexistent -> Initialized May 29 10:47:11.570768 Session 10.55.1.4 state Initialized -> OpenRec May 29 10:47:11.570799 LDP: Session param Max PDU length 4096 from 10.55.1.4, negotiated 4096 May 29 10:47:11.570823 Session 10.55.1.4 GR state Nonexistent -> Operational May 29 10:47:11.669295 Session 10.55.1.4 state OpenRec -> Operational May 29 10:47:11.669387 RPD_LDP_SESSIONUP: LDP session 10.55.1.4 is up

Si la configuration est modifiée de l’utilisation d’une adresse de transport valide à une adresse de transport non valide (non accessible), les traces suivantes peuvent être observées :

May 29 10:42:36.317942 Session 10.55.1.4 GR state Operational -> Nonexistent May 29 10:42:36.318171 Session 10.55.1.4 state Operational -> Closing May 29 10:42:36.318208 LDP session 10.55.1.4 is down, reason: received notification from peer May 29 10:42:36.318236 RPD_LDP_SESSIONDOWN: LDP session 10.55.1.4 is down, reason: received notification from peer May 29 10:42:36.320081 Connection 10.55.1.4 state Open -> Closed May 29 10:42:36.322411 Session 10.55.1.4 state Closing -> Nonexistent

En cas de configuration défectueuse, effectuez les tâches de dépannage suivantes :

Vérifiez l’icône

address family. L’adresse de transport configurée sous l’instructionsessiondoit appartenir à la même famille d’adresses que le voisin ou la session.L’adresse configurée en tant qu’adresse de transport sous une

neighborinstruction ousessiondoit être locale au routeur pour que les messages hello ciblés démarrent. Vous pouvez vérifier si l’adresse est configurée. Si l’adresse n’est configurée sous aucune interface, la configuration est rejetée.

Configuration des préfixes annoncés dans LDP à partir de la table de routage

Vous pouvez contrôler l’ensemble des préfixes annoncés dans LDP et faire en sorte que le routeur soit le routeur de sortie pour ces préfixes. Par défaut, seule l’adresse de bouclage est annoncée dans LDP. Pour configurer l’ensemble de préfixes de la table de routage à annoncer dans LDP, incluez l’instruction egress-policy suivante :

egress-policy policy-name;

Pour obtenir la liste des niveaux hiérarchiques auxquels vous pouvez inclure cette instruction, reportez-vous à la section Résumé de cette instruction.

Si vous configurez une stratégie de sortie pour LDP qui n’inclut pas l’adresse de bouclage, elle n’est plus annoncée dans LDP. Pour continuer à publier l’adresse de bouclage, vous devez la configurer explicitement dans le cadre de la stratégie de sortie LDP.

La stratégie nommée (configurée au niveau ou [edit policy-options][edit logical-systems logical-system-name policy-options] hiérarchie) est appliquée à tous les itinéraires de la table de routage. Les routes qui correspondent à la stratégie sont annoncées dans LDP. Vous pouvez contrôler l’ensemble des voisins auxquels ces préfixes sont annoncés à l’aide de l’instruction export . Seuls les from opérateurs sont pris en compte, vous pouvez utiliser n’importe quel opérateur valide from . Pour plus d’informations, reportez-vous à la bibliothèque de protocoles de routage de Junos OS pour les périphériques de routage.

Les routeurs ACX Series ne prennent pas en charge le niveau hiérarchique [edit logical-systems].

Exemple : Configuration des préfixes annoncés dans LDP

Annoncez tous les itinéraires connectés dans LDP :

[edit protocols]

ldp {

egress-policy connected-only;

}

policy-options {

policy-statement connected-only {

from {

protocol direct;

}

then accept;

}

}

Configuration de la désagrégation FEC

Lorsqu’un routeur de sortie LDP annonce plusieurs préfixes, ceux-ci sont liés à une étiquette unique et agrégés en une seule classe d’équivalence de transfert (FEC). Par défaut, LDP conserve cette agrégation lorsque la publication traverse le réseau.

Normalement, étant donné qu’un LSP n’est pas réparti sur plusieurs sauts suivants et que les préfixes sont liés en un seul LSP, l’équilibrage de charge sur les chemins à coût égal ne se produit pas. Toutefois, vous pouvez équilibrer la charge sur des chemins à coût égal si vous configurez une stratégie d’équilibrage de charge et désagrégez les FEC.

La désagrégation des FEC entraîne la liaison de chaque préfixe à une étiquette distincte et devient un LSP distinct.

Pour configurer des FEC désagrégées, incluez l’instruction deaggregate suivante :

deaggregate;

Pour obtenir la liste des niveaux hiérarchiques auxquels vous pouvez inclure cette instruction, reportez-vous à la section Résumé de cette instruction.

Pour toutes les sessions LDP, vous ne pouvez configurer des FEC désagrégées que globalement.

La désagrégation d’une FEC permet aux LSP multiples qui en résultent d’être distribués sur plusieurs chemins à coût égal et distribue les LSP sur les multiples sauts suivants sur les segments de sortie, mais n’installe qu’un seul saut suivant par LSP.

Pour agréger les FEC, incluez l’énoncé no-deaggregate suivant :

no-deaggregate;

Pour obtenir la liste des niveaux hiérarchiques auxquels vous pouvez inclure cette instruction, reportez-vous à la section Résumé de cette instruction.

Pour toutes les sessions LDP, vous ne pouvez configurer des FEC agrégées que globalement.

Configuration des mécanismes de contrôle pour les FEC LDP

Vous pouvez configurer Junos OS pour suivre et contrôler le trafic pour les FEC LDP. Les mécanismes de contrôle FEC LDP peuvent être utilisés pour effectuer l’une des opérations suivantes :

Suivez ou contrôlez le trafic entrant pour détecter un FEC LDP.

Suivre ou surveiller le trafic de transit pour un FEC LDP.

Suivez ou contrôlez le trafic LDP FEC provenant d’une classe de transfert spécifique.

Suivez ou contrôlez le trafic FEC LDP provenant d’un site VRF (Virtual Routing and Forwarding) spécifique.

Ignorez le trafic faux lié à une FEC LDP spécifique.

Pour contrôler le trafic d’une FEC LDP, vous devez d’abord configurer un filtre. Plus précisément, vous devez configurer l’instruction interface ou l’instruction interface-set au niveau de la [edit firewall family protocol-family filter filter-name term term-name from] hiérarchie. L’instruction interface vous permet de faire correspondre le filtre à une seule interface. L’instruction interface-set vous permet de faire correspondre le filtre à plusieurs interfaces.

Pour plus d’informations sur la configuration de l’instruction, de l’instruction interface-set et des mécanismes de contrôle pour les FEC LDP, consultez le Guide de l’utilisateur des stratégies de routage, des filtres de pare-feu et des mécanismes de contrôle du trafic.interface

Une fois que vous avez configuré les filtres, vous devez les inclure dans la configuration de l’instruction policing pour LDP. Pour configurer les mécanismes de contrôle pour les FEC LDP, incluez l’instruction policing suivante :

policing { fec fec-address { ingress-traffic filter-name; transit-traffic filter-name; } }

Pour obtenir la liste des niveaux hiérarchiques auxquels vous pouvez inclure cette instruction, reportez-vous à la section Résumé de cette instruction.

La policing déclaration comprend les options suivantes :

fec: spécifiez l’adresse FEC de la FEC LDP que vous souhaitez contrôler.ingress-filter: spécifiez le nom du filtre de trafic entrant.transit-traffic: spécifiez le nom du filtre de trafic de transit.

Configuration du filtrage FEC LDP IPv4

Par défaut, lorsqu’une session LDP ciblée est établie, Junos OS échange toujours les classes d’équivalence de transfert IPv4 (FEC) et les FEC de circuit de couche 2 sur la session LDP ciblée. Dans le cas d’une session LDP vers un voisin indirectement connecté, vous ne souhaiterez peut-être exporter les FEC de circuit de couche 2 vers le voisin que si la session a été spécifiquement configurée pour prendre en charge les circuits de couche 2 ou VPLS.

Dans un réseau de fournisseurs mixtes où tous les préfixes non-BGP sont annoncés dans LDP, la base de données LDP peut devenir volumineuse. Pour ce type d’environnement, il peut être utile d’empêcher la publication de FEC IPv4 sur des sessions LDP créées en raison d’une configuration VPLS de circuit de couche 2 ou LDP. De même, il peut être utile de filtrer les FEC IPv4 reçues dans ce type d’environnement.

Si tous les voisins LDP associés à une session LDP sont de couche 2 uniquement, vous pouvez configurer Junos OS pour annoncer uniquement les FEC de circuit de couche 2 en configurant l’instruction l2-smart-policy . Cette fonctionnalité filtre également automatiquement les FEC IPv4 reçus au cours de cette session. La configuration d’une stratégie d’exportation ou d’importation explicite activée pour l2-smart-policy désactive cette fonctionnalité dans la direction correspondante.

Si l’un des voisins de la session LDP est formé en raison d’une contiguïté découverte ou si la contiguïté est formée en raison d’une configuration de tunnelisation LDP sur un ou plusieurs LSP RSVP, les FEC IPv4 sont annoncés et reçus en utilisant le comportement par défaut.

Pour empêcher LDP d’exporter des FEC IPv4 sur des sessions LDP avec des voisins de couche 2 uniquement et pour filtrer les FEC IPv4 reçus au cours de ces sessions, incluez l’instruction l2-smart-policy suivante :

l2-smart-policy;

Pour obtenir la liste des niveaux hiérarchiques auxquels vous pouvez configurer cette instruction, reportez-vous au résumé de cette instruction.

Configuration de BFD pour les LSP LDP

Vous pouvez configurer la détection de transfert bidirectionnel (BFD) pour les LSP LDP. Le protocole BFD est un mécanisme hello simple qui détecte les défaillances dans un réseau. Les paquets Hello sont envoyés à un intervalle spécifié et régulier. Une défaillance de voisinage est détectée lorsque le routeur cesse de recevoir une réponse après un intervalle spécifié. BFD fonctionne avec une grande variété d’environnements et de topologies réseau. Les temporisateurs de détection des défaillances pour BFD ont des limites de temps plus courtes que les mécanismes de détection des défaillances des routes statiques, ce qui permet une détection plus rapide.

Une erreur est consignée chaque fois qu’une session BFD pour un chemin échoue. La solution suivante montre comment les messages de journal BFD pour LDP LSP peuvent s’afficher :

RPD_LDP_BFD_UP: LDP BFD session for FEC 10.255.16.14/32 is up RPD_LDP_BFD_DOWN: LDP BFD session for FEC 10.255.16.14/32 is down

Vous pouvez également configurer BFD pour les LSP RSVP, comme décrit dans Configuration de BFD pour les LSP avec signal RSVP.

Les minuteries de détection de défaillance BFD sont adaptatives et peuvent être ajustées pour être plus ou moins agressives. Par exemple, les temporisateurs peuvent s’adapter à une valeur plus élevée si la contiguïté échoue, ou un voisin peut négocier une valeur plus élevée pour un temporisateur que la valeur configurée. Les temporisateurs s’adaptent à une valeur plus élevée lorsqu’un battement de session BFD se produit plus de trois fois en l’espace de 15 secondes. Un algorithme d’interruption augmente l’intervalle de réception (Rx) de deux si l’instance BFD locale est à l’origine de l’interruption de session. L’intervalle de transmission (Tx) est augmenté de deux si l’instance BFD distante est à l’origine de l’interruption de session. Vous pouvez utiliser la clear bfd adaptation commande pour ramener les temporisateurs d’intervalle BFD à leurs valeurs configurées. La clear bfd adaptation commande est sans impact, ce qui signifie qu’elle n’affecte pas le flux de trafic sur le périphérique de routage.

Pour activer BFD pour les LSP LDP, incluez les oam instructions et bfd-liveness-detection :