AUF DIESER SEITE

Grundlegendes zur Datenverkehrsverarbeitung auf Sicherheitsgeräten

Grundlegendes zum Standardverarbeitungsverhalten für IPv4-Datenverkehr

Grundlegendes zur Datenverkehrsverarbeitung auf SRX210- und SRX320-Geräten

Grundlegendes zur Datenverkehrsverarbeitung auf SRX3000 Leitungs- und SRX1400-Geräten

Grundlegendes zur Datenverkehrsverarbeitung auf SRX4600 Geräten

Grundlegendes zur Datenverkehrsverarbeitung auf SRX5000 Leitungsgeräten

Grundlegendes zur Datenstromverarbeitung auf SRX5K-SPC3-Geräten

Datenverkehrsverarbeitung auf Firewalls der SRX-Serie – Übersicht

Junos OS für Sicherheitsgeräte integriert die Netzwerksicherheits- und Routing-Funktionen von Juniper Networks. Pakete, die in ein Gerät eingehen und es verlassen, durchlaufen sowohl eine paketbasierte als auch eine datenstrombasierte Verarbeitung.

Grundlegendes zur Datenverkehrsverarbeitung auf Sicherheitsgeräten

Junos OS für Sicherheitsgeräte integriert die erstklassigen Netzwerksicherheits- und Routing-Funktionen von Juniper Networks. Junos OS umfasst eine breite Palette von paketbasierten Filter-, Class-of-Service-Klassifizierern (CoS)-Klassifizierern und Traffic-Shaping-Funktionen sowie einen umfangreichen, umfangreichen Satz an Flow-basierten Sicherheitsfunktionen, einschließlich Richtlinien, Bildschirmen, Network Address Translation (NAT) und anderen Flow-basierten Services.

Der Datenverkehr, der in ein Sicherheitsgerät ein- und ausgeht, wird gemäß den von Ihnen konfigurierten Funktionen verarbeitet, z. B. Paketfilter, Sicherheitsrichtlinien und Bildschirme. Die Software kann zum Beispiel feststellen:

Gibt an, ob das Paket in das Gerät gelangt ist

Welche Firewall-Screens auf das Paket angewendet werden sollen

Die Route, die das Paket nimmt, um sein Ziel zu erreichen

Welches CoS ggf. auf das Paket angewendet werden soll

Gibt an, ob NAT angewendet werden soll, um die IP-Adresse des Pakets zu übersetzen

Gibt an, ob für das Paket ein Application Layer Gateway (ALG) erforderlich ist

Pakete, die in ein Gerät ein- und ausgehen, durchlaufen sowohl eine paketbasierte als auch eine datenflussbasierte Verarbeitung:

Bei der flussbasierten Paketverarbeitung werden verwandte Pakete oder ein Datenstrom von Paketen auf die gleiche Weise behandelt. Die Paketbehandlung hängt von den Merkmalen ab, die für das erste Paket des Paketdatenstroms festgelegt wurden, der als Datenfluss bezeichnet wird.

Bei der verteilten Verarbeitungsarchitektur des Services Gateways erfolgt die gesamte datenflussbasierte Verarbeitung auf der SPU, und das Sampling ist Multithread-fähig. Die Paketsequenzierung wird für die Stichprobenpakete beibehalten.

Bei der paketbasierten oder zustandslosen Paketverarbeitung werden Pakete diskret behandelt. Jede Packung wird individuell für die Behandlung beurteilt.

Bei der verteilten Verarbeitungsarchitektur des Services Gateways findet eine paketbasierte Verarbeitung, z. B. Traffic Shaping, auf der NPU statt. Einige paketbasierte Verarbeitungen, wie z. B. das Anwenden von Klassifizierern auf ein Paket, finden auf der SPU statt.

Dieses Thema umfasst die folgenden Abschnitte:

Grundlegendes zur datenflussbasierten Verarbeitung

Ein Paket wird einer datenstrombasierten Verarbeitung unterzogen, nachdem paketbasierte Filter und einige Bildschirme darauf angewendet wurden. Die gesamte datenflussbasierte Verarbeitung für einen einzelnen Datenfluss findet auf einer einzigen Services Processing Unit (SPU) statt. Eine SPU verarbeitet die Pakete eines Datenstroms gemäß den für die Sitzung konfigurierten Sicherheitsfunktionen und anderen Diensten.

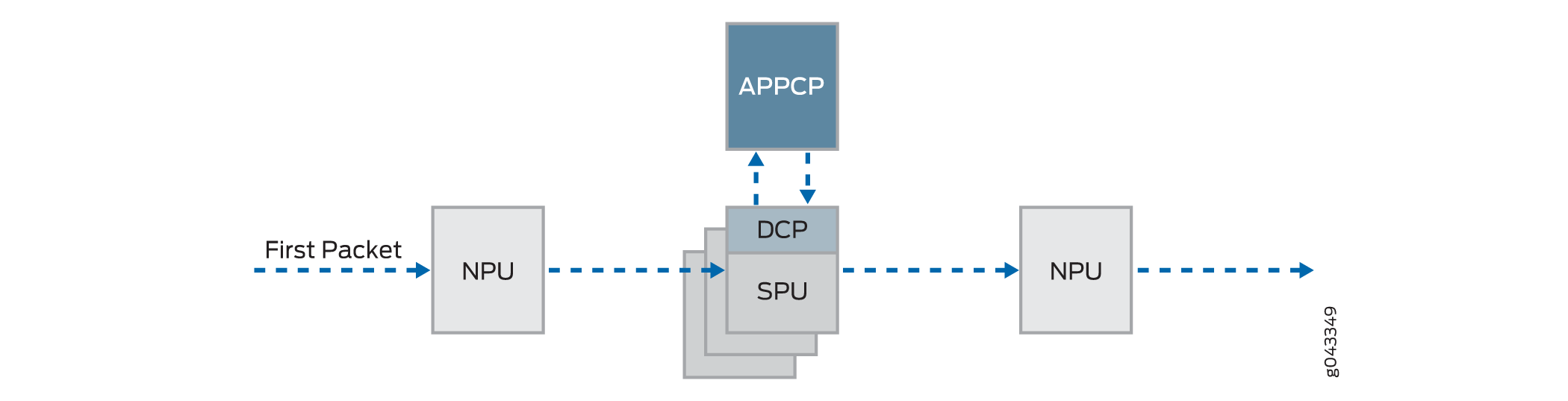

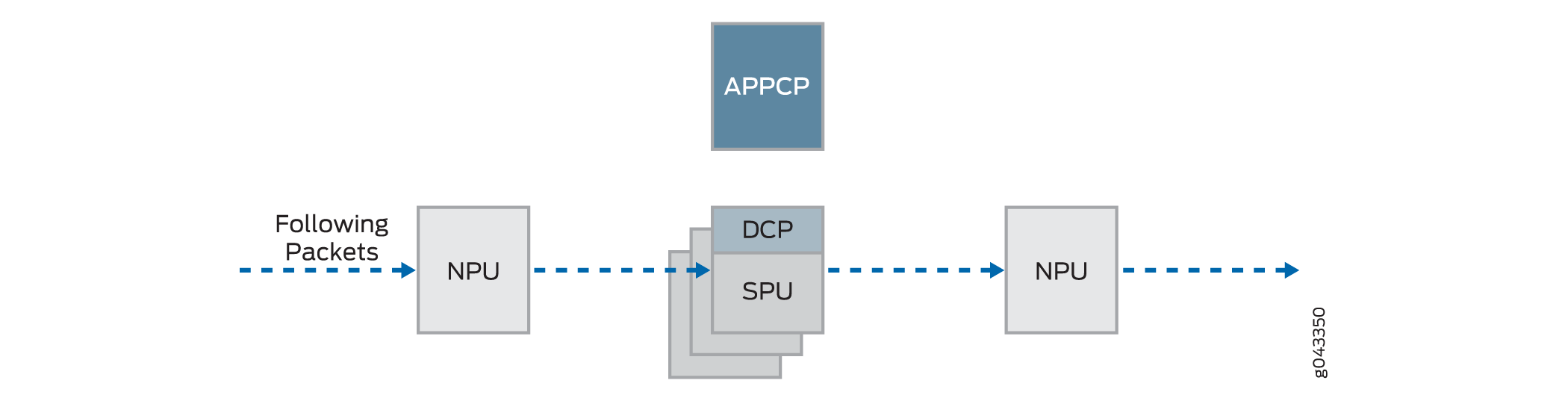

Abbildung 1 zeigt eine konzeptionelle Ansicht der Verarbeitung des datenstrombasierten Datenverkehrs auf Services Gateway.

Ein Datenstrom ist ein Strom zusammengehöriger Pakete, die die gleichen Übereinstimmungskriterien erfüllen und die gleichen Merkmale aufweisen. Junos OS behandelt Pakete, die zum selben Datenstrom gehören, auf die gleiche Weise.

Konfigurationseinstellungen, die den Status eines Pakets bestimmen – z. B. die Sicherheitsrichtlinie, die für das Paket gilt, ob ein Application Layer Gateway (ALG) erforderlich ist, ob NAT angewendet wird, um die Quell- und/oder Ziel-IP-Adresse des Pakets zu übersetzen – werden für das erste Paket eines Datenstroms bewertet.

Um festzustellen, ob ein Datenstrom für ein Paket vorhanden ist, versucht die NPU, die Informationen des Pakets anhand der folgenden Übereinstimmungskriterien mit denen einer vorhandenen Sitzung abzugleichen:

Quelladresse

Zieladresse

Quell-Port

Zielhafen

Protokoll

Eindeutige Sitzungstokennummer für eine bestimmte Zone und einen bestimmten virtuellen Router

Zonen und Richtlinien

Die Sicherheitsrichtlinie, die für das erste Paket eines Datenstroms verwendet werden soll, wird in einer Datenflusstabelle zwischengespeichert, um sie mit demselben Datenfluss und eng verwandten Datenflüssen zu verwenden. Sicherheitsrichtlinien sind Zonen zugeordnet. Eine Zone ist eine Sammlung von Schnittstellen, die eine Sicherheitsgrenze definieren. Die eingehende Zone eines Pakets, die durch die Schnittstelle bestimmt wird, über die es eingetroffen ist, und die ausgehende Zone, die durch die Weiterleitungssuche bestimmt wird, bestimmen zusammen, welche Richtlinie für Pakete des Datenstroms verwendet wird.

Flows und Sitzungen

Die flussbasierte Paketverarbeitung, die zustandsbehaftet ist, erfordert die Erstellung von Sitzungen. Für das erste Paket eines Datenstroms wird zu folgenden Zwecken eine Sitzung erstellt:

Speichern der meisten Sicherheitsmaßnahmen, die auf die Pakete des Datenflusses angewendet werden sollen.

Zum Zwischenspeichern von Informationen über den Status des Schemas.

Beispielsweise werden Protokollierungs- und Zählinformationen für ein Schema in seiner Sitzung zwischengespeichert. (Einige Stateful-Firewall-Bildschirme basieren auf Schwellenwerten, die sich auf einzelne Sitzungen oder auf alle Sitzungen beziehen.)

So ordnen Sie die erforderlichen Ressourcen für den Flow für Features wie NAT zu.

Bereitstellen eines Frameworks für Funktionen wie ALGs und Firewall-Funktionen.

Der größte Teil der Paketverarbeitung findet im Kontext eines Datenflusses statt, einschließlich:

Verwaltung von Richtlinien, NAT, Zonen und den meisten Bildschirmen.

Verwaltung von ALGs und Authentifizierung.

Paketbasierte Verarbeitung verstehen

Ein Paket durchläuft eine paketbasierte Verarbeitung, wenn es auf seiner Eingabeschnittstelle aus der Warteschlange entfernt wird und bevor es der Warteschlange auf seiner Ausgabeschnittstelle hinzugefügt wird.

Bei der paketbasierten Verarbeitung werden zustandslose Firewall-Filter, CoS-Funktionen und einige Bildschirme auf einzelne Pakete angewendet.

Wenn ein Paket an einer Schnittstelle ankommt, werden Plausibilitätsprüfungen, paketbasierte Filter, einige CoS-Funktionen und einige Bildschirme darauf angewendet.

Bevor ein Paket das Gerät verlässt, werden paketbasierte Filter, einige CoS-Funktionen und einige Bildschirme, die mit der Schnittstelle verbunden sind, auf das Paket angewendet.

Filter und CoS-Funktionen sind in der Regel mit einer oder mehreren Schnittstellen verknüpft, um zu beeinflussen, welche Pakete das System passieren dürfen, und um bei Bedarf spezielle Aktionen auf Pakete anzuwenden.

In den folgenden Themen werden die Arten von paketbasierten Features beschrieben, die Sie konfigurieren und auf den Transitdatenverkehr anwenden können.

Zustandslose Firewall-Filter

Zustandslose Firewall-Filter, die auch als Zugriffskontrolllisten (ACLs) bezeichnet werden, kontrollieren den Zugriff und begrenzen die Datenverkehrsraten. Sie werten statisch den Inhalt von Paketen aus, die das Gerät von einer Quelle zu einem Ziel übertragen, oder von Paketen, die von der Routing-Engine stammen oder für diese bestimmt sind. Ein zustandsloser Firewall-Filter wertet jedes Paket aus, auch fragmentierte Pakete.

Sie können einen zustandslosen Firewallfilter auf eine Eingabe- oder Ausgabeschnittstelle oder auf beide anwenden. Ein Filter enthält einen oder mehrere Begriffe, und jeder Begriff besteht aus zwei Komponenten: Übereinstimmungsbedingungen und Aktionen. Standardmäßig wird ein Paket, das nicht mit einem Firewallfilter übereinstimmt, verworfen.

Sie können zustandslose Firewallfilter für verschiedene Zwecke planen und entwerfen, z. B. zur Begrenzung des Datenverkehrs auf bestimmte Protokolle, IP-Quell- oder Zieladressen oder Datenraten. Zustandslose Firewall-Filter werden auf der NPU ausgeführt.

Class-of-Service-Funktionen

CoS-Funktionen ermöglichen es Ihnen, den Datenverkehr zu klassifizieren und zu gestalten. CoS-Funktionen werden auf der NPU ausgeführt.

Behavior Aggregate (BA)-Klassifizierer: Diese Klassifizierer arbeiten mit Paketen, sobald sie in das Gerät gelangen. Mithilfe von Verhaltensaggregatklassifizierern fasst das Gerät verschiedene Datenverkehrstypen in einer einzigen Weiterleitungsklasse zusammen, um die gleiche Weiterleitungsbehandlung zu erhalten. Mit BA-Klassifizierern können Sie die Weiterleitungsklasse und die Verlustpriorität eines Pakets basierend auf dem DiffServ-Wert (Differentiated Service) festlegen.

Traffic Shaping: Sie können den Datenverkehr gestalten, indem Sie bestimmten Anwendungen, die von bestimmten Datenverkehrsströmen bedient werden, Servicelevel mit unterschiedlichen Verzögerungs-, Jitter- und Paketverlusteigenschaften zuweisen. Traffic Shaping ist besonders nützlich für Echtzeitanwendungen wie Sprach- und Videoübertragung.

Bildschirme

Einige Screens, wie z. B. DoS-Screens (Denial-of-Service), werden auf ein Paket außerhalb des Datenflussprozesses angewendet. Sie werden auf der Network Processing Unit (NPU) ausgeführt.

Grundlegendes zum Standardverarbeitungsverhalten für IPv4-Datenverkehr

Der Flow-basierte Verarbeitungsmodus ist erforderlich, damit Sicherheitsfunktionen wie Zonen, Bildschirme und Firewallrichtlinien funktionieren. Standardmäßig ist die Firewall der SRX-Serie für die datenstrombasierte Weiterleitung von IPv4-Datenverkehr auf allen Geräten aktiviert, mit Ausnahme der SRX300-Serie und SRX550M Geräten, die auf den Drop-Modus eingestellt sind. Ab Junos OS Version 15.1X49-D70 und Junos OS Version 17.3R1 müssen Sie für die Geräte der SRX1500-Serie, SRX4100, SRX4200, SRX5400, SRX5600, SRX5800 und vSRX Virtual Firewall das Gerät nicht neu starten, wenn Sie zwischen Flow-Modus, Paketmodus und Drop-Modus wechseln. Bei Geräten der SRX300-Serie und SRX550M müssen Sie das Gerät neu starten, wenn Sie zwischen Flow-Modus, Paketmodus und Drop-Modus wechseln.

SRX300 Series and SRX550M

Bei der SRX300-Serie und den SRX550M Geräten ist der Standardverarbeitungsmodus aufgrund von Speicherbeschränkungen auf den Drop-Modus festgelegt. In diesem Fall müssen Sie das Gerät neu starten, nachdem Sie den Verarbeitungsmodus vom Standardwert für den Drop-Modus in den Flow-basierten Verarbeitungsmodus oder den paketbasierten Verarbeitungsmodus geändert haben, d. h. zwischen den Modi auf diesen Geräten.

Bei der Verarbeitung im Drop-Modus wird der Datenverkehr direkt verworfen, er wird nicht weitergeleitet. Sie unterscheidet sich von der Paketmodusverarbeitung, bei der der Datenverkehr verarbeitet, aber keine Sicherheitsprozesse angewendet werden.

Configuring an SRX Series Device as a Border Router

Wenn eine Firewall der SRX-Serie für die datenflussbasierte Verarbeitung oder den Drop-Modus aktiviert ist, müssen Sie den Modus für MPLS in paketbasierte Verarbeitung ändern, um das Gerät als Border-Router zu konfigurieren. Verwenden Sie in diesem Fall die set security forwarding-options family mpls mode packet-based folgende Anweisung, um die Firewall der SRX-Serie für den Paketmodus für MPLS zu konfigurieren.

Wie bereits erwähnt, müssen Sie bei der SRX300-Serie und den SRX550M Geräten jedes Mal, wenn Sie den Verarbeitungsmodus ändern, das Gerät neu starten.

Grundlegendes zur Datenverkehrsverarbeitung auf SRX210- und SRX320-Geräten

In diesem Thema wird der Prozess beschrieben, den die Services Gateways SRX210 und SRX320 beim Einrichten einer Sitzung für Pakete durchführen, die zu einem Datenfluss gehören, der das Gerät durchläuft. Die Datenstromdienste der SRX210- und SRX320-Geräte sind Single-Thread-basiert und nicht verteilt. Obwohl sie sich in dieser Hinsicht von den anderen Firewalls der SRX-Serie unterscheiden, wird dem gleichen Ablaufmodell gefolgt und die gleiche Befehlszeilenschnittstelle (CLI) implementiert.

Um den Sitzungsaufbau und den Paketspaziergang einschließlich der Punkte, an denen Dienste auf die Pakete eines Datenstroms angewendet werden, zu veranschaulichen, wird in dem in den folgenden Abschnitten beschriebenen Beispiel der einfache Fall einer Unicastsitzung verwendet:

- Grundlegendes zur Datenstromverarbeitung und zum Sitzungsmanagement

- Grundlegendes zur Verarbeitung des ersten Pakets

- Grundlegendes zur Sitzungserstellung

- Grundlegendes zur Fast-Path-Verarbeitung

Grundlegendes zur Datenstromverarbeitung und zum Sitzungsmanagement

In diesem Thema wird erläutert, wie eine Sitzung für die Verarbeitung der Pakete eingerichtet wird, aus denen sich ein Datenfluss zusammensetzt. Im folgenden Thema bezieht sich die SPU auf den Data Plane-Thread der SRX210- oder SRX320-Firewall.

Zu Beginn ruft der Data Plane-Thread das Paket ab und führt grundlegende Plausibilitätsprüfungen durch. Anschließend verarbeitet es das Paket für zustandslose Filter und CoS-Klassifizierer und wendet einige Raster an.

Grundlegendes zur Verarbeitung des ersten Pakets

Um festzustellen, ob ein Paket zu einem vorhandenen Datenstrom gehört, versucht das Gerät, die Informationen des Pakets anhand der folgenden sechs Übereinstimmungskriterien mit denen einer vorhandenen Sitzung abzugleichen:

Quelladresse

Zieladresse

Quell-Port

Zielhafen

Protokoll

Eindeutiges Token aus einer bestimmten Zone und einem bestimmten virtuellen Router

Die SPU überprüft ihre Sitzungstabelle auf eine vorhandene Sitzung für das Paket. Wenn keine vorhandene Sitzung gefunden wird, richtet die SPU eine Sitzung für den Flow ein. Wenn eine Sitzungsübereinstimmung gefunden wird, wurde die Sitzung bereits erstellt, sodass die SPU eine Fast-Path-Verarbeitung für das Paket durchführt.

Grundlegendes zur Sitzungserstellung

Beim Einrichten der Sitzung führt die SPU die folgenden Dienste für das Paket aus:

Bildschirme

Routensuche

Richtliniensuche

Service-Suche

NAT, falls erforderlich

Nachdem eine Sitzung eingerichtet wurde, wird sie für alle Pakete verwendet, die zum Datenfluss gehören. Pakete eines Datenstroms werden entsprechend den Parametern seiner Sitzung verarbeitet. Für die restlichen Schritte der Paketverarbeitung fahren Sie mit Schritt 1 in "Fast-Path Processing" fort. Alle Pakete durchlaufen eine schnelle Verarbeitung.

Grundlegendes zur Fast-Path-Verarbeitung

Wenn ein Paket mit einer Sitzung übereinstimmt, führt Junos OS eine Fast-Path-Verarbeitung durch, wie in den folgenden Schritten beschrieben. Nachdem eine Sitzung für das erste Paket in einem Datenstrom eingerichtet wurde, wird auch eine Fast-Path-Verarbeitung durchlaufen. Alle Pakete durchlaufen eine schnelle Verarbeitung.

Die SPU wendet datenstrombasierte Sicherheitsfunktionen auf das Paket an.

Konfigurierte Bildschirme werden angewendet.

TCP-Prüfungen werden durchgeführt.

Bei Bedarf werden Datenstromdienste wie NAT, ALG und IPsec angewendet.

Die SPU bereitet das Paket für die Weiterleitung vor und überträgt es.

Routing-Paketfilter werden angewendet.

Traffic Shaping wird angewendet.

Die Priorisierung des Datenverkehrs wird angewendet.

Die Verkehrsplanung wird angewendet.

Das Paket wird übertragen.

Grundlegendes zur Datenverkehrsverarbeitung auf SRX3000 Leitungs- und SRX1400-Geräten

Junos OS für die Services Gateways SRX1400, SRX3400 und SRX3600 integriert die erstklassigen Netzwerksicherheits- und Routing-Funktionen der Juniper Netzwerke. Junos OS für diese Service Gateways umfasst eine breite Palette von Sicherheitsservices, einschließlich Richtlinien, Bildschirmen, Netzwerkadressübersetzung, Class-of-Service-Klassifizierer und den umfangreichen, umfangreichen Satz von Flow-basierten Services, die auch auf den anderen Geräten in den Services Gateways unterstützt werden.

Die verteilte parallele Verarbeitungsarchitektur der SRX1400-, SRX3400- und SRX3600-Geräte umfasst mehrere Prozessoren zur Verwaltung von Sitzungen und zur Ausführung von Sicherheits- und anderen Service-Verarbeitungen. Diese Architektur bietet mehr Flexibilität und ermöglicht einen hohen Durchsatz und eine schnelle Leistung.

In den folgenden Abschnitten wird die Verarbeitungsarchitektur am Beispiel von SRX3400- und SRX3600 Geräten beschrieben:

Dieses Thema enthält die folgenden Informationen:

- Komponenten, die am Einrichten einer Sitzung beteiligt sind

- Grundlegendes zum Datenpfad für Unicastsitzungen

- Session-Lookup und Paketübereinstimmungskriterien

- Grundlegendes zur Sitzungserstellung: Erste Paketverarbeitung

- Grundlegendes zur Fast-Path-Verarbeitung

Komponenten, die am Einrichten einer Sitzung beteiligt sind

Im Folgenden finden Sie eine Übersicht über die Hauptkomponenten, die beim Einrichten einer Sitzung für ein Paket und beim Verarbeiten der Pakete beim Übertragen der SRX3400 und SRX3600 Geräte eine Rolle spielen:

Services Processing Units (SPUs): Die Hauptprozessoren der SRX3400- und SRX3600-Geräte befinden sich auf Services Processing Cards (SPCs). Sie etablieren und verwalten Datenverkehrsströme und führen den größten Teil der Paketverarbeitung für ein Paket durch, während es das Gerät durchquert. Jede SPU verwaltet eine Hash-Tabelle für die schnelle Suche nach Sitzungen. Die SPU führt die gesamte datenstrombasierte Verarbeitung für ein Paket durch, einschließlich der Anwendung von Sicherheitsdiensten, Klassifizierern und Traffic-Shapern. Alle Pakete, die zum gleichen Fluss gehören, werden von derselben SPU verarbeitet.

Die SPU verwaltet eine Sitzungstabelle mit Einträgen für alle Sitzungen, die sie eingerichtet hat und deren Pakete sie verarbeitet. Wenn eine SPU ein Paket von einer NPU empfängt, überprüft sie ihre Sitzungstabelle, um sicherzustellen, dass das Paket zu ihr gehört.

Für SRX3400 und SRX3600 Geräte agiert eine SPU gemeinsam, indem sie ihre regulären Sitzungsverwaltungs- und Datenflussverarbeitungsfunktionen ausführt und als zentraler Punkt fungiert, an dem sie Sitzungen vermittelt und Ressourcen zuweist. Wenn eine SPU auf diese Weise arbeitet, befindet sie sich im Combo-Modus.

Zentraler Punkt: Der zentrale Punkt wird verwendet, um SPUs Sitzungsmanagement basierend auf Lastausgleichskriterien zuzuweisen. Sitzungen werden auf intelligente Weise verteilt, um Vorkommnisse zu vermeiden, in denen mehrere SPUs denselben Datenfluss fälschlicherweise verarbeiten. Der zentrale Punkt folgt den Load-Balancing-Kriterien bei der Zuweisung von Sitzungen zu SPUs. Wenn die Sitzung vorhanden ist, leitet der zentrale Punkt Pakete für diesen Datenfluss an die SPU weiter, die ihn hostet. Außerdem werden Pakete an die richtige SPU umgeleitet, falls die NPU dies nicht tut.

Für die SRX3400- und SRX3600-Geräte läuft eine SPU immer im sogenannten Combo-Modus, in dem sie sowohl die Funktionalität des zentralen Punktes als auch die Flow- und Session-Management-Funktionalität implementiert. Im Kombinationsmodus teilen sich die SPU und der zentrale Punkt dieselbe Infrastruktur für den Lastausgleichsthread (LBT) und den gleichen POT (Packet Ordering Thread). .

Routing-Engine (RE): Die Routing-Engine führt die Steuerungsebene aus und verwaltet den Steuerungsebenenprozessor (CPP).

Grundlegendes zum Datenpfad für Unicastsitzungen

Junos OS für die SRX3400 und SRX3600 Services Gateways ist ein verteiltes System mit paralleler Verarbeitung, hohem Durchsatz und hoher Leistung. In diesem Thema wird der Prozess des Einrichtens einer Sitzung für Pakete beschrieben, die zu einem Datenfluss gehören, der das Gerät durchläuft.

Um den Sitzungsaufbau und den Paketspaziergang einschließlich der Punkte, an denen Dienste auf die Pakete eines Datenstroms angewendet werden, zu veranschaulichen, wird im folgenden Beispiel der einfache Fall einer Unicastsitzung verwendet. Dieser Paket-"Walk" führt die paketbasierte Verarbeitung und die datenstrombasierte Verarbeitung zusammen, die das Junos-Betriebssystem für das Paket ausführt.

Session-Lookup und Paketübereinstimmungskriterien

Um festzustellen, ob ein Paket zu einem vorhandenen Datenstrom gehört, versucht das Gerät, die Informationen des Pakets anhand der folgenden sechs Übereinstimmungskriterien mit denen einer vorhandenen Sitzung abzugleichen:

Quelladresse

Zieladresse

Quell-Port

Zielhafen

Protokoll

Eindeutiges Token aus einer bestimmten Zone und einem bestimmten virtuellen Router

Grundlegendes zur Sitzungserstellung: Erste Paketverarbeitung

In diesem Thema wird erläutert, wie eine Sitzung für die Verarbeitung der Pakete eingerichtet wird, aus denen sich ein Datenfluss zusammensetzt. Zur Veranschaulichung des Prozesses wird in diesem Thema ein Beispiel mit einer Quelle "a" und einem Ziel "b" verwendet. Die Richtung von der Quelle zum Ziel für die Pakete des Datenstroms wird als (a -> b) bezeichnet. Die Richtung vom Ziel zur Quelle wird als (b -> a) bezeichnet.

Ein Paket kommt an einer Schnittstelle auf dem Gerät an und wird vom IOC verarbeitet.

Das IOC entfernt das Paket aus der Warteschlange und sendet es an die NPU, mit der es kommuniziert.

Die NPU empfängt das Paket vom IOC und verarbeitet es.

Die NPU führt grundlegende Plausibilitätsprüfungen für das Paket durch und wendet einige für die Schnittstelle konfigurierte Bildschirme auf das Paket an.

Wenn eine Sitzungsübereinstimmung gefunden wird, wurde die Sitzung bereits auf einer SPU erstellt, die ihr zugewiesen wurde, sodass die NPU das Paket zusammen mit der Sitzungs-ID zur Verarbeitung an die SPU weiterleitet.

Beispiel: Paket (a ->b) kommt von IOC1 bei NPU1 an. NPU1 führt Plausibilitätsprüfungen durch und wendet DoS-Screens auf das Paket an. NPU1 überprüft seine Sitzungstabelle auf eine Tupelübereinstimmung, und es wird keine vorhandene Sitzung gefunden. NPU1 leitet das Paket zur Zuweisung zu einer SPU an den zentralen Punkt auf SPU1 weiter.

Der zentrale Punkt erstellt eine Sitzung mit dem Status "Ausstehend".

Der zentrale Punkt verwaltet eine globale Sitzungstabelle, die Einträge für alle Sitzungen enthält, die für alle SPUs auf dem Gerät vorhanden sind. Er beteiligt sich an der Sitzungserstellung und delegiert und vermittelt die Zuweisung von Sitzungsressourcen.

Dieser Prozess umfasst die folgenden Teile:

Der zentrale Punkt überprüft seine Sitzungs- und Gate-Tabelle, um festzustellen, ob eine Sitzung oder ein Gate für das Paket existiert, das er von der NPU empfängt. (Eine NPU hat ein Paket an den zentralen Punkt weitergeleitet, weil in der Tabelle angegeben ist, dass keine Sitzung dafür vorhanden ist. Der zentrale Punkt überprüft diese Informationen, bevor eine SPU für die Sitzung zugewiesen wird.)

Wenn es in einer der beiden Tabellen keinen Eintrag gibt, der mit dem Paket übereinstimmt, erstellt der zentrale Punkt einen Pending Wing für die Sitzung und wählt basierend auf seinem Lastausgleichsalgorithmus eine SPU aus, die für die Sitzung verwendet werden soll.

Der zentrale Punkt leitet das erste Paket des Datenstroms in einer Nachricht an die ausgewählte SPU weiter, in der er sie auffordert, lokal eine Sitzung einzurichten, die für den Paketfluss verwendet werden soll.

Beispiel: Der zentrale Punkt erzeugt einen schwebenden Flügel (a ->b) für die Sitzung. Es wählt SPU1 aus, das für die Sitzung verwendet werden soll. Er sendet SPU1 das (a->b)-Paket zusammen mit einer Nachricht, um eine Sitzung für ihn zu erstellen. (Es ist der Fall, dass SPU1 die SPU ist, die im Combo-Modus läuft. Daher werden die Sitzungsverwaltungs- und Datenflussverarbeitungsdienste für die Sitzung verwendet.

Die SPU richtet die Sitzung ein.

Auch jede SPU verfügt über eine Sitzungstabelle, die Informationen zu ihren Sitzungen enthält. Wenn die SPU eine Nachricht vom zentralen Punkt zum Einrichten einer Sitzung empfängt, überprüft sie ihre Sitzungstabelle, um sicherzustellen, dass für das Paket nicht bereits eine Sitzung vorhanden ist.

Wenn keine Sitzung für das Paket vorhanden ist, richtet die SPU die Sitzung lokal ein.

Die SPU sendet eine Nachricht an den zentralen Punkt, in der sie ihn auffordert, die Sitzung zu installieren.

Wenn NAT während der Verarbeitung des ersten Pakets aktiviert ist, weist die SPU IP-Adressressourcen für NAT zu. In diesem Fall wird die Verarbeitung des ersten Pakets für die Sitzung angehalten, bis der NAT-Zuordnungsprozess abgeschlossen ist.

Die SPU fügt der Warteschlange alle zusätzlichen Pakete für den Datenstrom hinzu, die sie möglicherweise empfängt, bis die Sitzung installiert wurde.

Beispiel: SPU1 erstellt die Sitzung für (a ->b) und sendet eine Nachricht zurück an den zentralen Punkt (der auf derselben SPU implementiert ist), in der er aufgefordert wird, die anstehende Sitzung zu installieren.

Die zentrale Stelle installiert die Sitzung.

Dadurch wird der Status für den ausstehenden Flügel der Sitzung auf aktiv gesetzt.

Er installiert den Reverse Wing für die Session als aktiven Schirm.

Er sendet eine ACK-Nachricht (Acknowledge) an die SPU, die angibt, dass die Sitzung installiert ist.

Beispiel: Die Zentrale erhält eine Nachricht von SPU1, um die Sitzung für (a->b) zu installieren. Es setzt den Sitzungsstatus für (a->b) Flügel auf aktiv. Er installiert den Reverse Wing (b->a) für die Session und aktiviert ihn; Dies ermöglicht die Zustellung von Paketen aus der umgekehrten Richtung des Datenstroms: Ziel (B) soll an die Quelle (A) geliefert werden.

Die SPU richtet die Sitzung auf den Eingangs- und Ausgangs-NPUs ein.

NPUs verwalten Informationen über eine Sitzung für die Weiterleitung und Zustellung von Paketen. Sitzungsinformationen werden in den Ausgangs- und Eingangs-NPUs (die manchmal identisch sind) eingerichtet, sodass Pakete direkt an die SPU gesendet werden können, die ihre Datenströme verwaltet, und nicht an den zentralen Punkt zur Umleitung.

Es findet eine Fast-Path-Verarbeitung statt.

Fahren Sie für die restlichen Schritte der Paketverarbeitung mit Schritt 1 in "Grundlegendes zur Fast-Path-Verarbeitung" fort.

Grundlegendes zur Fast-Path-Verarbeitung

Alle Pakete durchlaufen eine schnelle Verarbeitung. Wenn jedoch eine Sitzung für ein Paket vorhanden ist, durchläuft das Paket eine Schnellverarbeitung und umgeht den Prozess des ersten Pakets. Wenn bereits eine Sitzung für den Paketfluss vorhanden ist, durchläuft das Paket den zentralen Punkt nicht.

So funktioniert die Fast-Path-Verarbeitung: NPUs an den Ausgangs- und Eingangsschnittstellen enthalten Sitzungstabellen, die die Identifizierung der SPU enthalten, die den Fluss eines Pakets verwaltet. Da die NPUs über diese Sitzungsinformationen verfügen, wird der gesamte Datenverkehr für den Datenstrom, einschließlich des umgekehrten Datenverkehrs, zur Verarbeitung direkt an diese SPU gesendet.

Auf SRX1400-, SRX3400- und SRX3600-Geräten wird die iflset-Funktionalität für aggregierte Schnittstellen wie reth nicht unterstützt.

Grundlegendes zur Datenverkehrsverarbeitung auf SRX4600 Geräten

Die Juniper Networks SRX4600 Firewall integriert Flow-basierte Sicherheits- und Routing-Services, einschließlich erweiterter Sicherheit und Bedrohungsabwehr sowie herkömmlicher Stateful-Firewall-Sicherheit. Die Flow-basierte Infrastruktur von Junos OS bildet die Grundlage und das Framework für anwendungsbasierte Services von Layer 4 bis Layer 7. Die SRX4600 Firewall ist für den Einsatz als integrierte Firewall am Edge und Core des Datencenters großer Unternehmen sowie am Campus-Edge konzipiert. Es kann auch als LTE-Sicherheitsgateway und Gi/SGi-Firewall eingesetzt werden.

Dieses Thema umfasst die folgenden Inhalte:

- Grundlegendes zu Bereitstellungsszenarien für die SRX4600 Firewall und ihren Funktionen

- Flow-basierte Verarbeitung und Sitzungsgrundlagen

- Flow- und Sitzungskomponenten, die in Firewalls der SRX-Serie implementiert sind

Grundlegendes zu Bereitstellungsszenarien für die SRX4600 Firewall und ihren Funktionen

Die SRX4600 Firewall kann in vielen Bereichen eingesetzt werden, um Ihre Umgebung und deren Ressourcen zu schützen. Es wird häufig verwendet, um den Edge und Core des Datencenters auf folgende Weise zu schützen:

Bereitstellen der SRX4600 Firewall als Datencenter-Edge-Firewall

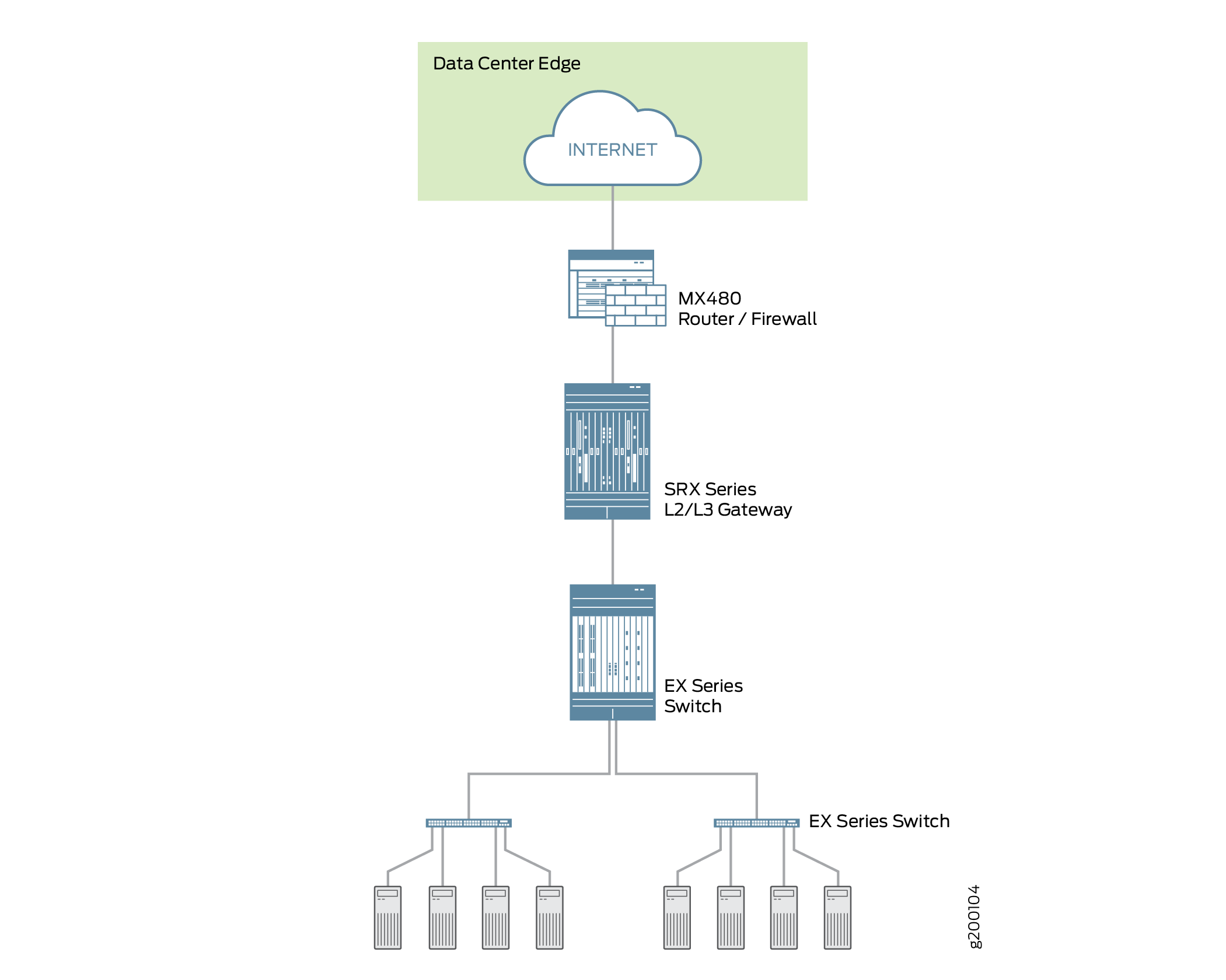

Sie können die SRX4600 Firewall am Edge Ihres Datencenters bereitstellen, um die Anwendungen und Services, die sie hostet, optimal zu schützen. Jedes Datencenter verfügt über einen Eingangspunkt, um Kunden den Zugriff auf die Services des Datencenters zu ermöglichen, aber böswillige Angreifer können ihn ausnutzen, um Angriffe auf diese Services zu starten. Ein großer Teil des Datenverkehrs, der in das Datencenter gelangt, ist eingehender Internetverkehr. Allein aus diesem Grund ist die Bereitstellung robuster, mehrschichtiger Sicherheit am Edge des Datencenters unerlässlich. Die SRX4600 Firewall blockiert Angriffe effektiv und zuverlässig und ermöglicht es Ihnen, das System so zu konfigurieren, dass bestimmte Arten von Angriffen vereitelt werden. Die SRX4600 Firewall unterstützt das Software-Defined Secure Network (SDSN)-Framework von Juniper, einschließlich Juniper Advanced Threat Prevention Cloud (ATP Cloud), das auf automatisierten und verwertbaren Informationen basiert, die schnell weitergegeben werden können, um Bedrohungen zu erkennen und zu entschärfen. Abbildung 2 zeigt die SRX4600 Firewall, die am Edge des Datencenters in Verbindung mit einem MX480-Router und Switches der EX-Serie bereitgestellt wird.

Abbildung 2: Bereitstellung der SRX4600 Firewall am Datencenter-Edge

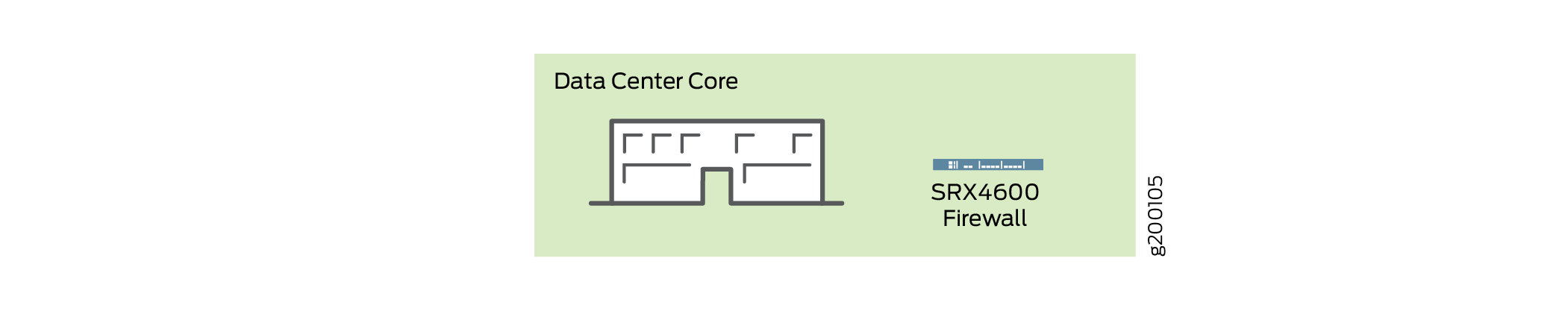

Bereitstellung der SRX4600 Firewall im Datencenter-Core

Sie können die SRX4600 Firewall im Datencenter-Core bereitstellen, um die Sicherheit zu erhöhen und sicherzustellen, dass die Compliance-Anforderungen erfüllt werden. Die Verarbeitung in Datencentern ist immer dynamischer geworden, was eine klare Netzwerkdefinition und die Durchsetzung von Compliance-Anforderungen erfordert. Um die Einhaltung der Vorschriften zu gewährleisten, können Sie die SRX4600 Firewall verwenden, um Ihr gesamtes Netzwerk in einzelne Servernetzwerke zu unterteilen und den Datenverkehr innerhalb dieser zu sichern. Die SRX4600-Firewall bietet Hochverfügbarkeit und Automatisierung, und ihre leistungsstarken Layer-3- und Layer-4-Services erfüllen die Sicherheitsanforderungen des Datencenter-Cores. Abbildung 3 zeigt die SRX4600 Firewall, die als mehrschichtige Firewall im Kern des Datencenters bereitgestellt wird.

Abbildung 3: Bereitstellung der SRX4600 Firewall im Datencenter-Core

Zusätzlich zu den erweiterten Anti-Malware-Funktionen unterstützt die SRX4600-Firewall die folgenden Funktionen:

Zustandsbehaftete Firewall

Anwendungssicherheits-Suite

Content Security (Sophos AV, Webfilterung, Antispam)

IDP

Hohe Verfügbarkeit (Chassis-Cluster)

Zwei HA-Steuerports (10 G)

MACsec-Unterstützung für HA-Ports

Ethernet-Schnittstellen über QSFP28 (100G/40G/4x10G-Modus), QSFP+ (40G/4x10G-Modi) und SFP+ (10G-Modus)

IPsec-VPN, einschließlich AutoVPN und Gruppen-VPNv2

QoS und Netzwerkservices

J-Web

Routing-Richtlinien mit Multicast

Flow-basierte Verarbeitung und Sitzungsgrundlagen

Um die Datenstromverarbeitung in der SRX4600 Firewall zu verstehen, ist es wichtig, die Grundlagen des Datenstroms zu verstehen.

Ein Datenstrom ist ein Strom zusammengehöriger Pakete, die die gleichen Übereinstimmungskriterien erfüllen und die gleichen Merkmale aufweisen. Junos OS behandelt Pakete, die zum selben Datenstrom gehören, auf die gleiche Weise. Die Architektur eines Services Gateways der SRX-Serie und die Art und Weise, wie es Paketflüsse verarbeitet, sind eng gekoppelt. Folglich wird der Datenstrom innerhalb der Familie der Firewalls der SRX-Serie aufgrund ihrer architektonischen Unterschiede teilweise unterschiedlich implementiert.

Die flussbasierte Paketverarbeitung, die zustandsbehaftet ist, erfordert die Erstellung von Sitzungen. Sitzungen werden auf der Grundlage von Routing- und anderen Datenverkehrsklassifizierungsinformationen erstellt, um Informationen zu speichern und Ressourcen für einen Datenstrom zuzuweisen. Sitzungen speichern Informationen über den Status des Datenstroms im Cache und speichern die meisten Sicherheitsmaßnahmen, die auf Pakete des Datenstroms angewendet werden sollen. Aufgrund der Unterschiede in der Architektur zwischen den Geräten werden Sitzungen auch von verschiedenen Geräten unterschiedlich verwaltet.

Unabhängig von diesen Unterschieden ist der Datenflussprozess konzeptionell auf allen Services Gateways gleich, und Sitzungen dienen denselben Zwecken und haben die gleichen Funktionen.

Flow- und Sitzungskomponenten, die in Firewalls der SRX-Serie implementiert sind

Die Firewalls der SRX-Serie verwenden die gleichen Infrastrukturkomponenten zur Unterstützung des Datenflusses und zur Verwaltung von Sitzungen, aber nicht alle Geräte implementieren alle.

Um den Flow zu verstehen, ist es wichtig, die folgenden Komponenten und deren Verwendung zu verstehen:

Die Services Processing Unit (SPU)

Eine SPU verwaltet die Sitzung für einen Paketfluss. Es wendet Sicherheitsfunktionen und andere Dienste auf das Paket an. Außerdem werden paketbasierte, zustandslose Firewall-Filter, Klassifizierer und Traffic-Shaper auf das Paket angewendet.

Der zentrale Punkt (CP)

Der zentrale Punkt ist eine SPU, die das System verwendet, um Ressourcen zuzuweisen und das Sitzungsmanagement auf SPUs zu verteilen. Wenn das erste Paket eines Datenstroms verarbeitet wird, bestimmt der zentrale Punkt, welche SPU für die Sitzung dieses Pakets verwendet werden soll. Die SRX4600 Firewall implementiert keinen zentralen Punkt.

Die Network Processing Unit (NPU) und die Netzwerkverarbeitungssitzung

Eine NPU ist ein Prozessor, der auf einer E/A-Karte (IOC) läuft und Pakete diskret verarbeitet. Wenn ein Datenfluss erstellt wird, werden nachfolgende Pakete des Datenstroms mit der Sitzung auf der NPU abgeglichen. Die NPU übernimmt zusätzliche Verarbeitungen wie TCP-Sequenzprüfung, TTL-Verarbeitung (Time-to-Live) und Layer-2-Header-Übersetzung. Eine NPU verbessert die Performance, indem eine zusätzliche Paketweiterleitung zwischen einer Session-SPU und einer Hash-SPU vermieden wird. Die SRX4600 Firewall implementiert eine NPU.

Die SRX4600 Firewall-Flow-Architektur wurde verbessert, um die Nutzung der fortschrittlichen Multi-Core-Xeon-Prozessoren™ des SRX4600 Geräts zu optimieren. Die SRX4600 Firewall implementiert die Verwendung eines dedizierten Sitzungsthreads, um Probleme wie die Verwaltung von Paketen außerhalb der Reihenfolge in einem Datenstrom zu umgehen. Es nutzt die Netzwerkverarbeitungssitzung, um sicherzustellen, dass Pakete an den richtigen, dedizierten Thread weitergeleitet werden. Pakete werden gemäß dem Hash-basierten Sitzungsverteilungsmodell auf verschiedene Threads verteilt.

Grundlegendes zur Datenverkehrsverarbeitung auf SRX5000 Leitungsgeräten

Junos OS auf SRX5000 Geräten ist ein verteiltes, paralleles Verarbeitungssystem mit hohem Durchsatz und hoher Leistung. Die verteilte Parallelverarbeitungsarchitektur der SRX5000-Reihe von Services Gateways umfasst mehrere Prozessoren zur Verwaltung von Sitzungen und zur Ausführung von Sicherheits- und anderen Service-Verarbeitungen. Diese Architektur bietet mehr Flexibilität und ermöglicht einen hohen Durchsatz und eine schnelle Leistung.

Bei SRX1400-, SRX3400-, SRX3600-, SRX5400-, SRX5600- und SRX5800-Geräten funktionieren IKE-Aushandlungen mit NAT-Traversierung nicht, wenn sich der IKE-Peer hinter einem NAT-Gerät befindet, das die Quell-IP-Adresse der IKE-Pakete während der Aushandlung ändert. Wenn das NAT-Gerät beispielsweise mit DIP konfiguriert ist, ändert es die Quell-IP, da das IKE-Protokoll den UDP-Port von 500 auf 4500 umschaltet.

Die E/A-Karten (IOCs) und Services Processing Cards (SPCs) auf Geräten der SRX5000-Reihe enthalten Verarbeitungseinheiten, die ein Paket verarbeiten, während es das Gerät durchläuft. Ein IOC verfügt über eine oder mehrere Network Processing Units (NPUs), und ein SPC verfügt über eine oder mehrere Services Processing Units (SPUs).

Diese Verarbeitungseinheiten haben unterschiedliche Zuständigkeiten. Alle datenstrombasierten Dienste für ein Paket werden auf einer einzigen SPU ausgeführt. Die Verantwortlichkeiten dieser NPUs sind in Bezug auf die anderen Arten von Diensten, die auf ihnen laufen, nicht klar abgegrenzt. .)

Zum Beispiel:

Eine NPU verarbeitet Pakete diskret. Es führt Plausibilitätsprüfungen durch und wendet einige Bildschirme, die für die Schnittstelle konfiguriert sind, wie z. B. Denial-of-Service-Bildschirme (DoS), auf das Paket an.

Eine SPU verwaltet die Sitzung für den Paketfluss und wendet Sicherheitsfunktionen und andere Dienste auf das Paket an. Außerdem werden paketbasierte, zustandslose Firewall-Filter, Klassifizierer und Traffic-Shaper auf das Paket angewendet.

Eine NPU leitet ein Paket mithilfe des Hash-Algorithmus an die SPU weiter. Bei einigen Anwendungen, wie z. B. ALG, muss das System jedoch den zentralen Punkt der Anwendung abfragen, um zu bestimmen, auf welcher SPU das Paket verarbeitet werden soll.

Diese diskreten, kooperierenden Teile des Systems, einschließlich des zentralen Punktes, speichern jeweils die Informationen, die identifizieren, ob eine Sitzung für einen Strom von Paketen existiert, und die Informationen, mit denen ein Paket abgeglichen wird, um zu bestimmen, ob es zu einer vorhandenen Sitzung gehört.

Diese Architektur ermöglicht es dem Gerät, die Verarbeitung aller Sitzungen auf mehrere SPUs zu verteilen. Außerdem kann eine NPU feststellen, ob eine Sitzung für ein Paket vorhanden ist, das Paket überprüfen und Raster auf das Paket anwenden. Wie ein Paket behandelt wird, hängt davon ab, ob es sich um das erste Paket in einem Datenfluss handelt.

In den folgenden Abschnitten wird die Verarbeitungsarchitektur am Beispiel von SRX5400-, SRX5600- und SRX5800 Geräten beschrieben:

- Grundlegendes zur Verarbeitung des ersten Pakets

- Grundlegendes zur Fast-Path-Verarbeitung

- Grundlegendes zum Datenpfad für Unicastsitzungen

- Grundlegendes zu Services Processing Units

- Grundlegendes zu den Scheduler-Merkmalen

- Grundlegendes zur Bündelung von Netzwerkprozessoren

Grundlegendes zur Verarbeitung des ersten Pakets

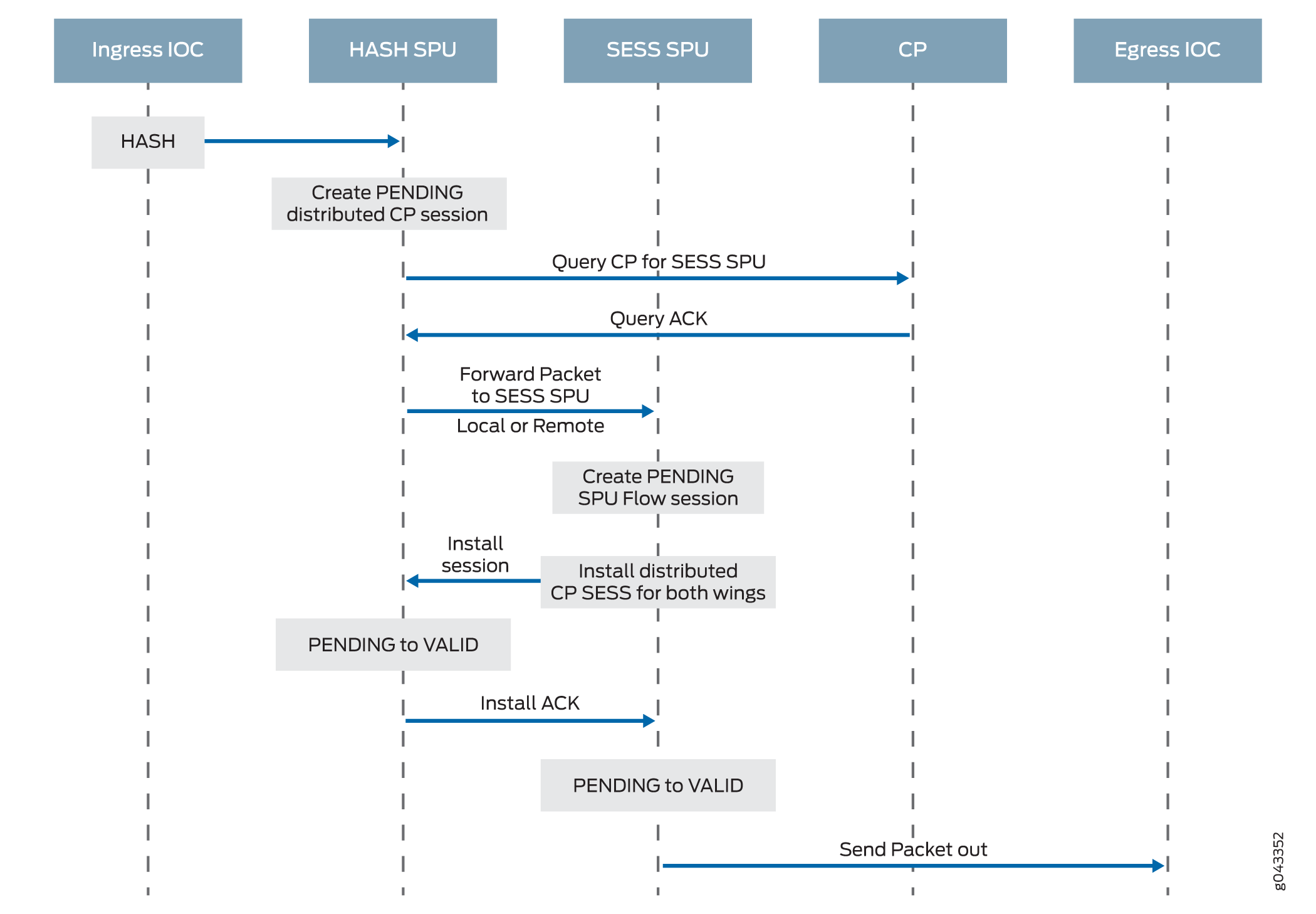

Abbildung 4 veranschaulicht den Pfad, den das erste Paket in einem Datenstrom nimmt, wenn es in das Gerät eintritt – die NPU stellt fest, dass keine Sitzung für das Paket vorhanden ist, und die NPU sendet das Paket an den verteilten zentralen Punkt, um eine verteilte zentrale Punktsitzung einzurichten. Der verteilte zentrale Punkt sendet dann eine Nachricht an den zentralen Punkt der Anwendung, um die SPU auszuwählen, eine Sitzung für das Paket einzurichten und das Paket zu verarbeiten. Der verteilte zentrale Punkt sendet dann das Paket an diese SPU. Die SPU verarbeitet das Paket und sendet es zur Übertragung vom Gerät an die NPU. (Diese allgemeine Beschreibung befasst sich nicht mit der Anwendung von Funktionen auf ein Paket.)

Nachdem das erste Paket in einem Datenstrom das System durchlaufen hat und eine Sitzung für das Paket eingerichtet wurde, wird es auf hohem Pfad verarbeitet.

Nachfolgende Pakete im Datenstrom werden ebenfalls auf hohem Pfad verarbeitet. In diesem Fall leitet die NPU das Paket an die SPU weiter, die ihre Sitzung verwaltet, nachdem jedes Paket in die Sitzung eingetreten ist und die NPU eine Übereinstimmung dafür in ihrer Sitzungstabelle gefunden hat.

Abbildung 5 veranschaulicht die Fast-Path-Verarbeitung. Dies ist der Pfad, den ein Paket nimmt, wenn bereits ein Datenstrom für die zugehörigen Pakete eingerichtet wurde. (Dies ist auch der Pfad, den das erste Paket in einem Datenfluss nach der Sitzung für den Datenfluss nimmt, den das initiierte Paket eingerichtet hat.) Nachdem das Paket das Gerät erreicht hat, findet die NPU eine Übereinstimmung für das Paket in ihrer Sitzungstabelle und leitet das Paket an die SPU weiter, die die Sitzung des Pakets verwaltet. Beachten Sie, dass das Paket die Interaktion mit dem zentralen Punkt umgeht.

Grundlegendes zur Fast-Path-Verarbeitung

Im folgenden Abschnitt wird erläutert, wie eine Sitzung erstellt wird und welcher Prozess ein Paket bei der Übertragung des Geräts durchläuft.

Im Folgenden finden Sie eine Übersicht über die Hauptkomponenten, die beim Einrichten einer Sitzung für ein Paket und beim Verarbeiten von Paketen sowohl diskret als auch als Teil eines Datenstroms beim Übertragen der SRX5400-, SRX5600- und SRX5800 Geräte eine Rolle spielen.

Network Processing Units (NPUs): NPUs befinden sich auf IOCs. Sie kümmern sich um die Überprüfung der Paketintegrität und die Anwendung einiger Bildschirme. NPUs verwalten Sitzungstabellen, anhand derer sie bestimmen, ob eine Sitzung für ein eingehendes Paket oder für umgekehrten Datenverkehr vorhanden ist.

Die NPU-Sitzungstabelle enthält einen Eintrag für eine Sitzung, wenn die Sitzung auf einer SPU für ein Paket aufgebaut wird, das zuvor über die Schnittstelle in das Gerät gelangt war und von dieser NPU verarbeitet wurde. Die SPU installiert die Sitzung in der NPU-Tabelle, wenn sie die Sitzung erstellt.

Eine NPU bestimmt, ob eine Sitzung für ein Paket vorhanden ist, indem sie die Paketinformationen mit der Sitzungstabelle abgleicht. Wenn das Paket mit einer vorhandenen Sitzung übereinstimmt, sendet die NPU das Paket und die Metadaten dafür an die SPU. Wenn keine Sitzung stattfindet, senden die NPUs das Paket an eine SPU, die mit dem Hash-Algorithmus berechnet wird.

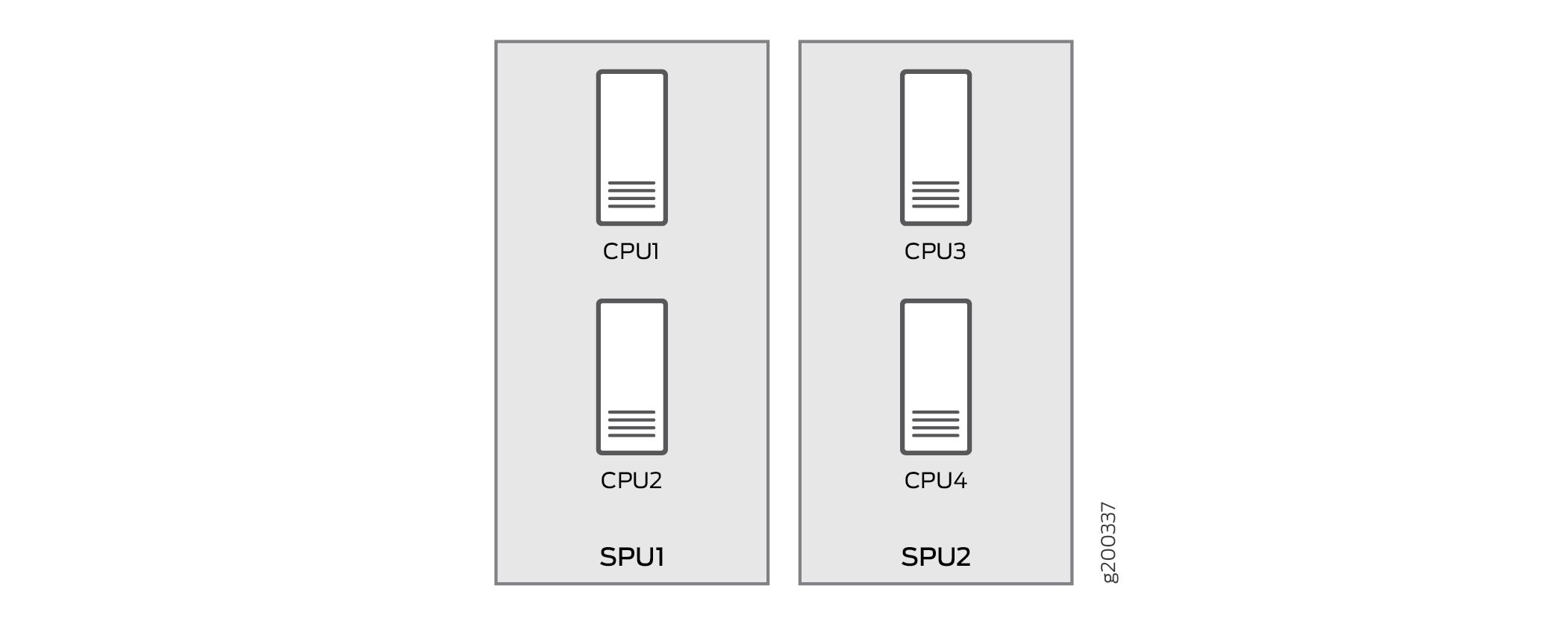

Services Processing Units (SPUs): Die Hauptprozessoren der SRX5400-, SRX5600- und SRX5800-Geräte befinden sich auf SPCs. SPUs etablieren und verwalten Datenverkehrsflüsse und führen den größten Teil der Paketverarbeitung für ein Paket durch, während es das Gerät durchquert. Jede SPU verwaltet eine Hash-Tabelle für die schnelle Suche nach Sitzungen. Die SPU wendet zustandslose Firewallfilter, Klassifizierer und Datenverkehrsformer auf den Datenverkehr an. Eine SPU führt die gesamte datenflussbasierte Verarbeitung für ein Paket und die meisten paketbasierten Verarbeitungsvorgänge aus. Jede Multicore-SPU verarbeitet Pakete unabhängig voneinander mit minimaler Interaktion zwischen SPUs auf demselben oder unterschiedlichen SPC. Alle Pakete, die zum gleichen Fluss gehören, werden von derselben SPU verarbeitet.

Die SPU verwaltet eine Sitzungstabelle mit Einträgen für alle Sitzungen, die sie eingerichtet hat und deren Pakete sie verarbeitet. Wenn eine SPU ein Paket von einer NPU empfängt, überprüft sie ihre Sitzungstabelle, um sicherzustellen, dass das Paket zu ihr gehört. Er überprüft auch seine Sitzungstabelle, wenn er ein Paket vom verteilten zentralen Punkt empfängt, und sendet eine Nachricht, um eine Sitzung für dieses Paket einzurichten, um sicherzustellen, dass keine Sitzung für das Paket vorhanden ist.

Zentraler Punkt: Die Architektur des zentralen Punktes ist in zwei Module unterteilt: den zentralen Punkt der Anwendung und den verteilten zentralen Punkt. Der zentrale Punkt der Anwendung ist für das globale Ressourcenmanagement und das Load Balancing zuständig, während der verteilte zentrale Punkt für die Identifizierung des Datenverkehrs (Global Session Matching) zuständig ist. Die Funktionalität des zentralen Punktes der Anwendung wird auf der dedizierten SPU des zentralen Punktes ausgeführt, während die Funktionalität des verteilten zentralen Punktes auf die übrigen SPUs verteilt wird. Jetzt befinden sich die zentralen Punktsitzungen nicht mehr auf der dedizierten zentralen Punkt-SPU, sondern mit dem verteilten zentralen Punkt auf anderen Flow-SPUs.

Routing-Engine: Die Routing-Engine führt die Steuerungsebene aus.

Grundlegendes zum Datenpfad für Unicastsitzungen

In diesem Abschnitt wird beschrieben, wie eine Sitzung für Pakete eingerichtet wird, die zu einem Datenfluss gehören, der das Gerät durchläuft.

Um den Sitzungsaufbau und den Paketspaziergang einschließlich der Punkte, an denen Dienste auf die Pakete in einem Datenfluss angewendet werden, zu veranschaulichen, wird in diesem Beispiel der einfache Fall einer Unicastsitzung verwendet.

Dieser Paket-"Walk" führt die paketbasierte und die Flow-basierte Verarbeitung zusammen, die Junos OS für das Paket ausführt.

- Session-Lookup und Paketübereinstimmungskriterien

- Grundlegendes zur Sitzungserstellung: Verarbeitung des ersten Pakets

- Grundlegendes zur Fast-Path-Verarbeitung

Session-Lookup und Paketübereinstimmungskriterien

Um festzustellen, ob ein Paket zu einem vorhandenen Datenstrom gehört, versucht das Gerät, die Informationen des Pakets anhand der folgenden sechs Übereinstimmungskriterien mit denen einer vorhandenen Sitzung abzugleichen:

Quelladresse

Zieladresse

Quell-Port

Zielhafen

Protokoll

Eindeutiges Token aus einer bestimmten Zone und einem bestimmten virtuellen Router

Grundlegendes zur Sitzungserstellung: Verarbeitung des ersten Pakets

In diesem Abschnitt wird erläutert, wie eine Sitzung für die Verarbeitung der Pakete eingerichtet wird, aus denen sich ein Datenfluss zusammensetzt. Um den Prozess zu veranschaulichen, wird in diesem Abschnitt ein Beispiel mit einer Quelle "a" und einem Ziel "b" verwendet. Die Richtung von der Quelle zum Ziel für die Pakete des Datenstroms wird als (a ->b) bezeichnet. Die Richtung vom Ziel zur Quelle wird als (b->a) bezeichnet.

Schritt 1. Ein Paket kommt an einer Schnittstelle auf dem Gerät an und wird von der NPU verarbeitet.

In diesem Abschnitt wird beschrieben, wie ein Paket behandelt wird, wenn es bei einem Eingangs-IOC einer Firewall der SRX-Serie eintrifft.

Das Paket kommt im IOC des Geräts an und wird von der NPU auf dem IOC verarbeitet.

Die NPU führt grundlegende Plausibilitätsprüfungen für das Paket durch und wendet einige für die Schnittstelle konfigurierte Bildschirme auf das Paket an.

Die NPU prüft ihre Sitzungstabelle auf eine vorhandene Sitzung für das Paket. (Es vergleicht das Tupel des Pakets mit denen von Paketen für vorhandene Sitzungen in seiner Sitzungstabelle.)

Wenn keine vorhandene Sitzung gefunden wird, leitet die NPU das Paket an die Hash-SPU weiter.

Wenn eine Sitzungsübereinstimmung gefunden wird, wurde die Sitzung bereits auf einer SPU erstellt, die ihr zugewiesen wurde, sodass die NPU das Paket zusammen mit der Sitzungs-ID zur Verarbeitung an die SPU weiterleitet.

Example: Paket (a ->b) kommt bei NPU1 an. NPU1 führt Plausibilitätsprüfungen durch und wendet DoS-Screens auf das Paket an. NPU1 überprüft seine Sitzungstabelle auf eine Tupelübereinstimmung, und es wurde keine vorhandene Sitzung gefunden. NPU1 leitet das Paket an eine SPU weiter.

Schritt 2. Der verteilte zentrale Punkt erstellt eine Sitzung mit dem Status "Ausstehend".

Wenn eine NPU ein Paket empfängt, sendet die NPU es basierend auf dem Hash-Algorithmus an den verteilten zentralen Punkt. Der verteilte zentrale Punkt sucht dann nach der Sitzungstabelle des verteilten zentralen Punktes und erstellt bei Bedarf einen Eintrag.

Dieser Prozess umfasst die folgenden Teile:

Der verteilte zentrale Punkt überprüft seine Sitzungstabelle, um festzustellen, ob eine Sitzung für das von der NPU empfangene Paket vorhanden ist. (Eine NPU leitet ein Paket an den verteilten zentralen Punkt weiter, da sie keine vorhandene Sitzung für das Paket finden kann.)

Wenn in der Sitzungstabelle für den verteilten zentralen Punkt kein Eintrag vorhanden ist, der mit dem Paket übereinstimmt, erstellt der verteilte zentrale Punkt einen ausstehenden Flügel für die Sitzung. Der verteilte zentrale Punkt sendet dann eine Abfragenachricht an den zentralen Punkt der Anwendung, um eine SPU auszuwählen, die für die Sitzung verwendet werden soll.

Nach Erhalt der Abfragenachricht überprüft der zentrale Punkt der Anwendung seine Gate-Tabelle, um festzustellen, ob ein Gate für das Paket vorhanden ist. Wenn ein Gate übereinstimmt oder ein anderer Sitzungsverteilungsalgorithmus ausgelöst wird, wählt der zentrale Punkt der Anwendung eine andere SPU aus, um das Paket zu verarbeiten. Andernfalls wird die SPU (d. h. die SPU für den verteilten zentralen Punkt) ausgewählt. Schließlich sendet der zentrale Punkt der Anwendung eine Abfrageantwort an den verteilten zentralen Punkt.

Nach Erhalt der Abfrageantwort leitet der verteilte zentrale Punkt das erste Paket im Fluss an die ausgewählte SPU in einer Nachricht weiter, in der die SPU angewiesen wird, lokal eine Sitzung einzurichten, die für den Paketfluss verwendet werden soll. Beispielsweise erstellt der verteilte zentrale Punkt einen ausstehenden Flügel (a ->b) für die Sitzung. Der zentrale Punkt der Anwendung wählt SPU1 aus, das dafür verwendet werden soll. Der verteilte zentrale Punkt sendet SPU1 das (a->b)-Paket zusammen mit einer Nachricht, um eine Sitzung für den verteilten zentralen Punkt zu erstellen.

Example: Der verteilte zentrale Punkt erzeugt einen Pending Wing (a ->b) für die Session. Es wählt SPU1 aus, das dafür verwendet werden soll. Er sendet SPU1 das (a->b)-Paket zusammen mit einer Nachricht, um eine Sitzung für ihn zu erstellen.

Schritt 3. Die SPU richtet die Sitzung ein.

Auch jede SPU verfügt über eine Sitzungstabelle, die Informationen zu ihren Sitzungen enthält. Wenn die SPU eine Nachricht vom verteilten zentralen Punkt zum Einrichten einer Sitzung empfängt, überprüft sie ihre Sitzungstabelle, um sicherzustellen, dass für das Paket nicht bereits eine Sitzung vorhanden ist.

Wenn keine Sitzung für das Paket vorhanden ist, richtet die SPU die Sitzung lokal ein.

Die SPU sendet eine Nachricht an den verteilten zentralen Punkt, in der sie ihn anweist, die Sitzung zu installieren.

Hinweis:Wenn NAT während der Verarbeitung des ersten Pakets aktiviert ist, weist die SPU IP-Adressressourcen für NAT zu. In diesem Fall wird die Verarbeitung des ersten Pakets für die Sitzung angehalten, bis der NAT-Zuordnungsprozess abgeschlossen ist.

Die SPU fügt der Warteschlange alle zusätzlichen Pakete für den Datenstrom hinzu, die sie möglicherweise empfängt, bis die Sitzung installiert wurde.

Example: SPU1 erstellt die Sitzung für (a ->b) und sendet eine Nachricht zurück an den verteilten zentralen Punkt, in der er ihn anweist, die ausstehende Sitzung zu installieren.

Schritt 4. Der verteilte zentrale Punkt installiert die Sitzung.

Der verteilte zentrale Punkt empfängt die Installationsnachricht von der SPU.

Der verteilte zentrale Punkt setzt den Status für den ausstehenden Flügel der Sitzung auf aktiv.

Der verteilte Mittelpunkt installiert den Reverse-Wing für die Session als aktiven Wing.

Hinweis:In einigen Fällen, wie z. B. NAT, kann der umgekehrte Flügel an einem anderen verteilten zentralen Punkt als dem verteilten zentralen Punkt des init-Flügels installiert werden.

Er sendet eine Bestätigungsnachricht (ACK) an die SPU, die angibt, dass die Sitzung installiert ist.

Example: Die verteilte Zentrale erhält eine Nachricht von SPU1, um die Sitzung für den (a->b)-Flügel zu installieren. Es setzt den Sitzungsstatus für den (a->b)-Flügel auf aktiv. Er installiert den Reverse Wing (b->a) für die Session und aktiviert ihn; Dies ermöglicht die Zustellung von Paketen aus der umgekehrten Richtung des Datenstroms: Ziel (B) soll an die Quelle (A) geliefert werden.

Schritt 5. Die SPU richtet die Sitzung auf den Eingangs- und Ausgangs-NPUs ein.

NPUs verwalten Informationen über eine Sitzung für die Weiterleitung und Zustellung von Paketen. Sitzungsinformationen werden in den Ausgangs- und Eingangs-NPUs (die manchmal identisch sind) eingerichtet, sodass Pakete direkt an die SPU gesendet werden können, die ihre Datenströme verwaltet, und nicht zur Umleitung an den verteilten zentralen Punkt.

Schritt 6. Es findet eine Fast-Path-Verarbeitung statt.

Fahren Sie für die restlichen Schritte der Paketverarbeitung mit Schritt 1 in Grundlegendes zur Fast-Path-Verarbeitung fort.

Abbildung 6 veranschaulicht den ersten Teil des Prozesses, den das erste Paket in einem Datenstrom durchläuft, nachdem es das Gerät erreicht hat. An diesem Punkt wird eine Sitzung eingerichtet, um das Paket und die restlichen Pakete, die zu seinem Fluss gehören, zu verarbeiten. Anschließend werden es und die übrigen Pakete im Datenfluss einer Fast-Path-Verarbeitung unterzogen.

Grundlegendes zur Fast-Path-Verarbeitung

Alle Pakete durchlaufen eine schnelle Verarbeitung. Wenn jedoch eine Sitzung für ein Paket vorhanden ist, durchläuft das Paket eine Schnellverarbeitung und umgeht den Prozess des ersten Pakets. Wenn bereits eine Sitzung für den Paketfluss vorhanden ist, durchläuft das Paket den zentralen Punkt nicht.

So funktioniert die Fast-Path-Verarbeitung: NPUs an den Ausgangs- und Eingangsschnittstellen enthalten Sitzungstabellen, die die Identifizierung der SPU enthalten, die den Fluss eines Pakets verwaltet. Da die NPUs über diese Sitzungsinformationen verfügen, wird der gesamte Datenverkehr für den Datenstrom, einschließlich des umgekehrten Datenverkehrs, zur Verarbeitung direkt an diese SPU gesendet.

Um den Fast-Path-Prozess zu veranschaulichen, wird in diesem Abschnitt ein Beispiel mit einer Quelle "a" und einem Ziel "b" verwendet. Die Richtung von der Quelle zum Ziel für die Pakete des Datenstroms wird als (a->b) bezeichnet. Die Richtung vom Ziel zur Quelle wird als (b->a) bezeichnet.

Schritt 1. Ein Paket kommt am Gerät an und wird von der NPU verarbeitet.

In diesem Abschnitt wird beschrieben, wie ein Paket behandelt wird, wenn es im IOC eines Services Gateways eintrifft.

Das Paket kommt am IOC des Geräts an und wird von der NPU auf der Karte verarbeitet.

Die NPU führt Plausibilitätsprüfungen durch und wendet einige Screens, wie z. B. Denial-of-Service-Screens (DoS), auf das Paket an.

Die NPU identifiziert einen Eintrag für eine vorhandene Sitzung in ihrer Sitzungstabelle, mit dem das Paket übereinstimmt.

Die NPU leitet das Paket zusammen mit Metadaten aus ihrer Sitzungstabelle, einschließlich der Sitzungs-ID und der Pakettupelinformationen, an die SPU weiter, die die Sitzung für den Datenstrom verwaltet, zustandslose Firewall-Filter und CoS-Funktionen auf ihre Pakete anwendet und die Datenflussverarbeitung des Pakets sowie die Anwendung von Sicherheits- und anderen Funktionen übernimmt.

Example: Paket (a ->b) kommt bei NPU1 an. NPU1 führt Plausibilitätsprüfungen für das Paket durch, wendet DoS-Screens darauf an und überprüft seine Sitzungstabelle auf eine Tupelübereinstimmung. Es findet eine Übereinstimmung und dass eine Sitzung für das Paket auf SPU1 existiert. NPU1 leitet das Paket zur Verarbeitung an SPU1 weiter.

Schritt 2. Die SPU für die Sitzung verarbeitet das Paket.

Der größte Teil der Verarbeitung eines Pakets findet auf der SPU statt, der seine Sitzung zugewiesen ist. Das Paket wird für paketbasierte Funktionen wie zustandslose Firewallfilter, Datenverkehrsformer und Klassifizierer verarbeitet, falls zutreffend. Konfigurierte datenflussbasierte Sicherheit und zugehörige Dienste wie Firewall-Funktionen, NAT, ALGs usw. werden auf das Paket angewendet. (Informationen dazu, wie Sicherheitsdienste für eine Sitzung bestimmt werden.

Bevor das Paket verarbeitet wird, überprüft die SPU ihre Sitzungstabelle, um sicherzustellen, dass das Paket zu einer ihrer Sitzungen gehört.

Die SPU verarbeitet das Paket für die entsprechenden Funktionen und Dienste.

Example: SPU1 empfängt das Paket (a->b) von NPU1. SPU1 überprüft seine Sitzungstabelle, um sicherzustellen, dass das Paket zu einer seiner Sitzungen gehört. Dann verarbeitet es Pakete (a ->b) gemäß Eingabefiltern und CoS-Funktionen, die für seine Eingabeschnittstelle gelten. Die SPU wendet die Sicherheitsfunktionen und -dienste an, die für den Fluss des Pakets konfiguriert sind, basierend auf ihrer Zone und ihren Richtlinien. Falls konfiguriert, werden Ausgabefilter, Traffic-Shaper und zusätzliche Bildschirme auf das Paket angewendet.

Schritt 3. Die SPU leitet das Paket an die NPU weiter.

Die SPU leitet das Paket an die NPU weiter.

Die NPU wendet alle anwendbaren Bildschirme, die der Schnittstelle zugeordnet sind, auf das Paket an.

Example: SPU1 leitet das Paket (a ->b) an NPU2 weiter, und NPU2 wendet DoS-Screens an.

Schritt 4. Die Schnittstelle überträgt das Paket vom Gerät.

Example: Die Schnittstelle überträgt das Paket (a->b) vom Gerät.

Schritt 5. Ein Reverse-Traffic-Paket kommt an der Ausgangsschnittstelle an und wird von der NPU verarbeitet.

Dieser Schritt spiegelt Schritt 1 genau umgekehrt wider. Weitere Informationen finden Sie in Schritt 1 in diesem Abschnitt.

Example: Paket (b->a) trifft bei NPU2 ein. NPU2 überprüft seine Sitzungstabelle auf eine Tupelübereinstimmung. Es findet eine Übereinstimmung und dass eine Sitzung für das Paket auf SPU1 existiert. NPU2 leitet das Paket zur Verarbeitung an SPU1 weiter.

Schritt 6. Die SPU für die Sitzung verarbeitet das Reverse-Traffic-Paket.

Dieser Schritt ist derselbe wie Schritt 2, mit der Ausnahme, dass er für den umgekehrten Datenverkehr gilt. Weitere Informationen finden Sie in Schritt 2 in diesem Abschnitt.

Example: SPU1 empfängt das Paket (b->a) von NPU2. Er überprüft seine Sitzungstabelle, um sicherzustellen, dass das Paket zu der von NPU2 identifizierten Sitzung gehört. Anschließend werden paketbasierte Funktionen, die für die Schnittstelle der NPU1 konfiguriert sind, auf das Paket angewendet. Er verarbeitet Pakete (b->a) gemäß den Sicherheitsfunktionen und anderen Diensten, die für seinen Datenfluss konfiguriert sind, basierend auf seiner Zone und seinen Richtlinien.

Schritt 7. Die SPU leitet das Reverse-Traffic-Paket an die NPU weiter.

Dieser Schritt ist derselbe wie Schritt 3, mit der Ausnahme, dass er für den umgekehrten Datenverkehr gilt. Weitere Informationen finden Sie in Schritt 3 in diesem Abschnitt.

Example: SPU1 leitet das Paket (b->a) an NPU1 weiter. NPU1 verarbeitet alle für die Schnittstelle konfigurierten Bildschirme.

8. Die Schnittstelle überträgt das Paket vom Gerät.

Dieser Schritt ist derselbe wie Schritt 4, mit der Ausnahme, dass er für den umgekehrten Datenverkehr gilt. Weitere Informationen finden Sie in Schritt 4 in diesem Abschnitt.

Beispiel: Die Schnittstelle überträgt das Paket (b->a) vom Gerät.

Abbildung 7 veranschaulicht den Prozess, den ein Paket durchläuft, wenn es das Gerät erreicht und eine Sitzung für den Datenstrom existiert, zu dem das Paket gehört.

Grundlegendes zu Services Processing Units

Für eine bestimmte physische Schnittstelle empfängt die SPU eingehende Pakete von allen Netzwerkprozessoren im Netzwerkprozessorpaket, das der physischen Schnittstelle zugeordnet ist. Die SPU extrahiert Netzwerkprozessor-Bundle-Informationen von der physischen Schnittstelle und verwendet denselben 5-Tupel-Hash-Algorithmus, um einen Datenfluss einem Netzwerkprozessorindex zuzuordnen. Um den Netzwerkprozessor zu ermitteln, führt die SPU eine Suche im Netzwerkprozessorindex im Netzwerkprozessorpaket durch. Die SPU sendet Ausgangspakete für den ausgehenden Datenverkehr an das lokale Physical Interface Module (PIM) der physischen Schnittstelle.

Der Netzwerkprozessor und die SPU verwenden denselben 5-Tupel-Hash-Algorithmus, um die Hash-Werte für die Pakete abzurufen.

Grundlegendes zu den Scheduler-Merkmalen

Für SRX5400-, SRX5600- und SRX5800 Geräte unterstützt der IOC die folgenden hierarchischen Scheduler-Merkmale:

IFL – Die Konfiguration des Netzwerkprozessorpakets wird in der Datenstruktur der physischen Schnittstelle gespeichert. Beispielsweise verfügen SRX5400-, SRX5600- und SRX5800-Geräte über maximal 48 PIMs. Die physische Schnittstelle kann eine 48-Bit-Maske verwenden, um das PIM anzuzeigen, oder der Datenverkehr des Netzwerkprozessors von dieser physischen Schnittstelle wird zusätzlich zum primären Netzwerkprozessor der physischen Schnittstelle verteilt.

Auf SRX5000-Line-Geräten wird die iflset-Funktionalität für aggregierte Schnittstellen wie reth nicht unterstützt.

IFD – Die logische Schnittstelle , die der physischen Schnittstelle eines Netzwerkprozessorpakets zugeordnet ist, wird an alle IOCs übergeben, die über ein PIM im Netzwerkprozessorpaket verfügen.

Grundlegendes zur Bündelung von Netzwerkprozessoren

Die Bündelungsfunktion für Netzwerkprozessoren ist auf Geräten der SRX5000-Reihe verfügbar. Diese Funktion ermöglicht die Verteilung des Datenverkehrs von einer Schnittstelle auf mehrere Netzwerkprozessoren für die Paketverarbeitung. Ein primärer Netzwerkprozessor wird einer Schnittstelle zugewiesen, die den eingehenden Datenverkehr empfängt und die Pakete auf mehrere andere sekundäre Netzwerkprozessoren verteilt. Ein einzelner Netzwerkprozessor kann als primärer Netzwerkprozessor oder als sekundärer Netzwerkprozessor für mehrere Schnittstellen fungieren. Ein einzelner Netzwerkprozessor kann nur einem Netzwerkprozessorpaket beitreten.

Einschränkungen bei der Bündelung von Netzwerkprozessoren

Für die Bündelungsfunktion von Netzwerkprozessoren gelten die folgenden Einschränkungen:

Die Bündelung von Netzwerkprozessoren ermöglicht insgesamt 16 PIMs pro Bündel und 8 verschiedene Netzwerkprozessor-Bündelsysteme.

Sie müssen das Gerät neu starten, um die Konfigurationsänderungen auf das Bundle anzuwenden.

Die Bündelung von Netzwerkprozessoren befindet sich in der Gesamtarchitektur unterhalb der reth-Schnittstelle. Sie können eine oder beide Schnittstellen aus dem Netzwerkprozessor-Bundle auswählen, um die reth-Schnittstelle zu bilden.

Wenn der IOC aus einem Netzwerkprozessorpaket entfernt wird, gehen die Pakete, die an das PIM auf diesem IOC weitergeleitet werden, verloren.

Wenn das Netzwerkprozessorpaket aktiviert ist, gelten die ICMP-, UDP- und TCP-Synchronisierungs-Flooding-Schwellenwerte nicht mehr für eine Schnittstelle. Pakete werden zur Verarbeitung an mehrere Netzwerkprozessoren verteilt. Diese Schwellenwerte gelten für jeden Netzwerkprozessor im Netzwerkprozessorpaket.

Die Bündelung von Netzwerkprozessoren wird im Layer-2-Modus nicht unterstützt.

Aufgrund von Speicherbeschränkungen auf dem Netzwerkprozessor ist die Anzahl der gebündelten Ports des Netzwerkprozessors, die pro PIM unterstützt werden, begrenzt. Innerhalb des Netzwerkprozessorpakets muss jeder Port über einen globalen Portindex verfügen. Der globale Portindex wird mit der folgenden Formel berechnet:

Global_port_index = (global_pic * 16) + port_offset

Link Aggregation Groups (LAGs) und redundante Ethernet-Schnittstellen-LAGs in Chassis-Cluster-Implementierungen können mit der Bündelung von Netzwerkprozessoren koexistieren. Allerdings können sich weder LAGs noch redundante Ethernet-Schnittstellen-LAGs mit einem Netzwerkprozessorpaket überschneiden oder physische Verbindungen mit diesem gemeinsam nutzen.

Grundlegendes zum Sitzungscache

- Übersicht

- Selektive Session-Cache-Installation

- Verbesserung der IPsec-VPN-Sitzungsaffinität mithilfe des Sitzungscaches

- Reihenfolge von Fragmentierungspaketen mithilfe des NP-Sitzungscaches

Übersicht

SRX5K-MPC (IOC2), SRX5K-MPC3-100G10G (IOC3) und SRX5K-MPC3-40G10G (IOC3) auf SRX5400-, SRX5600- und SRX5800 Geräten unterstützen den Sitzungscache und die selektive Installation des Sitzungscaches.

Der Sitzungscache wird verwendet, um eine Konversation zwischen dem Netzwerkprozessor (NP) und der SPU auf einem IOC zwischenzuspeichern. Bei einer Konversation kann es sich um eine Sitzung, GTP-U-Tunnelverkehr, IPsec-VPN-Tunnelverkehr usw. handeln. Eine Konversation hat zwei Sitzungscache-Einträge, einen für eingehenden Datenverkehr und den anderen für umgekehrten Datenverkehr. Je nachdem, wo sich die Eingangs- und Ausgangsports des Datenverkehrs befinden, können sich zwei Einträge im selben Netzwerkprozessor oder in verschiedenen Netzwerkprozessoren befinden. IOCs unterstützen den Sitzungscache für IPv6-Sitzungen.

Ein Session-Cache-Eintrag wird auch als Session-Wing bezeichnet.

Der Sitzungscache auf dem IOC nutzt die Express Path-Funktionalität (früher bekannt als Services Offloading) und hilft, Probleme wie hohe Latenz und IPsec-Leistungseinbußen zu vermeiden.

Ein Sitzungscacheeintrag zeichnet Folgendes auf:

An welche SPU der Traffic der Conversion weitergeleitet werden soll

An welchen Ausgangsport der Datenverkehr der Konvertierung im Express-Path-Modus weitergeleitet werden soll

Verarbeitung für ausgehenden Datenverkehr, z. B. NAT-Übersetzung im Express-Path-Modus

Ab Junos OS Version 15.1X49-D10 und Junos OS Version 17.3R1 hilft der Sitzungscache der Sitzungen im IOC bei der Lösung bestimmter Leistungsprobleme. Die SPU kann nun den IOC-Sitzungscache anweisen, nachfolgenden Datenverkehr an eine bestimmte Anker-SPU weiterzuleiten.

Ab Junos OS Version 15.1X49-D10 unterstützen der SRX5K-MPC (IOC2) und der IOC3 VPN-Sitzungsaffinität durch verbessertes Flow-Modul und verbesserten Sitzungs-Cache. Ab Junos OS Version 12.3X48-D30 wird auf dem IOC2 VPN-Sitzungsaffinität über den Sitzungscache unterstützt.

Anderer Datenverkehr wurde basierend auf ihren 5-Tupel-Schlüsselinformationen an SPUs gehasht. Beim VPN-Datenverkehr wurde das Konzept der verankerten SPU verwendet, das nicht unbedingt mit den Funktionen der Flow-SPU übereinstimmte. Der Netzwerkprozessor konnte die Pakete nur basierend auf dem 5-Tupel-Hash an die Flow-SPU weiterleiten. Die Flow-SPU leitete das Paket dann an die verankerte SPU weiter. Dadurch entstand ein zusätzlicher Hop für VPN-Datenverkehr, wodurch die Bandbreite der Switch-Fabric verschwendet und der VPN-Durchsatz um etwa die Hälfte reduziert wurde. Diese Leistungsminderung trat auf, weil der Datenverkehr nach der Verarbeitung auf der verankerten SPU immer noch zur Flow-SPU zurückkehren musste.

Die Sitzungs-Cache-Tabelle wurde jetzt auf IOC erweitert, um die NP-Sitzungen zu unterstützen. Express-Path-Datenverkehr und NP-Datenverkehr verwenden dieselbe Sitzungscachetabelle auf IOCs. Express Path-Datenverkehr wird vom IOC selbst entweder lokal oder an ein anderes IOC weitergeleitet, da für den Datenverkehr keine Services von der SPU erforderlich sind. NP-Datenverkehr wird zur weiteren Verarbeitung an die im Sitzungscache angegebene SPU weitergeleitet. Alle Sitzungscacheeinträge werden sowohl vom Express Path-Sitzungsdatenverkehr als auch vom NP-Datenverkehr gemeinsam genutzt.

Um den Sitzungscache auf den IOCs zu aktivieren, müssen Sie den set chassis fpc <fpc-slot> np-cache Befehl ausführen.

IOC2 und IOC3 verwenden den Mechanismus zum Löschen von Verzögerungssitzungen. Dieselben Sitzungen (Sitzungen mit denselben fünf Tupeln), die gelöscht und dann sofort neu installiert werden, werden nicht auf den IOCs zwischengespeichert.

Selektive Session-Cache-Installation

Um hohe Latenzzeiten zu vermeiden, die IPSec-Leistung zu verbessern und die wertvollen Ressourcen besser zu nutzen, werden bestimmte Prioritätsmechanismen sowohl auf das Flow-Modul als auch auf das IOC angewendet.

Die IOCs verwalten und überwachen die Schwellenwerte für die Nutzung des Sitzungscaches. Die IOCs übermitteln auch die Sitzungscachenutzung an die SPU, sodass die SPU bei Erreichen eines bestimmten Schwellenwerts für die Sitzungscachenutzung nur für selektive Datenverkehrssitzungen mit hoher Priorität Sitzungscache-Installationsanforderungen sendet.

Anwendungen wie IDP und ALG müssen Pakete der Reihe nach verarbeiten. Eine SPU verfügt über mehrere Flow-Threads, um Pakete zu verarbeiten, die zu einer Sitzung gehören, Load Balancing Thread (LBT) und Paketreihenfolge (Packet Ordering Thread, POT) kann sicherstellen, dass der Datenverkehr in der richtigen Reihenfolge durch die Firewall geleitet wird, es kann nicht garantiert werden, dass die Anwendung Pakete, die zu derselben Sitzung gehören, in der richtigen Reihenfolge verarbeitet. Die Flow-Serialisierung bietet die Methode, dass jeweils nur ein SPU-Flow-Thread-Verarbeitungspaket zur gleichen Sitzung gehört, sodass Anwendungen Pakete der Reihe nach empfangen, verarbeiten und senden können. Andere Flow-Threads können gleichzeitig die Verarbeitung der Flow-Serialisierung für andere Sitzungen durchführen.

Die folgenden vier Prioritätsstufen werden verwendet, um zu bestimmen, welcher Datenverkehrstyp Sitzungscache auf den IOCs installieren kann:

Priority 1 (P1)— IPSec- und Express-Path-qualifizierter Datenverkehr

Priority 2 (P2)— Reihenfolge der Fragmentierung

Priority 3 (P3)— NAT/SZ-Datenverkehr (Sitzungsserialisierung)

Priority 4(P3)— Alle anderen Arten von Datenverkehr

Die IOCs verwalten und überwachen die Schwellenwerte für die Sitzungscachenutzung und aktualisieren die aktuelle Sitzungscachenutzung in Echtzeit auf die SPU. Die SPU fordert das IOC auf, den Sitzungscache für bestimmte Datenverkehrssitzungen mit hoher Priorität zu installieren. Die Verwendung des Sitzungscaches für Datenverkehrssitzungen mit hoher Priorität ist in der folgenden Tabelle definiert:

Art des Datenverkehrs |

0 % < Auslastung < 25 % |

25 % < Auslastung < 50 % |

50 % < Auslastung < 75 % |

75 % < Auslastung < 100 % |

|---|---|---|---|---|

IPsec- und Express Path-Datenverkehr |

Ja |

Ja |

Ja |

Ja |

Fragmentierung Sortierung des Datenverkehrs |

Ja |

Ja |

Ja |

Nein |

NAT/SZ-Datenverkehr |

Ja |

Ja |

Nein |

Nein |

Sonstiger Datenverkehr |

Ja |

Nein |

Nein |

Nein |

Um Sitzungseinträge auf dem IOC zu erhalten, installiert das Flow-Modul selektiv Sitzungen auf dem IOC. Um die Auswahl der Sitzungsinstallation zu erleichtern, verwaltet der IOC entsprechende Schwellenwerte, um dem Flow-Modul einen Hinweis zu geben (wie voll die Sitzungscachetabelle auf den IOCs ist). Zwei Bits im Meta-Header werden hinzugefügt, um den aktuellen Auslastungsstatus der Cache-Tabelle anzugeben. Alle Pakete, die an die SPU gesendet werden, tragen diese beiden Statusbits, um das Flow-Modul über die Verwendung der Cache-Tabelle auf dem IOC zu informieren.

Verbesserung der IPsec-VPN-Sitzungsaffinität mithilfe des Sitzungscaches

Bei Firewalls der SRX-Serie handelt es sich um vollständig verteilte Systeme, bei denen ein IPsec-Tunnel einer bestimmten SPU zugewiesen und verankert ist. Der gesamte Datenverkehr, der zu einem IPsec-Tunnel gehört, wird auf seiner im Tunnel verankerten SPU verschlüsselt und entschlüsselt. Um eine bessere IPsec-Leistung zu erzielen, verbessert IOC das Datenstrommodul, um Sitzungen für IPsec-Tunnel-basierten Datenverkehr (vor der Verschlüsselung und nach der Entschlüsselung) auf seiner Tunnel-verankerten SPU zu erstellen, und installiert einen Sitzungscache für die Sitzungen, sodass der IOC die Pakete direkt an dieselbe SPU umleiten kann, um den Paketweiterleitungsaufwand zu minimieren. Express-Path-Datenverkehr und NP-Datenverkehr verwenden dieselbe Sitzungscachetabelle auf IOCs.

Sie müssen den Sitzungscache auf den IOCs aktivieren und die Sicherheitsrichtlinie festlegen, um zu bestimmen, ob sich eine Sitzung auf dem ausgewählten Flexible PIC Concentrator (FPC) für den Express-Path-Modus (früher als Services Offloading bezeichnet) befindet.

Um die Verwendung der IPsec-VPN-Affinität zu aktivieren, verwenden Sie den set security flow load-distribution session-affinity ipsec Befehl.

Um die IPsec-VPN-Affinität zu aktivieren, müssen Sie auch den Sitzungscache auf IOCs mithilfe des set chassis fpc <fpc-slot> np-cache Befehls aktivieren.

Reihenfolge von Fragmentierungspaketen mithilfe des NP-Sitzungscaches

Eine Sitzung kann sowohl aus normalen als auch aus fragmentierten Paketen bestehen. Bei der Hash-basierten Verteilung können 5-Tupel- und 3-Tupel-Schlüssel verwendet werden, um normale bzw. fragmentierte Pakete an verschiedene SPUs zu verteilen. Bei Firewalls der SRX-Serie werden alle Pakete der Sitzung an eine Verarbeitungs-SPU weitergeleitet. Aufgrund der Weiterleitungs- und Verarbeitungslatenz garantiert die Verarbeitungs-SPU möglicherweise nicht die Paketreihenfolge der Sitzung.

Der Sitzungscache auf den IOCs stellt die Reihenfolge der Pakete einer Sitzung mit fragmentierten Paketen sicher. Ein Sitzungscache-Eintrag wird für normale Pakete der Sitzung zugewiesen und ein 3-Tupel-Schlüssel wird verwendet, um die fragmentierten Pakete zu finden. Nach dem Empfang des ersten fragmentierten Pakets der Sitzung ermöglicht das Flow-Modul dem IOC, den Sitzungscache-Eintrag zu aktualisieren, um die fragmentierten Pakete für die SPU zu speichern. Später leitet IOC alle nachfolgenden Pakete der Sitzung an die SPU weiter, um die Reihenfolge der Pakete einer Sitzung mit fragmentierten Paketen sicherzustellen.

IOC-zu-NPC-Mapping konfigurieren

Bei der Zuordnung von Input/Output-Karte (IOC) zu Network Processing Card (NPC) müssen Sie einen IOC einem NPC zuordnen. Du kannst jedoch mehrere IOCs einem einzelnen NPC zuordnen. Um die Rechenleistung im NPC auf dem SRX3400 und SRX3600 Services Gateways auszugleichen, führt der Chassis-Prozess (Daemon) einen Algorithmus aus, der das Mapping durchführt. Es ordnet ein IOC einem NPC zu, dem die geringste Anzahl von IOCs zugeordnet ist. Du kannst auch die Befehlszeilenschnittstelle (CLI) verwenden, um einem bestimmten NPC einen bestimmten IOC zuzuweisen. Wenn Sie das Mapping konfigurieren, verwendet der Chassis-Prozess zuerst Ihre Konfiguration und wendet dann den NPC-Algorithmus mit der geringsten Anzahl für die restlichen IOCs an.

Die Plattformunterstützung hängt von der Junos OS-Version in Ihrer Installation ab.

So konfigurieren Sie die IOC-zu-NPC-Zuordnung:

[edit]

set chassis ioc-npc-connectivity {

ioc slot-number npc (none | slot-number);

}

Eine Beschreibung der set chassis ioc-npc-connectivity Optionen finden Sie in Tabelle 2.

Option |

Beschreibung |

|---|---|

Ioc slot-number |

Geben Sie die IOC-Steckplatznummer an. Der Bereich liegt zwischen 0 und 7 für SRX3400 Geräte und 0 bis 12 für SRX3600 Geräte. |

Npc slot-number |

Gib die NPC-Slot-Nummer an. Der Bereich liegt zwischen 0 und 7 für SRX3400-Geräte und 0 bis 12 für SRX3600- und SRX 4600-Geräte. |

nichts |

Der Chassis-Prozess bildet die Verbindung für den jeweiligen IOC ab. |

Sie müssen die Chassis-Steuerung neu starten, nachdem Sie den set chassis ioc-npc-connectivity Befehl festgeschrieben haben.

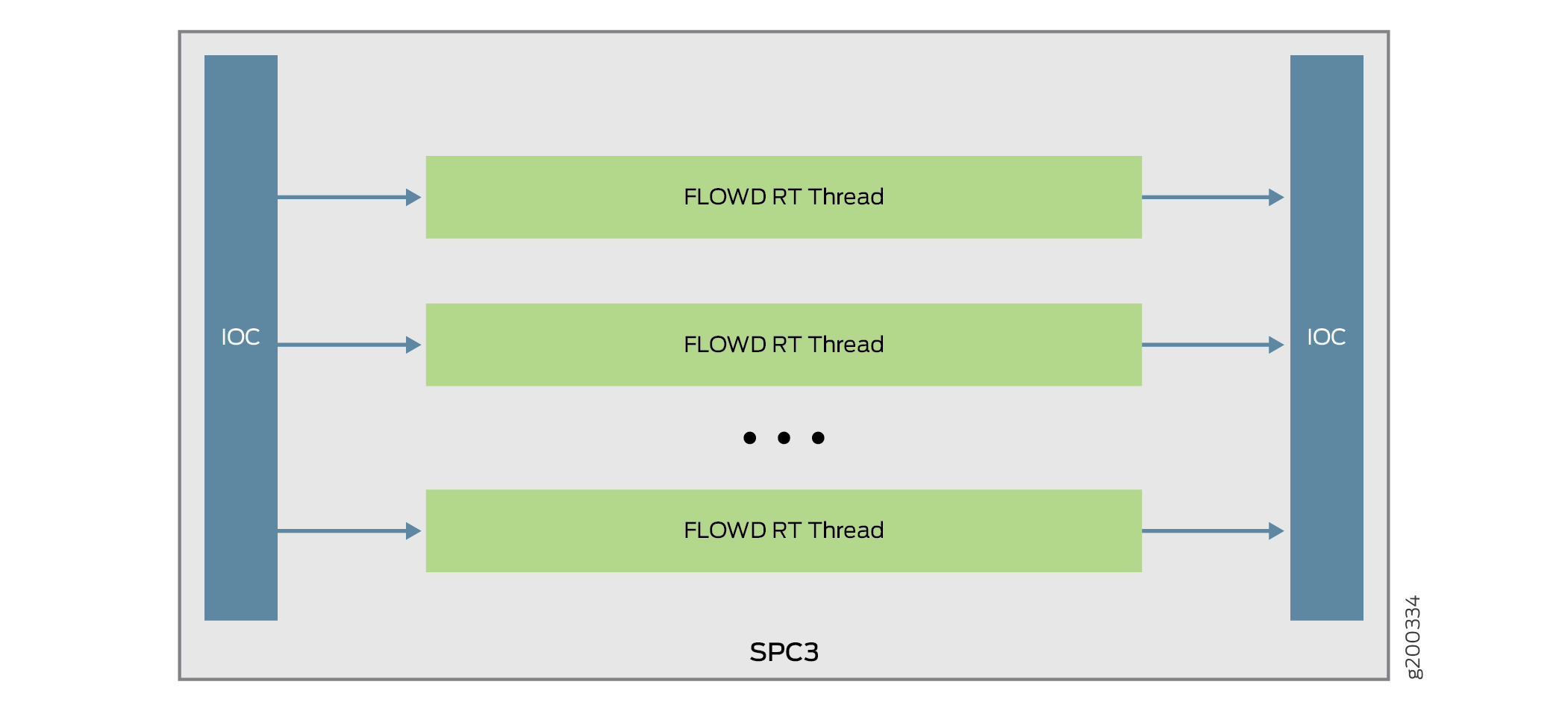

Grundlegendes zur Datenstromverarbeitung auf SRX5K-SPC3-Geräten

Die Service Processing Card SRX5K-SPC3 wird eingeführt, um die Leistung von Sicherheitsdiensten auf dem SRX5000 Security Services Gateway zu verbessern. Die SPC3-Karte unterstützt einen höheren Durchsatz und behält ihre Zuverlässigkeit bei, da sie die Funktionalität des Chassis-Clusters und die Skalierbarkeit für die Serviceverarbeitung beibehält.

Die SPC3-Karte unterstützt die folgenden Sicherheitsfunktionen:

Application Layer Gateway (ALG). [Siehe ALG-Übersicht]

Erweiterter Malware-Schutz (Juniper ATP Cloud). [Weitere Informationen finden Sie unter Juniper Sky Advanced Threat Prevention Administration]

Anwendungssicherheits-Suite. [ Sicherheitsgeräte finden Sie im Benutzerhandbuch zur Anwendungssicherheit]

Flow-basierte Paketverarbeitungsimplementierung

GPRS-Tunneling-Protokoll (GTP) und Stream Control Transmission Protocol (SCTP). [Weitere Informationen zu Sicherheitsgeräten finden Sie im allgemeinen Benutzerhandbuch für den Packet Radio Service]

Hochverfügbarkeit (Chassis-Cluster). [Siehe Chassis-Cluster-Benutzerhandbuch für Geräte der SRX-Serie]

Intrusion Detection and Prevention (IDP). [Siehe Übersicht über Intrusion Detection and Prevention]

Network Address Translation (NAT). [Weitere Informationen zu Sicherheitsgeräten finden Sie im Network Address Translation-Benutzerhandbuch]

Zustandsbehaftete Firewall

SSL-Proxy. [Siehe SSL-Proxy]

Firewall-Benutzerauthentifizierung. [Sicherheitsgeräte finden Sie im Benutzerhandbuch für Authentifizierung und integrierte Benutzer-Firewalls]

Inhaltssicherheit (Virenschutz, Webfilterung, Inhaltsfilterung und Spamschutz). [Siehe UTM-Benutzerhandbuch für Sicherheitsgeräte]

Der Sicherheitsablauf wurde erweitert, um SPC3-Karten mit allen vorhandenen Sicherheitsfunktionen zu unterstützen, die auf der SPC2-Karte unterstützt werden.

Die folgenden Einschränkungen gelten für die SPC3-Karte in Junos OS Version 18.2R1-S1:

Die Interoperabilität von SPC3-Karte und SPC2-Karte wird nicht unterstützt.

Die IPsec-VPN-Funktionalität wird mit einer SPC3-Karte nicht unterstützt.

Ab Junos OS Version 18.2R1-S1 wird eine neue Service Processing Card (SPC3) für die Geräte der SRX5000-Reihe eingeführt. Die Einführung der neuen Karte verbessert die Skalierbarkeit und Leistung des Geräts und behält seine Zuverlässigkeit bei, da die Chassis-Cluster-Funktionalität erhalten bleibt. Die SPC3-Karte unterstützt einen höheren Durchsatz und Skalierbarkeit für die Serviceverarbeitung.

Bei Geräten der SRX5000-Reihe arbeitet die SPC3-Karte mit E/A-Karten (IOC2, IOC3), Switch Control Board (SCB2, SCB3), Routing-Engines und SPC2-Karten zusammen.

Ab Junos OS Version 18.4R1 wird auf Geräten der SRX5000 Reihe eine Mischung aus SPC3- und SPC2-Karten unterstützt.

Wenn Sie die SPC3-Karten in SRX5000 Reihe von Geräten hinzufügen, muss die neue SPC3-Karte im Steckplatz mit der niedrigsten Nummer eines SPCs installiert werden. Die SPC3-Karte wird im ursprünglichen Steckplatz mit der niedrigsten Nummer installiert und bietet die CP-Funktionalität (Central Point) im gemischten Modus. Wenn Ihr Services Gateway beispielsweise eine Mischung aus SPC2- und SPC3-Karten enthält, muss ein SPC3 den Steckplatz mit der niedrigsten Nummer eines SPC im Gehäuse belegen. Diese Konfiguration stellt sicher, dass die CP-Funktionalität (Central Point) im Mixed-Mode von der SPC3-Karte ausgeführt wird.

Bei SRX5000-Geräten, die im Mixed-Mode arbeiten, wird die Datenflussverarbeitung zwischen SPC3- und SPC2-Karten gemeinsam genutzt. Die Verarbeitung des Central Point erfolgt auf dem SPC-Steckplatz mit der niedrigsten Nummer, für den eine SPC3-Karte installiert ist.