Cómo configurar OTT DCI en una red EVPN

Requisitos

En este ejemplo de configuración se utilizan los siguientes dispositivos y versiones de software:

Dispositivos spine que constan de conmutadores QFX5120-32C que ejecutan Junos OS versión 19.1R3-S2 en ambos centros de distribución.

Dispositivos leaf que constan de conmutadores QFX5110-48S que ejecutan Junos OS versión 18.4R2-S5 en DC1.

Dispositivos leaf que constan de conmutadores QFX5120-48Y que ejecutan Junos OS versión 18.4R2-S5 en DC2.

Visión general

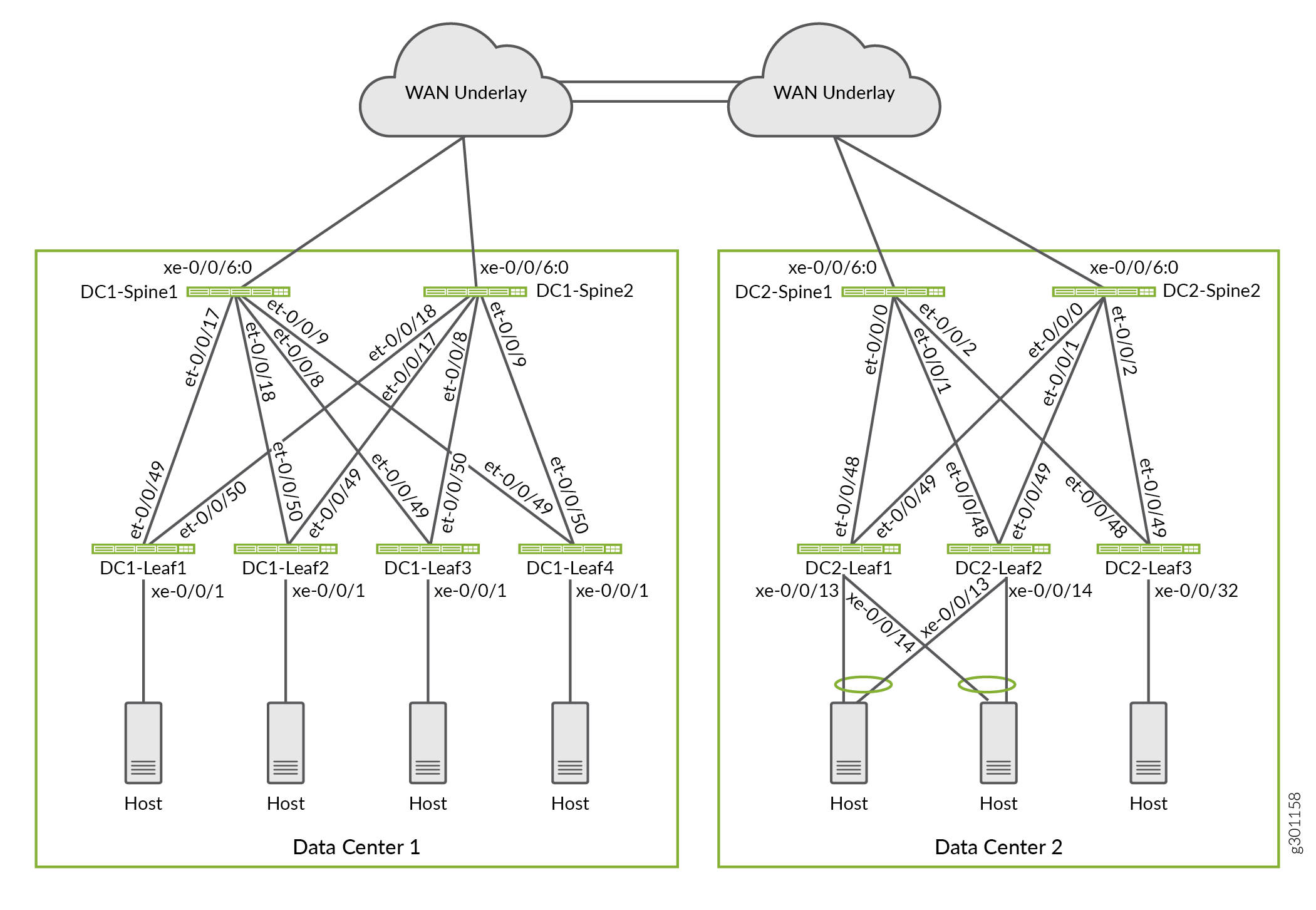

En esta implementación, usamos una arquitectura con dos redes de estructura de centro de datos que se han configurado en un modelo de superposición de puente enrutado en el borde (ERB). Los centros de datos están interconectados con una red subyacente IP de capa 3. La figura 1 muestra la conectividad WAN que proporciona el transporte subyacente entre los dos centros de datos. Utilizamos una arquitectura DCI de EVPN-VXLAN de alto nivel para proporcionar conectividad de capa 2 y capa 3 para puntos de conexión y máquinas virtuales en los dos centros de datos.

OTT DCI

OTT DCI

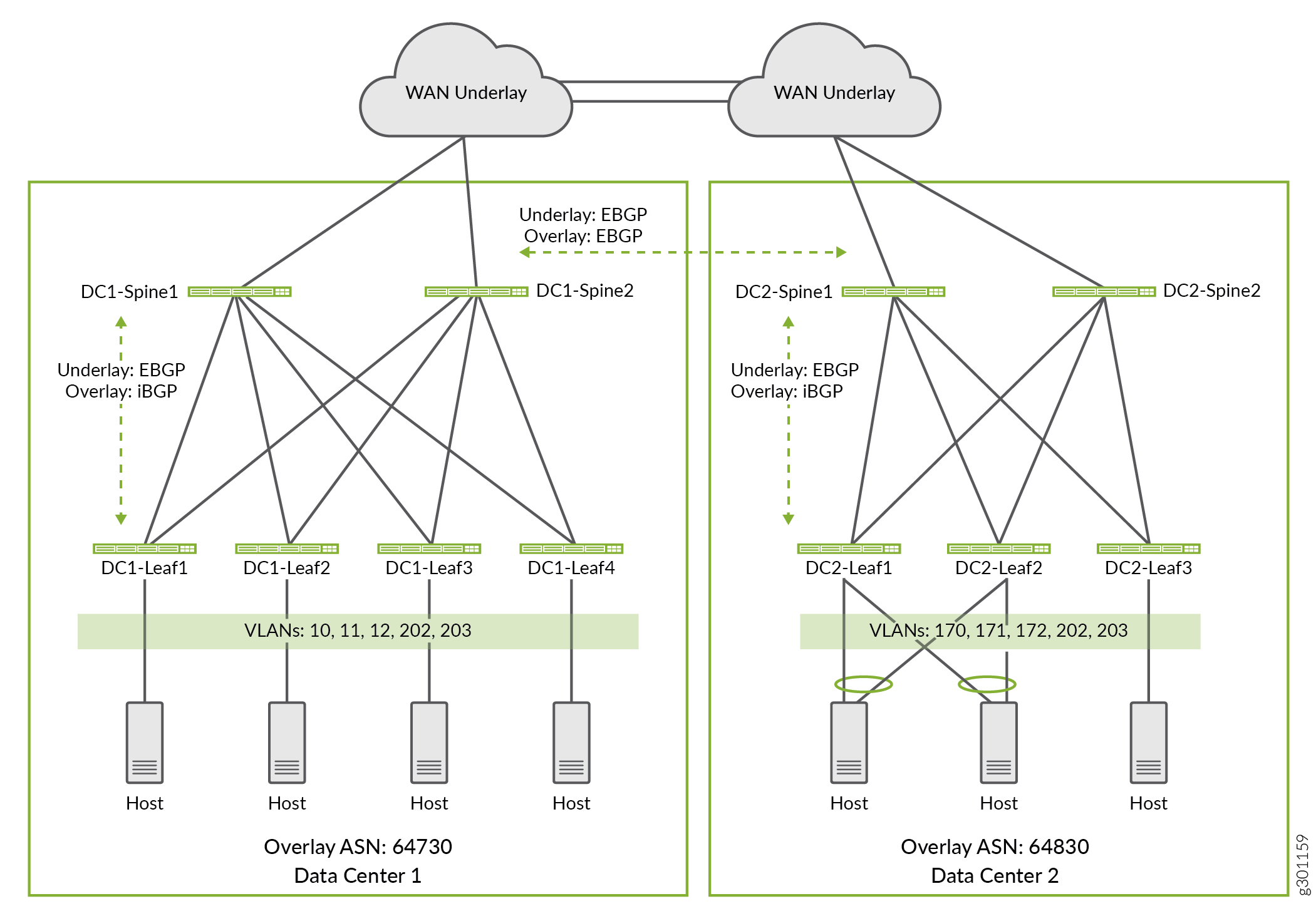

En este ejemplo, algunas VLAN están configuradas para existir solo dentro de un centro de datos específico, mientras que otras VLAN abarcan los dos centros de datos. La figura 2 muestra las VLAN configuradas en los dos centros de datos. Configuramos las VLAN de la siguiente manera:

Las VLAN 10, 11 y 12 son locales del centro de datos 1. Los puntos de conexión de estas VLAN utilizan el enrutamiento de capa 3 para llegar a otras VLAN en Data Center 2.

Las VLAN 170, 171 y 172 son locales del centro de datos 2. Los puntos de conexión de estas VLAN utilizan el enrutamiento de capa 3 para llegar a otras VLAN en Data Center 1.

Las VLAN 202 y 203 son comunes al centro de datos 1 y al centro de datos 2. Estas VLAN se extienden a través de todos los dispositivos leaf en ambos centros de datos. Los puntos de conexión en estas VLAN utilizan puentes de capa 2 para llegar a los puntos de conexión en el otro centro de datos.

de datos

de datos

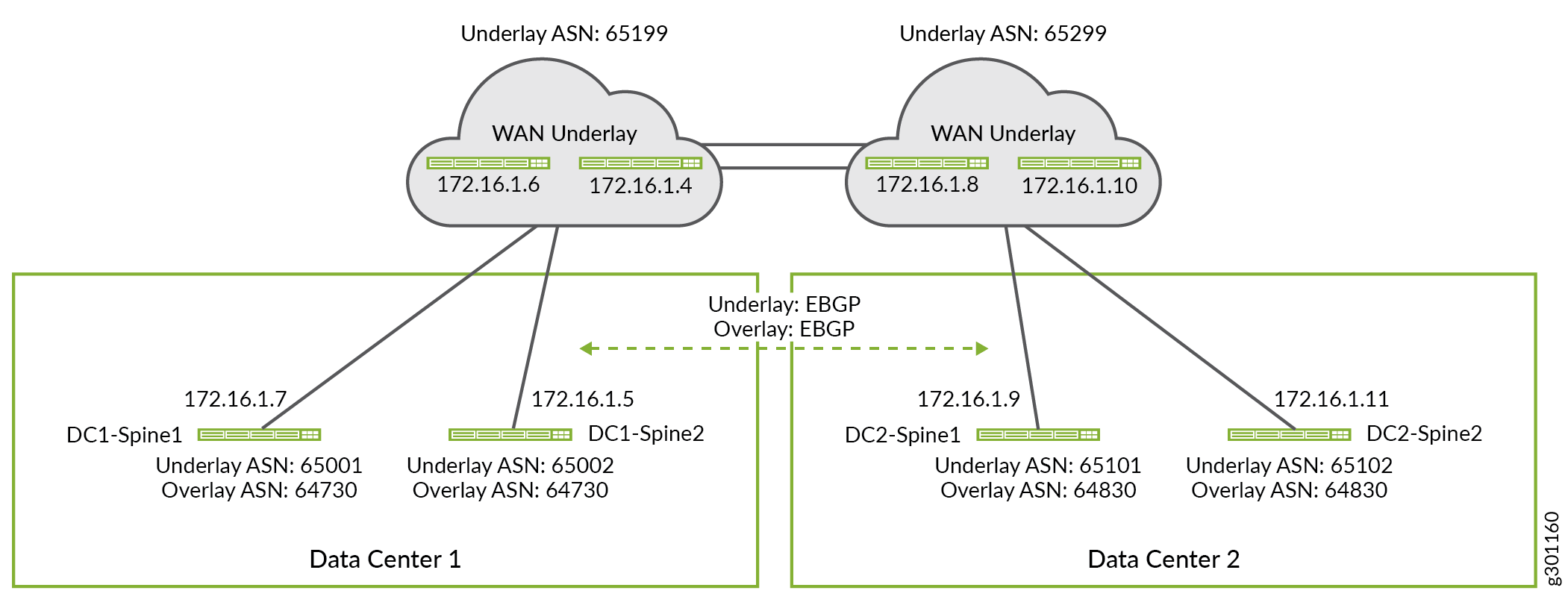

Puede utilizar cualquier protocolo de enrutamiento en la red subyacente. El protocolo de enrutamiento subyacente permite a los dispositivos intercambiar direcciones IP de circuito cerrado entre sí. En este ejemplo, eBGP se utiliza como protocolo de enrutamiento subyacente dentro de cada estructura de centro de datos. El protocolo eBGP también se utiliza para extender la red subyacente a través de la conexión WAN entre los dos centros de datos. Puede utilizar iBGP o eBGP como protocolo de enrutamiento de superposición entre los centros de dominio. La elección depende de si utiliza los mismos números de sistema autónomo o diferentes para sus centros de datos. En este ejemplo, usaremos iBGP para el protocolo de superposición dentro de una estructura y eBGP entre los dos centros de datos. La figura 3 muestra los números del sistema autónomo y las direcciones IP utilizadas en este ejemplo.

enrutador WAN

enrutador WAN

Configurar los dispositivos de columna vertebral de borde para la conectividad WAN

Requisitos

Configuración subyacente de WAN de spine de borde

Las configuraciones que se muestran en esta página se establecen en una estructura EVPN preexistente con una red operativa subyacente y superpuesta. En otras palabras, esta sección muestra solo las configuraciones adicionales necesarias para extender la base de DC a una nube WAN. Por el contrario, las configuraciones detalladas muestran la configuración completa de cada dispositivo DC.

En esta sección se muestra cómo configurar la configuración subyacente de WAN para dispositivos de columna vertebral de borde. Para abreviar, solo mostraremos los pasos para configurar un dispositivo spine en cada centro de datos. Puede configurar los demás dispositivos de columna de borde aplicando pasos de configuración similares.

Repita estos procedimientos para todos los dispositivos de columna vertebral de borde en cada centro de datos.

Consulte las configuraciones detalladas de la red EVPN-VXLAN para los centros de datos para ver las configuraciones completas utilizadas en este ejemplo.

Base WAN de spine de borde

Procedimiento

Procedimiento paso a paso

Agregue la sesión de emparejamiento WAN al grupo subyacente existente en Data Center 1 Spine 1 (DC1-Spine1). Los dispositivos de columna vertebral de borde utilizan la red subyacente WAN para intercambiar información de dirección de circuito cerrado entre los centros de datos. Esto, a su vez, permite que los dispositivos spine formen una conexión de superposición eBGP a través de la nube WAN.

set protocols bgp group UNDERLAY neighbor 172.16.1.6 peer-as 65199

En este ejemplo, el emparejamiento del enrutador WAN se agrega al grupo del par BGP preexistente

UNDERLAY. Dado que este grupo ya está configurado como parte de la capa subyacente del controlador de dominio, solo necesita agregar el enrutador WAN como vecino al grupo existenteUNDERLAY.Agregue el emparejamiento WAN al grupo existente

UNDERLAYen Data Center 2 Spine 1 (DC2-Spine1).set protocols bgp group UNDERLAY neighbor 172.16.1.8 peer-as 65299

Configure la política subyacente de WAN común que se usa en los dispositivos spine y leaf en ambos centros de datos. Reservamos la subred 10.80.224.128/25 para la dirección de circuito cerrado en el centro de datos 1 y la subred 10.0.0.0/24 para la dirección de circuito cerrado en el centro de datos 2. Al especificar un rango reservado de direcciones de circuito cerrado en nuestra política, no tenemos que actualizar la política cuando se agrega un dispositivo, siempre y cuando el dispositivo esté configurado con una dirección de circuito cerrado reservada.

set policy-options policy-statement UNDERLAY-EXPORT term LOOPBACK from route-filter 10.80.224.128/25 orlonger set policy-options policy-statement UNDERLAY-EXPORT term LOOPBACK from route-filter 10.0.0.0/24 orlonger set policy-options policy-statement UNDERLAY-EXPORT term LOOPBACK then accept set policy-options policy-statement UNDERLAY-EXPORT term DEFAULT then reject set policy-options policy-statement UNDERLAY-IMPORT term LOOPBACK from route-filter 10.80.224.128/25 orlonger set policy-options policy-statement UNDERLAY-IMPORT term LOOPBACK from route-filter 10.0.0.0/24 orlonger set policy-options policy-statement UNDERLAY-IMPORT term LOOPBACK then accept set policy-options policy-statement UNDERLAY-IMPORT term DEFAULT then reject

En este ejemplo, la capa subyacente solo intercambia rutas de circuito cerrado tanto dentro de los DC como entre ellos. Las políticas de importación y exportación para la capa subyacente están escritas de tal manera que pueden ser utilizadas por todos los dispositivos en ambos DC. Por ejemplo, la

UNDERLAY-EXPORTdirectiva está configurada para que coincida con las direcciones de circuito cerrado del controlador de dominio local y remoto. Cuando se aplica a un dispositivo en DC1, solo coincide el10.80.224.128/25 orlongertérmino. Tener el término adicionalroute-filterpara las direcciones de circuito cerrado asignadas a DC2 no causa ningún daño, y permite que se aplique la misma política a la capa subyacente en ambos DC.

Superposición WAN de spine de borde

Procedimiento paso a paso

Para la superposición de estructura, se configura una malla completa de emparejamiento eBGP entre todos los dispositivos de columna vertebral de borde en ambos centros de datos mediante eBGP. Los dispositivos de columna vertebral funcionan como reflectores de ruta de superposición dentro de su respectivo CC. La sesión de emparejamiento de superposición extiende la superposición de EVPN entre los controladores de dominio.

Debido a que la sesión de superposición entre DC se ejecuta sobre una nube, la detección de errores bidireccionales (BFD) de WAN no está habilitada para este grupo del mismo nivel. BFD está habilitado para ejecutarse dentro de cada DC, tanto en la capa subyacente como en la superposición.

De forma predeterminada, eBGP cambia la dirección IP en el campo Protocolo del próximo salto para utilizar su propia dirección IP al volver a anunciar rutas. En este caso, queremos que el campo de protocolo del próximo salto use la dirección IP VTEP del dispositivo leaf que originó la ruta. Para evitar que BGP cambie los siguientes saltos de rutas superpuestas, habilitamos la no-nexthop-change opción en el OVERLAY_INTERDC grupo par.

Configure la red de superposición WAN en DC1-Spine1.

set protocols bgp group OVERLAY_INTERDC type external set protocols bgp group OVERLAY_INTERDC description "Group for overlay EBGP peering to remote DC" set protocols bgp group OVERLAY_INTERDC multihop no-nexthop-change set protocols bgp group OVERLAY_INTERDC local-address 10.80.224.149 set protocols bgp group OVERLAY_INTERDC family evpn signaling delay-route-advertisements minimum-delay routing-uptime 480 set protocols bgp group OVERLAY_INTERDC local-as 64730 set protocols bgp group OVERLAY_INTERDC multipath multiple-as set protocols bgp group OVERLAY_INTERDC neighbor 10.0.0.2 peer-as 64830 set protocols bgp group OVERLAY_INTERDC neighbor 10.0.0.3 peer-as 64830

Configure la red de superposición WAN en DC2-Spine1.

set protocols bgp group EVPN_FABRIC type internal set protocols bgp group OVERLAY_INTERDC type external set protocols bgp group OVERLAY_INTERDC description "Group for overlay EBGP peering to remote DC" set protocols bgp group OVERLAY_INTERDC multihop no-nexthop-change set protocols bgp group OVERLAY_INTERDC local-address 10.0.0.2 set protocols bgp group OVERLAY_INTERDC family evpn signaling delay-route-advertisements minimum-delay routing-uptime 480 set protocols bgp group OVERLAY_INTERDC local-as 64830 set protocols bgp group OVERLAY_INTERDC multipath multiple-as set protocols bgp group OVERLAY_INTERDC neighbor 10.80.224.149 peer-as 64730 set protocols bgp group OVERLAY_INTERDC neighbor 10.80.224.150 peer-as 64730

Configurar los dispositivos Leaf para que admitan DCI de capa 2

Para extender la conectividad de capa 2 (VLAN) a través de los dos DC, debemos configurar la red para extender el dominio de difusión de capa 2 para todos los puntos de conexión en la VLAN compartida. En este ejemplo, los puntos de conexión de las VLAN 202 y 203 pertenecen al mismo dominio de capa 2, independientemente de si los puntos de conexión se encuentran en los centros de datos locales o remotos. El objetivo es extender o ampliar estas VLAN entre los dos centros de dominio.

Para ampliar la conectividad de capa 2 para estas VLAN compartidas entre los centros de dominio, debe configurar lo siguiente:

-

Configure destinos de ruta basados en el identificador de red VXLAN (VNI) único para las rutas EVPN tipo 2 y EVPN tipo 3 asociadas a las VLAN extendidas en la

protocols evpnjerarquía. -

Aplique una política de importación para aceptar los destinos de ruta únicos que están enlazados a las VLAN extendidas mediante el

vrf-importcomando en laswitch-optionsjerarquía. Las VLAN ampliadas son rutas EVPN tipo 2 y tipo 3 que anuncia el centro de datos remoto.

Repita estos procedimientos para todos los dispositivos leaf en el centro de datos correspondiente. Los comandos que se muestran a continuación se agregan a las jerarquías y protocols evpn existentes switch-options para ampliar las VLAN compartidas entre los dos centros de dominio.

Procedimiento

Procedimiento paso a paso

Configure destinos específicos de VNI para las VLAN extendidas en Data Center 1 Leaf 1 (DC1-Leaf1).

set protocols evpn vni-options vni 1202 vrf-target target:64730:202 set protocols evpn vni-options vni 1203 vrf-target target:64730:203

Configure una política de importación de VRF para que coincida con los destinos de VNI para las VLAN expandidas en el centro de datos 1 hoja 1 (DC1-Leaf1). La política también coincide con las rutas predeterminadas de EVPN tipo 1 utilizadas para la detección automática (AD). La propia política se define en un paso posterior.

set switch-options vrf-import OVERLAY_IMPORT

Configure destinos específicos de VNI para las VLAN ampliadas en el centro de datos de 2 hojas 1 (DC2-Leaf1).

set protocols evpn vni-options vni 1202 vrf-target target:64830:202 set protocols evpn vni-options vni 1203 vrf-target target:64830:203 03

Especifique una política de importación de VRF para que coincida con los destinos de VNI para las VLAN expandidas en Data Center 2 Leaf 1 (DC2-Leaf1).

set switch-options vrf-import OVERLAY_IMPORT

Defina la directiva de importación de VRF que configuró en la

switch-options vrf-importjerarquía del paso anterior. En este ejemplo, usamos destinos de ruta únicos para cada centro de datos y para cada dominio de capa 2 que se extiende entre los centros de dominio. La directiva se establece para importar la ruta de AD de tipo 1 de EVPN asociada a cada DC/POD, así como las rutas de EVPN tipo 2 y EVPN tipo 3 que usan las VLAN expandidas en ambos centros de datos.Esta política debe configurarse en todos los dispositivos leaf de ambos centros de dominio.

Nota:En su implementación, puede usar un destino de ruta común para los dispositivos leaf en sus centros de datos. Cuando se utiliza un destino de ruta común, las rutas de los centros de datos se importarán automáticamente como parte de la política de importación implícita.

set policy-options policy-statement OVERLAY_IMPORT term 5 from community comm_pod1 set policy-options policy-statement OVERLAY_IMPORT term 5 then accept set policy-options policy-statement OVERLAY_IMPORT term 10 from community comm_pod2 set policy-options policy-statement OVERLAY_IMPORT term 10 then accept set policy-options policy-statement OVERLAY_IMPORT term 20 from community shared_202_fm_pod2 set policy-options policy-statement OVERLAY_IMPORT term 20 from community shared_202_fm_pod1 set policy-options policy-statement OVERLAY_IMPORT term 20 from community shared_203_fm_pod2 set policy-options policy-statement OVERLAY_IMPORT term 20 from community shared_203_fm_pod1 set policy-options policy-statement OVERLAY_IMPORT term 20 then accept set policy-options community comm_pod1 members target:64730:999 set policy-options community comm_pod2 members target:64830:999 set policy-options community shared_202_fm_pod1 members target:64730:202 set policy-options community shared_202_fm_pod2 members target:64830:202 set policy-options community shared_203_fm_pod1 members target:64730:203 set policy-options community shared_203_fm_pod2 members target:64830:203

Los valores utilizados para las

comm_pod1comunidades ycomm_po2coinciden con los valores especificados con laswitch-optionsvrf-target statementjerarquía inferior de los dispositivos leaf en DC1 y DC2, respectivamente. Este es el destino de ruta que se agrega a todas las rutas de EVPN tipo 1, que se usan para la detección automática. Este destino también se adjunta a todas las demás rutas EVPN que no tienen un destino específico de VNI especificado en laprotocols evpnjerarquía.En este ejemplo, las VLAN extendidas se configuran para usar destinos específicos de VNI. Por lo tanto, la política de importación se escribe para que coincida con los tres destinos utilizados por cada DC. Una vez más, este enfoque permite utilizar una política común en todos los dispositivos leaf de ambos centros de distribución.

Requisitos

Configurar los dispositivos Leaf para que admitan DCI de capa 3

Las rutas de EVPN tipo 5 se usan para la conectividad de capa 3 entre DC para VLAN que no se estiran. Una ruta EVPN tipo 5 también se denomina ruta de prefijo IP. En otras palabras, se utiliza una ruta de tipo 5 cuando el dominio de difusión de capa 2 está confinado dentro del centro de datos. Las rutas EVPN tipo 5 permiten la conectividad de capa 3 al anunciar el prefijo IP de la interfaz IRB asociada con VLAN no extendidas. En este ejemplo, las VLAN (10, 11, 12) se limitan al centro de datos 1, mientras que las VLAN (170, 171, 172) están confinadas al centro de datos 2. Establecemos la conectividad entre centros de datos de capa 3 entre los miembros de estas VLAN mediante el uso de rutas de prefijo IP.

Procedimiento

Procedimiento paso a paso

Configure el DCI de capa 3 en DC1-Leaf1 definiendo un VRF de capa 3 compatible con rutas de tipo 5 de EVPN.

set routing-instances TENANT_1_VRF description "VRF for Tenant_1" set routing-instances TENANT_1_VRF instance-type vrf set routing-instances TENANT_1_VRF interface irb.10 set routing-instances TENANT_1_VRF interface irb.11 set routing-instances TENANT_1_VRF interface irb.12 set routing-instances TENANT_1_VRF interface irb.202 set routing-instances TENANT_1_VRF interface irb.203 set routing-instances TENANT_1_VRF interface lo0.1 set routing-instances TENANT_1_VRF route-distinguisher 10.80.225.140:9999 set routing-instances TENANT_1_VRF vrf-import VRF1_VRF1_T5_RT_IMPORT set routing-instances TENANT_1_VRF vrf-export VRF1_VRF1_T5_RT_EXPORT set routing-instances TENANT_1_VRF vrf-target target:1:65001 set routing-instances TENANT_1_VRF vrf-table-label set routing-instances TENANT_1_VRF routing-options multipath set routing-instances TENANT_1_VRF protocols evpn ip-prefix-routes advertise direct-nexthop set routing-instances TENANT_1_VRF protocols evpn ip-prefix-routes encapsulation vxlan set routing-instances TENANT_1_VRF protocols evpn ip-prefix-routes vni 9999 set routing-instances TENANT_1_VRF protocols evpn ip-prefix-routes export T5_EXPORT

Configure el DCI de capa 3 en DC2-Leaf1 definiendo un VRF de capa 3 compatible con rutas de tipo 5 de EVPN.

set routing-instances TENANT_1_VRF description "VRF for Tenant_1" set routing-instances TENANT_1_VRF instance-type vrf set routing-instances TENANT_1_VRF interface irb.170 set routing-instances TENANT_1_VRF interface irb.171 set routing-instances TENANT_1_VRF interface irb.172 set routing-instances TENANT_1_VRF interface irb.202 set routing-instances TENANT_1_VRF interface irb.203 set routing-instances TENANT_1_VRF interface lo0.1 set routing-instances TENANT_1_VRF route-distinguisher 10.0.1.19:9999 set routing-instances TENANT_1_VRF vrf-import VRF1_T5_RT_IMPORT set routing-instances TENANT_1_VRF vrf-export VRF1_T5_RT_EXPORT set routing-instances TENANT_1_VRF vrf-target target:1:65001 set routing-instances TENANT_1_VRF vrf-table-label set routing-instances TENANT_1_VRF routing-options multipath set routing-instances TENANT_1_VRF protocols evpn ip-prefix-routes advertise direct-nexthop set routing-instances TENANT_1_VRF protocols evpn ip-prefix-routes encapsulation vxlan set routing-instances TENANT_1_VRF protocols evpn ip-prefix-routes vni 9999 set routing-instances TENANT_1_VRF protocols evpn ip-prefix-routes export T5_EXPORT

Configurar la política DCI de capa 3 para todos los dispositivos leaf en DC1

set policy-options policy-statement T5_EXPORT term fm_direct from protocol direct set policy-options policy-statement T5_EXPORT term fm_direct then accept set policy-options policy-statement T5_EXPORT term fm_static from protocol static set policy-options policy-statement T5_EXPORT term fm_static then accept set policy-options policy-statement T5_EXPORT term fm_v4_host from protocol evpn set policy-options policy-statement T5_EXPORT term fm_v4_host from route-filter 0.0.0.0/0 prefix-length-range /32-/32 set policy-options policy-statement T5_EXPORT term fm_v4_host then accept set policy-options policy-statement T5_EXPORT term fm_v6_host from protocol evpn set policy-options policy-statement T5_EXPORT term fm_v6_host from route-filter 0::0/0 prefix-length-range /128-/128 set policy-options policy-statement T5_EXPORT term fm_v6_host then accept set policy-options policy-statement VRF1_T5_RT_EXPORT term t1 then community add target_t5_pod1 set policy-options policy-statement VRF1_T5_RT_EXPORT term t1 then accept set policy-options policy-statement VRF1_T5_RT_IMPORT term t1 from community target_t5_pod1 set policy-options policy-statement VRF1_T5_RT_IMPORT term t1 then accept set policy-options policy-statement VRF1_T5_RT_IMPORT term t2 from community target_t5_pod2 set policy-options policy-statement VRF1_T5_RT_IMPORT term t2 then accept set policy-options community target_t5_pod1 members target:64730:9999 set policy-options community target_t5_pod2 members target:64830:9999

Configurar la política DCI de capa 3 para todos los dispositivos leaf en DC2

set policy-options policy-statement T5_EXPORT term fm_direct from protocol direct set policy-options policy-statement T5_EXPORT term fm_direct then accept set policy-options policy-statement T5_EXPORT term fm_static from protocol static set policy-options policy-statement T5_EXPORT term fm_static then accept set policy-options policy-statement T5_EXPORT term fm_v4_host from protocol evpn set policy-options policy-statement T5_EXPORT term fm_v4_host from route-filter 0.0.0.0/0 prefix-length-range /32-/32 set policy-options policy-statement T5_EXPORT term fm_v4_host then accept set policy-options policy-statement T5_EXPORT term fm_v6_host from protocol evpn set policy-options policy-statement T5_EXPORT term fm_v6_host from route-filter 0::0/0 prefix-length-range /128-/128 set policy-options policy-statement T5_EXPORT term fm_v6_host then accept set policy-options policy-statement VRF1_T5_RT_EXPORT term t1 then community add target_t5_pod2 set policy-options policy-statement VRF1_T5_RT_EXPORT term t1 then accept set policy-options policy-statement VRF1_T5_RT_IMPORT term t1 from community target_t5_pod1 set policy-options policy-statement VRF1_T5_RT_IMPORT term t1 then accept set policy-options policy-statement VRF1_T5_RT_IMPORT term t2 from community target_t5_pod2 set policy-options policy-statement VRF1_T5_RT_IMPORT term t2 then accept set policy-options community target_t5_pod1 members target:64730:9999 set policy-options community target_t5_pod2 members target:64830:9999

Configuración de directiva alternativa para importar destinos de ruta

Requisitos

En este ejemplo, los destinos de ruta derivados automáticamente incluyen el número de AS de superposición como parte de su identificador. Como resultado, obtiene diferentes destinos de ruta para el mismo VNI en el centro de datos 1 y el centro de datos 2.

Para una configuración de directiva más sencilla, puede derivar automáticamente destinos de ruta incluyendo la vrf-target instrucción con la auto opción en la switch-options jerarquía. Cuando se habilita vrf-target auto, Junos crea automáticamente los destinos de ruta usados para las rutas de EVPN de tipo 2 y tipo 3. Para EVPN-VXLAN, el destino de ruta se deriva automáticamente del identificador de red VXLAN (VNI). En este ejemplo, los objetivos de ruta de EVPN tipo 2 y tipo 3 derivados automáticamente para VNI 1202 son target:64730:268436658 en el centro de datos 1 y target:64830:268436658 en el centro de datos 2. Estos destinos de ruta se adjuntan a rutas EVPN tipo 2 y tipo 3 asociadas. La vrf-target auto instrucción crea una política de importación implícita para hacer coincidir e importar los mismos valores de destino de ruta para estas VNI.

Con una política más simple, las rutas EVPN tipo 2 y 3 para VLAN 202 y 203 no se importan automáticamente. Para importar rutas de EVPN de tipo 2 y 3 desde un centro de datos con un número de sistema autónomo diferente, incluya la vrf-target auto import-as instrucción.

Este es el ejemplo de configuración para Leaf 1 en Data Center 1.

set switch-options vrf-import OVERLAY_IMPORT set switch-options vrf-target target:64730:999 set switch-options vrf-target auto import-as 64830 vni-list 1202 set switch-options vrf-target auto import-as 64830 vni-list 1203 set protocols evpn extended-vni-list 110 set protocols evpn extended-vni-list 111 set protocols evpn extended-vni-list 112 set protocols evpn extended-vni-list 1202 set protocols evpn extended-vni-list 1203 set policy-options policy-statement OVERLAY_IMPORT term 5 from community comm_pod1 set policy-options policy-statement OVERLAY_IMPORT term 5 then accept set policy-options policy-statement OVERLAY_IMPORT term 10 from community comm_pod2 set policy-options policy-statement OVERLAY_IMPORT term 10 then accept set policy-options community comm_pod1 members target:64730:999 set policy-options community comm_pod2 members target:64830:999

Verificación

Procedimiento

Requisitos

Visión general

Verificar el emparejamiento BGP

- #verify-BGP-peering__d2091e390

- Verificar VTEP en un dispositivo Leaf

- Verificar rutas de EVPN tipo 1

- Verificar rutas de EVPN tipo 2

- Verificar el DCI de capa 3

Propósito

Verifique las sesiones de emparejamiento de BGP subyacentes, superpuestas e inter-DC.

Acción

Compruebe que se hayan establecido todas las sesiones de emparejamiento de BGP subyacentes y superpuestas. Esto incluye el emparejamiento de superposición eBGP entre los controladores de dominio formados a través de la nube WAN.

Lo siguiente está tomado del dispositivo DC2-Spine1 en DC2. Todas las sesiones de emparejamiento BGP deben establecerse en todos los dispositivos leaf and spines de ambos centros de distribución.

user@dc2spine1> show bgp summary

Threading mode: BGP I/O

Groups: 3 Peers: 9 Down peers: 0

Table Tot Paths Act Paths Suppressed History Damp State Pending

inet.0

10 5 0 0 0 0

bgp.evpn.0

99 99 0 0 0 0

Peer AS InPkt OutPkt OutQ Flaps Last Up/Dwn State|#Active/Received/Accepted/Damped...

10.0.0.14 64830 11634 11582 0 1 8:49:40 Establ

bgp.evpn.0: 36/36/36/0

10.0.0.18 64830 11646 11604 0 2 8:49:40 Establ

bgp.evpn.0: 36/36/36/0

10.0.0.19 64830 11652 11603 0 3 8:49:38 Establ

bgp.evpn.0: 36/36/36/0

10.80.224.149 64730 11621 11622 0 6 8:49:31 Establ

bgp.evpn.0: 27/27/27/0

10.80.224.150 64730 11630 11600 0 6 8:49:31 Establ

bgp.evpn.0: 27/27/27/0

172.16.0.1 65019 11640 11582 0 2 8:49:39 Establ

inet.0: 1/1/1/0

172.16.0.3 65018 11634 11583 0 1 8:49:42 Establ

inet.0: 1/1/1/0

172.16.1.5 65229 11678 11500 0 1 8:49:43 Establ

inet.0: 3/8/3/0

172.16.1.8 65229 11688 11581 0 1 8:49:43 Establ

inet.0: 3/8/3/0

Significado

La salida en DC2-Spine1 confirma que todas sus sesiones BGP están establecidas. Hay una sesión subyacente y de superposición por hoja local, además de la sesión de emparejamiento WAN y las 2 sesiones de emparejamiento de superposición a los dispositivos spine en el DC remoto. Esto eleva el número total de sesiones a 9. La capacidad de establecer el emparejamiento de superposición con el controlador de dominio remoto confirma el intercambio de ruta subyacente adecuado a través de la nube WAN.

Verificar VTEP en un dispositivo Leaf

Propósito

Verifique la conexión de capa 2 entre dos dispositivos leaf en diferentes centros de datos.

Acción

Verifique que las interfaces VTEP estén activas en los dispositivos leaf tanto en los centros de datos locales como en los remotos.

A continuación se muestra un fragmento de la salida del estado de VTEP de una hoja en el centro de datos 1.

user@dc1leaf1> show interfaces vtep

Physical interface: vtep, Enabled, Physical link is Up

Interface index: 641, SNMP ifIndex: 508

Type: Software-Pseudo, Link-level type: VxLAN-Tunnel-Endpoint, MTU: Unlimited, Speed: Unlimited

Device flags : Present Running

Link type : Full-Duplex

Link flags : None

Last flapped : Never

Input packets : 0

Output packets: 0

.

.

.

Logical interface vtep.32769 (Index 555) (SNMP ifIndex 539)

Flags: Up SNMP-Traps Encapsulation: ENET2

VXLAN Endpoint Type: Remote, VXLAN Endpoint Address: 10.80.224.141, L2 Routing Instance: default-switch, L3 Routing Instance: default

Input packets : 731317

Output packets: 469531709

Protocol eth-switch, MTU: Unlimited

Flags: Trunk-Mode

.

.

.

Logical interface vtep.32770 (Index 572) (SNMP ifIndex 541)

Flags: Up SNMP-Traps Encapsulation: ENET2

VXLAN Endpoint Type: Remote, VXLAN Endpoint Address: 10.0.0.18, L2 Routing Instance: default-switch, L3 Routing Instance: default

Input packets : 136973831

Output packets: 141901343

Protocol eth-switch, MTU: Unlimited

Flags: Trunk-Mode

.

.

.

Significado

La salida en DC1-Leaf1 muestra que se crean túneles VXLAN de capa 2 entre este dispositivo leaf y los otros dispositivos leaf en la estructura del centro de datos local (la dirección VTEP de leaf 2 en DC1 se muestra en el fragmento). El resultado también muestra que los VTEP se aprenden entre este dispositivo leaf y los otros dispositivos leaf en la estructura del centro de datos remoto (el VTEP para leaf 2 en DC2 se muestra en el fragmento de código). Los contadores de paquetes de entrada y salida verifican que la transmisión de datos entre puntos de conexión en estos VTEP se realice correctamente.

Verificar rutas de EVPN tipo 1

Propósito

Compruebe que las rutas de EVPN tipo 1 se están agregando a la tabla de enrutamiento.

Acción

Compruebe que se ha recibido e instalado la ruta EVPN tipo 1 (AD/ESI).

user@dc1leaf1>show route | match 1:10.0.0.181:10.0.0.18:0::0202020201::FFFF:FFFF/192 AD/ESI 1:10.0.0.18:0::0202020202::FFFF:FFFF/192 AD/ESI user@dc1leaf1>show route extensive | find 1:10.0.0.18:0::0202020201:1:10.0.0.18:0::0202020201::FFFF:FFFF/192 AD/ESI (1 entry, 0 announced) *BGP Preference: 170/-101 Route Distinguisher: 10.0.0.18:0 Next hop type: Indirect, Next hop index: 0 Address: 0xbd78c94 Next-hop reference count: 50 Source: 10.80.224.149 Protocol next hop: 10.0.0.18 Indirect next hop: 0x2 no-forward INH Session ID: 0x0 State: <Active Int Ext> Local AS: 64730 Peer AS: 64730 Age: 1:22 Metric2: 0 Validation State: unverified Task: BGP_64730.10.80.224.149 AS path: 64830 I Communities: target:64830:999 encapsulation:vxlan(0x8) esi-label:0x0:all-active (label 0) Import Accepted Route Label: 1 Localpref: 100 Router ID: 10.80.224.149 Secondary Tables: default-switch.evpn.0 Indirect next hops: 1 Protocol next hop: 10.0.0.18 Indirect next hop: 0x2 no-forward INH Session ID: 0x0 Indirect path forwarding next hops: 1 Next hop type: Router Next hop: 10.80.224.2 via et-0/0/49.0 Session Id: 0x0 10.0.0.18/32 Originating RIB: inet.0 Node path count: 1 Forwarding nexthops: 1 Nexthop: 10.80.224.2 via et-0/0/49.0 Session Id: 0

Muestra la información de la instancia de enrutamiento EVPN. El siguiente fragmento está tomado en la hoja 1 en DC1.

user@dc1leaf1> show evpn instance extensive

Instance: __default_evpn__

Route Distinguisher: 10.80.224.140:0

Number of bridge domains: 0

Number of neighbors: 0

. . .

ESI: 00:00:00:00:00:02:02:02:02:01

Status: Resolved

Number of remote PEs connected: 2

Remote PE MAC label Aliasing label Mode

10.0.0.19 1203 0 all-active

10.0.0.18 0 0 all-active

ESI: 00:00:00:00:00:02:02:02:02:02

Status: Resolved

Number of remote PEs connected: 2

Remote PE MAC label Aliasing label Mode

10.0.0.19 0 0 all-active

10.0.0.18 0 0 all-active

. . .

Significado

Estas salidas muestran que DC1-Leaf1 ha recibido rutas EVPN tipo 1 (AD/ESI) desde el centro de datos remoto. Puede utilizar el resultado del show route extensive comando para mostrar que estas rutas tienen un destino de ruta de "target:64830:999" y que estas rutas se instalaron correctamente. Los ESI 02:02:02:02:01 y 02:02:02:02:02 son segmentos Ethernet en el centro de datos remoto. Esta salida también muestra que los PE remotos con direcciones IP de 10.0.0.18 y 10.0.0.19 forman parte de estos segmentos de Ethernet.

Verificar rutas de EVPN tipo 2

Propósito

Compruebe que las rutas de tipo 2 de EVPN se están agregando a la tabla de enrutamiento.

Acción

Compruebe que se ha recibido e instalado una ruta EVPN tipo 2 en la tabla de rutas de un dispositivo leaf del centro de datos 1.

Utilice show route para encontrar un punto de conexión en VLAN 203 que se encuentre en el centro de datos remoto.

user@dc1leaf1>show route | match 00:10:94:00:00:06

2:10.0.0.18:1::1203::00:10:94:00:00:06/304 MAC/IP

2:10.0.0.18:1::1203::00:10:94:00:00:06::10.1.203.151/304 MAC/IP

Utilice la vista detallada de mostrar ruta para ver más detalles.

user@dc1leaf1> show route extensive | find 2:10.0.0.18:1::1203::00:10:94:00:00:06::10.1.203.151/304

2:10.0.0.18:1::1203::00:10:94:00:00:06::10.1.203.151/304 MAC/IP (1 entry, 0 announced)

*BGP Preference: 170/-101

Route Distinguisher: 10.0.0.18:1

Next hop type: Indirect, Next hop index: 0

Address: 0xbd78c94

Next-hop reference count: 58

Source: 10.80.224.149

Protocol next hop: 10.0.0.18

Indirect next hop: 0x2 no-forward INH Session ID: 0x0

State: <Active Int Ext>

Local AS: 64730 Peer AS: 64730

Age: 1:31 Metric2: 0

Validation State: unverified

Task: BGP_64730.10.80.224.149

AS path: 64830 I

Communities: target:64830:203 encapsulation:vxlan(0x8)

Import Accepted

Route Label: 1203

ESI: 00:00:00:00:00:00:00:00:01:01

Localpref: 100

Router ID: 10.80.224.149

Secondary Tables: default-switch.evpn.0

Indirect next hops: 1

Protocol next hop: 10.0.0.18

Indirect next hop: 0x2 no-forward INH Session ID: 0x0

Indirect path forwarding next hops: 1

Next hop type: Router

Next hop: 10.80.224.2 via et-0/0/49.0

Session Id: 0x0

10.0.0.18/32 Originating RIB: inet.0

Node path count: 1

Forwarding nexthops: 1

Nexthop: 10.80.224.2 via et-0/0/49.0

Session Id: 0

Utilice el show vlans comando para buscar la información en la VLAN 203.

user@dc1leaf1> show vlans v203

Routing instance VLAN name Tag Interfaces

default-switch v203 203

esi.1860*

vtep.32769*

vtep.32770*

vtep.32772*

xe-0/0/1.0*

La salida anterior muestra que VLAN 203 está configurada en VTEP "vtep.32769 - 10.80.224.141 – DC1-Leaf2", "vtep.32772 – 10.0.0.18 – DC2-Leaf2", "vtep.32770 - 10.0.0.19 – DC2-Leaf1". El resultado también indica que hay puntos de conexión conectados a VLAN v203 en estos VTEP. Puede usar show interfaces VTEP para obtener la dirección IP de VTEP para estos VTEP. Utilice los show evpn database comandos y para show ethernet-switching-table buscar la dirección MAC y la dirección IP de estos extremos.

Utilice el show evpn database para buscar entradas en la base de datos EVPN.

user@dc1leaf1> show evpn database neighbor 10.0.0.18

Instance: default-switch

VLAN DomainId MAC address Active source Timestamp IP address

1202 3c:8c:93:2e:a8:c0 10.0.0.18 Jul 18 23:41:54 10.1.202.18

1203 00:10:94:00:00:06 00:00:00:00:00:02:02:02:02:01 Jul 19 03:16:42 10.1.203.151

1203 3c:8c:93:2e:a8:c0 10.0.0.18 Jul 18 23:41:54 10.1.203.18

Utilice el show ethernet-switching table comando para mostrar información de una dirección MAC determinada.

user@dc1leaf1> show ethernet-switching table 00:10:94:00:00:06

MAC flags (S - static MAC, D - dynamic MAC, L - locally learned, P - Persistent static

SE - statistics enabled, NM - non configured MAC, R - remote PE MAC, O - ovsdb MAC)

Ethernet switching table : 29 entries, 29 learned

Routing instance : default-switch

Vlan MAC MAC Logical Active

name address flags interface source

v203 00:10:94:00:00:06 DR esi.1874 00:00:00:00:00:02:02:02:02:01

Significado

El resultado muestra que la dirección MAC de un dispositivo en la VLAN 203 en el PE remoto se ha instalado en la base de datos EVPN y está en la tabla Conmutación Ethernet.

Verificar el DCI de capa 3

Propósito

Compruebe que las rutas de capa 3 estén instaladas en la tabla de enrutamiento.

Acción

Compruebe que se ha recibido e instalado una ruta EVPN tipo 5 en la tabla de rutas de un dispositivo leaf del centro de datos 1.

Compruebe que está recibiendo rutas de EVPN tipo 5 desde 10.1.170.0/24, que es la subred de VLAN 170. Esta VLAN es local para el centro de datos 2. Para llegar a esta subred desde el centro de datos 1 se requiere enrutamiento de capa 3.

user@dc1leaf1> show route | match 5: | match 10.1.170.0

5:10.0.1.18:9999::0::10.1.170.0::24/248

5:10.0.1.19:9999::0::10.1.170.0::24/248

. . .

Puede ver más detalles sobre la ruta EVPN tipo 5 para la red 10.1.170.0/24. El tráfico enviado desde este dispositivo leaf para esta subred se encapsula en el túnel VXLAN con VNI 9999 y se envía al leaf remoto 10.0.0.18 en el centro de datos 2.

user@dc1leaf1> show route 10.1.170.0/24 extensive

TENANT_1_VRF.inet.0: 28 destinations, 57 routes (28 active, 0 holddown, 0 hidden)

10.1.170.0/24 (3 entries, 1 announced)

TSI:

KRT in-kernel 10.1.170.0/24 -> {composite(1742)}

*EVPN Preference: 170/-101

Next hop type: Indirect, Next hop index: 0

Address: 0xdfacd74

Next-hop reference count: 9

Next hop type: Router, Next hop index: 1738

Next hop: 10.80.224.2 via et-0/0/49.0, selected

Session Id: 0x0

Protocol next hop: 10.0.0.18

Composite next hops: 1

Protocol next hop: 10.0.0.18

Composite next hop: 0xb959d60 1740 INH Session ID: 0x0

VXLAN tunnel rewrite:

MTU: 0, Flags: 0x0

Encap table ID: 0, Decap table ID: 11

Encap VNI: 9999, Decap VNI: 9999

Source VTEP: 10.80.224.140, Destination VTEP: 10.0.0.18

SMAC: e4:5d:37:ea:98:00, DMAC: 3c:8c:93:2e:a8:c0

Indirect next hop: 0xc710304 131071 INH Session ID: 0x0

Indirect path forwarding next hops: 1

Next hop type: Router

Next hop: 10.80.224.2 via et-0/0/49.0

Session Id: 0x0

10.0.0.18/32 Originating RIB: inet.0

Node path count: 1

Forwarding nexthops: 1

Nexthop: 10.80.224.2 via et-0/0/49.0

Session Id: 0

El resultado confirma que las rutas para la subred 10.1.170.0/24 están presentes en este dispositivo leaf. Dado que estamos exportando e importando rutas de host, verá las rutas de host específicas de EVPN tipo 5.

user@dc1leaf1> show route table TENANT_1_VRF.inet.0 10.1.170.0/24

TENANT_1_VRF.inet.0: 21 destinations, 35 routes (21 active, 0 holddown, 0 hidden)

@ = Routing Use Only, # = Forwarding Use Only

+ = Active Route, - = Last Active, * = Both

10.1.170.0/24 @[EVPN/170] 1d 06:38:11

> to 10.80.224.2 via et-0/0/49.0

> to 10.80.224.12 via et-0/0/50.0

[EVPN/170] 1d 06:38:09

> to 10.80.224.2 via et-0/0/49.0

> to 10.80.224.12 via et-0/0/50.0

#[Multipath/255] 1d 06:38:09, metric2 0

> to 10.80.224.2 via et-0/0/49.0

> to 10.80.224.12 via et-0/0/50.0

10.1.170.100/32 @[EVPN/170] 00:00:23

> to 10.80.224.2 via et-0/0/49.0

> to 10.80.224.12 via et-0/0/50.0

[EVPN/170] 00:00:22

> to 10.80.224.2 via et-0/0/49.0

> to 10.80.224.12 via et-0/0/50.0

#[Multipath/255] 00:00:22, metric2 0

> to 10.80.224.2 via et-0/0/49.0

> to 10.80.224.12 via et-0/0/50.0

El resultado muestra rutas para la subred 10.1.203.0/24 en este dispositivo leaf. En este caso, la VLAN 203 se extiende a ambos centros de datos. Cuando solo limite las rutas de EVPN tipo 5 a rutas de subred, tendrá un enrutamiento asimétrico entre VNI para VLAN expandidas L2. Si prefiere implementar un modelo simétrico para el enrutamiento entre VNI para VLAN expandidas L2, debe exportar e importar rutas de host EVPN de tipo 5.

En este ejemplo se utiliza la T5_EXPORT directiva aplicada a la TENANT_1_VRF como una directiva de exportación para el protocolo EVPN para efectuar la publicidad de las rutas de host /32. Como resultado, en este ejemplo se muestra el enrutamiento simétrico para el enrutamiento entre VLAN cuando esas VLAN se extienden entre controladores de dominio.

user@dc1leaf1>show route table TENANT_1_VRF.inet.0 10.1.203.0/24

TENANT_1_VRF.inet.0: 28 destinations, 57 routes (28 active, 0 holddown, 0 hidden)

+ = Active Route, - = Last Active, * = Both

10.1.203.0/24 *[Direct/0] 1d 05:42:50

> via irb.203

[EVPN/170] 1d 05:42:50

> to 10.80.224.2 via et-0/0/49.0

to 10.80.224.12 via et-0/0/50.0

[EVPN/170] 1d 05:42:50

> to 10.80.224.2 via et-0/0/49.0

to 10.80.224.12 via et-0/0/50.0

[EVPN/170] 1d 05:42:50

> to 10.80.224.2 via et-0/0/49.0

to 10.80.224.12 via et-0/0/50.0

[EVPN/170] 1d 05:42:50

> to 10.80.224.2 via et-0/0/49.0

to 10.80.224.12 via et-0/0/50.0

[EVPN/170] 01:06:19

> to 10.80.224.2 via et-0/0/49.0

to 10.80.224.12 via et-0/0/50.0

[EVPN/170] 01:17:41

> to 10.80.224.2 via et-0/0/49.0

to 10.80.224.12 via et-0/0/50.0

10.1.203.1/32 *[Local/0] 1d 05:42:50

Local via irb.203

10.1.203.11/32 *[Local/0] 1d 05:42:50

Local via irb.203

10.1.203.52/32 *[EVPN/7] 02:52:51

> via irb.203

Significado

Este resultado muestra que se han instalado tanto la subred 10.1.203.0/24 como la ruta de host específica para 10.1.203.52/32 (la dirección IP de un punto de conexión en Data Center 2). Se prefiere la ruta más EVPN tipo 5 sobre la ruta EVPN tipo 2 para la ruta 10.1.203.52/32. Esto da como resultado un enrutamiento simétrico entre VNI sobre VLAN expandidas de capa 2.