Cómo configurar una columna colapsada con multiconexión EVPN

Requisitos

En este ejemplo se supone que tiene dos centros de datos (DC1 y DC2) con redes independientes. En este ejemplo se utilizan los siguientes dispositivos y software:

DC1:

Dos conmutadores spine: QFX5120-48Y con Junos OS versión 18.4R2-S1.4

Dos conmutadores ToR: EX4300-48T con Junos OS versión 18.1R3-S6.1

Dos dispositivos de seguridad: dispositivos SRX345 con Junos OS versión 18.2R3.4 (configuración complementaria opcional)

Cuatro servidores

DC2:

Dos conmutadores spine: QFX5120-48Y con Junos OS versión 18.4R2-S1.4

Dos conmutadores ToR: EX4300-48T con Junos OS versión 18.1R3-S6.1

Dos servidores

Cada par de conmutadores ToR ya debería estar configurado como un chasis virtual. Consulte Descripción del chasis virtual de la serie EX para obtener más información acerca de cómo formar un chasis virtual con conmutadores EX4300. Esta configuración de ejemplo utiliza vínculos Ethernet agregados de múltiples conexiones entre el chasis virtual ToR y los dos dispositivos spine en un solo miembro del chasis virtual. Si es posible, para una mejor resistencia, puede conectar los vínculos Ethernet agregados de multiconexión entre el Virtual Chassis y los dispositivos spine mediante interfaces de diferentes miembros de Virtual Chassis.

Visión general

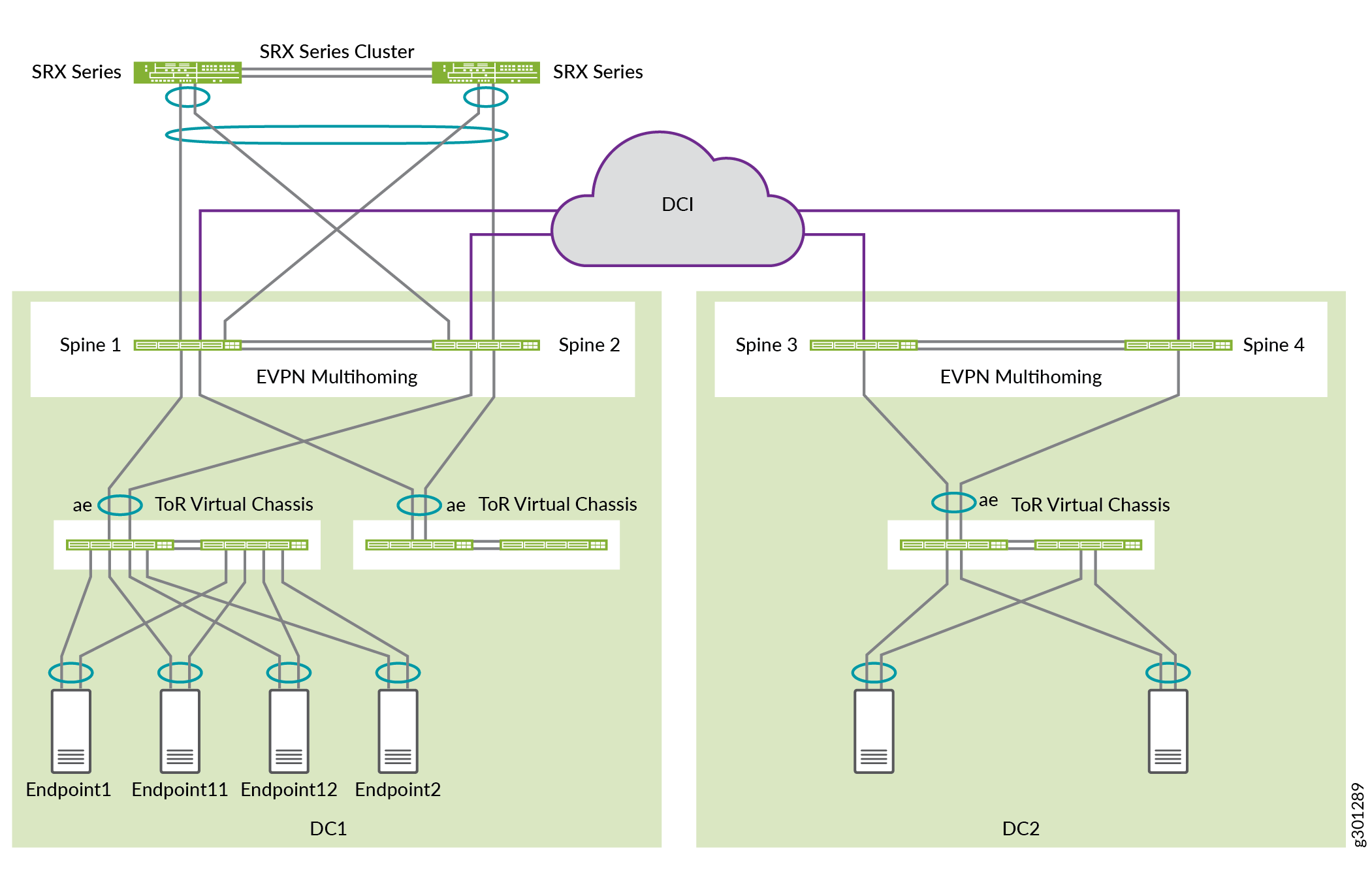

Utilice este ejemplo para configurar una arquitectura de spine colapsada con multiconexión EVPN de los conmutadores ToR. Tenemos dos centros de datos con una configuración opcional de interconexión del centro de datos (DCI), un clúster SRX opcional para mayor seguridad y una configuración opcional de relé DHCP. En este ejemplo de configuración se muestra cómo configurar esta arquitectura en DC1. Puede utilizar una configuración similar en DC2.

Topología

En este despliegue, hay dos centros de datos: DC1 y DC2. Las redes del centro de datos se configuran con una arquitectura de spine colapsada que utiliza QFX5120 como conmutadores de spine. En este caso, le recomendamos que limite la estructura EVPN-VXLAN al centro de datos local.

Opcionalmente, puede conectar los centros de datos utilizando DCI de capa 3 en la capa subyacente. Este caso de uso no requiere un tramo de capa 2 entre los centros de datos. El tráfico entre centros de datos es solo de capa 3 y se enruta a través del clúster SRX en DC1 para una inspección avanzada.

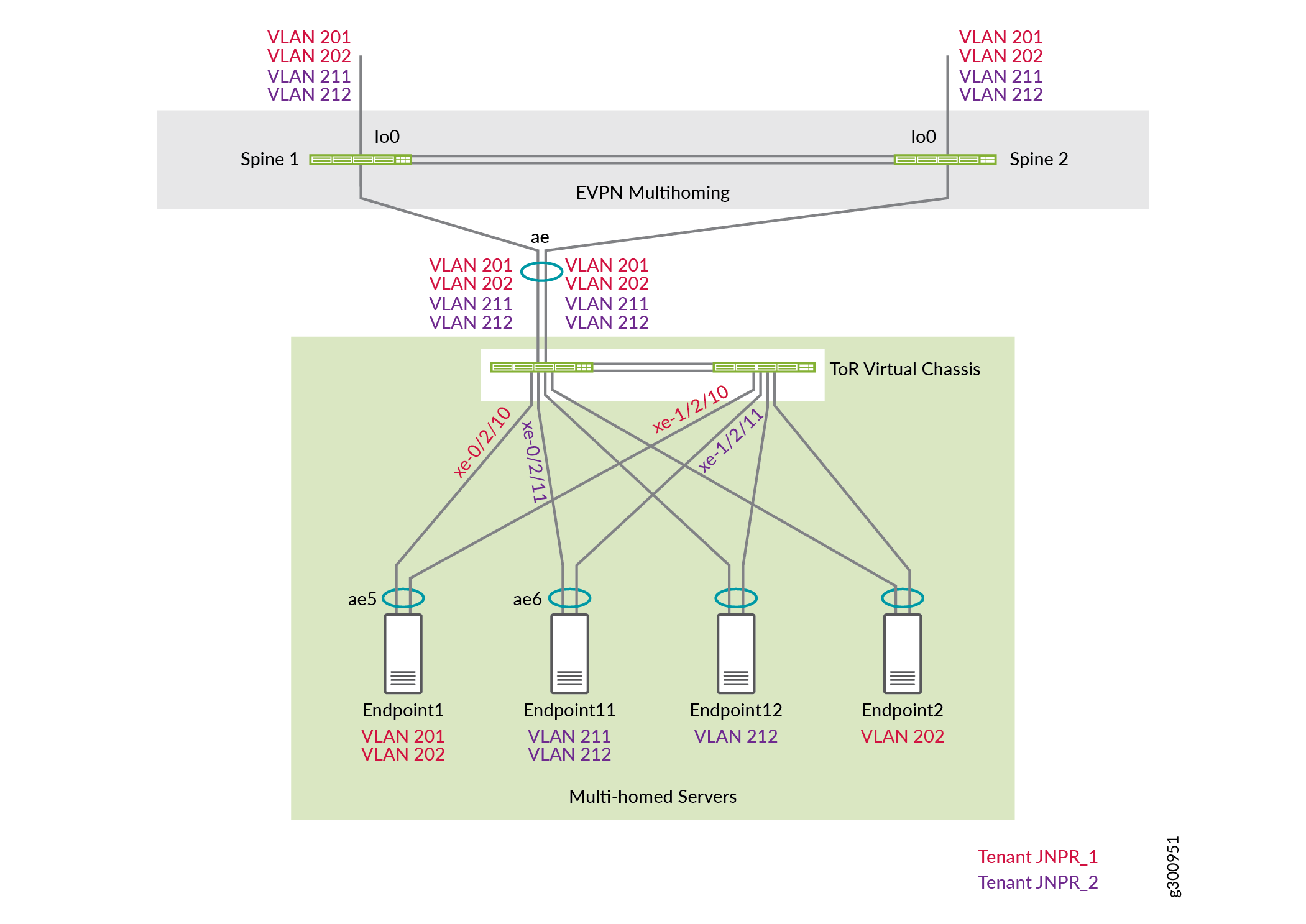

La figura 1 muestra la conectividad lógica entre los componentes utilizados en este NCE.

lógica

lógica

Hay dos inquilinos en DC1: JNPR1 y JNPR2. Cualquier tráfico entre inquilinos entre JNPR1 y JNPR2 en DC1 se enruta a través del clúster de firewall SRX por motivos de seguridad.

DC1:

Las VLAN 201 y 202 pertenecen a JNPR1.

Las VLAN 211 y 212 pertenecen a JNPR2.

DC1 tiene servidores en las VLAN 201, 202, 211 y 212.

DC2:

Las VLAN 221 y 222 pertenecen al inquilino predeterminado, que es el mismo que la instancia de enrutamiento predeterminada.

DC2 tiene servidores en las VLAN 221 y 222.

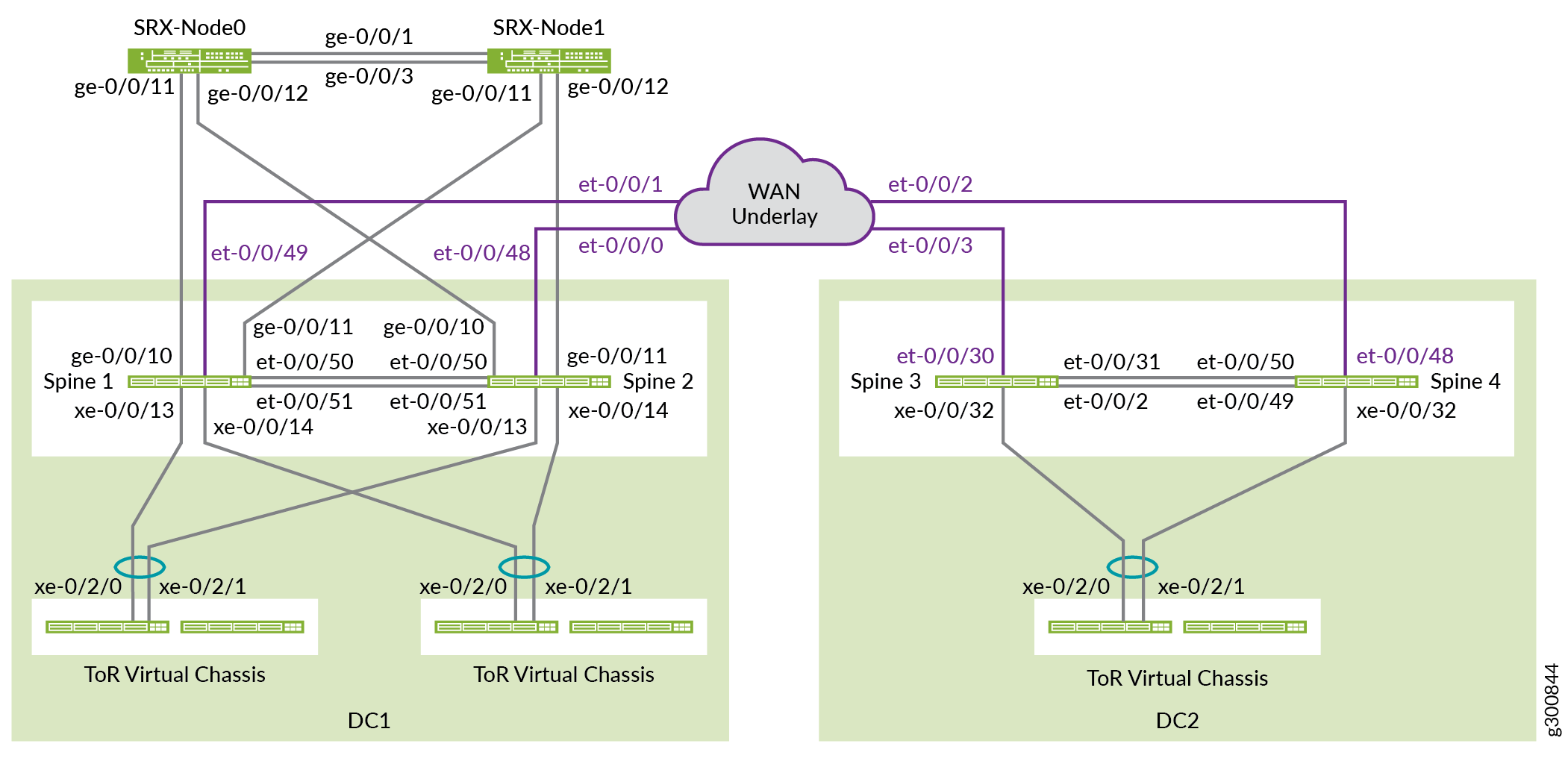

La figura 2 muestra la conectividad física entre los componentes utilizados en este NCE.

física

física

Antes de empezar

Debe implementar alguna configuración básica en sus dispositivos antes de configurar la estructura.

Procedimiento

Procedimiento paso a paso

De forma predeterminada, no se crean interfaces Ethernet agregadas. Debe establecer el número de interfaces Ethernet agregadas antes de poder configurarlas. Una vez establecido el recuento de dispositivos, el sistema creará ese número de interfaces Ethernet agregadas vacías, cada una con una dirección MAC única globalmente. Puede crear más interfaces Ethernet agregadas aumentando el número de dispositivos al número de interfaces ESI-LAG necesarias en el dispositivo.

Establezca el número de interfaces Ethernet agregadas en todos los conmutadores spine y ToR.

set chassis aggregated-devices ethernet device-count 15

Los puertos 0 a 47 en un QFX5120-48Y funcionan como puertos de 10 gigabits de forma predeterminada. Los dispositivos SRX solo admiten 1 gigabit. Configure los puertos de Spine 1 y Spine 2 que están conectados al firewall de la serie SRX para que sean puertos de 1 gigabit. En este caso, estos puertos son ge-0/0/10 y ge-0/0/11. Para habilitar 1 gigabit en estos puertos, configure la velocidad del primer puerto del quad, que en este caso es ge-0/0/8.

Use la siguiente instrucción en Spine 1 y Spine 2:

set chassis fpc 0 pic 0 port 8 speed 1G

Nota:Puede configurar las velocidades de los puertos de 1 gigabit y 25 gigabits solo por quad (grupo de cuatro puertos) y no individualmente. Todos los puertos operan a una sola velocidad dentro del quad. Por ejemplo, si configura los puertos 8 a 11 para que funcionen como puertos Ethernet de 1 gigabit e inserta un transceptor SFP+ de 10 gigabits en el puerto 10, no se crea una interfaz para este puerto.

El modo de detección automática de velocidad detecta interfaces Ethernet de 100 gigabits y Ethernet de 40 gigabits y las canaliza automáticamente. La canalización automática y la detección de velocidad están habilitadas de forma predeterminada. En este ejemplo, la canalización automática dividiría cada interfaz Ethernet de 40 gigabits en cuatro interfaces Ethernet de 10 gigabits.

Desactive la canalización automática en los puertos et-0/0/2 y et-0/0/31 en Spine 3 y en los puertos et-0/0/49 y et-0/0/50 en Spine 4 para que sigan siendo interfaces Ethernet de 40 gigabits.

Columna vertebral 3:

set chassis fpc 0 pic 0 port 2 channel-speed disable-auto-speed-detection set chassis fpc 0 pic 0 port 31 channel-speed disable-auto-speed-detection

Columna vertebral 4:

set chassis fpc 0 pic 0 port 49 channel-speed disable-auto-speed-detection set chassis fpc 0 pic 0 port 50 channel-speed disable-auto-speed-detection

Configurar la base subyacente

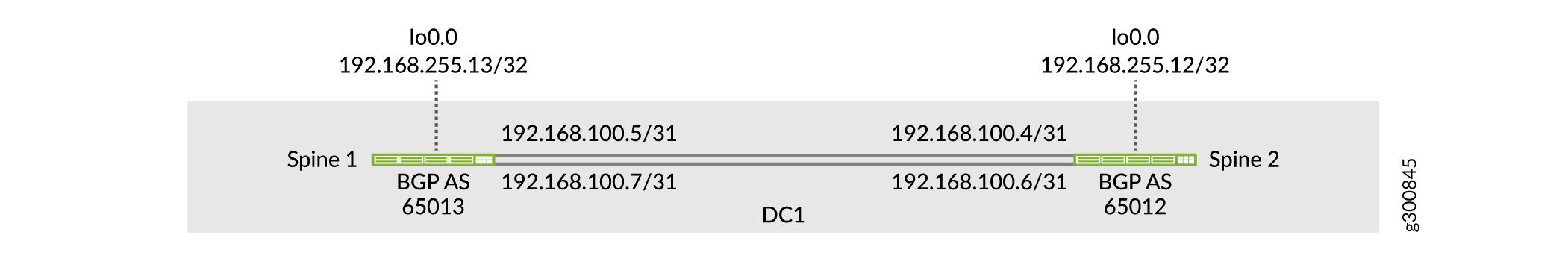

En esta topología, la estructura IP solo se encuentra entre los dos conmutadores spine, como se muestra en la figura 3. Los dos conmutadores spine establecen un emparejamiento EBGP sobre los vínculos punto a punto para intercambiar direcciones de circuito cerrado entre sí.

de la estructura de IP

de la estructura de IP

Configurar Spine 1

Procedimiento paso a paso

Configure las interfaces en Spine 1.

set interfaces et-0/0/50 description "* connected to DC1-Spine2" set interfaces et-0/0/50 traps set interfaces et-0/0/50 mtu 9216 set interfaces et-0/0/50 unit 0 family inet address 192.168.100.5/31 set interfaces et-0/0/51 description "* connected to DC1-Spine2" set interfaces et-0/0/51 traps set interfaces et-0/0/51 mtu 9216 set interfaces et-0/0/51 unit 0 family inet address 192.168.100.7/31 set interfaces lo0 unit 0 description "** DC1 Spine1 Loopback" set interfaces lo0 unit 0 family inet address 192.168.255.13/32

Configure la base de EBGP.

set protocols bgp log-updown set protocols bgp graceful-restart restart-time 30 set protocols bgp group UNDERLAY type external set protocols bgp group UNDERLAY description "Connection to EBGP UNDERLAY" set protocols bgp group UNDERLAY import UNDERLAY-IMPORT set protocols bgp group UNDERLAY family inet unicast set protocols bgp group UNDERLAY authentication-key "$ABC123" set protocols bgp group UNDERLAY export UNDERLAY-EXPORT set protocols bgp group UNDERLAY local-as 65013 set protocols bgp group UNDERLAY multipath multiple-as set protocols bgp group UNDERLAY neighbor 192.168.100.4 peer-as 65012 set protocols bgp group UNDERLAY neighbor 192.168.100.6 peer-as 65012

Configure las directivas de importación y exportación.

set policy-options policy-statement UNDERLAY-EXPORT term LOOPBACK from route-filter 192.168.255.0/24 orlonger set policy-options policy-statement UNDERLAY-EXPORT term LOOPBACK then accept set policy-options policy-statement UNDERLAY-EXPORT term DEFAULT then reject set policy-options policy-statement UNDERLAY-IMPORT term LOOPBACK from route-filter 192.168.255.0/24 orlonger set policy-options policy-statement UNDERLAY-IMPORT term LOOPBACK then accept set policy-options policy-statement UNDERLAY-IMPORT term DEFAULT then reject

Active ECMP y la protección de reenrutamiento rápido ECMP. Habilite el equilibrio de carga por flujo, lo que hace con la

per-packetpalabra clave.set policy-options policy-statement ECMP-POLICY then load-balance per-packet set routing-options forwarding-table export ECMP-POLICY

Si un vínculo deja de funcionar, ECMP utiliza la protección de reenrutamiento rápido para cambiar el reenvío de paquetes a vínculos operativos, lo que disminuye la pérdida de paquetes. La protección de reenrutamiento rápido actualiza los conjuntos ECMP para la interfaz sin tener que esperar a que se actualice la tabla de rutas. Cuando se produzca la próxima actualización de la tabla de rutas, se puede agregar un nuevo conjunto de ECMP con menos vínculos o la ruta puede apuntar a un único salto siguiente.

set routing-options forwarding-table ecmp-fast-reroute

De forma predeterminada, el temporizador de antigüedad ARP se establece en 20 minutos y el temporizador de antigüedad de MAC se establece en 5 minutos. Para evitar problemas de sincronización con entradas de enlace MAC y MAC-IP en un entorno EVPN-VXLAN, configure la antigüedad de ARP para que sea más rápida que la antigüedad de MAC.

set system arp aging-timer 5 set protocols l2-learning global-mac-ip-table-aging-time 300 set protocols l2-learning global-mac-table-aging-time 600

Configurar Spine 2

Procedimiento paso a paso

Repita la configuración desde Spine 1 en Spine 2.

Configure las interfaces en Spine 2.

set interfaces et-0/0/50 description "* connected to DC1-Spine1" set interfaces et-0/0/50 traps set interfaces et-0/0/50 mtu 9216 set interfaces et-0/0/50 unit 0 family inet address 192.168.100.4/31 set interfaces et-0/0/51 description "* connected to DC1-Spine1" set interfaces et-0/0/51 traps set interfaces et-0/0/51 mtu 9216 set interfaces et-0/0/51 unit 0 family inet address 192.168.100.6/31 set interfaces lo0 unit 0 description "** DC1 Spine2 Loopback" set interfaces lo0 unit 0 family inet address 192.168.255.12/32

Configure la base de EBGP.

set protocols bgp log-updown set protocols bgp graceful-restart restart-time 30 set protocols bgp group UNDERLAY type external set protocols bgp group UNDERLAY description "EBGP UNDERLAY" set protocols bgp group UNDERLAY import UNDERLAY-IMPORT set protocols bgp group UNDERLAY family inet unicast set protocols bgp group UNDERLAY authentication-key "$ABC123" set protocols bgp group UNDERLAY export UNDERLAY-EXPORT set protocols bgp group UNDERLAY local-as 65012 set protocols bgp group UNDERLAY multipath multiple-as set protocols bgp group UNDERLAY neighbor 192.168.100.5 peer-as 65013 set protocols bgp group UNDERLAY neighbor 192.168.100.7 peer-as 65013

Configure las directivas de importación y exportación.

set policy-options policy-statement UNDERLAY-EXPORT term LOOPBACK from route-filter 192.168.255.0/24 orlonger set policy-options policy-statement UNDERLAY-EXPORT term LOOPBACK then accept set policy-options policy-statement UNDERLAY-EXPORT term DEFAULT then reject set policy-options policy-statement UNDERLAY-IMPORT term LOOPBACK from route-filter 192.168.255.0/24 orlonger set policy-options policy-statement UNDERLAY-IMPORT term LOOPBACK then accept set policy-options policy-statement UNDERLAY-IMPORT term DEFAULT then reject

Active ECMP y la protección de reenrutamiento rápido ECMP.

set policy-options policy-statement ECMP-POLICY then load-balance per-packet set routing-options forwarding-table export ECMP-POLICY set routing-options forwarding-table ecmp-fast-reroute

Para evitar problemas de sincronización con entradas de enlace MAC y MAC-IP en un entorno EVPN-VXLAN, configure la antigüedad de ARP para que sea más rápida que la antigüedad de MAC.

set system arp aging-timer 5 set protocols l2-learning global-mac-ip-table-aging-time 300 set protocols l2-learning global-mac-table-aging-time 600

Comprobar la capa subyacente

Procedimiento paso a paso

Compruebe que ambas sesiones de vecino de BGP estén establecidas en la columna vertebral 1.

user@spine1> show bgp neighbor 192.168.100.4 Peer: 192.168.100.4+179 AS 65012 Local: 192.168.100.5+51424 AS 65013 Description: Connection to EBGP UNDERLAY Group: UNDERLAY Routing-Instance: master Forwarding routing-instance: master Type: External State: Established Flags: <Sync> Last State: OpenConfirm Last Event: RecvKeepAlive Last Error: Cease Export: [ UNDERLAY-EXPORT ] Import: [ UNDERLAY-IMPORT ] . . .

user@spine1> show bgp neighbor 192.168.100.6 Peer: 192.168.100.6+59705 AS 65012 Local: 192.168.100.7+179 AS 65013 Description: Connection to EBGP UNDERLAY Group: UNDERLAY Routing-Instance: master Forwarding routing-instance: master Type: External State: Established Flags: <Sync> Last State: OpenConfirm Last Event: RecvKeepAlive Last Error: Cease Export: [ UNDERLAY-EXPORT ] Import: [ UNDERLAY-IMPORT ] . . .

Compruebe que la dirección de bucle invertido de Spine 2 (192.168.255.12) es recibida por Spine 1 de ambas sesiones de vecinos de BGP.

user@spine1> show route receive-protocol bgp 192.168.100.4 inet.0: 17 destinations, 25 routes (17 active, 0 holddown, 0 hidden) Restart Complete Prefix Nexthop MED Lclpref AS path * 192.168.255.12/32 192.168.100.4 65012 I . . .

user@spine1> show route receive-protocol bgp 192.168.100.6 inet.0: 17 destinations, 25 routes (17 active, 0 holddown, 0 hidden) Restart Complete Prefix Nexthop MED Lclpref AS path 192.168.255.12/32 192.168.100.6 65012 I

user@spine1> show route 192.168.255.12 inet.0: 17 destinations, 25 routes (17 active, 0 holddown, 0 hidden) Restart Complete + = Active Route, - = Last Active, * = Both 192.168.255.12/32 *[BGP/170] 00:39:43, localpref 100, from 192.168.100.4 AS path: 65012 I, validation-state: unverified to 192.168.100.4 via et-0/0/50.0 > to 192.168.100.6 via et-0/0/51.0 [BGP/170] 00:39:43, localpref 100 AS path: 65012 I, validation-state: unverified > to 192.168.100.6 via et-0/0/51.0Haga ping al loopback del otro dispositivo de columna vertebral desde Spine 1.

user@spine1> ping 192.168.255.12 source 192.168.255.13 PING 192.168.255.12 (192.168.255.12): 56 data bytes 64 bytes from 192.168.255.12: icmp_seq=0 ttl=64 time=0.746 ms 64 bytes from 192.168.255.12: icmp_seq=1 ttl=64 time=0.699 ms 64 bytes from 192.168.255.12: icmp_seq=2 ttl=64 time=0.784 ms

Configurar la superposición

En esta sección se muestra cómo configurar la superposición. Incluye emparejamientos de IBGP y las asignaciones de VLAN a VXLAN para las redes virtuales.

Configurar Spine 1

Procedimiento paso a paso

Configure el emparejamiento de IBGP entre las direcciones de circuito cerrado de Spine 1 y Spine 2.

set protocols bgp group EVPN_FABRIC type internal set protocols bgp group EVPN_FABRIC local-address 192.168.255.13 set protocols bgp group EVPN_FABRIC family evpn signaling set protocols bgp group EVPN_FABRIC authentication-key "$ABC123" set protocols bgp group EVPN_FABRIC local-as 65100 set protocols bgp group EVPN_FABRIC multipath set protocols bgp group EVPN_FABRIC bfd-liveness-detection minimum-interval 1000 set protocols bgp group EVPN_FABRIC bfd-liveness-detection multiplier 3 set protocols bgp group EVPN_FABRIC neighbor 192.168.255.12 set protocols bgp group EVPN_FABRIC vpn-apply-export

Configure las VLAN y la asignación de VLAN a VXLAN.

set vlans VLAN-201 description "jnpr_1 - bridge domain id 201" set vlans VLAN-201 vlan-id 201 set vlans VLAN-201 vxlan vni 5201 set vlans VLAN-202 description "jnpr_1 - bridge domain id 202" set vlans VLAN-202 vlan-id 202 set vlans VLAN-202 vxlan vni 5202 set vlans VLAN-211 description "jnpr_2 - bridge domain id 211" set vlans VLAN-211 vlan-id 211 set vlans VLAN-211 vxlan vni 5211 set vlans VLAN-212 description "jnpr_2 - bridge domain id 212" set vlans VLAN-212 vlan-id 212 set vlans VLAN-212 vxlan vni 5212

Configure las siguientes opciones de conmutador:

La interfaz de origen del punto de conexión del túnel virtual (VTEP). Esta es la dirección de circuito cerrado en Spine 1.

El distinguidor de ruta para las rutas generadas por este dispositivo.

El destino de la ruta.

set switch-options vtep-source-interface lo0.0 set switch-options route-distinguisher 192.168.255.13:1 set switch-options vrf-target target:1:999 set switch-options vrf-target auto

Las rutas EVPN de tipo 1 utilizan el destino de ruta configurado en

vrf-target. Las rutas EVPN de tipo 2 y tipo 3 usan el destino de ruta por VNI derivado automáticamente para la exportación y la importación.Configure el protocolo EVPN. En primer lugar, configure VXLAN como encapsulación del plano de datos para EVPN.

set protocols evpn encapsulation vxlan

A continuación, configure las VNI que forman parte de este dominio EVPN-VXLAN MP-BGP. Utilícelo

set protocols evpn extended-vni-list allpara configurar todos los VNI o configure cada VNI por separado, como se muestra a continuación.set protocols evpn extended-vni-list 5201 set protocols evpn extended-vni-list 5202 set protocols evpn extended-vni-list 5211 set protocols evpn extended-vni-list 5212

Si el centro de datos solo tiene dos conmutadores de spine que solo tienen sesiones de vecinos de BGP entre sí, debe deshabilitar el aislamiento de núcleo en ambos conmutadores de spine. De lo contrario, si un conmutador de spine deja de funcionar, el otro conmutador de spine pierde todas las sesiones de vecino de BGP, lo que coloca los puertos orientados hacia ToR en modo de espera LACP y provoca una pérdida de tráfico completa. Consulte Estado del cerebro dividido y Descripción de cuándo deshabilitar el aislamiento del núcleo EVPN-VXLAN para obtener más información.

set protocols evpn no-core-isolation

Configurar Spine 2

Procedimiento paso a paso

Para evitar problemas de sincronización con entradas de enlace MAC y MAC-IP en un entorno EVPN-VXLAN, configure la antigüedad de ARP para que sea más rápida que la antigüedad de MAC.

set system arp aging-timer 5 set protocols l2-learning global-mac-ip-table-aging-time 300 set protocols l2-learning global-mac-table-aging-time 600

Configure el emparejamiento de IBGP.

set protocols bgp group EVPN_FABRIC type internal set protocols bgp group EVPN_FABRIC local-address 192.168.255.12 set protocols bgp group EVPN_FABRIC family evpn signaling set protocols bgp group EVPN_FABRIC authentication-key "$ABC123" set protocols bgp group EVPN_FABRIC local-as 65100 set protocols bgp group EVPN_FABRIC multipath set protocols bgp group EVPN_FABRIC bfd-liveness-detection minimum-interval 1000 set protocols bgp group EVPN_FABRIC bfd-liveness-detection multiplier 3 set protocols bgp group EVPN_FABRIC neighbor 192.168.255.13 set protocols bgp group EVPN_FABRIC vpn-apply-export

Configure las VLAN y la asignación de VLAN a VXLAN.

set vlans VLAN-201 description "jnpr_1 - bridge domain id 201" set vlans VLAN-201 vlan-id 201 set vlans VLAN-201 vxlan vni 5201 set vlans VLAN-202 description "jnpr_1 - bridge domain id 202" set vlans VLAN-202 vlan-id 202 set vlans VLAN-202 vxlan vni 5202 set vlans VLAN-211 description "jnpr_2 - bridge domain id 211" set vlans VLAN-211 vlan-id 211 set vlans VLAN-211 vxlan vni 5211 set vlans VLAN-212 description "jnpr_2 - bridge domain id 212" set vlans VLAN-212 vlan-id 212 set vlans VLAN-212 vxlan vni 5212

Configure las siguientes opciones de conmutador.

set switch-options vtep-source-interface lo0.0 set switch-options route-distinguisher 192.168.255.12:1 set switch-options vrf-target target:1:999 set switch-options vrf-target auto

Configure el protocolo EVPN.

set protocols evpn encapsulation vxlan

A continuación, configure las VNI que forman parte de este dominio EVPN-VXLAN MP-BGP. Utilícelo

set protocols evpn extended-vni-list allpara configurar todos los VNI o configure cada VNI por separado, como se muestra a continuación.set protocols evpn extended-vni-list 5201 set protocols evpn extended-vni-list 5202 set protocols evpn extended-vni-list 5211 set protocols evpn extended-vni-list 5212

Si el centro de datos solo tiene dos conmutadores spine que solo tienen sesiones de vecino BGP entre sí, debe deshabilitar el aislamiento de núcleo en ambos conmutadores spine.

set protocols evpn no-core-isolation

Comprobar la superposición

Procedimiento paso a paso

Verifique que se haya establecido el emparejamiento de IBGP entre Spine 1 y Spine 2.

user@spine1> show bgp neighbor 192.168.255.12 Peer: 192.168.255.12+179 AS 65100 Local: 192.168.255.13+62666 AS 65100 Description: Overlay neighbor with peer Group: EVPN_FABRIC Routing-Instance: master Forwarding routing-instance: master Type: Internal State: Established Flags:<Sync> Last State: OpenConfirm Last Event: RecvKeepAlive Last Error: Hold Timer Expired Error Options: <Preference LocalAddress HoldTime AuthKey GracefulRestart LogUpDown AddressFamily Multipath LocalAS Rib-group Refresh> Authentication key is configured Address families configured: evpn

Compruebe el VTEP de origen para el dominio EVPN.

user@spine1> show ethernet-switching vxlan-tunnel-end-point source Logical System Name Id SVTEP-IP IFL L3-Idx SVTEP-Mode <default> 0 192.168.255.13 lo0.0 0 L2-RTT Bridge Domain VNID MC-Group-IP default-switch VLAN-201+201 5201 0.0.0.0 default-switch VLAN-202+202 5202 0.0.0.0 default-switch VLAN-211+211 5211 0.0.0.0 default-switch VLAN-212+212 5212 0.0.0.0Compruebe todos los VTEP de origen y VTEP remotos.

user@spine1> show interfaces vtep Physical interface: vtep, Enabled, Physical link is Up Interface index: 641, SNMP ifIndex: 506 Type: Software-Pseudo, Link-level type: VxLAN-Tunnel-Endpoint, MTU: Unlimited, Speed: Unlimited Device flags : Present Running Link type : Full-Duplex Link flags : None Last flapped : Never Input packets : 0 Output packets: 0 Logical interface vtep.32768 (Index 545) (SNMP ifIndex 548) Flags: Up SNMP-Traps 0x4000 Encapsulation: ENET2 VXLAN Endpoint Type: Source, VXLAN Endpoint Address: 192.168.255.13, L2 Routing Instance: default-switch, L3 Routing Instance: default Input packets : 0 Output packets: 0 Logical interface vtep.32769 (Index 560) (SNMP ifIndex 550) Flags: Up SNMP-Traps Encapsulation: ENET2 VXLAN Endpoint Type: Remote, VXLAN Endpoint Address: 192.168.255.12, L2 Routing Instance: default-switch, L3 Routing Instance: default Input packets : 9140 Output packets: 0 Protocol eth-switch, MTU: Unlimited Flags: Trunk-Mode

Configurar y segmentar la capa 3

Configurar Spine 1

Procedimiento paso a paso

Configure las opciones de enrutamiento y reenvío.

Nota:Cambiar las opciones de enrutamiento y reenvío como

next-hop,overlay-ecmpochained-composite-next-hophace que el motor de reenvío de paquetes se reinicie, lo que interrumpe todas las operaciones de reenvío.Establezca el número de saltos siguientes en al menos el número esperado de entradas ARP en la superposición. Consulte Siguiente salto (enrutamiento VXLAN) para obtener más información acerca de la configuración

vxlan-routing next-hopde .Habilite los próximos saltos de múltiples rutas de dos niveles y de igual costo mediante la

overlay-ecmpinstrucción. Esta instrucción es necesaria para una red superpuesta EVPN-VXLAN de capa 3 cuando también está configurado el enrutamiento puro de tipo 5. Se recomienda encarecidamente configurar esta instrucción cuando estén habilitadas las rutas puras de tipo 5.La

chained-composite-next-hopconfiguración es imprescindible para EVPN puro Tipo 5 con encapsulación VXLAN. Sin esto, el PFE no configurará el próximo salto del túnel.Configure el ID del enrutador para que sea el mismo que la dirección IP de circuito cerrado utilizada como origen de VTEP y la dirección local del BGP de superposición.

set forwarding-options vxlan-routing next-hop 32768 set forwarding-options vxlan-routing overlay-ecmp set routing-options forwarding-table chained-composite-next-hop ingress evpn set routing-options router-id 192.168.255.13

Para habilitar la función de puerta de enlace predeterminada, configure interfaces IRB con una dirección IP única y una dirección de puerta de enlace virtual (VGA), que debe ser una dirección IP de cualquier difusión. Cuando se especifica una dirección IPv4 para VGA, la puerta de enlace VXLAN de capa 3 genera automáticamente 00:00:5e:00:01:01 como dirección MAC. En este ejemplo se muestra cómo configurar manualmente la dirección MAC de la puerta de enlace virtual. Configure la misma dirección MAC de puerta de enlace virtual en ambos dispositivos spine para un IRB determinado.

Nota:Si la dirección IP VGA es inferior a la dirección IP IRB, debe usar la

preferredopción en la configuración IRB como se muestra en este ejemplo.set interfaces irb unit 201 virtual-gateway-accept-data set interfaces irb unit 201 description "** L3 interface for VLAN-201 in jnpr_1" set interfaces irb unit 201 family inet address 192.168.201.3/24 virtual-gateway-address 192.168.201.1 set interfaces irb unit 201 family inet address 192.168.201.3/24 preferred set interfaces irb unit 201 virtual-gateway-v4-mac 3c:8c:93:2e:20:01 set vlans VLAN-201 l3-interface irb.201 set interfaces irb unit 202 virtual-gateway-accept-data set interfaces irb unit 202 description "** L3 interface for VLAN-202 in jnpr_1" set interfaces irb unit 202 family inet address 192.168.202.3/24 virtual-gateway-address 192.168.202.1 set interfaces irb unit 202 family inet address 192.168.202.3/24 preferred set interfaces irb unit 202 virtual-gateway-v4-mac 3c:8c:93:2e:20:02 set vlans VLAN-202 l3-interface irb.202 set interfaces irb unit 211 virtual-gateway-accept-data set interfaces irb unit 211 description "** L3 interface for VLAN-211 in jnpr_2" set interfaces irb unit 211 family inet address 192.168.211.3/24 virtual-gateway-address 192.168.211.1 set interfaces irb unit 211 family inet address 192.168.211.3/24 preferred set interfaces irb unit 211 virtual-gateway-v4-mac 3c:8c:93:2e:21:11 set vlans VLAN-211 l3-interface irb.211 set interfaces irb unit 212 virtual-gateway-accept-data set interfaces irb unit 212 description "** L3 interface for VLAN-212 in jnpr_2" set interfaces irb unit 212 family inet address 192.168.212.3/24 virtual-gateway-address 192.168.212.1 set interfaces irb unit 212 family inet address 192.168.212.3/24 preferred set interfaces irb unit 212 virtual-gateway-v4-mac 3c:8c:93:2e:21:12 set vlans VLAN-212 l3-interface irb.212

Configurará las mismas direcciones IP y MAC IRB anycast en las interfaces IRB de cada dispositivo spine. Dado que los dispositivos spine actúan como dispositivos spine y leaf en una arquitectura spine colapsada, son los únicos dispositivos que necesitan saber acerca de las interfaces IRB. Desactive el anuncio de las interfaces IRB a los otros dispositivos.

set protocols evpn default-gateway do-not-advertise

Coloque los IRB que pertenecen a los diferentes inquilinos en sus respectivas instancias de enrutamiento. Esto permite que los IRB de las mismas instancias de enrutamiento compartan una tabla de enrutamiento. Como resultado, los IRB de una instancia de enrutamiento pueden enrutarse entre sí. Los IRB en diferentes instancias de enrutamiento pueden comunicarse entre sí a través de un ejecutor de políticas de seguridad externo, como firewalls SRX, o si filtramos rutas explícitamente entre las instancias de enrutamiento.

set routing-instances JNPR_1_VRF description "VRF for tenant jnpr_1" set routing-instances JNPR_1_VRF instance-type vrf set routing-instances JNPR_1_VRF interface irb.201 set routing-instances JNPR_1_VRF interface irb.202 set routing-instances JNPR_1_VRF vrf-table-label set routing-instances JNPR_1_VRF routing-options multipath set routing-instances JNPR_2_VRF description "VRF for tenant jnpr_2" set routing-instances JNPR_2_VRF instance-type vrf set routing-instances JNPR_2_VRF interface irb.211 set routing-instances JNPR_2_VRF interface irb.212 set routing-instances JNPR_2_VRF vrf-table-label set routing-instances JNPR_2_VRF routing-options multipath

Configure VNI de tipo 5 para las instancias de enrutamiento. Al configurar una instancia de enrutamiento para EVPN-VXLAN, debe incluir una interfaz de circuito cerrado y su dirección IP. Si omite la interfaz de circuito cerrado y la dirección IP asociada, no se podrán procesar los paquetes de control EVPN.

set routing-instances JNPR_1_VRF protocols evpn ip-prefix-routes advertise direct-nexthop set routing-instances JNPR_1_VRF protocols evpn ip-prefix-routes encapsulation vxlan set routing-instances JNPR_1_VRF protocols evpn ip-prefix-routes vni 1101 set routing-instances JNPR_1_VRF protocols evpn ip-prefix-routes export T5_EXPORT set routing-instances JNPR_2_VRF protocols evpn ip-prefix-routes advertise direct-nexthop set routing-instances JNPR_2_VRF protocols evpn ip-prefix-routes encapsulation vxlan set routing-instances JNPR_2_VRF protocols evpn ip-prefix-routes vni 1102 set routing-instances JNPR_2_VRF protocols evpn ip-prefix-routes export T5_EXPORT set interfaces lo0 unit 1 description "Tenant 1 T5 Loopback" set interfaces lo0 unit 1 family inet address 192.168.255.21/32 set routing-instances JNPR_1_VRF interface lo0.1 set interfaces lo0 unit 2 description "Tenant 2 T5 Loopback" set interfaces lo0 unit 2 family inet address 192.168.255.22/32 set routing-instances JNPR_2_VRF interface lo0.2 set policy-options policy-statement T5_EXPORT term 1 from protocol direct set policy-options policy-statement T5_EXPORT term 1 then accept set policy-options policy-statement T5_EXPORT term 2 from protocol bgp set policy-options policy-statement T5_EXPORT term 2 then accept

Configurar Spine 2

Procedimiento paso a paso

Configure las opciones de enrutamiento y reenvío.

Nota:Cambiar las opciones de enrutamiento y reenvío como

next-hop,overlay-ecmpochained-composite-next-hophace que el motor de reenvío de paquetes se reinicie, lo que interrumpe todas las operaciones de reenvío.set forwarding-options vxlan-routing next-hop 32768 set forwarding-options vxlan-routing overlay-ecmp set routing-options forwarding-table chained-composite-next-hop ingress evpn set routing-options router-id 192.168.255.12

Configure IRB.

set interfaces irb unit 201 virtual-gateway-accept-data set interfaces irb unit 201 description "** L3 interface for VLAN-201 in jnpr_1" set interfaces irb unit 201 family inet address 192.168.201.2/24 virtual-gateway-address 192.168.201.1 set interfaces irb unit 201 family inet address 192.168.201.2/24 preferred set interfaces irb unit 201 virtual-gateway-v4-mac 3c:8c:93:2e:20:01 set vlans VLAN-201 l3-interface irb.201 set interfaces irb unit 202 virtual-gateway-accept-data set interfaces irb unit 202 description "** L3 interface for VLAN-202 in jnpr_1" set interfaces irb unit 202 family inet address 192.168.202.2/24 virtual-gateway-address 192.168.202.1 set interfaces irb unit 202 family inet address 192.168.202.2/24 preferred set interfaces irb unit 202 virtual-gateway-v4-mac 3c:8c:93:2e:20:02 set vlans VLAN-202 l3-interface irb.202 set interfaces irb unit 211 virtual-gateway-accept-data set interfaces irb unit 211 description "** L3 interface for VLAN-211 in jnpr_2" set interfaces irb unit 211 family inet address 192.168.211.2/24 virtual-gateway-address 192.168.211.1 set interfaces irb unit 211 family inet address 192.168.211.2/24 preferred set interfaces irb unit 211 virtual-gateway-v4-mac 3c:8c:93:2e:21:11 set vlans VLAN-211 l3-interface irb.211 set interfaces irb unit 212 virtual-gateway-accept-data set interfaces irb unit 212 description "** L3 interface for VLAN-212 in jnpr_2" set interfaces irb unit 212 family inet address 192.168.212.2/24 virtual-gateway-address 192.168.212.1 set interfaces irb unit 212 family inet address 192.168.212.2/24 preferred set interfaces irb unit 212 virtual-gateway-v4-mac 3c:8c:93:2e:21:12 set vlans VLAN-212 l3-interface irb.212

Dado que ha configurado las mismas direcciones IP y MAC IRB anycast en las interfaces IRB de ambos conmutadores spine, desactive la publicidad de las interfaces IRB a otros dispositivos.

set protocols evpn default-gateway do-not-advertise

Coloque los IRB que pertenecen a los diferentes inquilinos en sus respectivas instancias de enrutamiento.

set routing-instances JNPR_1_VRF description "VRF for tenant jnpr_1" set routing-instances JNPR_1_VRF instance-type vrf set routing-instances JNPR_1_VRF interface irb.201 set routing-instances JNPR_1_VRF interface irb.202 set routing-instances JNPR_1_VRF vrf-table-label set routing-instances JNPR_1_VRF routing-options multipath set routing-instances JNPR_2_VRF description "VRF for tenant jnpr_2" set routing-instances JNPR_2_VRF instance-type vrf set routing-instances JNPR_2_VRF interface irb.211 set routing-instances JNPR_2_VRF interface irb.212 set routing-instances JNPR_2_VRF vrf-table-label set routing-instances JNPR_2_VRF routing-options multipath

Configure VNI de tipo 5 para las instancias de enrutamiento.

set routing-instances JNPR_1_VRF protocols evpn ip-prefix-routes advertise direct-nexthop set routing-instances JNPR_1_VRF protocols evpn ip-prefix-routes encapsulation vxlan set routing-instances JNPR_1_VRF protocols evpn ip-prefix-routes vni 1101 set routing-instances JNPR_1_VRF protocols evpn ip-prefix-routes export T5_EXPORT set routing-instances JNPR_2_VRF protocols evpn ip-prefix-routes advertise direct-nexthop set routing-instances JNPR_2_VRF protocols evpn ip-prefix-routes encapsulation vxlan set routing-instances JNPR_2_VRF protocols evpn ip-prefix-routes vni 1102 set routing-instances JNPR_2_VRF protocols evpn ip-prefix-routes export T5_EXPORT set interfaces lo0 unit 101 description "Tenant 1 T5 Loopback" set interfaces lo0 unit 101 family inet address 192.168.255.31/32 set routing-instances JNPR_1_VRF interface lo0.101 set interfaces lo0 unit 102 description "Tenant 2 T5 Loopback" set interfaces lo0 unit 102 family inet address 192.168.255.32/32 set routing-instances JNPR_2_VRF interface lo0.102 set policy-options policy-statement T5_EXPORT term 1 from protocol direct set policy-options policy-statement T5_EXPORT term 1 then accept set policy-options policy-statement T5_EXPORT term 2 from protocol bgp set policy-options policy-statement T5_EXPORT term 2 then accept

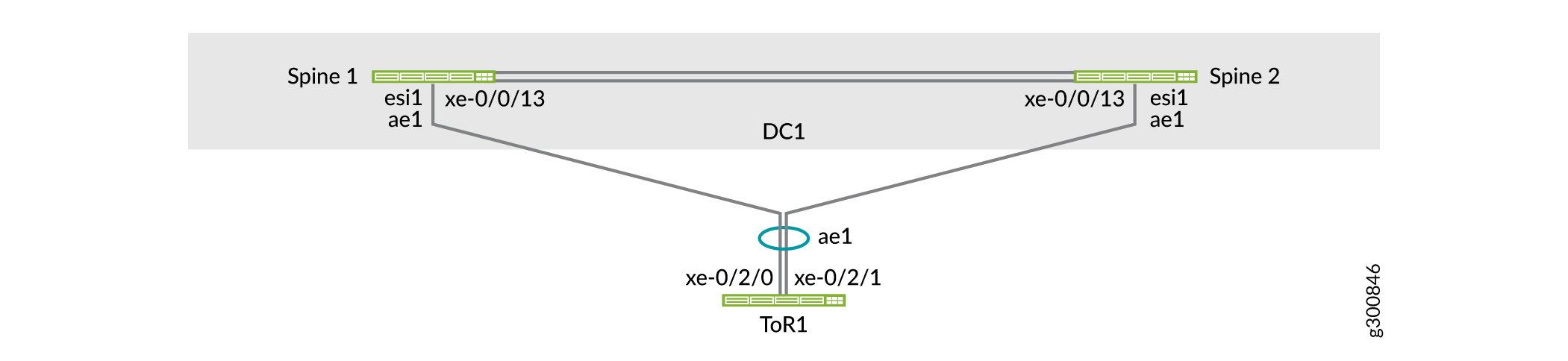

Configurar la multiconexión de EVPN para los conmutadores ToR

La multiconexión de EVPN utiliza ESI. Un ESI es un atributo obligatorio que habilita la multiconexión del servidor LAG de EVPN. Los valores ESI se codifican como enteros de 10 bytes y se utilizan para identificar un segmento de host múltiple. El mismo valor ESI habilitado en todos los conmutadores spine conectados a un conmutador ToR forma un LAG EVPN. Este LAG de EVPN admite la multiconexión activa-activa hacia el conmutador ToR.

Los conmutadores ToR (implementados como ToR Virtual Chassis en este ejemplo) utilizan un LAG para conectarse a los dos conmutadores spine. Como se muestra en la figura 4, ToR1 está conectado a los conmutadores de la columna vertebral con LAG ae1. Este LAG en los conmutadores spine está habilitado por la función de multiconexión de EVPN.

Configurar Spine 1

Procedimiento paso a paso

De forma predeterminada, no se crean interfaces Ethernet agregadas. Debe establecer el número de interfaces Ethernet agregadas en el conmutador antes de poder configurarlas.

set chassis aggregated-devices ethernet device-count 15 set interfaces ae1 description "to ToR1" set interfaces ae1 mtu 9216

Configure una ESI. Configúrelo igual en ambos interruptores de columna vertebral. Habilite todos los modos activos.

set interfaces ae1 esi 00:00:00:00:00:00:00:00:01:01 set interfaces ae1 esi all-active set interfaces ae1 aggregated-ether-options link-speed 10g set interfaces ae1 aggregated-ether-options lacp active set interfaces ae1 aggregated-ether-options lacp periodic fast

Nota:También puede derivar ESI automáticamente. En este ejemplo, se configura ESI manualmente.

Configure el ID de sistema LACP. Establézcalo igual en ambos conmutadores de spine para indicar a los conmutadores de ToR que los enlaces ascendentes a los dos conmutadores de spine pertenecen al mismo paquete de LAG. Como resultado, los conmutadores ToR colocan los vínculos ascendentes a los dos conmutadores spine en el mismo paquete LAG y cargan el tráfico compartido entre los vínculos miembro.

set interfaces ae1 aggregated-ether-options lacp system-id 00:00:00:00:01:01 set interfaces ae1 unit 0 family ethernet-switching interface-mode trunk set interfaces ae1 unit 0 family ethernet-switching vlan members VLAN-201 set interfaces ae1 unit 0 family ethernet-switching vlan members VLAN-202 set interfaces ae1 unit 0 family ethernet-switching vlan members VLAN-211 set interfaces ae1 unit 0 family ethernet-switching vlan members VLAN-212

Configure la interfaz física en la spine 1 conectada a ToR 1 como miembro del LAG ae1.

set interfaces xe-0/0/13 ether-options 802.3ad ae1

Configurar Spine 2

Procedimiento paso a paso

Establezca el número de interfaces Ethernet agregadas en el conmutador.

set chassis aggregated-devices ethernet device-count 15 set interfaces ae1 description "to ToR1" set interfaces ae1 mtu 9216

Configure una ESI. Configúrelo igual en ambos interruptores de columna vertebral. Habilite todos los modos activos.

set interfaces ae1 esi 00:00:00:00:00:00:00:00:01:01 set interfaces ae1 esi all-active set interfaces ae1 aggregated-ether-options link-speed 10g set interfaces ae1 aggregated-ether-options lacp active set interfaces ae1 aggregated-ether-options lacp periodic fast

Configure el ID del sistema LACP. Configúrelo igual en ambos conmutadores de columna vertebral.

set interfaces ae1 aggregated-ether-options lacp system-id 00:00:00:00:01:01 set interfaces ae1 unit 0 family ethernet-switching interface-mode trunk set interfaces ae1 unit 0 family ethernet-switching vlan members VLAN-201 set interfaces ae1 unit 0 family ethernet-switching vlan members VLAN-202 set interfaces ae1 unit 0 family ethernet-switching vlan members VLAN-211 set interfaces ae1 unit 0 family ethernet-switching vlan members VLAN-212

Configure la interfaz física en la spine 2 conectada a ToR 1 como miembro del LAG ae1.

set interfaces xe-0/0/13 ether-options 802.3ad ae1

Configurar ToR 1

Procedimiento paso a paso

De forma predeterminada, no se crean interfaces Ethernet agregadas. Debe establecer el número de interfaces Ethernet agregadas en el conmutador antes de poder configurarlas.

set chassis aggregated-devices ethernet device-count 4

Configure las interfaces Ethernet agregadas.

set interfaces xe-0/2/0 ether-options 802.3ad ae1 set interfaces xe-0/2/1 ether-options 802.3ad ae1 set interfaces ae1 aggregated-ether-options lacp active set interfaces ae1 unit 0 family ethernet-switching interface-mode trunk set interfaces ae1 unit 0 family ethernet-switching vlan members VLAN-201 set interfaces ae1 unit 0 family ethernet-switching vlan members VLAN-202 set interfaces ae1 unit 0 family ethernet-switching vlan members VLAN-211 set interfaces ae1 unit 0 family ethernet-switching vlan members VLAN-212

Configure las VLAN.

set vlans VLAN-201 vlan-id 201 set vlans VLAN-202 vlan-id 202 set vlans VLAN-211 vlan-id 211 set vlans VLAN-212 vlan-id 212

Verificar multiconexión de EVPN

Procedimiento paso a paso

Compruebe el estado de ae1 y el ESI asociado al LAG.

user@spine1> show interfaces ae1 Physical interface: ae1, Enabled, Physical link is Up Interface index: 689, SNMP ifIndex: 552 Description: to ToR1 Link-level type: Ethernet, MTU: 9216, Speed: 10Gbps, BPDU Error: None, Ethernet-Switching Error: None, MAC-REWRITE Error: None, Loopback: Disabled, Source filtering: Disabled, Flow control: Disabled, Minimum links needed: 1, Minimum bandwidth needed: 1bps Device flags : Present Running Interface flags: SNMP-Traps Internal: 0x4000 Current address: 3c:8c:93:2e:a9:80, Hardware address: 3c:8c:93:2e:a9:80 Ethernet segment value: 00:00:00:00:00:00:00:00:01:01, Mode: all-active Last flapped : 2019-11-10 14:50:49 PST (00:26:56 ago) Input rate : 624 bps (0 pps) Output rate : 936 bps (1 pps) ...

Verifique que los miembros de ae1 estén recolectando y distribuyendo.

user@spine1> show lacp interfaces ae1 Aggregated interface: ae1 LACP state: Role Exp Def Dist Col Syn Aggr Timeout Activity xe-0/0/13 Actor No No Yes Yes Yes Yes Fast Active xe-0/0/13 Partner No No Yes Yes Yes Yes Fast Active LACP protocol: Receive State Transmit State Mux State xe-0/0/13 Current Fast periodic Collecting distributingCompruebe que el estado de la multiconexión de EVPN en la instancia de EVPN está

Resolveden la columna vertebral 1. También puede ver qué conmutador de columna vertebral es el reenviador designado para el tráfico de BUM.user@spine1> show evpn instance extensive Instance: __default_evpn__ Route Distinguisher: 192.168.255.13:0 Number of bridge domains: 0 Number of neighbors: 1 Address MAC MAC+IP AD IM ES Leaf-label 192.168.255.12 0 0 0 0 2 Instance: default-switch Route Distinguisher: 192.168.255.13:1 Encapsulation type: VXLAN Duplicate MAC detection threshold: 5 Duplicate MAC detection window: 180 MAC database status Local Remote MAC advertisements: 6 10 MAC+IP advertisements: 10 10 Default gateway MAC advertisements: 8 0 Number of local interfaces: 5 (3 up) Interface name ESI Mode Status AC-Role .local..6 00:00:00:00:00:00:00:00:00:00 single-homed Up Root ae1.0 00:00:00:00:00:00:00:00:01:01 all-active Up Root ... Number of neighbors: 1 Address MAC MAC+IP AD IM ES Leaf-label 192.168.255.12 10 10 8 4 0 Number of ethernet segments: 10 ESI: 00:00:00:00:00:00:00:00:01:01 Status: Resolved by IFL ae1.0 Local interface: ae1.0, Status: Up/Forwarding Number of remote PEs connected: 1 Remote PE MAC label Aliasing label Mode 192.168.255.12 5212 0 all-active DF Election Algorithm: MOD based Designated forwarder: 192.168.255.13 Backup forwarder: 192.168.255.12 Last designated forwarder update: Nov 10 14:50:49Compruebe que todos los vínculos de miembro de la interfaz ae1 se recopilan y distribuyen en ToR 1.

user@tor1> show lacp interfaces Aggregated interface: ae1 LACP state: Role Exp Def Dist Col Syn Aggr Timeout Activity xe-0/2/0 Actor No No Yes Yes Yes Yes Fast Active xe-0/2/0 Partner No No Yes Yes Yes Yes Fast Active xe-0/2/1 Actor No No Yes Yes Yes Yes Fast Active xe-0/2/1 Partner No No Yes Yes Yes Yes Fast Active LACP protocol: Receive State Transmit State Mux State xe-0/2/0 Current Fast periodic Collecting distributing xe-0/2/1 Current Fast periodic Collecting distributing

Configurar la multiconexión para los servidores

Multihome los servidores al chasis virtual ToR para redundancia y uso compartido de carga. Los servidores utilizan LAG para conectarse a los dos conmutadores miembro del chasis virtual ToR.

Como se muestra en la figura 5, el extremo 1 está conectado al chasis virtual de ToR a través de LAG ae5 y pertenece al inquilino JNPR_1. El punto de conexión 11 está conectado al chasis virtual ToR a través de LAG ae6 y pertenece al inquilino JNPR_2.

de servidor multihost

de servidor multihost

Configurar ToR 1

Procedimiento paso a paso

Dado que los conmutadores ToR se configuran en un Virtual Chassis, sólo tiene que confirmar la configuración en el conmutador principal. En este ejemplo, ToR 1 es el conmutador principal.

Configure LAG en las interfaces conectadas al punto de conexión 1: interfaz xe-0/2/10 en ToR 1 e interfaz xe-1/2/10 en ToR 2. El punto de conexión 1 pertenece a las VLAN 201 y 202.

set interfaces xe-0/2/10 ether-options 802.3ad ae5 set interfaces xe-1/2/10 ether-options 802.3ad ae5 set interfaces ae5 aggregated-ether-options lacp active set interfaces ae5 description "Connected to Endpoint1" set interfaces ae5 unit 0 family ethernet-switching interface-mode trunk set interfaces ae5 unit 0 family ethernet-switching vlan members VLAN-201 set interfaces ae5 unit 0 family ethernet-switching vlan members VLAN-202

Configure LAG en las interfaces conectadas al punto de conexión 11. El punto de conexión 11 pertenece a las VLAN 211 y 212.

set interfaces xe-0/2/11 ether-options 802.3ad ae6 set interfaces xe-1/2/11 ether-options 802.3ad ae6 set interfaces ae6 aggregated-ether-options lacp active set interfaces ae6 description "Connected to Endpoint11" set interfaces ae6 unit 0 family ethernet-switching interface-mode trunk set interfaces ae6 unit 0 family ethernet-switching vlan members VLAN-211 set interfaces ae6 unit 0 family ethernet-switching vlan members VLAN-212

Comprobar la conectividad del servidor

Utilice esta sección para comprobar que los servidores están conectados entre sí a través de los conmutadores ToR y spine. La forma de hacerlo depende de si forman parte de la misma VLAN o de dos VLAN diferentes.

Se recomienda multiconexión de los servidores a los conmutadores ToR para obtener redundancia y uso compartido de carga, tal como se describe en la sección anterior. En esta sección se muestran los servidores de base única para simplificar.

- Verificar la conectividad del servidor dentro de VLAN

- Verificar la conectividad del servidor entre VLAN

- ¿Qué sigue?

Verificar la conectividad del servidor dentro de VLAN

Procedimiento paso a paso

Compruebe que las direcciones MAC de ambos puntos de conexión aparecen en la tabla de conmutación Ethernet de ambos conmutadores ToR.

user@tor1> show ethernet-switching table MAC flags (S - static MAC, D - dynamic MAC, L - locally learned, P - Persistent static, C - Control MAC SE - statistics enabled, NM - non configured MAC, R - remote PE MAC, O - ovsdb MAC) Ethernet switching table : 4 entries, 4 learned Routing instance : default-switch Vlan MAC MAC Age Logical NH RTR name address flags interface Index ID VLAN-201 f4:b5:2f:40:9f:01 D - ae1.0 0 0 VLAN-202 00:10:94:00:01:01 D - xe-0/2/2.0 0 0 VLAN-202 00:10:94:00:01:02 D - ae1.0 0 0 VLAN-202 3c:8c:93:2e:a8:c0 D - ae1.0 0 0user@tor2> show ethernet-switching table MAC flags (S - static MAC, D - dynamic MAC, L - locally learned, P - Persistent static, C - Control MAC SE - statistics enabled, NM - non configured MAC, R - remote PE MAC, O - ovsdb MAC) Ethernet switching table : 4 entries, 4 learned Routing instance : default-switch Vlan MAC MAC Age Logical NH RTR name address flags interface Index ID VLAN-201 f4:b5:2f:40:9f:01 D - ae1.0 0 0 VLAN-202 00:10:94:00:01:01 D - xe-0/2/2.0 0 0 VLAN-202 00:10:94:00:01:02 D - ae1.0 0 0 VLAN-202 3c:8c:93:2e:a8:c0 D - ae1.0 0 0Verifique que las dos direcciones MAC aparezcan en la tabla Conmutación Ethernet de ambos conmutadores spine. Las dos direcciones MAC se aprenden de los conmutadores ToR a través del LAG (ae1 y ae2) conectado a cada conmutador ToR. Los indicadores MAC , e

DLRindican si el tráfico deDLDRla dirección MAC fue aprendido localmente por el conmutador spine, por el conmutador spine remoto o por ambos conmutadores spine.user@spine1> show ethernet-switching table vlan-id 202 MAC flags (S - static MAC, D - dynamic MAC, L - locally learned, P - Persistent static SE - statistics enabled, NM - non configured MAC, R - remote PE MAC, O - ovsdb MAC) Ethernet switching table : 4 entries, 4 learned Routing instance : default-switch Vlan MAC MAC Logical Active name address flags interface source VLAN-202 00:00:5e:00:01:01 DR esi.1723 05:00:00:fe:4c:00:00:14:52:00 VLAN-202 00:10:94:00:01:01 DR ae1.0 VLAN-202 00:10:94:00:01:02 DL ae2.0 VLAN-202 3c:8c:93:2e:da:c0 D vtep.32769 192.168.255.12user@spine2> show ethernet-switching table vlan-id 202 MAC flags (S - static MAC, D - dynamic MAC, L - locally learned, P - Persistent static SE - statistics enabled, NM - non configured MAC, R - remote PE MAC, O - ovsdb MAC) Ethernet switching table : 4 entries, 4 learned Routing instance : default-switch Vlan MAC MAC Logical Active name address flags interface source VLAN-202 00:00:5e:00:01:01 DR esi.1723 05:00:00:fe:4c:00:00:14:52:00 VLAN-202 00:10:94:00:01:01 DR ae1.0 VLAN-202 00:10:94:00:01:02 DL ae2.0 VLAN-202 3c:8c:93:2e:da:c0 D vtep.32769 192.168.255.12Verifique que la primera dirección MAC esté en la base de datos de EVPN en Spine 1. Este resultado indica que la dirección MAC fue aprendida localmente por este conmutador spine a través del ESI 00:00:00:00:00:00:00:01:02 y LAG ae2. Esta dirección MAC se anuncia en EVPN al otro conmutador spine.

user@spine1> show evpn database mac-address 00:10:94:00:01:02 extensive Instance: default-switch VN Identifier: 5202, MAC address: 00:10:94:00:01:02 State: 0x0 Source: 00:00:00:00:00:00:00:00:01:02, Rank: 1, Status: Active Local origin: ae2.0 Mobility sequence number: 0 (minimum origin address 192.168.255.13) Timestamp: Nov 10 16:48:41 (0x5dc8afe9) State: <Local-MAC-Only Local-To-Remote-Adv-Allowed> MAC advertisement route status: Created History db: Time Event Nov 10 16:48:41 2019 Updating output state (change flags 0x20 <ESI-Added>) Nov 10 16:48:41 2019 Active ESI changing (not assigned -> 00:00:00:00:00:00:00:00:01:02) Nov 10 16:48:41 2019 Creating all output state Nov 10 16:48:41 2019 Creating MAC advertisement route Nov 10 16:48:41 2019 Adding to instance ESI list Nov 10 16:48:41 2019 Clearing change flags <ESI-Added> Nov 10 16:48:41 2019 Clearing change flags <Intf ESI-Local-State> Nov 10 16:48:42 2019 Updating output state (change flags 0x0) Nov 10 16:48:42 2019 Active ESI unchanged (00:00:00:00:00:00:00:00:01:02) Nov 10 16:48:42 2019 Updating output state (change flags 0x0)Verifique que la segunda dirección MAC esté en la base de datos EVPN en Spine 1. Esta dirección MAC fue aprendida por el conmutador remoto de spine y se anunció al conmutador spine local a través de EVPN. Esta salida también muestra que esta dirección MAC está asignada a ESI 00:00:00:00:00:00:00:00:01:01. El tráfico destinado a esta dirección MAC se puede cambiar localmente a ToR 1 utilizando el mismo segmento Ethernet.

user@spine1> show evpn database mac-address 00:10:94:00:01:01 extensive Instance: default-switch VN Identifier: 5202, MAC address: 00:10:94:00:01:01 State: 0x0 Source: 00:00:00:00:00:00:00:00:01:01, Rank: 1, Status: Active Remote origin: 192.168.255.12 Mobility sequence number: 0 (minimum origin address 192.168.255.12) Timestamp: Nov 10 16:48:41 (0x5dc8afe9) State: <Remote-To-Local-Adv-Done> MAC advertisement route status: Not created (no local state present) History db: Time Event Nov 10 16:48:41 2019 Adding to instance ESI list Nov 10 16:48:41 2019 Clearing change flags <ESI-Added> Nov 10 16:48:41 2019 Clearing change flags <ESI-Peer-Added ESI-Remote-Peer-Com-Chg> Nov 10 16:48:42 2019 Updating output state (change flags 0x0) Nov 10 16:48:42 2019 Active ESI unchanged (00:00:00:00:00:00:00:00:01:01) Nov 10 16:48:42 2019 Updating output state (change flags 0x0) Nov 10 16:48:42 2019 Advertisement route cannot be created (no local state present) Nov 10 16:48:42 2019 ESI 00:00:00:00:00:00:00:00:01:01, peer 192.168.255.12 per-ES AD route not rcvd, remote peer found Nov 10 16:48:42 2019 Sent MAC add with NH 0, interface ae1.0 (index 0), RTT 6, remote addr 192.168.255.12, ESI 0101, VLAN 0, VNI 5202, flags 0x0, timestamp 0x5dc8afe9 to L2ALD Nov 10 16:48:42 2019 Sent peer 192.168.255.12 record createdVerifique las rutas de EVPN en Spine 1. Este resultado muestra que los conmutadores spine anuncian estas direcciones MAC como rutas BGP.

user@spine1> show route table bgp.evpn.0 evpn-mac-address 00:10:94:00:01:01 bgp.evpn.0: 75 destinations, 75 routes (75 active, 0 holddown, 0 hidden) Restart Complete + = Active Route, - = Last Active, * = Both 2:192.168.255.13:1::5202::00:10:94:00:01:01/304 MAC/IP *[EVPN/170] 00:01:52 Indirect user@spine1> show route table bgp.evpn.0 evpn-mac-address 00:10:94:00:01:02 bgp.evpn.0: 75 destinations, 75 routes (75 active, 0 holddown, 0 hidden) Restart Complete + = Active Route, - = Last Active, * = Both 2:192.168.255.13:1::5202::00:10:94:00:01:02/304 MAC/IP *[EVPN/170] 00:02:02 IndirectVerifique las rutas de EVPN en Spine 2. Esta salida muestra las rutas BGP que recibieron el emparejamiento de IBGP con Spine 1. Veamos estas rutas en detalle.

user@spine2> show route receive-protocol bgp 192.168.255.13 inet.0: 13 destinations, 14 routes (13 active, 0 holddown, 0 hidden) Restart Complete JNPR_1_VRF.inet.0: 9 destinations, 11 routes (9 active, 0 holddown, 0 hidden) :vxlan.inet.0: 9 destinations, 9 routes (9 active, 0 holddown, 0 hidden) Restart Complete JNPR_2_VRF.inet.0: 9 destinations, 11 routes (9 active, 0 holddown, 0 hidden) mpls.0: 2 destinations, 2 routes (2 active, 0 holddown, 0 hidden) Restart Complete inet6.0: 1 destinations, 1 routes (1 active, 0 holddown, 0 hidden) Restart Complete JNPR_1_VRF.inet6.0: 1 destinations, 1 routes (1 active, 0 holddown, 0 hidden) JNPR_2_VRF.inet6.0: 1 destinations, 1 routes (1 active, 0 holddown, 0 hidden) bgp.evpn.0: 75 destinations, 75 routes (75 active, 0 holddown, 0 hidden) Restart Complete Prefix Nexthop MED Lclpref AS path 1:192.168.255.13:0::0101::FFFF:FFFF/192 AD/ESI * 192.168.255.13 100 I 1:192.168.255.13:0::0102::FFFF:FFFF/192 AD/ESI * 192.168.255.13 100 I ... 1:192.168.255.13:0::050000fe4c0000145c00::FFFF:FFFF/192 AD/ESI * 192.168.255.13 100 I 1:192.168.255.13:1::0101::0/192 AD/EVI * 192.168.255.13 100 I 1:192.168.255.13:1::0102::0/192 AD/EVI * 192.168.255.13 100 I ...

Las dos rutas de tipo 1 enfatizadas anteriormente muestran que Spine 1 está conectado a dos segmentos Ethernet (ES). Los números ESI son 0101 y 0102.

... 2:192.168.255.13:1::5202::00:00:5e:00:01:01/304 MAC/IP * 192.168.255.13 100 I 2:192.168.255.13:1::5202::00:10:94:00:01:01/304 MAC/IP * 192.168.255.13 100 I 2:192.168.255.13:1::5202::00:10:94:00:01:02/304 MAC/IP * 192.168.255.13 100 I ...

Estas dos rutas son de tipo 2 que se muestran arriba anunciadas por Spine 1. Muestran que se puede acceder a las dos direcciones MAC desde Spine 1.

Verifique el plano de control para las siguientes direcciones MAC en Spine 1.

user@spine1> show route table bgp.evpn.0 evpn-mac-address 00:10:94:00:01:01 bgp.evpn.0: 78 destinations, 78 routes (78 active, 0 holddown, 0 hidden) Restart Complete + = Active Route, - = Last Active, * = Both 2:192.168.255.13:1::5202::00:10:94:00:01:01/304 MAC/IP *[EVPN/170] 00:11:49 Indirectuser@spine1> show route table bgp.evpn.0 evpn-mac-address 00:10:94:00:01:02 bgp.evpn.0: 78 destinations, 78 routes (78 active, 0 holddown, 0 hidden) Restart Complete + = Active Route, - = Last Active, * = Both 2:192.168.255.13:1::5202::00:10:94:00:01:02/304 MAC/IP *[EVPN/170] 00:11:52 IndirectVerifique las entradas de la tabla de reenvío para estas direcciones MAC en Spine 1. El siguiente resultado muestra que la interfaz Ethernet agregada local se utiliza para conmutar el tráfico destinado a estas direcciones MAC.

user@spine1> show route forwarding-table destination 00:10:94:00:01:01 Routing table: default-switch.bridge Bridging domain: VLAN-202.bridge VPLS: Enabled protocols: Bridging, ACKed by all peers, Destination Type RtRef Next hop Type Index NhRef Netif 00:10:94:00:01:01/48 user 0 ucst 1710 7 ae1.0

user@spine1> show route forwarding-table destination 00:10:94:00:01:02 Routing table: default-switch.bridge Bridging domain: VLAN-202.bridge VPLS: Enabled protocols: Bridging, ACKed by all peers, Destination Type RtRef Next hop Type Index NhRef Netif 00:10:94:00:01:02/48 user 0 ucst 1754 9 ae2.0

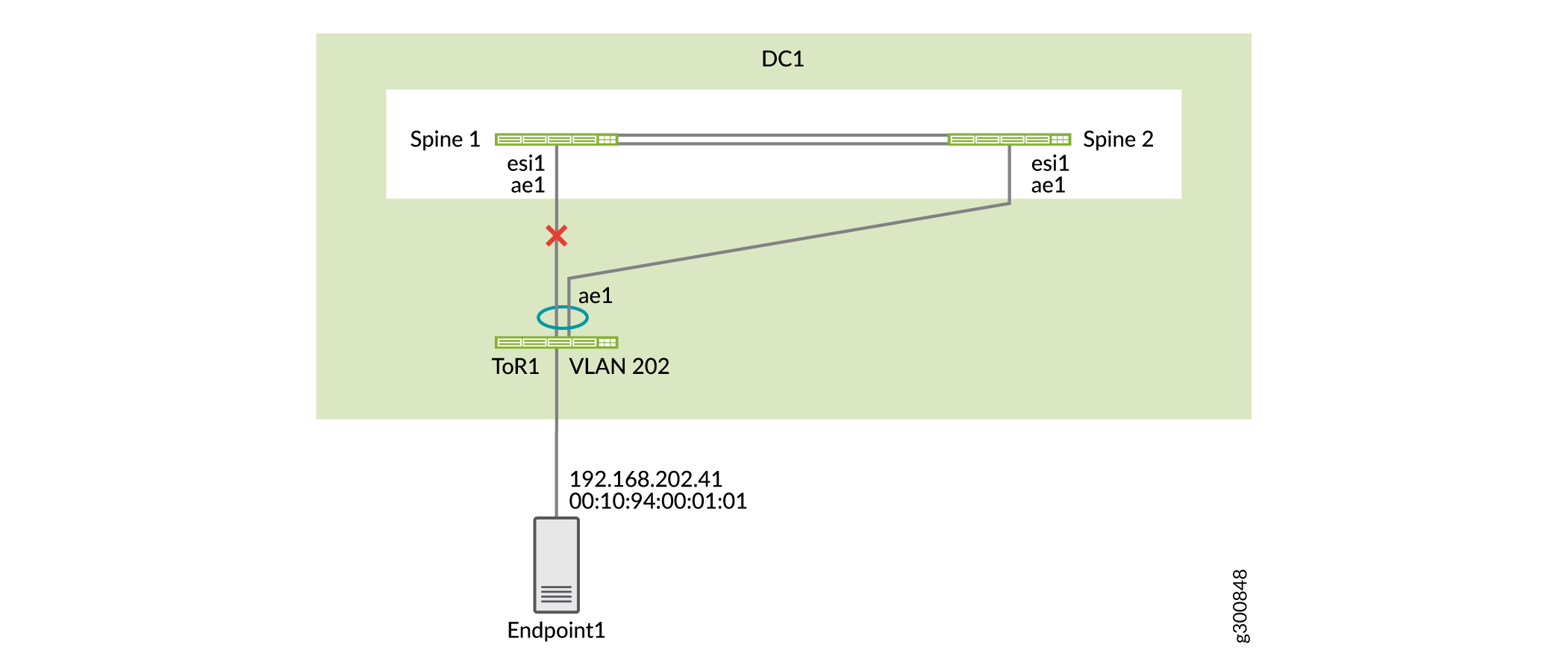

Pruebe lo que sucede cuando falla un enlace ascendente. Si se produce un error en un vínculo ascendente de ToR 1, el resultado muestra que el estado de esa interfaz es

Detached.user@spine1> show lacp interfaces ae1 Aggregated interface: ae1 LACP state: Role Exp Def Dist Col Syn Aggr Timeout Activity xe-0/0/13 Actor No Yes No No No Yes Fast Active xe-0/0/13 Partner No Yes No No No Yes Fast Passive LACP protocol: Receive State Transmit State Mux State xe-0/0/13 Port disabled No periodic DetachedLa figura 6 muestra la topología cuando la interfaz conectada a ToR 1 en la spine 1 está inactiva.

Figura 6: Topología cuando falla el enlace ascendente

el enlace ascendente

Verifique que Spine 1 esté aprendiendo esta dirección MAC de Spine 2, ya que Spine 1 no tiene una conexión directa a ToR 1.

user@spine1> show route table bgp.evpn.0 evpn-mac-address 00:10:94:00:01:01 bgp.evpn.0: 76 destinations, 76 routes (76 active, 0 holddown, 0 hidden) Restart Complete + = Active Route, - = Last Active, * = Both 2:192.168.255.12:1::5202::00:10:94:00:01:01/304 MAC/IP *[BGP/170] 00:01:05, localpref 100, from 192.168.255.12 AS path: I, validation-state: unverified to 192.168.100.4 via et-0/0/50.0 > to 192.168.100.6 via et-0/0/51.0Los detalles de la tabla de reenvío en Spine 1 muestran que el tráfico destinado a esta dirección MAC se envía a Spine 2.

user@spine1> show route forwarding-table destination 00:10:94:00:01:01 extensive Routing table: default-switch.bridge [Index 6] Bridging domain: VLAN-202.bridge [Index 6] VPLS: Enabled protocols: Bridging, ACKed by all peers, Destination: 00:10:94:00:01:01/48 Learn VLAN: 0 Route type: user Route reference: 0 Route interface-index: 560 Multicast RPF nh index: 0 P2mpidx: 0 IFL generation: 514 Epoch: 0 Sequence Number: 0 Learn Mask: 0x4000000000000000010000000000000000000000 L2 Flags: control_dyn Flags: sent to PFE Nexthop: Next-hop type: composite Index: 1724 Reference: 26 Next-hop type: indirect Index: 524289 Reference: 3 Next-hop type: unilist Index: 524288 Reference: 6 Nexthop: 192.168.100.4 Next-hop type: unicast Index: 1708 Reference: 4 Next-hop interface: et-0/0/50.0 Weight: 0x0 Nexthop: 192.168.100.6 Next-hop type: unicast Index: 1709 Reference: 4 Next-hop interface: et-0/0/51.0 Weight: 0x0

Verificar la conectividad del servidor entre VLAN

Procedimiento paso a paso

En Spine 1, verifique que las dos direcciones MAC estén en VLAN diferentes.

user@spine1> show ethernet-switching table | match 00:10:94:00:11:11 VLAN-201 00:10:94:00:11:11 DLR ae1.0

user@spine1> show ethernet-switching table | match 00:10:94:00:01:02 VLAN-202 00:10:94:00:01:02 DL ae2.0

En la columna vertebral 1, compruebe la resolución ARP de los dos extremos.

user@spine1> show arp no-resolve | match 00:10:94:00:11:11 00:10:94:00:11:11 192.168.201.41 irb.201 [ae1.0] permanent remote

user@spine1> show arp no-resolve | match 00:10:94:00:01:02 00:10:94:00:01:02 192.168.202.42 irb.202 [ae2.0] permanent remote

En Spine 1, compruebe el aprendizaje del plano de control para la dirección MAC 00:10:94:00:11:11. Puede ver que hay una ruta MAC para la dirección MAC y una ruta MAC/IP para esta dirección MAC.

user@spine1> show route table bgp.evpn.0 evpn-mac-address 00:10:94:00:11:11 bgp.evpn.0: 82 destinations, 82 routes (82 active, 0 holddown, 0 hidden) Restart Complete + = Active Route, - = Last Active, * = Both 2:192.168.255.12:1::5201::00:10:94:00:11:11/304 MAC/IP *[BGP/170] 00:08:43, localpref 100, from 192.168.255.12 AS path: I, validation-state: unverified to 192.168.100.4 via et-0/0/50.0 > to 192.168.100.6 via et-0/0/51.0 2:192.168.255.13:1::5201::00:10:94:00:11:11/304 MAC/IP *[EVPN/170] 00:09:01 Indirect 2:192.168.255.12:1::5201::00:10:94:00:11:11::192.168.201.41/304 MAC/IP *[BGP/170] 00:08:43, localpref 100, from 192.168.255.12 AS path: I, validation-state: unverified to 192.168.100.4 via et-0/0/50.0 > to 192.168.100.6 via et-0/0/51.0 2:192.168.255.13:1::5201::00:10:94:00:11:11::192.168.201.41/304 MAC/IP *[EVPN/170] 00:09:01 IndirectCompruebe las entradas de la tabla de reenvío para estas direcciones MAC. Dado que Spine 1 está conectado a ambos conmutadores ToR localmente, el tráfico se conmuta localmente al conmutador ToR correspondiente desde Spine 1.

user@spine1> show route forwarding-table destination 00:10:94:00:11:11 Routing table: default-switch.bridge Bridging domain: VLAN-201.bridge VPLS: Enabled protocols: Bridging, ACKed by all peers, Destination Type RtRef Next hop Type Index NhRef Netif 00:10:94:00:11:11/48 user 0 ucst 1710 8 ae1.0

user@spine1> show route forwarding-table destination 00:10:94:00:01:02 Routing table: default-switch.bridge Bridging domain: VLAN-202.bridge VPLS: Enabled protocols: Bridging, ACKed by all peers, Destination Type RtRef Next hop Type Index NhRef Netif 00:10:94:00:01:02/48 user 0 ucst 1754 10 ae2.0

¿Qué sigue?

Ha configurado y verificado una arquitectura de spine colapsada para su primer centro de datos. Si es necesario, repita la configuración en los dispositivos del segundo centro de datos.

Vaya a la página siguiente para configurar la seguridad avanzada y conectar sus centros de datos.

Estado de cerebro dividido

Cómo prevenir un estado de cerebro dividido

Problema

Si los vínculos entre los conmutadores de columna vertebral no funcionan, lo que provoca que el emparejamiento BGP deje de funcionar, ambos conmutadores de columna vertebral están activos y reenviando. Las interfaces Ethernet agregadas descendentes están activas y reenviando. Este escenario se conoce como un estado de cerebro dividido y puede causar múltiples problemas.

Solución

Para evitar que se produzca este problema, elija un conmutador de columna vertebral para que sea el interruptor de espera.

También recomendamos:

-

Usar al menos dos enlaces entre los interruptores de la columna vertebral. Esto hace que sea menos probable que todos los enlaces entre los interruptores de la columna vertebral se caigan.

-

Multiconexión de todos los servidores. Si hay un servidor de base única en uno de los conmutadores spine, es posible que no se pueda acceder al servidor.

¿Qué sigue?

Ha configurado y verificado una arquitectura de spine colapsada para su primer centro de datos. Si es necesario, repita la configuración en los dispositivos del segundo centro de datos.

Vaya a la página siguiente para configurar la seguridad avanzada y conectar sus centros de datos.