Ejemplo: Configuración de la propagación TTL de MPLS para LSP con señal LDP

Descripción general

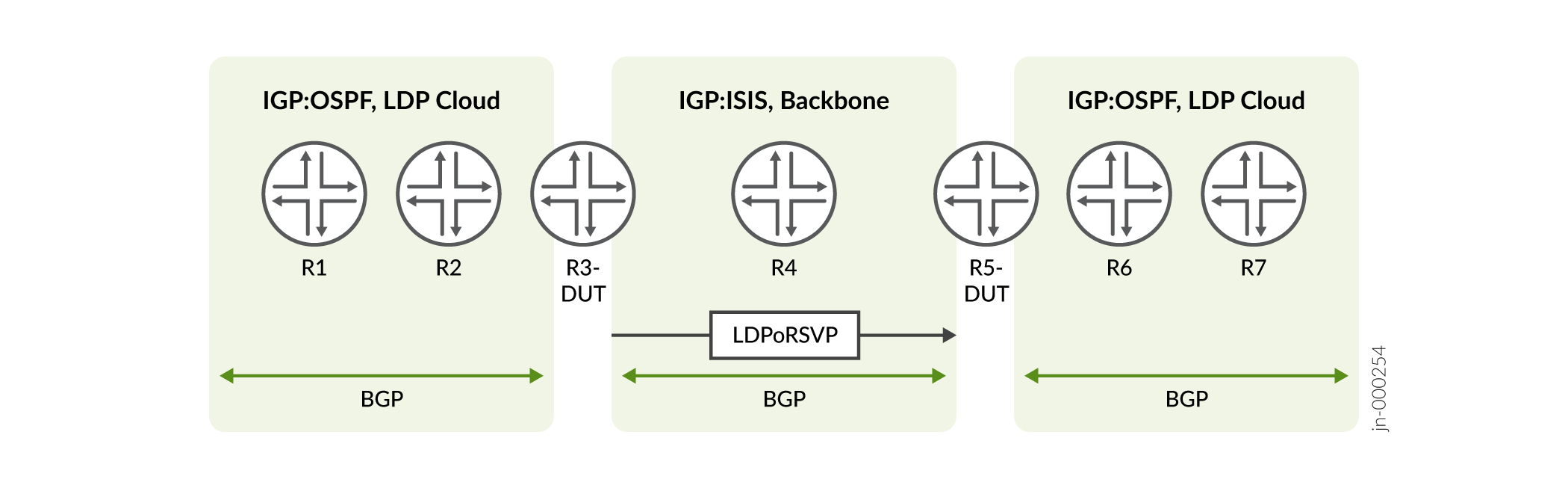

La siguiente figura muestra un escenario típico en el que la no-propagate-ttl instrucción en la [edit protocol ldp] jerarquía es beneficiosa.

Topología

En la figura, puede ver dos nubes LDP nativas conectadas por una red troncal con LDPoRSVP.

- Desde el enrutador R1, los paquetes se encapsulan con la etiqueta LDP y se envían al R7 de destino.

- En el enrutador R3, la etiqueta LDP de un paquete se elimina a un paquete IP. Luego, el paquete se encapsula con LDP a través de RSVP (LDPoRSVP) y se envía a través de la red troncal.

- En el enrutador R5, las etiquetas LDPoRSVP se despojan a un paquete IP, luego el paquete se encapsula nuevamente en la etiqueta LDP y se envía al destino.

Propósito

El propósito es hacer las siguientes acciones:

- Ocultar las dos nubes LDP sin propagación TTL

- Mostrar la red troncal (LDPoRSVP)

Cuando se envía un paquete del enrutador R1 al enrutador R7, estas acciones deben realizarse en dos enrutadores, R1 y R5. Esto no se puede lograr con las opciones existentes. Por ejemplo, cuando se utiliza la opción global (set protocol mpls no-propagate-ttl) en el enrutador R5, se desactiva la red troncal LDPoRSVP de propagación TTL en la dirección inversa (R7-R1). Esto sucede porque la opción es aplicable tanto para LDP como para RSVP.

Caso de uso para el comportamiento TTL sin propagación y TTL de propagación en LDP

LDP en el enrutador R3 debe admitir tanto el comportamiento de TTL sin propagación como el comportamiento de TTL de propagación.

Desde el enrutador R3 con LDPoRSVP, en la dirección R4, el enrutador debe admitir el comportamiento TTL de propagación. Sin embargo, hacia el LDP nativo (enrutador R2), el LDP debe admitir el comportamiento TTL de no propagación.

Para lograr este resultado, hemos introducido una nueva opción, bajo LDP, no-propagate-ttl que debe configurar para el enrutador R3 y el enrutador R5. Esta opción deshabilita la propagación de TTL para rutas LDP.

En el caso de un LDPoRSVP, el comportamiento de propagación depende de la opción TTL (no-decrement-ttl) sin disminución de RSVP.

- Si configura la

no-propagate-ttlopción en el escenario LDPoRSVP y no está configurado el TTL (no-decrement-ttl) sin decremento, se produce la propagación de TTL.Veamos algunos ejemplos:

En el enrutador R3, en el caso del escenario LDPoRSVP, si establece la siguiente configuración, se produce la propagación TTL.

user@host> set protocol ldp no-propagate-ttl

- Si configura la

no-decrement-ttlopción sobre el LSP entre el enrutador R3 y el enrutador R5, la propagación TTL se desactiva.Por ejemplo, en el enrutador R3:

user@host> set protocol ldp no-propagate-ttl user@host> set protocol mpls no-decrement-ttl

En el enrutador R1, los paquetes se encapsulan con la etiqueta LDP con TTL 255, ya que se configura cualquiera de las no-propagate-ttl CLI.

En el enrutador R3:

- La etiqueta LDP de un paquete se elimina a un encabezado IP y el TTL no se copia de la etiqueta LDP al encabezado IP.

- El paquete se encapsula con etiquetas LDPoRSVP y se envía a través de la red troncal.

- La nueva opción

ldp no-propagate-ttlconno-decrement-tlldecide si el TTL debe propagarse o no. - La

no-decrement-ttlopción no está configurada, por lo que se produce la propagación TTL habitual

En el enrutador R5, las etiquetas LDPoRSVP se eliminan al encabezado IP. La nueva opción está configurada para admitir no-propagate-ttl el protocolo LDP, y el paquete IP se encapsula con una etiqueta LDP con TTL 255 y se envía.

Configuración

Configuración rápida de CLI

Para configurar rápidamente este ejemplo, copie los siguientes comandos, péguelos en un archivo de texto, elimine los saltos de línea, cambie los detalles necesarios para que coincidan con su configuración de red y, luego, copie y pegue los comandos en la CLI en el nivel de jerarquía [edit].

set protocol ldp no-propagate-ttl

Resultados

Hemos modificado la salida del comando show ldp overview CLI para mostrar la configuración TTL.

Compruebe los resultados de la configuración:

user@host> show ldp overview Instance: master Reference count: 4 Router ID: 10.1.1.1 Inet LSR ID: 10.1.1.4 Inet6 LSR ID: 10.1.1.6 LDP inet: enabled LDP inet6: enabled Transport preference: Single-stack Message id: 21 Configuration sequence: 1 Deaggregate: disabled Explicit null: disabled IPv6 tunneling: disabled Strict targeted hellos: disabled Loopback if added: yes Route preference: 9 Unicast transit LSP chaining: disabled P2MP transit LSP chaining: disabled Transit LSP statistics based on route statistics: disabled LDP route acknowledgement: enabled BGP export: enabled No TTL propagate: enabled LDP mtu discovery: disabled LDP SR Mapping Client: disabled Capabilities enabled: none Egress FEC capabilities enabled: entropy-label-capability Downstream unsolicited Sessions: Operational: 2 Retention: liberal Control: ordered Auto targeted sessions: Auto targeted: disabled Dynamic tunnel session count: 0 P2MP: Recursive route: disabled No rsvp tunneling: disabled Timers: Keepalive interval: 10, Keepalive timeout: 30 Link hello interval: 5, Link hello hold time: 15 Targeted hello interval: 15, Targeted hello hold time: 45 Label withdraw delay: 60, Make before break timeout: 30 Make before break switchover delay: 3 Link protection timeout: 120 Graceful restart: Restart: enabled, Helper: enabled, Restart in process: false Reconnect time: 60000, Max neighbor reconnect time: 120000 Recovery time: 160000, Max neighbor recovery time: 240000 Traffic Engineering: Bgp igp: disabled Both ribs: disabled Mpls forwarding: disabled IGP: Tracking igp metric: disabled Sync session up delay: 10 Session protection: Session protection: disabled Session protection timeout: 0 Interface addresses advertising: 10.1.1.1 10.100.2.1 10.101.2.1 10.1.1.4 10.1.1.6 10.53.85.142 2001:db8:1000:1:2::1 2001:db8:1001:1:2::1 2001:db8:1111::1 2001:db8:abcd::128:53:85:142 fe80:1:2::1 fe80:1001:1002::1 LDP Job: Read job time quantum: 1000, Write job time quantum: 1000 Read job loop quantum: 100, Write job loop quantum: 100 Backup inbound read job time quantum: 1000, Backup outbound read job time quantum: 1000 Backup inbound read job loop quantum: 100, Backup outbound read job loop quantum: 100 Label allocation: Current number of LDP labels allocated: 4 Total number of LDP labels allocated: 7 Total number of LDP labels freed: 3 Total number of LDP label allocation failure: 0 Current number of labels allocated by all protocols: 4