AUF DIESER SEITE

Beispiel: Konfigurieren einer zentral gerouteten EVPN-VXLAN-Bridging-Fabric

Moderne Datencenter basieren auf einer IP-Fabric. Eine IP-Fabric verwendet BGP-basierte Ethernet VPN (EVPN)-Signale in der Steuerungsebene und Virtual Extensible LAN (VXLAN)-Kapselung in der Datenebene. Diese Technologie bietet eine standardbasierte, leistungsstarke Lösung für Layer 2 (L2)-Bridging innerhalb eines VLANs und für das Routing zwischen VLANs.

In den meisten Fällen besteht eine Eins-zu-Eins-Beziehung zwischen einem Benutzer-VLAN und einem VXLAN Network Identifier (VNI). Daher werden die Abkürzungen VLAN und VXLAN oft synonym verwendet. Standardmäßig entfernt die VXLAN-Kapselung alle eingehenden VLAN-Tags, wenn sie von einem Zugriffsport empfangen werden. Der Rest des Ethernet-Frames ist für den Transport über die Fabric in VXLAN gekapselt. Am Ausgangspunkt wird die VXLAN-Kapselung entfernt und das VLAN-Tag (falls vorhanden) wieder eingefügt, bevor der Frame an das angeschlossene Gerät gesendet wird.

Dies ist ein Beispiel für eine EVPN-VXLAN-IP-Fabric, die auf einer zentral gerouteten Bridging-Architektur (CRB) basiert. Integrierte Routing- und Bridging-Schnittstellen (IRB) bieten Layer-3-Konnektivität (L3) für Server und VMs, die zu verschiedenen VLANs und Netzwerken gehören. Diese IRB-Schnittstellen dienen als Standard-Gateway für den Datenverkehr zwischen VLANs innerhalb einer Fabric. Sie dienen auch als Ziele, die von der Fabric entfernt sind, wie z. B. im Fall von Data Center Interconnect (DCI). In einem CRB-Design definieren Sie die IRB-Schnittstellen nur auf den Spine-Geräten. Ein solches Design wird daher als zentral geroutet bezeichnet, da das gesamte Routing auf den Spines erfolgt.

Ein Beispiel für ein ERB-Design (Edge-Routed Bridging) finden Sie unter Beispiel: Konfigurieren einer EVPN-VXLAN-Edge-Routed-Bridging-Fabric mit einem Anycast-Gateway

Hintergrundinformationen zur EVPN-VXLAN-Technologie und den unterstützten Architekturen finden Sie unter EVPN-Einführung.

Anforderungen

Im ursprünglichen Beispiel wurden die folgenden Hardware- und Softwarekomponenten verwendet:

-

Zwei QFX10002 Switches (Spine 1 und Spine 2), auf denen die Software Junos OS Version 15.1X53-D30 ausgeführt wird.

-

Vier QFX5100-Switches (Leaf 1 bis Leaf 4) mit der Software Junos OS Version 14.1X53-D30.

-

Aktualisiert und erneut validiert mit Junos OS Version 20.4R1.

-

Eine Liste der unterstützten Plattformen finden Sie in der Hardwarezusammenfassung .

-

Übersicht

In diesem Beispiel benötigen physische Server, die drei Benutzergruppen (d. h. drei VLANs) unterstützen, die folgende Konnektivität:

- Server A und C sollten in der Lage sein, auf L2 zu kommunizieren. Diese Server müssen sich ein Subnetz und damit ein VLAN teilen.

- Server B und D müssen sich in separaten VLANs befinden, um die Übertragung zu isolieren. Diese Server müssen in der Lage sein, bei L3 zu kommunizieren.

- Server A und C sollten nicht in der Lage sein, mit den Servern B und D zu kommunizieren.

Um diese Konnektivitätsanforderungen zu erfüllen, werden die folgenden Protokolle und Technologien verwendet:

-

EVPN richtet eine virtuelle L2-Bridge ein, um die Server A und C zu verbinden, und platziert die Server B und D in ihren jeweiligen VLANs.

-

Innerhalb der EVPN-Topologie tauscht BGP Routeninformationen aus.

-

VXLAN tunnelt die L2-Frames durch die zugrunde liegende L3-Fabric. Durch die Verwendung der VXLAN-Kapselung bleibt die L3-Fabric für die Verwendung durch Routing-Protokolle erhalten.

-

IRB-Schnittstellen leiten IP-Pakete zwischen den VLANs weiter.

Auch hier werden die IRB-Schnittstellen nur auf den Spine-Geräten für Central Routing Bridging (CRB) konfiguriert. In diesem Design fungieren die Spine-Geräte als L3-Gateways für die verschiedenen Server, VMs oder containerisierten Workloads, die mit den Zugriffsports auf den Leaf-Switches verbunden sind. Wenn die Workloads Daten innerhalb ihrer eigenen VLANs austauschen, überbrückt das Leaf den Datenverkehr. Der resultierende VXLAN-gekapselte Datenverkehr wird dann als Underlay-Datenverkehr (IP) über die Spines gesendet. Für den VLAN-internen Datenverkehr wird die VXLAN Virtual Tunnel Endpoint (VTEP)-Funktionalität des Spines nicht verwendet. VLAN-interner Datenverkehr wird zwischen den VTEPs im Quell- und Ziel-Leaf gesendet.

Im Gegensatz dazu muss der Datenverkehr zwischen VLANs (und zwischen Fabrics) geroutet werden. Dieser Datenverkehr wird in VXLAN gekapselt und vom Leaf zur Wirbelsäule überbrückt. Die Leaves wissen, dass sie diesen Datenverkehr an die Spine senden müssen, da die Quelle, die Routing benötigt, auf die MAC-Zieladresse des Standard-Gateways des VLAN abzielt. Mit anderen Worten: Frames, die an die MAC-Adresse des IRB gesendet werden, werden bei L2 an das Spine-Gerät weitergeleitet.

Auf der Spine wird die L2-Kapselung entfernt, um eine L3-Routensuche in der Routing-Instanz zu ermöglichen, die dem VLAN/IRB zugeordnet ist. Bei Inter-VLAN-Datenverkehr ermittelt das Spine das Ziel-VLAN und den entsprechenden VXLAN-VNI aus seiner Routensuche. Die Wirbelsäule kapselt dann den Datenverkehr wieder ein und sendet ihn durch die Unterlage an das Zielblatt oder die Zielblätter.

Topologie

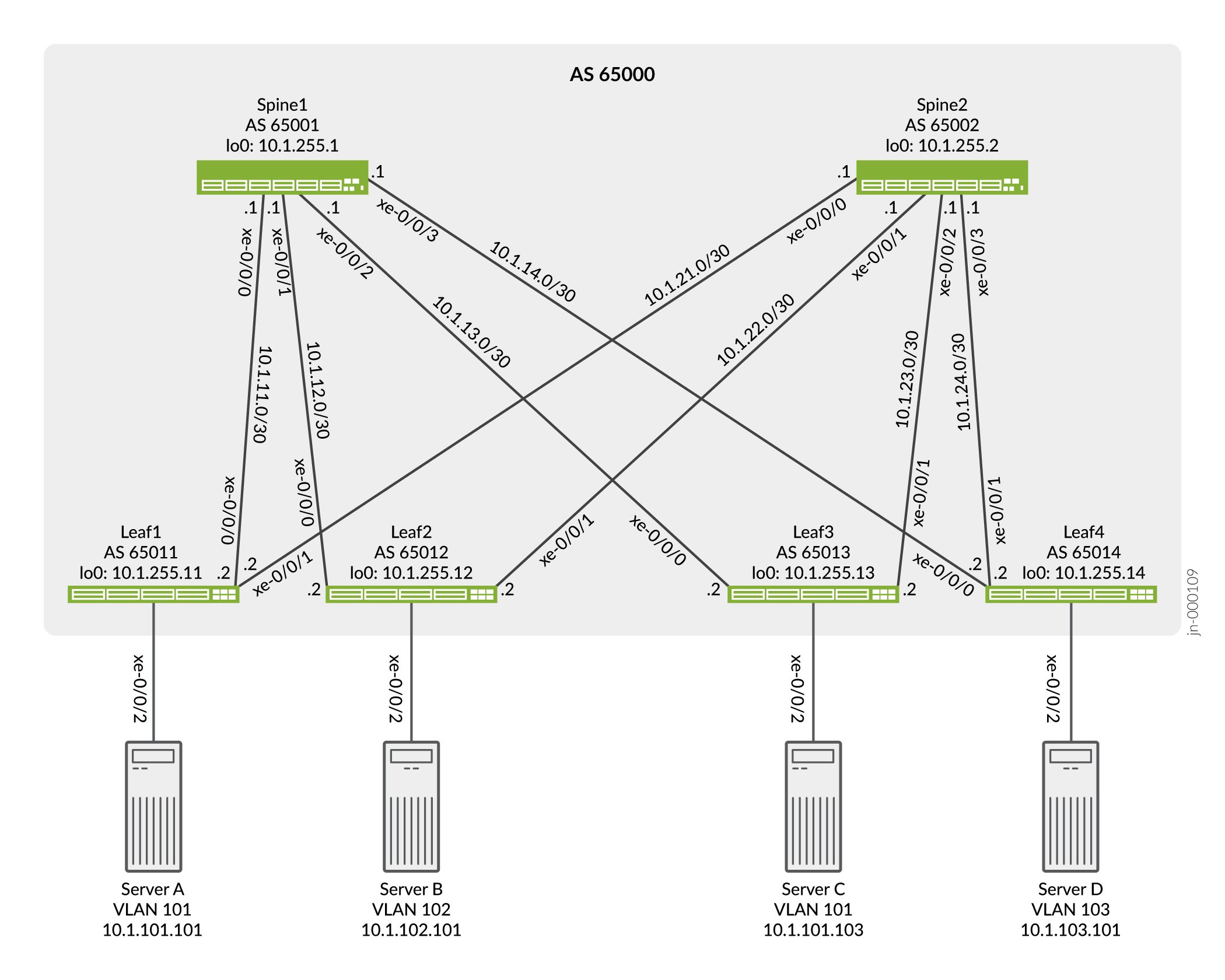

Die einfache IP-Clos-Topologie in Abbildung 1 umfasst zwei Spine-Switches, vier Leaf-Switches und vier Server. Jeder Leaf-Switch verfügt über eine Verbindung zu jedem der Spine-Switches für Redundanz.

Die Servernetzwerke sind in 3 VLANS unterteilt, von denen jedes einem VXLAN Virtual Network Identifier (VNI) zugeordnet ist. VLAN v101 unterstützt die Server A und C, und die VLANs v102 und v103 unterstützen die Server B bzw. D. Konfigurationsparameter finden Sie in Tabelle 1 .

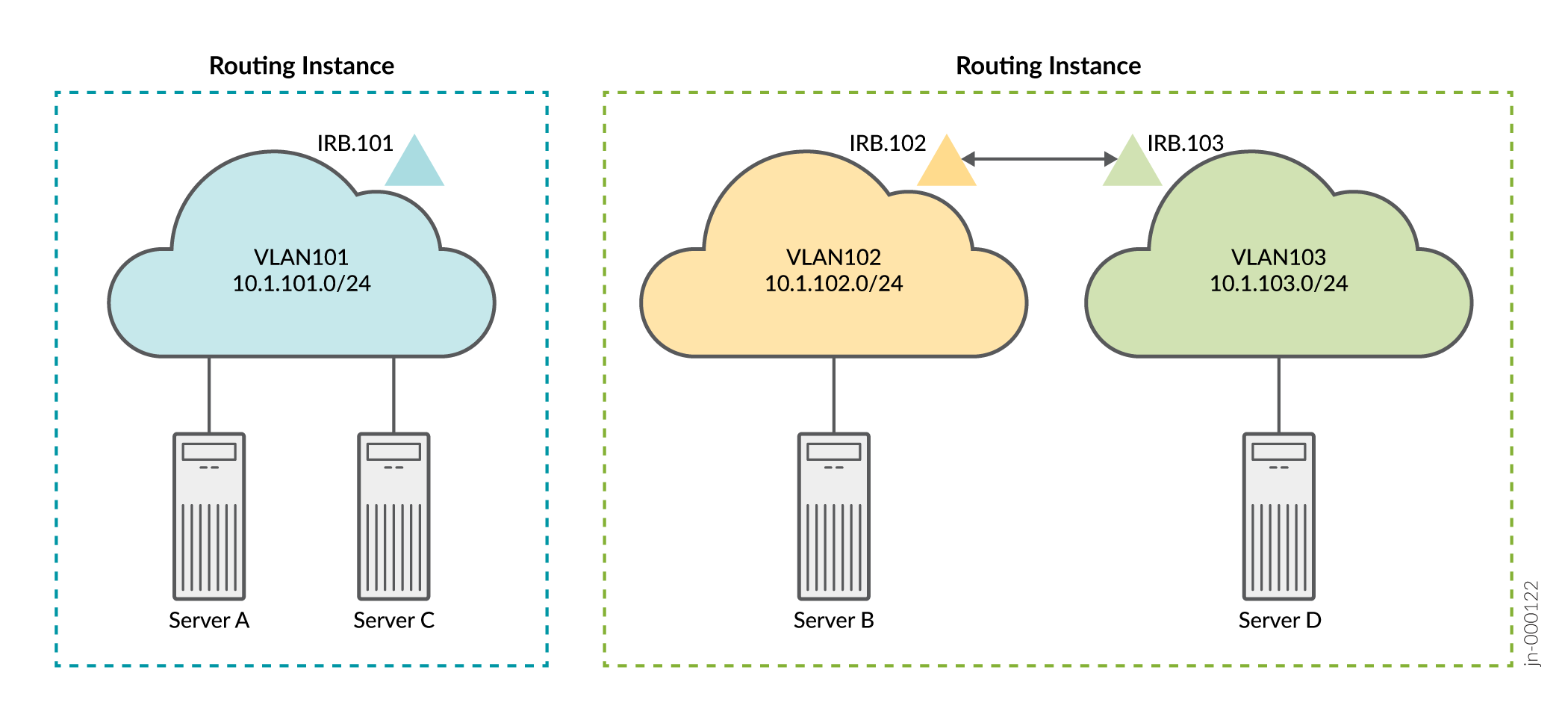

Die logische Topologie zeigt die erwartete Konnektivität an. In diesem Beispiel wird eine Routing-Instanz verwendet, um die Server A und C über VLAN 101 zu verbinden, und eine Routing-Instanz wird verwendet, um die Server B und D über die VLANs 102 und 103 zu verbinden. Die Server können standardmäßig nur mit anderen Servern kommunizieren, die sich in derselben Routinginstanz befinden.

Da Server A und C dasselbe VLAN verwenden, kommunizieren die Server über L2. Daher wird die IRB-Schnittstelle für die Kommunikation zwischen Server A und C nicht benötigt. Wir definieren eine IRB-Schnittstelle in der Routing-Instanz als Best Practice, um zukünftige L3-Konnektivität zu ermöglichen. Im Gegensatz dazu benötigen Server B und D für die Kommunikation L3-Konnektivität über ihre jeweiligen IRB-Schnittstellen, da sich diese Server in unterschiedlichen VLANs befinden, die in eindeutigen IP-Subnetzen ausgeführt werden.

Tabelle 1 enthält die wichtigsten Parameter, einschließlich der IRB-Schnittstellen, die für jedes Netzwerk konfiguriert sind. Eine IRB-Schnittstelle unterstützt jedes VLAN und leitet Datenpakete von den anderen VLANs über das VLAN.

| Parameter |

Server A und C |

Server B und C |

|---|---|---|

| VLAN |

v101 |

v102 |

| v103 |

||

| VXLAN-VNI |

101 |

102 |

| 103 |

||

| VLAN-ID |

101 |

102 |

| 103 |

||

| IRB-Schnittstelle |

IRB.101 |

IRB.102 |

| IRB.103 |

Beachten Sie Folgendes, wenn Sie die Parameter in Tabelle 1 konfigurieren. Du musst:

-

Ordnen Sie jedem VLAN ein eindeutiges IP-Subnetz und damit eine eindeutige IRB-Schnittstelle zu.

-

Weisen Sie jedem VLAN einen eindeutigen VXLAN Network Identifier (VNI) zu.

-

Geben Sie jede IRB-Schnittstelle als Teil einer L3-VRF-Instanz (Virtual Routing Forwarding) an, oder Sie können die Schnittstellen in der Standard-Switch-Instanz zusammenfassen. In diesem Beispiel werden VRF-Instanzen verwendet, um eine Trennung zwischen der Benutzer-Community (VLANs) zu erzwingen.

-

Fügen Sie in die Konfiguration jeder IRB-Schnittstelle eine Standard-Gateway-Adresse ein, die Sie mit der

virtual-gateway-addressKonfigurationsanweisung auf Hierarchieebene[interfaces irb unit logical-unit-number family inet address ip-address]angeben. Durch die Konfiguration eines virtuellen Gateways wird ein redundantes Standard-Gateway für jede IRB-Schnittstelle eingerichtet.

Spine 1: Underlay-Netzwerkkonfiguration

CLI-Schnellkonfiguration

Um dieses Beispiel schnell zu konfigurieren, kopieren Sie die folgenden Befehle, fügen Sie sie in eine Textdatei ein, entfernen Sie alle Zeilenumbrüche, ändern Sie alle Details, die für Ihre Konfiguration erforderlich sind, kopieren Sie die Befehle und fügen Sie sie in die CLI auf der Hierarchieebene [edit] ein, und geben Sie sie dann aus dem Konfigurationsmodus ein commit .

set interfaces xe-0/0/0 unit 0 family inet address 10.1.11.1/30 set interfaces xe-0/0/1 unit 0 family inet address 10.1.12.1/30 set interfaces xe-0/0/2 unit 0 family inet address 10.1.13.1/30 set interfaces xe-0/0/3 unit 0 family inet address 10.1.14.1/30 set interfaces lo0 unit 0 family inet address 10.1.255.1/32 primary set policy-options policy-statement load-balancing-policy then load-balance per-packet set policy-options policy-statement send-direct term 1 from protocol direct set policy-options policy-statement send-direct term 1 then accept set routing-options router-id 10.1.255.1 set routing-options autonomous-system 65000 set routing-options forwarding-table export load-balancing-policy set protocols bgp group underlay type external set protocols bgp group underlay export send-direct set protocols bgp group underlay local-as 65001 set protocols bgp group underlay multipath multiple-as set protocols bgp group underlay neighbor 10.1.11.2 peer-as 65011 set protocols bgp group underlay neighbor 10.1.12.2 peer-as 65012 set protocols bgp group underlay neighbor 10.1.13.2 peer-as 65013 set protocols bgp group underlay neighbor 10.1.14.2 peer-as 65014

Spine 1: Konfigurieren des Underlay-Netzwerks

Schritt-für-Schritt-Anleitung

So konfigurieren Sie das Underlay-Netzwerk auf Spine 1:

-

Konfigurieren Sie die L3-Fabric-Schnittstellen.

[edit] user@Spine1# set interfaces xe-0/0/0 unit 0 family inet address 10.1.11.1/30 user@Spine1# set interfaces xe-0/0/1 unit 0 family inet address 10.1.12.1/30 user@Spine1# set interfaces xe-0/0/2 unit 0 family inet address 10.1.13.1/30 user@Spine1# set interfaces xe-0/0/3 unit 0 family inet address 10.1.14.1/30

-

Geben Sie eine IP-Adresse für die Loopback-Schnittstelle an. Diese IP-Adresse dient als Quell-IP-Adresse im äußeren Header von VXLAN-gekapselten Paketen.

[edit] user@Spine1# set interfaces lo0 unit 0 family inet address 10.1.255.1/32 primary

-

Konfigurieren Sie die Routing-Optionen. Die Konfiguration enthält einen Verweis auf eine Lastausgleichsrichtlinie, um die Verwendung von ECMP-Routing (Equal Cost Multiple Path) durch das Underlay zu ermöglichen.

[edit] user@Spine1# set routing-options router-id 10.1.255.1 user@Spine1# set routing-options autonomous-system 65000 user@Spine1# set routing-options forwarding-table export load-balancing-policy

-

Konfigurieren Sie eine BGP-Gruppe für das externe BGP (EBGP)-basierte Underlay. Beachten Sie, dass Multipath in der BGP-Konfiguration enthalten ist, um die Verwendung mehrerer Pfade mit gleichen Kosten zu ermöglichen. Normalerweise verwendet BGP einen Tie-Break-Algorithmus, der den besten Pfad auswählt.

[edit] user@Spine1# set protocols bgp group underlay type external user@Spine1# set protocols bgp group underlay export send-direct user@Spine1# set protocols bgp group underlay local-as 65001 user@Spine1# set protocols bgp group underlay multipath multiple-as user@Spine1# set protocols bgp group underlay neighbor 10.1.11.2 peer-as 65011 user@Spine1# set protocols bgp group underlay neighbor 10.1.12.2 peer-as 65012 user@Spine1# set protocols bgp group underlay neighbor 10.1.13.2 peer-as 65013 user@Spine1# set protocols bgp group underlay neighbor 10.1.14.2 peer-as 65014

-

Konfigurieren Sie die Load-Balancing-Richtlinie pro Paket.

[edit] user@Spine1# set policy-options policy-statement load-balancing-policy then load-balance per-packet

-

Konfigurieren Sie eine Richtlinie, um direkte Schnittstellenrouten in das Underlay anzukündigen. Sie müssen mindestens die Routen der Loopback-Schnittstelle (lo0) im Underlay ankündigen.

[edit] user@Spine1# set policy-options policy-statement send-direct term 1 from protocol direct user@Spine1# set policy-options policy-statement send-direct term 1 then accept

Spine 1: Konfiguration des Overlay-Netzwerks

CLI-Schnellkonfiguration

Um dieses Beispiel schnell zu konfigurieren, kopieren Sie die folgenden Befehle, fügen Sie die Konfiguration in eine Textdatei ein, entfernen Sie alle Zeilenumbrüche, ändern Sie alle Details, die für Ihre Konfiguration erforderlich sind, kopieren Sie die Befehle und fügen Sie sie in die CLI auf der Hierarchieebene [edit] ein, und geben Sie sie dann aus dem Konfigurationsmodus ein commit .

set protocols bgp group evpn type internal set protocols bgp group evpn local-address 10.1.255.1 set protocols bgp group evpn family evpn signaling set protocols bgp group evpn cluster 10.1.1.1 set protocols bgp group evpn multipath set protocols bgp group evpn neighbor 10.1.255.2 set protocols bgp group evpn neighbor 10.1.255.11 set protocols bgp group evpn neighbor 10.1.255.12 set protocols bgp group evpn neighbor 10.1.255.13 set protocols bgp group evpn neighbor 10.1.255.14 set protocols evpn encapsulation vxlan set protocols evpn default-gateway no-gateway-community set protocols evpn multicast-mode ingress-replication set switch-options vtep-source-interface lo0.0 set switch-options route-distinguisher 10.1.255.1:1 set switch-options vrf-target target:65000:1 set switch-options vrf-target auto

Konfigurieren des Overlay-Netzwerks auf Spine 1

Schritt-für-Schritt-Anleitung

So konfigurieren Sie das Overlay-Netzwerk auf Spine 1:

-

Konfigurieren Sie ein internes BGP (IBGP)-basiertes EVPN-VXLAN-Overlay. Beachten Sie, dass die EVPN-Adressfamilie so konfiguriert ist, dass sie die Ankündigung von EVPN-Routen unterstützt. In diesem Fall definieren wir ein Overlay-Peering zu Spine 2 für Spine-to-Spine-Konnektivität. Wie beim Underlay haben wir auch im Overlay BGP-Multipath aktiviert.

Hinweis:Einige IP-Fabrics verwenden ein EBGP-basiertes EVPN-VXLAN-Overlay. Ein Beispiel für eine IP-Fabric, die EBGP sowohl für das Underlay als auch für das Overlay verwendet, finden Sie unter Beispiel: Konfigurieren einer EVPN-VXLAN-Bridging-Fabric mit Edge-Routing und einem Anycast-Gateway. Beachten Sie, dass sich die Wahl von EBGP oder IBGP für das Overlay nicht negativ auf die Fabric-Architektur auswirkt. Sowohl das zentral geroutete Bridging (CRB) als auch das kantengeroutete Bridging (ERB) unterstützen beide Overlay-Typen.

[edit] user@Spine1# set protocols bgp group evpn type internal user@Spine1# set protocols bgp group evpn local-address 10.1.255.1 user@Spine1# set protocols bgp group evpn family evpn signaling user@Spine1# set protocols bgp group evpn cluster 10.1.1.1 user@Spine1# set protocols bgp group evpn multipath user@Spine1# set protocols bgp group evpn neighbor 10.1.255.2 user@Spine1# set protocols bgp group evpn neighbor 10.1.255.11 user@Spine1# set protocols bgp group evpn neighbor 10.1.255.12 user@Spine1# set protocols bgp group evpn neighbor 10.1.255.13 user@Spine1# set protocols bgp group evpn neighbor 10.1.255.14

-

Konfigurieren Sie die VXLAN-Kapselung für die L2-Frames, die zwischen den L2-VXLAN-VTEPs ausgetauscht werden.

[edit] user@Spine1# set protocols evpn encapsulation vxlan

-

Konfigurieren Sie die Standard-Gateway-Option

no-gateway-communityfür EVPN-Protokolle.[edit] user@Spine1# set protocols evpn default-gateway no-gateway-community

Hinweis:Wenn eine virtuelle Gateway-Adresse verwendet wird, wird auf beiden Spines eine VRRP-basierte MAC "00:00:5e:00:01:01" verwendet, so dass keine MAC-Synchronisierung erforderlich ist. Weitere Informationen finden Sie unter Standard-Gateway .

-

Geben Sie an, wie Multicast-Datenverkehr in der Fabric repliziert wird.

[edit] user@Spine1# set protocols evpn multicast-mode ingress-replication

-

Konfigurieren Sie die Standardoptionen für Routing-Instanzen (virtueller Switch-Typ).

[edit] user@Spine1# set switch-options vtep-source-interface lo0.0 user@Spine1# set switch-options route-distinguisher 10.1.255.1:1 user@Spine1# set switch-options vrf-target target:65000:1 user@Spine1# set switch-options vrf-target auto

Spine 1: Konfiguration des Zugriffsprofils

CLI-Schnellkonfiguration

Das Zugriffsprofil oder die Zugriffsportkonfiguration umfasst die Einstellungen, die erforderlich sind, um Server-Workloads, BMS oder VMs an die Zugriffs-Switches (Leaf-Switches) anzuhängen. Dieser Schritt umfasst die Definition des VLANs des Geräts zusammen mit der Routing-Instanz und der IRB-Konfiguration, die die Benutzerisolierung bzw. das L3-Routing bereitstellen.

Da es sich hierbei um ein Beispiel für eine zentral geroutete Bridging-Fabric (CRB) handelt, werden die Routing-Instanzen und die integrierten Routing- und Bridging-Schnittstellen (IRB) nur auf den Spine-Geräten definiert. Die Leaf-Geräte in einer CRB-Fabric verfügen nur über L2-VXLAN-Funktionalität.

Um dieses Beispiel schnell zu konfigurieren, kopieren Sie die folgenden Befehle, fügen Sie die Befehle in eine Textdatei ein, entfernen Sie alle Zeilenumbrüche, ändern Sie alle Details, die für Ihre Konfiguration erforderlich sind, kopieren Sie die Befehle und fügen Sie sie in die CLI auf der Hierarchieebene [edit] ein, und geben Sie sie dann aus dem Konfigurationsmodus ein commit .

Wenn proxy-macip-advertisement aktiviert ist, kündigt das L3-Gateway MAC- und IP-Routen (MAC+IP-Typ-2-Routen) im Namen von L2-VXLAN-Gateways in EVPN-VXLAN-Netzwerken an. Dieses Verhalten wird von EVPN-MPLS nicht unterstützt. Ab Junos OS Version 20.2R2 wird die folgende Warnmeldung angezeigt, wenn Sie proxy-macip-advertisement aktivieren:

WARNUNG: Nur EVPN VXLAN unterstützt die Konfiguration proxy-macip-advertisement.

Die Meldung wird angezeigt, wenn Sie Ihre Konfiguration ändern, Ihre Konfiguration speichern oder den Befehl show verwenden, um Ihre Konfiguration anzuzeigen

set interfaces irb unit 101 proxy-macip-advertisement set interfaces irb unit 101 virtual-gateway-accept-data set interfaces irb unit 101 family inet address 10.1.101.1/24 virtual-gateway-address 10.1.101.254 set interfaces irb unit 102 proxy-macip-advertisement set interfaces irb unit 102 virtual-gateway-accept-data set interfaces irb unit 102 family inet address 10.1.102.1/24 virtual-gateway-address 10.1.102.254 set interfaces irb unit 103 proxy-macip-advertisement set interfaces irb unit 103 virtual-gateway-accept-data set interfaces irb unit 103 family inet address 10.1.103.1/24 virtual-gateway-address 10.1.103.254 set protocols evpn vni-options vni 101 vrf-target target:65000:101 set protocols evpn vni-options vni 102 vrf-target target:65000:102 set protocols evpn vni-options vni 103 vrf-target target:65000:103 set protocols evpn extended-vni-list 101 set protocols evpn extended-vni-list 102 set protocols evpn extended-vni-list 103 set routing-instances serverAC instance-type vrf set routing-instances serverAC interface irb.101 set routing-instances serverAC route-distinguisher 10.1.255.1:13 set routing-instances serverAC vrf-target target:65000:13 set routing-instances serverBD instance-type vrf set routing-instances serverBD interface irb.102 set routing-instances serverBD interface irb.103 set routing-instances serverBD route-distinguisher 10.1.255.1:24 set routing-instances serverBD vrf-target target:65000:24 set vlans v101 vlan-id 101 set vlans v101 l3-interface irb.101 set vlans v101 vxlan vni 101 set vlans v102 vlan-id 102 set vlans v102 l3-interface irb.102 set vlans v102 vxlan vni 102 set vlans v103 vlan-id 103 set vlans v103 l3-interface irb.103 set vlans v103 vxlan vni 103

Konfigurieren der Zugriffsprofile für Spine 1

Schritt-für-Schritt-Anleitung

So konfigurieren Sie Profile für die Servernetzwerke:

-

Konfigurieren Sie die IRB-Schnittstellen, die das Routing zwischen den VLANs 101, 102 und 103 unterstützen.

[edit] user@Spine1# set interfaces irb unit 101 proxy-macip-advertisement user@Spine1# set interfaces irb unit 101 virtual-gateway-accept-data user@Spine1# set interfaces irb unit 101 family inet address 10.1.101.1/24 virtual-gateway-address 10.1.101.254 user@Spine1# set interfaces irb unit 102 proxy-macip-advertisement user@Spine1# set interfaces irb unit 102 virtual-gateway-accept-data user@Spine1# set interfaces irb unit 102 family inet address 10.1.102.1/24 virtual-gateway-address 10.1.102.254 user@Spine1# set interfaces irb unit 103 proxy-macip-advertisement user@Spine1# set interfaces irb unit 103 virtual-gateway-accept-data user@Spine1# set interfaces irb unit 103 family inet address 10.1.103.1/24 virtual-gateway-address 10.1.103.254

-

Geben Sie an, welche virtuellen Netzwerkbezeichner (VNIs) in der EVPN-VXLAN-Domäne enthalten sind.

[edit] user@Spine1# set protocols evpn extended-vni-list 101 user@Spine1# set protocols evpn extended-vni-list 102 user@Spine1# set protocols evpn extended-vni-list 103

-

Konfigurieren Sie für jeden VNI ein Routenziel.

[edit] user@Spine1# set protocols evpn vni-options vni 101 vrf-target target:65000:101 user@Spine1# set protocols evpn vni-options vni 102 vrf-target target:65000:102 user@Spine1# set protocols evpn vni-options vni 103 vrf-target target:65000:103

Hinweis:In der ursprünglichen Konfiguration wird auf den Spine-Geräten Junos OS Version 15.1X53-D30 und auf den Leaf-Geräten 14.1X53-D30 ausgeführt. Wenn Sie in diesen Softwareversionen die

vrf-targetKonfigurationsanweisung in die[edit protocols evpn vni-options vni]Hierarchieebene aufnehmen, müssen Sie auch dieexportOption einschließen. Beachten Sie, dass diese Option für spätere Junos OS-Versionen nicht mehr erforderlich ist. Daher wird dieexportOption in den Konfigurationen in diesem aktualisierten Beispiel weggelassen. -

Konfigurieren Sie die Routinginstanz für die Server A und C.

[edit] user@Spine1# set routing-instances serverAC instance-type vrf user@Spine1# set routing-instances serverAC interface irb.101 user@Spine1# set routing-instances serverAC route-distinguisher 10.1.255.1:13 user@Spine1# set routing-instances serverAC vrf-target target:65000:13

-

Konfigurieren Sie die Routinginstanz für die Server B und D.

[edit] user@Spine1# set routing-instances serverBD instance-type vrf user@Spine1# set routing-instances serverBD interface irb.102 user@Spine1# set routing-instances serverBD interface irb.103 user@Spine1# set routing-instances serverBD route-distinguisher 10.1.255.1:24 user@Spine1# set routing-instances serverBD vrf-target target:65000:24

-

Konfigurieren Sie die VLANs v101, v102 und v103 und ordnen Sie jedem VLAN die entsprechenden VNIs und IRB-Schnittstellen zu.

[edit] user@Spine1# set vlans v101 vlan-id 101 user@Spine1# set vlans v101 l3-interface irb.101 user@Spine1# set vlans v101 vxlan vni 101 user@Spine1# set vlans v102 vlan-id 102 user@Spine1# set vlans v102 l3-interface irb.102 user@Spine1# set vlans v102 vxlan vni 102 user@Spine1# set vlans v103 vlan-id 103 user@Spine1# set vlans v103 l3-interface irb.103 user@Spine1# set vlans v103 vxlan vni 103

Spine 2: Vollständige Konfiguration

CLI-Schnellkonfiguration

Die Konfiguration von Spine 2 ähnelt der von Spine 1, daher stellen wir die vollständige Konfiguration anstelle einer Schritt-für-Schritt-Konfiguration zur Verfügung. Um dieses Beispiel schnell zu konfigurieren, kopieren Sie die folgenden Befehle, fügen Sie die Befehle in eine Textdatei ein, entfernen Sie alle Zeilenumbrüche, ändern Sie alle Details, die für Ihre Konfiguration erforderlich sind, kopieren Sie die Befehle und fügen Sie sie in die CLI auf der Hierarchieebene [edit] ein, und geben Sie sie dann aus dem Konfigurationsmodus ein commit .

set interfaces xe-0/0/0 unit 0 family inet address 10.1.21.1/30 set interfaces xe-0/0/1 unit 0 family inet address 10.1.22.1/30 set interfaces xe-0/0/2 unit 0 family inet address 10.1.23.1/30 set interfaces xe-0/0/3 unit 0 family inet address 10.1.24.1/30 set interfaces irb unit 101 proxy-macip-advertisement set interfaces irb unit 101 virtual-gateway-accept-data set interfaces irb unit 101 family inet address 10.1.101.2/24 virtual-gateway-address 10.1.101.254 set interfaces irb unit 102 proxy-macip-advertisement set interfaces irb unit 102 virtual-gateway-accept-data set interfaces irb unit 102 family inet address 10.1.102.2/24 virtual-gateway-address 10.1.102.254 set interfaces irb unit 103 proxy-macip-advertisement set interfaces irb unit 103 virtual-gateway-accept-data set interfaces irb unit 103 family inet address 10.1.103.2/24 virtual-gateway-address 10.1.103.254 set interfaces lo0 unit 0 family inet address 10.1.255.2/32 primary set policy-options policy-statement load-balancing-policy then load-balance per-packet set policy-options policy-statement send-direct term 1 from protocol direct set policy-options policy-statement send-direct term 1 then accept set routing-instances serverAC instance-type vrf set routing-instances serverAC interface irb.101 set routing-instances serverAC route-distinguisher 10.1.255.1:13 set routing-instances serverAC vrf-target target:65000:13 set routing-instances serverBD instance-type vrf set routing-instances serverBD interface irb.102 set routing-instances serverBD interface irb.103 set routing-instances serverBD route-distinguisher 10.1.255.1:24 set routing-instances serverBD vrf-target target:65000:24 set routing-options router-id 10.1.255.2 set routing-options autonomous-system 65000 set routing-options forwarding-table export load-balancing-policy set protocols bgp group underlay type external set protocols bgp group underlay export send-direct set protocols bgp group underlay local-as 65002 set protocols bgp group underlay multipath multiple-as set protocols bgp group underlay neighbor 10.1.21.2 peer-as 65011 set protocols bgp group underlay neighbor 10.1.22.2 peer-as 65012 set protocols bgp group underlay neighbor 10.1.23.2 peer-as 65013 set protocols bgp group underlay neighbor 10.1.24.2 peer-as 65014 set protocols bgp group evpn type internal set protocols bgp group evpn local-address 10.1.255.2 set protocols bgp group evpn family evpn signaling set protocols bgp group evpn cluster 10.2.2.2 set protocols bgp group evpn multipath set protocols bgp group evpn neighbor 10.1.255.1 set protocols bgp group evpn neighbor 10.1.255.11 set protocols bgp group evpn neighbor 10.1.255.12 set protocols bgp group evpn neighbor 10.1.255.13 set protocols bgp group evpn neighbor 10.1.255.14 set protocols evpn encapsulation vxlan set protocols evpn default-gateway no-gateway-community set protocols evpn multicast-mode ingress-replication set protocols evpn vni-options vni 101 vrf-target target:65000:101 set protocols evpn vni-options vni 102 vrf-target target:65000:102 set protocols evpn vni-options vni 103 vrf-target target:65000:103 set protocols evpn extended-vni-list 101 set protocols evpn extended-vni-list 102 set protocols evpn extended-vni-list 103 set switch-options vtep-source-interface lo0.0 set switch-options route-distinguisher 10.1.255.2:1 set switch-options vrf-target target:65000:1 set switch-options vrf-target auto set vlans v101 vlan-id 101 set vlans v101 l3-interface irb.101 set vlans v101 vxlan vni 101 set vlans v102 vlan-id 102 set vlans v102 l3-interface irb.102 set vlans v102 vxlan vni 102 set vlans v103 vlan-id 103 set vlans v103 l3-interface irb.103 set vlans v103 vxlan vni 103

Leaf 1: Underlay-Netzwerkkonfiguration

CLI-Schnellkonfiguration

Um dieses Beispiel schnell zu konfigurieren, kopieren Sie die folgenden Befehle, fügen Sie die Befehle in eine Textdatei ein, entfernen Sie alle Zeilenumbrüche, ändern Sie alle Details, die für Ihre Konfiguration erforderlich sind, kopieren Sie die Befehle und fügen Sie sie in die CLI auf der Hierarchieebene [edit] ein, und geben Sie sie dann aus dem Konfigurationsmodus ein commit .

set interfaces xe-0/0/0 unit 0 family inet address 10.1.11.2/30 set interfaces xe-0/0/1 unit 0 family inet address 10.1.21.2/30 set interfaces lo0 unit 0 family inet address 10.1.255.11/32 primary set routing-options router-id 10.1.255.11 set routing-options autonomous-system 65000 set routing-options forwarding-table export load-balancing-policy set protocols bgp group underlay type external set protocols bgp group underlay export send-direct set protocols bgp group underlay local-as 65011 set protocols bgp group underlay multipath multiple-as set protocols bgp group underlay neighbor 10.1.11.1 peer-as 65001 set protocols bgp group underlay neighbor 10.1.21.1 peer-as 65002 set policy-options policy-statement load-balancing-policy then load-balance per-packet set policy-options policy-statement send-direct term 1 from protocol direct set policy-options policy-statement send-direct term 1 then accept

Konfigurieren des Underlay-Netzwerks für Leaf 1

Schritt-für-Schritt-Anleitung

So konfigurieren Sie das Underlay-Netzwerk für Leaf 1:

-

Konfigurieren Sie die L3-Schnittstellen.

[edit] user@Leaf1# set interfaces xe-0/0/0 unit 0 family inet address 10.1.11.2/30 user@Leaf1# set interfaces xe-0/0/1 unit 0 family inet address 10.1.21.2/30

-

Geben Sie eine IP-Adresse für die Loopback-Schnittstelle an. Diese IP-Adresse dient als Quell-IP-Adresse im äußeren Header aller VXLAN-gekapselten Pakete.

[edit] user@Leaf1# set interfaces lo0 unit 0 family inet address 10.1.255.11/32 primary

-

Legen Sie die Routing-Optionen fest.

[edit] user@Leaf1# set routing-options router-id 10.1.255.11 user@Leaf1# set routing-options autonomous-system 65000 user@Leaf1# set routing-options forwarding-table export load-balancing-policy

-

Konfigurieren Sie eine externe BGP-Gruppe (EBGP), die die Spines als Peers für das Underlay-Routing enthält.

[edit] user@Leaf1# set protocols bgp group underlay type external user@Leaf1# set protocols bgp group underlay export send-direct user@Leaf1# set protocols bgp group underlay local-as 65011 user@Leaf1# set protocols bgp group underlay multipath multiple-as user@Leaf1# set protocols bgp group underlay neighbor 10.1.11.1 peer-as 65001 user@Leaf1# set protocols bgp group underlay neighbor 10.1.21.1 peer-as 65002

-

Konfigurieren Sie eine Richtlinie, die den Datenverkehr über mehrere Pfade zwischen den Switches von Juniper Networks verteilt.

[edit] user@Leaf1# set policy-options policy-statement load-balancing-policy then load-balance per-packet

-

Konfigurieren Sie eine Richtlinie so, dass direkte Schnittstellenrouten angekündigt werden. Das Underlay muss mindestens eine vollständige Erreichbarkeit zu den Loopback-Adressen des Geräts haben.

[edit] user@Leaf1# set policy-options policy-statement send-direct term 1 from protocol direct user@Leaf1# set policy-options policy-statement send-direct term 1 then accept

Leaf 1: Overlay-Netzwerkkonfiguration

CLI-Schnellkonfiguration

Um dieses Beispiel schnell zu konfigurieren, kopieren Sie die folgenden Befehle, fügen Sie die Befehle in eine Textdatei ein, entfernen Sie alle Zeilenumbrüche, ändern Sie alle Details, die für Ihre Konfiguration erforderlich sind, kopieren Sie die Befehle und fügen Sie sie in die CLI auf Hierarchieebene ein, und geben Sie dann den Befehl aus dem [edit] Konfigurationsmodus ein commit .

set protocols bgp group evpn type internal set protocols bgp group evpn local-address 10.1.255.11 set protocols bgp group evpn family evpn signaling set protocols bgp group evpn multipath set protocols bgp group evpn neighbor 10.1.255.1 set protocols bgp group evpn neighbor 10.1.255.2 set protocols evpn encapsulation vxlan set protocols evpn multicast-mode ingress-replication set switch-options vtep-source-interface lo0.0 set switch-options route-distinguisher 10.1.255.11:1 set switch-options vrf-target target:65000:1 set switch-options vrf-target auto

Konfigurieren des Overlay-Netzwerks für Leaf 1

Schritt-für-Schritt-Anleitung

So konfigurieren Sie das Overlay-Netzwerk für Leaf 1:

-

Konfigurieren Sie eine interne BGP-Gruppe (IBGP) für das EVPN-VXLAN-Overlay-Netzwerk.

[edit] user@Leaf1# set protocols bgp group evpn type internal user@Leaf1# set protocols bgp group evpn local-address 10.1.255.11 user@Leaf1# set protocols bgp group evpn family evpn signaling user@Leaf1# set protocols bgp group evpn multipath user@Leaf1# set protocols bgp group evpn neighbor 10.1.255.1 user@Leaf1# set protocols bgp group evpn neighbor 10.1.255.2

-

Konfigurieren Sie die VXLAN-Kapselung für die Datenpakete, die zwischen den EVPN-Nachbarn ausgetauscht werden.

[edit] user@Leaf1# set protocols evpn encapsulation vxlan

-

Geben Sie an, wie Multicast-Datenverkehr in der EVPN-VXLAN-Umgebung repliziert wird.

[edit] user@Leaf1# set protocols evpn multicast-mode ingress-replication

-

Konfigurieren Sie die Standardoptionen für Routing-Instanzen (virtueller Switch-Typ).

[edit] user@Leaf1# set switch-options vtep-source-interface lo0.0 user@Leaf1# set switch-options route-distinguisher 10.1.255.11:1 user@Leaf1# set switch-options vrf-target target:65000:1 user@Leaf1# set switch-options vrf-target auto

Blatt 1: Konfiguration des Zugriffsprofils

CLI-Schnellkonfiguration

Um dieses Beispiel schnell zu konfigurieren, kopieren Sie die folgenden Befehle, fügen Sie die Befehle in eine Textdatei ein, entfernen Sie alle Zeilenumbrüche, ändern Sie alle Details, die für Ihre Konfiguration erforderlich sind, kopieren Sie die Befehle und fügen Sie sie in die CLI auf der Hierarchieebene [edit] ein, und geben Sie sie dann aus dem Konfigurationsmodus ein commit .

set interfaces xe-0/0/2 unit 0 family ethernet-switching interface-mode trunk set interfaces xe-0/0/2 unit 0 family ethernet-switching vlan members 101 set protocols evpn vni-options vni 101 vrf-target target:65000:101 set protocols evpn extended-vni-list 101 set vlans v101 vlan-id 101 set vlans v101 vxlan vni 101

Konfigurieren des Zugriffsprofils für Leaf 1

Schritt-für-Schritt-Anleitung

So konfigurieren Sie das Profil für das Servernetzwerk:

-

Konfigurieren Sie eine L2-Ethernet-Schnittstelle für die Verbindung mit dem physischen Server. Diese Schnittstelle ist VLAN 101 zugeordnet. In diesem Beispiel wird die Zugriffsschnittstelle als Trunk konfiguriert, um VLAN-Tagging zu unterstützen. Nicht getaggte Zugriffsschnittstellen werden ebenfalls unterstützt.

[edit] user@Leaf1# set interfaces xe-0/0/2 unit 0 family ethernet-switching interface-mode trunk user@Leaf1# set interfaces xe-0/0/2 unit 0 family ethernet-switching vlan members 101

-

Konfigurieren Sie ein Routenziel für den Virtual Network Identifier (VNI).

[edit] user@Leaf1# set protocols evpn vni-options vni 101 vrf-target target:65000:101

Hinweis:In der ursprünglichen Konfiguration wird auf den Spine-Geräten Junos OS Version 15.1X53-D30 und auf den Leaf-Geräten 14.1X53-D30 ausgeführt. Wenn Sie in diesen Softwareversionen die

vrf-targetKonfigurationsanweisung in die[edit protocols evpn vni-options vni]Hierarchieebene aufnehmen, müssen Sie auch dieexportOption einschließen. Beachten Sie, dass diese Option in späteren Junos OS-Versionen nicht mehr erforderlich ist, wie in den in diesem Beispiel verwendeten aktualisierten Konfigurationen widergespiegelt wird. -

Geben Sie an, welche VNIs in der EVPN-VXLAN-Domäne enthalten sind.

[edit] user@Leaf1# set protocols evpn extended-vni-list 101

-

Konfigurieren Sie VLAN v101. Das VLAN wird demselben VXLAN-VNI zugeordnet, den Sie auf den Spine-Geräten konfiguriert haben. Beachten Sie, dass die L3-IRB-Schnittstelle (Integrated Routing and Bridging) auf den Leaf-Geräten nicht spezifiziert ist. Dies liegt daran, dass bei der zentral gerouteten Überbrückung (CRB) die Blätter nur die L2-Überbrückung durchführen.

[edit] user@Leaf1# set vlans v101 vlan-id 101 user@Leaf1# set vlans v101 vxlan vni 101

Leaf 2: Vollständige Konfiguration

CLI-Schnellkonfiguration

Die Konfiguration von Leaf 2 ähnelt der von Leaf 1, daher stellen wir die vollständige Konfiguration anstelle einer Schritt-für-Schritt-Konfiguration zur Verfügung. Um dieses Beispiel schnell zu konfigurieren, kopieren Sie die folgenden Befehle, fügen Sie die Befehle in eine Textdatei ein, entfernen Sie alle Zeilenumbrüche, ändern Sie alle Details, die für Ihre Konfiguration erforderlich sind, kopieren Sie die Befehle und fügen Sie sie in die CLI auf Hierarchieebene ein, und geben Sie dann den Befehl aus dem [edit] Konfigurationsmodus ein commit .

set interfaces xe-0/0/0 unit 0 family inet address 10.1.12.2/30 set interfaces xe-0/0/1 unit 0 family inet address 10.1.22.2/30 set interfaces xe-0/0/2 unit 0 family ethernet-switching interface-mode trunk set interfaces xe-0/0/2 unit 0 family ethernet-switching vlan members 102 set interfaces lo0 unit 0 family inet address 10.1.255.12/32 primary set policy-options policy-statement load-balancing-policy then load-balance per-packet set policy-options policy-statement send-direct term 1 from protocol direct set policy-options policy-statement send-direct term 1 then accept set routing-options router-id 10.1.255.12 set routing-options autonomous-system 65000 set routing-options forwarding-table export load-balancing-policy set protocols bgp group underlay type external set protocols bgp group underlay export send-direct set protocols bgp group underlay local-as 65012 set protocols bgp group underlay multipath multiple-as set protocols bgp group underlay as-override set protocols bgp group underlay neighbor 10.1.12.1 peer-as 65001 set protocols bgp group underlay neighbor 10.1.22.1 peer-as 65002 set protocols bgp group evpn type internal set protocols bgp group evpn local-address 10.1.255.12 set protocols bgp group evpn family evpn signaling set protocols bgp group evpn multipath set protocols bgp group evpn neighbor 10.1.255.1 set protocols bgp group evpn neighbor 10.1.255.2 set protocols evpn encapsulation vxlan set protocols evpn multicast-mode ingress-replication set protocols evpn vni-options vni 102 vrf-target target:65000:102 set protocols evpn extended-vni-list 102 set switch-options vtep-source-interface lo0.0 set switch-options route-distinguisher 10.1.255.12:1 set switch-options vrf-target target:65000:1 set switch-options vrf-target auto set vlans v102 vlan-id 102 set vlans v102 vxlan vni 102

Leaf 3: Vollständige Konfiguration

CLI-Schnellkonfiguration

Die Konfiguration von Leaf 3 ähnelt der von Leaf 1, daher stellen wir die vollständige Konfiguration anstelle einer Schritt-für-Schritt-Konfiguration bereit. Um dieses Beispiel schnell zu konfigurieren, kopieren Sie die folgenden Befehle, fügen Sie die Befehle in eine Textdatei ein, entfernen Sie alle Zeilenumbrüche, ändern Sie alle Details, die für Ihre Konfiguration erforderlich sind, kopieren Sie die Befehle und fügen Sie sie in die CLI auf Hierarchieebene ein, und geben Sie dann den Befehl aus dem [edit] Konfigurationsmodus ein commit .

set interfaces xe-0/0/0 unit 0 family inet address 10.1.13.2/30 set interfaces xe-0/0/1 unit 0 family inet address 10.1.23.2/30 set interfaces xe-0/0/2 unit 0 family ethernet-switching interface-mode trunk set interfaces xe-0/0/2 unit 0 family ethernet-switching vlan members 101 set interfaces lo0 unit 0 family inet address 10.1.255.13/32 primary set policy-options policy-statement load-balancing-policy then load-balance per-packet set policy-options policy-statement send-direct term 1 from protocol direct set policy-options policy-statement send-direct term 1 then accept set routing-options router-id 10.1.255.13 set routing-options autonomous-system 65000 set routing-options forwarding-table export load-balancing-policy set protocols bgp group underlay type external set protocols bgp group underlay export send-direct set protocols bgp group underlay local-as 65013 set protocols bgp group underlay multipath multiple-as set protocols bgp group underlay neighbor 10.1.13.1 peer-as 65001 set protocols bgp group underlay neighbor 10.1.23.1 peer-as 65002 set protocols bgp group evpn type internal set protocols bgp group evpn local-address 10.1.255.13 set protocols bgp group evpn family evpn signaling set protocols bgp group evpn multipath set protocols bgp group evpn neighbor 10.1.255.1 set protocols bgp group evpn neighbor 10.1.255.2 set protocols evpn encapsulation vxlan set protocols evpn multicast-mode ingress-replication set protocols evpn vni-options vni 101 vrf-target target:65000:101 set protocols evpn extended-vni-list 101 set switch-options vtep-source-interface lo0.0 set switch-options route-distinguisher 10.1.255.13:1 set switch-options vrf-target target:65000:1 set switch-options vrf-target auto set vlans v101 vlan-id 101 set vlans v101 vxlan vni 101

Leaf 4: Vollständige Konfiguration

CLI-Schnellkonfiguration

Die Konfiguration von Leaf 4 ähnelt der von Leaf 1, daher stellen wir die vollständige Konfiguration anstelle einer Schritt-für-Schritt-Konfiguration zur Verfügung. Um dieses Beispiel schnell zu konfigurieren, kopieren Sie die folgenden Befehle, fügen Sie die Befehle in eine Textdatei ein, entfernen Sie alle Zeilenumbrüche, ändern Sie alle Details, die für Ihre Konfiguration erforderlich sind, kopieren Sie die Befehle und fügen Sie sie in die CLI auf Hierarchieebene ein, und geben Sie dann den Befehl aus dem [edit] Konfigurationsmodus ein commit .

set interfaces xe-0/0/0 unit 0 family inet address 10.1.14.2/30 set interfaces xe-0/0/1 unit 0 family inet address 10.1.24.2/30 set interfaces xe-0/0/2 unit 0 family ethernet-switching interface-mode trunk set interfaces xe-0/0/2 unit 0 family ethernet-switching vlan members 103 set interfaces lo0 unit 0 family inet address 10.1.255.14/32 primary set policy-options policy-statement load-balancing-policy then load-balance per-packet set policy-options policy-statement send-direct term 1 from protocol direct set policy-options policy-statement send-direct term 1 then accept set routing-options router-id 10.1.255.14 set routing-options autonomous-system 65000 set routing-options forwarding-table export load-balancing-policy set protocols bgp group underlay type external set protocols bgp group underlay export send-direct set protocols bgp group underlay local-as 65014 set protocols bgp group underlay multipath multiple-as set protocols bgp group underlay neighbor 10.1.14.1 peer-as 65001 set protocols bgp group underlay neighbor 10.1.24.1 peer-as 65002 set protocols bgp group evpn type internal set protocols bgp group evpn local-address 10.1.255.14 set protocols bgp group evpn family evpn signaling set protocols bgp group evpn multipath set protocols bgp group evpn neighbor 10.1.255.1 set protocols bgp group evpn neighbor 10.1.255.2 set protocols evpn encapsulation vxlan set protocols evpn multicast-mode ingress-replication set protocols evpn vni-options vni 103 vrf-target target:65000:103 set protocols evpn extended-vni-list 103 set switch-options vtep-source-interface lo0.0 set switch-options route-distinguisher 10.1.255.14:1 set switch-options vrf-target target:65000:1 set switch-options vrf-target auto set vlans v103 vlan-id 103 set vlans v103 vxlan vni 103

Überprüfung

Vergewissern Sie sich, dass die integrierten Routing- und Bridging-Schnittstellen (IRB) ordnungsgemäß funktionieren:

- Überprüfen der IRB-Schnittstellen

- Überprüfen der Routing-Instanzen

- Verifizieren des Lernens dynamischer MAC-Adressen

- Überprüfen von Routen in den Routing-Instanzen

- Überprüfen der Konnektivität

Überprüfen der IRB-Schnittstellen

Zweck

Überprüfen Sie die Konfiguration der IRB-Schnittstellen auf Spine 1 und Spine 2.

Aktion

Geben Sie im Betriebsmodus den show interfaces irb Befehl ein.

user@Spine1> show interfaces irb

Physical interface: irb, Enabled, Physical link is Up

Interface index: 640, SNMP ifIndex: 505

Type: Ethernet, Link-level type: Ethernet, MTU: 1514

Device flags : Present Running

Interface flags: SNMP-Traps

Link type : Full-Duplex

Link flags : None

Current address: 02:05:86:71:57:00, Hardware address: 02:05:86:71:57:00

Last flapped : Never

Input packets : 0

Output packets: 0

Logical interface irb.101 (Index 558) (SNMP ifIndex 583)

Flags: Up SNMP-Traps 0x4004000 Encapsulation: ENET2

Bandwidth: 1Gbps

Routing Instance: default-switch Bridging Domain: v101

Input packets : 7

Output packets: 13

Protocol inet, MTU: 1514

Max nh cache: 75000, New hold nh limit: 75000, Curr nh cnt: 2, Curr new hold cnt: 0, NH drop cnt: 0

Flags: Sendbcast-pkt-to-re, Is-Primary

Addresses, Flags: Is-Default Is-Preferred Is-Primary

Destination: 10.1.101/24, Local: 10.1.101.1, Broadcast: 10.1.101.255

Destination: 10.1.101/24, Local: 10.1.101.254, Broadcast: 10.1.101.255

Logical interface irb.102 (Index 582) (SNMP ifIndex 584)

Flags: Up SNMP-Traps 0x4000 Encapsulation: ENET2

Bandwidth: 1Gbps

Routing Instance: default-switch Bridging Domain: v102

Input packets : 2

Output packets: 6

Protocol inet, MTU: 1514

Max nh cache: 75000, New hold nh limit: 75000, Curr nh cnt: 1, Curr new hold cnt: 0, NH drop cnt: 0

Flags: Sendbcast-pkt-to-re

Addresses, Flags: Is-Preferred Is-Primary

Destination: 10.1.102/24, Local: 10.1.102.1, Broadcast: 10.1.102.255

Destination: 10.1.102/24, Local: 10.1.102.254, Broadcast: 10.1.102.255

Logical interface irb.103 (Index 580) (SNMP ifIndex 585)

Flags: Up SNMP-Traps 0x4000 Encapsulation: ENET2

Bandwidth: 1Gbps

Routing Instance: default-switch Bridging Domain: v103

Input packets : 2

Output packets: 6

Protocol inet, MTU: 1514

Max nh cache: 75000, New hold nh limit: 75000, Curr nh cnt: 1, Curr new hold cnt: 0, NH drop cnt: 0

Flags: Sendbcast-pkt-to-re, Is-Primary

Addresses, Flags: Is-Default Is-Preferred Is-Primary

Destination: 10.1.103/24, Local: 10.1.103.1, Broadcast: 10.1.103.255

Destination: 10.1.103/24, Local: 10.1.103.254, Broadcast: 10.1.103.255

Bedeutung

Die Beispielausgabe von Spine 1 überprüft Folgendes:

-

Die IRB-Schnittstellen irb.101, irb.102 und irb.103 sind konfiguriert.

-

Die physische Schnittstelle, auf der die IRB-Schnittstellen konfiguriert sind, ist betriebsbereit.

-

Jede IRB-Schnittstelle ist ihrem jeweiligen VLAN ordnungsgemäß zugeordnet.

-

Die Konfiguration jeder IRB-Schnittstelle gibt die ihr zugewiesene IP-Adresse und das Ziel (virtuelle Gateway-Adresse) korrekt wieder.

Überprüfen der Routing-Instanzen

Zweck

Stellen Sie sicher, dass die Routinginstanzen für die Server A und B sowie für die Server C und D auf Spine 1 und Spine 2 ordnungsgemäß konfiguriert sind.

Aktion

Geben Sie im Betriebsmodus den show route instance routing-instance-name extensive Befehl Routing-Instanzen serversAC und serversBD ein.

user@Spine1> show route instance serverAC extensive

serverAC:

Router ID: 10.1.101.1

Type: vrf State: Active

Interfaces:

irb.101

Route-distinguisher: 10.1.255.1:12

Vrf-import: [ __vrf-import-serverAC-internal__ ]

Vrf-export: [ __vrf-export-serverAC-internal__ ]

Vrf-import-target: [ target:65000:12 ]

Vrf-export-target: [ target:65000:12 ]

Fast-reroute-priority: low

Tables:

serverAC.inet.0 : 3 routes (3 active, 0 holddown, 0 hidden)

serverAC.iso.0 : 0 routes (0 active, 0 holddown, 0 hidden)

serverAC.inet6.0 : 1 routes (1 active, 0 holddown, 0 hidden)

serverAC.mdt.0 : 0 routes (0 active, 0 holddown, 0 hidden)

user@Spine1> show route instance serverBD extensive

serverBD:

Router ID: 10.1.102.1

Type: vrf State: Active

Interfaces:

irb.102

irb.103

Route-distinguisher: 10.1.255.1:34

Vrf-import: [ __vrf-import-serverBD-internal__ ]

Vrf-export: [ __vrf-export-serverBD-internal__ ]

Vrf-import-target: [ target:65000:34 ]

Vrf-export-target: [ target:65000:34 ]

Fast-reroute-priority: low

Tables:

serverBD.inet.0 : 6 routes (6 active, 0 holddown, 0 hidden)

serverBD.iso.0 : 0 routes (0 active, 0 holddown, 0 hidden)

serverBD.inet6.0 : 1 routes (1 active, 0 holddown, 0 hidden)

serverBD.mdt.0 : 0 routes (0 active, 0 holddown, 0 hidden)

Bedeutung

In der Beispielausgabe von Spine 1 zeigen die Routinginstanzen für die Server A und C sowie für die Server B und D die Loopback- und IRB-Schnittstellen, die jeder Gruppe zugeordnet sind. Die Ausgabe zeigt auch die tatsächliche Routenunterscheidung, den VRF-Import (Virtual Routing and Forwarding) und die Konfiguration der VRF-Exportrichtlinie.

Verifizieren des Lernens dynamischer MAC-Adressen

Zweck

Stellen Sie sicher, dass für die VLANs v101, v102 und v103 eine dynamische MAC-Adresse in den Ethernet-Switching-Tabellen auf allen Leaves installiert ist.

Aktion

Geben Sie im Betriebsmodus den show ethernet-switching table Befehl ein.

user@Leaf1> show ethernet-switching table

MAC flags (S - static MAC, D - dynamic MAC, L - locally learned, P - Persistent static

SE - statistics enabled, NM - non configured MAC, R - remote PE MAC, O - ovsdb MAC)

Ethernet switching table : 5 entries, 5 learned

Routing instance : default-switch

Vlan MAC MAC Logical SVLBNH/ Active

name address flags interface VENH Index source

v101 00:00:5e:00:01:01 DR esi.1746 05:00:00:fd:e8:00:00:00:65:00

v101 00:50:56:93:87:58 D xe-0/0/2.0

v101 00:50:56:93:ab:f6 D vtep.32770 10.1.255.13

v101 02:05:86:71:27:00 D vtep.32771 10.1.255.1

v101 02:05:86:71:5f:00 D vtep.32769 10.1.255.2

Bedeutung

Die Beispielausgabe von Leaf 1 gibt an, dass es die MAC-Adresse 00:00:5e:00:01:01 für sein virtuelles Gateway (IRB) gelernt hat. Dies ist die MAC-Adresse, die die angeschlossenen Server verwenden, um ihr Standardgateway zu erreichen. Da auf beiden Spines dieselbe virtuelle IP/MAC-Adresse konfiguriert ist, wird die virtuelle IP-Adresse als ESI-LAG behandelt, um die aktive Weiterleitung an beide Spines ohne das Risiko von Paketschleifen zu unterstützen. Die Ausgabe zeigt auch, dass Leaf 1 die IRB-MAC-Adressen für Spine 1 und Spine 2 gelernt hat, die als VTEPs fungieren.

Überprüfen von Routen in den Routing-Instanzen

Zweck

Stellen Sie sicher, dass sich die richtigen Routen in den Routing-Instanzen befinden.

Aktion

Geben Sie im Betriebsmodus den show route table routing-instance-name.inet.0 Befehl ein.

user@Spine1> show route table serverAC.inet.0

serverAC.inet.0: 3 destinations, 3 routes (3 active, 0 holddown, 0 hidden)

+ = Active Route, - = Last Active, * = Both

10.1.101.0/24 *[Direct/0] 2d 01:34:44

> via irb.101

10.1.101.1/32 *[Local/0] 2d 01:34:44

Local via irb.101

10.1.101.254/32 *[Local/0] 2d 01:34:44

Local via irb.101

user@Spine1> show route table serverBD.inet.0

serverBD.inet.0: 6 destinations, 6 routes (6 active, 0 holddown, 0 hidden)

+ = Active Route, - = Last Active, * = Both

10.1.102.0/24 *[Direct/0] 2d 01:34:51

> via irb.102

10.1.102.1/32 *[Local/0] 2d 01:34:51

Local via irb.102

10.1.102.254/32 *[Local/0] 2d 01:34:51

Local via irb.102

10.1.103.0/24 *[Direct/0] 2d 01:34:51

> via irb.103

10.1.103.1/32 *[Local/0] 2d 01:34:51

Local via irb.103

10.1.103.254/32 *[Local/0] 2d 01:34:51

Local via irb.103

Bedeutung

Die Beispielausgabe von Spine 1 gibt an, dass die Routing-Instanz für die Server A und C über die IRB-Schnittstellenrouten verfügt, die VLAN 101 zugeordnet sind, und dass die Routing-Instanz für Server B und D über die IRB-Schnittstellenrouten verfügt, die den VLANs 102 und 103 zugeordnet sind.

Anhand der Routen in den einzelnen Tabellen ist klar, dass die Server A und C in VLAN 101 die Server in C und D in den VLANs 102 oder 103 nicht erreichen können. Die Ausgabe zeigt auch, dass die gemeinsame Tabelle, die Routen für die Server B und D enthält, L3-Kommunikation über ihre IRB-Schnittstellen zulässt.

Überprüfen der Konnektivität

Zweck

Stellen Sie sicher, dass Server A und C sich gegenseitig anpingen und Server B und D sich gegenseitig anpingen können.

Aktion

Führen Sie den Ping-Befehl von den Servern aus.

user@serverA> ping 10.1.101.103 count 2 PING 10.1.101.103 (10.1.101.103): 56 data bytes 64 bytes from 10.1.101.103: icmp_seq=0 ttl=64 time=103.749 ms 64 bytes from 10.1.101.103: icmp_seq=1 ttl=64 time=116.325 ms --- 10.1.101.103 ping statistics --- 2 packets transmitted, 2 packets received, 0% packet loss round-trip min/avg/max/stddev = 103.749/110.037/116.325/6.288 ms user@serverB> ping 10.1.103.101 count 2 PING 10.1.103.101 (10.1.103.101): 56 data bytes 64 bytes from 10.1.103.101: icmp_seq=0 ttl=63 time=103.346 ms 64 bytes from 10.1.103.101: icmp_seq=1 ttl=63 time=102.355 ms --- 10.1.103.101 ping statistics --- 2 packets transmitted, 2 packets received, 0% packet loss round-trip min/avg/max/stddev = 102.355/102.851/103.346/0.495 ms

Bedeutung

Die Beispielausgabe zeigt, dass Server A Server C und Server B Server D anpingen kann. Server A und C sollten nicht in der Lage sein, Server B und D anzupingen, und Server B und D sollten nicht in der Lage sein, Server A und C anzupingen.

Spine 1 und 2: Leckage (optional)

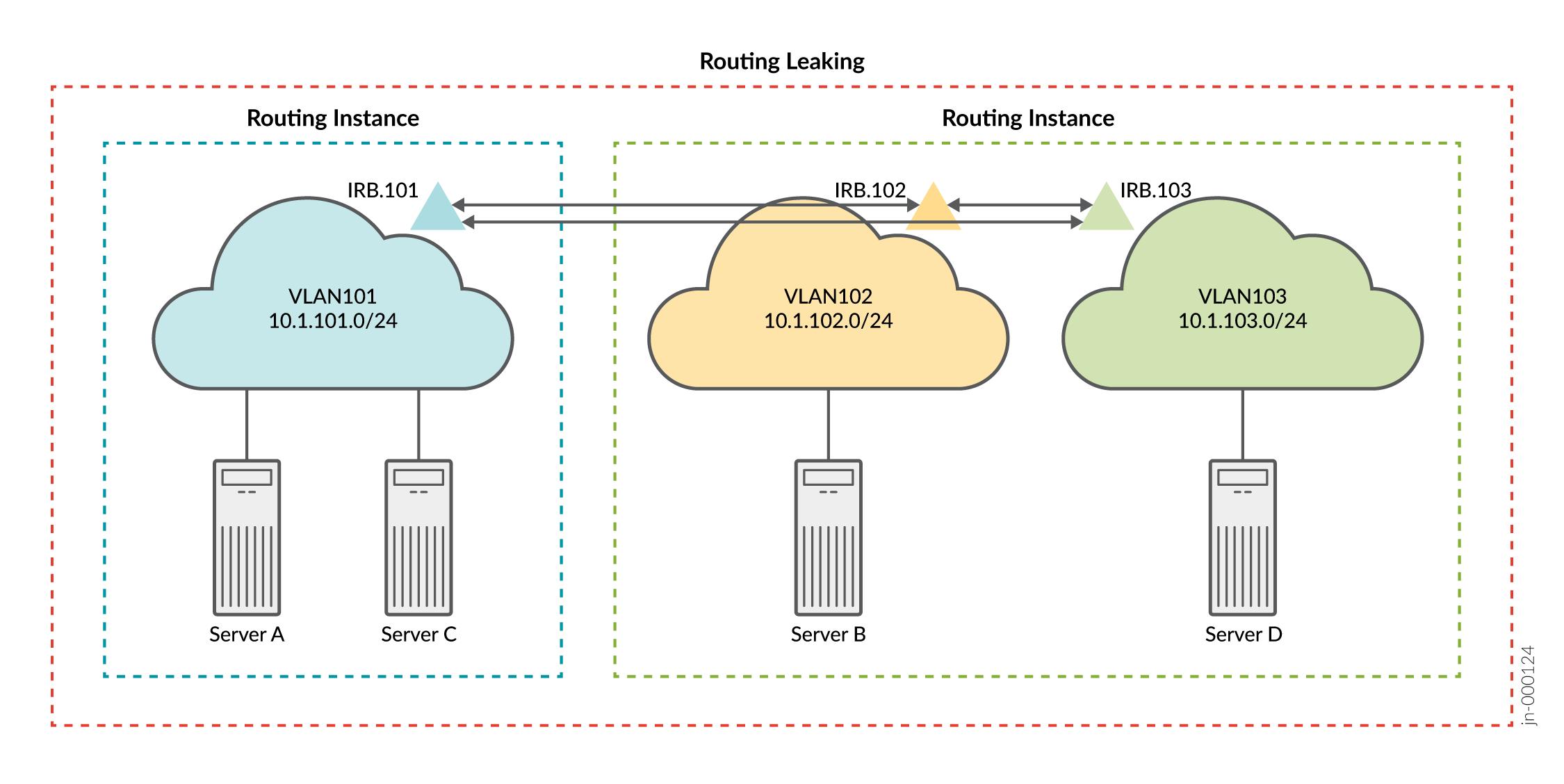

Erinnern Sie sich anhand von Abbildung 2 daran, dass Sie drei VLANs und zwei Routing-Instanzen konfiguriert haben, um Konnektivität für die Server A und C in VLAN 101 und für die Server B und D in den VLANs 102 bzw. 103 bereitzustellen. In diesem Abschnitt ändern Sie die Konfiguration, um Routen zwischen den beiden Routing-Instanzen zu verlieren. Abbildung 3 zeigt die resultierende logische Konnektivität, nachdem die IRB-Routen (Integrated Routing and Bridging) durchgesickert sind.

Mit den Änderungen Ihrer RIB-Gruppe (Routing Information Base) können Sie davon ausgehen, dass die Server in VLAN 101 die Server in den VLANs 102 und 103 über L3-Konnektivität erreichen.

CLI-Schnellkonfiguration

Zu diesem Zeitpunkt haben Sie eine CRB-basierte EVPN-Fabric bereitgestellt und die erwartete Konnektivität bestätigt. Das heißt, Server A und C können auf L2 kommunizieren. Die Server B und D (in den VLANs 102 bzw. 103) kommunizieren über IRB-Routing in ihrer gemeinsam genutzten Routing-Instanz. Was ist, wenn Sie möchten, dass sich alle Server gegenseitig anpingen können? Eine Möglichkeit, dieses Problem zu lösen, besteht darin, die Routen zwischen den Routing-Instanzen preiszugeben. Weitere Informationen zu ungenutzten Routen zwischen virtuellen Routing- und Weiterleitungsinstanzen (VRF) finden Sie unter Automatischer Export . Um dieses Beispiel schnell zu konfigurieren, kopieren Sie die folgenden Befehle, fügen Sie die Befehle in eine Textdatei ein, entfernen Sie alle Zeilenumbrüche, ändern Sie alle Details, die für Ihre Konfiguration erforderlich sind, kopieren Sie die Befehle und fügen Sie sie in die CLI auf Hierarchieebene ein, und geben Sie dann den Befehl aus dem [edit] Konfigurationsmodus ein commit .

set policy-options policy-statement serverAC_vrf_imp term 1 from community serverBD set policy-options policy-statement serverAC_vrf_imp term 1 then accept set policy-options policy-statement serverBD_vrf_imp term 1 from community serverAC set policy-options policy-statement serverBD_vrf_imp term 1 then accept set policy-options community serverAC members target:65000:13 set policy-options community serverBD members target:65000:24 set routing-instances serverAC routing-options auto-export set routing-instances serverAC vrf-import serverAC_vrf_imp set routing-instances serverBD routing-options auto-export set routing-instances serverBD vrf-import serverBD_vrf_imp

Verifizierung mit Route Leaking (optional)

- Verifizieren von Routen mit undichten Routen (optional)

- Überprüfen der Konnektivität mit Routenlecks (optional)

Verifizieren von Routen mit undichten Routen (optional)

Zweck

Stellen Sie sicher, dass sich die richtigen Routen in den Routing-Instanzen befinden.

Aktion

Geben Sie im Betriebsmodus den show route table routing-instance-name.inet.0 Befehl ein.

user@Spine1> show route table serverAC.inet.0

serverAC.inet.0: 9 destinations, 9 routes (9 active, 0 holddown, 0 hidden)

+ = Active Route, - = Last Active, * = Both

10.1.101.0/24 *[Direct/0] 2d 02:18:50

> via irb.101

10.1.101.1/32 *[Local/0] 2d 02:18:50

Local via irb.101

10.1.101.254/32 *[Local/0] 2d 02:18:50

Local via irb.101

10.1.102.0/24 *[Direct/0] 00:31:21

> via irb.102

10.1.102.1/32 *[Local/0] 00:31:21

Local via irb.102

10.1.102.254/32 *[Local/0] 00:31:21

Local via irb.102

10.1.103.0/24 *[Direct/0] 00:31:21

> via irb.103

10.1.103.1/32 *[Local/0] 00:31:21

Local via irb.103

10.1.103.254/32 *[Local/0] 00:31:21

Local via irb.103

user@Spine1> show route table serverBD.inet.0

serverBD.inet.0: 9 destinations, 9 routes (9 active, 0 holddown, 0 hidden)

+ = Active Route, - = Last Active, * = Both

10.1.101.0/24 *[Direct/0] 00:32:00

> via irb.101

10.1.101.1/32 *[Local/0] 00:32:00

Local via irb.101

10.1.101.254/32 *[Local/0] 00:32:00

Local via irb.101

10.1.102.0/24 *[Direct/0] 2d 02:19:29

> via irb.102

10.1.102.1/32 *[Local/0] 2d 02:19:29

Local via irb.102

10.1.102.254/32 *[Local/0] 2d 02:19:29

Local via irb.102

10.1.103.0/24 *[Direct/0] 2d 02:19:29

> via irb.103

10.1.103.1/32 *[Local/0] 2d 02:19:29

Local via irb.103

10.1.103.254/32 *[Local/0] 2d 02:19:29

Local via irb.103

Bedeutung

Die Beispielausgabe von Spine 1 zeigt, dass beide Routing-Instanzen jetzt über die integrierten Routing- und Bridging-Schnittstellenrouten (IRB) verfügen, die allen drei VLANs zugeordnet sind. Da Sie Routen zwischen den Instanztabellen kopiert haben, ist das Nettoergebnis dasselbe, als ob Sie alle drei VLANs in einer gemeinsamen Routing-Instanz konfiguriert hätten. Daher können Sie in allen drei VLANs eine vollständige L3-Konnektivität zwischen Servern erwarten.

Überprüfen der Konnektivität mit Routenlecks (optional)

Zweck

Stellen Sie sicher, dass Server A und C die Server B und D anpingen können.

Aktion

Führen Sie den Ping-Befehl von den Servern aus.

user@serverA> ping 10.1.102.101 count 2 PING 10.1.102.101 (10.1.102.101): 56 data bytes 64 bytes from 10.1.102.101: icmp_seq=0 ttl=63 time=102.448 ms 64 bytes from 10.1.102.101: icmp_seq=1 ttl=63 time=102.384 ms --- 10.1.102.101 ping statistics --- 2 packets transmitted, 2 packets received, 0% packet loss round-trip min/avg/max/stddev = 102.384/102.416/102.448/0.032 ms user@serverA> ping 10.1.103.101 count 2 PING 10.1.103.101 (10.1.103.101): 56 data bytes 64 bytes from 10.1.103.101: icmp_seq=0 ttl=63 time=103.388 ms 64 bytes from 10.1.103.101: icmp_seq=1 ttl=63 time=102.623 ms --- 10.1.103.101 ping statistics --- 2 packets transmitted, 2 packets received, 0% packet loss round-trip min/avg/max/stddev = 102.623/103.006/103.388/0.382 ms user@serverC> ping 10.1.102.101 count 2 PING 10.1.102.101 (10.1.102.101): 56 data bytes 64 bytes from 10.1.102.101: icmp_seq=0 ttl=63 time=167.580 ms 64 bytes from 10.1.102.101: icmp_seq=1 ttl=63 time=168.075 ms --- 10.1.102.101 ping statistics --- 2 packets transmitted, 2 packets received, 0% packet loss round-trip min/avg/max/stddev = 167.580/167.827/168.075/0.248 ms user@serverC> ping 10.1.103.101 count 2 PING 10.1.103.101 (10.1.103.101): 56 data bytes 64 bytes from 10.1.103.101: icmp_seq=0 ttl=63 time=103.673 ms 64 bytes from 10.1.103.101: icmp_seq=1 ttl=63 time=115.090 ms --- 10.1.103.101 ping statistics --- 2 packets transmitted, 2 packets received, 0% packet loss round-trip min/avg/max/stddev = 103.673/109.382/115.090/5.709 ms

Bedeutung

Die Beispielausgabe zeigt, dass Server A Server B und Server D anpingen kann. Es zeigt auch, dass Server C Server B und Server D anpingen kann. Dies bestätigt die erwartete vollständige Konnektivität zwischen den Servern und ihren VLANs.

Tabelle "Änderungshistorie"

Die Funktionsunterstützung hängt von der Plattform und der Version ab, die Sie verwenden. Verwenden Sie den Feature-Explorer , um festzustellen, ob ein Feature auf Ihrer Plattform unterstützt wird.