Como configurar uma spine colapsada com multihoming EVPN

Requisitos

Este exemplo pressupõe que você tenha dois data centers (DC1 e DC2) com redes separadas. Este exemplo usa os seguintes dispositivos e software:

DC1:

Dois switches spine: QFX5120-48Y executando o Junos OS Release 18.4R2-S1.4

Dois switches ToR: EX4300-48T executando o Junos OS Release 18.1R3-S6.1

Dois dispositivos de segurança: dispositivos SRX345 que executam o Junos OS Release 18.2R3.4 (configuração complementar opcional)

Quatro servidores

DC2:

Dois switches spine: QFX5120-48Y executando o Junos OS Release 18.4R2-S1.4

Dois switches ToR: EX4300-48T executando o Junos OS Release 18.1R3-S6.1

Dois servidores

Cada par de switches ToR já deve ser configurado como um Virtual Chassis. Veja entenda o Virtual Chassis da Série EX para obter mais informações sobre a formação de um Virtual Chassis com switches EX4300. Esta configuração de exemplo usa links Ethernet agregados de multihoming entre o ToR Virtual Chassis e os dois dispositivos spine em apenas um membro no Virtual Chassis. Se possível, para uma melhor resiliência, você pode conectar os links Ethernet agregados multihoming entre o Virtual Chassis e os dispositivos spine usando interfaces de diferentes membros do Virtual Chassis.

Visão geral

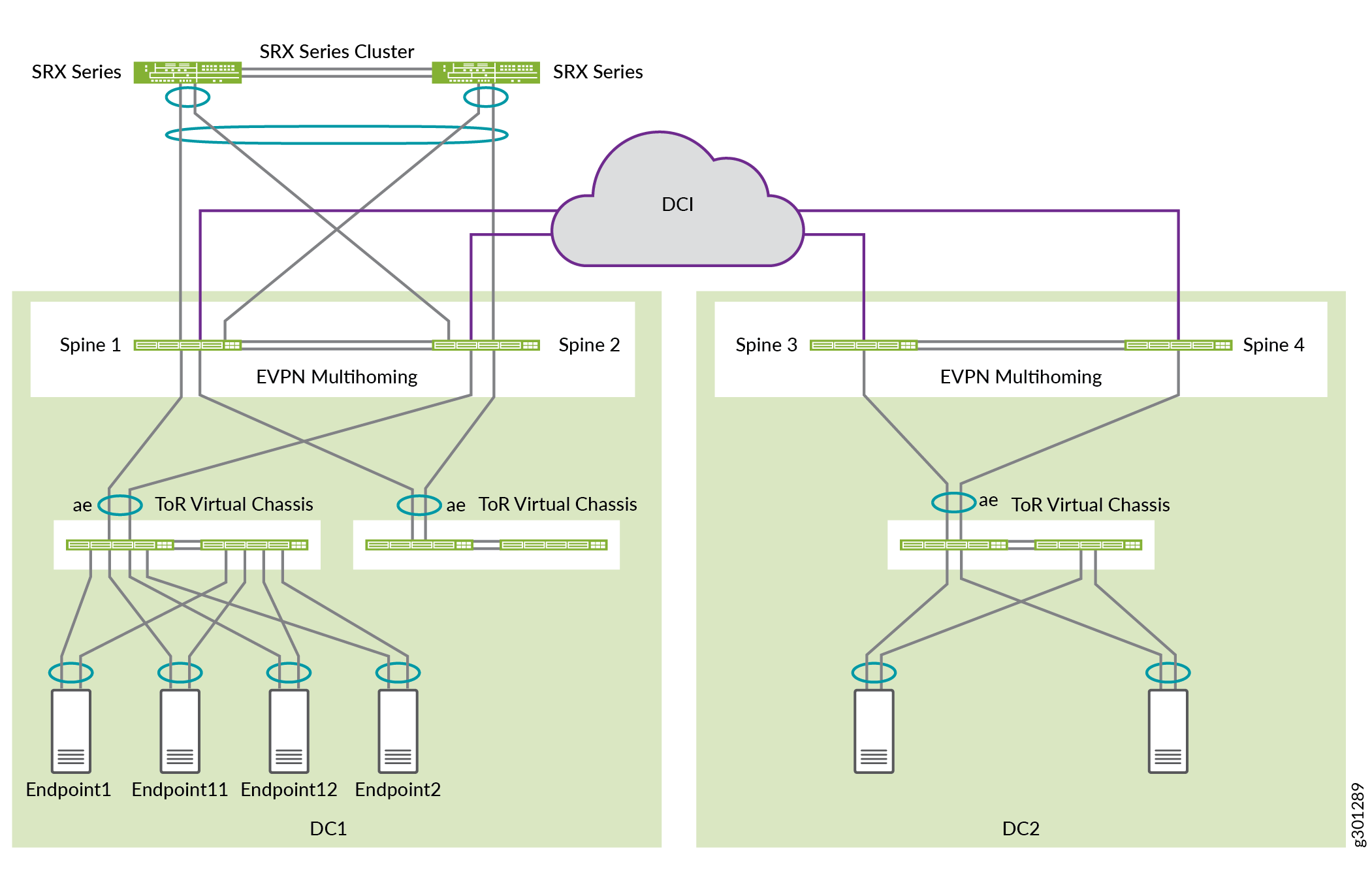

Use este exemplo para configurar uma arquitetura spine colapsada com multihoming EVPN dos switches ToR. Temos dois data centers com uma configuração opcional de Interconexão de Data Center (DCI), um cluster SRX opcional para maior segurança e uma configuração opcional de retransmissão DHCP. Este exemplo de configuração mostra como configurar essa arquitetura em DC1. Você pode usar uma configuração semelhante em DC2.

Topologia

Nesta implantação, existem dois data centers: DC1 e DC2. As redes de data center estão configuradas com uma arquitetura spine colapsada usando QFX5120 como switches spine. Neste caso, recomendamos que você limite a malha EVPN-VXLAN ao data center local.

Você pode conectar opcionalmente os data centers usando DCI de Camada 3 no underlay. Este caso de uso não requer alongamento de Camada 2 entre os data centers. O tráfego entre data centers é apenas de Camada 3 e é roteado pelo cluster SRX em DC1 para inspeção avançada.

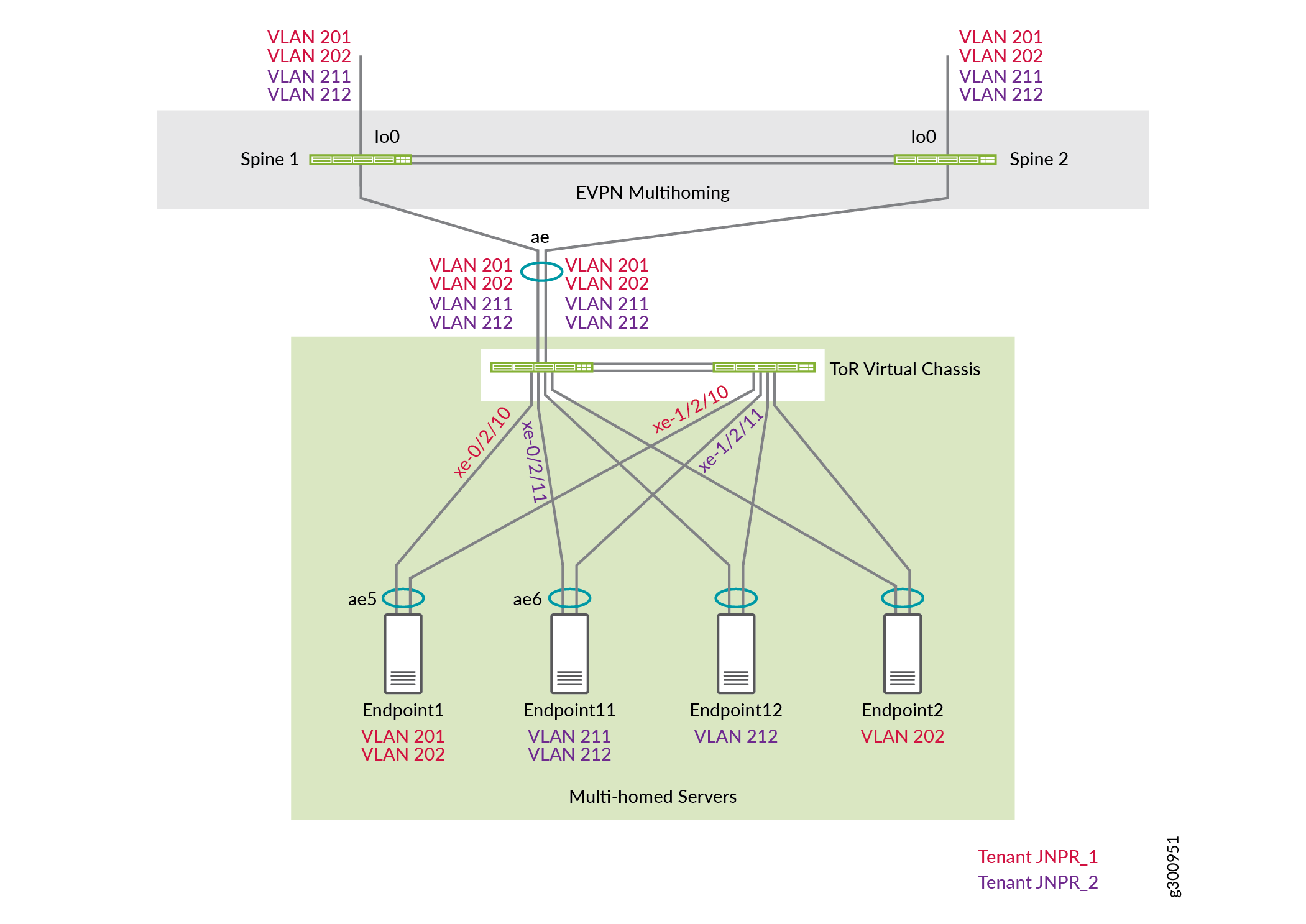

A Figura 1 mostra a conectividade lógica entre os componentes usados nesta NCE.

Há dois locatários em DC1: JNPR1 e JNPR2. Qualquer tráfego entre locatários entre o JNPR1 e o JNPR2 em DC1 é roteado pelo cluster de firewall SRX para segurança.

DC1:

As VLANs 201 e 202 pertencem à JNPR1.

As VLANs 211 e 212 pertencem à JNPR2.

O DC1 tem servidores em VLANs 201, 202, 211 e 212.

DC2:

As VLANs 221 e 222 pertencem ao locatário padrão, que é o mesmo que a instância de roteamento padrão.

O DC2 tem servidores em VLANs 221 e 222.

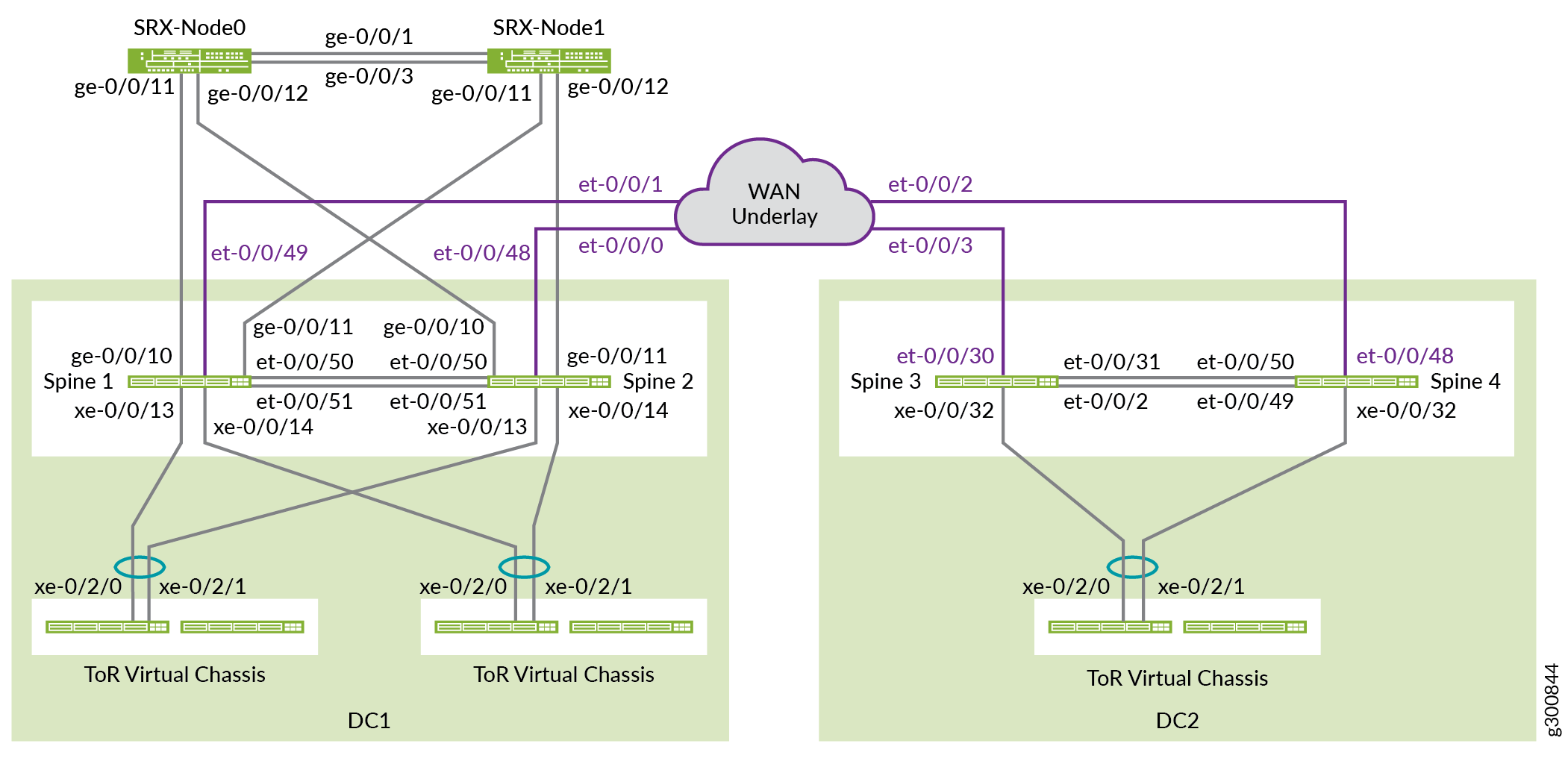

A Figura 2 mostra a conectividade física entre os componentes usados nesta NCE.

física

física

Antes de começar

Você precisa implementar alguma configuração básica em seus dispositivos antes de configurar a malha.

Procedimento

Procedimento passo a passo

Por padrão, nenhuma interface Ethernet agregada é criada. Você deve definir o número de interfaces Ethernet agregadas antes de configurá-las. Depois de definir a contagem de dispositivos, o sistema cria esse número de interfaces Ethernet agregadas vazias, cada uma com um endereço MAC globalmente único. Você pode criar interfaces Ethernet mais agregadas aumentando a contagem de dispositivos para o número de interfaces ESI-LAG necessárias no dispositivo.

Defina o número de interfaces Ethernet agregadas em todos os switches spine e ToR.

set chassis aggregated-devices ethernet device-count 15

As portas de 0 a 47 em um QFX5120-48Y operam como portas de 10 gigabits por padrão. Os dispositivos SRX oferecem suporte a apenas 1 gigabit. Configure as portas no Spine 1 e Spine 2 que estão conectadas ao firewall da Série SRX para portas de 1 gigabit. Neste caso, essas portas são ge-0/0/10 e ge-0/0/11. Para habilitar 1 gigabit nessas portas, configure a velocidade da primeira porta no quad, que neste caso é ge-0/0/8.

Use a declaração a seguir sobre Spine 1 e Spine 2:

set chassis fpc 0 pic 0 port 8 speed 1G

Nota:Você pode configurar as velocidades de porta de 1 gigabit e 25 gigabits apenas por quad (grupo de quatro portas) e não individualmente. Todas as portas operam em uma única velocidade dentro do quad. Por exemplo, se você configurar portas de 8 a 11 para operar como portas Ethernet de 1 gigabit e inserir um transceptor SFP+ de 10 gigabits na porta 10, uma interface não será criada para esta porta.

O modo de detecção de velocidade automática detecta interfaces Ethernet de 100 gigabits e interfaces Ethernet de 40 gigabits e as canaliza automaticamente. A canalização automática e a detecção de velocidade são habilitadas por padrão. Neste exemplo, a canalização automática dividiria cada interface Ethernet de 40 gigabits em quatro interfaces Ethernet de 10 gigabits.

Desabilitar a canalização automática em portas et-0/0/2 e et-0/31 no Spine 3 e portas et-0/0/49 e et-0/0/50 no Spine 4 para que permaneçam interfaces Ethernet de 40 gigabits.

Spine 3:

set chassis fpc 0 pic 0 port 2 channel-speed disable-auto-speed-detection set chassis fpc 0 pic 0 port 31 channel-speed disable-auto-speed-detection

Spine 4:

set chassis fpc 0 pic 0 port 49 channel-speed disable-auto-speed-detection set chassis fpc 0 pic 0 port 50 channel-speed disable-auto-speed-detection

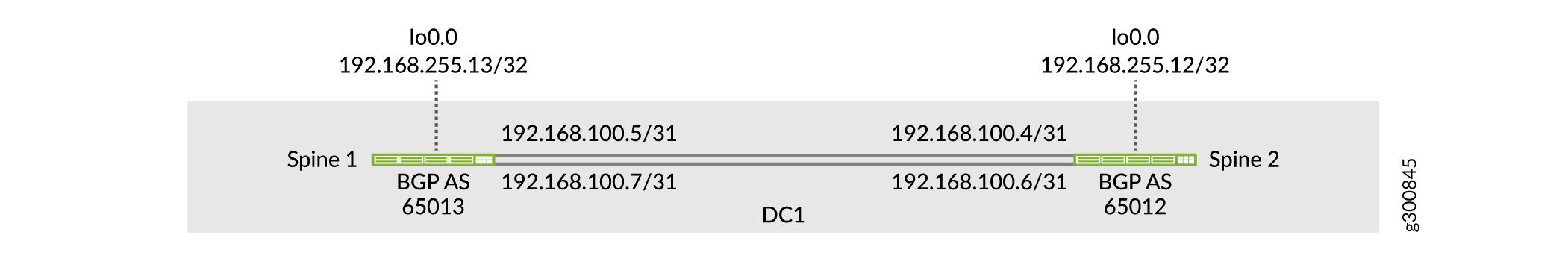

Configure a underlay

Nesta topologia, a malha de IP é apenas entre os dois switches spine, como mostrado na Figura 3. Os dois switches spine estabelecem o peering EBGP sobre os links ponto a ponto para trocar endereços de loopback entre si.

da malha ip

da malha ip

Configure a Spine 1

Procedimento passo a passo

Configure as interfaces no Spine 1.

set interfaces et-0/0/50 description "* connected to DC1-Spine2" set interfaces et-0/0/50 traps set interfaces et-0/0/50 mtu 9216 set interfaces et-0/0/50 unit 0 family inet address 192.168.100.5/31 set interfaces et-0/0/51 description "* connected to DC1-Spine2" set interfaces et-0/0/51 traps set interfaces et-0/0/51 mtu 9216 set interfaces et-0/0/51 unit 0 family inet address 192.168.100.7/31 set interfaces lo0 unit 0 description "** DC1 Spine1 Loopback" set interfaces lo0 unit 0 family inet address 192.168.255.13/32

Configure o underlay do EBGP.

set protocols bgp log-updown set protocols bgp graceful-restart restart-time 30 set protocols bgp group UNDERLAY type external set protocols bgp group UNDERLAY description "Connection to EBGP UNDERLAY" set protocols bgp group UNDERLAY import UNDERLAY-IMPORT set protocols bgp group UNDERLAY family inet unicast set protocols bgp group UNDERLAY authentication-key "$ABC123" set protocols bgp group UNDERLAY export UNDERLAY-EXPORT set protocols bgp group UNDERLAY local-as 65013 set protocols bgp group UNDERLAY multipath multiple-as set protocols bgp group UNDERLAY neighbor 192.168.100.4 peer-as 65012 set protocols bgp group UNDERLAY neighbor 192.168.100.6 peer-as 65012

Configure as políticas de importação e exportação.

set policy-options policy-statement UNDERLAY-EXPORT term LOOPBACK from route-filter 192.168.255.0/24 orlonger set policy-options policy-statement UNDERLAY-EXPORT term LOOPBACK then accept set policy-options policy-statement UNDERLAY-EXPORT term DEFAULT then reject set policy-options policy-statement UNDERLAY-IMPORT term LOOPBACK from route-filter 192.168.255.0/24 orlonger set policy-options policy-statement UNDERLAY-IMPORT term LOOPBACK then accept set policy-options policy-statement UNDERLAY-IMPORT term DEFAULT then reject

Habilite a proteção rápida de redirecionamento ECMP e ECMP. Habilite o balanceamento de carga por fluxo, o que você faz com a

per-packetpalavra-chave.set policy-options policy-statement ECMP-POLICY then load-balance per-packet set routing-options forwarding-table export ECMP-POLICY

Se um link cair, o ECMP usa uma proteção de redirecionamento rápido para transferir o encaminhamento de pacotes para links operacionais, o que diminui a perda de pacotes. A proteção de redirecionamento rápido atualiza os conjuntos de ECMP para a interface sem precisar esperar a atualização da tabela de rotas. Quando a próxima atualização da tabela de rota ocorre, um novo conjunto de ECMP pode ser adicionado com menos links, ou a rota pode apontar para um único salto seguinte.

set routing-options forwarding-table ecmp-fast-reroute

Por padrão, o tempor de envelhecimento de ARP é definido em 20 minutos e o tempor de envelhecimento MAC é definido em 5 minutos. Para evitar problemas de sincronização com entradas de ligação MAC e MAC-IP em um ambiente EVPN-VXLAN, configure o envelhecimento do ARP para ser mais rápido do que o envelhecimento mac.

set system arp aging-timer 5 set protocols l2-learning global-mac-ip-table-aging-time 300 set protocols l2-learning global-mac-table-aging-time 600

Configure a Spine 2

Procedimento passo a passo

Repita a configuração do Spine 1 na Spine 2.

Configure as interfaces no Spine 2.

set interfaces et-0/0/50 description "* connected to DC1-Spine1" set interfaces et-0/0/50 traps set interfaces et-0/0/50 mtu 9216 set interfaces et-0/0/50 unit 0 family inet address 192.168.100.4/31 set interfaces et-0/0/51 description "* connected to DC1-Spine1" set interfaces et-0/0/51 traps set interfaces et-0/0/51 mtu 9216 set interfaces et-0/0/51 unit 0 family inet address 192.168.100.6/31 set interfaces lo0 unit 0 description "** DC1 Spine2 Loopback" set interfaces lo0 unit 0 family inet address 192.168.255.12/32

Configure o underlay do EBGP.

set protocols bgp log-updown set protocols bgp graceful-restart restart-time 30 set protocols bgp group UNDERLAY type external set protocols bgp group UNDERLAY description "EBGP UNDERLAY" set protocols bgp group UNDERLAY import UNDERLAY-IMPORT set protocols bgp group UNDERLAY family inet unicast set protocols bgp group UNDERLAY authentication-key "$ABC123" set protocols bgp group UNDERLAY export UNDERLAY-EXPORT set protocols bgp group UNDERLAY local-as 65012 set protocols bgp group UNDERLAY multipath multiple-as set protocols bgp group UNDERLAY neighbor 192.168.100.5 peer-as 65013 set protocols bgp group UNDERLAY neighbor 192.168.100.7 peer-as 65013

Configure as políticas de importação e exportação.

set policy-options policy-statement UNDERLAY-EXPORT term LOOPBACK from route-filter 192.168.255.0/24 orlonger set policy-options policy-statement UNDERLAY-EXPORT term LOOPBACK then accept set policy-options policy-statement UNDERLAY-EXPORT term DEFAULT then reject set policy-options policy-statement UNDERLAY-IMPORT term LOOPBACK from route-filter 192.168.255.0/24 orlonger set policy-options policy-statement UNDERLAY-IMPORT term LOOPBACK then accept set policy-options policy-statement UNDERLAY-IMPORT term DEFAULT then reject

Habilite a proteção rápida de redirecionamento ECMP e ECMP.

set policy-options policy-statement ECMP-POLICY then load-balance per-packet set routing-options forwarding-table export ECMP-POLICY set routing-options forwarding-table ecmp-fast-reroute

Para evitar problemas de sincronização com entradas de ligação MAC e MAC-IP em um ambiente EVPN-VXLAN, configure o envelhecimento do ARP para ser mais rápido do que o envelhecimento mac.

set system arp aging-timer 5 set protocols l2-learning global-mac-ip-table-aging-time 300 set protocols l2-learning global-mac-table-aging-time 600

Verifique o Underlay

Procedimento passo a passo

Verifique se ambas as sessões de vizinhos BGP estão estabelecidas no Spine 1.

user@spine1> show bgp neighbor 192.168.100.4 Peer: 192.168.100.4+179 AS 65012 Local: 192.168.100.5+51424 AS 65013 Description: Connection to EBGP UNDERLAY Group: UNDERLAY Routing-Instance: master Forwarding routing-instance: master Type: External State: Established Flags: <Sync> Last State: OpenConfirm Last Event: RecvKeepAlive Last Error: Cease Export: [ UNDERLAY-EXPORT ] Import: [ UNDERLAY-IMPORT ] . . .

user@spine1> show bgp neighbor 192.168.100.6 Peer: 192.168.100.6+59705 AS 65012 Local: 192.168.100.7+179 AS 65013 Description: Connection to EBGP UNDERLAY Group: UNDERLAY Routing-Instance: master Forwarding routing-instance: master Type: External State: Established Flags: <Sync> Last State: OpenConfirm Last Event: RecvKeepAlive Last Error: Cease Export: [ UNDERLAY-EXPORT ] Import: [ UNDERLAY-IMPORT ] . . .

Verifique se o endereço de loopback do Spine 2 (192.168.255.12) é recebido pelo Spine 1 de ambas as sessões vizinhas do BGP.

user@spine1> show route receive-protocol bgp 192.168.100.4 inet.0: 17 destinations, 25 routes (17 active, 0 holddown, 0 hidden) Restart Complete Prefix Nexthop MED Lclpref AS path * 192.168.255.12/32 192.168.100.4 65012 I . . .

user@spine1> show route receive-protocol bgp 192.168.100.6 inet.0: 17 destinations, 25 routes (17 active, 0 holddown, 0 hidden) Restart Complete Prefix Nexthop MED Lclpref AS path 192.168.255.12/32 192.168.100.6 65012 I

user@spine1> show route 192.168.255.12 inet.0: 17 destinations, 25 routes (17 active, 0 holddown, 0 hidden) Restart Complete + = Active Route, - = Last Active, * = Both 192.168.255.12/32 *[BGP/170] 00:39:43, localpref 100, from 192.168.100.4 AS path: 65012 I, validation-state: unverified to 192.168.100.4 via et-0/0/50.0 > to 192.168.100.6 via et-0/0/51.0 [BGP/170] 00:39:43, localpref 100 AS path: 65012 I, validation-state: unverified > to 192.168.100.6 via et-0/0/51.0Ping o loopback do outro dispositivo spine do Spine 1.

user@spine1> ping 192.168.255.12 source 192.168.255.13 PING 192.168.255.12 (192.168.255.12): 56 data bytes 64 bytes from 192.168.255.12: icmp_seq=0 ttl=64 time=0.746 ms 64 bytes from 192.168.255.12: icmp_seq=1 ttl=64 time=0.699 ms 64 bytes from 192.168.255.12: icmp_seq=2 ttl=64 time=0.784 ms

Configure o Overlay

Esta seção mostra como configurar o overlay. Ele inclui peerings IBGP e mapeamentos VLAN para VXLAN para as redes virtuais.

Configure a Spine 1

Procedimento passo a passo

Configure o peering do IBGP entre os endereços de loopback Spine 1 e Spine 2.

set protocols bgp group EVPN_FABRIC type internal set protocols bgp group EVPN_FABRIC local-address 192.168.255.13 set protocols bgp group EVPN_FABRIC family evpn signaling set protocols bgp group EVPN_FABRIC authentication-key "$ABC123" set protocols bgp group EVPN_FABRIC local-as 65100 set protocols bgp group EVPN_FABRIC multipath set protocols bgp group EVPN_FABRIC bfd-liveness-detection minimum-interval 1000 set protocols bgp group EVPN_FABRIC bfd-liveness-detection multiplier 3 set protocols bgp group EVPN_FABRIC neighbor 192.168.255.12 set protocols bgp group EVPN_FABRIC vpn-apply-export

Configure as VLANs e VLAN para o mapeamento VXLAN.

set vlans VLAN-201 description "jnpr_1 - bridge domain id 201" set vlans VLAN-201 vlan-id 201 set vlans VLAN-201 vxlan vni 5201 set vlans VLAN-202 description "jnpr_1 - bridge domain id 202" set vlans VLAN-202 vlan-id 202 set vlans VLAN-202 vxlan vni 5202 set vlans VLAN-211 description "jnpr_2 - bridge domain id 211" set vlans VLAN-211 vlan-id 211 set vlans VLAN-211 vxlan vni 5211 set vlans VLAN-212 description "jnpr_2 - bridge domain id 212" set vlans VLAN-212 vlan-id 212 set vlans VLAN-212 vxlan vni 5212

Configure as seguintes opções de switch:

A interface de origem do endpoint de túnel virtual (VTEP). Este é o endereço de loopback no Spine 1.

O diferencial de rota para rotas geradas por este dispositivo.

O alvo da rota.

set switch-options vtep-source-interface lo0.0 set switch-options route-distinguisher 192.168.255.13:1 set switch-options vrf-target target:1:999 set switch-options vrf-target auto

O alvo de rota configurado sob

vrf-targeté usado por rotas EVPN tipo 1. As rotas EVPN tipo 2 e Tipo 3 usam a meta de rota por VNI derivada automaticamente para exportação e importação.Configure o protocolo EVPN. Primeiro, configure o VXLAN como o encapsulamento do plano de dados para EVPN.

set protocols evpn encapsulation vxlan

Em seguida, configure as VNIs que fazem parte deste domínio MP-BGP EVPN-VXLAN. Use

set protocols evpn extended-vni-list allpara configurar todas as VNIs ou configurar cada VNI separadamente, conforme mostrado abaixo.set protocols evpn extended-vni-list 5201 set protocols evpn extended-vni-list 5202 set protocols evpn extended-vni-list 5211 set protocols evpn extended-vni-list 5212

Se o data center tiver apenas dois switches spine que tenham apenas sessões de vizinhos BGP entre si, você deve desabilitar o isolamento do núcleo em ambos os switches spine. Caso contrário, se um switch spine cair, o outro switch spine perde todas as sessões de vizinhos BGP, o que coloca as portas voltadas para ToR no modo de espera LACP e resulta em perda completa de tráfego. Veja o estado e a compreensão de quando desativar o isolamento do núcleo EVPN-VXLAN para obter mais informações.

set protocols evpn no-core-isolation

Configure a Spine 2

Procedimento passo a passo

Para evitar problemas de sincronização com entradas de ligação MAC e MAC-IP em um ambiente EVPN-VXLAN, configure o envelhecimento do ARP para ser mais rápido do que o envelhecimento mac.

set system arp aging-timer 5 set protocols l2-learning global-mac-ip-table-aging-time 300 set protocols l2-learning global-mac-table-aging-time 600

Configure o peering do IBGP.

set protocols bgp group EVPN_FABRIC type internal set protocols bgp group EVPN_FABRIC local-address 192.168.255.12 set protocols bgp group EVPN_FABRIC family evpn signaling set protocols bgp group EVPN_FABRIC authentication-key "$ABC123" set protocols bgp group EVPN_FABRIC local-as 65100 set protocols bgp group EVPN_FABRIC multipath set protocols bgp group EVPN_FABRIC bfd-liveness-detection minimum-interval 1000 set protocols bgp group EVPN_FABRIC bfd-liveness-detection multiplier 3 set protocols bgp group EVPN_FABRIC neighbor 192.168.255.13 set protocols bgp group EVPN_FABRIC vpn-apply-export

Configure as VLANs e VLAN para o mapeamento VXLAN.

set vlans VLAN-201 description "jnpr_1 - bridge domain id 201" set vlans VLAN-201 vlan-id 201 set vlans VLAN-201 vxlan vni 5201 set vlans VLAN-202 description "jnpr_1 - bridge domain id 202" set vlans VLAN-202 vlan-id 202 set vlans VLAN-202 vxlan vni 5202 set vlans VLAN-211 description "jnpr_2 - bridge domain id 211" set vlans VLAN-211 vlan-id 211 set vlans VLAN-211 vxlan vni 5211 set vlans VLAN-212 description "jnpr_2 - bridge domain id 212" set vlans VLAN-212 vlan-id 212 set vlans VLAN-212 vxlan vni 5212

Configure as seguintes opções de switch.

set switch-options vtep-source-interface lo0.0 set switch-options route-distinguisher 192.168.255.12:1 set switch-options vrf-target target:1:999 set switch-options vrf-target auto

Configure o protocolo EVPN.

set protocols evpn encapsulation vxlan

Em seguida, configure as VNIs que fazem parte deste domínio MP-BGP EVPN-VXLAN. Use

set protocols evpn extended-vni-list allpara configurar todas as VNIs ou configurar cada VNI separadamente, conforme mostrado abaixo.set protocols evpn extended-vni-list 5201 set protocols evpn extended-vni-list 5202 set protocols evpn extended-vni-list 5211 set protocols evpn extended-vni-list 5212

Se o data center tiver apenas dois switches spine que têm apenas sessões de vizinhos BGP entre si, você deve desabilitar o isolamento do núcleo em ambos os switches spine.

set protocols evpn no-core-isolation

Verifique o Overlay

Procedimento passo a passo

Verifique se o peering do IBGP entre Spine 1 e Spine 2 está estabelecido.

user@spine1> show bgp neighbor 192.168.255.12 Peer: 192.168.255.12+179 AS 65100 Local: 192.168.255.13+62666 AS 65100 Description: Overlay neighbor with peer Group: EVPN_FABRIC Routing-Instance: master Forwarding routing-instance: master Type: Internal State: Established Flags:<Sync> Last State: OpenConfirm Last Event: RecvKeepAlive Last Error: Hold Timer Expired Error Options: <Preference LocalAddress HoldTime AuthKey GracefulRestart LogUpDown AddressFamily Multipath LocalAS Rib-group Refresh> Authentication key is configured Address families configured: evpn

Verifique o VTEP de origem para o domínio EVPN.

user@spine1> show ethernet-switching vxlan-tunnel-end-point source Logical System Name Id SVTEP-IP IFL L3-Idx SVTEP-Mode <default> 0 192.168.255.13 lo0.0 0 L2-RTT Bridge Domain VNID MC-Group-IP default-switch VLAN-201+201 5201 0.0.0.0 default-switch VLAN-202+202 5202 0.0.0.0 default-switch VLAN-211+211 5211 0.0.0.0 default-switch VLAN-212+212 5212 0.0.0.0Verifique todos os VTEP de origem e VTEPs remotos.

user@spine1> show interfaces vtep Physical interface: vtep, Enabled, Physical link is Up Interface index: 641, SNMP ifIndex: 506 Type: Software-Pseudo, Link-level type: VxLAN-Tunnel-Endpoint, MTU: Unlimited, Speed: Unlimited Device flags : Present Running Link type : Full-Duplex Link flags : None Last flapped : Never Input packets : 0 Output packets: 0 Logical interface vtep.32768 (Index 545) (SNMP ifIndex 548) Flags: Up SNMP-Traps 0x4000 Encapsulation: ENET2 VXLAN Endpoint Type: Source, VXLAN Endpoint Address: 192.168.255.13, L2 Routing Instance: default-switch, L3 Routing Instance: default Input packets : 0 Output packets: 0 Logical interface vtep.32769 (Index 560) (SNMP ifIndex 550) Flags: Up SNMP-Traps Encapsulation: ENET2 VXLAN Endpoint Type: Remote, VXLAN Endpoint Address: 192.168.255.12, L2 Routing Instance: default-switch, L3 Routing Instance: default Input packets : 9140 Output packets: 0 Protocol eth-switch, MTU: Unlimited Flags: Trunk-Mode

Configure e segmente a Camada 3

Configure a Spine 1

Procedimento passo a passo

Configure opções de roteamento e encaminhamento.

Nota:Mudar as opções de roteamento e encaminhamento, como

next-hop,overlay-ecmpouchained-composite-next-hopfazer com que o Mecanismo de encaminhamento de pacotes seja reiniciado, o que interrompe todas as operações de encaminhamento.Definir o número de próximos saltos para pelo menos o número esperado de entradas ARP na sobreposição. Consulte next-hop (roteamento VXLAN) para obter mais informações sobre a configuração

vxlan-routing next-hop.Habilite um próximo salto multicaminho de dois níveis de igual custo usando a

overlay-ecmpdeclaração. Essa declaração é necessária para uma rede de sobreposição EVPN-VXLAN de Camada 3 quando o roteamento tipo 5 puro também está configurado. Recomendamos fortemente que você configure esta declaração quando as rotas tipo 5 puras estiverem habilitadas.A

chained-composite-next-hopconfiguração é essencial para o tipo 5 puro de EVPN com encapsulamento VXLAN. Sem isso, o PFE não configurará o próximo salto do túnel.Configure o ID do roteador para ser o mesmo que o endereço IP de loopback usado como fonte VTEP e o endereço local BGP overlay.

set forwarding-options vxlan-routing next-hop 32768 set forwarding-options vxlan-routing overlay-ecmp set routing-options forwarding-table chained-composite-next-hop ingress evpn set routing-options router-id 192.168.255.13

Para habilitar a função de gateway padrão, configure interfaces IRB cada uma com um endereço IP exclusivo e um endereço de gateway virtual (VGA), que deve ser um endereço IPcast qualquer. Quando você especifica um endereço IPv4 para a VGA, o gateway VXLAN de Camada 3 gera automaticamente 00:00:5e:00:01:01 como endereço MAC. Este exemplo mostra como configurar manualmente o endereço MAC do gateway virtual. Configure o mesmo endereço MAC de gateway virtual em ambos os dispositivos spine para um determinado IRB.

Nota:Se o endereço IP VGA for menor que o endereço IP IRB, você deve usar a opção

preferredna configuração IRB, conforme mostrado neste exemplo.set interfaces irb unit 201 virtual-gateway-accept-data set interfaces irb unit 201 description "** L3 interface for VLAN-201 in jnpr_1" set interfaces irb unit 201 family inet address 192.168.201.3/24 virtual-gateway-address 192.168.201.1 set interfaces irb unit 201 family inet address 192.168.201.3/24 preferred set interfaces irb unit 201 virtual-gateway-v4-mac 3c:8c:93:2e:20:01 set vlans VLAN-201 l3-interface irb.201 set interfaces irb unit 202 virtual-gateway-accept-data set interfaces irb unit 202 description "** L3 interface for VLAN-202 in jnpr_1" set interfaces irb unit 202 family inet address 192.168.202.3/24 virtual-gateway-address 192.168.202.1 set interfaces irb unit 202 family inet address 192.168.202.3/24 preferred set interfaces irb unit 202 virtual-gateway-v4-mac 3c:8c:93:2e:20:02 set vlans VLAN-202 l3-interface irb.202 set interfaces irb unit 211 virtual-gateway-accept-data set interfaces irb unit 211 description "** L3 interface for VLAN-211 in jnpr_2" set interfaces irb unit 211 family inet address 192.168.211.3/24 virtual-gateway-address 192.168.211.1 set interfaces irb unit 211 family inet address 192.168.211.3/24 preferred set interfaces irb unit 211 virtual-gateway-v4-mac 3c:8c:93:2e:21:11 set vlans VLAN-211 l3-interface irb.211 set interfaces irb unit 212 virtual-gateway-accept-data set interfaces irb unit 212 description "** L3 interface for VLAN-212 in jnpr_2" set interfaces irb unit 212 family inet address 192.168.212.3/24 virtual-gateway-address 192.168.212.1 set interfaces irb unit 212 family inet address 192.168.212.3/24 preferred set interfaces irb unit 212 virtual-gateway-v4-mac 3c:8c:93:2e:21:12 set vlans VLAN-212 l3-interface irb.212

Você configurará os mesmos endereços IRB IP e MACcast nas interfaces IRB de cada dispositivo spine. Como os dispositivos spine agem como dispositivos spine e leaf em uma arquitetura spine colapsada, eles são os únicos dispositivos que precisam saber sobre as interfaces IRB. Desabile o anúncio das interfaces IRB para os outros dispositivos.

set protocols evpn default-gateway do-not-advertise

Coloque as IRBs pertencentes aos diferentes locatários em suas respectivas instâncias de roteamento. Isso permite que as IRBs nas mesmas instâncias de roteamento compartilhem uma tabela de roteamento. Como resultado, as IRBs em uma instância de roteamento podem rotear entre si. As IRBs em diferentes instâncias de roteamento podem se comunicar entre si, seja por meio de um agente externo de políticas de segurança, como firewalls SRX, ou se vazarmos explicitamente rotas entre as instâncias de roteamento.

set routing-instances JNPR_1_VRF description "VRF for tenant jnpr_1" set routing-instances JNPR_1_VRF instance-type vrf set routing-instances JNPR_1_VRF interface irb.201 set routing-instances JNPR_1_VRF interface irb.202 set routing-instances JNPR_1_VRF vrf-table-label set routing-instances JNPR_1_VRF routing-options multipath set routing-instances JNPR_2_VRF description "VRF for tenant jnpr_2" set routing-instances JNPR_2_VRF instance-type vrf set routing-instances JNPR_2_VRF interface irb.211 set routing-instances JNPR_2_VRF interface irb.212 set routing-instances JNPR_2_VRF vrf-table-label set routing-instances JNPR_2_VRF routing-options multipath

Configure o VNI tipo 5 para as instâncias de roteamento. Ao configurar uma instância de roteamento para EVPN-VXLAN, você deve incluir uma interface de loopback e seu endereço IP. Se você omitir a interface de loopback e o endereço IP associado, os pacotes de controle de EVPN não poderão ser processados.

set routing-instances JNPR_1_VRF protocols evpn ip-prefix-routes advertise direct-nexthop set routing-instances JNPR_1_VRF protocols evpn ip-prefix-routes encapsulation vxlan set routing-instances JNPR_1_VRF protocols evpn ip-prefix-routes vni 1101 set routing-instances JNPR_1_VRF protocols evpn ip-prefix-routes export T5_EXPORT set routing-instances JNPR_2_VRF protocols evpn ip-prefix-routes advertise direct-nexthop set routing-instances JNPR_2_VRF protocols evpn ip-prefix-routes encapsulation vxlan set routing-instances JNPR_2_VRF protocols evpn ip-prefix-routes vni 1102 set routing-instances JNPR_2_VRF protocols evpn ip-prefix-routes export T5_EXPORT set interfaces lo0 unit 1 description "Tenant 1 T5 Loopback" set interfaces lo0 unit 1 family inet address 192.168.255.21/32 set routing-instances JNPR_1_VRF interface lo0.1 set interfaces lo0 unit 2 description "Tenant 2 T5 Loopback" set interfaces lo0 unit 2 family inet address 192.168.255.22/32 set routing-instances JNPR_2_VRF interface lo0.2 set policy-options policy-statement T5_EXPORT term 1 from protocol direct set policy-options policy-statement T5_EXPORT term 1 then accept set policy-options policy-statement T5_EXPORT term 2 from protocol bgp set policy-options policy-statement T5_EXPORT term 2 then accept

Configure a Spine 2

Procedimento passo a passo

Configure opções de roteamento e encaminhamento.

Nota:Mudar as opções de roteamento e encaminhamento, como

next-hop,overlay-ecmpouchained-composite-next-hopfazer com que o Mecanismo de encaminhamento de pacotes seja reiniciado, o que interrompe todas as operações de encaminhamento.set forwarding-options vxlan-routing next-hop 32768 set forwarding-options vxlan-routing overlay-ecmp set routing-options forwarding-table chained-composite-next-hop ingress evpn set routing-options router-id 192.168.255.12

Configure IRB.

set interfaces irb unit 201 virtual-gateway-accept-data set interfaces irb unit 201 description "** L3 interface for VLAN-201 in jnpr_1" set interfaces irb unit 201 family inet address 192.168.201.2/24 virtual-gateway-address 192.168.201.1 set interfaces irb unit 201 family inet address 192.168.201.2/24 preferred set interfaces irb unit 201 virtual-gateway-v4-mac 3c:8c:93:2e:20:01 set vlans VLAN-201 l3-interface irb.201 set interfaces irb unit 202 virtual-gateway-accept-data set interfaces irb unit 202 description "** L3 interface for VLAN-202 in jnpr_1" set interfaces irb unit 202 family inet address 192.168.202.2/24 virtual-gateway-address 192.168.202.1 set interfaces irb unit 202 family inet address 192.168.202.2/24 preferred set interfaces irb unit 202 virtual-gateway-v4-mac 3c:8c:93:2e:20:02 set vlans VLAN-202 l3-interface irb.202 set interfaces irb unit 211 virtual-gateway-accept-data set interfaces irb unit 211 description "** L3 interface for VLAN-211 in jnpr_2" set interfaces irb unit 211 family inet address 192.168.211.2/24 virtual-gateway-address 192.168.211.1 set interfaces irb unit 211 family inet address 192.168.211.2/24 preferred set interfaces irb unit 211 virtual-gateway-v4-mac 3c:8c:93:2e:21:11 set vlans VLAN-211 l3-interface irb.211 set interfaces irb unit 212 virtual-gateway-accept-data set interfaces irb unit 212 description "** L3 interface for VLAN-212 in jnpr_2" set interfaces irb unit 212 family inet address 192.168.212.2/24 virtual-gateway-address 192.168.212.1 set interfaces irb unit 212 family inet address 192.168.212.2/24 preferred set interfaces irb unit 212 virtual-gateway-v4-mac 3c:8c:93:2e:21:12 set vlans VLAN-212 l3-interface irb.212

Como você configurou os mesmos endereços IRB IP e MACcast nas interfaces IRB de ambos os switches spine, desabite o anúncio das interfaces IRB para outros dispositivos.

set protocols evpn default-gateway do-not-advertise

Coloque as IRBs pertencentes aos diferentes locatários em suas respectivas instâncias de roteamento.

set routing-instances JNPR_1_VRF description "VRF for tenant jnpr_1" set routing-instances JNPR_1_VRF instance-type vrf set routing-instances JNPR_1_VRF interface irb.201 set routing-instances JNPR_1_VRF interface irb.202 set routing-instances JNPR_1_VRF vrf-table-label set routing-instances JNPR_1_VRF routing-options multipath set routing-instances JNPR_2_VRF description "VRF for tenant jnpr_2" set routing-instances JNPR_2_VRF instance-type vrf set routing-instances JNPR_2_VRF interface irb.211 set routing-instances JNPR_2_VRF interface irb.212 set routing-instances JNPR_2_VRF vrf-table-label set routing-instances JNPR_2_VRF routing-options multipath

Configure o VNI tipo 5 para as instâncias de roteamento.

set routing-instances JNPR_1_VRF protocols evpn ip-prefix-routes advertise direct-nexthop set routing-instances JNPR_1_VRF protocols evpn ip-prefix-routes encapsulation vxlan set routing-instances JNPR_1_VRF protocols evpn ip-prefix-routes vni 1101 set routing-instances JNPR_1_VRF protocols evpn ip-prefix-routes export T5_EXPORT set routing-instances JNPR_2_VRF protocols evpn ip-prefix-routes advertise direct-nexthop set routing-instances JNPR_2_VRF protocols evpn ip-prefix-routes encapsulation vxlan set routing-instances JNPR_2_VRF protocols evpn ip-prefix-routes vni 1102 set routing-instances JNPR_2_VRF protocols evpn ip-prefix-routes export T5_EXPORT set interfaces lo0 unit 101 description "Tenant 1 T5 Loopback" set interfaces lo0 unit 101 family inet address 192.168.255.31/32 set routing-instances JNPR_1_VRF interface lo0.101 set interfaces lo0 unit 102 description "Tenant 2 T5 Loopback" set interfaces lo0 unit 102 family inet address 192.168.255.32/32 set routing-instances JNPR_2_VRF interface lo0.102 set policy-options policy-statement T5_EXPORT term 1 from protocol direct set policy-options policy-statement T5_EXPORT term 1 then accept set policy-options policy-statement T5_EXPORT term 2 from protocol bgp set policy-options policy-statement T5_EXPORT term 2 then accept

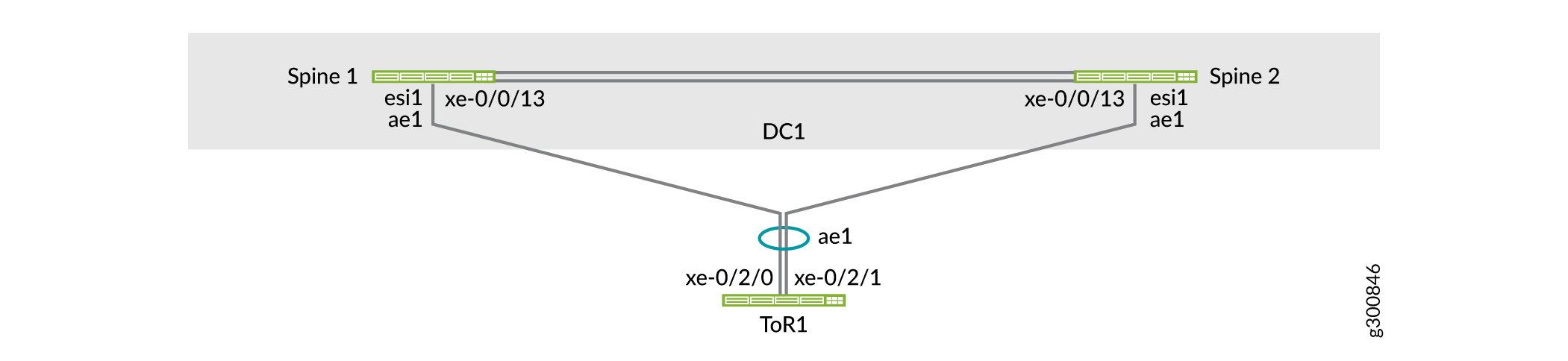

Configure o multihoming EVPN para os switches ToR

O multihoming EVPN usa ESIs. Um ESI é um atributo obrigatório que permite o multihoming de servidor EVPN LAG. Os valores de ESI são codificados como inteiros de 10 byte e são usados para identificar um segmento multihomed. O mesmo valor de ESI habilitado em todos os switches spine conectados a um switch ToR forma um EVPN LAG. Este EVPN LAG oferece suporte a multihoming ativo em direção ao switch ToR.

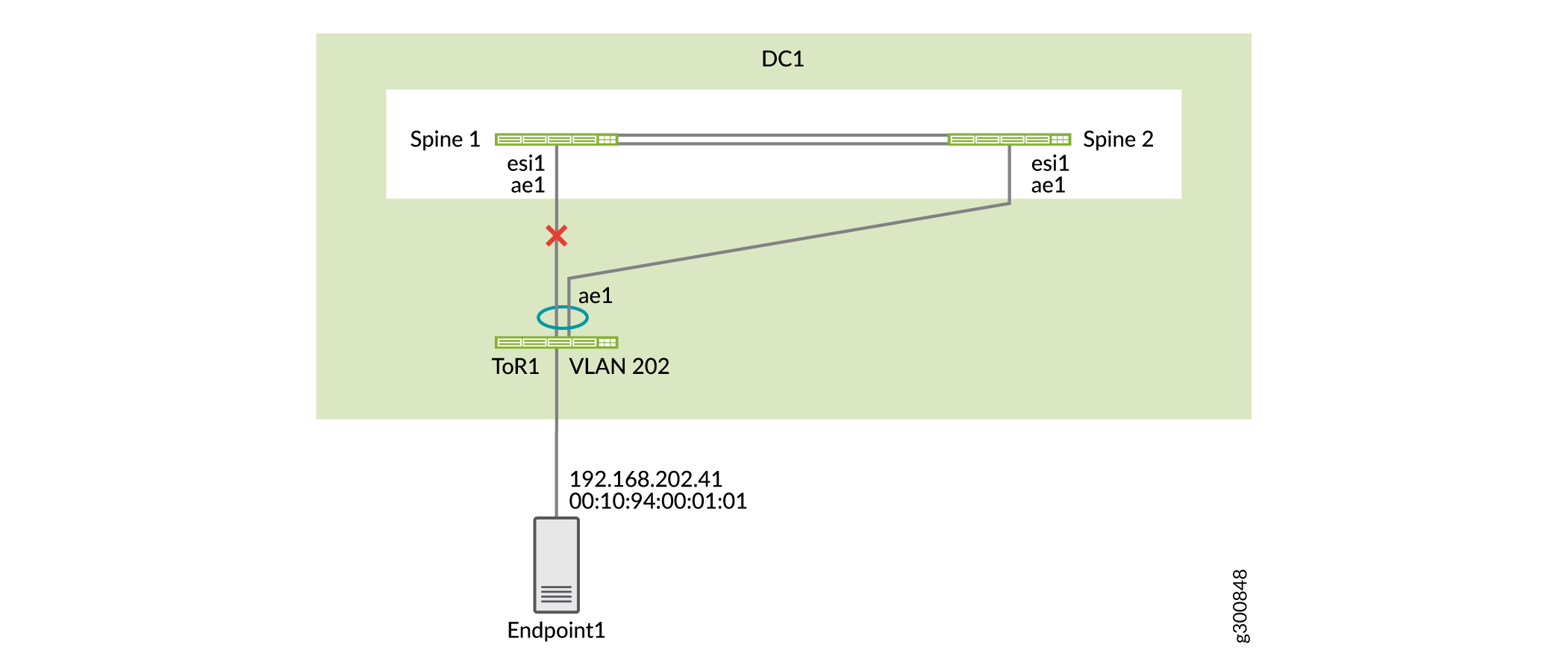

Os switches ToR (implementados como ToR Virtual Chassis neste exemplo) usam um LAG para se conectar aos dois switches spine. Como mostrado na Figura 4, o ToR1 está conectado aos switches spine com LAG ae1. Esse LAG nos switches spine é habilitado pelo recurso de multihoming EVPN.

Configure a Spine 1

Procedimento passo a passo

Por padrão, as interfaces Ethernet agregadas não são criadas. Você deve definir o número de interfaces Ethernet agregadas no switch antes de configurá-las.

set chassis aggregated-devices ethernet device-count 15 set interfaces ae1 description "to ToR1" set interfaces ae1 mtu 9216

Configure uma ESI. Configure o mesmo em ambos os switches spine. Habilite modos totalmente ativos.

set interfaces ae1 esi 00:00:00:00:00:00:00:00:01:01 set interfaces ae1 esi all-active set interfaces ae1 aggregated-ether-options link-speed 10g set interfaces ae1 aggregated-ether-options lacp active set interfaces ae1 aggregated-ether-options lacp periodic fast

Nota:Você também pode derivar automaticamente a ESI. Neste exemplo, você configura manualmente a ESI.

Configure o ID do sistema LACP. Configure o mesmo em ambos os switches spine para indicar aos switches ToR que os uplinks para os dois switches spine pertencem ao mesmo pacote LAG. Como resultado, os switches ToR coloca os uplinks para os dois switches spine no mesmo pacote LAG e a carga compartilha tráfego entre os links dos membros.

set interfaces ae1 aggregated-ether-options lacp system-id 00:00:00:00:01:01 set interfaces ae1 unit 0 family ethernet-switching interface-mode trunk set interfaces ae1 unit 0 family ethernet-switching vlan members VLAN-201 set interfaces ae1 unit 0 family ethernet-switching vlan members VLAN-202 set interfaces ae1 unit 0 family ethernet-switching vlan members VLAN-211 set interfaces ae1 unit 0 family ethernet-switching vlan members VLAN-212

Configure a interface física no Spine 1 conectado ao ToR 1 como um membro do ae1 LAG.

set interfaces xe-0/0/13 ether-options 802.3ad ae1

Configure a Spine 2

Procedimento passo a passo

Defina o número de interfaces Ethernet agregadas no switch.

set chassis aggregated-devices ethernet device-count 15 set interfaces ae1 description "to ToR1" set interfaces ae1 mtu 9216

Configure uma ESI. Configure o mesmo em ambos os switches spine. Habilite modos totalmente ativos.

set interfaces ae1 esi 00:00:00:00:00:00:00:00:01:01 set interfaces ae1 esi all-active set interfaces ae1 aggregated-ether-options link-speed 10g set interfaces ae1 aggregated-ether-options lacp active set interfaces ae1 aggregated-ether-options lacp periodic fast

Configure o ID do sistema LACP. Configure o mesmo em ambos os switches spine.

set interfaces ae1 aggregated-ether-options lacp system-id 00:00:00:00:01:01 set interfaces ae1 unit 0 family ethernet-switching interface-mode trunk set interfaces ae1 unit 0 family ethernet-switching vlan members VLAN-201 set interfaces ae1 unit 0 family ethernet-switching vlan members VLAN-202 set interfaces ae1 unit 0 family ethernet-switching vlan members VLAN-211 set interfaces ae1 unit 0 family ethernet-switching vlan members VLAN-212

Configure a interface física no Spine 2 conectado ao ToR 1 como um membro do ae1 LAG.

set interfaces xe-0/0/13 ether-options 802.3ad ae1

Configure o ToR 1

Procedimento passo a passo

Por padrão, as interfaces Ethernet agregadas não são criadas. Você deve definir o número de interfaces Ethernet agregadas no switch antes de configurá-las.

set chassis aggregated-devices ethernet device-count 4

Configure as interfaces Ethernet agregadas.

set interfaces xe-0/2/0 ether-options 802.3ad ae1 set interfaces xe-0/2/1 ether-options 802.3ad ae1 set interfaces ae1 aggregated-ether-options lacp active set interfaces ae1 unit 0 family ethernet-switching interface-mode trunk set interfaces ae1 unit 0 family ethernet-switching vlan members VLAN-201 set interfaces ae1 unit 0 family ethernet-switching vlan members VLAN-202 set interfaces ae1 unit 0 family ethernet-switching vlan members VLAN-211 set interfaces ae1 unit 0 family ethernet-switching vlan members VLAN-212

Configure as VLANs.

set vlans VLAN-201 vlan-id 201 set vlans VLAN-202 vlan-id 202 set vlans VLAN-211 vlan-id 211 set vlans VLAN-212 vlan-id 212

Verificar multihoming EVPN

Procedimento passo a passo

Verifique o status do ae1 e do ESI associados ao LAG.

user@spine1> show interfaces ae1 Physical interface: ae1, Enabled, Physical link is Up Interface index: 689, SNMP ifIndex: 552 Description: to ToR1 Link-level type: Ethernet, MTU: 9216, Speed: 10Gbps, BPDU Error: None, Ethernet-Switching Error: None, MAC-REWRITE Error: None, Loopback: Disabled, Source filtering: Disabled, Flow control: Disabled, Minimum links needed: 1, Minimum bandwidth needed: 1bps Device flags : Present Running Interface flags: SNMP-Traps Internal: 0x4000 Current address: 3c:8c:93:2e:a9:80, Hardware address: 3c:8c:93:2e:a9:80 Ethernet segment value: 00:00:00:00:00:00:00:00:01:01, Mode: all-active Last flapped : 2019-11-10 14:50:49 PST (00:26:56 ago) Input rate : 624 bps (0 pps) Output rate : 936 bps (1 pps) ...

Verifique se os membros da ae1 estão coletando e distribuindo.

user@spine1> show lacp interfaces ae1 Aggregated interface: ae1 LACP state: Role Exp Def Dist Col Syn Aggr Timeout Activity xe-0/0/13 Actor No No Yes Yes Yes Yes Fast Active xe-0/0/13 Partner No No Yes Yes Yes Yes Fast Active LACP protocol: Receive State Transmit State Mux State xe-0/0/13 Current Fast periodic Collecting distributingVerifique se o status do Multihoming EVPN na instância EVPN está

Resolvedno Spine 1. Você também pode ver qual switch spine é o encaminhamento designado para tráfego BUM.user@spine1> show evpn instance extensive Instance: __default_evpn__ Route Distinguisher: 192.168.255.13:0 Number of bridge domains: 0 Number of neighbors: 1 Address MAC MAC+IP AD IM ES Leaf-label 192.168.255.12 0 0 0 0 2 Instance: default-switch Route Distinguisher: 192.168.255.13:1 Encapsulation type: VXLAN Duplicate MAC detection threshold: 5 Duplicate MAC detection window: 180 MAC database status Local Remote MAC advertisements: 6 10 MAC+IP advertisements: 10 10 Default gateway MAC advertisements: 8 0 Number of local interfaces: 5 (3 up) Interface name ESI Mode Status AC-Role .local..6 00:00:00:00:00:00:00:00:00:00 single-homed Up Root ae1.0 00:00:00:00:00:00:00:00:01:01 all-active Up Root ... Number of neighbors: 1 Address MAC MAC+IP AD IM ES Leaf-label 192.168.255.12 10 10 8 4 0 Number of ethernet segments: 10 ESI: 00:00:00:00:00:00:00:00:01:01 Status: Resolved by IFL ae1.0 Local interface: ae1.0, Status: Up/Forwarding Number of remote PEs connected: 1 Remote PE MAC label Aliasing label Mode 192.168.255.12 5212 0 all-active DF Election Algorithm: MOD based Designated forwarder: 192.168.255.13 Backup forwarder: 192.168.255.12 Last designated forwarder update: Nov 10 14:50:49Verifique se todos os links de membros da interface ae1 estão coletando e distribuindo no ToR 1.

user@tor1> show lacp interfaces Aggregated interface: ae1 LACP state: Role Exp Def Dist Col Syn Aggr Timeout Activity xe-0/2/0 Actor No No Yes Yes Yes Yes Fast Active xe-0/2/0 Partner No No Yes Yes Yes Yes Fast Active xe-0/2/1 Actor No No Yes Yes Yes Yes Fast Active xe-0/2/1 Partner No No Yes Yes Yes Yes Fast Active LACP protocol: Receive State Transmit State Mux State xe-0/2/0 Current Fast periodic Collecting distributing xe-0/2/1 Current Fast periodic Collecting distributing

Configure o multihoming para os servidores

Multihome os servidores para o ToR Virtual Chassis para redundância e compartilhamento de carga. Os servidores usam LAG para se conectar aos dois switches de membros do ToR Virtual Chassis.

Como mostrado na Figura 5, o Endpoint 1 está conectado ao ToR Virtual Chassis por meio do LAG ae5 e pertence ao locatário JNPR_1. O Endpoint 11 está conectado ao ToR Virtual Chassis por lag ae6 e pertence ao locatário JNPR_2.

de servidor multihomed

de servidor multihomed

Configure o ToR 1

Procedimento passo a passo

Como os switches ToR estão configurados em um Virtual Chassis, você só precisa confirmar a configuração no switch principal. Neste exemplo, o ToR 1 é o switch principal.

Configure o LAG nas interfaces conectadas ao Endpoint 1: interface xe-0/2/10 no ToR 1 e interface xe-1/2/10 no ToR 2. O Endpoint 1 pertence às VLANs 201 e 202.

set interfaces xe-0/2/10 ether-options 802.3ad ae5 set interfaces xe-1/2/10 ether-options 802.3ad ae5 set interfaces ae5 aggregated-ether-options lacp active set interfaces ae5 description "Connected to Endpoint1" set interfaces ae5 unit 0 family ethernet-switching interface-mode trunk set interfaces ae5 unit 0 family ethernet-switching vlan members VLAN-201 set interfaces ae5 unit 0 family ethernet-switching vlan members VLAN-202

Configure o LAG nas interfaces conectadas ao Endpoint 11. O endpoint 11 pertence às VLANs 211 e 212.

set interfaces xe-0/2/11 ether-options 802.3ad ae6 set interfaces xe-1/2/11 ether-options 802.3ad ae6 set interfaces ae6 aggregated-ether-options lacp active set interfaces ae6 description "Connected to Endpoint11" set interfaces ae6 unit 0 family ethernet-switching interface-mode trunk set interfaces ae6 unit 0 family ethernet-switching vlan members VLAN-211 set interfaces ae6 unit 0 family ethernet-switching vlan members VLAN-212

Verifique a conectividade do servidor

Use esta seção para verificar se os servidores estão conectados entre si por meio dos switches ToR e spine. Como você faz isso depende se eles fazem parte da mesma VLAN ou duas VLANs diferentes.

Recomendamos a multihoming de seus servidores para os switches ToR para redundância e compartilhamento de carga, conforme descrito na seção anterior. Esta seção mostra servidores de casa única para simplicidade.

- Verifique a conectividade do servidor intra-VLAN

- Verifique a conectividade entre servidores VLAN

- O que vem a seguir

Verifique a conectividade do servidor intra-VLAN

Procedimento passo a passo

Verifique se os endereços MAC de ambos os endpoints aparecem na tabela de comutação Ethernet em ambos os switches ToR.

user@tor1> show ethernet-switching table MAC flags (S - static MAC, D - dynamic MAC, L - locally learned, P - Persistent static, C - Control MAC SE - statistics enabled, NM - non configured MAC, R - remote PE MAC, O - ovsdb MAC) Ethernet switching table : 4 entries, 4 learned Routing instance : default-switch Vlan MAC MAC Age Logical NH RTR name address flags interface Index ID VLAN-201 f4:b5:2f:40:9f:01 D - ae1.0 0 0 VLAN-202 00:10:94:00:01:01 D - xe-0/2/2.0 0 0 VLAN-202 00:10:94:00:01:02 D - ae1.0 0 0 VLAN-202 3c:8c:93:2e:a8:c0 D - ae1.0 0 0user@tor2> show ethernet-switching table MAC flags (S - static MAC, D - dynamic MAC, L - locally learned, P - Persistent static, C - Control MAC SE - statistics enabled, NM - non configured MAC, R - remote PE MAC, O - ovsdb MAC) Ethernet switching table : 4 entries, 4 learned Routing instance : default-switch Vlan MAC MAC Age Logical NH RTR name address flags interface Index ID VLAN-201 f4:b5:2f:40:9f:01 D - ae1.0 0 0 VLAN-202 00:10:94:00:01:01 D - xe-0/2/2.0 0 0 VLAN-202 00:10:94:00:01:02 D - ae1.0 0 0 VLAN-202 3c:8c:93:2e:a8:c0 D - ae1.0 0 0Verifique se os dois endereços MAC aparecem na tabela de comutação Ethernet em ambos os switches spine. Os dois endereços MAC são aprendidos com os switches ToR no LAG (ae1 e ae2) conectados a cada switch ToR. As bandeiras

DLMAC ,DReDLRindicam se o tráfego para o endereço MAC foi aprendido localmente pelo switch spine, pelo switch spine remoto, ou por ambos os switches spine.user@spine1> show ethernet-switching table vlan-id 202 MAC flags (S - static MAC, D - dynamic MAC, L - locally learned, P - Persistent static SE - statistics enabled, NM - non configured MAC, R - remote PE MAC, O - ovsdb MAC) Ethernet switching table : 4 entries, 4 learned Routing instance : default-switch Vlan MAC MAC Logical Active name address flags interface source VLAN-202 00:00:5e:00:01:01 DR esi.1723 05:00:00:fe:4c:00:00:14:52:00 VLAN-202 00:10:94:00:01:01 DR ae1.0 VLAN-202 00:10:94:00:01:02 DL ae2.0 VLAN-202 3c:8c:93:2e:da:c0 D vtep.32769 192.168.255.12user@spine2> show ethernet-switching table vlan-id 202 MAC flags (S - static MAC, D - dynamic MAC, L - locally learned, P - Persistent static SE - statistics enabled, NM - non configured MAC, R - remote PE MAC, O - ovsdb MAC) Ethernet switching table : 4 entries, 4 learned Routing instance : default-switch Vlan MAC MAC Logical Active name address flags interface source VLAN-202 00:00:5e:00:01:01 DR esi.1723 05:00:00:fe:4c:00:00:14:52:00 VLAN-202 00:10:94:00:01:01 DR ae1.0 VLAN-202 00:10:94:00:01:02 DL ae2.0 VLAN-202 3c:8c:93:2e:da:c0 D vtep.32769 192.168.255.12Verifique se o primeiro endereço MAC está no banco de dados EVPN no Spine 1. Essa saída indica que o endereço MAC foi aprendido localmente por este switch spine por meio da ESI 00:00:00:00:00:00:00:01:02 e LAG ae2. Este endereço MAC é anunciado na EVPN para o outro switch spine.

user@spine1> show evpn database mac-address 00:10:94:00:01:02 extensive Instance: default-switch VN Identifier: 5202, MAC address: 00:10:94:00:01:02 State: 0x0 Source: 00:00:00:00:00:00:00:00:01:02, Rank: 1, Status: Active Local origin: ae2.0 Mobility sequence number: 0 (minimum origin address 192.168.255.13) Timestamp: Nov 10 16:48:41 (0x5dc8afe9) State: <Local-MAC-Only Local-To-Remote-Adv-Allowed> MAC advertisement route status: Created History db: Time Event Nov 10 16:48:41 2019 Updating output state (change flags 0x20 <ESI-Added>) Nov 10 16:48:41 2019 Active ESI changing (not assigned -> 00:00:00:00:00:00:00:00:01:02) Nov 10 16:48:41 2019 Creating all output state Nov 10 16:48:41 2019 Creating MAC advertisement route Nov 10 16:48:41 2019 Adding to instance ESI list Nov 10 16:48:41 2019 Clearing change flags <ESI-Added> Nov 10 16:48:41 2019 Clearing change flags <Intf ESI-Local-State> Nov 10 16:48:42 2019 Updating output state (change flags 0x0) Nov 10 16:48:42 2019 Active ESI unchanged (00:00:00:00:00:00:00:00:01:02) Nov 10 16:48:42 2019 Updating output state (change flags 0x0)Verifique se o segundo endereço MAC está no banco de dados EVPN no Spine 1. Este endereço MAC foi aprendido pelo switch spine remoto e anunciado para o switch spine local sobre EVPN. Essa saída também mostra que este endereço MAC é mapeado para ESI 00:00:00:00:00:00:00:01:01:01. O tráfego destinado a este endereço MAC pode ser trocado localmente para ToR 1 usando o mesmo segmento Ethernet.

user@spine1> show evpn database mac-address 00:10:94:00:01:01 extensive Instance: default-switch VN Identifier: 5202, MAC address: 00:10:94:00:01:01 State: 0x0 Source: 00:00:00:00:00:00:00:00:01:01, Rank: 1, Status: Active Remote origin: 192.168.255.12 Mobility sequence number: 0 (minimum origin address 192.168.255.12) Timestamp: Nov 10 16:48:41 (0x5dc8afe9) State: <Remote-To-Local-Adv-Done> MAC advertisement route status: Not created (no local state present) History db: Time Event Nov 10 16:48:41 2019 Adding to instance ESI list Nov 10 16:48:41 2019 Clearing change flags <ESI-Added> Nov 10 16:48:41 2019 Clearing change flags <ESI-Peer-Added ESI-Remote-Peer-Com-Chg> Nov 10 16:48:42 2019 Updating output state (change flags 0x0) Nov 10 16:48:42 2019 Active ESI unchanged (00:00:00:00:00:00:00:00:01:01) Nov 10 16:48:42 2019 Updating output state (change flags 0x0) Nov 10 16:48:42 2019 Advertisement route cannot be created (no local state present) Nov 10 16:48:42 2019 ESI 00:00:00:00:00:00:00:00:01:01, peer 192.168.255.12 per-ES AD route not rcvd, remote peer found Nov 10 16:48:42 2019 Sent MAC add with NH 0, interface ae1.0 (index 0), RTT 6, remote addr 192.168.255.12, ESI 0101, VLAN 0, VNI 5202, flags 0x0, timestamp 0x5dc8afe9 to L2ALD Nov 10 16:48:42 2019 Sent peer 192.168.255.12 record createdVerifique as rotas EVPN na Spine 1. Essa saída mostra que esses endereços MAC são anunciados pelos switches spine como rotas BGP.

user@spine1> show route table bgp.evpn.0 evpn-mac-address 00:10:94:00:01:01 bgp.evpn.0: 75 destinations, 75 routes (75 active, 0 holddown, 0 hidden) Restart Complete + = Active Route, - = Last Active, * = Both 2:192.168.255.13:1::5202::00:10:94:00:01:01/304 MAC/IP *[EVPN/170] 00:01:52 Indirect user@spine1> show route table bgp.evpn.0 evpn-mac-address 00:10:94:00:01:02 bgp.evpn.0: 75 destinations, 75 routes (75 active, 0 holddown, 0 hidden) Restart Complete + = Active Route, - = Last Active, * = Both 2:192.168.255.13:1::5202::00:10:94:00:01:02/304 MAC/IP *[EVPN/170] 00:02:02 IndirectVerifique as rotas EVPN na Spine 2. Essa saída mostra que as rotas BGP receberam o peering do IBGP com o Spine 1. Vamos analisar detalhadamente essas rotas.

user@spine2> show route receive-protocol bgp 192.168.255.13 inet.0: 13 destinations, 14 routes (13 active, 0 holddown, 0 hidden) Restart Complete JNPR_1_VRF.inet.0: 9 destinations, 11 routes (9 active, 0 holddown, 0 hidden) :vxlan.inet.0: 9 destinations, 9 routes (9 active, 0 holddown, 0 hidden) Restart Complete JNPR_2_VRF.inet.0: 9 destinations, 11 routes (9 active, 0 holddown, 0 hidden) mpls.0: 2 destinations, 2 routes (2 active, 0 holddown, 0 hidden) Restart Complete inet6.0: 1 destinations, 1 routes (1 active, 0 holddown, 0 hidden) Restart Complete JNPR_1_VRF.inet6.0: 1 destinations, 1 routes (1 active, 0 holddown, 0 hidden) JNPR_2_VRF.inet6.0: 1 destinations, 1 routes (1 active, 0 holddown, 0 hidden) bgp.evpn.0: 75 destinations, 75 routes (75 active, 0 holddown, 0 hidden) Restart Complete Prefix Nexthop MED Lclpref AS path 1:192.168.255.13:0::0101::FFFF:FFFF/192 AD/ESI * 192.168.255.13 100 I 1:192.168.255.13:0::0102::FFFF:FFFF/192 AD/ESI * 192.168.255.13 100 I ... 1:192.168.255.13:0::050000fe4c0000145c00::FFFF:FFFF/192 AD/ESI * 192.168.255.13 100 I 1:192.168.255.13:1::0101::0/192 AD/EVI * 192.168.255.13 100 I 1:192.168.255.13:1::0102::0/192 AD/EVI * 192.168.255.13 100 I ...

As duas rotas do Tipo 1 enfatizadas acima mostram que o Spine 1 está conectado a dois segmentos de Ethernet (ES). Os números de ESI são 0101 e 0102.

... 2:192.168.255.13:1::5202::00:00:5e:00:01:01/304 MAC/IP * 192.168.255.13 100 I 2:192.168.255.13:1::5202::00:10:94:00:01:01/304 MAC/IP * 192.168.255.13 100 I 2:192.168.255.13:1::5202::00:10:94:00:01:02/304 MAC/IP * 192.168.255.13 100 I ...

Essas duas rotas são rotas do Tipo 2 mostradas acima são anunciadas pela Spine 1. Eles mostram que os dois endereços MAC podem ser alcançados pelo Spine 1.

Verifique o plano de controle para os seguintes endereços MAC na Spine 1.

user@spine1> show route table bgp.evpn.0 evpn-mac-address 00:10:94:00:01:01 bgp.evpn.0: 78 destinations, 78 routes (78 active, 0 holddown, 0 hidden) Restart Complete + = Active Route, - = Last Active, * = Both 2:192.168.255.13:1::5202::00:10:94:00:01:01/304 MAC/IP *[EVPN/170] 00:11:49 Indirectuser@spine1> show route table bgp.evpn.0 evpn-mac-address 00:10:94:00:01:02 bgp.evpn.0: 78 destinations, 78 routes (78 active, 0 holddown, 0 hidden) Restart Complete + = Active Route, - = Last Active, * = Both 2:192.168.255.13:1::5202::00:10:94:00:01:02/304 MAC/IP *[EVPN/170] 00:11:52 IndirectVerifique as entradas da tabela de encaminhamento para esses endereços MAC no Spine 1. A saída a seguir mostra que a interface Ethernet agregada local é usada para comutação de tráfego destinado a esses endereços MAC.

user@spine1> show route forwarding-table destination 00:10:94:00:01:01 Routing table: default-switch.bridge Bridging domain: VLAN-202.bridge VPLS: Enabled protocols: Bridging, ACKed by all peers, Destination Type RtRef Next hop Type Index NhRef Netif 00:10:94:00:01:01/48 user 0 ucst 1710 7 ae1.0

user@spine1> show route forwarding-table destination 00:10:94:00:01:02 Routing table: default-switch.bridge Bridging domain: VLAN-202.bridge VPLS: Enabled protocols: Bridging, ACKed by all peers, Destination Type RtRef Next hop Type Index NhRef Netif 00:10:94:00:01:02/48 user 0 ucst 1754 9 ae2.0

Teste o que acontece quando um uplink falha. Se um uplink do ToR 1 falhar, a saída mostra que o estado nessa interface é

Detached.user@spine1> show lacp interfaces ae1 Aggregated interface: ae1 LACP state: Role Exp Def Dist Col Syn Aggr Timeout Activity xe-0/0/13 Actor No Yes No No No Yes Fast Active xe-0/0/13 Partner No Yes No No No Yes Fast Passive LACP protocol: Receive State Transmit State Mux State xe-0/0/13 Port disabled No periodic DetachedA Figura 6 mostra a topologia quando a interface conectada ao ToR 1 no Spine 1 está baixa.

Figura 6: topologia quando o uplink falha

Verifique se o Spine 1 está aprendendo agora este endereço MAC da Spine 2, já que a Spine 1 não tem uma conexão direta com o ToR 1.

user@spine1> show route table bgp.evpn.0 evpn-mac-address 00:10:94:00:01:01 bgp.evpn.0: 76 destinations, 76 routes (76 active, 0 holddown, 0 hidden) Restart Complete + = Active Route, - = Last Active, * = Both 2:192.168.255.12:1::5202::00:10:94:00:01:01/304 MAC/IP *[BGP/170] 00:01:05, localpref 100, from 192.168.255.12 AS path: I, validation-state: unverified to 192.168.100.4 via et-0/0/50.0 > to 192.168.100.6 via et-0/0/51.0Os detalhes da tabela de encaminhamento da Spine 1 mostram que o tráfego destinado a este endereço MAC é enviado à Spine 2.

user@spine1> show route forwarding-table destination 00:10:94:00:01:01 extensive Routing table: default-switch.bridge [Index 6] Bridging domain: VLAN-202.bridge [Index 6] VPLS: Enabled protocols: Bridging, ACKed by all peers, Destination: 00:10:94:00:01:01/48 Learn VLAN: 0 Route type: user Route reference: 0 Route interface-index: 560 Multicast RPF nh index: 0 P2mpidx: 0 IFL generation: 514 Epoch: 0 Sequence Number: 0 Learn Mask: 0x4000000000000000010000000000000000000000 L2 Flags: control_dyn Flags: sent to PFE Nexthop: Next-hop type: composite Index: 1724 Reference: 26 Next-hop type: indirect Index: 524289 Reference: 3 Next-hop type: unilist Index: 524288 Reference: 6 Nexthop: 192.168.100.4 Next-hop type: unicast Index: 1708 Reference: 4 Next-hop interface: et-0/0/50.0 Weight: 0x0 Nexthop: 192.168.100.6 Next-hop type: unicast Index: 1709 Reference: 4 Next-hop interface: et-0/0/51.0 Weight: 0x0

Verifique a conectividade entre servidores VLAN

Procedimento passo a passo

No Spine 1, verifique se os dois endereços MAC estão em VLANs diferentes.

user@spine1> show ethernet-switching table | match 00:10:94:00:11:11 VLAN-201 00:10:94:00:11:11 DLR ae1.0

user@spine1> show ethernet-switching table | match 00:10:94:00:01:02 VLAN-202 00:10:94:00:01:02 DL ae2.0

No Spine 1, verifique a resolução de ARP para os dois endpoints.

user@spine1> show arp no-resolve | match 00:10:94:00:11:11 00:10:94:00:11:11 192.168.201.41 irb.201 [ae1.0] permanent remote

user@spine1> show arp no-resolve | match 00:10:94:00:01:02 00:10:94:00:01:02 192.168.202.42 irb.202 [ae2.0] permanent remote

Na Spine 1, verifique o aprendizado do plano de controle para o endereço MAC 00:10:94:00:11:11. Você pode ver que existe uma rota MAC para o endereço MAC e uma rota MAC/IP para este endereço MAC.

user@spine1> show route table bgp.evpn.0 evpn-mac-address 00:10:94:00:11:11 bgp.evpn.0: 82 destinations, 82 routes (82 active, 0 holddown, 0 hidden) Restart Complete + = Active Route, - = Last Active, * = Both 2:192.168.255.12:1::5201::00:10:94:00:11:11/304 MAC/IP *[BGP/170] 00:08:43, localpref 100, from 192.168.255.12 AS path: I, validation-state: unverified to 192.168.100.4 via et-0/0/50.0 > to 192.168.100.6 via et-0/0/51.0 2:192.168.255.13:1::5201::00:10:94:00:11:11/304 MAC/IP *[EVPN/170] 00:09:01 Indirect 2:192.168.255.12:1::5201::00:10:94:00:11:11::192.168.201.41/304 MAC/IP *[BGP/170] 00:08:43, localpref 100, from 192.168.255.12 AS path: I, validation-state: unverified to 192.168.100.4 via et-0/0/50.0 > to 192.168.100.6 via et-0/0/51.0 2:192.168.255.13:1::5201::00:10:94:00:11:11::192.168.201.41/304 MAC/IP *[EVPN/170] 00:09:01 IndirectVerifique as entradas da tabela de encaminhamento para esses endereços MAC. Como o Spine 1 está conectado a ambos os switches ToR localmente, o tráfego é trocado localmente para o switch ToR correspondente do Spine 1.

user@spine1> show route forwarding-table destination 00:10:94:00:11:11 Routing table: default-switch.bridge Bridging domain: VLAN-201.bridge VPLS: Enabled protocols: Bridging, ACKed by all peers, Destination Type RtRef Next hop Type Index NhRef Netif 00:10:94:00:11:11/48 user 0 ucst 1710 8 ae1.0

user@spine1> show route forwarding-table destination 00:10:94:00:01:02 Routing table: default-switch.bridge Bridging domain: VLAN-202.bridge VPLS: Enabled protocols: Bridging, ACKed by all peers, Destination Type RtRef Next hop Type Index NhRef Netif 00:10:94:00:01:02/48 user 0 ucst 1754 10 ae2.0

O que vem a seguir

Você configurou e verificou uma arquitetura spine colapsada para o seu primeiro data center. Se necessário, repita a configuração dos dispositivos no segundo data center.

Acesse a próxima página para configurar a segurança avançada e conectar seus data centers.

Estado split-brain

Como evitar um estado de cérebro dividido

Problema

Se os links entre os switches spine estiverem desativados, fazendo com que o peering BGP seja desativado, ambos os switches spine estão ativos e encaminhando. As interfaces Ethernet agregadas a downstream estão ativas e em encaminhamento. Esse cenário é conhecido como estado split-brain e pode causar vários problemas.

Solução

Para evitar que esse problema ocorra, escolha um switch spine para ser o switch de espera.

Também recomendamos:

-

Usando pelo menos duas ligações entre os switches spine. Isso torna menos provável que todos os links entre os switches spine dimerão.

-

Multihoming de todos os servidores. Se houver um servidor de casa única em um dos switches spine, o servidor pode ser inalcançável.

O que vem a seguir

Você configurou e verificou uma arquitetura spine colapsada para o seu primeiro data center. Se necessário, repita a configuração dos dispositivos no segundo data center.

Acesse a próxima página para configurar a segurança avançada e conectar seus data centers.